Key points:预训练+微调模式;上游预训练;下游迁移;更通用的视觉表征学习;BiT-HyperRule

摘要:在训练视觉深度神经网络时,预训练表示的转移提高了样本效率,简化了超参数调优。回顾了在大型监督数据集上进行预训练的范式,并对目标任务上的模型进行微调。我们扩大了预训练的规模,并提出了一个简单的方法,我们称之为(BiT)。通过组合一些精心选择的组件,并使用简单的启发式传输,我们在超过20个数据集上实现了强大的性能。BiT在令人惊讶的广泛数据机制上表现良好——从每个类1个示例到总示例1million个。BiT在ILSVRC-2012上达到了87.5%的top 1精度,在CIFAR-10上达到了99.4%,在VTAB(19任务视觉任务适应基准)上达到了76.3%。在小数据集上,在ILSVRC-2012上每类10个样本的BiT达到76.8%,在CIFAR-10上每类10个样本的BiT达到97.0%。我们对导致高传输性能的主要组件进行了详细的分析。

BiT--分类任务--crop

对于预训练+微调模式的迁移学习来说,更有效的结果分为两种:1、在某一类下游任务中取得优秀的性能。2、能够完成尽可能多的下游任务,且都能够取得较为良好的成绩。

对于BiT来说,属于第二个,在近20个数据集上完成较好的结果,并且最关键的是,BiT在迁移的过程使用的是固定(相同)的处理方法,从而更能说明其具有较好的普适性。

预训练

1、在三个不同规模的数据集上进行预训练,ILSVRC-2012(1.3M图片), ImagegNet-21k(14M图片)和JFT(300M图片)数据集,探究了预训练数据集的数据量和带来的计算量对模型尺寸的相互作用,这一研究后续被使用到了ViT中。

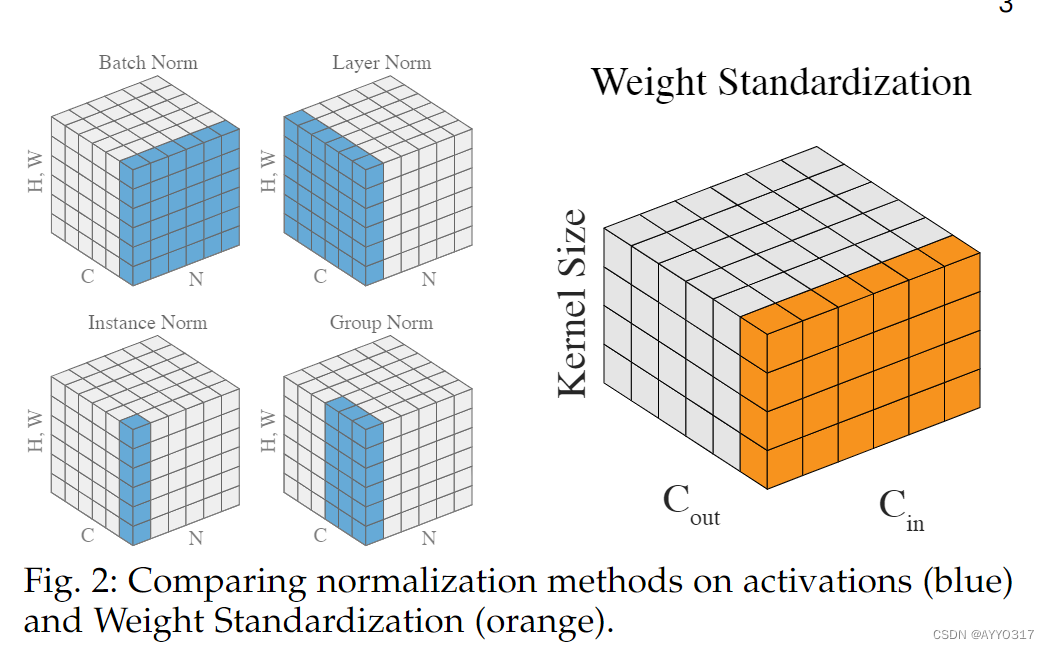

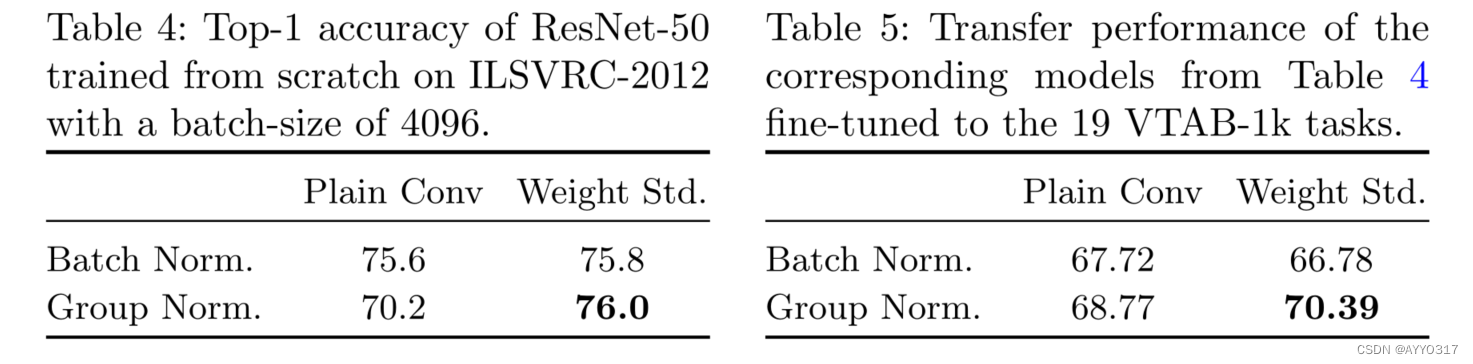

2、在预训练的过程中,探究了BN(Batch Norm),GN(Group Norm),WS(Weight Standardization)的结合引起的性能变化。

由此可以看出,GN 与WS 结合使用时可以得到更好的结果,原因在于:1. 预训练需要的多卡(多设备)训练,因此设备之间需要通信,然而,模型尺寸比较大的时候,在每个设备上的batch size无法太大。2. BN不适合迁移学习,因为数据变了统计量往往需要变化。

迁移到各个下游任务

将各个训练好的模型在具体的下游任务时进行微调fine-tuning。

固定策略包括:

1.training schedule length。对于training schedule length,我们根据示例的数量定义了三种规模机制:我们称小任务为标记示例少于20 k的任务,称中等任务为标记示例少于500 k的任务,任何更大的数据集都是大任务。我们对小任务的500步、中等任务的10k步和大任务的20k步进行微调BiT。在微调期间,我们在30%、60%和90%的训练步骤将学习率衰减10倍。

2.图片清晰程度。对于所有任务,使用SGD,初始学习率为0.003,动量为0.9,批处理大小为512。将面积小于96 × 96像素的输入图像调整为160 × 160像素,然后随机裁剪128 × 128像素。将较大的图像调整为448 × 448,并采用384 × 384大小的作物。除了那些剪裁或翻转破坏标签语义的任务外,对所有的任务应用随机裁剪和水平翻转。

3.是否使用Mix-up正则化,最后,文章使用MixUp , α = 0.1,用于中型和大型任务。

讨论

文章回顾了经典的迁移学习,其中一个经过预先训练的大型通才模型被微调为下游感兴趣的任务。并提供了一个简单的方法,利用大规模的预训练在所有这些任务上产生良好的表现。BiT使用简单方便的训练和微调设置,使用少量精心选择的组件,以平衡复杂性和性能。

BiT探索了转移到两类更具挑战性的任务的有效性:经典的图像识别任务,但只有很少的标记示例来适应新领域,以及VTAB,它包含更多样化的任务,如空间定位,来自模拟环境的任务,以及医疗和卫星成像任务。这些基准距离饱和还远得多;虽然BiT-L在这些方面表现良好,但仍有很大的进步空间。

839

839

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?