目录

ELK日志分析-简介

Elasticsearch是与名为Logstash的数据收集和日志解析引擎以及名为Kibana的分析和可视化平台一起开发的。这三个产品被设计成一个集成解决方案,称为“Elastic Stack”(以前称为“ELK stack”)。

ElasticSearch:是一个基于Lucene的搜索服务器。它提供了一个分布式多用户能力的全文搜索引擎,基于RESTful web接口。Elasticsearch是用Java开发的,并作为Apache许可条款下的开放源码发布,是当前流行的企业级搜索引擎。设计用于云计算中,能够达到实时搜索,稳定,可靠,快速,安装使用方便。

Logstash:是一个具有实时渠道能力的数据收集引擎,主要用于日志的收集与解析,并将其存入 ElasticSearch中。与ElasticSearch有很高的适配性。

Kibana:是一款基于 Apache 开源协议,使用 JavaScript 语言编写,为 Elasticsearch提供分析和可视化的 Web 平台。它可以在 Elasticsearch 的索引中查找,交互数据,并生成各种维度的表图。

1.实验环境

三台纯净的rhel7.6

2.Elasticsearch的部署

下载安装

下载中心 - Elastic 中文社区![]() https://elasticsearch.cn/download/这里下载了7.6.1

https://elasticsearch.cn/download/这里下载了7.6.1

wget https://artifacts.elastic.co/downloads/elasticsearch/elasticsearch-7.6.1-x86_64.rpm

yum install elasticsearch-7.6.1-x86_64.rpm -y

systemctl daemon-reload配置

编辑yml文件,重启服务报错

17 cluster.name: my-es 集群名

23 node.name: server1 主机名本地解析

43 bootstrap.memory_lock: true 锁定内存 生产环境

http.port: 9200

55 network.host: 0.0.0.0

68 discovery.seed_hosts: ["server1", "server2","server3"]

72 cluster.initial_master_nodes: ["server1", "server2","server3"] 初始化的master取值

查看日志分析

cat /var/log/elasticsearch/my-es.log

[1]: memory locking requested for elasticsearch process but memory is not locked

根据日志提示修改

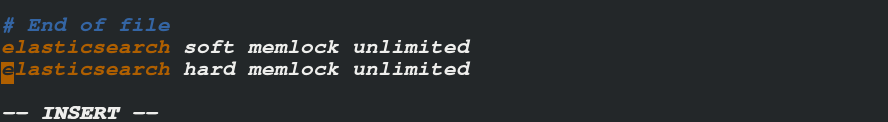

vim /etc/security/limits.conf

内存足够将swap分区禁掉

[root@server1 elasticsearch]# vim /etc/fstab

[root@server1 elasticsearch]# mount -a

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

9392

9392

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?