Hadoop伪分布式环境搭建

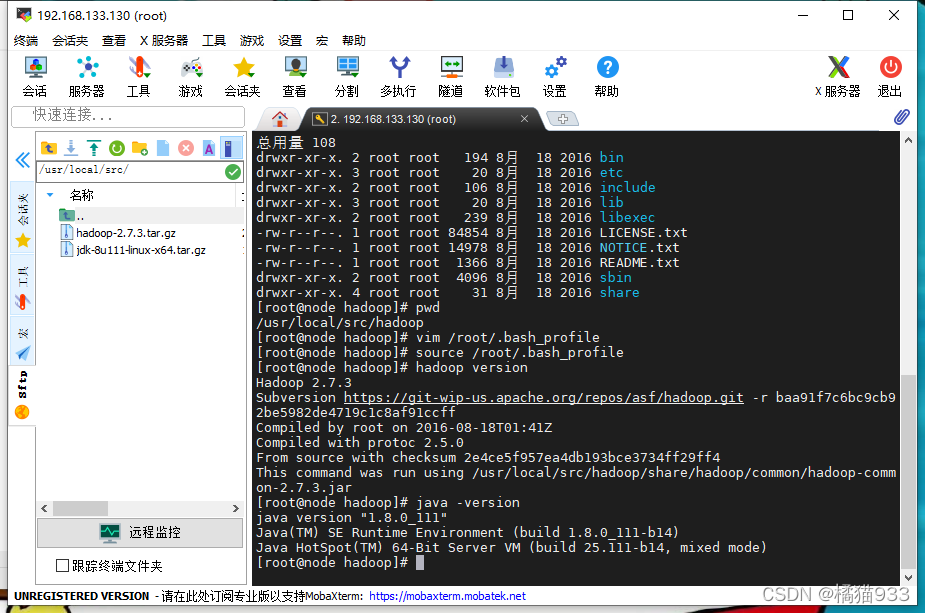

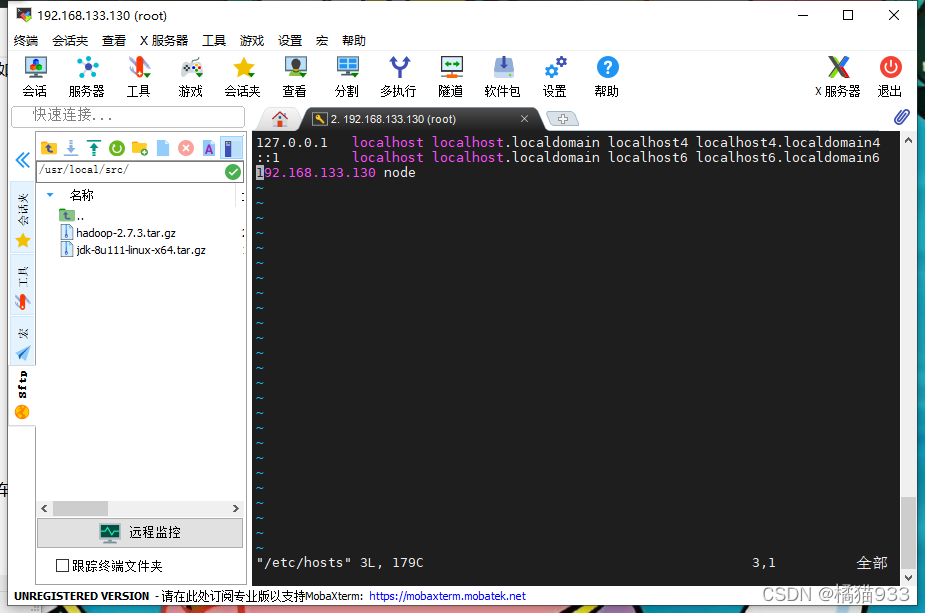

1. 准备环境(VMware、CentOS7/node-14.rar) -. 解压 node-14.rar这个压缩包到指定目录 -. 找到 解压之后的node/node.vmx 这个文件,双击它,会通过WMware打开 -. 在VMware中弹出的警告框中选择 【获取所有权】,在左侧菜单就会出现node -. 点击【开启此虚拟机】启动,在弹出框中选择【我已移动该虚拟机】 -. 启动完毕后,会出现一个 node login: 提示,表示需要输入用户名和密码进行登录(默认都是root) 注意在输入密码的时候,虚拟机上不会显示 当出现 [root@node ~]# 说明登录成功。 2. 配置网络 -. 查看当前虚拟机的网络环境:找到WMware的编辑菜单-->虚拟网络编辑器-->WMnet8-->子网IP(记录自己的网段) 192.168.xxx.0 --> xxx就是需要记录的 -->197 -. 通过一个命令 nmtui 回车,修改网络 -- 通过键盘的方向键--> Edit a connection --> <Edit...> --> Addresses : 修改224为前面记录的网段 Gateway: 修改224为前ping面记录的网段 修改完毕后,确认无误,移动到OK,退出 --> <Back> ---> Quit --> OK -. 退出之后,输入 reboot 命令,重启虚拟机 -. 测试网络是否畅通--> 输入一个命令 ping baidu.com 如果返回数据包,则表示畅通,否则需要检查上述步骤是否正确 要结束数据包的返回,则按 Ctrl + C 结束 3. 安装Hadoop和JDK软件 -- 下载 安装包:hadoop-2.7.3.tar.gz、 jdk-8u111-linux-x64.tar.gz -- 安装模拟终端工具 MobaXterm 工具,解压到任意目录即可 -- 打开模拟终端工具-->新建一个会话(终端下面的图表)-->输入远程主机鴀.168.xxx.130)和用户名(root) 注意:密码同样不会显示,输入正确即可 --> 密码也是root - 上传到指定目录: /usr/local/src 需要借助 MobaXterm 1). 输入命令:cd /usr/local/src ,通过 命令 pwd 查看目录,复制这个目录到左侧输入框中,回车 点击上传按钮,选择jdk和hadoop安装包上传 -- 安装Hadoop和JDK软件 1). 把jdk和hadoop安装包进行解压到当前目录 /usr/local/src [root@node src]# tar -zxvf hadoop-2.7.3.tar.gz [root@node src]# tar -zxvf jdk-8u111-linux-x64.tar.gz [root@node src]# clear 2). 删除安装包 [root@node src]# rm -rf *.gz 3). 把解压的文件夹名称进行重命名为 jdk 和 hadoop [root@node src]# mv hadoop-2.7.3/ hadoop [root@node src]# mv jdk1.8.0_111/ jdk 4). 配置环境变量 /root/.bash_profile,需要借助文本编辑器vim,默认是没有,需要手动安装 输入安装命令: yum install -y vim 输入一个命令: vim /root/.bash_profile 编辑文件,在文件最后面添加如下内容: export JAVA_HOME=/usr/local/src/jdk export HADOOP_HOME=/usr/local/src/hadoop export PATH=$PATH:$JAVA_HOME/bin:$HADOOP_HOME/bin:$HADOOP_HOME/sbin 输入完毕后,按ESC按键,确保左下角的 --插入-- 提示消失,再输入 :wq 保存退出 退出之后,要使上述配置生效,需要运行命令: source /root/.bash_profile 5). 测试JDK和Hadoop是否配置成功 [root@node src]# java -version [root@node src]# hadoop version 注意:如果出现 java 命令未找到或者 hadoop 命令未找到,则表示上述文件配置路径有误,需要回去查看 -- 修改Hadoop的配置文件 1). 输入一个命令:cd hadoop/etc/hadoop 如果不是在 src 目录,则输入 cd /usr/local/src/hadoop/etc/hadoop 2). 修改 hadoop-env.sh 文件 输入一个命令:vim hadoop-env.sh ,进入文本编辑器,找到 export JAVA_HOME 的配置,修改后面的值 export JAVA_HOME=/usr/local/src/jdkii 修改完毕后,就按ESC按键,确保左下角的 --插入-- 提示消失,再输入 :wq 保存退出 3). 修改 core-site.xml 文件 输入一个命令:vim core-site.xml ,进入文本编辑器,在<configuration></configuration> 标签之间加入如下代码: <property> <name>fs.defaultFS</nam <value>hdfs://node:8020</value> </property> <property> <name>hadoop.tmp.dir</name> <value>/usr/local/src/hadoop/data</value> </property> 修改完毕后,确认无误,就按ESC按键,确保左下角的 --插入-- 提示消失,再输入 :wq 保存退出 4). 修改 hdfs-site.xml 文件 输入一个命令:vim hdfs-site.xml ,进入文本编辑器,在<configuration></configuration> 标签之间加入如下代码: <property> <name>dfs.replication</name> <value>1</value> </property> <property> <name>dfs.namenode.secondary.http-address</name> <value>node:50090</value> </property> 修改完毕后,确认无误,就按ESC按键,确保左下角的 --插入-- 提示消失,再输入 :wq 保存退出 5). 修改 slaves 文件 输入一个命令:vim slaves ,进入文本编辑器,修改 localhost 为 node 修改完毕后,确认无误,就按ESC按键,确保左下角的 --插入-- 提示消失,再输入 :wq 保存退出 -- 配置SSH免密登录 1). 修改映射文件 /etc/hosts 输入命令: vim /etc/hosts ,进入文本编辑器,在最后面加入一行 IP地址 node ,如下: 192.168.xxx.130 node 2). 使用SSH命令生成公钥和私钥,运行命令:ssh-keygen ,然后4次回车 3). 使用SSH命令把公钥发送给需要免密登录的主机 node ,运行命令:ssh-copy-id node 回车,输入yes,回车,输入密码 注意:如果SSH第一次配置失败,想配置第二次的,需要删除一个文件夹才可以,运行一个命令:rm -rf /root/.ssh -- 启动Hadoop服务测试 1).

本文详细介绍了如何在CentOS7上搭建Hadoop的伪分布式环境,包括准备VMware虚拟机、配置网络、安装JDK和Hadoop、修改配置文件、设置SSH免密登录以及启动Hadoop服务的步骤,旨在帮助初学者快速入门Hadoop分布式计算。

本文详细介绍了如何在CentOS7上搭建Hadoop的伪分布式环境,包括准备VMware虚拟机、配置网络、安装JDK和Hadoop、修改配置文件、设置SSH免密登录以及启动Hadoop服务的步骤,旨在帮助初学者快速入门Hadoop分布式计算。

1124

1124

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?