原文:基于深度学习的图像-文本匹配研究综述

图像-文本匹配方法主要环节

文本编码器

-

目的:旨在捕获文本语句描述中蕴含的语义信息,以得到文本模态的特征表示

-

主要方法:

-

整体文本编码方法

-

Skip-Gram

-

费舍尔向量 Fisher Vector

-

缺点:忽略上下文信息的重要作用,也就是内部联系

-

word2vec结合RNN

结合seq上下文信息输出文本表示 -

带多头注意力机制的Transformer/Encoder结构

-

额外方法:引入外部知识

在上面的基础上,通过引入外部知识来增强文本语义理解,如共识知识

视觉编码器

-

目的:主要负责编码图像中蕴含的视觉语义信息,以得到视觉特征表示

-

主要方法:

-

卷积神经网络。

如AlexNet,对图像采用整体建模来得到全局视觉表示。缺点是会损失细粒度语义信息。 -

基于局部建模的编码策略。

如基于物体检测的区域建模方法,基于特征图的像素建模方法 -

采用自注意机制或图卷积网络。

用于强化视觉模态内实体间关系,从而进一步增强视觉语义理解 -

额外方法:引入外部知识

如场景图信息,来增强对于视觉语义信息的理解

跨模态匹配

-

旨在消除模态间的语义鸿沟,更好对齐两个模态的语义信息,从而更加精准地进行相似性估计

-

主要方法:

-

基于全局特征的图像-文本匹配方法。

将视觉特征和文本特征联合嵌入到共空间中进行跨模态语义相似性估计。 -

基于局部特征的图像文本匹配方法。

侧重于直接探究视觉区域和词语对之间的潜在语义对齐,也就是块之间的联系。而后利用平均或者LogSumExp聚合局部相似性,从而得到图像和文本的匹配得分。 -

设计不同跨模态交互机制。

-

设计不同度量方式

如NNAF利用不匹配的实体信息,CMCAN则为 匹配区域-词语对 赋值不同的置信度,来衡量跨模态语义相似性。

损失函数

-

目的:旨在通过不同的目标函数来约束图像-文本匹配模型的学习。

-

常用方法:

-

采用相同的排序函数来学习

如铰链排序损失(也叫三元组排序损失),和双向铰链排序损失 -

存在问题:很难直接找到最合适的三元组,可能会致使视觉-语义嵌入学习效果不理想

-

解决方法:度量学习图像-文本匹配方法

-

基于度量学习的图像-文本匹配方法。

通过引入新的损失函数来提升学习性能,如枢纽感知损失、多项式损失、五元组损失函数等 -

自适应边距的三元组损失函数

-

边距无关的损失函数

现有基于深度学习图像-文本匹配方法

需要解决的难题

- 目标:给定图像和文本,判断二者之间是否具有语义一致性。

- **模态内语义理解和建模

**需要在各自的模态内理解完进行相互比对才能产生一个不错的结果,否则容易造成文本语句和图像语义不匹配。图像中包含多种不同类别物体且物体间关系繁多;而文本语句描述通常比较繁琐冗长。 - 跨模态语义对齐和匹配

异模态构建信息存在巨大的语义鸿沟,所以还需要精准匹配两个模态间对应语义关系。模型需要对有区分性的语义信息进行准确地对齐才能精准地返回匹配结果。

研究现状分析

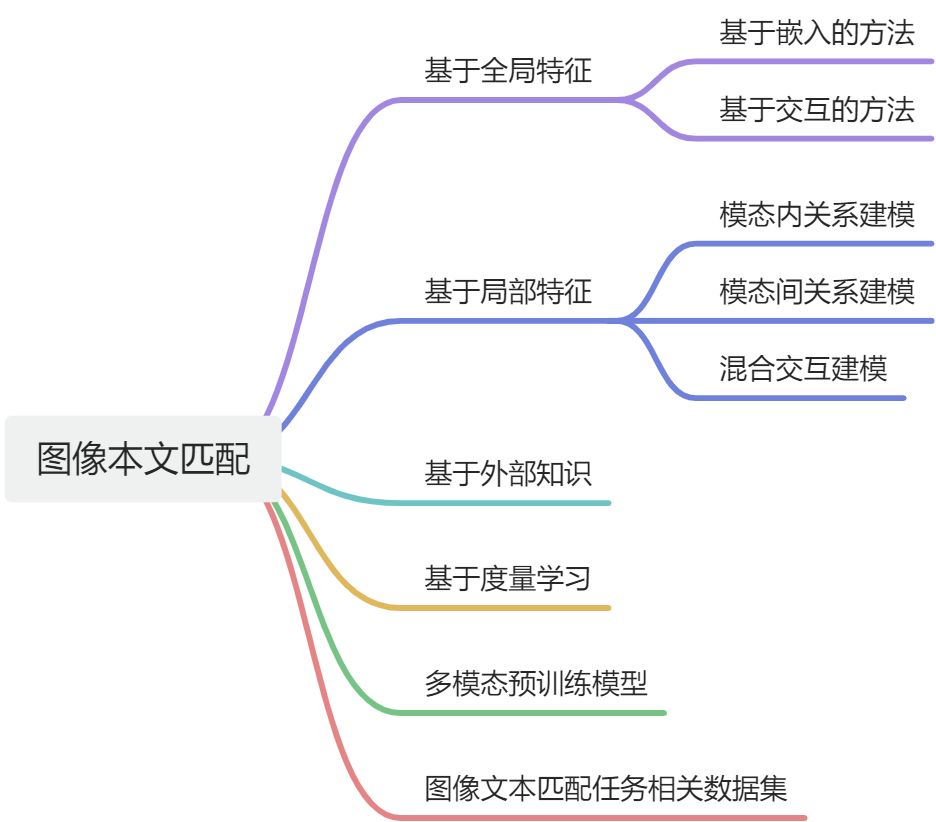

本文将现有图像-文本匹配方法划分为六大类

- 基于全局特征的图像文本匹配方法

- 基于局部特征的图像文本匹配方法

- 基于外部知识的图像文本匹配方法

- 基于度量学习的图像文本匹配方法

- 图像-文本多模态预训练模型

- 其他相关任务

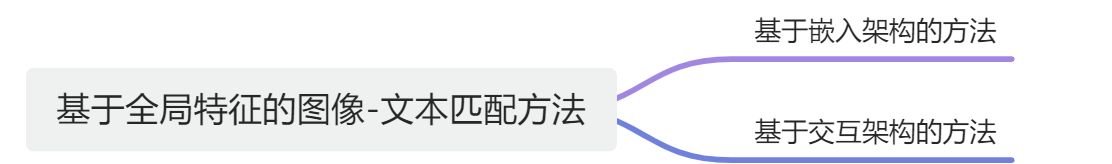

基于全局特征的图像文本匹配方法

CNN处理图像,RNN处理文本,利用不同的模型架构来实现图像-文本的跨模态匹配。

- 基于嵌入架构方法:直接在共空间中约束图像和文本表示的学习

- 基于交互式架构方法:通过挖掘两种模态间的交互信息,从而更好实现跨模态语义匹配

基于嵌入架构方法

共性

通常先将整个图像和文本描述的特征转换到一个公共嵌入空间中,然后通过度量嵌入特征间的相似度来衡量图像和文本是否匹配。该类方法重在探究如何学习鲁棒的多模态嵌入表示。

个性

- 部分方法直接采用传统共空间表示学习方法

- 一些方法则在传统共空间表示的基础上,引入其他约束,如保结构约束、跨模态相关性约束以及对抗约

束,来增强两种模态信息的表示。

基于交互架构的方法

核心:通过捕获模态间交互信息来预测匹配分数。

基于交互架构的全局图像-文本匹配工作较少,不同之处主要集中在交互机制的设计上面。

总结

- 仅对全局语义信息进行编码与处理,不涉及细粒度语义信息建模,所以匹配效率通常较高。

- 其不能充分理解各模态内蕴含的丰富语义信息,甚至引入噪声

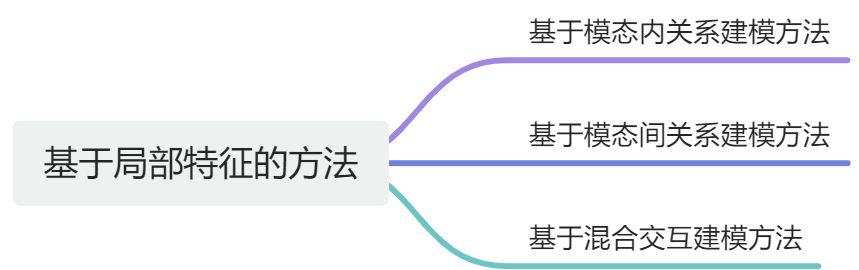

基于局部特征的图像文本匹配方法

基于模态内关系建模方法

双模态交互关系建模方法

- 多数采用图卷积神经网络增强实体间关系建模

- 使用多模态一致性关系约束来捕获视觉和文本中的一致性语义信息

- 致力于多模态信息编码效率研究

基于模态间关系建模方法

套索跨模态实体间关系建模,目的是更好地对齐视觉和文本语义信息,增强图像-文本匹配精准度。

目前多采用注意力机制或改进注意力机制建模的跨模态语义关联关系。

也有采用一致性语义约束或图网络等方式捕获跨模态关联关系

基于混合交互建模方法

为同时增强模态内和模态间关系建模而提出。既考虑文本-视觉交互信息建模,也考虑视觉-文本内部关联性关系建模。

常用方法:

- 串行混合模式

先模态间再模态内 - 同步进行模式

同步进行模态间和模态内交互。类似于基于模态间和基于模态内交互方法。混合交互策略大多也是采用注意力机制,少数工作采用图网络建模模态内或模态间关联关系。

总结

为了有效解决图像-文本匹配的模态内语义理解与建模的挑战,基于局部特征的匹配方法设计不同的注意力机制以及图卷积网络,来挖掘各个模态内有用的细粒度实体信息以及实体间关联关系。

为了提升模态间语义的对齐和匹配,许多基于注意力机制的模态间关联性关系建模策略提出。通过对关键性跨模态语义信息对进行对齐和聚集,以得到精准的图像-文本匹配的分数估计。

这两个方法有一定的效果,但复杂的关联性关系建模设计导致匹配效率过低。而且这些方法的底层特征往往由其他数据集上预训练模型提取,导致模型对实体信息理解较为局限,容易受上游预训练模型影响。

基于外部知识的图像文本匹配方法

基于局部特征的方法虽然捕获了细粒度语义信息,用于跨模态语义匹配,但对一些语义信息的理解仍然不全面,而且对一些语义关联关系的挖掘不够充分。所以基于外部知识的图像文本匹配方法被提出。

这类方法大多从外部获取一定先验知识,如预训练任务或场景图,用于提升对视觉或文本的语义理解,从而提升图像-文本匹配任务的精准度。、

常用方法:

- 场景图

- 共识信息。也就是两种模态间共享的常识性知识

- 外延图。概念及其对应视觉目标之间语义知识的层次组织,外延图中的结点是比目标标签语义丰富的复合短语,结点之间的关系也更丰富。

- 多模态神经机器翻译的Encoder-Decoder结构,可以丰富单语言和多语言文本多样性这一事实、

- 关注匹配效率提出的简单高效的匹配方法——LightningDOT。通过在三个新学习目标上进行预训练,可以离线提取特征,并采用点积匹配。将图像-文本匹配时间加快了数千倍。

结论

通过引入实体语义信息,以及实体间关联关系的先验知识,一定程度上可以增强模态内语义信息的理解,并有助于跨模态语义的匹配。

缺点:

由于先验知识数据来源与图像文本匹配任务数据集之间的域差异,可能会导致部分语义理解偏差且引入噪声,继而影响匹配结果。

基于度量学习的图像-文本匹配方法

不同于上述三种类别方法,基于度量学习的匹配方法旨在探究更好的模型约束或相似性度量机制,以提升不同样本对间的可区分性和同一样本对间的关联性。

特别地,这种基于度量的方法往往可以嵌入到上述三种类别方法的模型中,进一步提升它们的性能。

现有方法

- 排序损失学习视觉-语义嵌入表示。缺点是很难一开始就找到合适的三元组,故直接在异构特征上执行排序损失会使效果会变差,且损害网络对多模态关系的学习。

- 加权策略,通过调整样本对的权值来提升模型性能。

- 引入新的损失函数约束

- 从相似性度量设计角度出发。例如图最优传输框架,将图像-文本匹配任务转化为跨模态图匹配问题。

- 针对不匹配片段中蕴含的重要线索,提出消极感知注意框架

总结

基于度量学习的图像-文本匹配方法通常在不影响匹配效率的情况下,可进一步提升匹配精度。因为仅仅对于模型优化的目标函数进行改进,未引进过多的额外参数以及交互模块设计。相较于前面三种方法,基于度量学习的匹配方法并未从本质上解决模态内语义理解以及模态间语义对齐两个挑战。

图像-文本多模态预训练模型

上述几种类别方法仅在有限数据上进行训练,故泛化能力较弱。近期许多视觉-文本多模态预训练模型被提出,大致可以分为两类:

- 单流框架。视觉信息和文本信息由一个多模态编码器联合处理

- 双流框架。单独地对视觉信息和文本信息进行建模,而后再进行多模态联合建模。

双流框架

通常用两个单模态网络分别处理输入的文本和图像,然后利用一个跨模态融合网络对不同模态进行关联。

该分支的代表作是ViLBERT。分别采用Faster-RCNN进行视觉信息处理,和类BERT进行文本信息处理,而后采用协同注意力Transformer进行跨模态特征融合。

单流框架

不同于双流框架,单流框架的视觉-文本预训练模型结构较为简单,可以更早且更自由地对两种模态信息进行融合

Visual BERT:Transformer

OSCAR:相同语义下物体作为图像和语言对齐的连接点,从而简化图像文本之间的语义对齐学习任务

Pixel-BERT:使用传统像素级特征进行预训练,实现一种端到端的多模态训练方式

ViLT:把视觉编码模块变为无卷积的处理方式,是一种极简的视觉-文本预训练模型

SimVLM:采用类似的视觉处理方式,利用大规模弱标记数据集进行预训练,具有强大的泛化和迁移能力

UNITER,Unified-VLP和 XGPT:改进预训练任务来增强模型的学习能力

Image-BERT,UNIMO,VILLA和 VIVO:通过优化训练策略来提升模型性能

B2T2:针对视觉常识推理任务设定的预训练模型

VL-T5:提出了一个为视觉和语言学习不同任务的统一框架,使用相同的语言建模目标来学习不同任务

达摩院:大规模中文多模态预训练数据集和模型

总结

总体而言,图像-文本多模态预训练模型的泛化性能要优于前面几类方法. 由于训练任务以及数据的多样性,它们对于各个模态的语义理解也更加充分。 但是,这些模型往往复杂度和训练成本颇高。

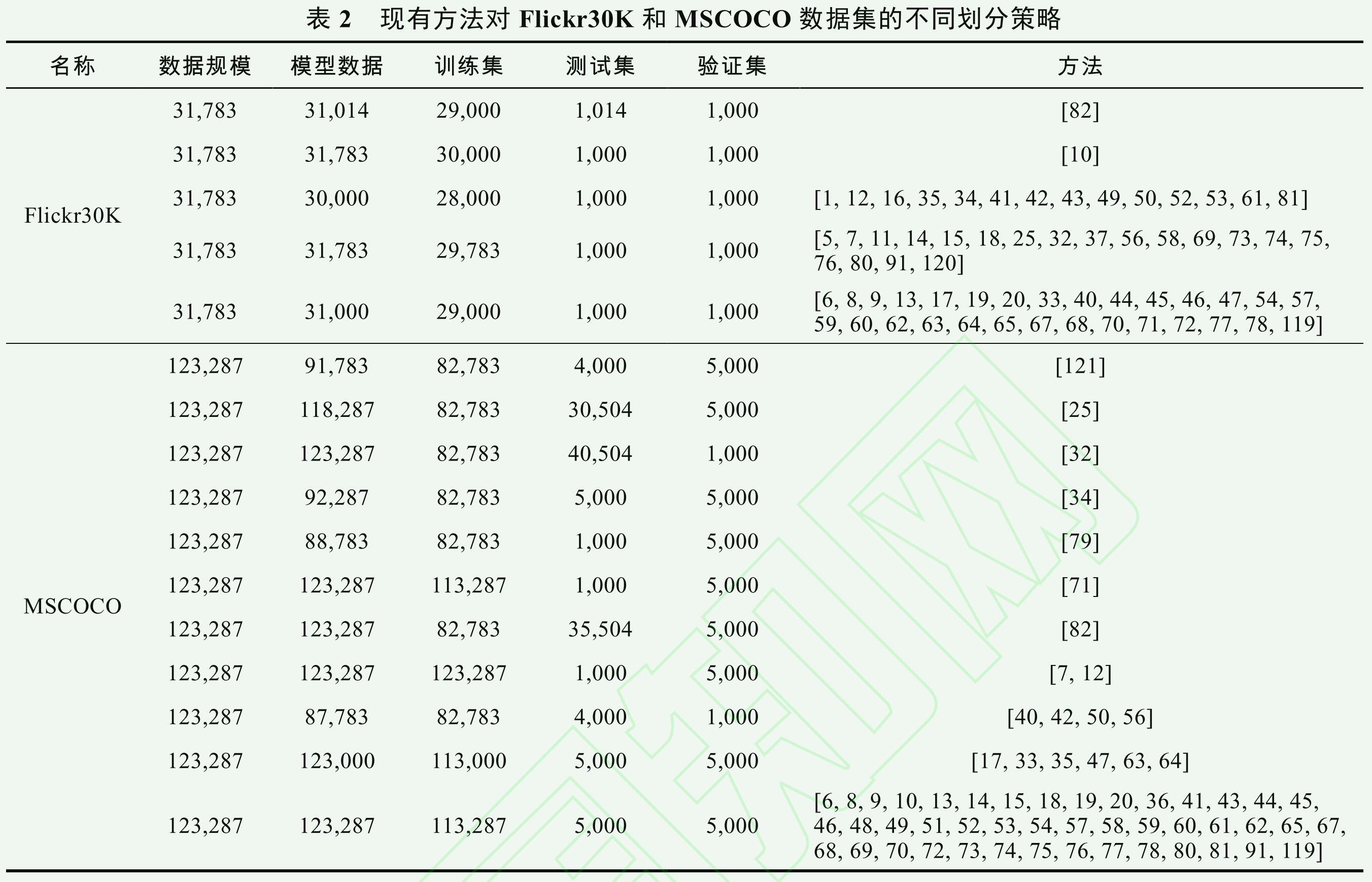

数据集和评价标准

数据集

- CUHK-PEDES 数据集:带有文本语句标注的行人数据集,40,206张图像和80,412个文本语句。多用于行人-文本检索任务

- Flickr8K 数据集:由8,092 张图片组成的众包数据集,单图片有 5 个对应的人类生成的文本语句描述

- Flickr30K 数据集:Flickr8K数据集的扩展,共包含 31,783 张图像. 与 Flickr8K一样,单张图片被 5 个文本句子所标注。和 Flickr8K两个数据集的数据来源相同,仅在数据规模方面不同,现有方法普遍采用数据量更大的 Flickr30K 数据集进行实验。

- MSCOCO 数据集:起初是为图像目标识别、目标检测和标题生成任务而创建,目前也经常用于图像-文本匹配任务. 它由 123,287张图像组成,并且单张图像标注 5 个文本句子.

- MUGE 数据集:达摩院智能计算实验室认知智能团队推出了大规模中文多模态评测基准牧歌(Multimodal Understanding and Generation Evalua-tion,MUGE),它是业界首个大规模中文多模态评测基准,包括图文描述、基于文本的图像生成、跨模态检索等. 同时,其构建了中文多模态预训练数据集,包含超过 1.9TB 图像和 292GB 文本

- Wukong 数据集:一个大型中文跨模态数据集,包含了 1 亿个来自互联网的中文图像-文本对

总结来说,目前在图像-文本匹配研究方向,大家常用数据集 Flickr30K 和MSCOCO 进行性能评估。但是,现有图像-文本匹配方法在利用上述两个数据集进行性能评估时,对于该数据集的训练集、验证集和测试集的划分策略不尽相同。注意,对于 MSCOCO 而言,若测试集包含 5,000 张图像,一般设置两种测试方式:

- MSCOCO1K,即将5000张图像划分为5部分,分别包含1000张图像,最终测试结果为在5个测试集结果的平均值。

- MSCOCO5K,直接对5000张图像进行测试

评价指标

对于图像-文本匹配任务,通常采用Recall@K(R@K)作为评估指标,即正确结果排在前 K 个检索结果的查询比例,这里 K 的取值一般为 1、5、以及 10。除上述指标外,也有些方法采用 RSUM 作为评估指标,即将图像-文本检索和文本-图像检索两个方向的结果累加,即

[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-PkLl5xJ0-1689088211232)(https://cdn.nlark.com/yuque/__latex/3f4456907025dfe0ded34498770b0195.svg)]

现有方法性能分析

基于全局特征图像-文本匹配方法

在Flickr30K以及MSCOCO数据集上的实验结果

嵌入架构

- 双向铰链损失函数模型的性能一定程度上要优于基于单向铰链损失函数的模型,同时也表明LSTM提取的全局文本特征比Skip-Gram提取到的文本特征中蕴含更丰富的信息

- 保持各个模态内域嵌入的相似性十分重要

- 难分样本挖掘对于提升匹配性能而言十分必要

- 引入对抗损失对于促进跨模态匹配有一定效果

- 将生成过程融入到嵌入学习中,可以增强视觉与文本的语义对齐

交互架构

- 精细化设计的融合模块比直接的非线性拼接更能捕获两个模态间交互信息,促进跨模态语义对齐

- 再一次证明,损失函数中集成难分样本挖掘的有效性

总结

两个数据集上,基于交互架构的匹配方法MTFN取得了最好的实验结果。这表明相较于直接进行嵌入表示学习,建模模态间的交互信息可能会对跨模态语义匹配起到一定促进作用。

基于局部特征图像-文本匹配方法

基于模态内

无论**显式(关系依赖)还是隐式(图网络)**地对实体间关系进行充分建模,都有利于文本语义的理解。

对关注视觉内实体关系建模的方法中,DSRAN取得最佳的实验结果,进一步表明图网络在建模实体间关系方面的强大能力。

兼顾两种模态内实体关系建模方法中,DASPGA性能表现最理想,且整体结果也优于DSRAN和LIWE,这与我们认知是一致的,即同时提升视觉和文本表示比仅提升其中之一性能要好。同时,再一次反映出图注意力网络在实体关系建模方面的有效性。

基于模态间

UARAD在MSCOCO1K和MSCOCO5K上取得最优的实验结果,而 ADAPT 在 Flickr30K 上取得最好的结果。这表明固定的模态交互建模策略并不适用于全部数据,而自适应的交互策略选择对于跨模态语义对齐更加有效。

SAN在MSCOCO1K上取得最优性能,可能要归功于其采用了显著性检测算法得到了更加精准的关注局部视觉区域

总结

基于局部特征匹配方法性能要优于基于全局特征匹配方法。很容易理解,因为细粒度的跨模态语义对齐精准度要高于粗粒度的语义对齐。此外,并不存在一种现有方法在三个数据集上一致取得最优结果。这表明现有方法泛化性能较弱,需要探究普适性更广的新交互模式。

多模态预训练模型

预训练模型在所有数据集上性能均优于基于全局或者局部特征的图像-文本匹配方法。主要归因于这些方法在大规模数据上被训练,所以可以更好地表征图像以及文本内容,有效削减跨模态语义鸿沟。

未来研究方向

公开数据集划分

FLickr30K数据集共存在5种训练集、验证集、测试集的划分方式,而对于MSCOCO而言存在11种划分方式。总的来说,现有方法的实验设置不一致,这导致实验结果的可对比性减弱。换而言之,我们无法确定当下方法的实验效果增益,究竟是来自模型自身,还是数据集划分方式不一致所带来的。由此可见,对于图像-文本匹配任务而言,为现有公开数据集提供一种统一的切分方式,以更加公平地进行实验比较,是一个未来亟待解决的问题。

模态内语义信息建模

现有工作多利用注意力机制和图网络等技术,来挖掘各个模态内语义信息。这些技术在文本检索图像部分的性能远低于其在图像检索文本部分的结果。虽然基于外部知识的匹配方法在文本检索图像任务上性能有所提升,但较为依赖场景图提取技术。所以构建更为灵活的知识驱动的图像-文本匹配方法,如将知识图谱等结构化知识诸如模型中,也是一个值得探索的方向。

此外,预训练模型使用数据集与图像文本匹配任务数据集之间存在数据域差距,可能会导致预训练模型迁移时性能下降。增大预训练模型数据域分布,在一定程度上可以缓解该问题,但会增加训练成本。因此,如何提升多模态预训练数据集多样性,以更好适应图像文本匹配任务也是一个可以探究的方向、

跨模态关联语义建模

现有图像-文本匹配方法多采用静态模型架构进行跨模态语义对齐,使得不能最优地处理所有类型数据,导致在不同数据集上呈现的性能不一致。目前动态神经网络在CV领域的成功应用,如何依据输入图像/文本语义信息的复杂程度,让模型自适应地选择合适的语义对齐方式,以进一步提升跨模态匹配性能,也是一个值得研究的问题。

如何更巧妙设计预训练任务使得模型建立词语与物体对象之间的相关性也很重要。

可解释性与效率

尤其是对于多模态预训练模型而言,提升效率以满足各种现实场景的应用需求(比如部署资源受限的设备)是一件十分必要且重要的事情。

文章概述了基于深度学习的图像-文本匹配方法,包括文本编码器、视觉编码器、跨模态匹配的策略,以及损失函数在模型训练中的作用。当前方法面临模态内语义理解和建模、跨模态语义对齐的挑战,多模态预训练模型展现出了较好的泛化性能,但复杂度和训练成本高。未来研究方向聚焦于数据集划分标准化、模态内语义信息建模、跨模态关联语义建模及模型的效率和可解释性。

文章概述了基于深度学习的图像-文本匹配方法,包括文本编码器、视觉编码器、跨模态匹配的策略,以及损失函数在模型训练中的作用。当前方法面临模态内语义理解和建模、跨模态语义对齐的挑战,多模态预训练模型展现出了较好的泛化性能,但复杂度和训练成本高。未来研究方向聚焦于数据集划分标准化、模态内语义信息建模、跨模态关联语义建模及模型的效率和可解释性。

32万+

32万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?