随着大数据行业的发展,大数据生态圈中相关的技术也在一直迭代进步,希望能通过本文帮助大家快速构建大数据生态圈的完整知识体系。

Apache Hive是一个用于数据查询和分析的数据仓库工具。Hive构建在Hadoop之上,并提供了一种类似SQL的查询语言,被称为HiveQL(Hive Query Language),用于处理和分析大规模数据。

Hive的主要功能包括:

-

SQL-Like查询:HiveQL允许用户使用SQL语法来查询和分析数据,使得用户可以利用熟悉的SQL技能来处理大规模的分布式数据。

-

数据仓库:Hive可以用作数据仓库,允许用户将结构化和半结构化数据存储在Hadoop分布式文件系统(HDFS)上,并执行高性能查询。

-

ETL(抽取、转换、加载):Hive可以用来执行ETL操作,将原始数据从不同源头抽取到HDFS,然后进行转换和加载到Hive表中。

-

数据分区和桶:Hive支持数据分区和桶,这有助于提高查询性能和数据组织。

-

用户定义函数(UDF):用户可以编写自定义函数以扩展Hive的功能,允许执行复杂的数据处理任务。

-

集成:Hive可以集成到其他Hadoop生态系统工具中,如HBase、Spark等,以支持更广泛的数据处理需求。

SparkR 是 Apache Spark 生态系统中的一个项目,它提供了一个接口,允许 R 语言用户利用 Spark 的分布式计算能力来进行数据分析和处理。因此,可以说 SparkR 是用来进行数据分析的工具,特别适用于需要处理大规模数据集的数据分析任务。

以下是 SparkR 的一些关键特点和用途:

Spark SQL 不仅用于传统的 SQL 查询,还可以用于复杂的数据处理和分析任务,包括数据清洗、数据转换、数据聚合等。它是用于结构化数据的强大工具,适用于大规模数据处理和分析需求。

-

分布式数据处理:SparkR允许 R 用户在分布式计算框架 Apache Spark 上运行他们的 R 代码。这意味着可以充分利用 Spark 的并行处理能力,处理大规模数据集。

-

支持大数据格式:SparkR 可以读取和处理各种大数据格式,如 Parquet、Avro、JSON 等,以及将结果写回到这些格式中。

-

SQL 查询:SparkR 提供了 SQL 查询的功能,允许用户使用 SQL 语法来查询和分析数据。

-

机器学习:SparkR 可以与 Spark MLlib 集成,以进行大规模机器学习任务。这使得用户可以使用 R 语言进行机器学习模型的开发和训练。

-

图分析:SparkR 也支持图分析,允许用户执行图算法和处理大规模图数据。

-

实时数据流处理:虽然 SparkR 主要用于批处理,但您还可以与 Spark Streaming 集成,以支持实时数据流处理需求。

-

DataFrame API:Spark SQL 引入了 DataFrame API,它是一种以结构化数据表格形式表示数据的 API。用户可以使用DataFrame API执行数据转换和分析操作,这比传统的RDD(弹性分布式数据集)更高级,更易于优化。

-

优化:Spark SQL 还包括查询优化器,可以自动优化查询计划以提高性能。它使用 Tungsten 项目来改进查询的执行效率。

-

集成:Spark SQL 可以与其他 Spark 组件(如Spark Streaming、Spark MLlib等)集成,使用户能够在一个统一的 Spark 应用程序中进行数据处理、实时数据流处理和机器学习。

-

可扩展性:由于它是基于 Apache Spark 构建的,Spark SQL 具有出色的可扩展性,可以处理大规模数据。

Apache Spark SQL 是 Apache Spark 生态系统中的一个模块,用于进行结构化数据查询和处理。它提供了一种 SQL 接口,允许用户执行 SQL 查询来分析和处理数据。因此,Spark SQL 主要用于数据查询和数据分析任务。

-

以下是 Spark SQL 的一些关键特点和用途:

-

SQL 查询:Spark SQL 允许用户使用标准的 SQL 查询语句来查询分布式数据集,包括大规模的数据。

-

数据源集成:Spark SQL 支持多种数据源,包括结构化数据(如Parquet、Avro、JSON、CSV)、关系型数据库、Hive表等。这使得用户可以轻松访问和处理各种数据。

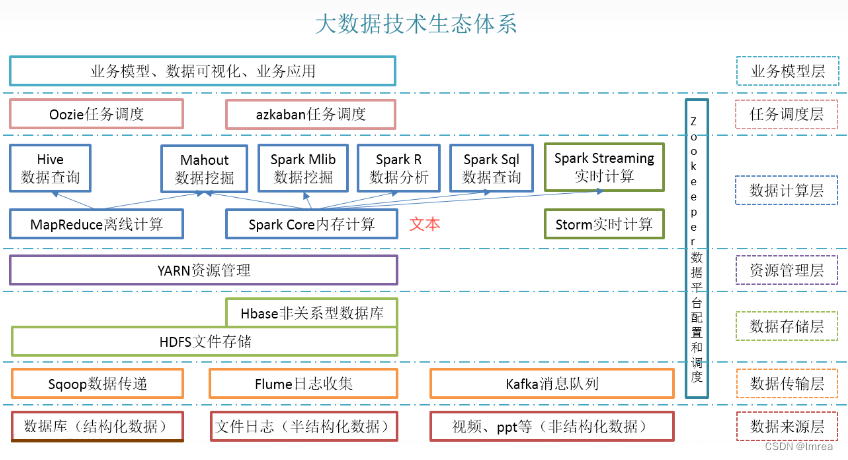

企业如果想从传统的数据处理转型到大数据处理,首先要做就是搭建一个稳定可靠的大数据平台。

一个完整的大数据平台需要包含数据采集、数据存储、数据计算、数据分析、集群监控等功能,这就意味着其中需要包含Flume、Kafka、Haodop、Hive、HBase、Spark、Flink等组件,这些组件需要部署到上百台甚至上千台机器中。

如果依靠运维人员单独安装每一个组件,则工作量比较大,而且需要考虑版本之间的匹配问题及各种冲突问题,并且后期集群维护工作也会给运维人员造成很大的压力。

于是,国外一些厂商就对大数据中的组件进行了封装,提供了一体化的大数据平台,利用它可以快速安装大数据组件。目前业内最常见的是包括CDH、HDP、CDP等。

- HDP:全称是 Hortonworks Data Platform。它由 Hortonworks 公司基于 Apache Hadoop 进行了封装,借助于 Ambari 工具提供界面化安装和管理,并且集成了大数据中的常见组件, 可以提供一站式集群管理。HDP 属于开源版免费大数据平台,没有提供商业化服务;

- CDH:全称是 Cloudera Distribution Including Apache Hadoop。它由 Cloudera 公司基于 Apache Hadoop 进行了商业化,借助于 Cloudera Manager 工具提供界面化安装和管理,并且集成了大数据中的常见组件,可以提供一站式集群管理。CDH 属于商业化收费大 数据平台,默认可以试用 30 天。之后,如果想继续使用高级功能及商业化服务,则需要付费购买授权,如果只使用基础功能,则可以继续免费使用;

- CDP:Cloudera 公司在 2018 年 10 月份收购了 Hortonworks,之后推出了新一代的大数据平台产品 CDP(Cloudera Data Center)。CDP 的版本号延续了之前 CDH 的版本号。从 7.0 版本开始, CDP 支持 Private Cloud(私有云)和 Hybrid Cloud(混合云)。CDP 将 HDP 和 CDH 中比较优秀的组件进行了整合,并且增加了一些新的组件。

三者的关系如图所示:

244

244

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?