Day 8 classification :Probabilistic Generative Model

今天上了一整天的课, 本来实在是更新不动了,但是看到《剑来》更新了,想一想这本书里面一直强调的成功的feature – 心性,嗯心性坚毅就好!主人公陈平安练拳一百万次,我才第八天而已,加油

主要任务

这里老师举了一堆案例,impressive – face reconization 因为之前接单刚搭了个项目 还赚了1k,哈哈

可以用来预测的属性(之后可以找到关键特征 extract features)

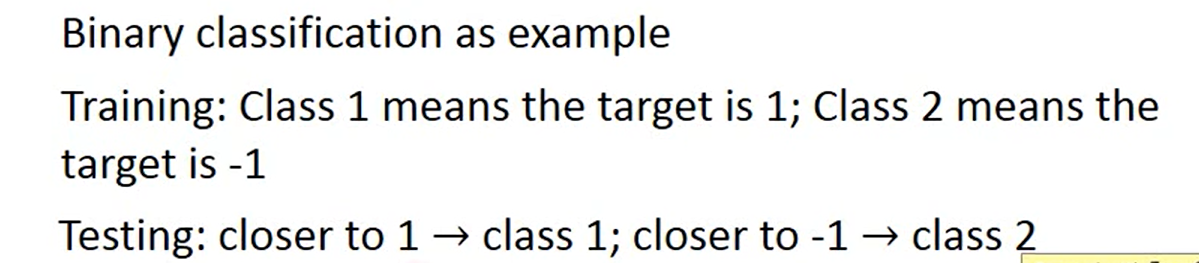

classification as Regression ?

这里还是有必要花一些时间的, 因为我一直以来的想法就是这个样子,也不明是非对错(学的一知半解的)大致思想就是下面

注意一下这里没有提到Loss function

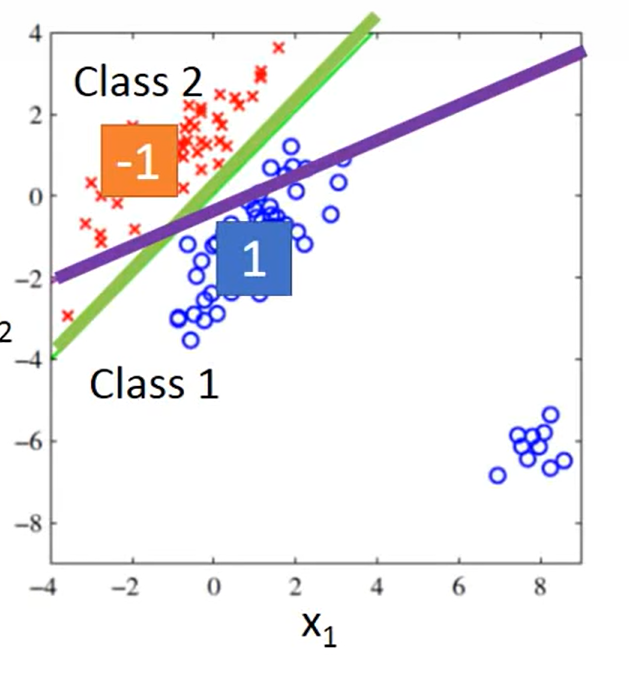

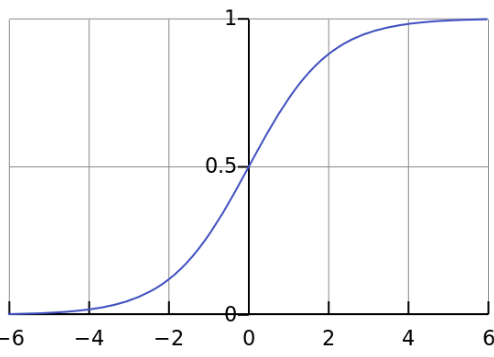

就是说 我让一条直线, 橙色点输入进去小于0(sigmoid 之后接近-1) 蓝色点输进去 大于0(sigmoid后接近+1),最后可以找到绿色的线;loss 的话……我去我不会;

Q:这里的loss function 是什么?

sigmoid(wx +wx+b)-1 和 +1的平方;每一个点输进去哈

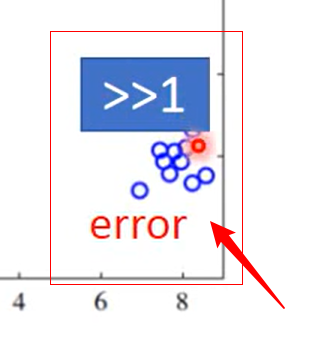

这些点是更加纯正的类,反而被error了,不合理 ,因为我们定义的模型是 越接近1 越是该类; 大于1 的点在我们这个模型里被认为是不应该存在的,超过了我的值域(ps:刚刚小憩了半个小时,真管用哇,本来想不通的东西困得不行还头疼,一下子想清楚啦哈哈)

另一个不合理:

当给类进行 -1 0 1 2 ……编码时候, 会认为 -1 class 和 0 class 离得比较近,实际上可能并没有这种距离关系

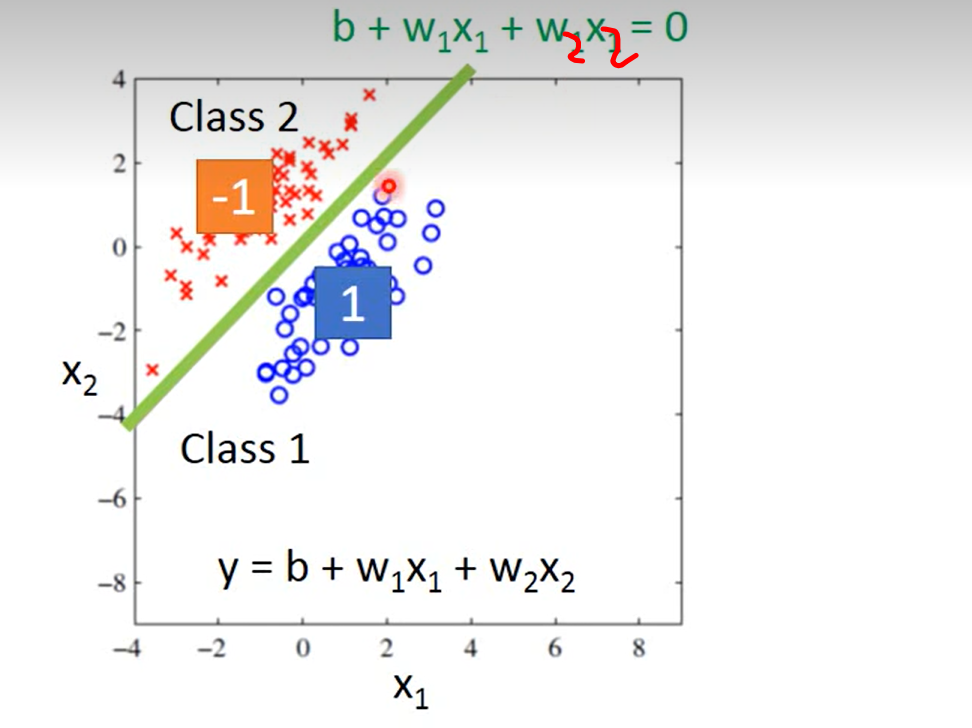

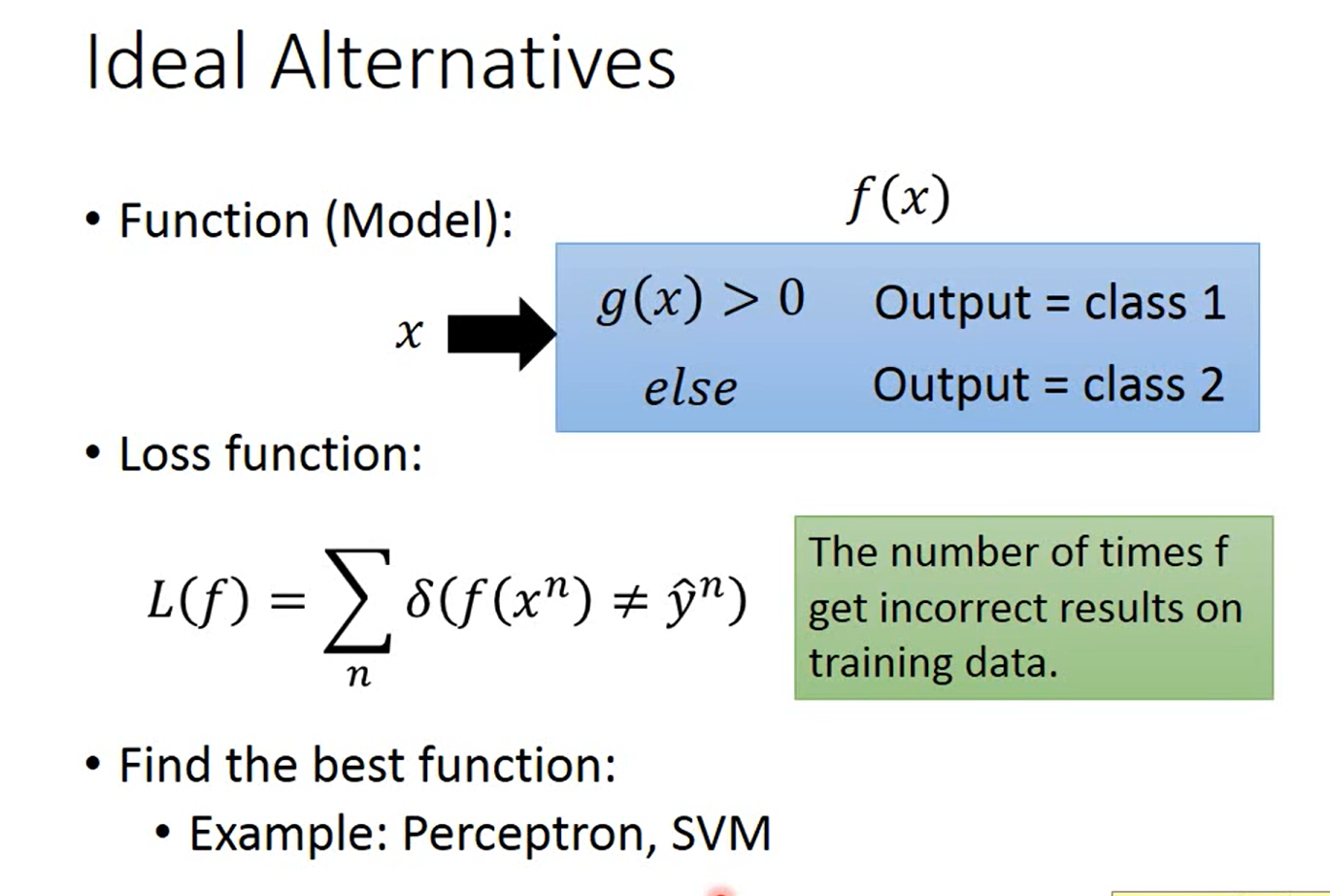

Ideal Alternatives (正确的做法)

这里把simoid去掉没有接近不接近1 的思想;g(x) 是自己学出来的一个function;

这里的loss 无法求梯度;

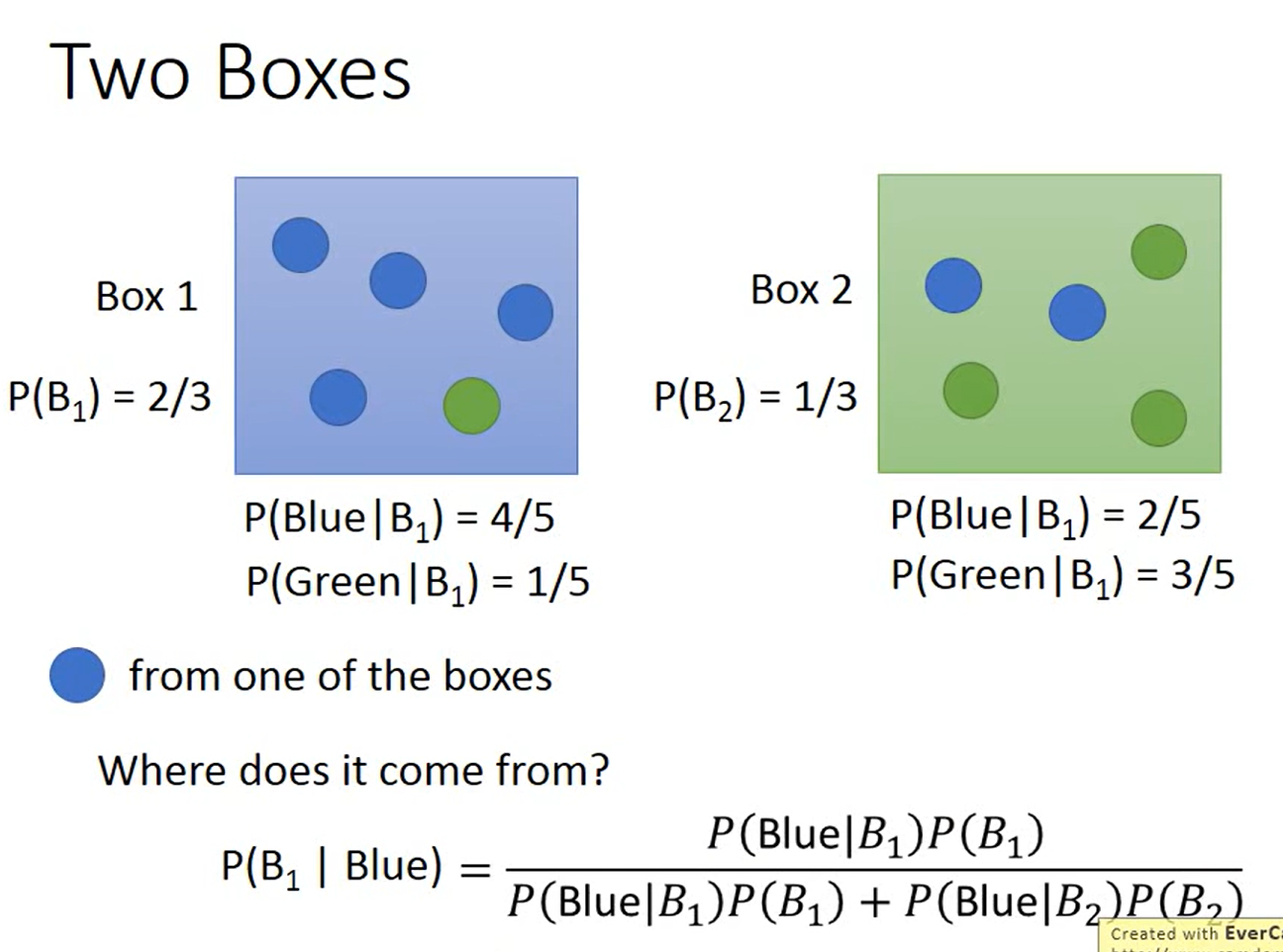

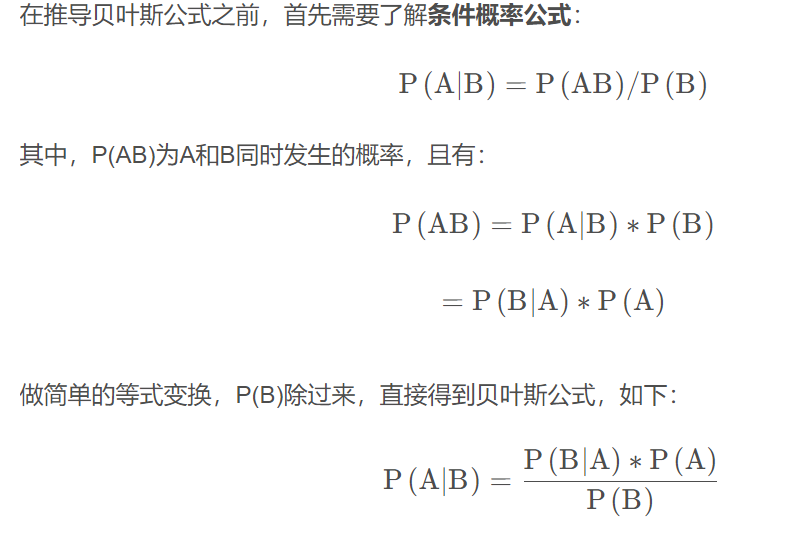

下面介绍贝叶斯

这里放了一个简单的推导:

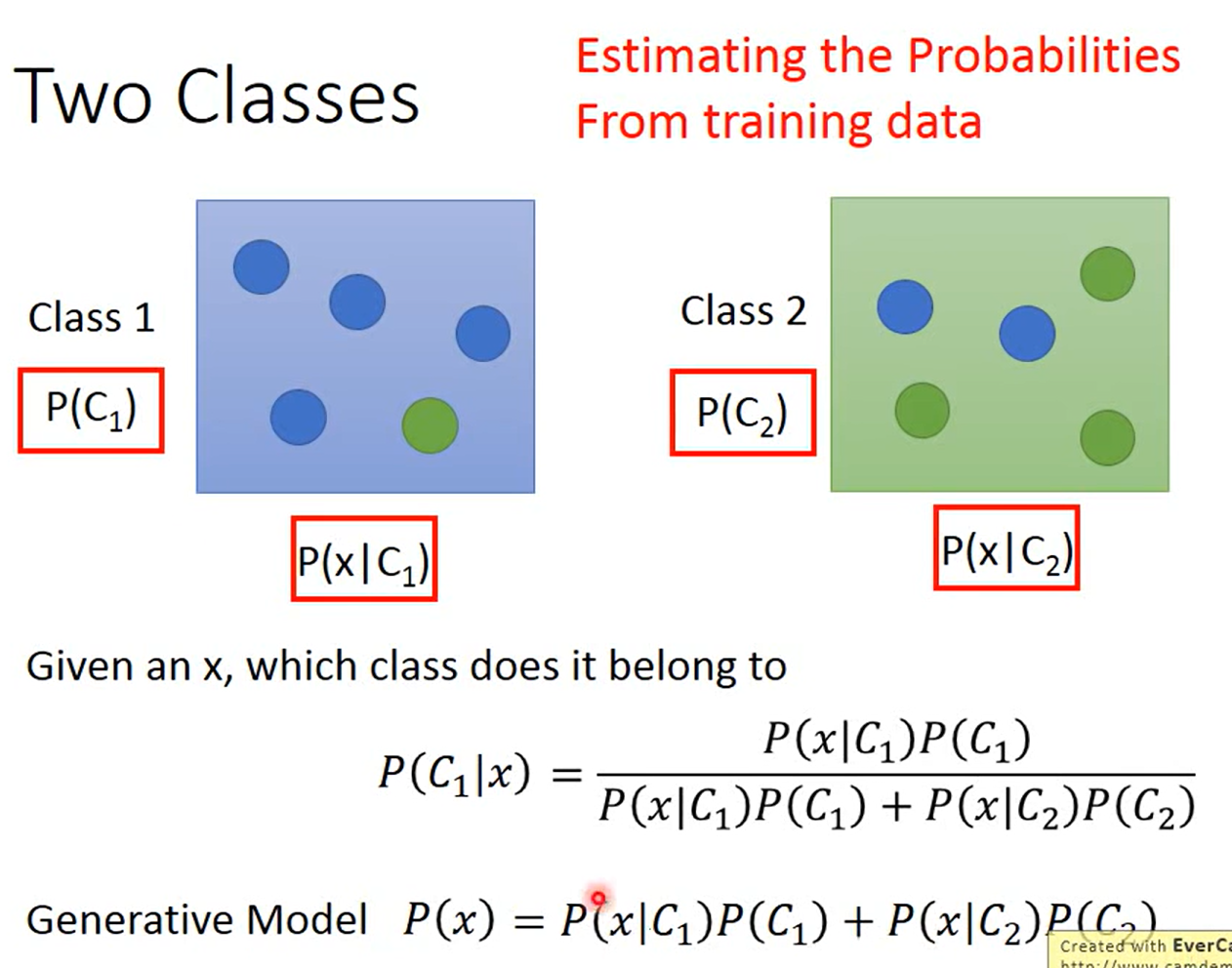

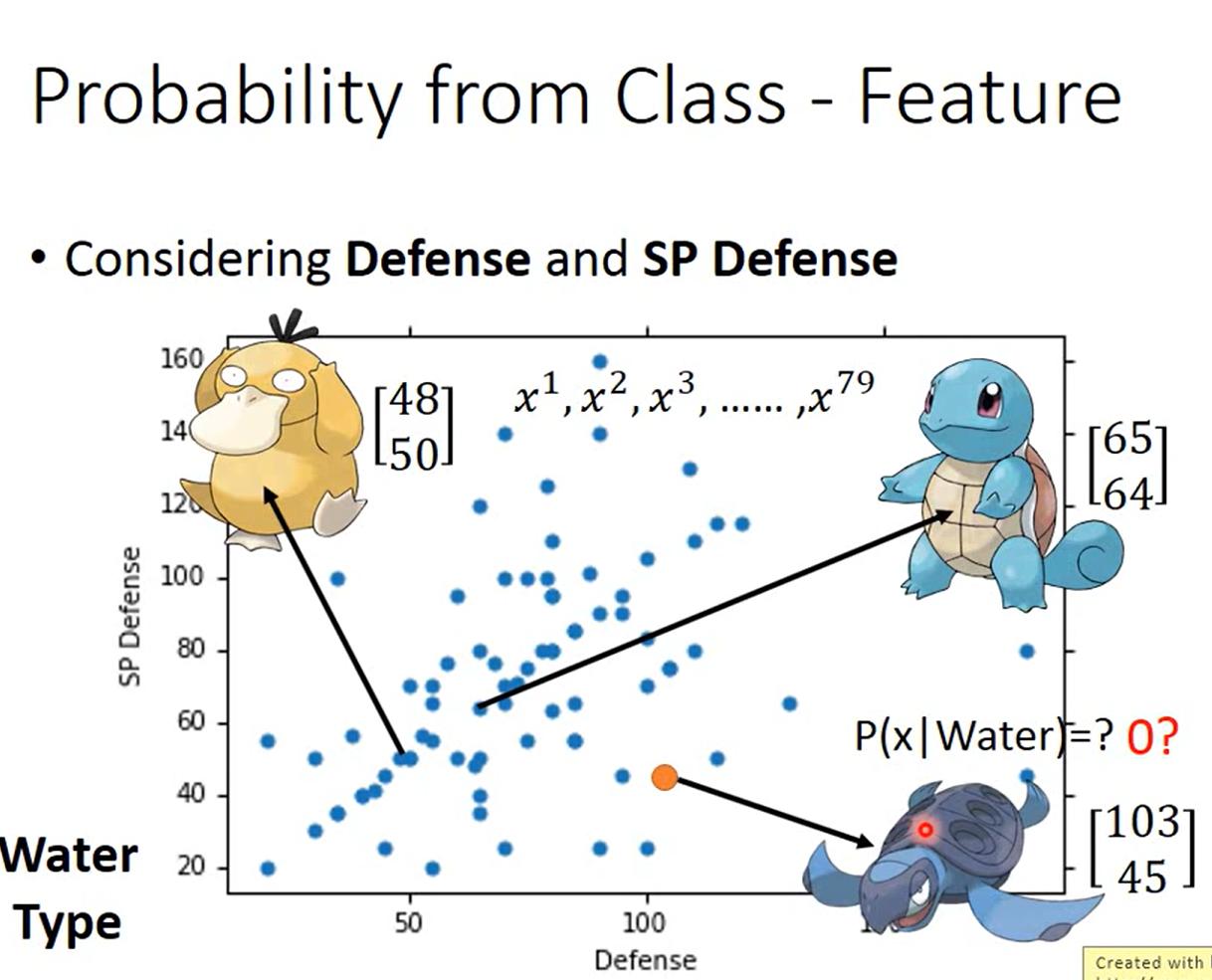

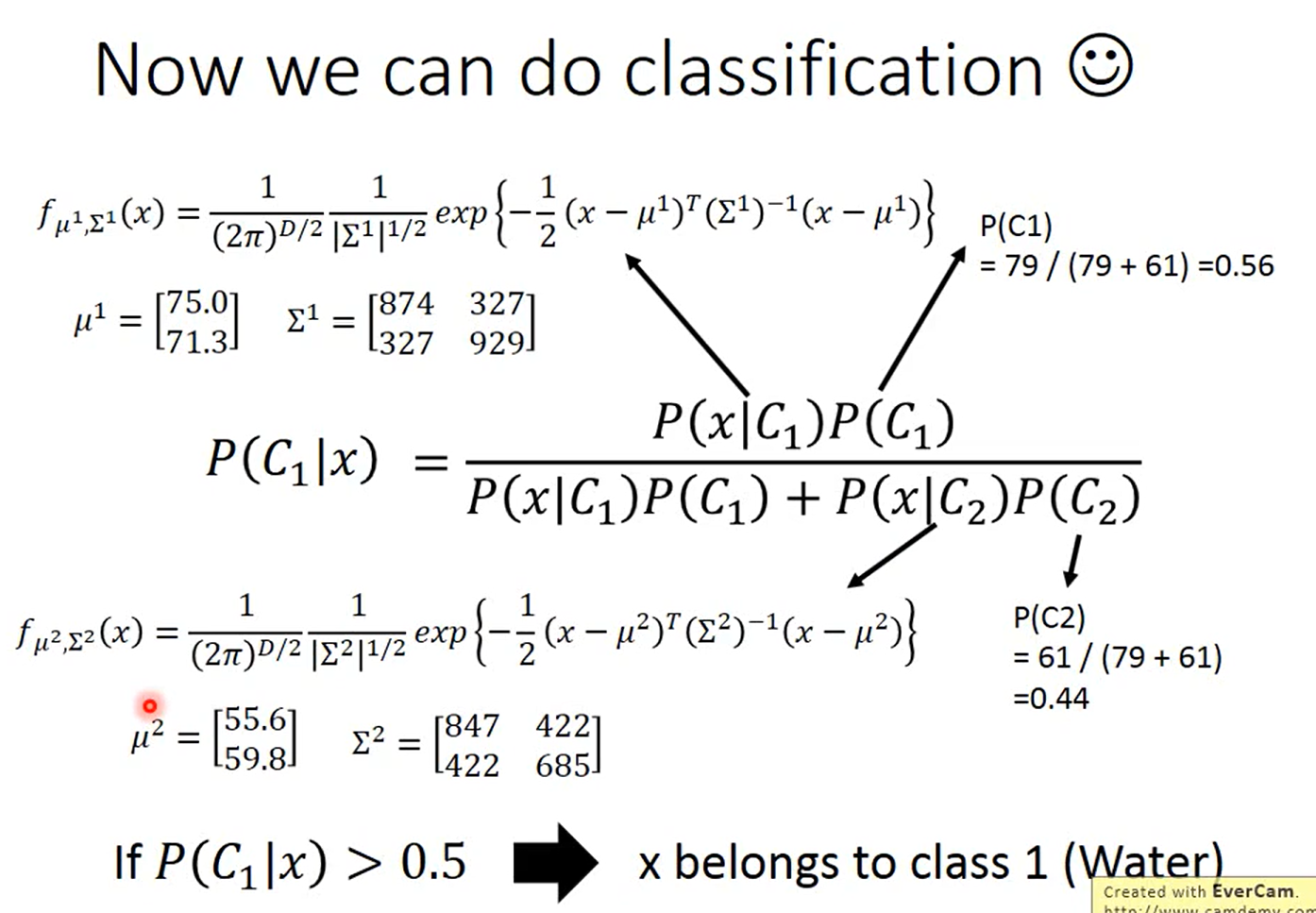

利用x 的抽样分布来估计概率

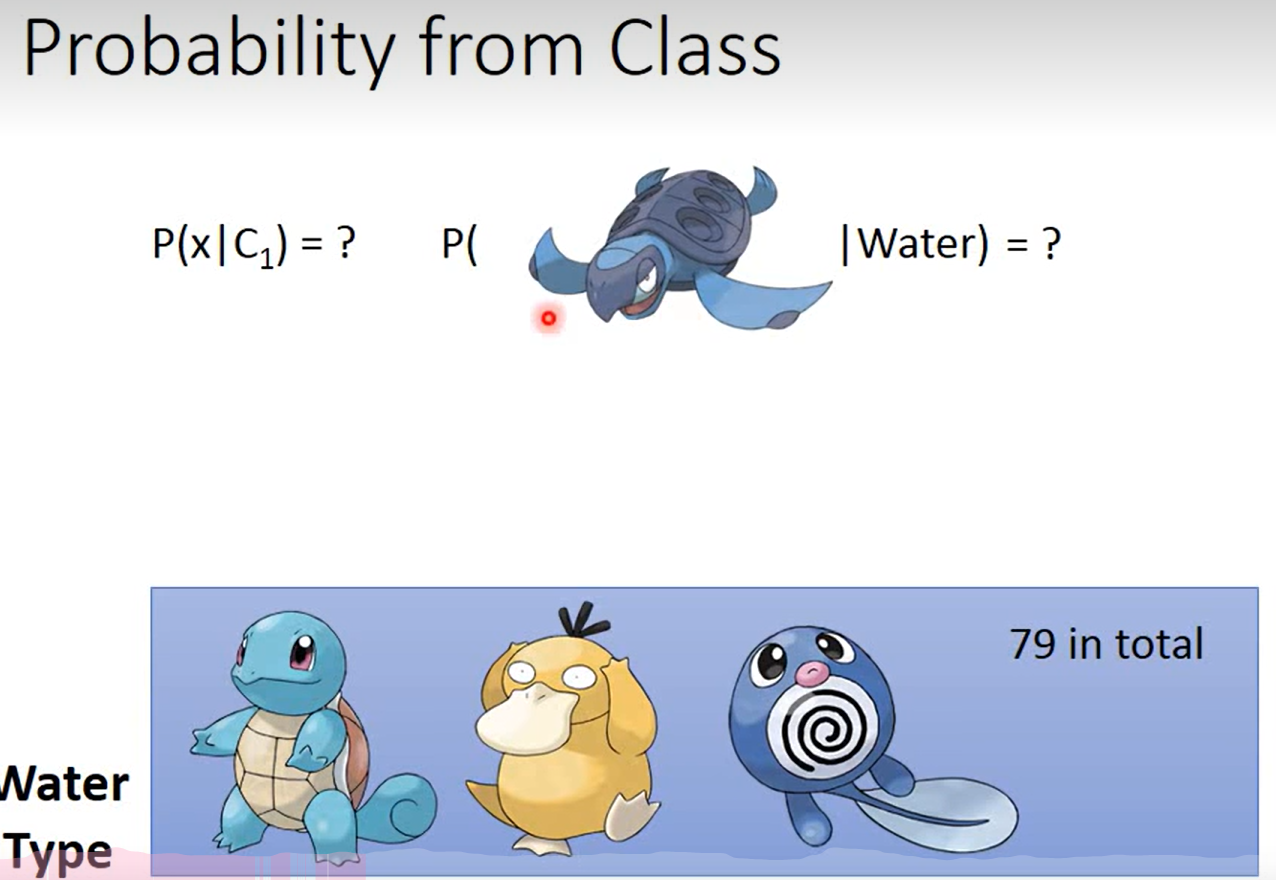

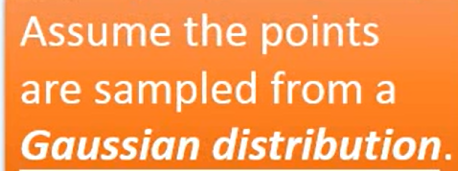

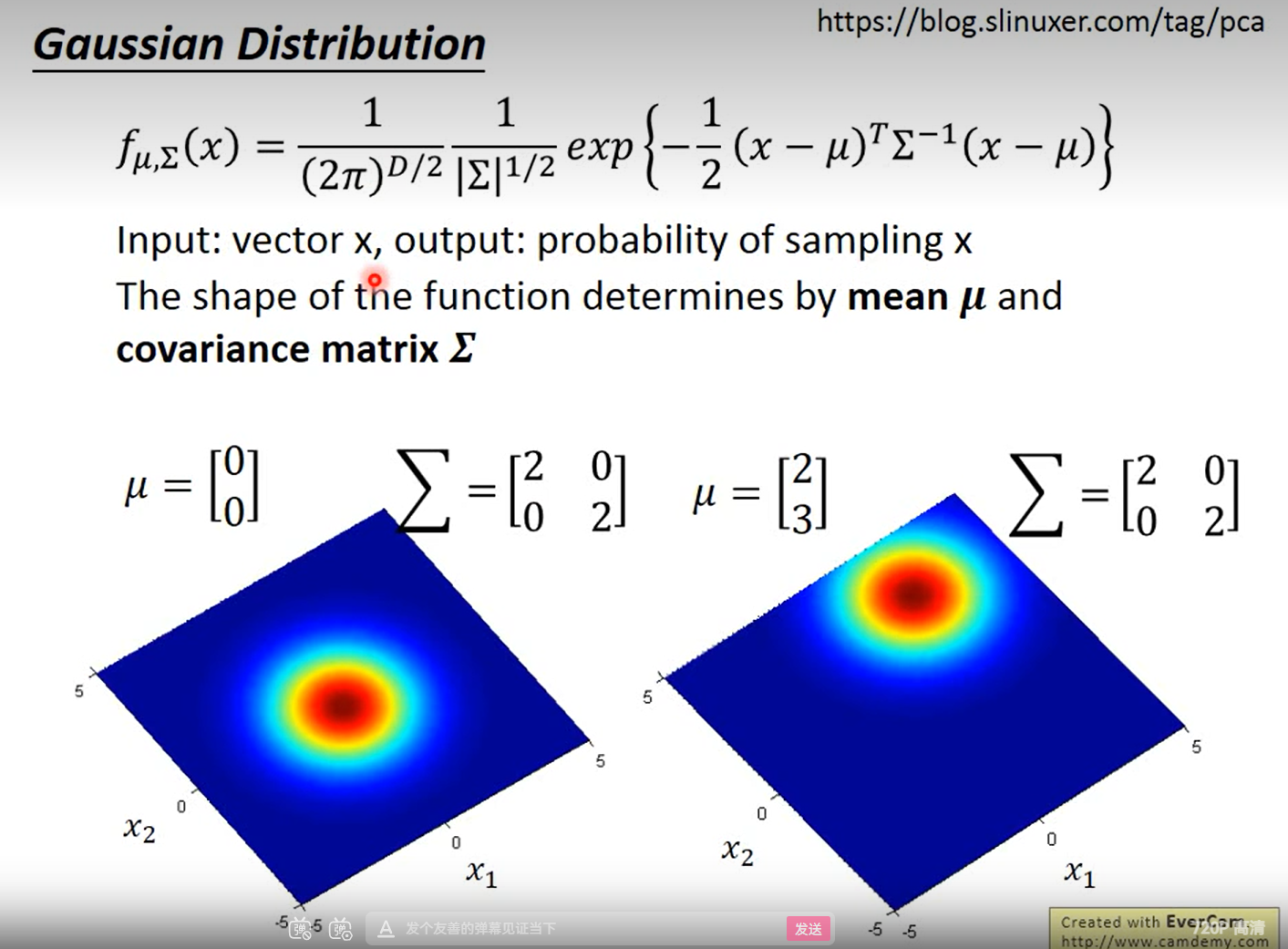

对于 0的不存在的数据,假设它的(x的)分布符合某一个高斯分布,以此来估计概率

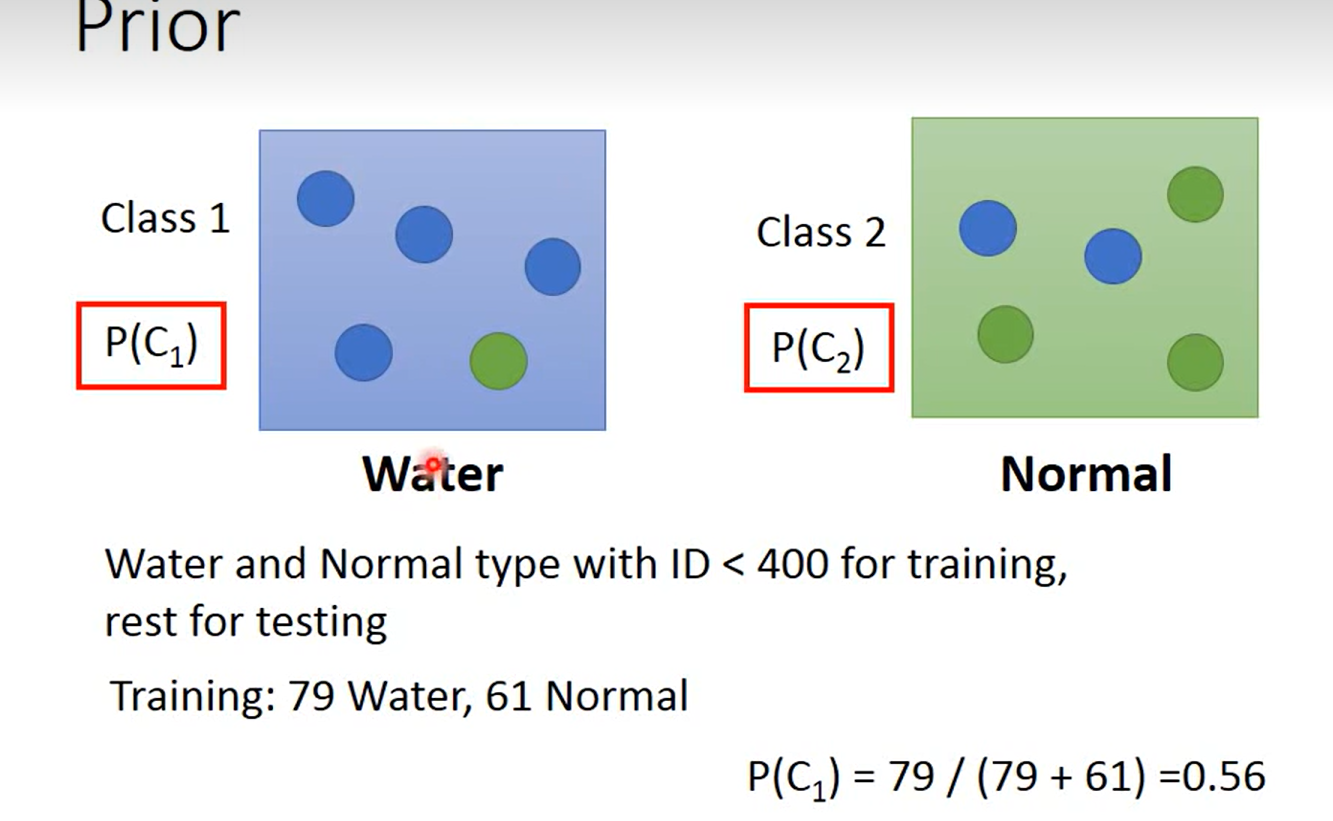

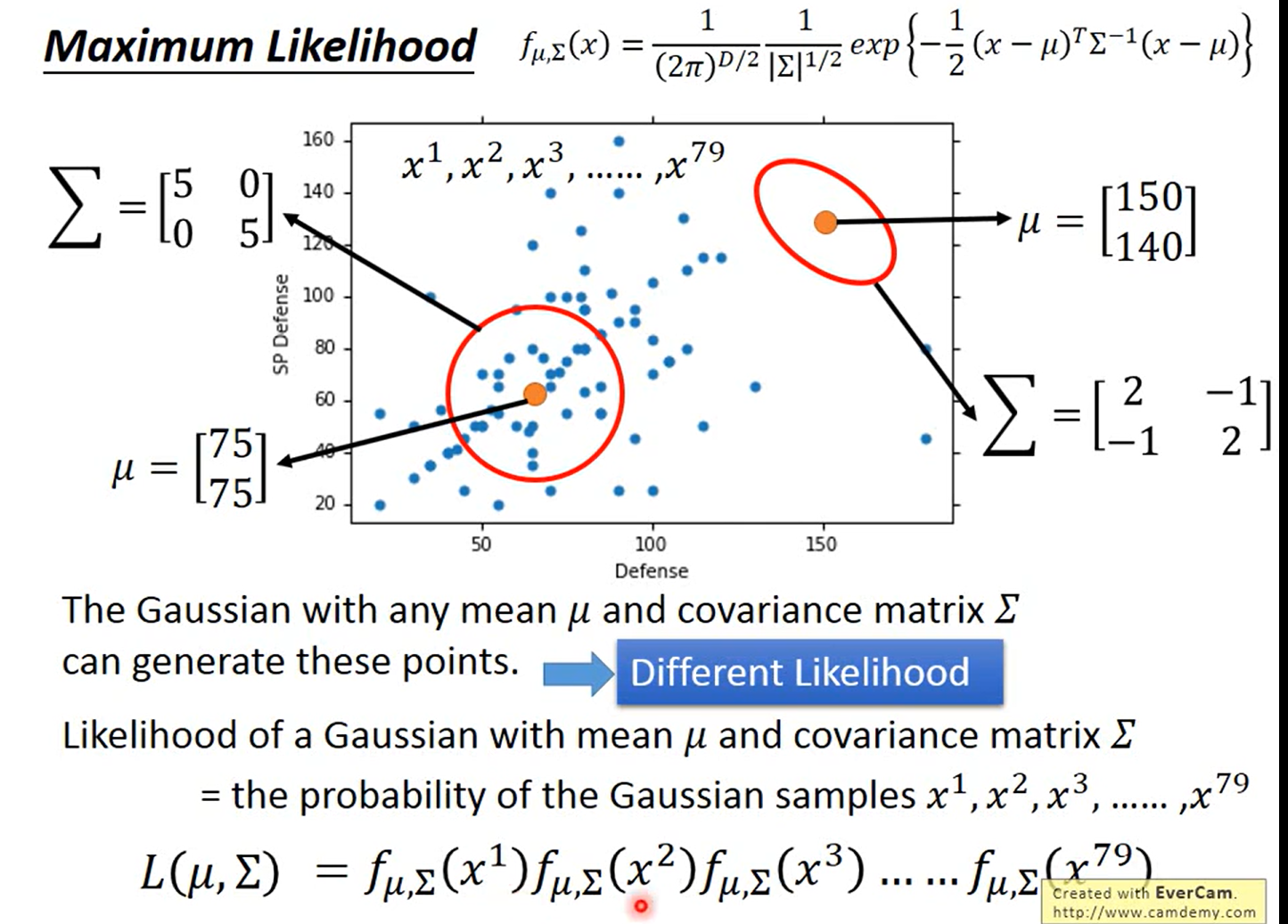

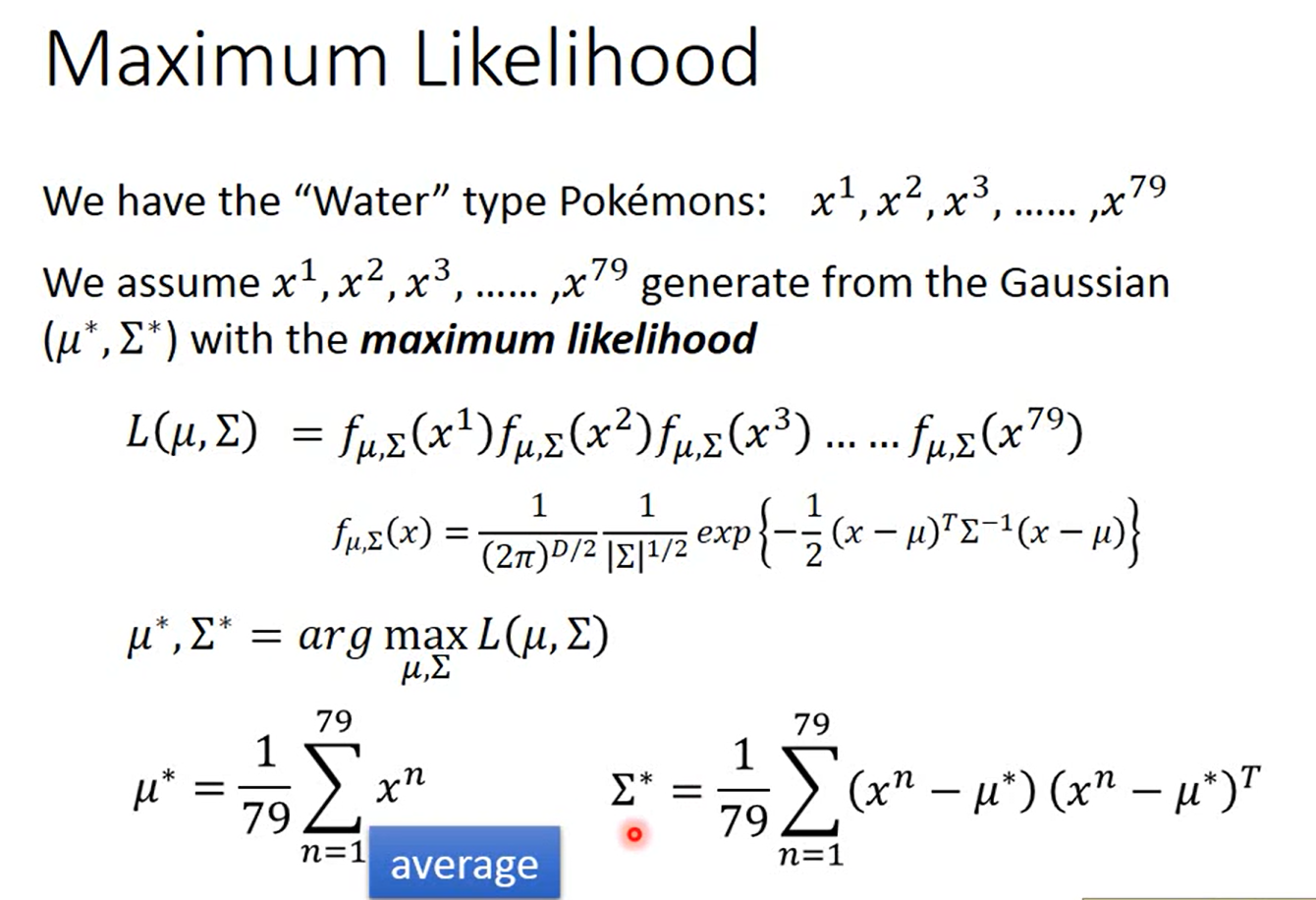

how to find the u and σ \sigma σ 也就是找到概率最大的生成这79个点的高斯分布

MAximum Likelihood (极大似然)

这里应该是用了矩估计;当然了我们也可以进行求导的那种极大似然解法

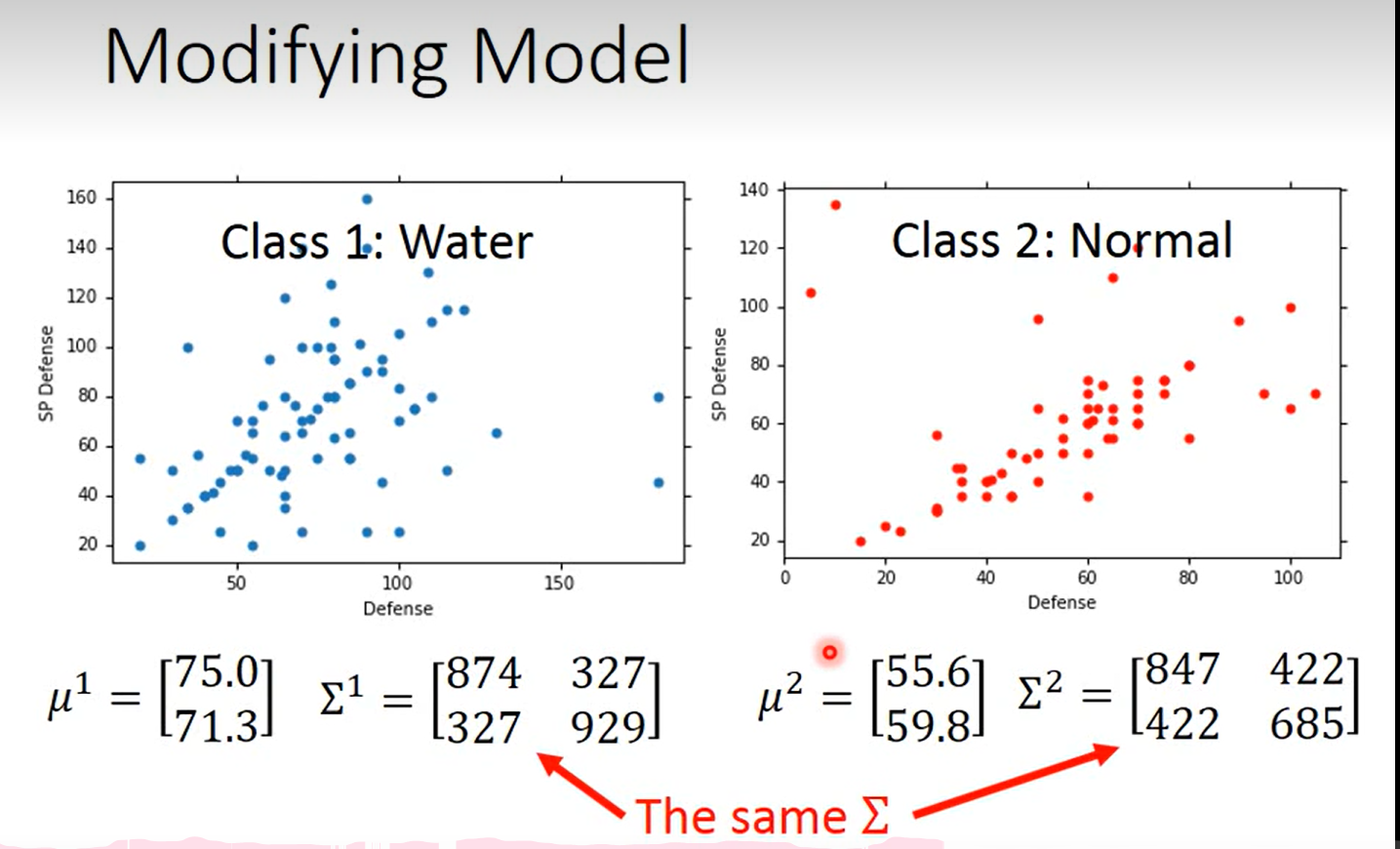

bad Result

how to fix ?

xdm 绷不住了,学到这里的时候图书馆的朗读亭里有小姐姐唱歌了 爱的回归线 哈哈哈哈哈哈哈哈哈哈哈(那个朗读亭隔音不好,很多同学以为那个地方可以隔音),唱的还挺好听的;

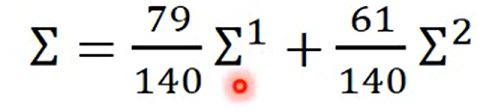

平均数还和原来的算法一样

这里有一点不明白 为什么这样就可以表示它的方差?(加权平均) 为啥不是直接把140个点求一个方差呢?

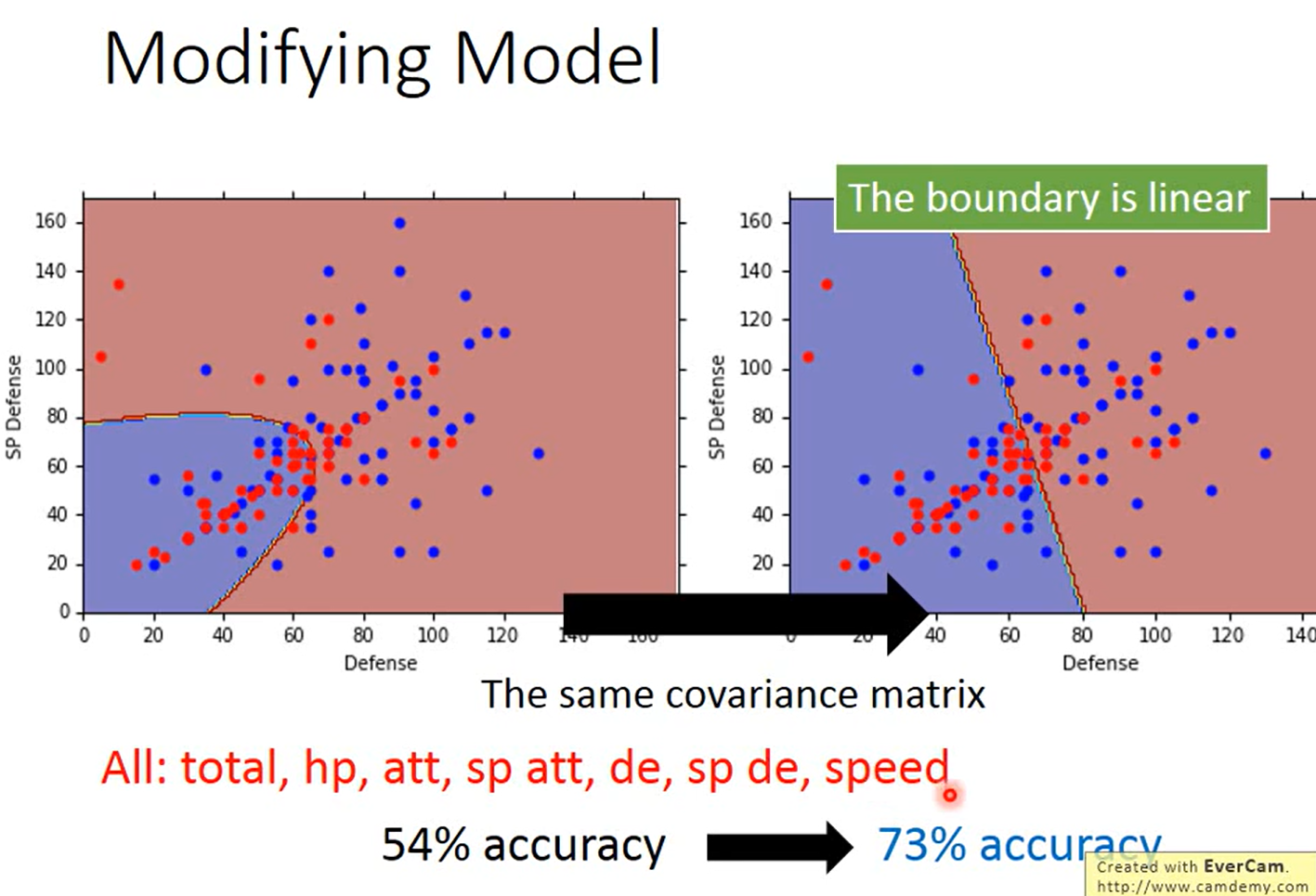

more Result

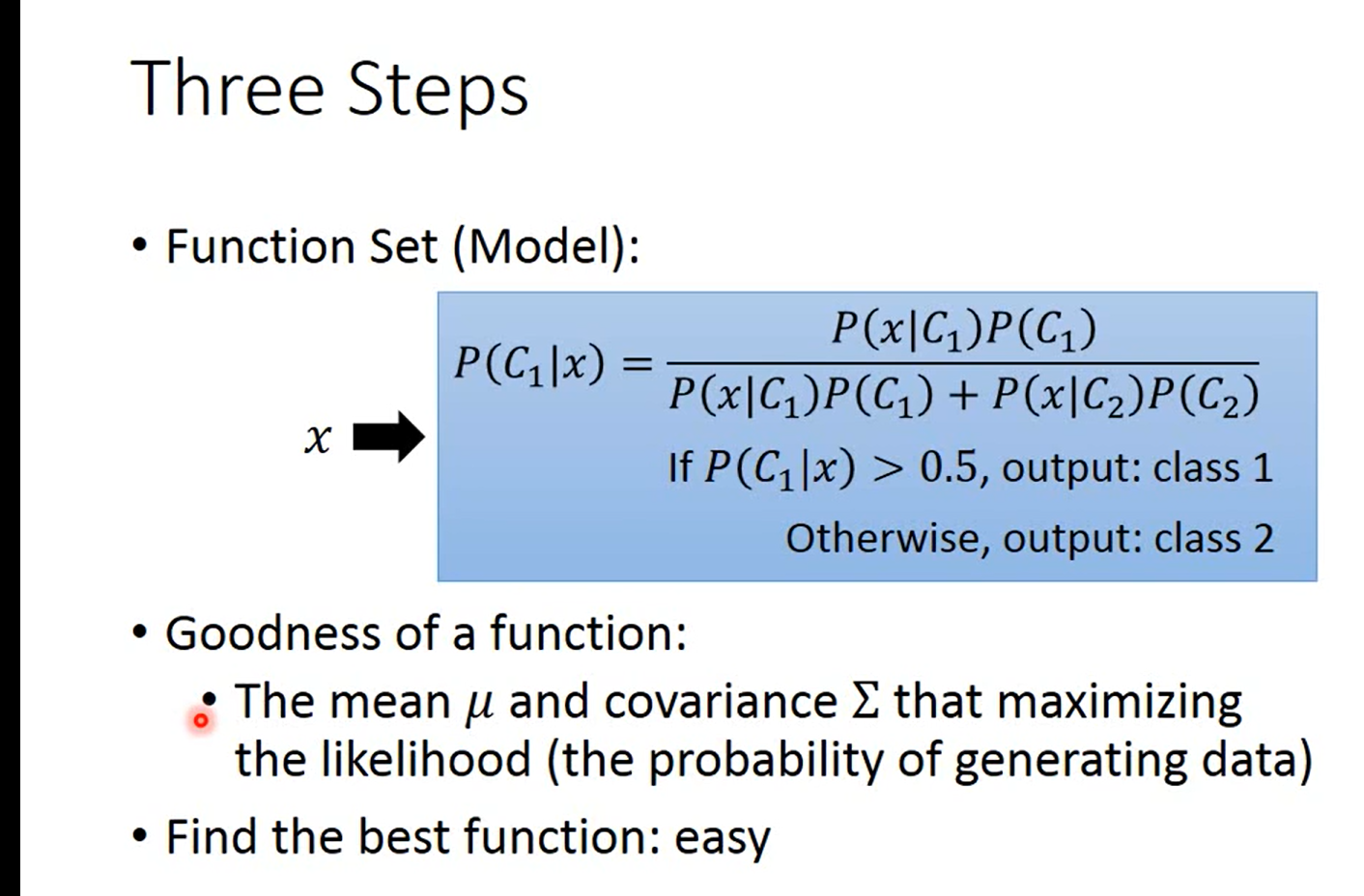

Three Steps 三板斧

other thinking

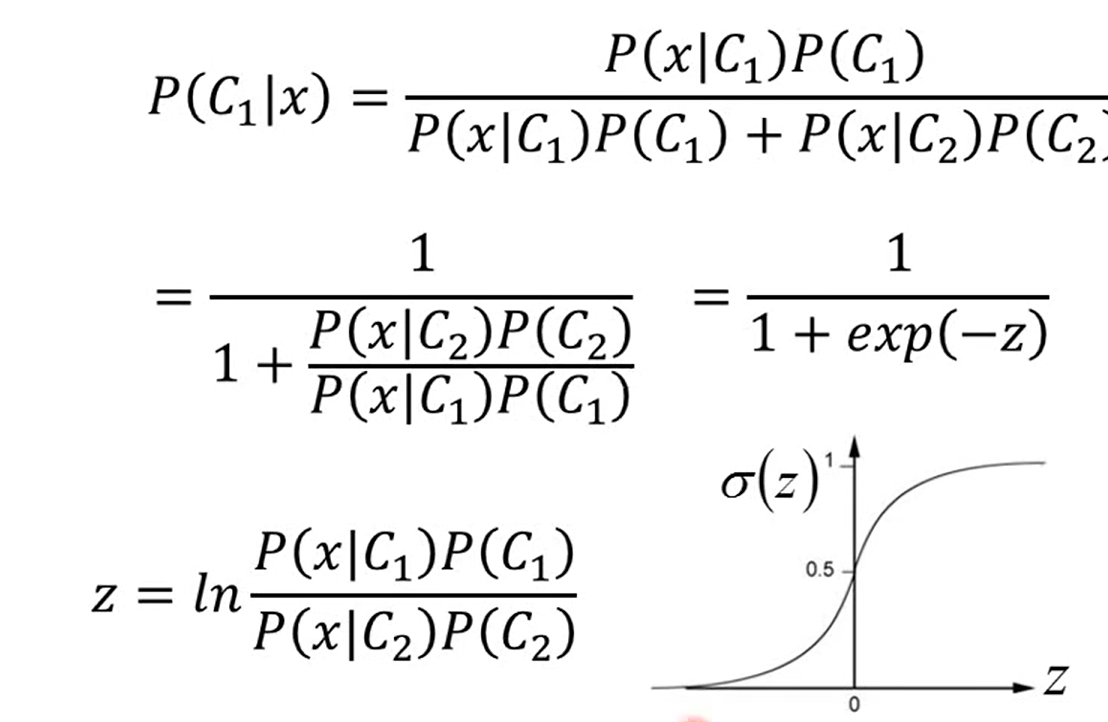

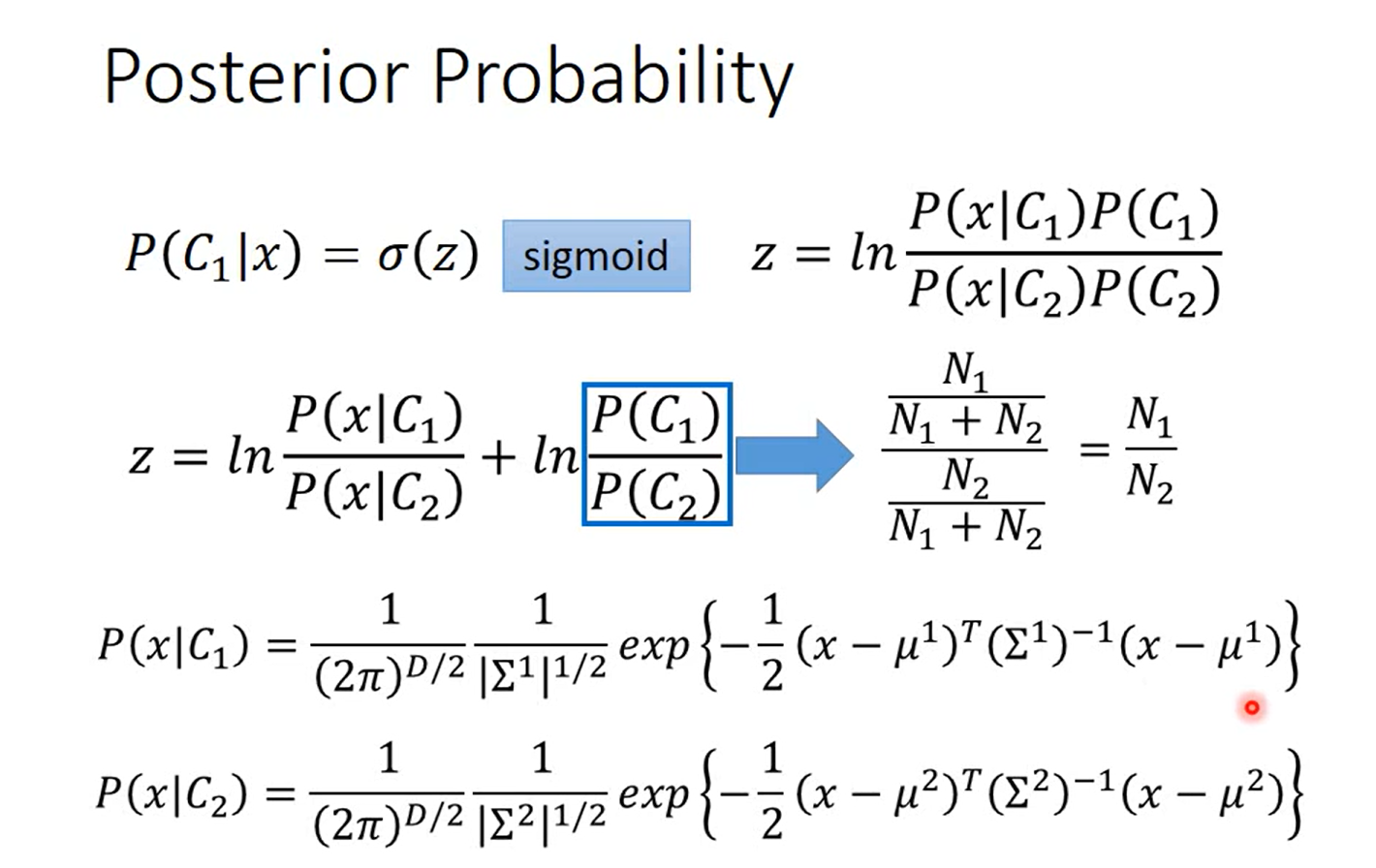

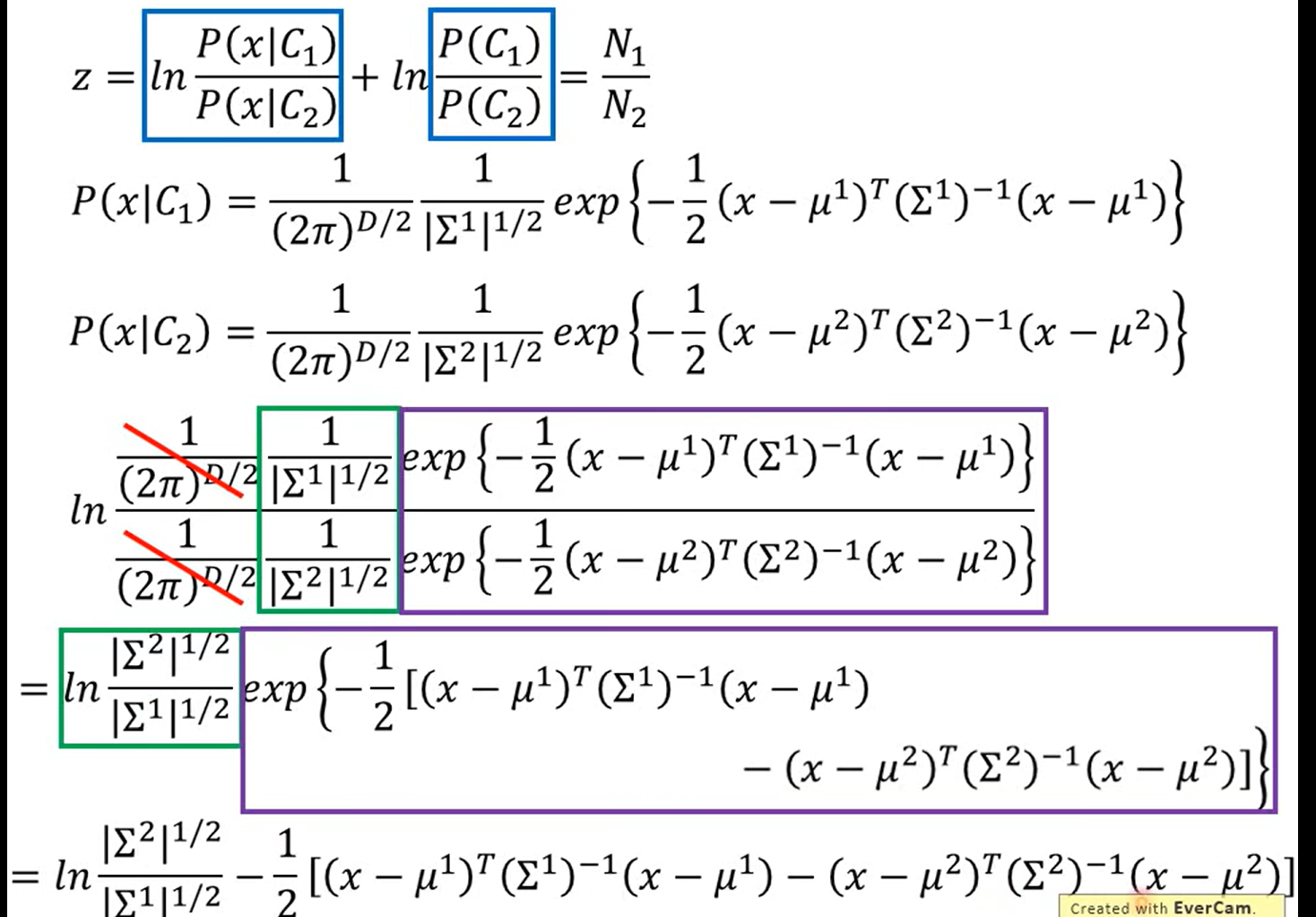

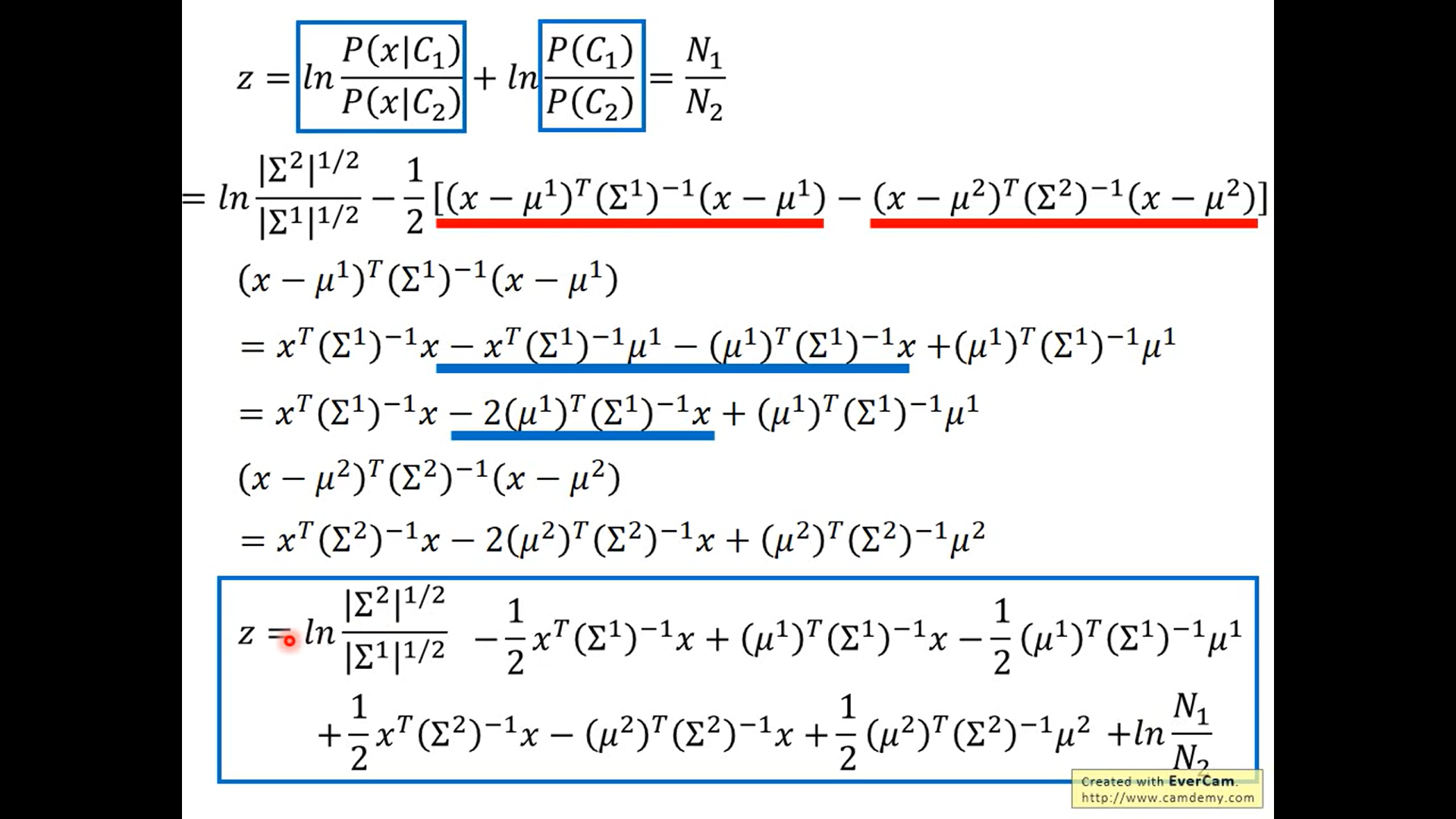

Some math一些数学的推导:

posterior probability 后验概率:考虑了一系列随机观测数据的条件概率。对于一个随机变量来说,量化其不确定性非常重要。其中一个实现方法便是提供其后验概率的置信区间。

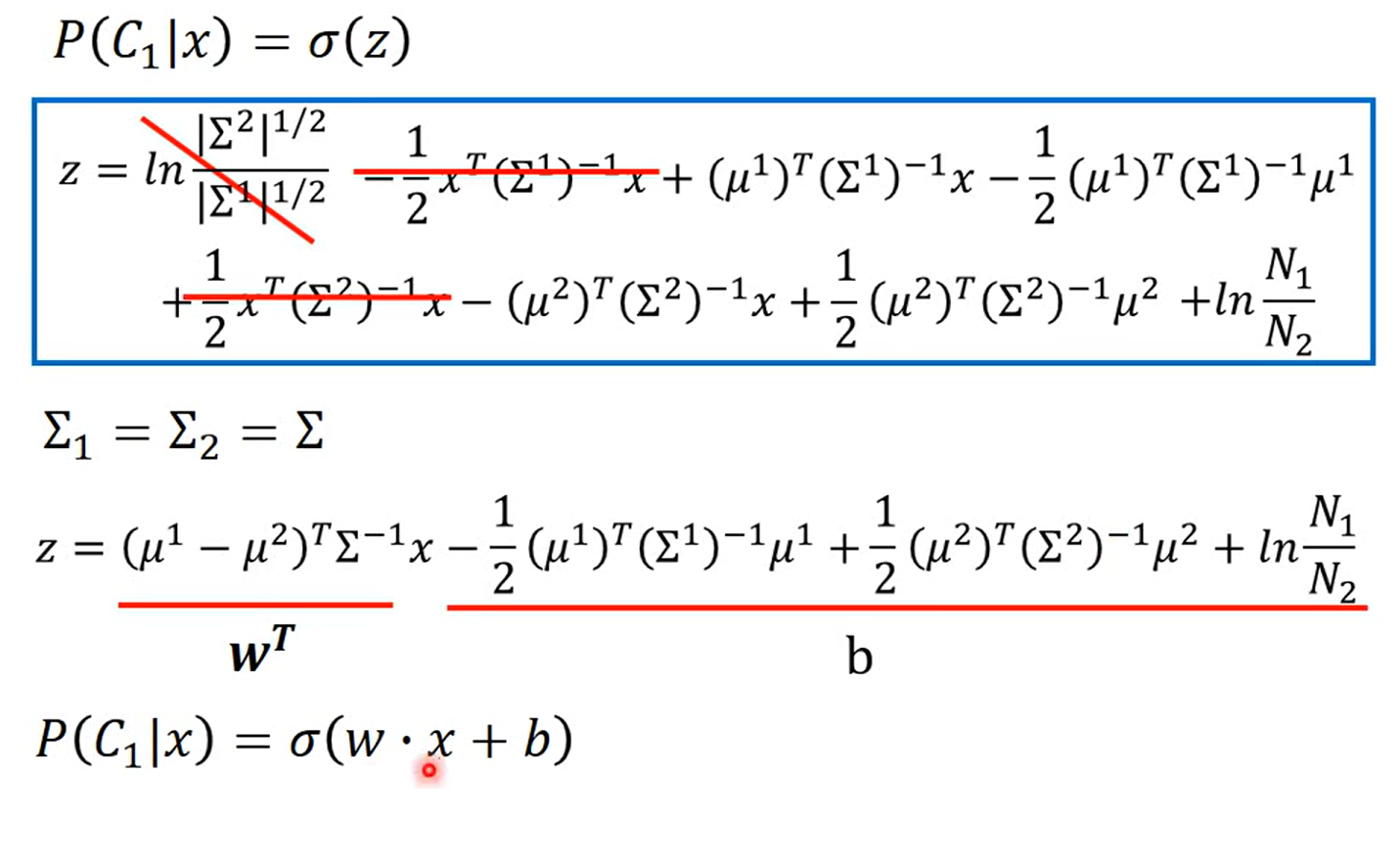

从这个式子可以看出,共用 Σ \Sigma Σ 的时候,为什么 boundary 会是一个直线

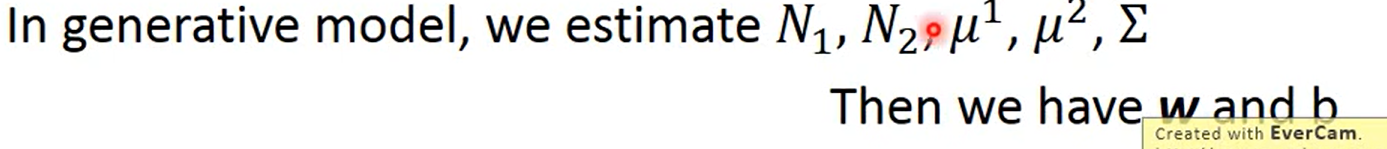

老师讲的真牛x,这里直接串起来了,后面紧接着讲logistic Regression

2045

2045

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?