1126环境配置说明

主要参照:

RV1109_RV1126 EVB板使用总结_咬我呀_Gemini的博客-CSDN博客_evb板

- usb驱动安装

- 虚拟机vmware如何共享文件夹

VMware ubuntu虚拟机与主机共享文件夹_whr197的博客-CSDN博客_ubuntu虚拟机和主机共享文件夹

- 开发板连接电脑以及深度学习

瑞芯微 TB-RK3399Pro -- 开发板环境_荪荪的博客-CSDN博客_rk3399

- 配置rknn

[RV1109/RV1126系列]-1.安装部署RKNN_ToolKit进行算法NPU移植_Ant5985的博客-CSDN博客_rv1126部署pytorch

- RV1109_RV1126 EVB板使用总结

RV1109_RV1126 EVB板使用总结_咬我呀_Gemini的博客-CSDN博客_evb板

- 认识buildboot

认识Buildroot_就是个linux工程师的博客-CSDN博客_buildroot

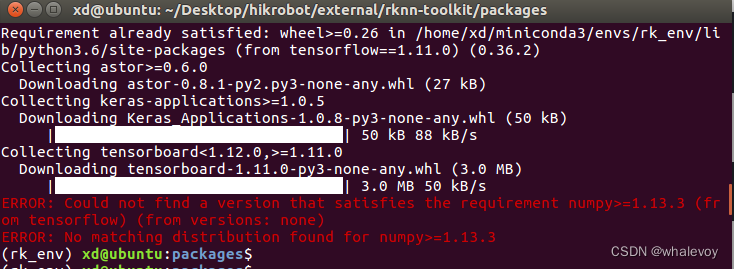

- 安装tensorflow报错时,可以升级pip

一开始安装tensorflow报错

升级pip后重新安装正常

- 安装rknn报错

可见rknn和python的一个画图库matplot是冲突的,此处暂时不做处理;

- Pc仿真环境中试跑demo

- 客户端连接Com无法打开,重新安装驱动

D:\BaiduNetdiskDownload\rp-rv1126_rv1109\06-工具\烧写驱动\DriverAssitant_v5.0

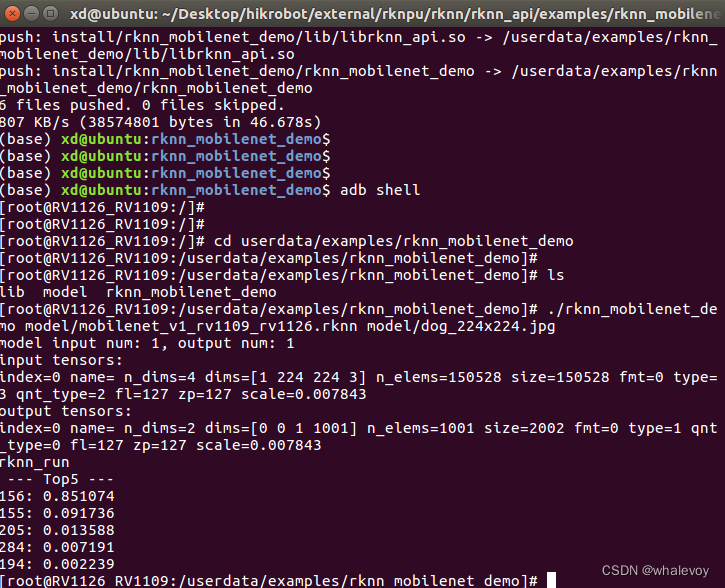

- Rknn sever编译烧录

- 重要:如何连接adb 进行调试

- Usb接入ubuntu系统后报错

- Pc联机调试开发板,报错

没有rknnsever,所以不能进行联机调试;

- 开发板 连接pc端联调,需要开发板侧有rknn server模块;

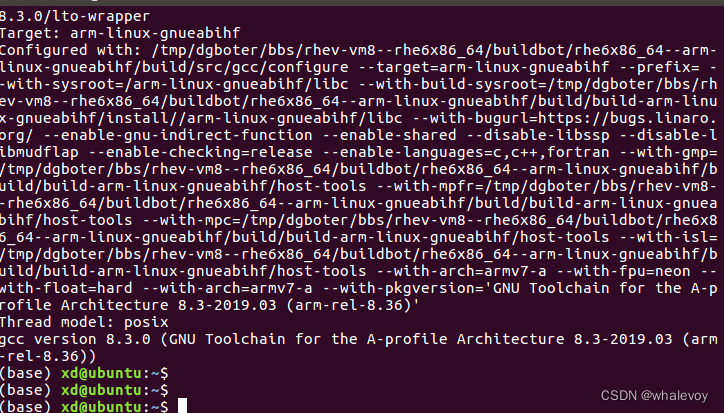

- 安装交叉编译工具链

- 交叉编译rknn的demo

- 交叉编译文件上传到板子上

- 在板子上运行算法模型

2291

2291

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?