CS2321n学习笔记——激活函数数、据预处理、权重初始化

激活函数

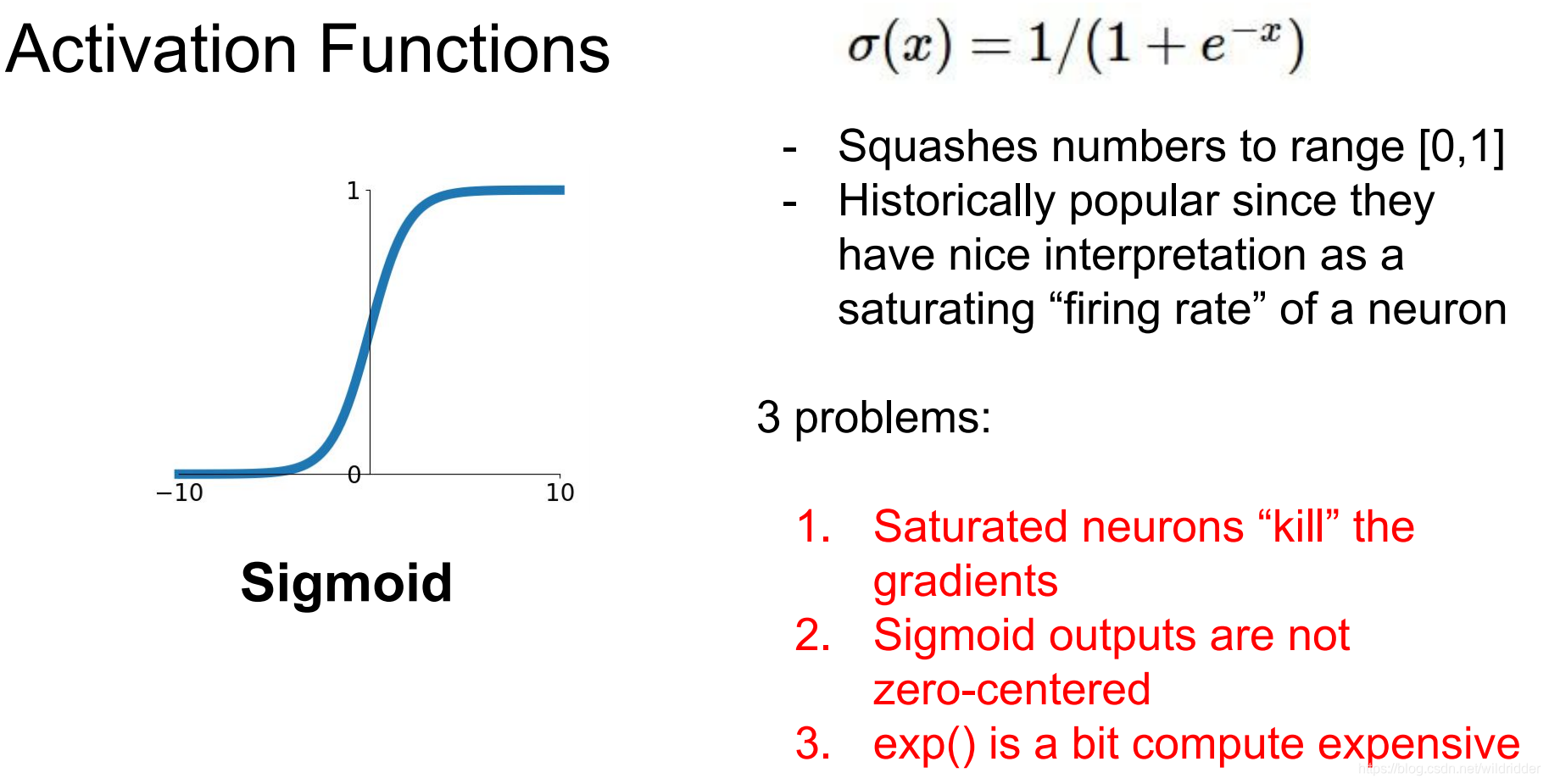

1、sigmoid函数

sigmoid函数曾经一度非常流行,但是它有三个严重缺点

1.饱和神经元将使梯度消失

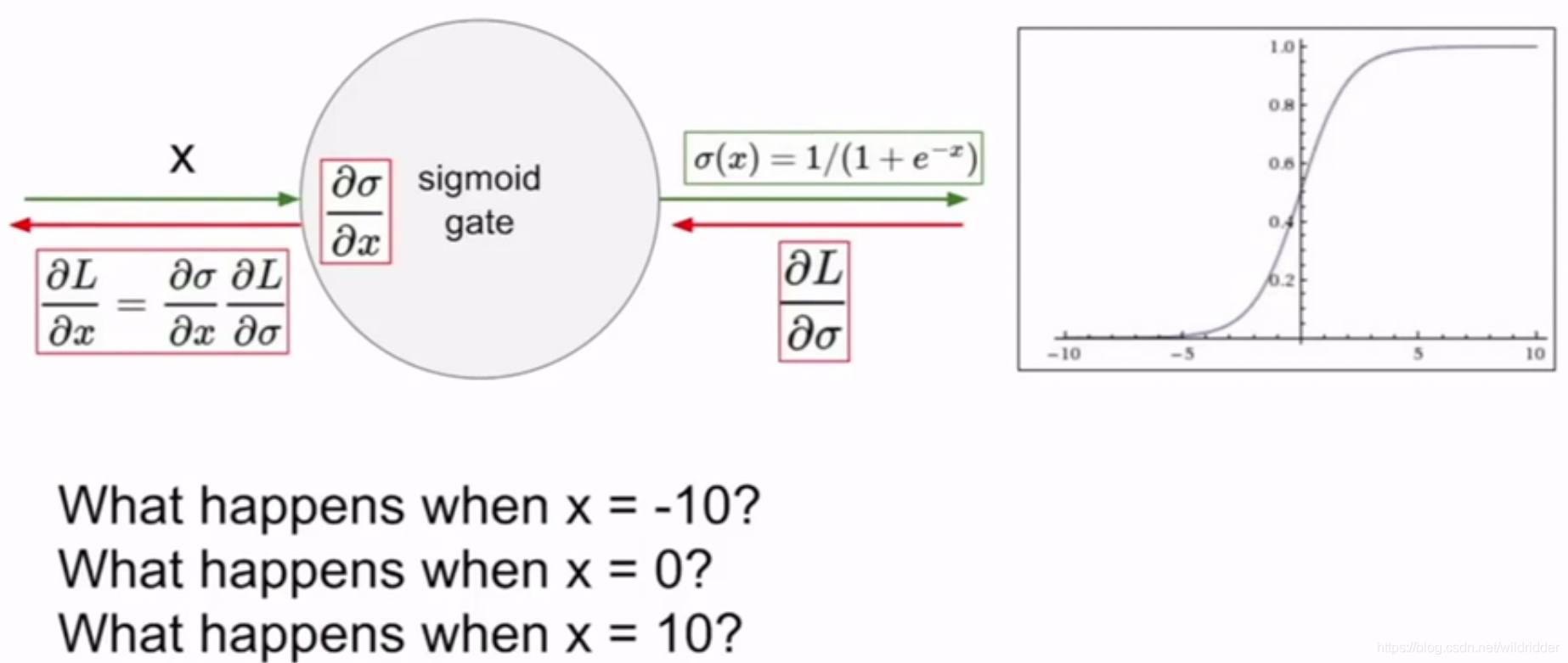

当x=-10时,接近负饱和区,它的导数非常接近0,所以当梯度反向传播时,经过sigmoid函数的上游传下来的梯度乘以一个非常接近0的数,得到一个非常接近零的数,经过链式法则后,零梯度就会传递到下游节点。

当x=0时会得到一个合理的梯度

当x=10时,导数又会接近0,同样会得到0梯度,从而得不到梯度流的反馈

2.sigmoid函数不是一个零中心函数(x=0时输出为0.5)

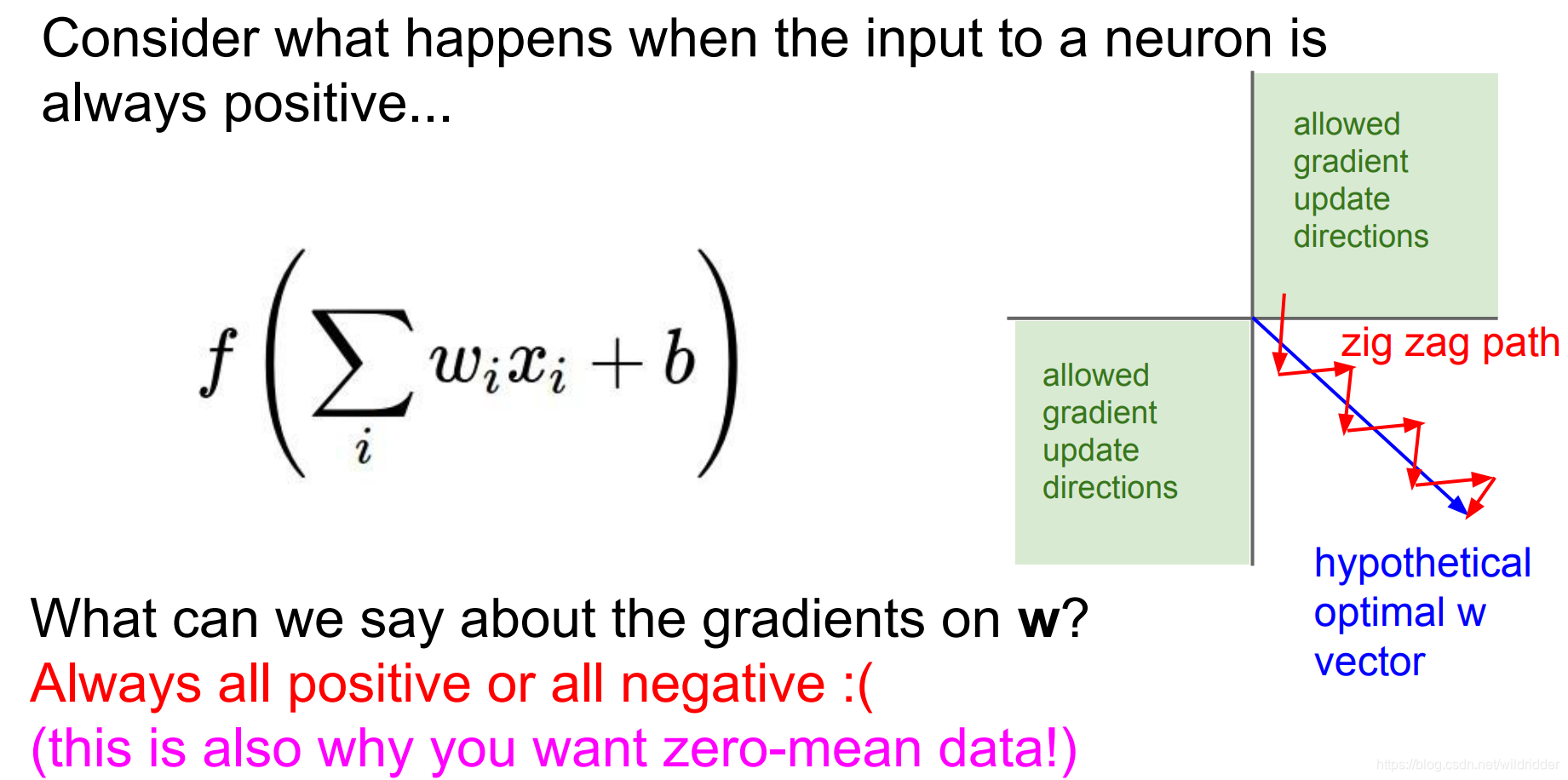

当神经元的输入数值始终为正时会怎么样?

结果就是所有值都是正或者所有值都为负,因为sigmoid的导数永远为正。上游传回来的梯度时dL/df,为正或者为负,再用它乘以局部梯度,df/dw=x,永远为正值,相当于把上游梯度的符号传递回来了,意味着所有关于w的梯度都同时为正或者为负,也就是会同时朝着一个方向改变。

这种方法对于梯度跟新来说效率是非常低的。这也是为什么我们经常想要使用均值为0的数据,这样我们就能得到正的和负的数值,就不会使梯度全部朝着一个方向改变。

3.exp()指数运算的运算代价有点高

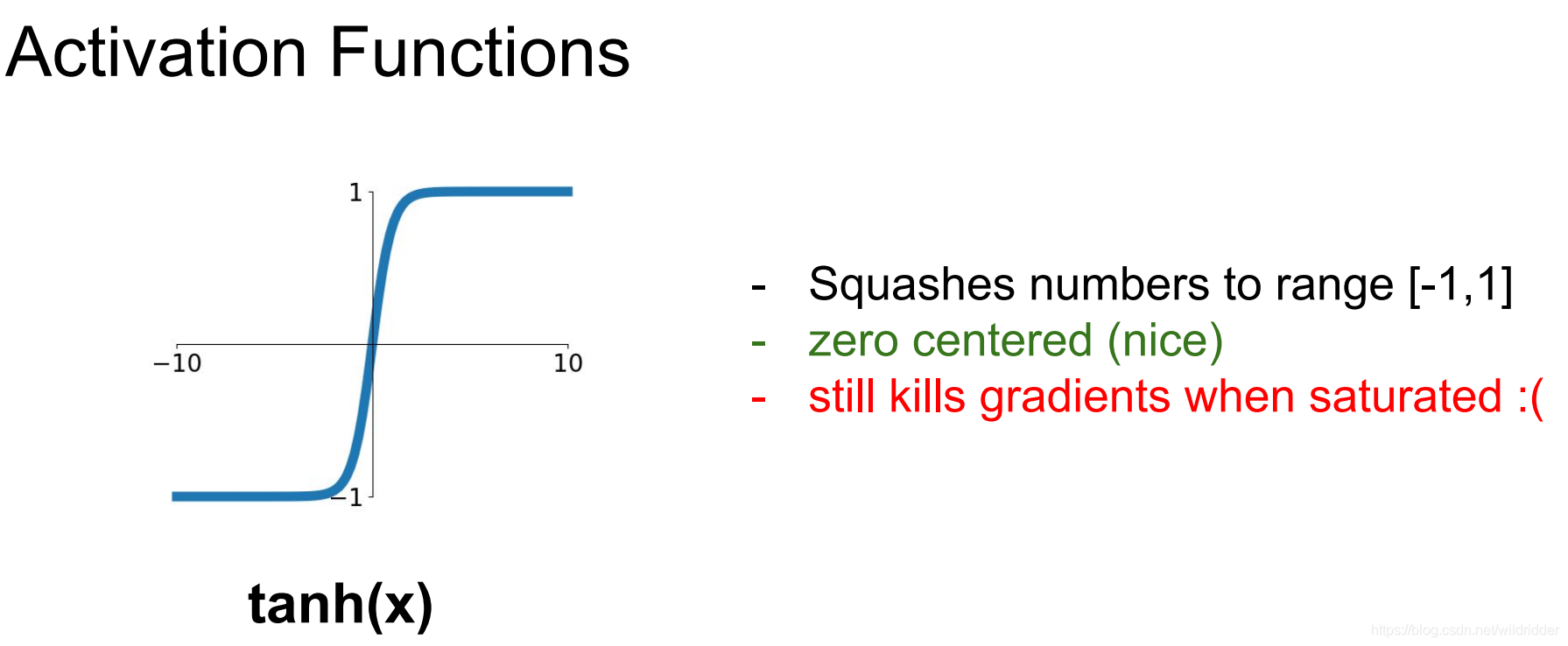

2、tanh函数

优点是以0为中心,但是当它饱和的时候依然会出现梯度消失的问题

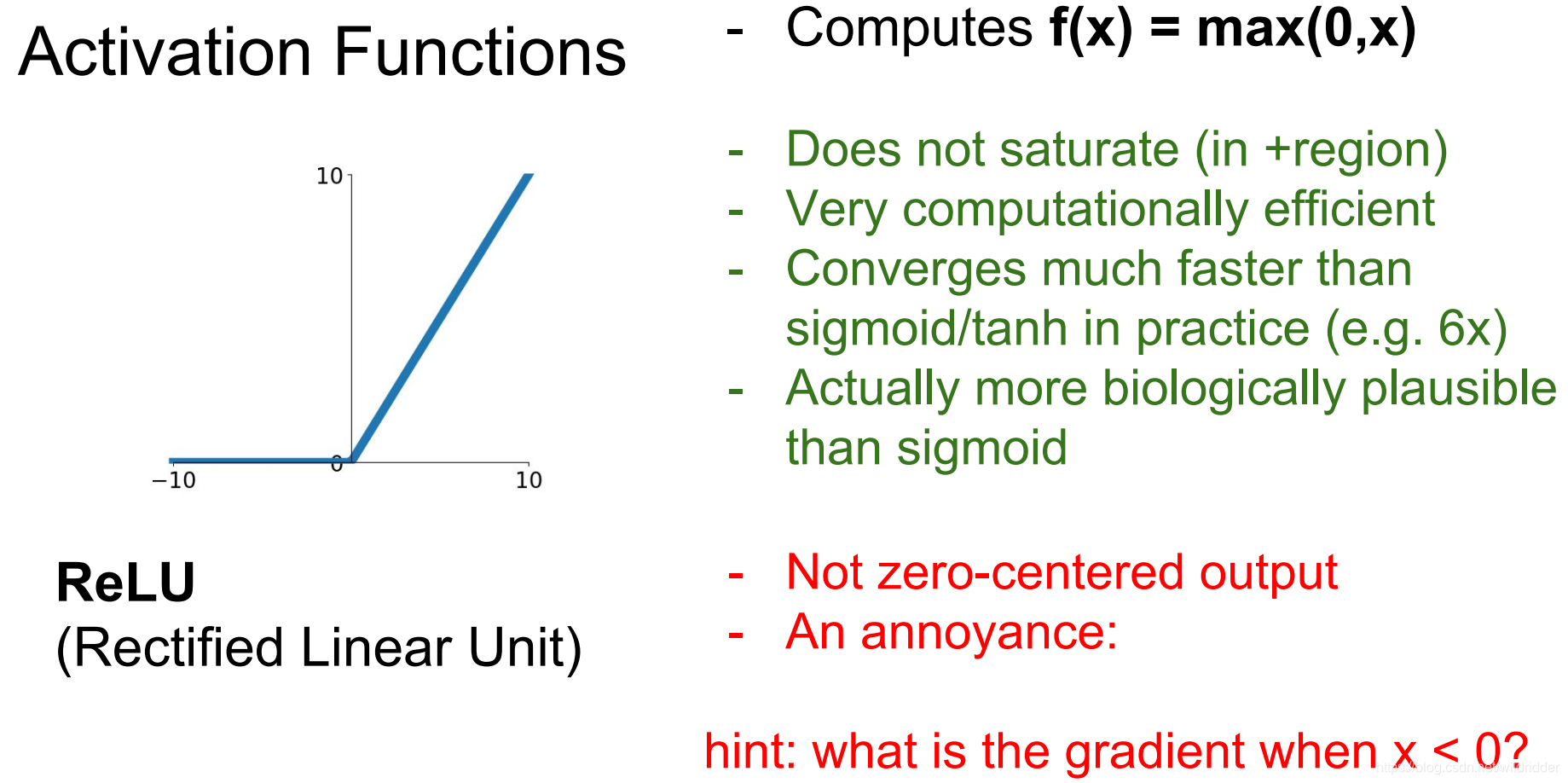

3、ReLU函数

优点:

1.不会饱和

2.计算效率高

3.收敛快

4.更符合生物学特性

缺点:

1.不是以零为中心

2.dead ReLU,如果初始化不好或者学习率太大,会让部分神经元挂掉(永远不被激活)

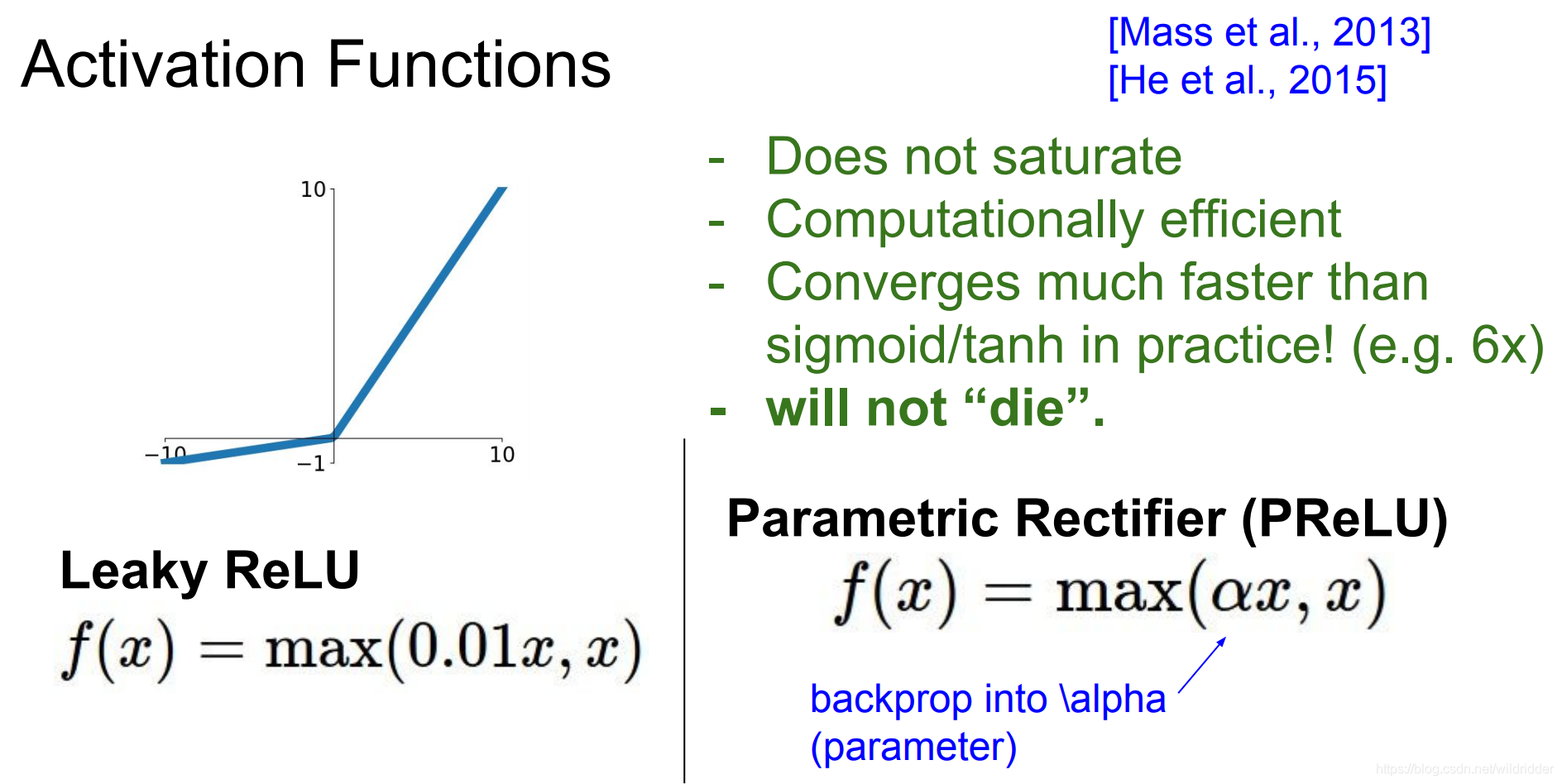

4、Leaky ReLU函数

优点:

1.不存在饱和区

2.计算效率高

3.收敛快

4.不会挂掉神经元

PReLU也是类似的函数,再负区间有一个可以被反向传播学习的斜率参数

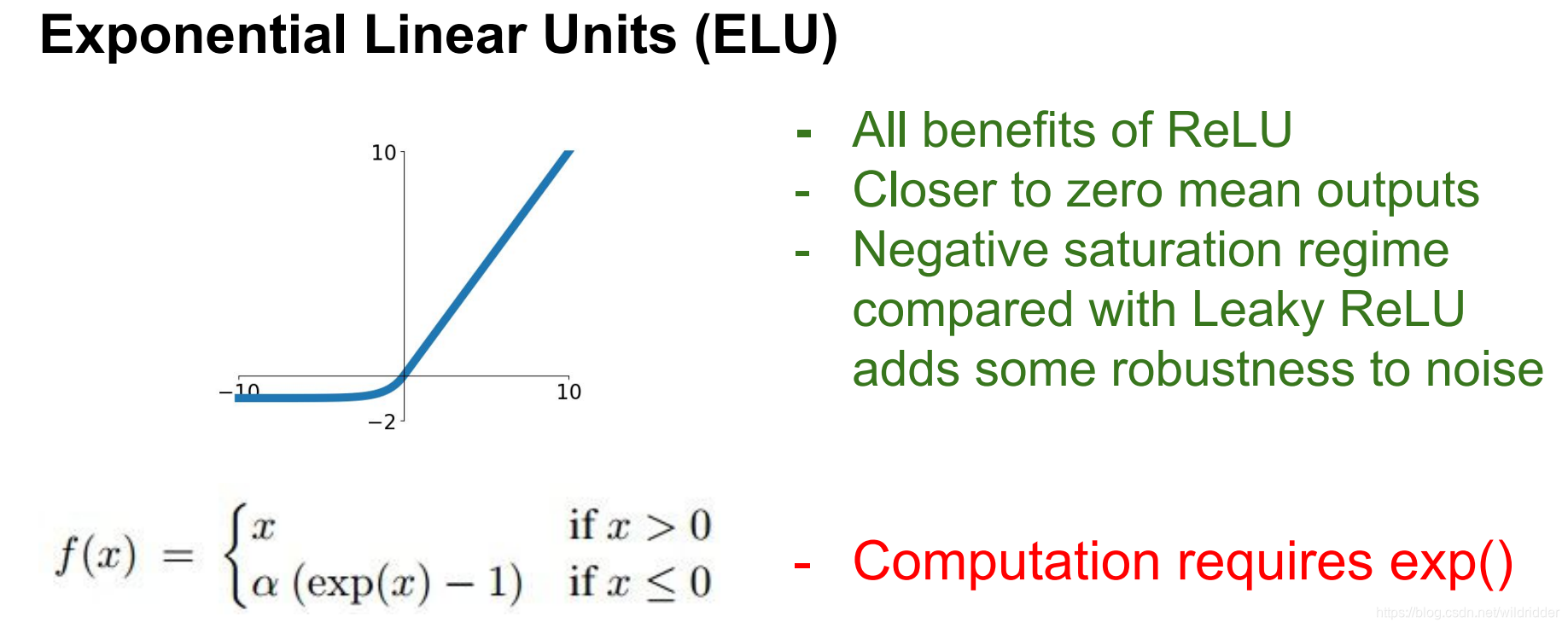

5、ELU函数

优点:

1.有ReLU的所有优点

2.接近零均值

3.建立负饱和区,对噪声有一定的鲁棒性

缺点:

需要计算指数运算exp()

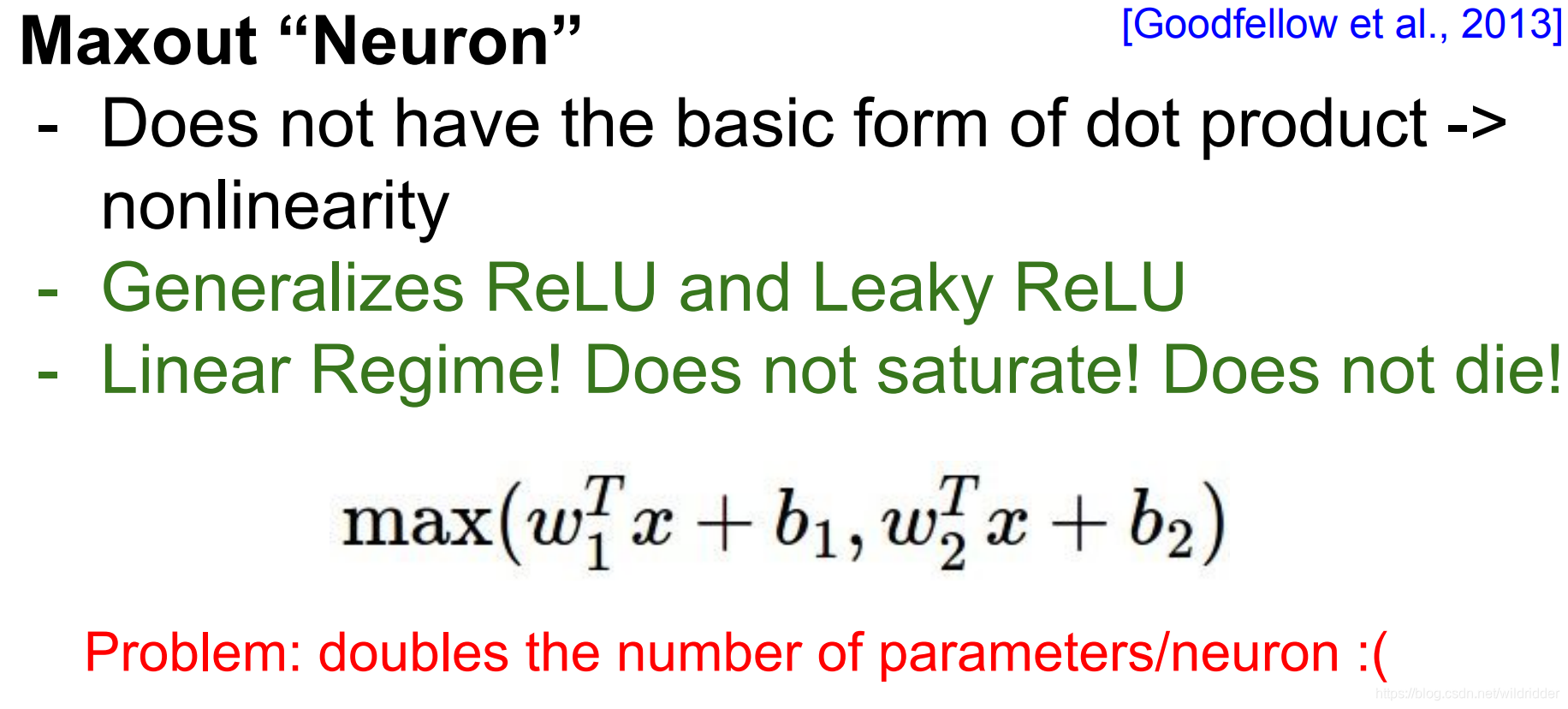

6、MAX()函数

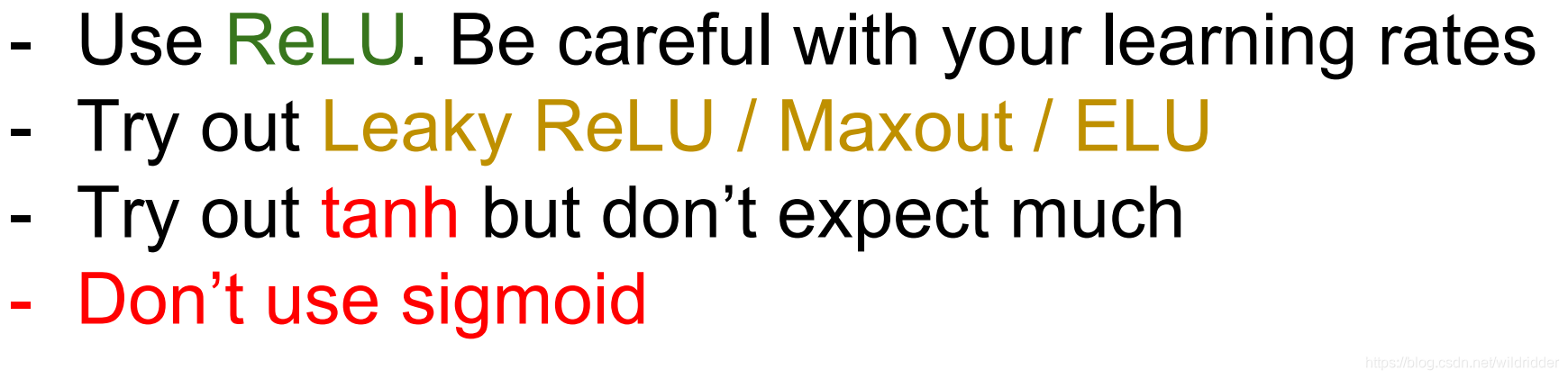

在实践中使用的策略:

一般先使用ReLU,这是大体上能用的方法中最标准的一种

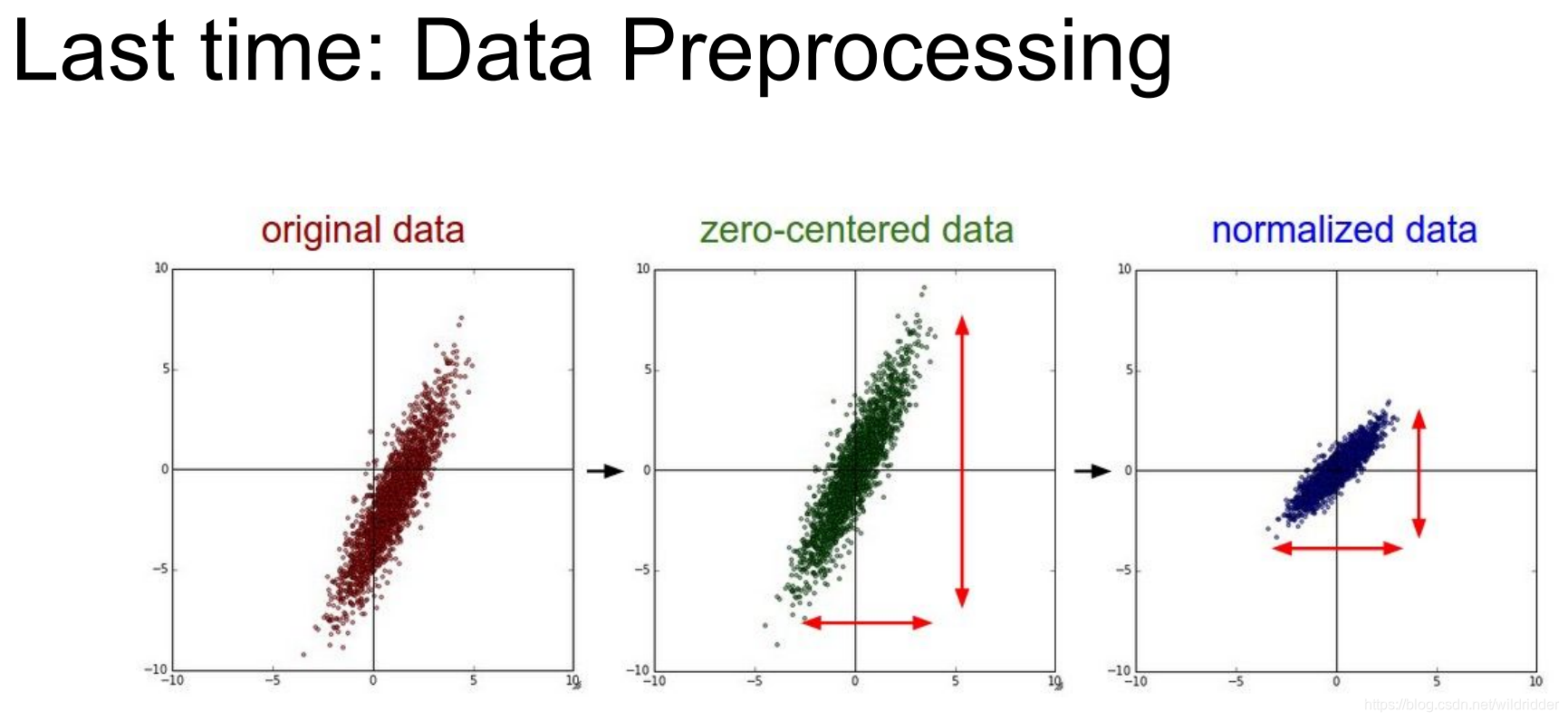

数据预处理

零中心化:为了避免得到的梯度全为正或者全为负(减去整个图片的均值)

归一化数据:为了让所有特征都在相同区间内,做出差不多的贡献

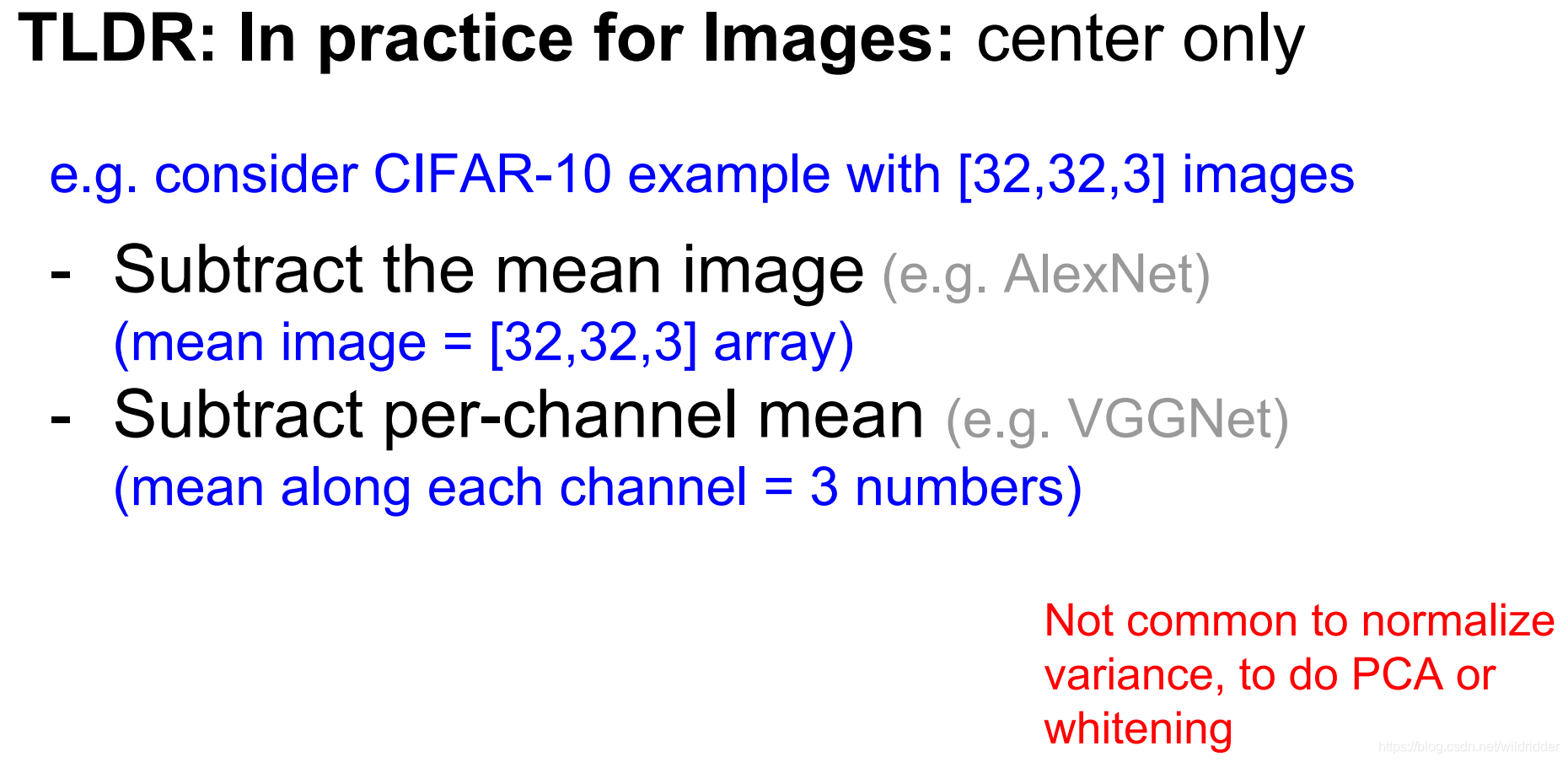

但一般图像的数据预处理只有零中心化,而不做其他处理:

在AlexNet中,像素值减去整个图片的均值,而在VGGNet中,则是减去每个颜色通道的均值。而这个操作并不能改变sigmoid函数缺点,只能在第一层解决梯度消失问题,但是在深度神经网络中后面的层依然存在梯度消失问题。

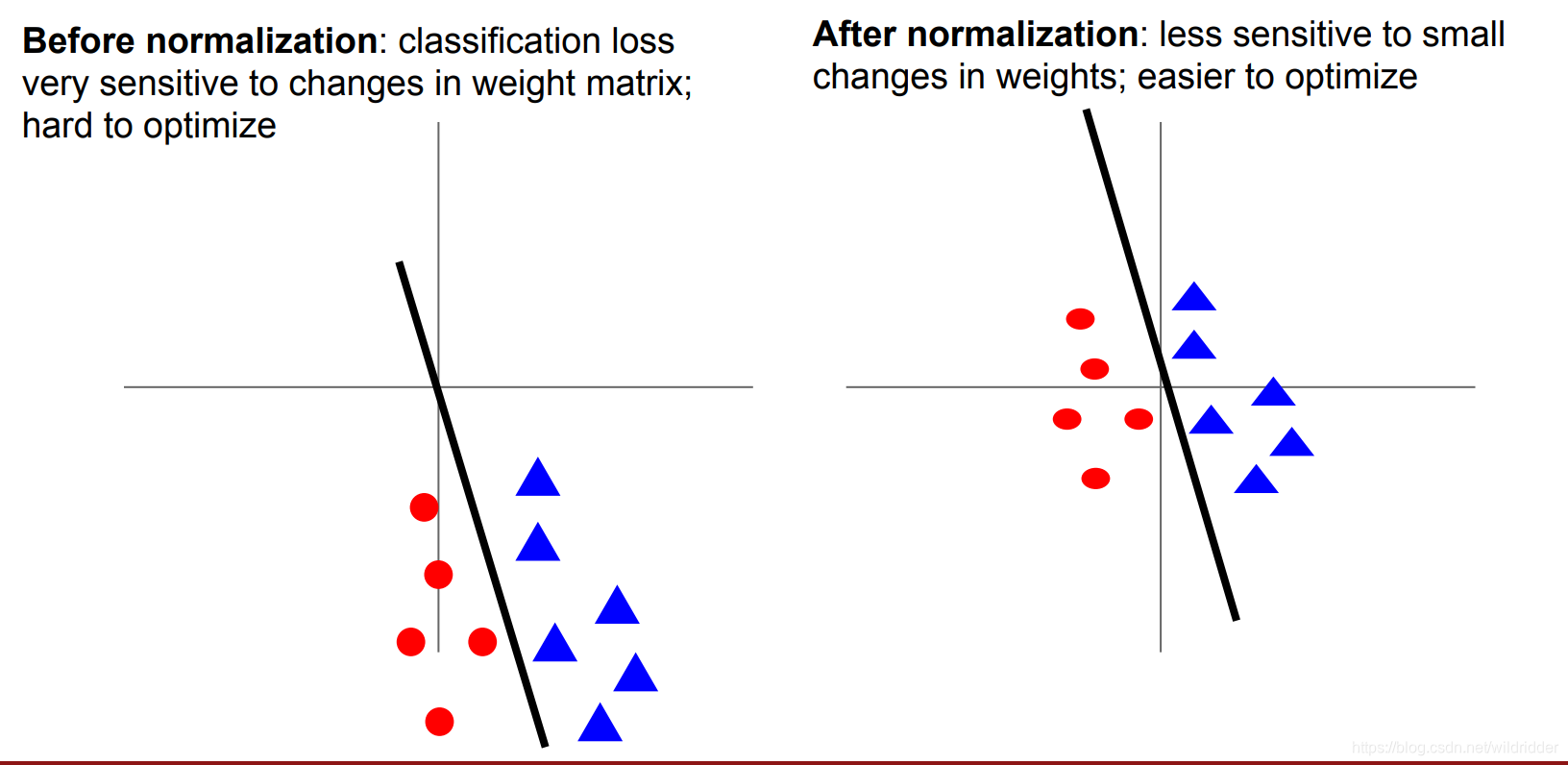

零中心化的意义:

从简单的二维分类任务来看,左图是没有被中心化的数据,离坐标原点很远,我们可以用一条直线分离他们,然是如果这条直线稍微转动一点,就会导致分类不准确,也就是说左边分类器的损失函数对权重W中的微小扰动非常敏感。而在右边中心化后的数据中,微小扰动对分类器的准确性影响则没有那么大,会使优化变得更容易。这种情况不仅仅在线性分类器中出现,在神经网络中我们需要交叉使用线性分类器卷积还有非线性激活函数,如果神经网络中某一层的输入均值不为零(没有零中心化),该层权重的微小扰动就会造成该层输出的巨大变动,从而造成学习困难

权重初始化

如果一个神经网络的权重参数都为0会怎么样?

所有神经元会同步更新相同参数,做同样的事情,得到一堆完全相同的神经元。

所以应该怎么做呢?

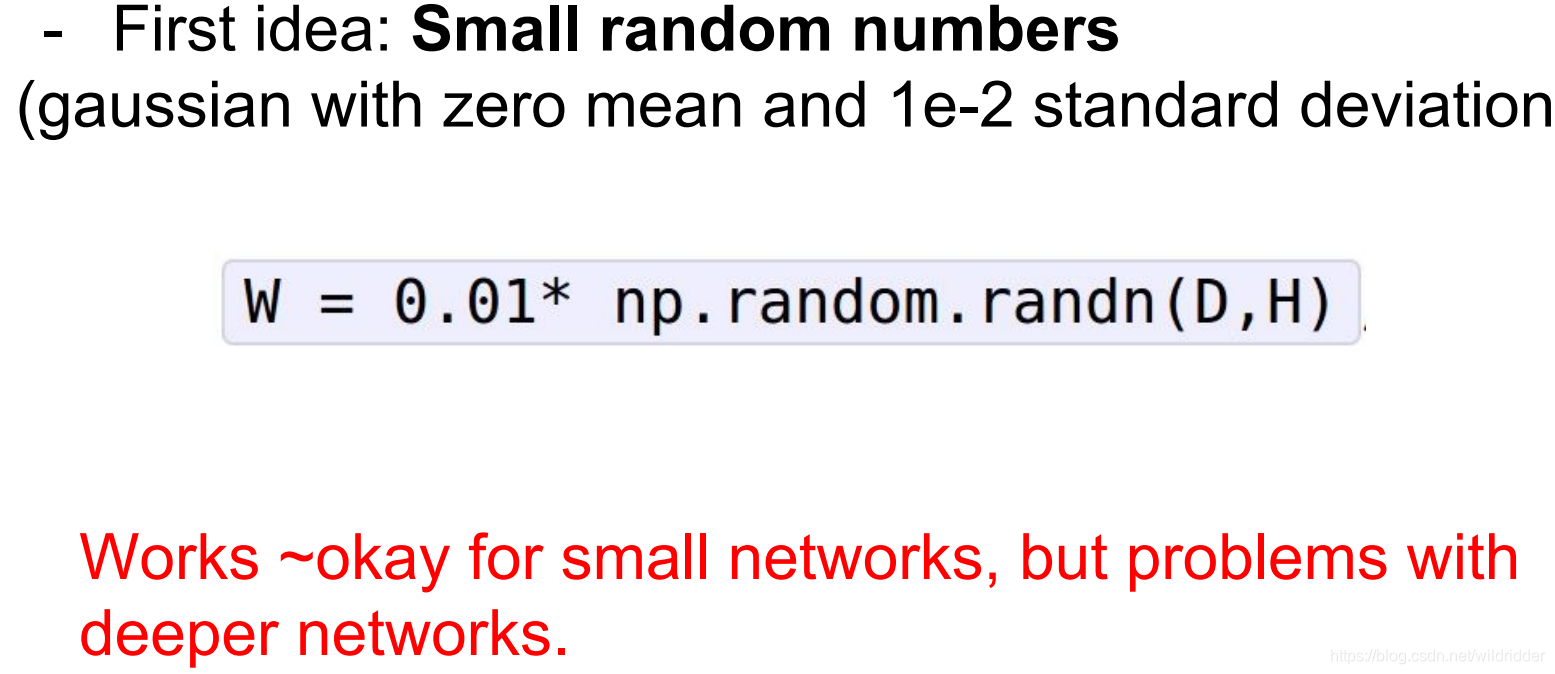

首先可以尝试小数据的高斯分布

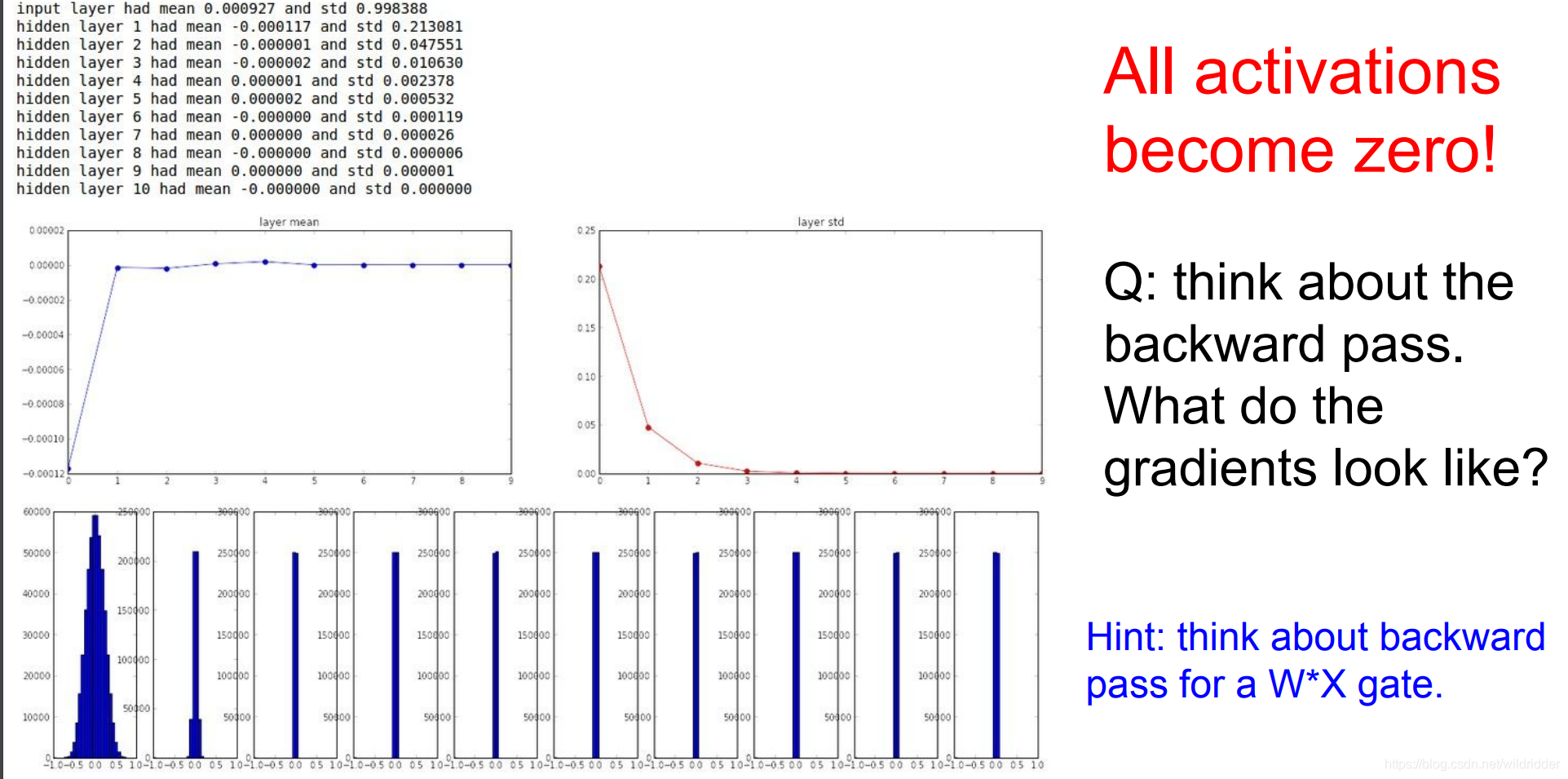

这样初始化参数在小的网络中有用,但是在更深的网络中会出现问题。

正向传播时在每层乘以一个随机权重(小于1的数),在一次次的乘法中参数迅速缩小,所有数值慢慢趋近于0。

反向传播的时候,也因为链式法则梯度不断乘以小数导致梯度消失。。

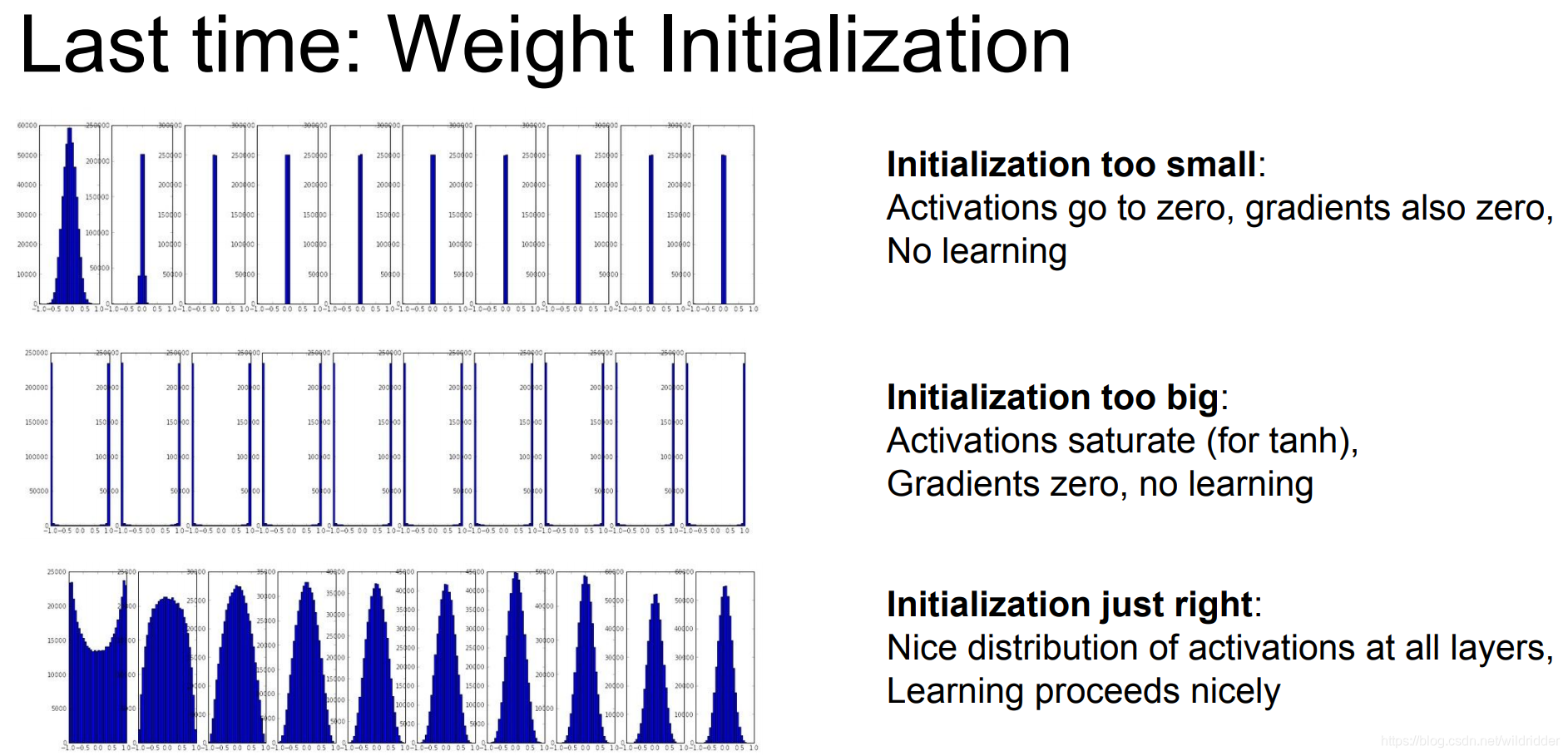

如果初始化权重比较大会怎么样呢?

会因为hanh函数的特性进入饱和区,导致梯度消失。

所以初始化的权重太大或者太小都不行,所以可以使用Xavier初始化法,或者MSRA初始化法进行合适的初始化。

522

522

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?