1.环境准备

Linux操作系统:ubuntu15.04 x86版

Jdk:jdk1.6.0_43

Hadoop:1.2.1

2.环境配置

1.hadoop使用过程中会用到ssh连接,因此需要安装ssh

2.hadoop由java编写,因此运行需要jvm,安装jdk

3.hadoop使用过程中连接其他节点需要ssh,经常输入密码不便,建议配置免密码登录

4.修改一下主机名之类的,改成有意义的名字,顺便绑定ip和主机名。

- 注:操作最好使用root来执行,其他用户会有许多文件只读权限或者其他问题,因此建议使用root用户执行操作。

下面开始配置:

1.安装ssh,默认情况下,Ubuntu会安装ssh-client,不会安装ssh-server,具体安装配置参照上一篇博文:win7中使用xshell连接VMware下ubuntu失败

2.安装jdk:默认情况下,Ubuntu会安装openjdk,这里我们先卸载openjdk,后安装sun的jdk。

1)卸载openjdk:

sudo apt-get purge openjdk*

或者

sudo apt-get autoremove openjdk*2)安装sun jdk:

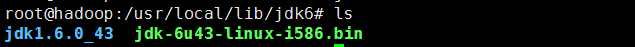

将下载的.bin文件复制到适当位置,此处以/usr/local/lib/jdk6为例:

进入目录,使用命令:

./jdk-6u43-linux-i586.bin进行解压,此处jdk安装完成,下面开始配置环境变量。

在/etc/profile中添加如下内容:

#set Java Environment

export JAVA_HOME=/usr/local/lib/jdk6/jdk1.6.0_43

export CLASSPATH=.:$JAVA_HOME/lib:$CLASSPATH

export PATH=$JAVA_HOME/bin:$PATH使用命令来使修改立即生效:

source /etc/profile3)至此jdk安装完成,输入命令:

java -version出现jdk版本信息,则安装完成。

3.配置ssh免密码登录

1)配置免密码登录,首先查看用户目录下是否有.ssh目录,输入命令:

ls -a /home/root2)如果不存在,则手动创建一个。因为此目录会保存ssh登录的密钥等信息。

下面输入命令:

ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa此处:ssh-keygen代表生成密钥;-t代表生成密钥类型;-P用于提供密语;-f指定生成的密钥文件。~代表当前用户文件夹。

3)此命令会在.ssh文件夹下创建id_dsa和id_dsa.pub两个文件,即私钥和公钥,把id_key.pub即公钥追加到授权的key中去。

输入命令:

cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys至此ssh免密码登录本机设置完成。

4)验证ssh配置是否成功。

ssh localhost此时会显示登录信息,地产一次会询问是否连接,输入yes即可进入,后面再使用即不需要输入。

- 注:ssh是否免密码登录不是必须设置的。但是过程中多次输入密码会很麻烦,因此建议设置免密码登录。

4.修改主机名,并绑定ip

输入命令:

hostname可以查看当前的主机名,修改/etc/hostname文件内容,永久修改主机名称,此处修改为hadoop。

主机名绑定ip:修改文件/etc/hosts文件,添加主机名和ip即可。

重启系统,使修改生效。

安装Hadoop

1.解压hadoop包,hadoop-1.2.1.tar.gz

使用命令将hadoop-1.2.1.tar.gz解压,此处放到/usr下

tar -zxvf hadoop-1.2.1.tar.gz修改目录为hadoop,便于使用

mv hadoop-1.2.1 hadoop此时,就是hadoop单机模式,下面进行伪分布式配置。

2.伪分布式配置

1)修改conf/hadoop-env.sh

将其中的jdk配置打开,设置为你的jdk安装目录。

2)conf/core-site.xml:

<configuration>

<property>

<name>fs.default.name</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>3)conf/hdfs-site.xml:

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>4)conf/mapred-site.xml:

<configuration>

<property>

<name>mapred.job.tracker</name>

<value>localhost:9001</value>

</property>

</configuration>至此配置完成。

3.执行

hadoop安装完成之后,要首先进行格式化,执行如下命令:

hadoop namenode -format启动Hadoop,下面命令启动全部:

start-all.sh- hadoop日志默认保存在如下路径:${HADOOP_HOME}/logs

4.执行之后,可以看到启动成功,或者执行如下命令查看:

jps也可以通过浏览器来查看启动状态,url如下:

NameNode - http://localhost:50070/

JobTracker - http://localhost:50030/

如果需要停止相关程序,使用如下命令:

stop-all.sh至此,hadoop伪分布式配置完成。

5771

5771

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?