准备三台虚拟机

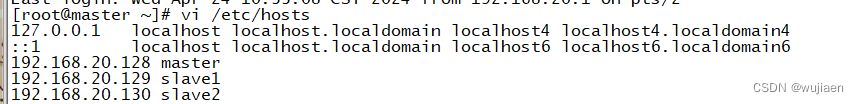

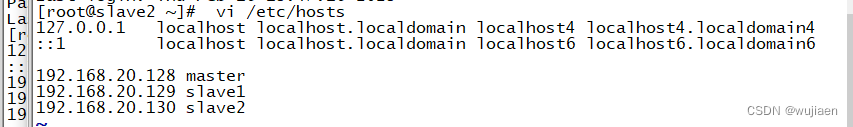

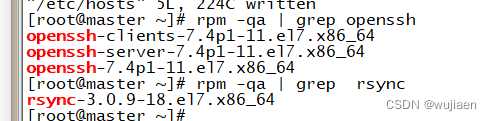

绑定主机名与 IP 地址

vi /etc/hosts

查看 SSH 服务状态

systemctl status sshd

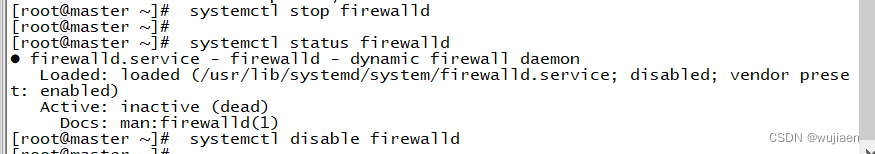

关闭防火墙

systemctl stop firewalld

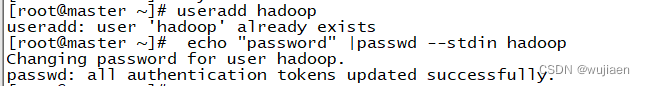

创建 hadoop 用户

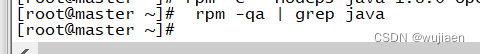

卸载自带 OpenJDK

卸载相关服务,键入命令

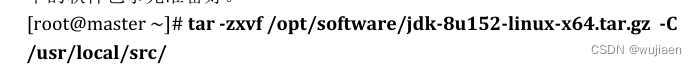

安装 JDK

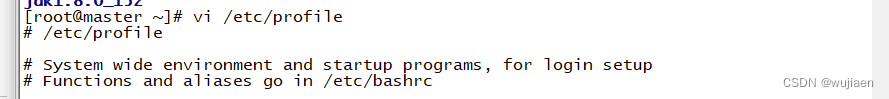

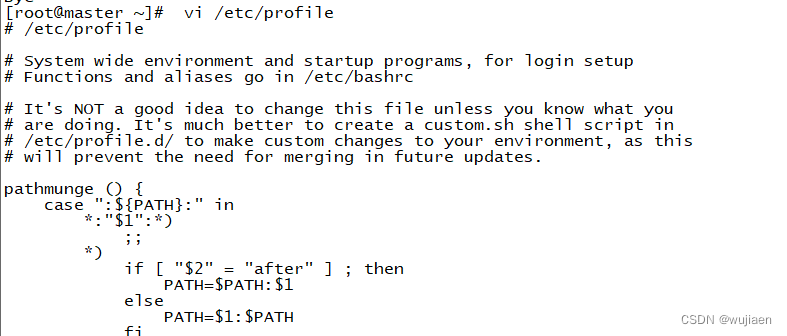

[root@master ~]# vi /etc/profile 在文件的最后增加如下两行: export JAVA_HOME=/usr/local/src/jdk1.8.0_152 export PATH=$PATH:$JAVA_HOME/bin

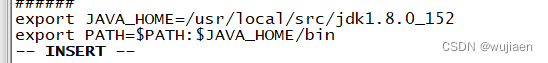

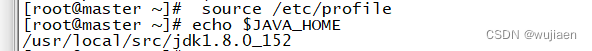

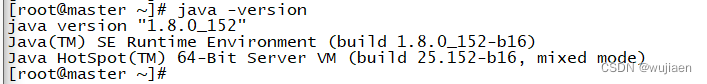

执行 source 使设置生效: [root@master ~]# source /etc/profile

检查 JAVA 是否可用。 [root@master ~]# echo $JAVA_HOME /usr/local/src/jdk1.8.0_152 [root@master ~]# java -version java version "1.8.0_152" Java(TM) SE Runtime Environment (build 1.8.0_152-b16) Java HotSpot(TM) 64-Bit Server VM (build 25.152-b16, mixed mode) 能够正常显示 Java 版本则说明 JDK 安装并配置成功。

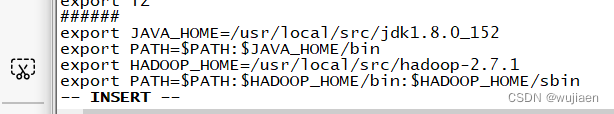

安装 Hadoop 软件

![]()

[root@master ~]# tar -zxvf /opt/software/hadoop-2.7.1.tar.gz -C /usr/local/src/

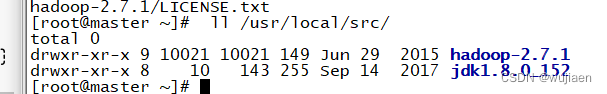

[root@master ~]# ll /usr/local/src/ 总用量 0 drwxr-xr-x. 9 10021 10021 149 6月 29 2015 hadoop-2.7.1 drwxr-xr-x. 8 10 143 255 9月 14 2017 jdk1.8.0_152

查看 Hadoop 目录,得知 Hadoop 目录内容如下:

[root@master ~]# ll /usr/local/src/hadoop-2.7.1/

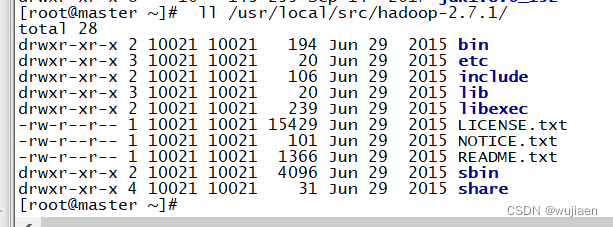

配置 Hadoop 环境变量

和设置 JAVA 环境变量类似,修改/etc/profile 文件。

[root@master ~]# vi /etc/profile 在文件的最后增加如下两行:

export HADOOP_HOME=/usr/local/src/hadoop-2.7.1 export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

![]()

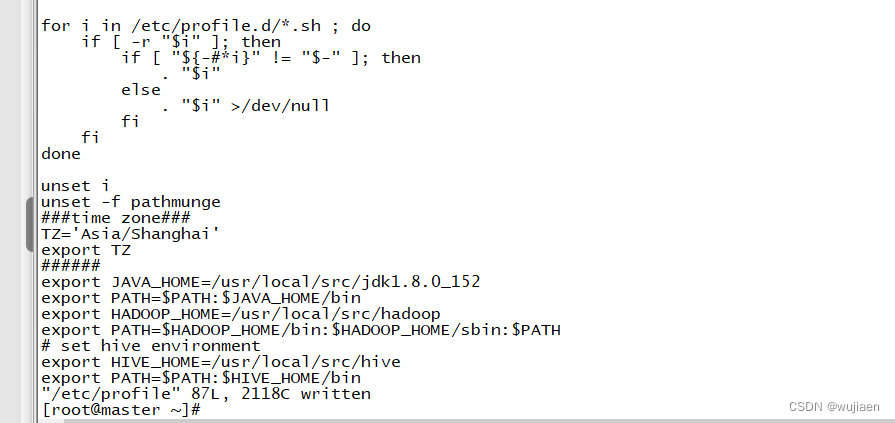

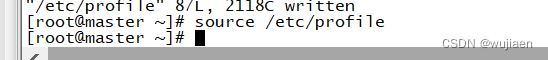

执行 source 使用设置生效:

[root@master ~]# source /etc/profile

![]()

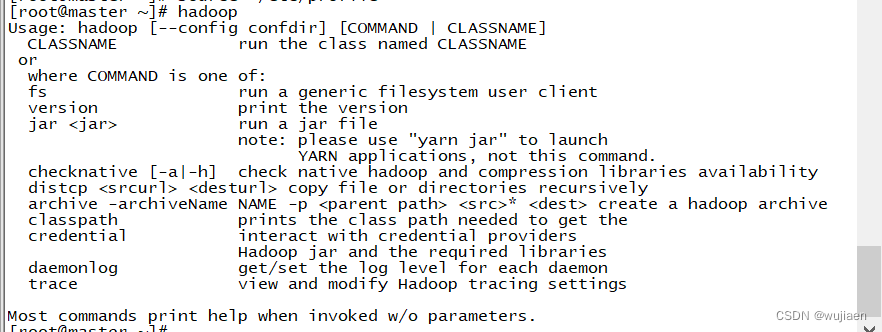

检查设置是否生效:

[root@master ~]# hadoop

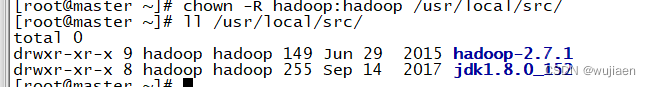

修改目录所有者和所有者组

上述安装完成的 Hadoop 软件只能让 root 用户使用,要让 hadoop 用户能够 运行 Hadoop 软件,需要将目录/usr/local/src 的所有者改为 hadoop 用户。

[root@master ~]# chown -R hadoop:hadoop /usr/local/src/

[root@master ~]# ll /usr/local/src/

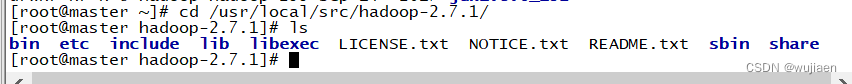

配置 Hadoop 配置文件

[root@master ~]# cd /usr/local/src/hadoop-2.7.1/

[root@master hadoop-2.7.1]# ls

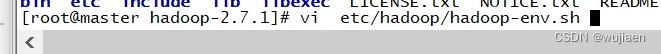

[root@master hadoop-2.7.1]# vi etc/hadoop/hadoop-env.sh

在文件中查找 export JAVA_HOME 这行,将其改为如下所示内容:

export JAVA_HOME=/usr/local/src/jdk1.8.0_152

![]()

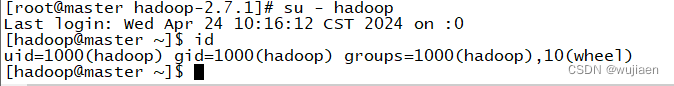

测试 Hadoop 本地模式的运行

切换到 hadoop 用户]

使用 hadoop 这个用户来运行 Hadoop 软件。

[root@master hadoop-2.7.1]# su - hadoop

[hadoop@master ~]$ id

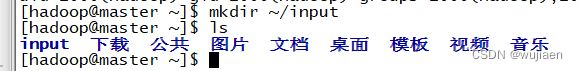

创建输入数据存放目录

将输入数据存放在~/input 目录(hadoop 用户主目录下的 input 目录中)。

[hadoop@master ~]$ mkdir ~/input

[hadoop@master ~]$ ls

创建数据输入文件

创建数据文件 data.txt,将要测试的数据内容输入到 data.txt 文件中。

[hadoop@master ~]$ vi input/data.txt 输入如下内容,保存退出。

Hello World

Hello Hadoop

Hello Husan

![]()

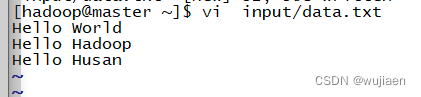

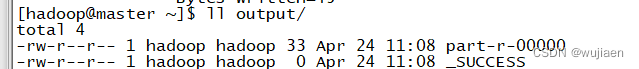

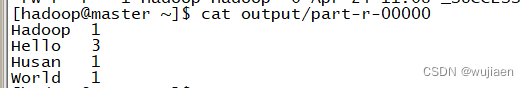

测试 MapReduce 运行

运行 WordCount 官方案例,统计 data.txt 文件中单词的出现频度。这个案例可 以用来统计年度十大热销产品、年度风云人物、年度最热名词等。命令如下:

[hadoop@master ~]$ hadoop jar /usr/local/src/hadoop2.7.1/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.1.jar wordcount ~/input/data.txt ~/output

![]()

运行结果保存在~/output 目录中(注:结果输出目录不能事先存在),命令执 行后查看结果: [hadoop@master ~]$ ll output/

文件_SUCCESS 表示处理成功,处理的结果存放在 part-r-00000 文件中,查看该 文件。 [hadoop@master ~]$ cat output/part-r-00000

可以看出统计结果正确,说明 Hadoop 本地模式运行正常。

Hadoop平台环境配置

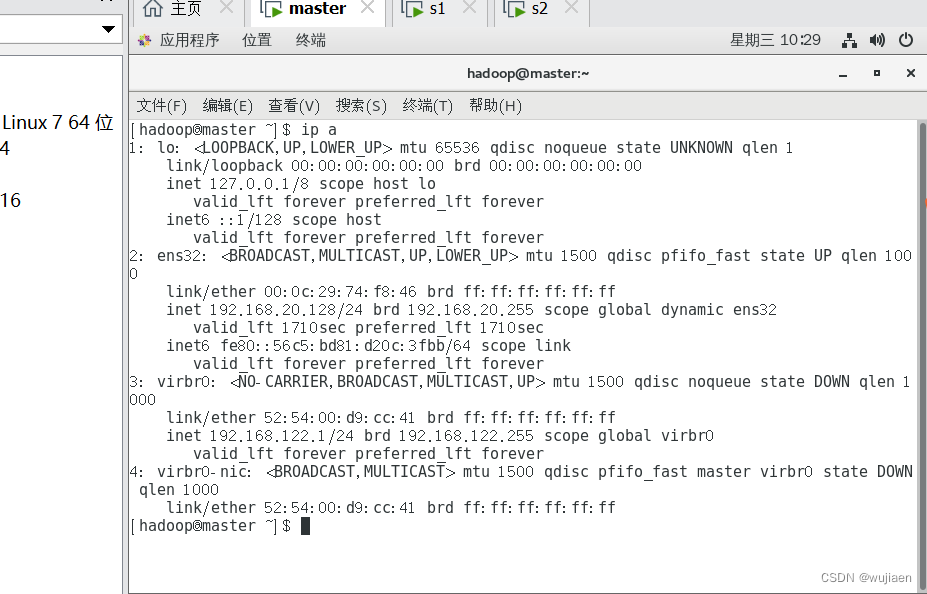

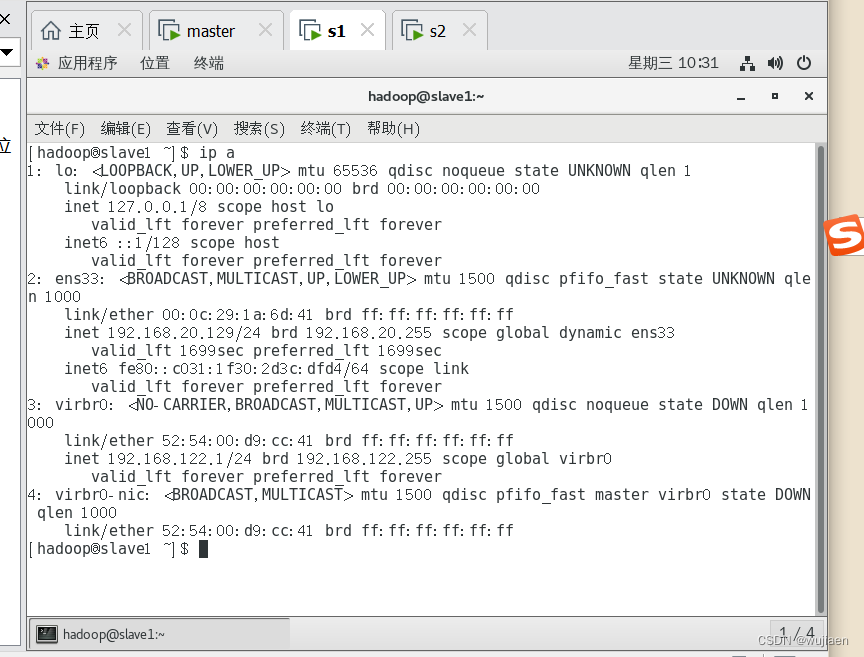

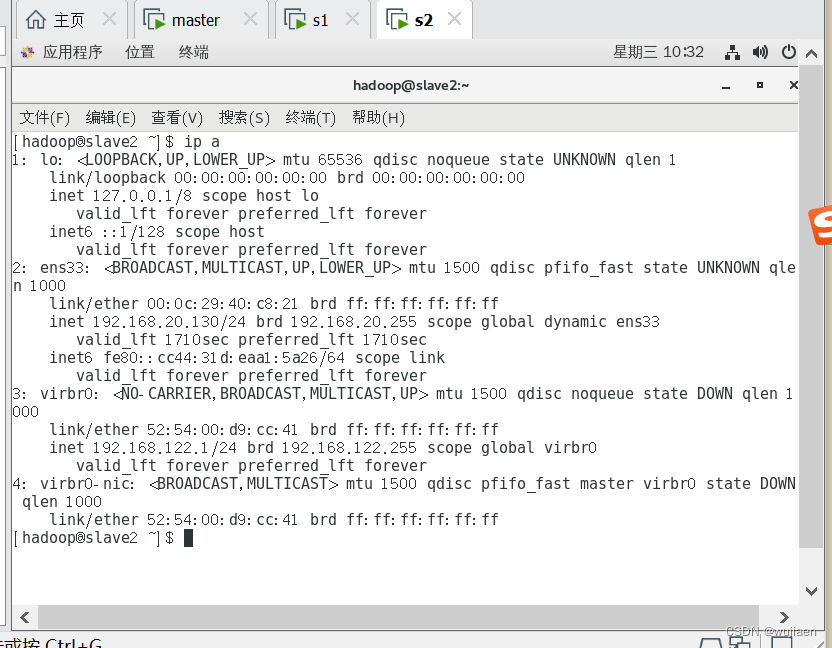

实验环境下集群网络配置

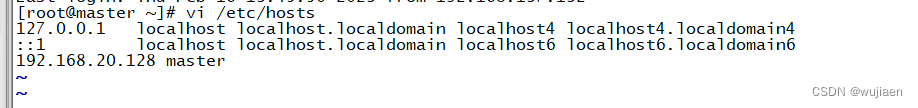

根据我们为 Hadoop 设置的主机名为“master、slave1、slave2”,映地址是 “192.168.20.128、192.168.20.129、192.168.20.130”,分别修改主机配置文件“/etc/hosts”, 在命令终端输入如下命令:

SSH 无密码验证配置

SSH 无密码验证配置

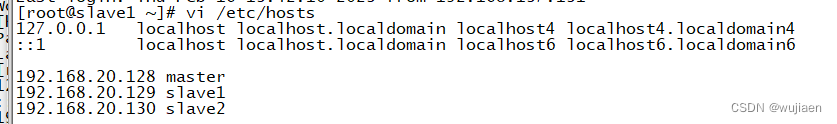

每个节点安装和启动 SSH 协议

实现 SSH 登录需要 openssh 和 rsync 两个服务,一般情况下默认已经安装(如没有自行安 装),可以通过下面命令查看结果。

[root@master ~]# rpm -qa | grep openssh

切换到 hadoop 用户

[root@master ~]# su - hadoop

[hadoop@master ~]$

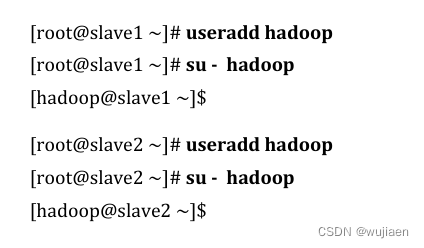

[root@slave1 ~]# useradd hadoop

[root@slave1 ~]# su - hadoop

[hadoop@slave1 ~]$

[root@slave2 ~]# useradd hadoop

[root@slave2 ~]# su - hadoop

[hadoop@slave2 ~]$

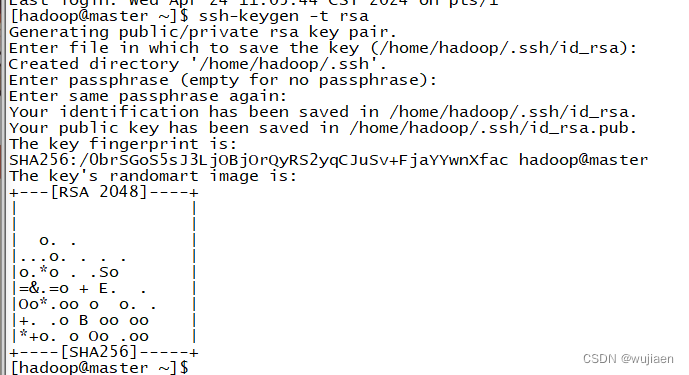

每个节点生成秘钥对

#在 master 上生成密钥

[hadoop@master ~]$ ssh-keygen -t rsa

#slave1 生成密钥

[hadoop@slave1 ~]$ ssh-keygen -t rsa

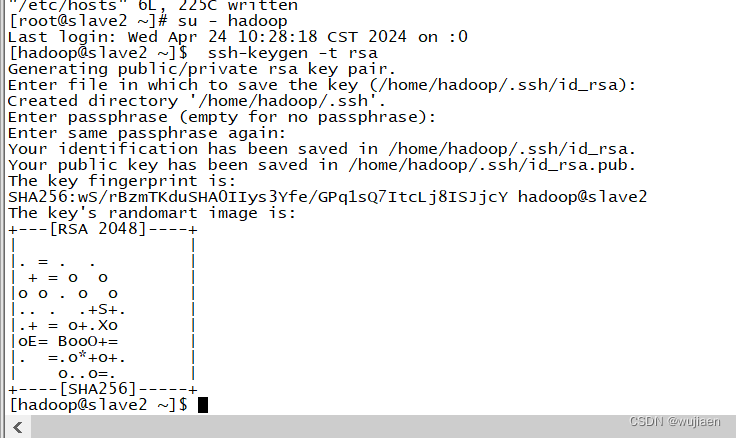

#slave2 生成密钥

[hadoop@slave2 ~]$ ssh-keygen -t rsa

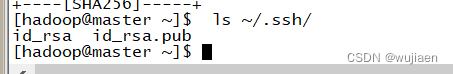

查看"/home/hadoop/"下是否有".ssh"文件夹,且".ssh"文件下是否有两个刚 生产的无密码密钥对。 [hadoop@master ~]$ ls ~/.ssh/

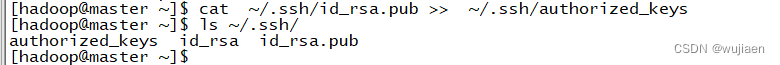

将 id_rsa.pub 追加到授权 key 文件中

#master

[hadoop@master ~]$ cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

[hadoop@master ~]$ ls ~/.ssh/

#slave1 [hadoop@slave1 ~]$ cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

[hadoop@slave1 ~]$ ls ~/.ssh/

#slave2 [hadoop@slave2 ~]$ cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

[hadoop@slave2 ~]$ ls ~/.ssh/

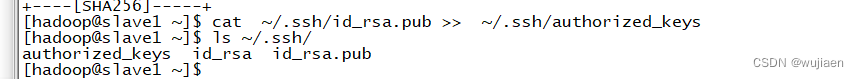

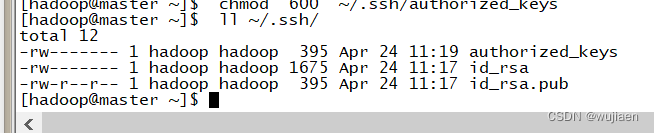

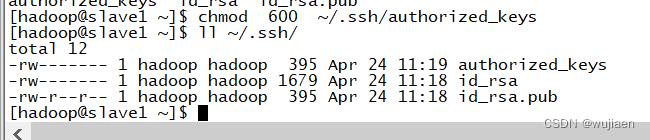

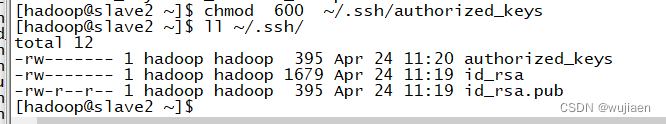

修改文件"authorized_keys"权限

通过 ll 命令查看,可以看到修改后 authorized_keys 文件的权限为“rw-------”,表示所有者 可读写,其他用户没有访问权限。如果该文件权限太大,ssh 服务会拒绝工作,出现无法 通过密钥文件进行登录认证的情况。

#master

[hadoop@master ~]$ chmod 600 ~/.ssh/authorized_keys

[hadoop@master ~]$ ll ~/.ssh/

#slave1

[hadoop@slave1 ~]$ chmod 600 ~/.ssh/authorized_keys

[hadoop@slave1 ~]$ ll ~/.ssh/

#slave2

[hadoop@slave2 ~]$ chmod 600 ~/.ssh/authorized_keys

[hadoop@slave2 ~]$ ll ~/.ssh/

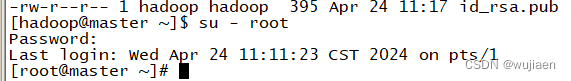

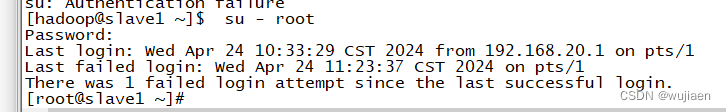

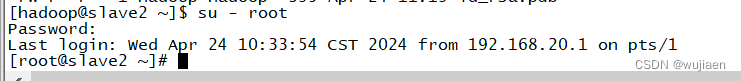

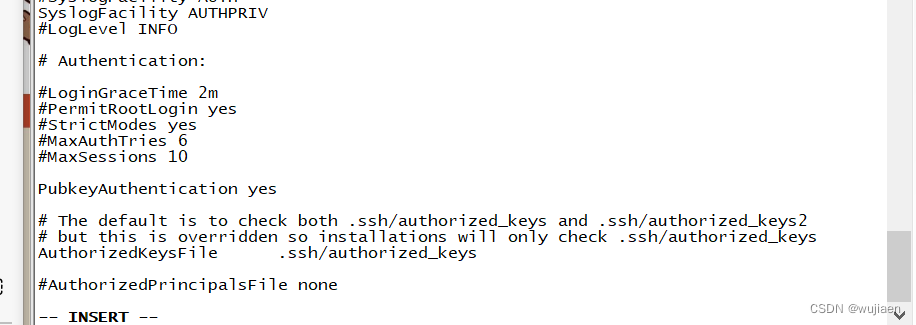

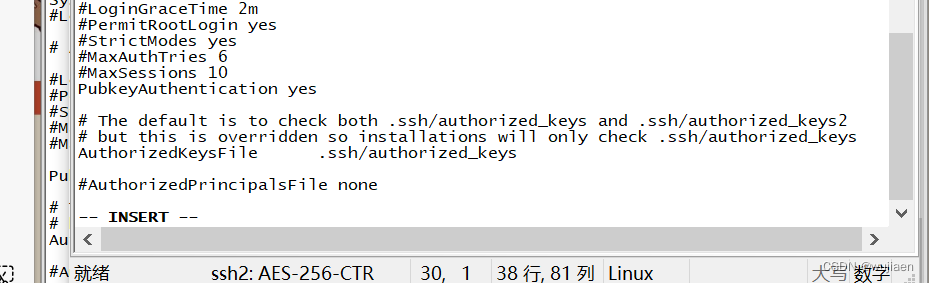

配置 SSH 服务

使用 root 用户登录,修改 SSH 配置文件"/etc/ssh/sshd_config"的下列内容,需要将该配 置字段前面的#号删除,启用公钥私钥配对认证方式。

#master

[hadoop@master ~]$ su - root

#slave1

[hadoop@ slave1 ~]$ su - root

#slave2

[hadoop@ slave2 ~]$ su - root

[root@master ~]# vi /etc/ssh/sshd_config PubkeyAuthentication yes #找到此行,并把#号注释删除。

![]()

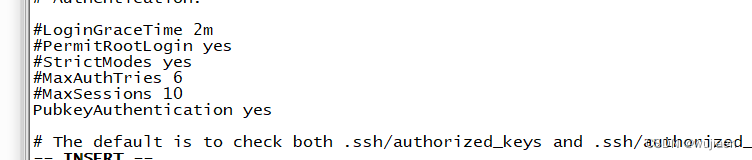

[root@ slave1 ~]# vi /etc/ssh/sshd_config PubkeyAuthentication yes #找到此行,并把#号注释删除。

![]()

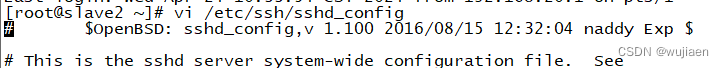

[root@ slave2 ~]# vi /etc/ssh/sshd_config PubkeyAuthentication yes #找到此行,并把#号注释删除。

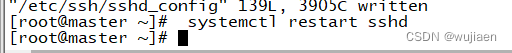

重启 SSH 服务

设置完后需要重启 SSH 服务,才能使配置生效。

[root@master ~]# systemctl restart sshd

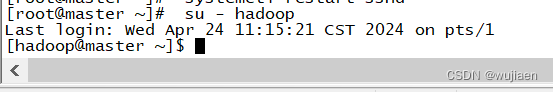

切换到 hadoop 用户

[root@master ~]# su - hadoop

验证 SSH 登录本机

在 hadoop 用户下验证能否嵌套登录本机,若可以不输入密码登录,则本机通过密钥登录 认证成功。

[hadoop@master ~]$ ssh localhost

首次登录时会提示系统无法确认 host 主机的真实性,只知道它的公钥指纹,询问用户是 否还想继续连接。需要输入“yes”,表示继续登录。第二次再登录同一个主机,则不会再 出现该提示,可以直接进行登录。 读者需要关注是否在登录过程中是否需要输入密码,不需要输入密码才表示通过密钥认 证成功。

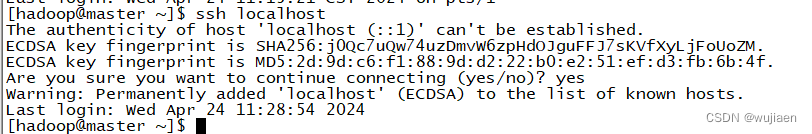

交换 SSH 密钥

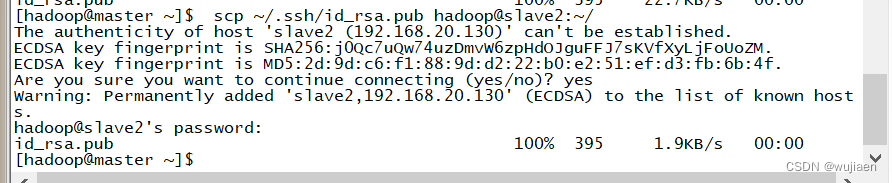

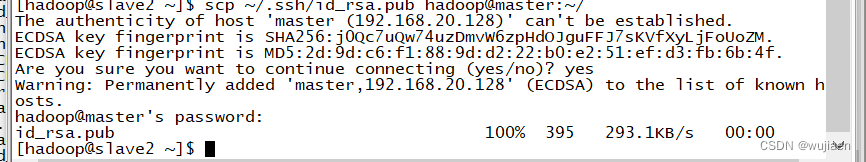

将 Master 节点的公钥 id_rsa.pub 复制到每个 Slave 点

hadoop 用户登录,通过 scp 命令实现密钥拷贝。

[hadoop@master ~]$ scp ~/.ssh/id_rsa.pub hadoop@slave1:~/

[hadoop@master ~]$ scp ~/.ssh/id_rsa.pub hadoop@slave2:~/

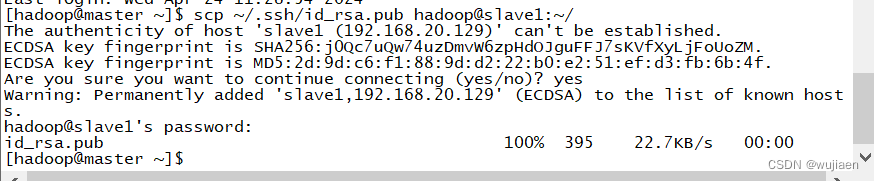

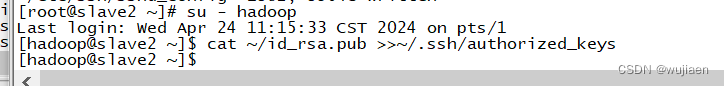

在每个 Slave 节点把 Master 节点复制的公钥复制到authorized_keys 文件

[hadoop@slave1 ~]$ cat ~/id_rsa.pub >>~/.ssh/authorized_keys

[hadoop@slave2 ~]$ cat ~/id_rsa.pub >>~/.ssh/authorized_keys

![]()

在每个 Slave 节点删除 id_rsa.pub 文件

[hadoop@slave1 ~]$ rm -rf ~/id_rsa.pub

[hadoop@slave2 ~]$ rm -rf ~/id_rsa.pub

![]()

![]()

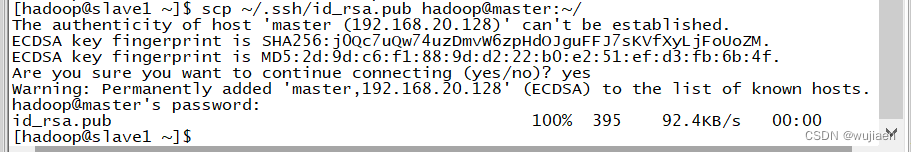

将每个 Slave 节点的公钥保存到 Master

(1)将 Slave1 节点的公钥复制到 Master

[hadoop@slave1 ~]$ scp ~/.ssh/id_rsa.pub hadoop@master:~/

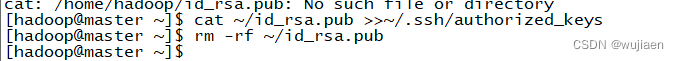

在 Master 节点把从 Slave 节点复制的公钥复制到 authorized_keys 文件

[hadoop@master ~]$ cat ~/id_rsa.pub >>~/.ssh/authorized_keys

在 Master 节点删除 id_rsa.pub 文件

[hadoop@master ~]$ rm -rf ~/id_rsa.pub

将 Slave2 节点的公钥复制到 Master

[hadoop@slave2 ~]$ scp ~/.ssh/id_rsa.pub hadoop@master:~/

验证 SSH 无密码登录

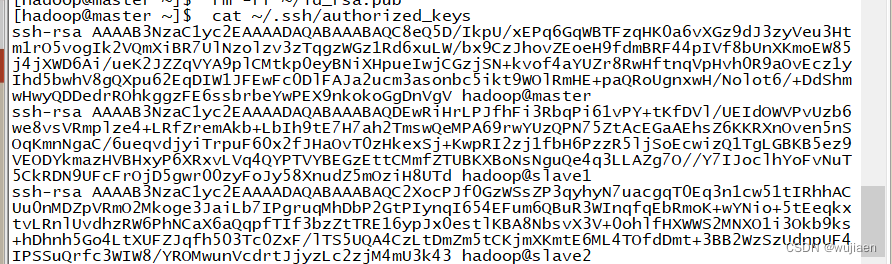

查看 Master 节点 authorized_keys 文件

[hadoop@master ~]$ cat ~/.ssh/authorized_keys

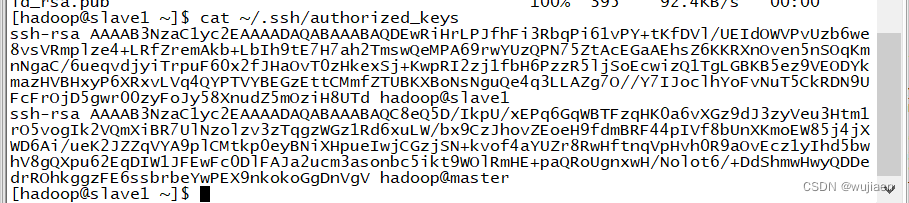

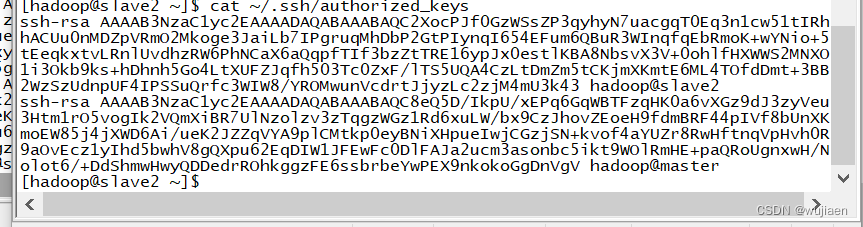

查看 Slave 节点 authorized_keys 文件

[hadoop@slave1 ~]$ cat ~/.ssh/authorized_keys

[hadoop@slave2 ~]$ cat ~/.ssh/authorized_keys

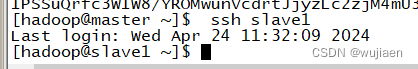

验证 Master 到每个 Slave 节点无密码登录

hadoop 用户登录 master 节点,执行 SSH 命令登录 slave1 和 slave2 节点。可以观察 到不需要输入密码即可实现 SSH 登录。

[hadoop@master ~]$ ssh slave1

Last login: Mon Nov 14 16:34:56 2022

[hadoop@slave1 ~]$

[hadoop@master ~]$ ssh slave2

Last login: Mon Nov 14 16:49:34 2022 from 192.168.47.140

[hadoop@slave2 ~]$

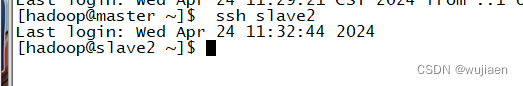

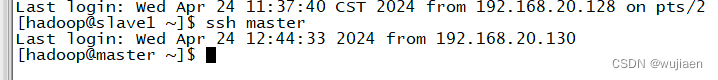

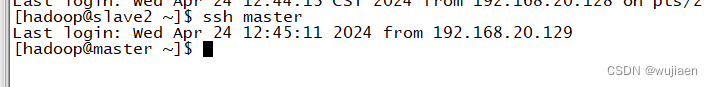

验证两个 Slave 节点到 Master 节点无密码登录

[hadoop@slave1 ~]$ ssh master

Last login: Mon Nov 14 16:30:45 2022 from ::1

[hadoop@master ~]$

[hadoop@slave2 ~]$ ssh master

Last login: Mon Nov 14 16:50:49 2022 from 192.168.47.141

[hadoop@master ~]$

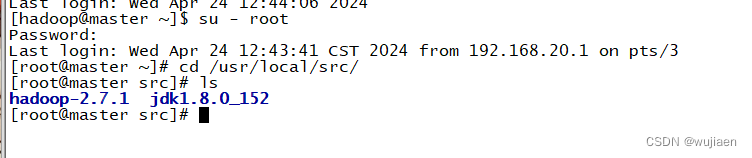

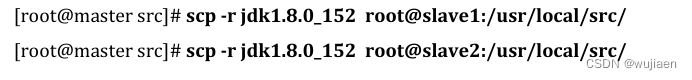

配置两个子节点slave1、slave2的JDK环境。

[root@master ~]# cd /usr/local/src/

[root@master src]# ls hadoop-2.7.1 jdk1.8.0_152

[root@master src]# scp -r jdk1.8.0_152 root@slave1:/usr/local/src/

[root@master src]# scp -r jdk1.8.0_152 root@slave2:/usr/local/src/

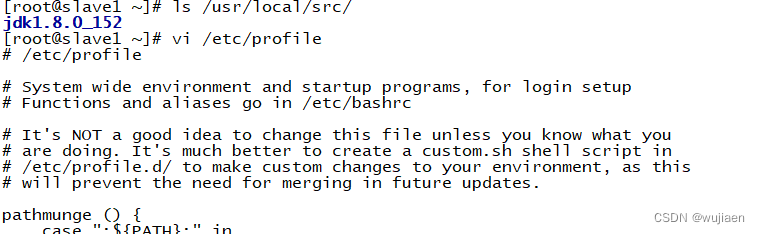

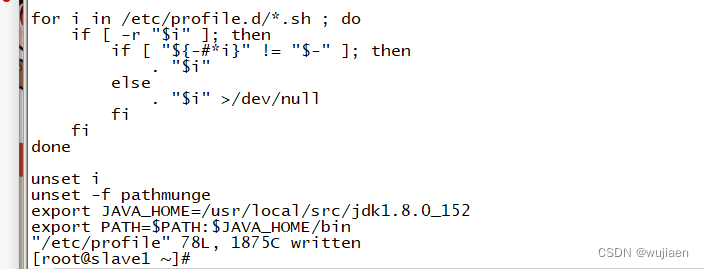

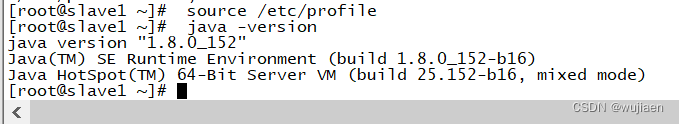

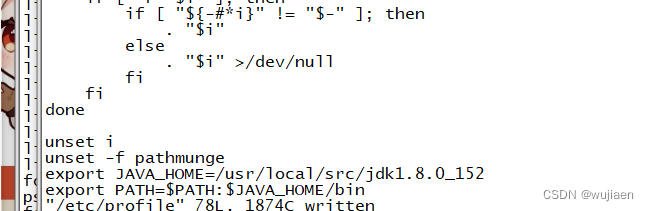

#slave1

[root@slave1 ~]# ls /usr/local/src/

jdk1.8.0_152

[root@slave1 ~]# vi /etc/profile #此文件最后添加下面两行

export JAVA_HOME=/usr/local/src/jdk1.8.0_152

export PATH=$PATH:$JAVA_HOME/bin

[root@slave1 ~]# source /etc/profile

[root@slave1 ~]# java -version

java version "1.8.0_152" Java(TM) SE Runtime Environment (build 1.8.0_152-b16) Java HotSpot(TM) 64-Bit Server VM (build 25.152-b16, mixed mode)

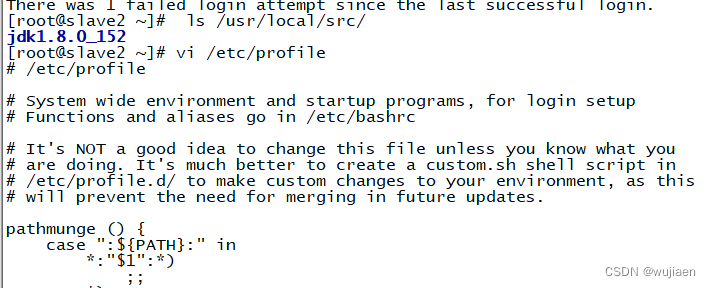

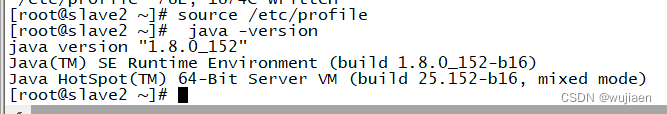

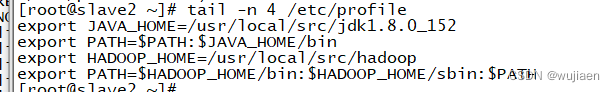

#slave2

[root@slave2 ~]# ls /usr/local/src/

jdk1.8.0_152

[root@slave2 ~]# vi /etc/profile #此文件最后添加下面两行

export JAVA_HOME=/usr/local/src/jdk1.8.0_152

export PATH=$PATH:$JAVA_HOME/bin

[root@slave2 ~]# source /etc/profile

[root@slave2 ~]# java -version

java version "1.8.0_152" Java(TM) SE Runtime Environment (build 1.8.0_152-b16) Java HotSpot(TM) 64-Bit Server VM (build 25.152-b16, mixed mode)

在 Master 节点上安装 Hadoop

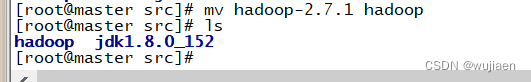

将 hadoop-2.7.1 文件夹重命名为 Hadoop

[root@master ~]# cd /usr/local/src/

[root@master src]# mv hadoop-2.7.1 hadoop

[root@master src]# ls hadoop jdk1.8.0_152

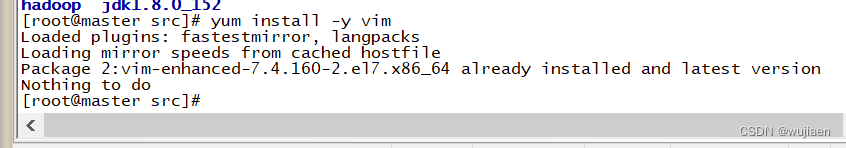

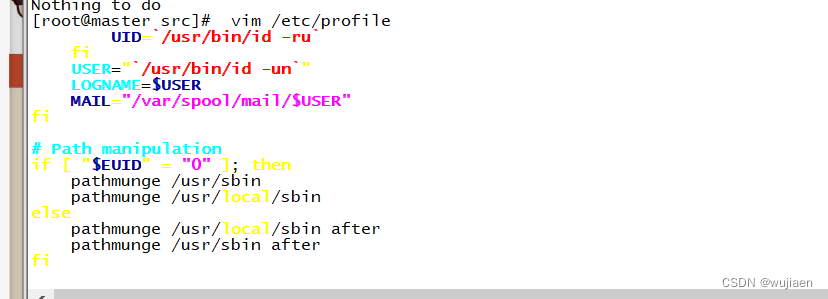

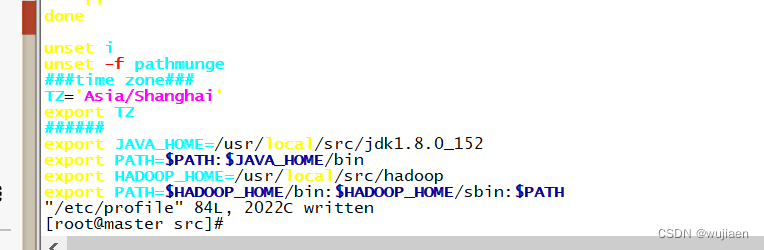

配置 Hadoop 环境变量

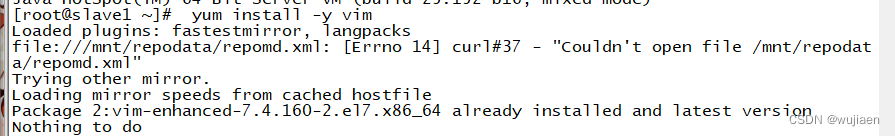

[root@master src]# yum install -y vim

[root@master src]# vim /etc/profile

[root@master src]# tail -n 4 /etc/profile

export JAVA_HOME=/usr/local/src/jdk1.8.0_152

export PATH=$PATH:$JAVA_HOME/bin

export HADOOP_HOME=/usr/local/src/hadoop

export PATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

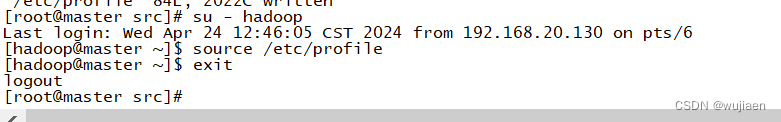

使配置的 Hadoop 的环境变量生效

[root@master src]# su - hadoop 上一次登录:一 2 月 28 15:55:37 CST 2022 从 192.168.41.143pts/1 上

[hadoop@master ~]$ source /etc/profile

[hadoop@master ~]$ exit

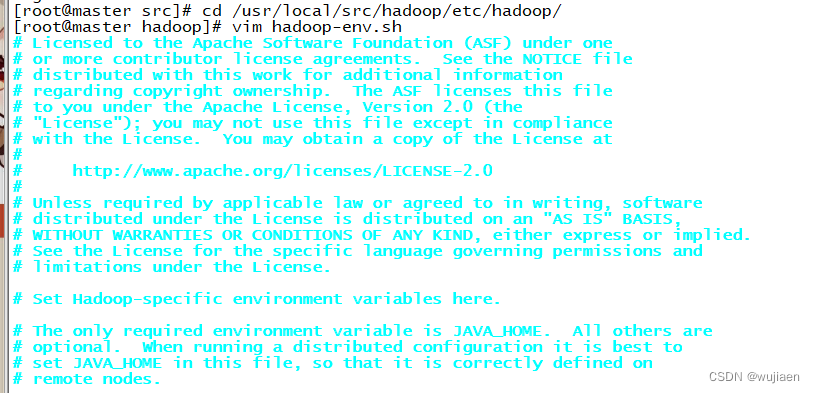

执行以下命令修改 hadoop-env.sh 配置文件

[root@master src]# cd /usr/local/src/hadoop/etc/hadoop/

[root@master hadoop]# vim hadoop-env.sh #修改以下配置

export JAVA_HOME=/usr/local/src/jdk1.8.0_152

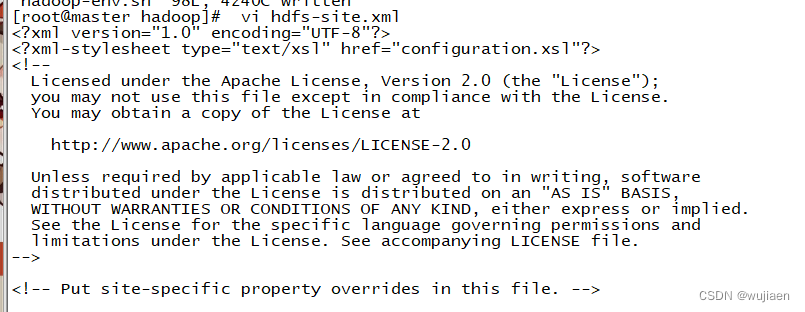

配置 hdfs-site.xml 文件参数

[root@master hadoop]# vim hdfs-site.xml #编辑以下内容

[root@master hadoop]# tail -n 14 hdfs-site.xml

配置 hdfs-site.xml 文件参数

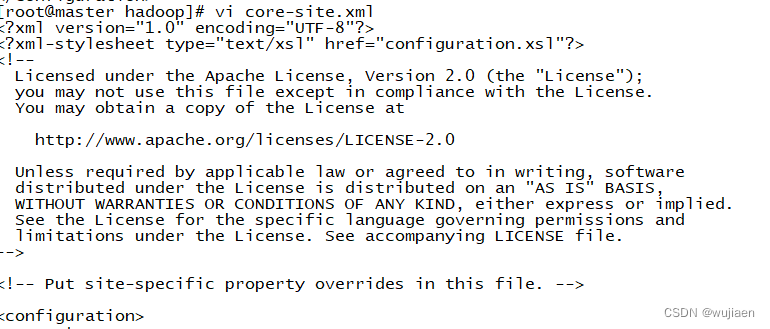

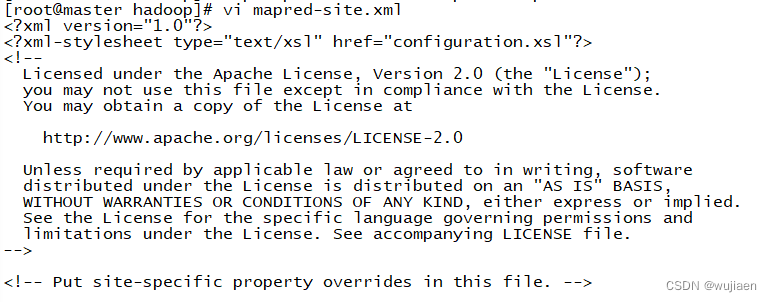

[root@master hadoop]# vim core-site.xml #编辑以下内容  [root@master hadoop]# tail -n 14 core-site.xml

[root@master hadoop]# tail -n 14 core-site.xml

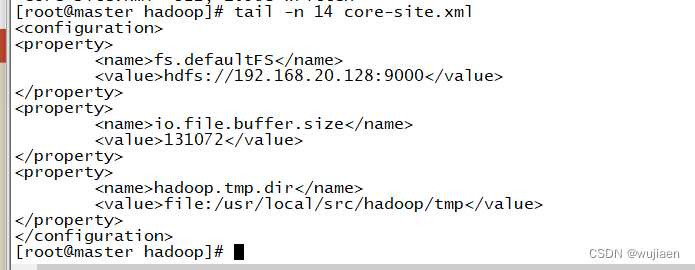

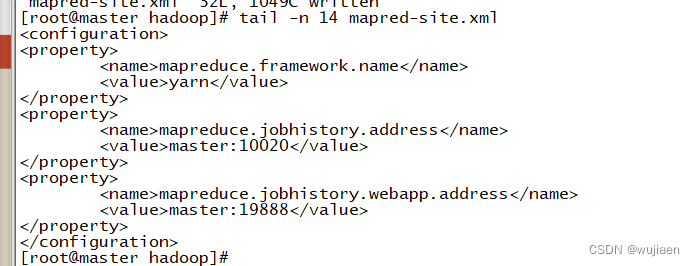

配置 mapred-site.xml

[root@master hadoop]# pwd /usr/local/src/hadoop/etc/hadoop

[root@master hadoop]# cp mapred-site.xml.template mapred-site.xm

[root@master hadoop]# vim mapred-site.xml #添加以下配置

[root@master hadoop]# tail -n 14 mapred-site.xm

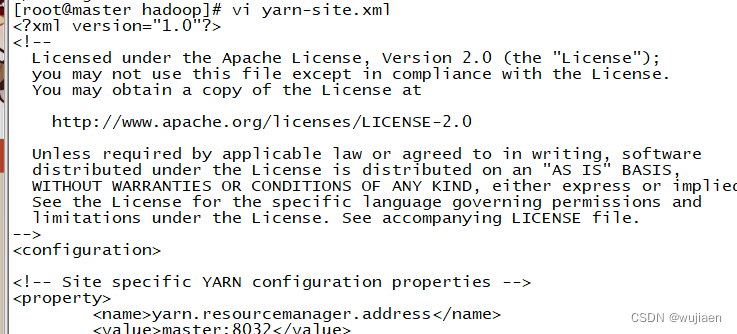

配置 yarn-site.xml

[root@master hadoop]# vim yarn-site.xml #添加以下配置

[root@master hadoop]# tail -n 32 yarn-site.xml

Hadoop 其他相关配置

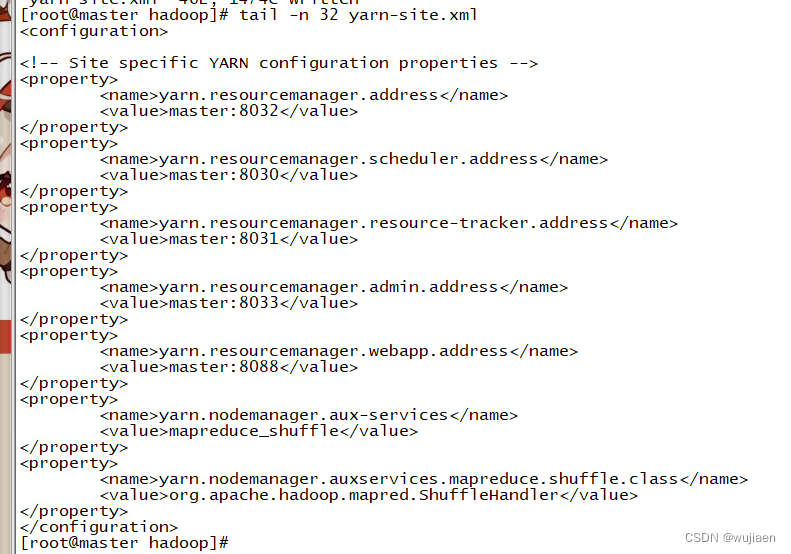

1. 配置 masters 文件

[root@master hadoop]# vim masters

[root@master hadoop]# cat masters

![]()

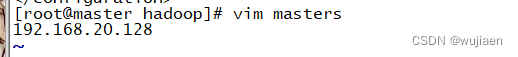

2. 配置 slaves 文件

[root@master hadoop]# vim slaves

[root@master hadoop]# cat slaves

3. 新建目录

[root@master hadoop]# mkdir /usr/local/src/hadoop/tmp

[root@master hadoop]# mkdir /usr/local/src/hadoop/dfs/name -p

[root@master hadoop]# mkdir /usr/local/src/hadoop/dfs/data -p

![]()

4. 修改目录权限

[root@master hadoop]# chown -R hadoop:hadoop /usr/local/src/hadoop/

![]()

5. 同步配置文件到 Slave 节点

[root@master ~]# scp -r /usr/local/src/hadoop/ root@slave1:/usr/local/src/

![]()

[root@master ~]# scp -r /usr/local/src/hadoop/ root@slave2:/usr/local/src/

![]()

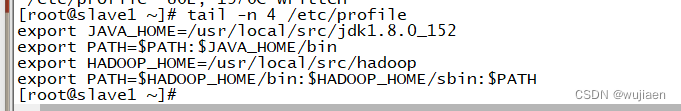

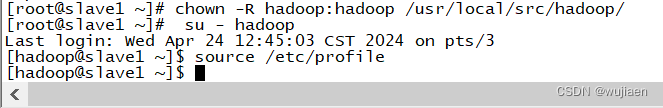

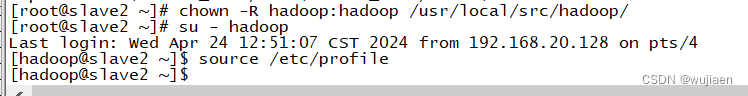

#slave1 配置

[root@slave1 ~]# yum install -y vim

[root@slave1 ~]# vim /etc/profile

[root@slave1 ~]# tail -n 4 /etc/profile

[root@slave1 ~]# chown -R hadoop:hadoop /usr/local/src/hadoop/

[root@slave1 ~]# su - hadoop

[hadoop@slave1 ~]$ source /etc/profile

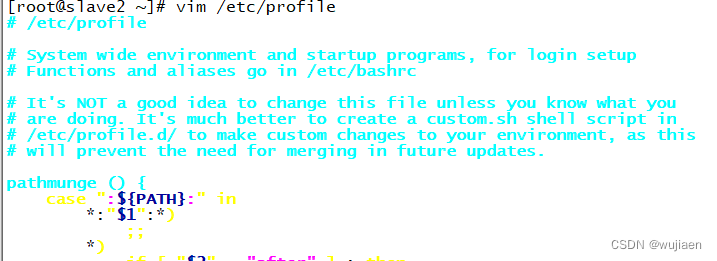

#slave2 配置

[root@slave2 ~]# yum install -y vim

[root@slave2 ~]# vim /etc/profile

[root@slave2 ~]# tail -n 4 /etc/profile

[root@slave2 ~]# chown -R hadoop:hadoop /usr/local/src/hadoop/

[root@slave2 ~]# su - hadoop

[hadoop@slave2 ~]$ source /etc/profile

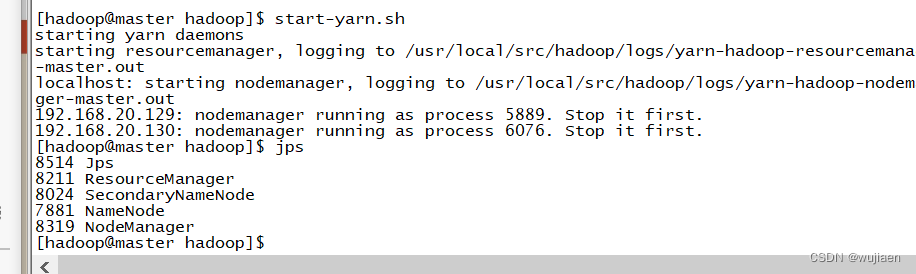

hadoop 集群运行

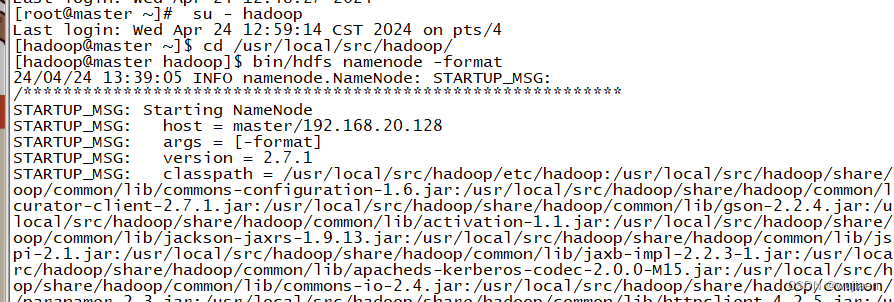

配置 Hadoop 格式化

NameNode 格式化

将 NameNode 上的数据清零,第一次启动 HDFS 时要进行格式化,以后启动无 需再格式化,否则会缺失 DataNode 进程。另外,只要运行过 HDFS,Hadoop 的 工作目录(本书设置为/usr/local/src/hadoop/tmp)就会有数据,如果需要重 新格式化,则在格式化之前一定要先删除工作目录下的数据,否则格式化时会 出问题。

执行如下命令,格式化 NameNode

[root@master ~]# su – hadoop

[hadoop@master ~]# cd /usr/local/src/hadoop/

[hadoop@master hadoop]$ bin/hdfs namenode –format

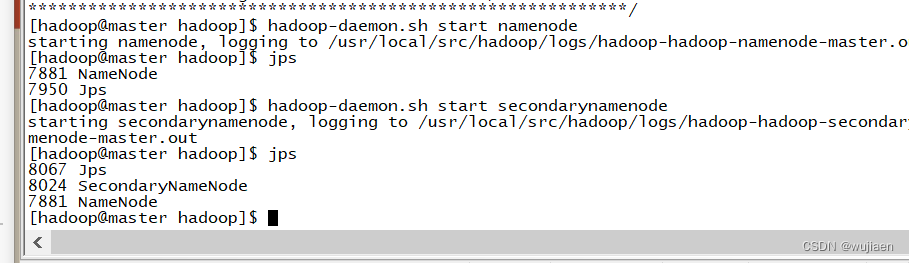

启动 NameNode

执行如下命令,启动 NameNode:

[hadoop@master hadoop]$ hadoop-daemon.sh start namenode

查看 Java 进程 启动完成后,可以使用 JPS 命令查看是否成功。JPS 命令是 Java 提供的一个显示当前所有 Java 进程 pid 的命令。

[hadoop@master hadoop]$ jps

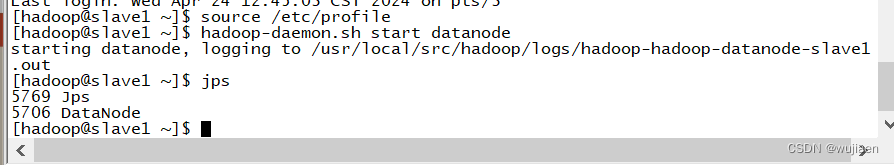

slave节点 启动 DataNode 执行如下命令,启动 DataNode:

[hadoop@slave1 hadoop]$ hadoop-daemon.sh start datanode

[hadoop@slave2 hadoop]$ hadoop-daemon.sh start datanode

启动 SecondaryNameNode

执行如下命令,启动 SecondaryNameNode:

[hadoop@master hadoop]$ hadoop-daemon.sh start secondarynamenode

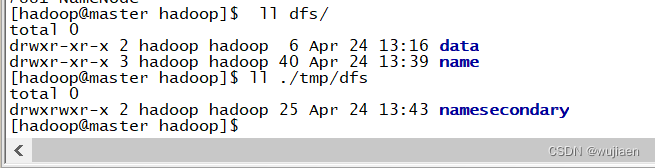

查看 HDFS 数据存放位置: 执行如下命令,查看 Hadoop 工作目录:

[hadoop@master hadoop]$ ll dfs/

[hadoop@master hadoop]$ ll ./tmp/dfs

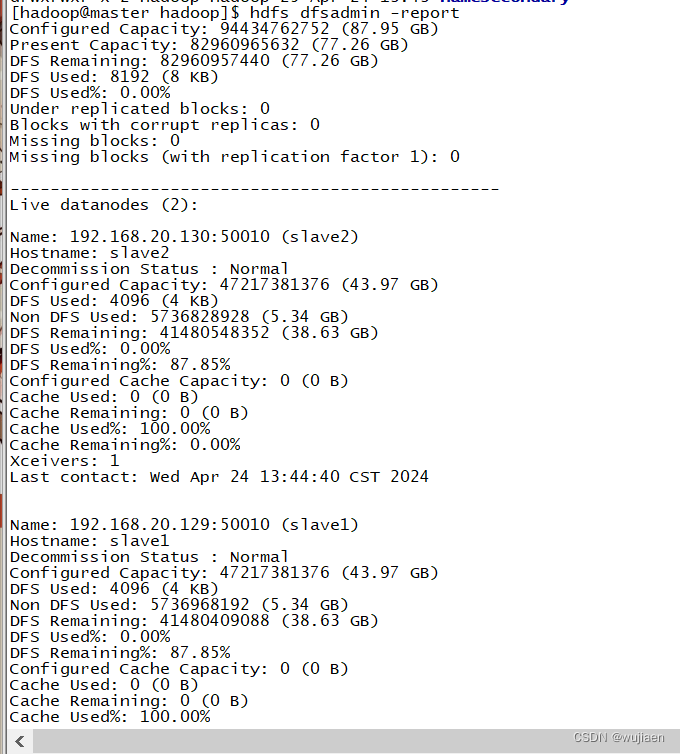

查看 HDFS 的报告

[hadoop@master sbin]$ hdfs dfsadmin -report

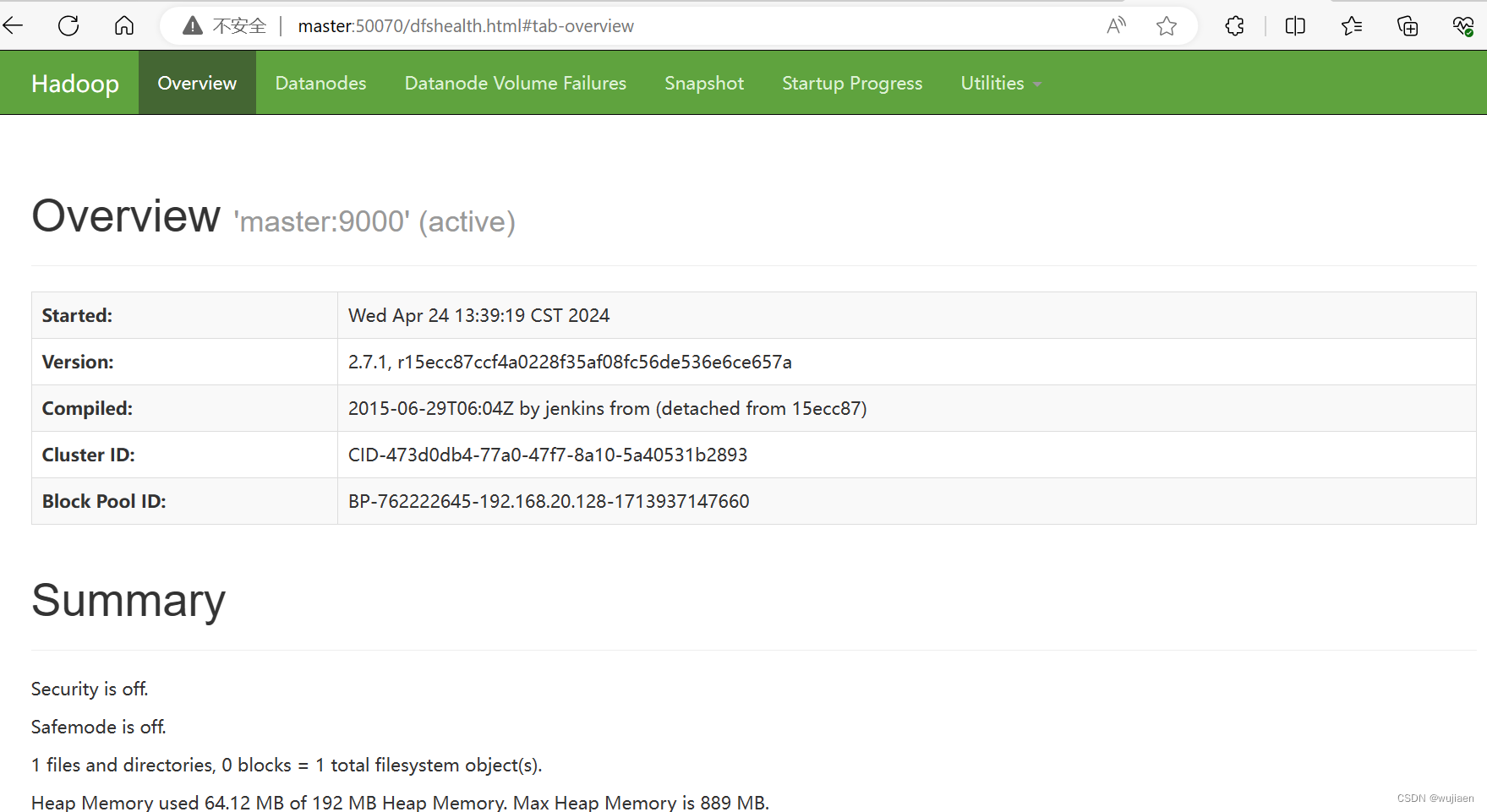

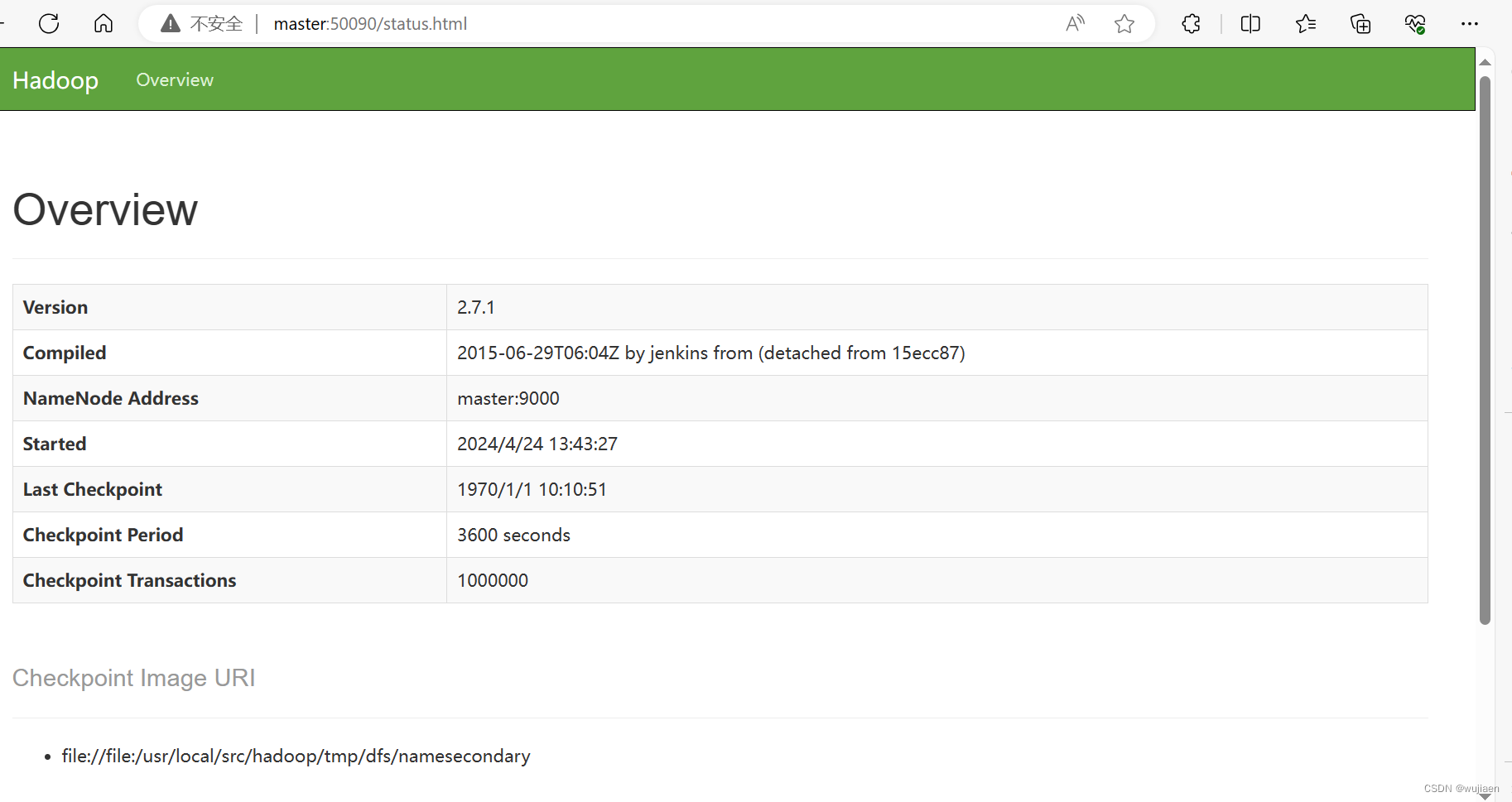

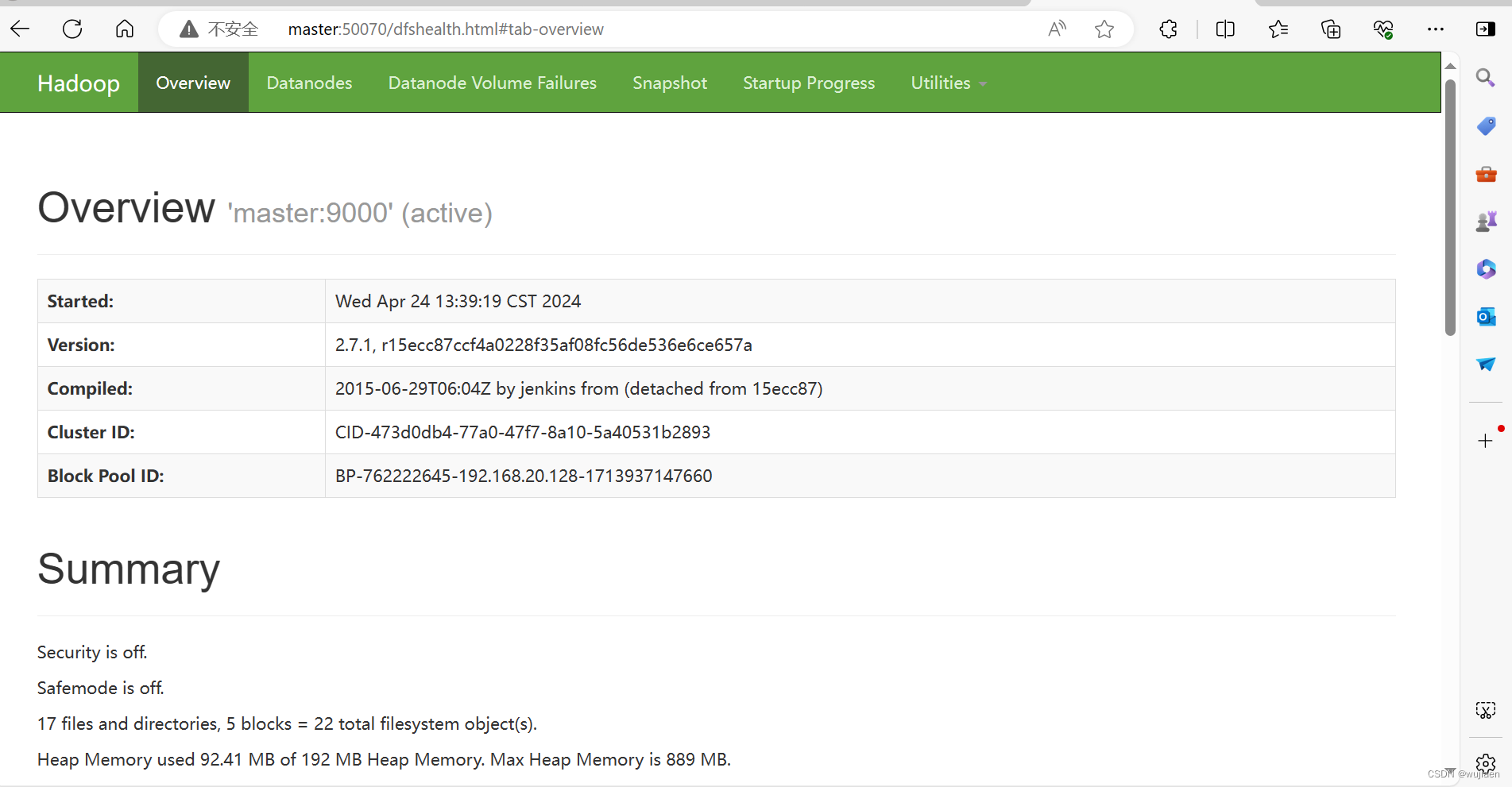

使用浏览器查看节点状态

在浏览器的地址栏输入http://master:50070,进入页面可以查看NameNode和DataNode 信息

在浏览器的地址栏输入 http://master:50090,进入页面可以查看 SecondaryNameNode信息

可以使用 start-dfs.sh 命令启动 HDFS。这时需要配置 SSH 免密码登录,否则在 启动过程中系统将多次要求确认连接和输入 Hadoop 用户密码。

[hadoop@master hadoop]$ stop-dfs.sh

[hadoop@master hadoop]$ start-dfs.sh

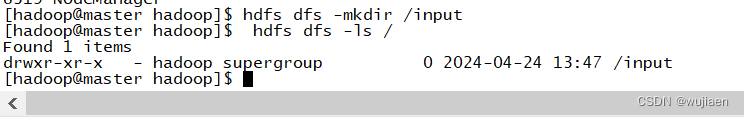

在 HDFS 文件系统中创建数据输入目录

[hadoop@master hadoop]$ hdfs dfs -mkdir /input

[hadoop@master hadoop]$ hdfs dfs -ls /

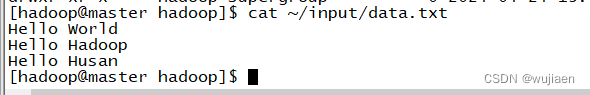

将输入数据文件复制到 HDFS 的/input 目录中 测试用数据文件仍然是上一节所用的测试数据文件~/input/data.txt,内容如下所示。

[hadoop@master hadoop]$ cat ~/input/data.txt Hello World Hello Hadoop Hello Huasan

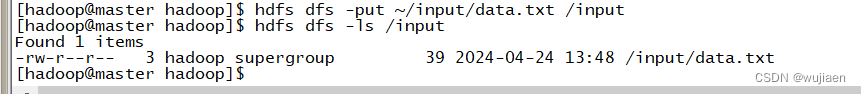

执行如下命令,将输入数据文件复制到 HDFS 的/input 目录中:

[hadoop@master hadoop]$ hdfs dfs -put ~/input/data.txt /input 确认文件已复制到 HDFS 的/input 目录:

[hadoop@master hadoop]$ hdfs dfs -ls /input

运行 WordCount 案例,计算数据文件中各单词的频度

[hadoop@master hadoop]$ hdfs dfs -mkdir /output

先执行如下命令查看 HDFS 中的文件:

[hadoop@master hadoop]$ hdfs dfs -ls /

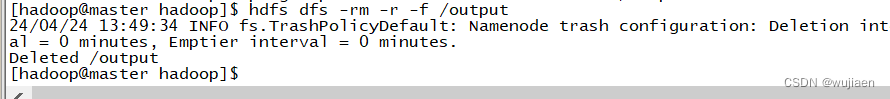

[hadoop@master hadoop]$ hdfs dfs -rm -r -f /output

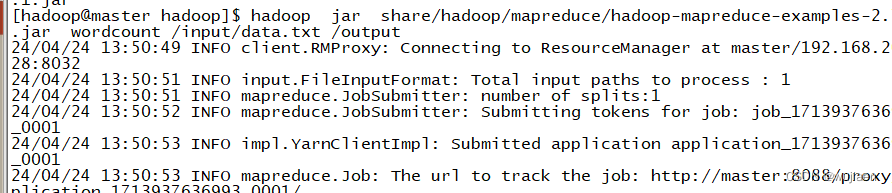

[hadoop@master hadoop]$ hadoop jar share/hadoop/mapreduce/hado mapreduce op-- -examples-2.7.1.jar wordcount /input/data.txt /output

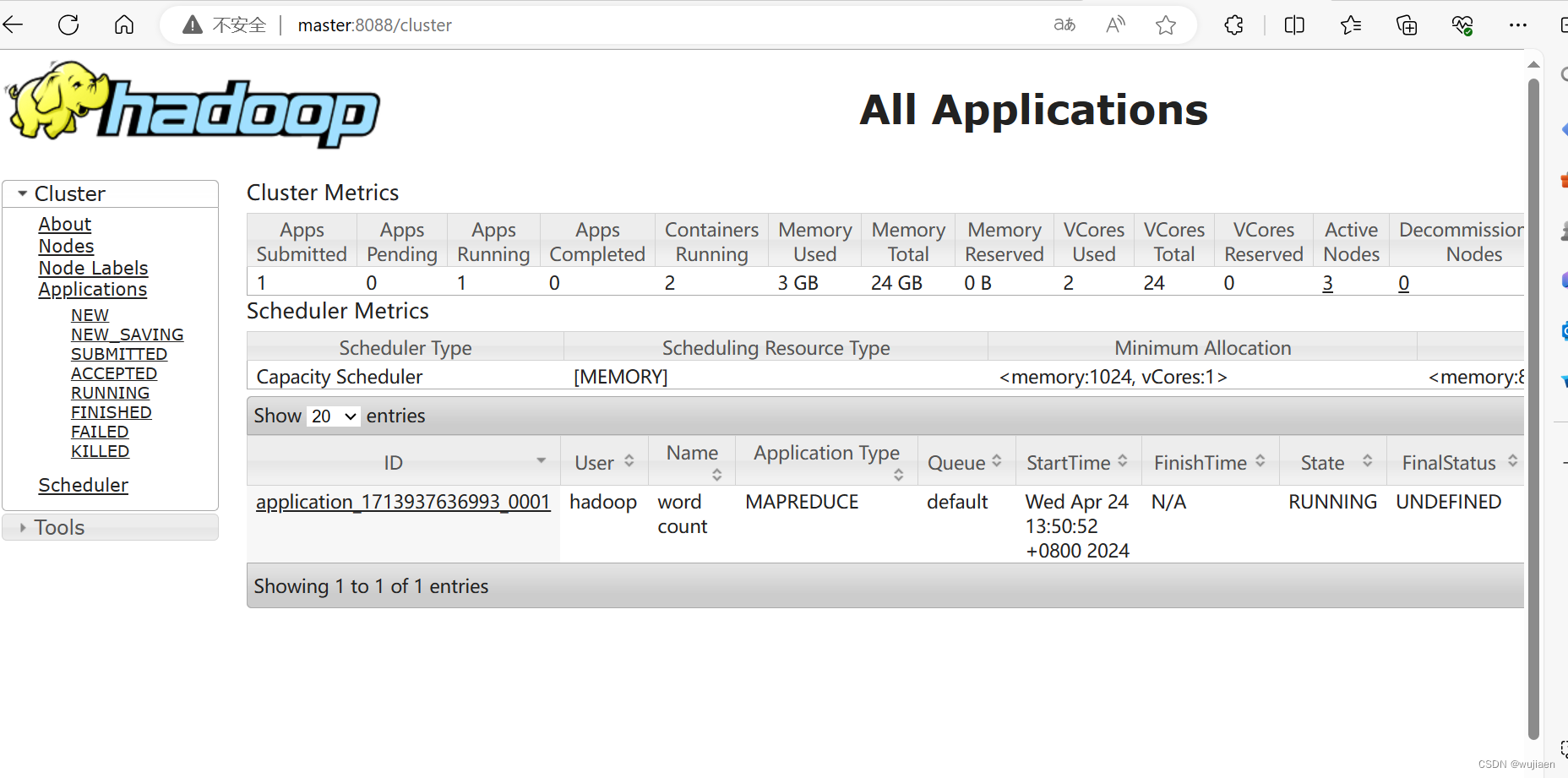

由上述信息可知 MapReduce 程序提交了一个作业,作业先进行 Map,再进行 Reduce 操作。 MapReduce 作业运行过程也可以在 YARN 集群网页中查看。在浏 览器的地址栏输入:http://master:8088

除了可以用 HDFS 命令查看 HDFS 文件系统中的内容,也可使用网页查看 HDFS 文件 系统。在浏览器的地址栏输入 http://master:50070,进入页面,在 Utilities 菜单中 选择 Browse the file system,可以查看 HDFS 文件系统内容。查看 HDFS 的根目录,可以看到 HDFS 根目录中有三个目录,input、output 和 tmp。

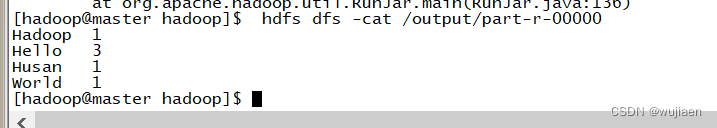

可以使用 HDFS 命令直接查看 part-r-00000 文件内容,结果如下所示:

[hadoop@master hadoop]$ hdfs dfs -cat /output/part-r-00000 50

Hadoop 1

Hello 3

Huasan 1

World 1

可以看出统计结果正确,说明 Hadoop 运行正常。

Hive 组件安装配置

下载和解压安装文件

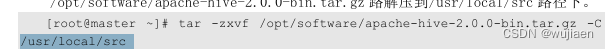

解压安装文件

(1)使用 root 用户,将 Hive 安装包 /opt/software/apache-hive-2.0.0-bin.tar.gz 路解压到/usr/local/src 路径下。

[root@master ~]# tar -zxvf /opt/software/apache-hive-2.0.0-bin.tar.gz -C /usr/local/src

(2)将解压后的 apache-hive-2.0.0-bin 文件夹更名为 hive;

[root@master ~]# mv /usr/local/src/apache-hive-2.0.0-bin usr/local/src/hive

![]()

(3)修改 hive 目录归属用户和用户组为 hadoop [root@master ~]# chown -R hadoop:hadoop /usr/local/src/hive

![]()

设置 Hive 环境

(1)关闭 Linux 系统防火墙,并将防火墙设定为系统开机并不自动启动。

# 关闭防火墙服务

[root@master ~]# systemctl stop firewalld

# 设置防火墙服务开机不启动

[root@master ~]# systemctl disable firewalld

![]()

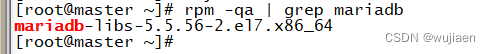

(2)卸载 Linux 系统自带的 MariaDB。

(1)首先查看 Linux 系统中 MariaDB 的安装情况。

# 查询已安装的 mariadb 软件包

[root@ master ~]# rpm -qa | grep mariadb

2)卸载 MariaDB 软件包。 # 卸载 mariadb 软件包

[root@master ~]# rpm -e --nodeps mariadb-libs-5.5.56-2.el7.x86_64

![]()

安装 MySQL 数据库

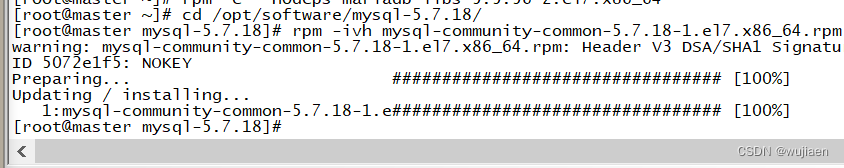

(1)按如下顺序依次按照 MySQL 数据库的 mysql common、mysql libs、mysql client 软件包。 # MySQL 软件包路径

[root@master ~]# cd /opt/software/mysql-5.7.18/

[root@master ~]# rpm -ivh mysql-community-common-5.7.18-1.el7.x86_64.rpm

[root@master ~]# rpm -ivh mysql-community-libs-5.7.18-1.el7.x86_64.rpm

[root@master ~]# rpm -ivh mysql-community-client-5.7.18-1.el7.x86_64.rpm

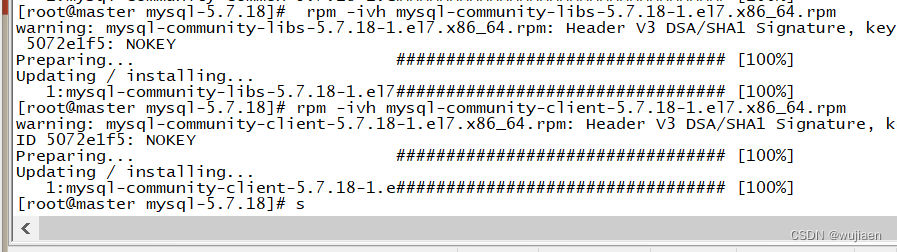

(2)安装 mysql server 软件包。

[root@master ~]# rpm -ivh mysql-community-server-5.7.18-1.el7.x86_64.rpm

(3)修改

将以下配置信息添加到/etc/my.cnf 文件 symbolic-links=0 配置信息的下方。 default-storage-engine=innodb innodb_file_per_table collation-server=utf8_general_ci init-connect='SET NAMES utf8' character-set-server=utf8 MySQL 数据库配置,在/etc/my.cnf 文件中添加如表 6-1 所示的 MySQL 数据 库配置项。

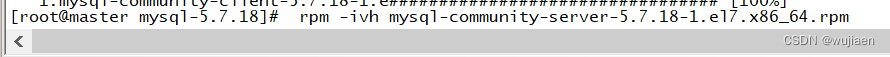

(4)启动 MySQL 数据库。

[root@master ~]# systemctl start mysqld

(5)查询 MySQL 数据库状态。mysqld 进程状态为 active (running),则表示 MySQL 数 据库正常运行。 如果 mysqld 进程状态为 failed,则表示 MySQL 数据库启动异常。此时需要排查 /etc/my.cnf 文件。

[root@master ~]# systemctl status mysqld

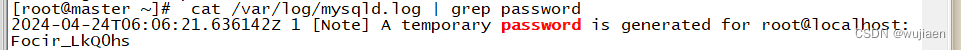

(6)查询 MySQL 数据库默认密码。 MySQL 数据库安装后的默认密码保存在/var/log/mysqld.log 文件中,在该文件中以 password 关键字搜索默认密码。

[root@master ~]# cat /var/log/mysqld.log | grep password

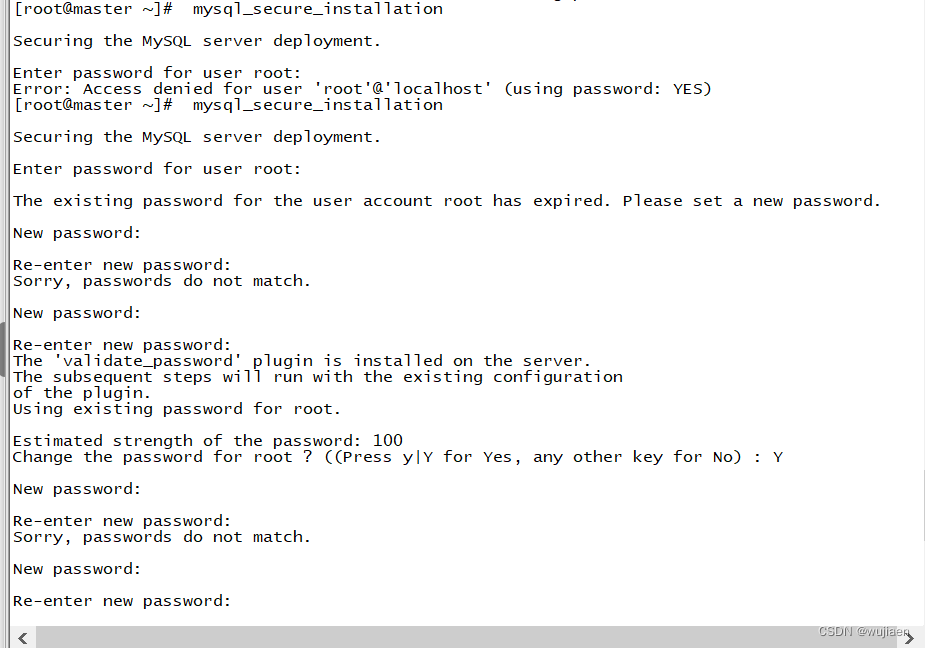

(7)MySQL 数据库初始化。 执行 mysql_secure_installation 命令初始化 MySQL 数据库,初始化过程中需要设定 数据库 root 用户登录密码,密码需符合安全规则,包括大小写字符、数字和特殊符号, 可设定密码为 Password123$。 在进行 MySQL 数据库初始化过程中会出现以下交互确认信息:

1)Change the password for root ? ((Press y|Y for Yes, any other key for No)表示是否更改 root 用户密码,在键盘输入 y 和回车。

2)Do you wish to continue with the password provided?(Press y|Y for Yes, any other key for No)表示是否使用设定的密码继续,在键盘输入 y 和回车。

3)Remove anonymous users? (Press y|Y for Yes, any other key for No)表示是 否删除匿名用户,在键盘输入 y 和回车。

4)Disallow root login remotely? (Press y|Y for Yes, any other key for No) 表示是否拒绝 root 用户远程登录,在键盘输入 n 和回车,表示允许 root 用户远程登录。

5)Remove test database and access to it? (Press y|Y for Yes, any other key for No)表示是否删除测试数据库,在键盘输入 y 和回车。

6)Reload privilege tables now? (Press y|Y for Yes, any other key for No) 表示是否重新加载授权表,在键盘输入 y 和回车。

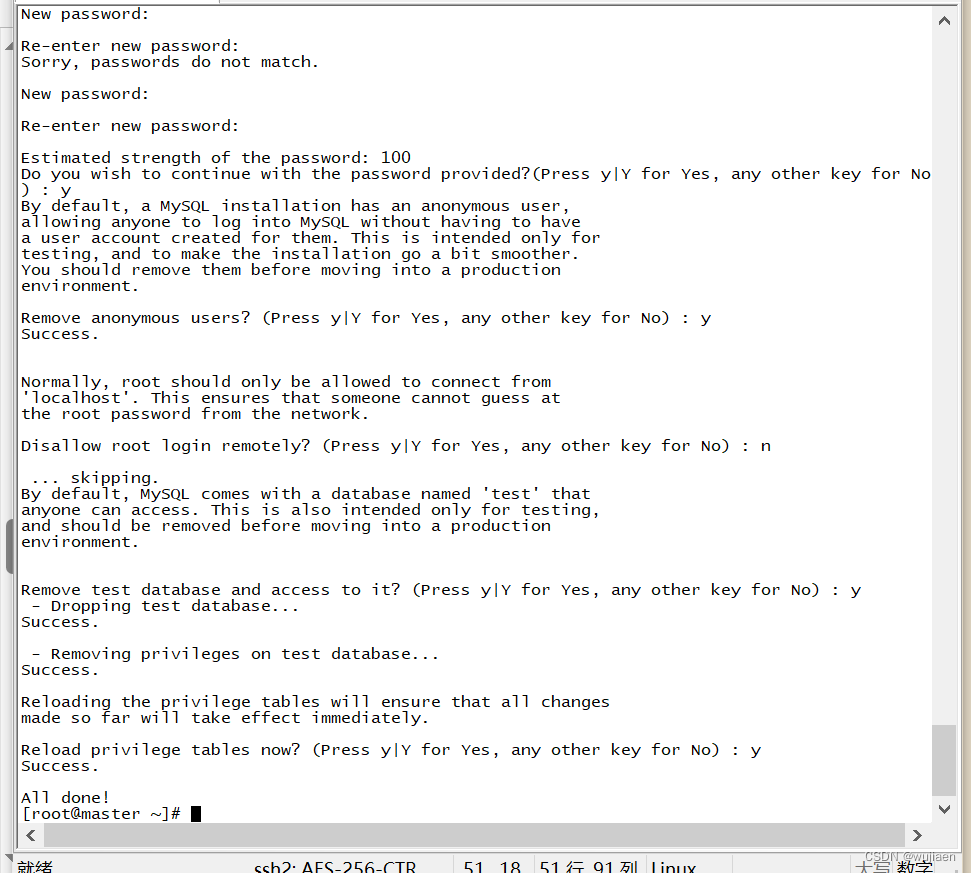

(8)添加 root 用户从本地和远程访问 MySQL 数据库表单的授权。

[root@master ~]# mysql -uroot -p

配置 Hive 组件

(1)设置 Hive 环境变量并使其生效。

# 在文件末尾追加以下配置内容

[root@master ~]# vi /etc/profile # set hive environment

export HIVE_HOME=/usr/local/src/hive

export PATH=$PATH:$HIVE_HOME/bin

# 使环境变量配置生效

[root@master ~]# source /etc/profile

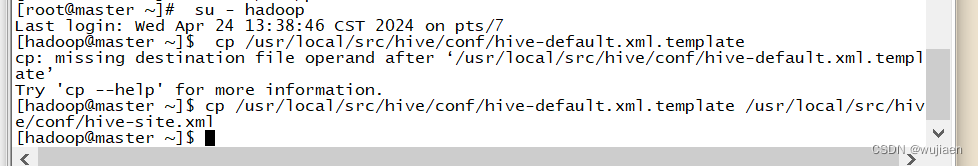

(2)修改 Hive 组件配置文件。 切换到 hadoop 用户执行以下对 Hive 组件的配置操作。 将/usr/local/src/hive/conf 文件夹下 hive-default.xml.template 文件,更名为 hive-site.xml。 [root@master ~]# su - hadoop

[hadoop@master ~]$ cp /usr/local/src/hive/conf/hive-default.xml.template /usr/local/src/hive/conf/hive-site.xml

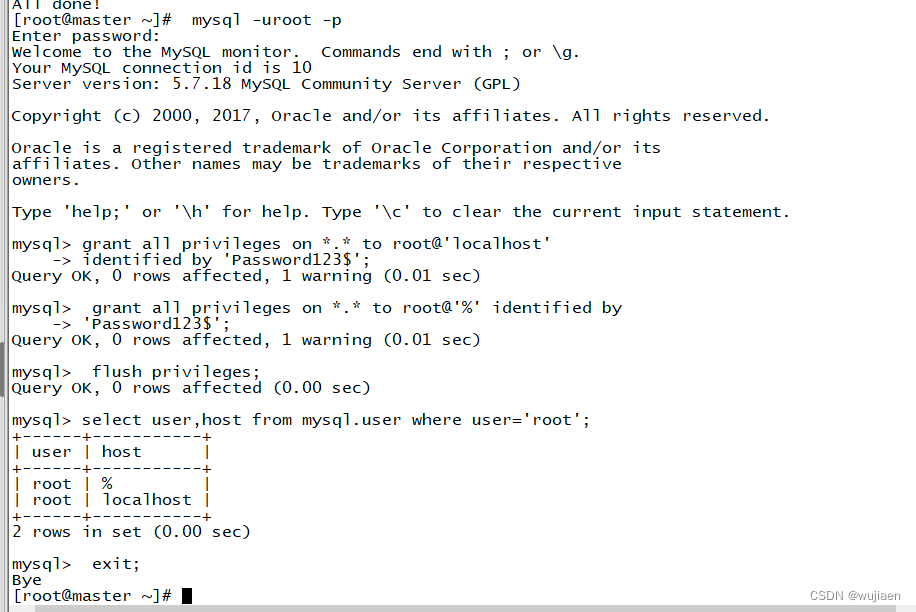

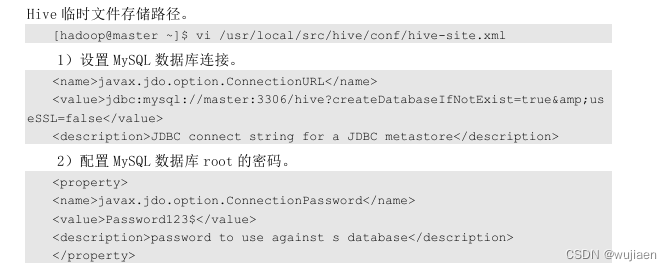

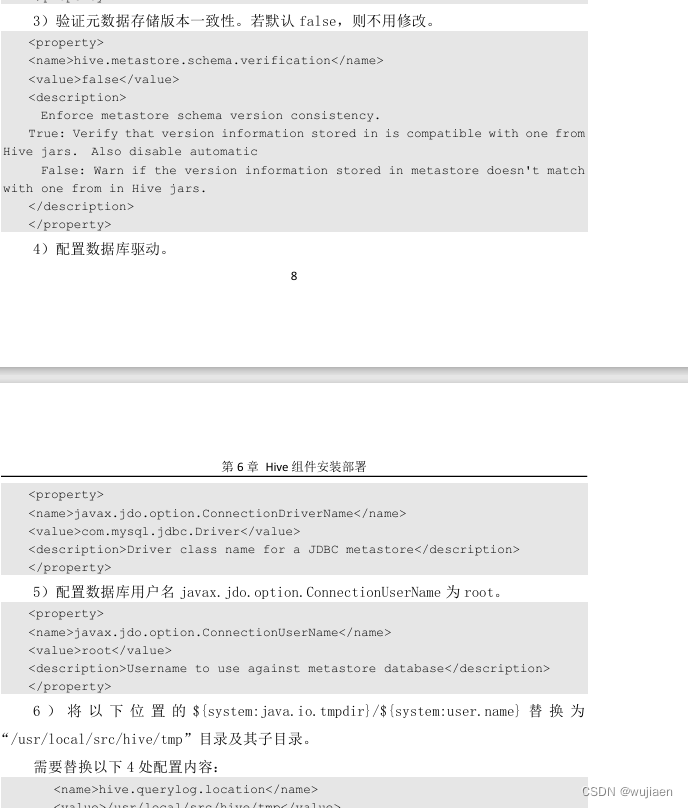

(3)通过 vi 编辑器修改 hive-site.xml 文件实现 Hive 连接 MySQL 数据库,并设定 Hive 临时文件存储路径。

[hadoop@master ~]$ vi /usr/local/src/hive/conf/hive-site.xml

![]()

初始化 hive 元数

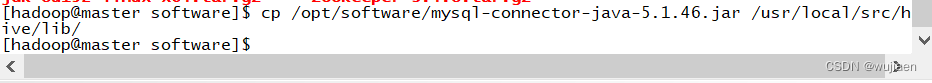

1)将 MySQL 数据库驱动(/opt/software/mysql-connector-java-5.1.46.jar)拷贝到 Hive 安装目录的 lib 下;

[hadoop@master ~]$ cp /opt/software/mysql-connector-java-5.1.46.jar /usr/local/src/hive/lib/

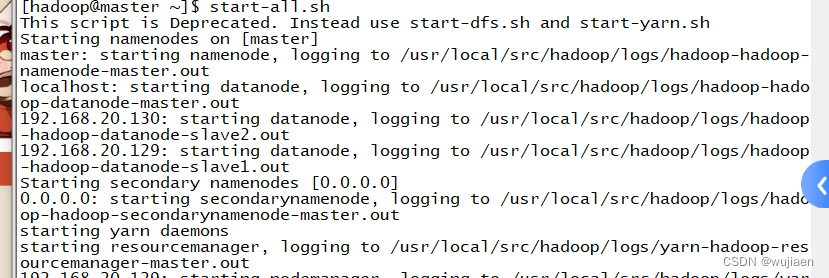

2)重新启动 hadooop 即可

[hadoop@master lib]$ stop-all.sh

[hadoop@master lib]$ start-all.sh

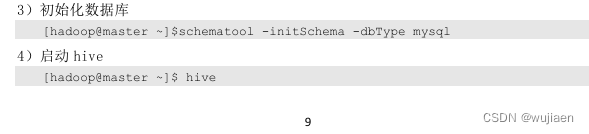

3)初始化数据库 [hadoop@master ~]$schematool -initSchema -dbType mysql

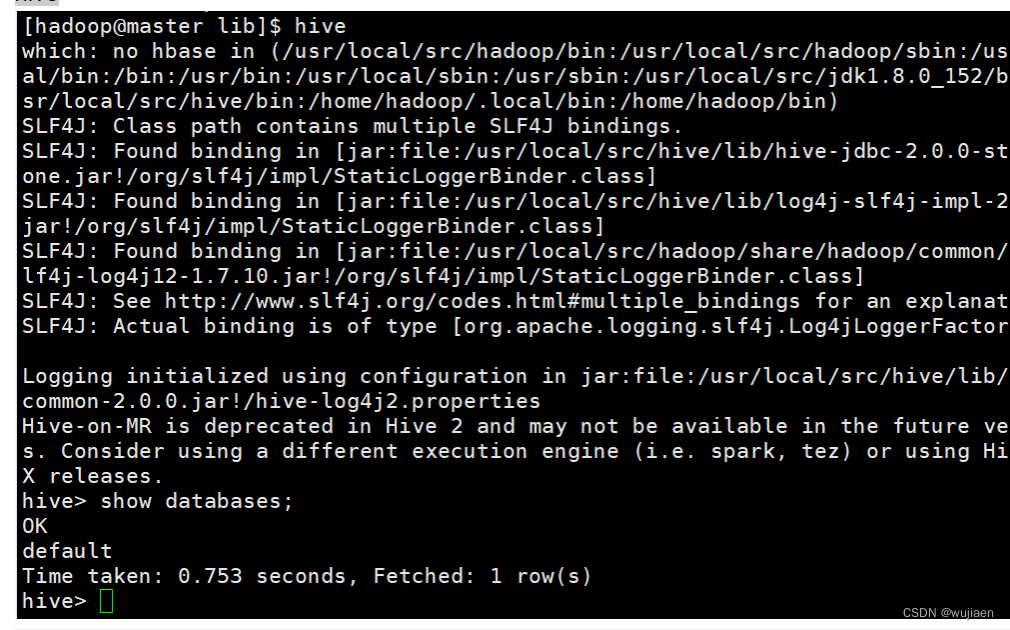

4)启动 hive [hadoop@master ~]$ hive

827

827

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?