前言:

Elk日志分析系统:

概念 :elk是一套完整的日志集中处理方案,由三个开源的软件简称组成:

E:elasticSearch ES是一个开源的,分布式的存储检索引擎(索引的非关系型数据库),存储日志

是基于Java代码开发的,基于lucence结构开发的发一套全文检索引擎,拥有一个web接口,用户可以通过浏览器的形式和ES组件进行通信

作用:存储,允许全文搜索,结构化搜索(索引点),索引点可以支持大容量的日志数据,也可以所有不同类型的文档

K:kiabana图形化界面,可以更好的分析存储在ES上的日志数据,提供了一个图形化的界面,来浏览ES上的日志数据,汇总,分析,搜索

L:logstash数据搜索引擎,支持动态的(实时的)从各种服务应用收集日志资源,还可以对收集到的日志进行过滤,分析,丰富,统一格式等等操作,然后把数据同步到ES存储引擎

他是由一个Ruby语言编写的,运行在Java虚拟机上的一个强大的数据处理工具,数据传输,格式化处理,格式化输出,主要用来处理日志

一些数据收集工具:

Fliebeat轻量级的开源的,日志收集共计,收集的速度比较快,但是没有数据分析的能力和过滤能力,一般和logstash结合使用

Kafka中间消息队列

rabbitMQ中间件消息队列

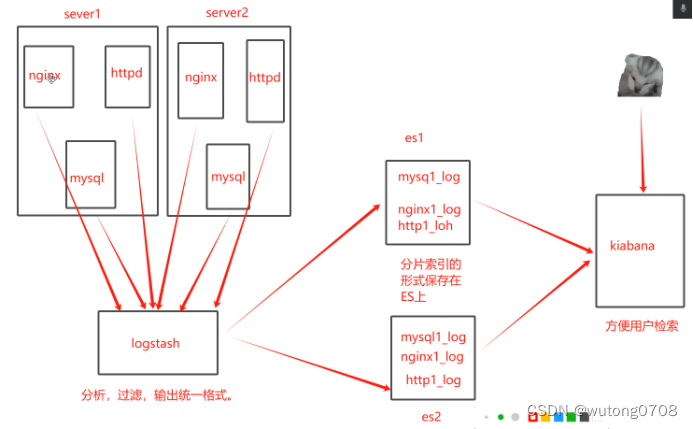

架构图:

Elk的核心作用:

当我们管理一个大集群时,需要分析和定位的日志很多,每台服务器分别去分析,将会耗时耗力,所以我们应运而生了一个elk,一个日志分析系统,极大的分太高了定位问题的效率

日志系统的特征:

- 收集,可以收集基本上市面上常用的软件日志

- 传输,收集到的日志需要发送到ES上

- 存储,ES负载存储数据

- UI:图形化界面(kiabanna)

实验部分:

用到三台主机:

Es:20.0.0.52

Es2:20.0.0.53

Logstash kiabanna 20.0.0.51(4核8G)

三台组件最要2核4G,Logstash kiabanna建议4核8G

前提:

systemctl stop firewalld

setenforce 0

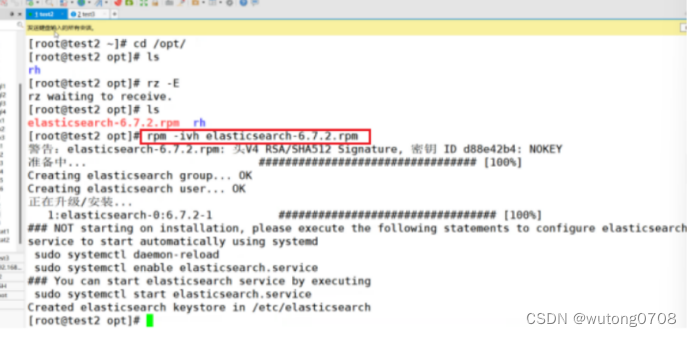

两台ES虚拟机:

环境准备

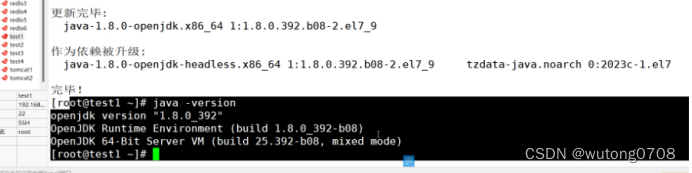

#设置Java环境

java -version #如果没有安装,yum -y install java

openjdk version "1.8.0_131"

OpenJDK Runtime Environment (build 1.8.0_131-b12)

OpenJDK 64-Bit Server VM (build 25.131-b12, mixed mode)

两台ES操作:

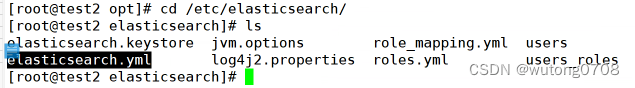

进入配置文件

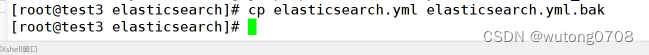

cp /etc/elasticsearch/elasticsearch.yml /etc/elasticsearch/elasticsearch.yml.bak

vim /etc/elasticsearch/elasticsearch.yml

分别对2,3配置文件修改

vim /etc/elasticsearch/elasticsearch.yml

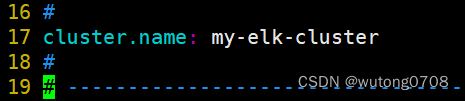

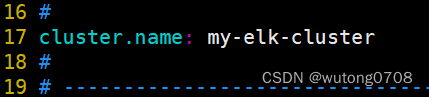

17行,空格要保留

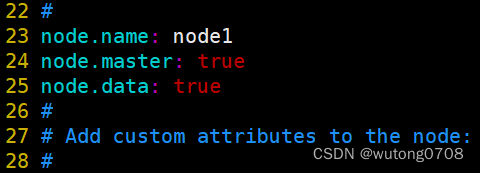

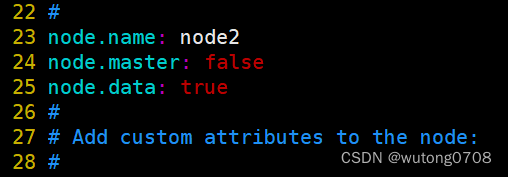

名字不能重复

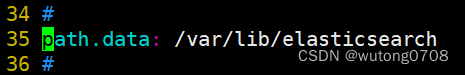

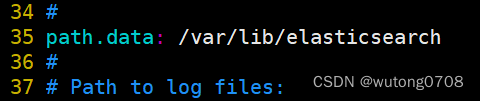

取消注释,指定数据存放路径(可以修改,一般设置为/opt/log)

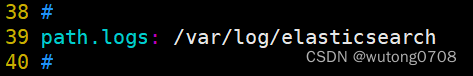

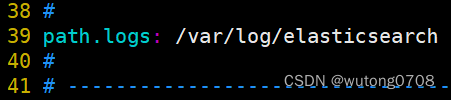

取消注释,指定日志存放路径

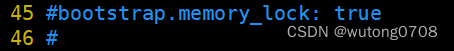

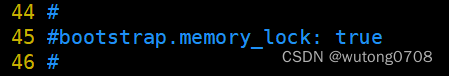

取消注释,避免es使用swap交换分区(必要情况下,将他注释,这里将他注释)

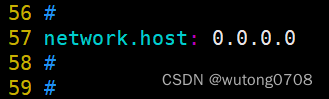

取消注释,设置监听地址,0.0.0.0代表所有地址

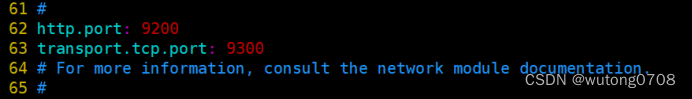

取消注释,ES 服务的默认监听端口为9200

http.port: 9200 #指定es集群提供外部访问的接口

transport.tcp.port: 9300 #指定es集群内部通信接口

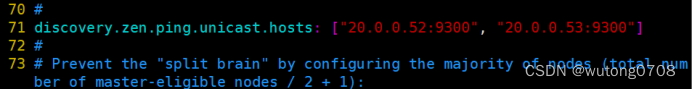

取消注释,集群发现通过单播实现,指定要发现的节点

另一台ES:

注释掉(否则会炸)实验环境无需打开

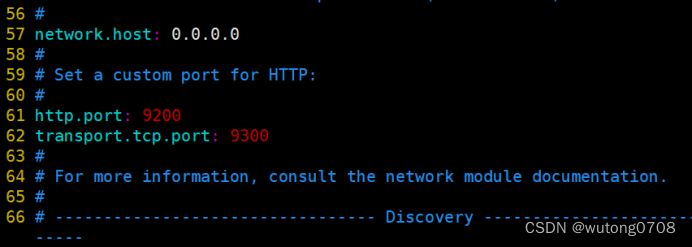

取反,验证,两台都要

grep -v "^#" /etc/elasticsearch/elasticsearch.yml

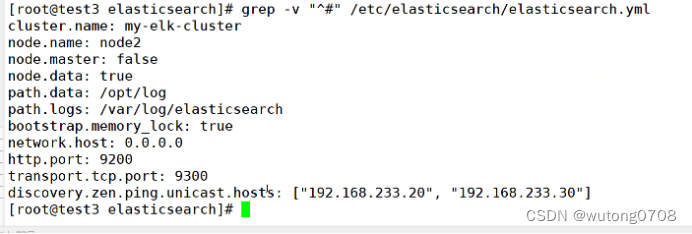

开启服务,设为开机自启动

systemctl start elasticsearch.service

systemctl enable elasticsearch.service

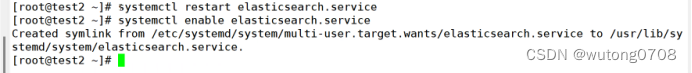

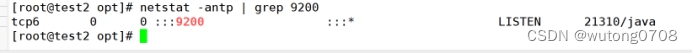

netstat -antp | grep 9200

端口起才是真的起,这个配置文件,写错了不报错

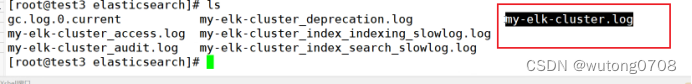

定位日志报错信息,里面有所有的日志

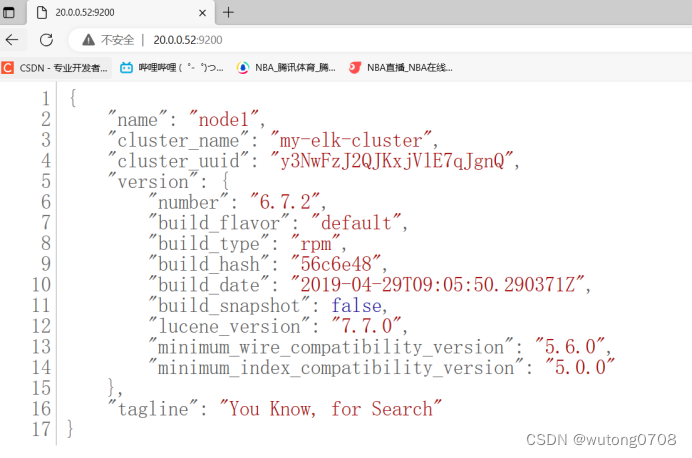

检测一下,已经可以正常使用

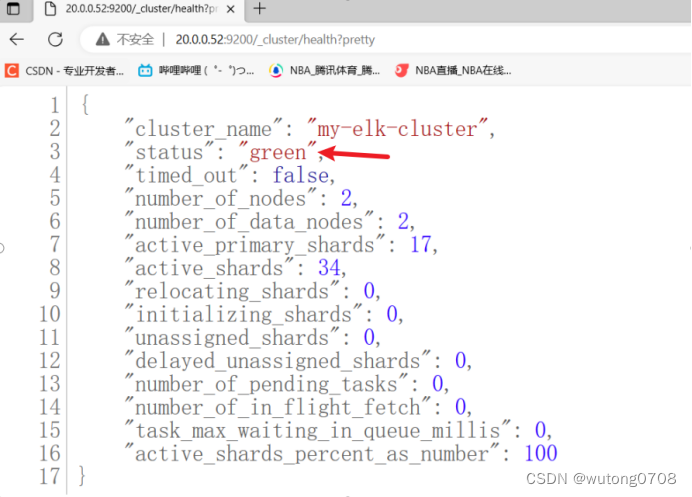

查看集群的监控状态

http://20.0.0.52:9200/_cluster/health?pretty

绿色表示正常,黄色表示故障

两台es:

安装 Elasticsearch-head 插件

Elasticsearch 在 5.0 版本后,Elasticsearch-head 插件需要作为独立服务进行安装,

需要使用npm工具(NodeJS的包管理工具)安装。

安装 Elasticsearch-head 需要提前安装好依赖软件 node 和 phantomjs。

node:是一个基于 Chrome V8 引擎的 JavaScript 运行环境。

phantomjs:是一个基于 webkit 的JavaScriptAPI,可以理解为一个隐形的浏览器,

任何基于 webkit 浏览器做的事情,它都可以做到

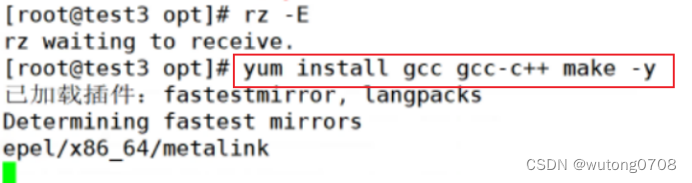

yum install gcc gcc-c++ make -y

cd /opt

tar zxvf node-v8.2.1.tar.gz

cd node-v8.2.1/

./configure

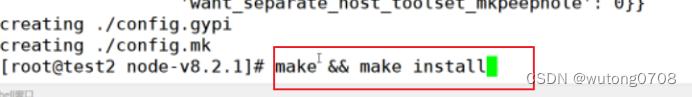

make && make install

安装 phantomjs

cd /opt

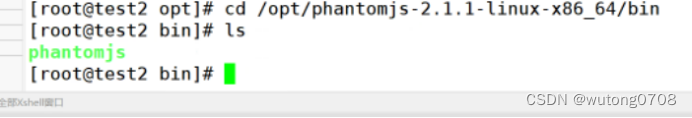

tar jxvf phantomjs-2.1.1-linux-x86_64.tar.bz2

cd /opt/phantomjs-2.1.1-linux-x86_64/bin

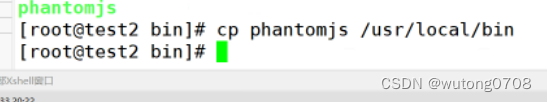

cp phantomjs /usr/local/bin

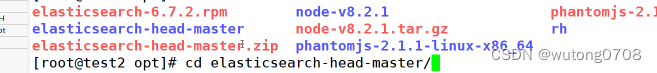

安装 Elasticsearch-head 数据可视化工具

cd /opt

unzip elasticsearch-head-master.zip

cd elasticsearch-head-master/

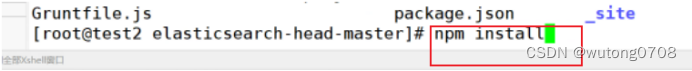

npm install //安装依赖包

特殊的安装方式nmp install

如果嫌慢,换成淘宝镜像

npm config set registry http://registry.npm.taobao.org/

#再次安装

npm install

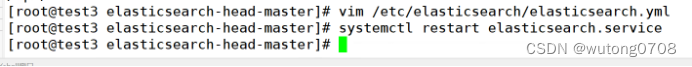

修改 Elasticsearch 主配置文件

vim /etc/elasticsearch/elasticsearch.yml

末行插入

http.cors.enabled: true

开启跨域访问的支持

http.cors.allow-origin: "*"

开启跨域访问之后,允许访问的域名地址 *:所有

systemctl restart elasticsearch

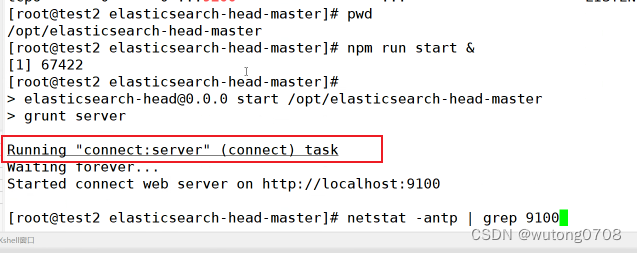

启动 elasticsearch-head 服务

#必须在解压后的 elasticsearch-head 目录下启动服务,进程会读取该目录下的 gruntfile.js 文件,否则可能启动失败。

cd /opt/elasticsearch-head-master

npm run start &

9100可视化工具的访问端口;9200是ES数据库的访问端口

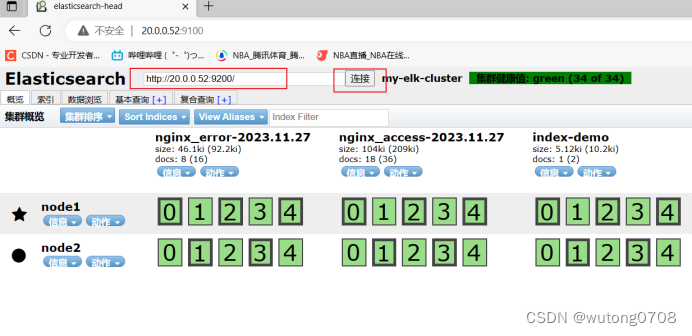

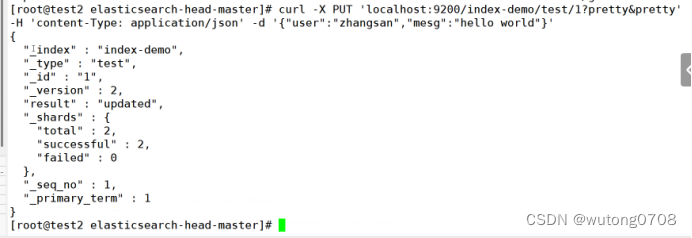

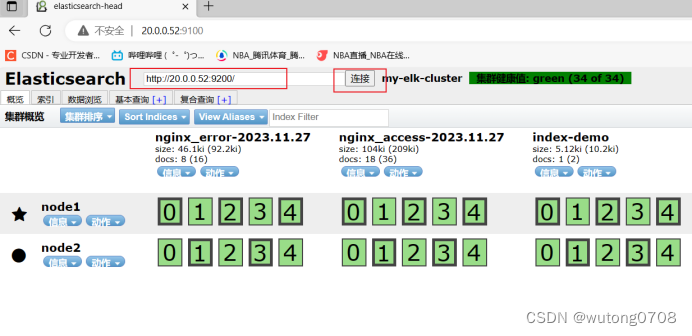

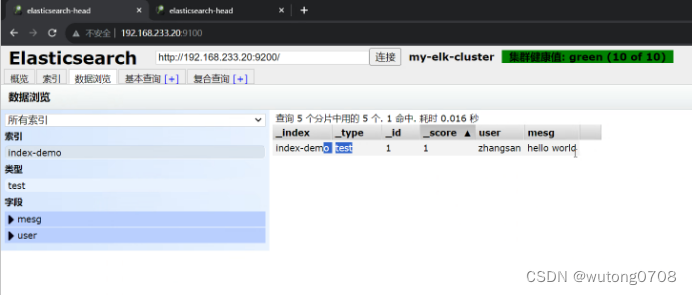

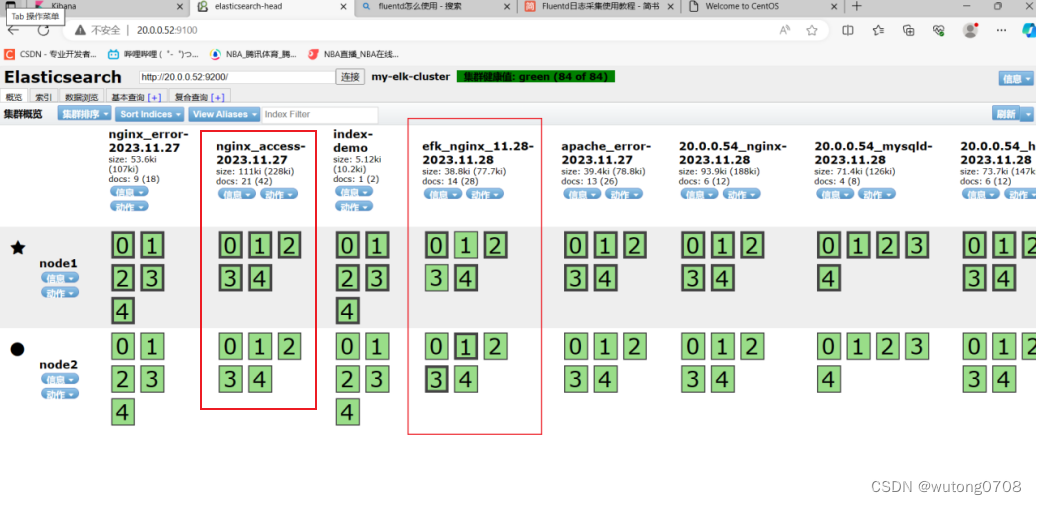

检测:插入一个索引,测试

curl -X PUT 'localhost:9200/index-demo/test/1?pretty&pretty' -H 'content-Type: application/json' -d '{"user":"zhangsan","mesg":"hello world"}'

加粗的黑框是主索引节点,没加粗的

到test1(主机一):

hostnamectl set-hostname apache

安装Apahce服务(httpd)

yum -y install httpd

systemctl start httpd

安装Java环境

yum -y install java

java -version

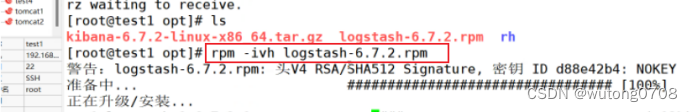

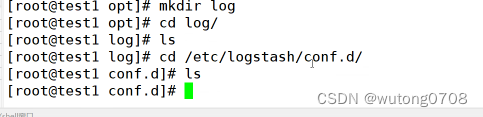

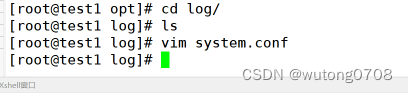

安装logstash

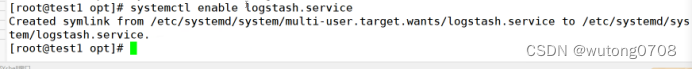

设为开机自启动和开启

systemctl start logstash.service

systemctl enable logstash.service

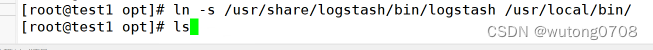

让系统识别

ln -s /usr/share/logstash/bin/logstash /usr/local/bin/

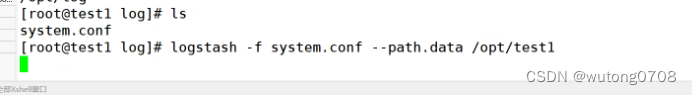

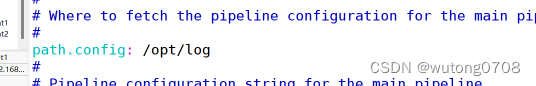

#可以指定logstash的工作目录,默认为:/etc/logstash/conf.d

path.config: /opt/log

Logstash的命令常用选项:

-f指定配置文件,根据文件识别输入和输出流

-e一般用于测试,从命令行当中获取输入,然后传送到logstash加工之后,形成一个标准输出

-t检测配置文件是否正确,然后退出

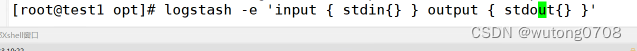

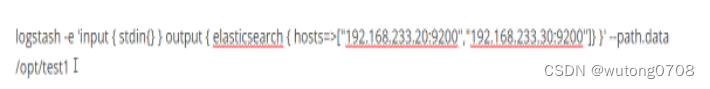

logstash -e 'input { stdin{} } output { stdout{ codec=>rubydebug } }'

#使用 rubydebug 输出详细格式显示,codec 为一种编解码器

logstash -e 'input { stdin{} } output { stdout{} }'

所有的键盘命令行输出,转化成标准输出(Rubydebug的模式),6.0之后logstash的默认输出格式就是Rubydebug格式的标准输出

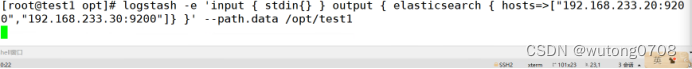

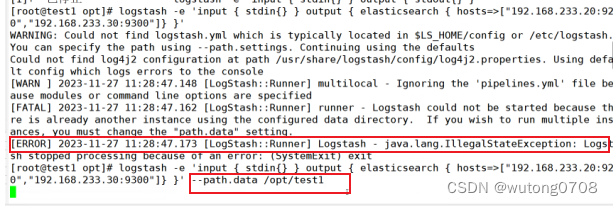

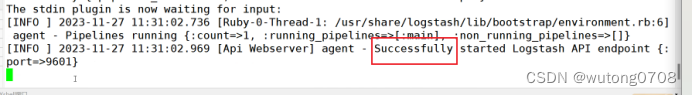

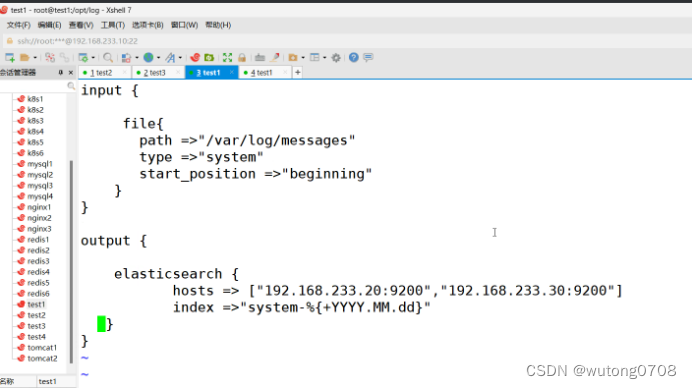

真正的转发,不在测试

表示已经成功

区分不同的数据存放目录

6.0之后logstash自带的输出格式Rubydebug,自动的把输出格式,定义为统一的标准格式输出

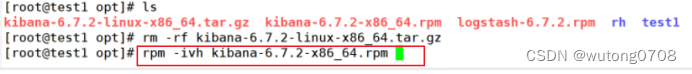

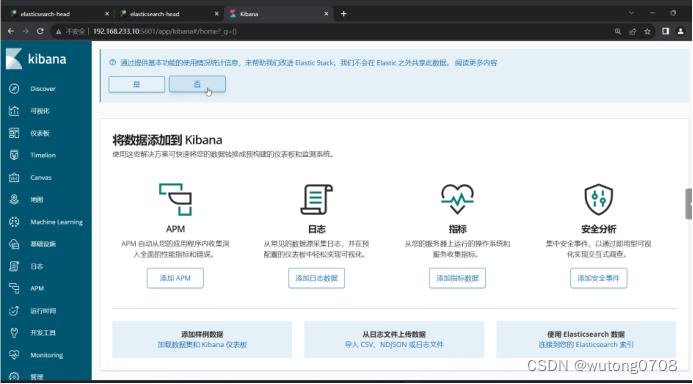

安装kibanna可视化工具

![]()

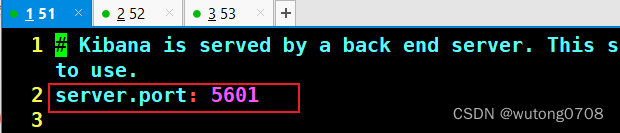

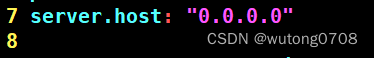

监听端口

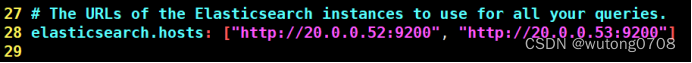

配置es服务器的ip,如果是集群则配置该集群中master节点的ip

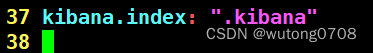

设置在 elasticsearch 中添加.kibana索引

取消注释,配置kibana的日志文件路径(需手动创建),不然默认是messages里记录日志

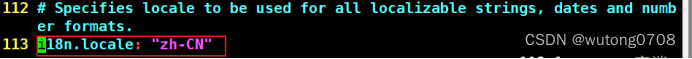

改成中文

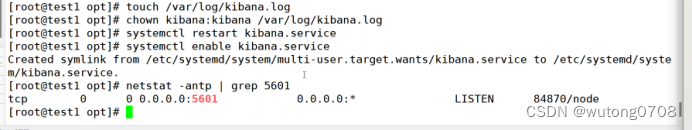

创建日志文件,启动 Kibana 服务

touch /var/log/kibana.log

chown kibana:kibana /var/log/kibana.log

systemctl start kibana.service

systemctl enable kibana.service

netstat -natp | grep 5601

验证 Kibana

默认读取读取日志的路径

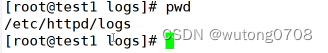

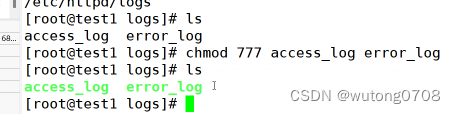

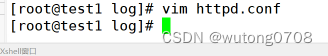

收集http日志

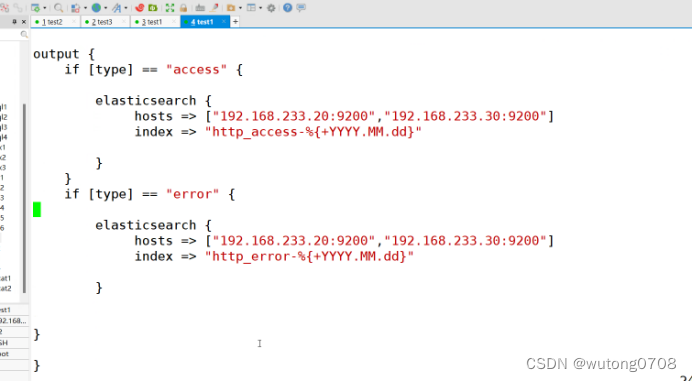

vim /etc/logstash/conf.d/apache_log.conf

input {

file{

path => "/etc/httpd/logs/access_log"

type => "access"

start_position => "beginning"

}

file{

path => "/etc/httpd/logs/error_log"

type => "error"

start_position => "beginning"

}

}

output {

if [type] == "access" {

elasticsearch {

hosts => ["192.168.233.12:9200","192.168.233.13:9200"]

index => "apache_access-%{+YYYY.MM.dd}"

}

}

if [type] == "error" {

elasticsearch {

hosts => ["192.168.233.12:9200","192.168.233.13:9200"]

index => "apache_error-%{+YYYY.MM.dd}"

}

}

}

cd /etc/logstash/conf.d/

启动

/usr/share/logstash/bin/logstash -f apache_log.conf

先检查ES实例:

然后进入kibace

如何实现过滤:以前需要配置文件加入filter字段,现在是kibana自带过滤功能

如何写一个实例添加

运行:

logstash -f nginx.conf --path.data /opt/test5 &

![]()

浏览器访问 http://20.0.0.51:9100 查看索引是否创建

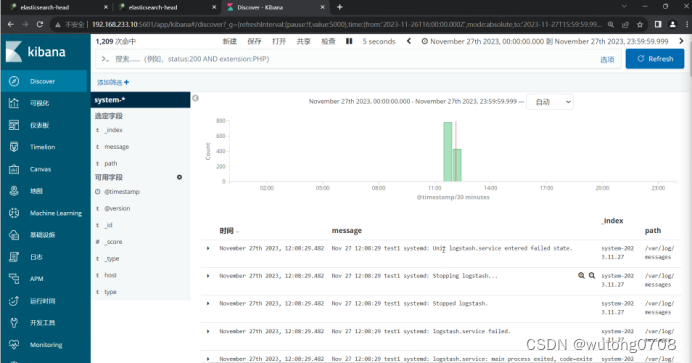

浏览器访问 http://20.0.0.51:5601 登录 Kibana,单击“Index Pattern -> Create Index Pattern”按钮添加索引, 在索引名中输入之前配置的 Output 前缀 apache_access-*,并单击“Create”按钮。在用相同的方法添加 apache_error-*索引。

选择“Discover”选项卡,在中间下拉列表中选择刚添加的 apache_access-* 、apache_error-* 索引, 可以查看相应的图表及日志信息。

补充:

如何对ES的性能进行调优:

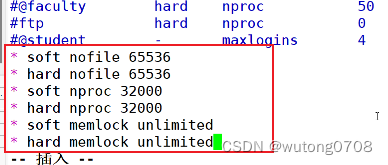

修改打开的最大文件数

![]()

* soft nofile 65536

* hard nofile 65536

* soft nproc 32000

* hard nproc 32000

* soft memlock unlimited

* hard memlock unlimited

对系统内置文件(需要重启虚拟机才能生效)

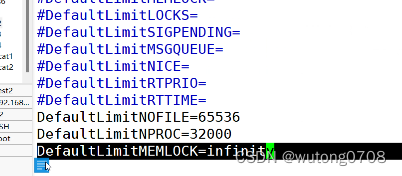

![]()

最后一行

DefaultLimitMEMlOCK=65535

一个用户会话的默认最大文件描述符的限制量

文件描述符:用于标识打开文件或者i/o资源限制的整数

DefaultLimiNPROC=3200

一个用户可以打开的最大进程数量限制32000.一个用户的终端可以运行多少个进程

DefaultLimMEMLOCK=infinity

一个用户的终端默认锁定内存的限制,不限制

内核优化:

ES是基于lucence架构,实现的一款索引型数据库,lucene可以利用操作系统的内存来缓存ES的索引数据,提供更快的查询速度,在工作当中我们会把系统的一半内存留给lucene。

如果机器内存小于64G,50%给ES 50%给操作系统

机器内存大于64G,ES分配4-32G即可,其他的都给操作系统,供lucene

改内核配置文件:

![]()

vm.max_map_count=262144

一个进程可以拥有最大内存映射区参数

内存映射:将文件或者其他的设备映射进程地址空间的方法,允许进程直接读取或写入文件,无需常规的i/o方式

映射空间越大,ES和luncne的速度越快

2g/262144

4g/4194304

8g/8388608

总结:

ES:存储数据,索引型数据库

Logstash:收集日志,然后按照标准化格式发送给ES(Rubydebug的模式)

K:可视化工具,更人性化的显示用户信息,方便用户检索查询

291

291

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?