什么是Scrapy?Scrapy是用来干嘛的?怎么使用Scrapy?这篇让我们一起来认识

目录

一、认识Scrapy

Scrapy是一个用Python编写而成的开源网络爬虫框架,主要用于抓取网页并从中提取结构化数据。Scrapy具有高度的可扩展性和灵活性,支持各种复杂的网络爬虫需求。

Scrapy框架的核心组件包括Spider、Item Pipeline、Downloader、Scheduler等。Spider是用于定义如何爬取网页的组件,Item Pipeline用于处理爬取到的数据,Downloader负责下载网页内容,Scheduler负责管理请求队列。

Scrapy框架使用Twisted异步网络库来处理网络请求和响应,具有高效的并发性能。同时,Scrapy还支持各种中间件和插件,可以方便地扩展其功能。

使用Scrapy进行网络爬虫开发需要一定的Python编程基础和对网络爬虫原理的了解。同时,还需要遵守法律法规和robots协议,尊重网站的数据所有权和使用权,避免过度抓取对网站造成负担。

总之,Scrapy是一个强大而灵活的网络爬虫框架,可以帮助开发者快速地构建高效的网络爬虫应用。

二、Scrapy的作用

Scrapy是一个用于网络爬虫的框架,主要作用是从网站上抓取数据。以下是Scrapy的具体作用:

- 数据抓取:Scrapy可以自动地抓取网站上的数据,包括HTML、XML、JSON等格式的数据。通过定义爬虫规则,Scrapy可以按照预设的逻辑和路径,自动地访问和抓取网站上的数据。

- 数据清洗和整理:Scrapy可以将抓取的数据进行清洗和整理,去除无关的噪声数据,提取出需要的数据字段。同时,Scrapy还支持将抓取的数据存储到各种数据库、文件或云存储中,方便后续的数据分析和应用。

- 数据分析和挖掘:Scrapy可以用于数据分析和挖掘,通过抓取大量的数据,使用Scrapy可以分析数据的趋势、模式和关联关系等,挖掘出有价值的信息和商业洞察。

- 网站监控和预警:Scrapy可以用于网站监控和预警,通过定期抓取网站的状态和内容,分析网站的变化和异常情况,及时发现和处理问题。

总之,Scrapy是一个强大的网络爬虫框架,可以用于数据抓取、清洗、分析和挖掘等方面,帮助开发者快速地构建高效的网络爬虫应用。

三、Scrapy框架的应用与示例

Scrapy框架的代码主要包含以下几个部分:

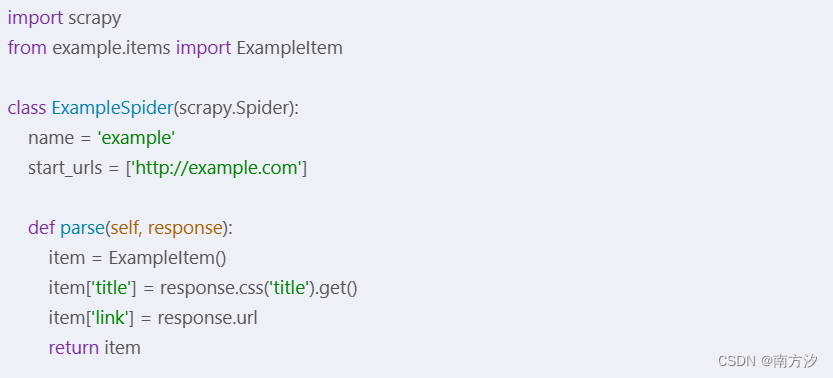

1、Spider:定义爬取网站数据的规则,包括如何提取数据,哪些URL需要抓取等。

示例1:

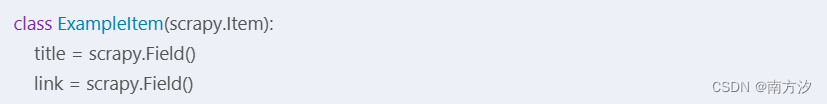

2、Item:定义要提取的数据的格式。

示例2:

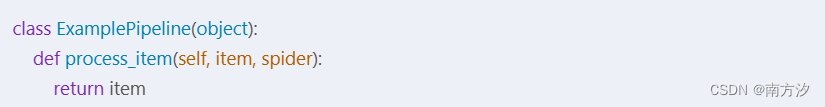

3、Pipeline:定义如何处理爬取到的数据,例如将数据存储到数据库或文件中。

示例3:

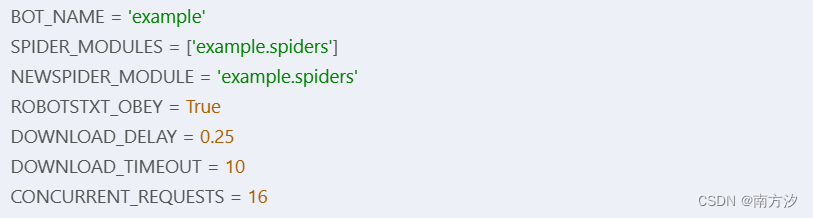

4、Settings:定义Scrapy框架的运行配置,例如并发数、代理设置等。

示例4:

四、使用 Scrapy框架要注意的地方

在使用Scrapy框架时,有以下几点需要注意:

- 遵守法律法规:在进行网页爬取时,应遵守相关法律法规,尊重网站的知识产权和隐私权,避免进行非法或恶意的数据抓取。

- 尊重网站反爬机制:许多网站都有反爬机制,以防止恶意抓取。在使用Scrapy进行网页爬取时,应尊重网站的规则,采用适当的请求头、代理等手段规避反爬检测。

- 注意数据质量:网页爬取的数据可能存在质量问题,例如数据不完整、格式不规范等。在使用爬取数据时,应对数据进行清洗和处理,确保数据的准确性和可靠性。

- 注意爬取频率:在进行网页爬取时,应注意爬取的频率,避免对目标网站造成过大压力。合理设置请求间隔和并发请求数,以降低对目标网站的影响。

- 注意Scrapy版本兼容性:Scrapy框架的版本之间可能存在兼容性问题。在使用Scrapy框架时,应关注版本之间的差异和更新说明,确保代码的稳定性和可维护性。

- 合理利用Scrapy框架特性:Scrapy框架提供了丰富的特性和工具,如XPath、CSS选择器、中间件、管道等。应合理利用这些特性和工具,提高数据抓取的效率和准确性。

- 注重调试和日志记录:在进行网页爬取时,应注意调试和日志记录。通过打印和记录日志,可以跟踪和排查代码中的问题,提高代码的稳定性和可维护性。

- 注意数据安全:在进行网页爬取时,应关注数据安全。对敏感数据进行加密和脱敏处理,确保数据的安全性和隐私保护。

总之,在使用Scrapy框架进行网页爬取时,应遵守法律法规、尊重网站反爬机制、注意数据质量和频率、关注版本兼容性、合理利用框架特性、注重调试和日志记录以及注意数据安全等方面的问题。

五、使用Scrapy框架容易出错的地方

在使用Scrapy框架时,可能会出现以下几个容易出错的地方:

- 代码错误:在使用Scrapy框架编写爬虫代码时,可能会因为语法错误、逻辑错误等原因导致代码无法正常运行。因此,在使用Scrapy框架时,应注意代码的正确性和可读性,并进行适当的测试和调试。

- 反爬机制:许多网站都设置了反爬机制,以防止恶意抓取。如果爬虫触发了这些机制,可能会导致请求被拒绝、IP被封禁等问题。因此,在使用Scrapy框架进行网页爬取时,应尊重网站的规则,采用适当的请求头、代理等手段规避反爬检测。

- 数据清洗和处理:网页爬取的数据可能存在质量问题,例如数据不完整、格式不规范等。在使用爬取数据时,应对数据进行清洗和处理,确保数据的准确性和可靠性。如果数据清洗和处理不当,可能会导致后续的数据分析和处理出现误差和错误。

- 请求超时:在进行网页爬取时,可能会因为网络延迟、服务器过载等原因导致请求超时。如果未对请求超时进行处理,可能会导致爬虫停止运行或出现其他问题。因此,在使用Scrapy框架时,应注意设置合理的超时时间,并对超时情况进行适当处理。

- 并发请求:Scrapy框架支持并发请求,可以提高爬取效率。但如果并发请求过多,可能会对目标网站造成过大压力,导致请求被拒绝或IP被封禁。因此,在使用Scrapy框架时,应注意控制并发请求的数量和频率。

- 依赖项问题:Scrapy框架和其依赖项的版本之间可能存在兼容性问题。如果未正确安装或更新依赖项,可能会导致代码运行出错或出现其他问题。因此,在使用Scrapy框架时,应关注依赖项的版本兼容性和更新情况,并正确安装和更新依赖项。

总之,在使用Scrapy框架进行网页爬取时,应注意代码的正确性和可读性、尊重网站的规则和反爬机制、合理清洗和处理数据、设置合理的超时时间和并发请求数量、关注依赖项的版本兼容性和更新情况等方面的问题。

本文介绍了Scrapy,一个强大的Python网络爬虫框架,包括其作用、组成部分、应用示例、注意事项和常见问题。Scrapy用于抓取网页数据、数据清洗、存储及数据分析,同时强调了遵守法律法规和合理使用的重要性。

本文介绍了Scrapy,一个强大的Python网络爬虫框架,包括其作用、组成部分、应用示例、注意事项和常见问题。Scrapy用于抓取网页数据、数据清洗、存储及数据分析,同时强调了遵守法律法规和合理使用的重要性。

991

991

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?