Caused by: java.io.NotSerializableException: org.apache.log4j.Logger

Serialization stack:

- object not serializable (class: org.apache.log4j.Logger, value: org.apache.log4j.Logger@149ff4b5)

- field (class: com.bluedon.dataMatch.NTADataProcess, name: log, type: class org.apache.log4j.Logger)

- object (class com.bluedon.dataMatch.NTADataProcess, com.bluedon.dataMatch.NTADataProcess@288c751a)

- field (class: com.bluedon.dataMatch.NTADataProcess$$anonfun$ntaflowProcess$1, name: $outer, type: class com.bluedon.dataMatch.NTADataProcess)

- object (class com.bluedon.dataMatch.NTADataProcess$$anonfun$ntaflowProcess$1, <function1>)

- field (class: com.bluedon.dataMatch.NTADataProcess$$anonfun$ntaflowProcess$1$$anonfun$apply$1, name: $outer, type: class com.bluedon.dataMatch.NTADataProcess$$anonfun$ntaflowProcess$1)

- object (class com.bluedon.dataMatch.NTADataProcess$$anonfun$ntaflowProcess$1$$anonfun$apply$1, <function1>)

at org.apache.spark.serializer.SerializationDebugger$.improveException(SerializationDebugger.scala:40)

at org.apache.spark.serializer.JavaSerializationStream.writeObject(JavaSerializer.scala:46)

at org.apache.spark.serializer.JavaSerializerInstance.serialize(JavaSerializer.scala:100)

at org.apache.spark.util.ClosureCleaner$.ensureSerializable(ClosureCleaner.scala:295)

Serialization stack:

- object not serializable (class: org.apache.log4j.Logger, value: org.apache.log4j.Logger@149ff4b5)

- field (class: com.bluedon.dataMatch.NTADataProcess, name: log, type: class org.apache.log4j.Logger)

- object (class com.bluedon.dataMatch.NTADataProcess, com.bluedon.dataMatch.NTADataProcess@288c751a)

- field (class: com.bluedon.dataMatch.NTADataProcess$$anonfun$ntaflowProcess$1, name: $outer, type: class com.bluedon.dataMatch.NTADataProcess)

- object (class com.bluedon.dataMatch.NTADataProcess$$anonfun$ntaflowProcess$1, <function1>)

- field (class: com.bluedon.dataMatch.NTADataProcess$$anonfun$ntaflowProcess$1$$anonfun$apply$1, name: $outer, type: class com.bluedon.dataMatch.NTADataProcess$$anonfun$ntaflowProcess$1)

- object (class com.bluedon.dataMatch.NTADataProcess$$anonfun$ntaflowProcess$1$$anonfun$apply$1, <function1>)

at org.apache.spark.serializer.SerializationDebugger$.improveException(SerializationDebugger.scala:40)

at org.apache.spark.serializer.JavaSerializationStream.writeObject(JavaSerializer.scala:46)

at org.apache.spark.serializer.JavaSerializerInstance.serialize(JavaSerializer.scala:100)

at org.apache.spark.util.ClosureCleaner$.ensureSerializable(ClosureCleaner.scala:295)

... 30 more

log的文件是

trait LogSupport {

val log = Logger.getLogger(this.getClass)

}

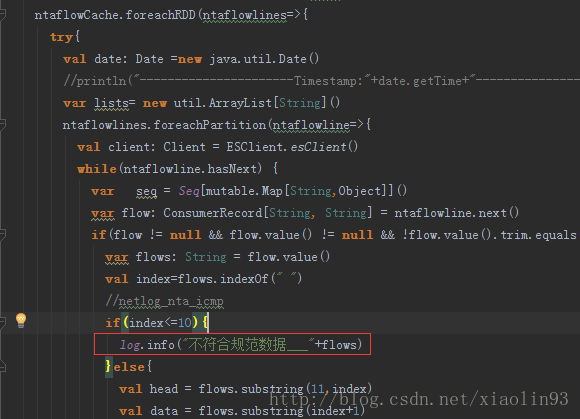

原因是因为在foreachRDD中是分区并行执行的,及时logsupport实现序列化也会报错,解决方案是在

@transient lazy val log = Logger.getLogger(this.getClass)

4201

4201

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?