紧接着上一节公开课,第三节老师在线性回归算法的基础上讲了局部加权回归(LOESS)和logistic回归

首先,我们明确几个概念:

(1)欠拟合 过拟合

(2)非参数学习算法:参数的数量会随着m的增多而增多

--------------------------------------------------------------------分割线---------------------------------------------------------------------------------------------------------------

一,局部加权线性回归(locally weightal regression)

根据大神们的数据,得到一组这样的点点

代码如下:(有200个点吧)

clc;

clear all;

close all;

%%

%载入数据

load ('data2.mat');

x=data(:,1:2);

y=data(:,3);

figure;

plot(x(:,2),y,'r.');%原始数据

(1)用上一节的批梯度下降法拟合如下

(2)用上一节的增量梯度下降法得到的实验结果如下

(3)用最小二乘法得到的实验结果如下

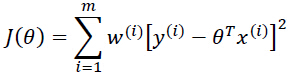

(4)局部加权回归算法

它是一种非参数学习算法,参数的数量会随着m的增多而增多

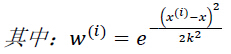

在这个公式中,x为预测点,xi为样本点

xi和x的差距很小时,xi-x很小时,w(i)=1 xi和x的差距很大时,xi-x很大时,w(i)=0 ,也就是说样本点和预测点越远,贡献的权值越小;样本点和预测点的距离越近,贡献的权值越大。 也就是说J可以看成是若干二次项*1+若干二次项*0

利用推导结果:

实验结果如下:

其中k 为带宽参数,局部加权回归算法存在过拟合和欠拟合等因素。

k越小,每一步走的越小,则过小会出现过拟合;k很大的时候,每一步走的太大,则过大会出现欠拟合

k=0.15,欠拟合

k=0.1

k=0.05

k=0.01

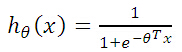

(5)logistic 算法

线性回归用于分类问题会很糟糕,但是我们可以用logistic 算法,通过非线性回归解决分类问题.其中,自变量可以是连续的,也可以是离散的;因变量是离散的

与线性回归类似,我们只是把线性的h(x)改成非线性的h(X)

代码

实验结果如下:

不同的学习率得到的曲线是不同的

-----------------------------------------------------------------------分割线————————————————————————————————————————————

欢迎大家讨论更多关于机器学习的好的方法,啦啦

4万+

4万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?