家人们家人们!就在刚刚,NLP领域最权威的顶级会议ACL揭晓了本届的获奖名单,今年共有7篇论文荣获最佳论文奖!

据我所知,我们卖萌屋的读者们对此都非常关注!有些人在焦急地等待结果,还有人甚至正在颁奖典礼现场。

今年的ACL大会于8月11日在泰国曼谷开幕,为期6天。

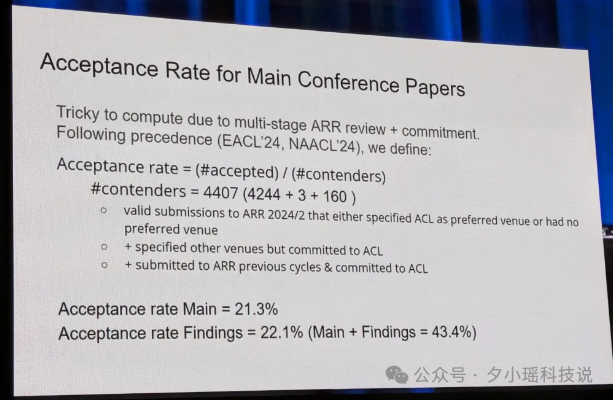

除了主会之外,还有34场研讨会。根据官方统计数据,今年ACL的录用率再次刷新纪录。过去几年录用率一直稳定在25%左右,而今年主会的录用率为21.3%,Findings的录用率为22.1%。

怎么又低了!还让不让我们中了!(虽然25%俺也中不了QAQ)

接下来和奶茶一起看看都有哪些工作摘得了桂冠 !友情提示,关注公众号,后台回复「ACL 2024」即可下载所有获奖论文~

最佳论文奖

首先是大家最关注的Best Paper!一共有以下七篇论文获奖:

1. ExplainableDetector: Exploring Transformer-based Language Modeling Approach for SMS Spam Detection with Explainability Analysis

研究工作:采用优化微调的 Transformer-based 大语言模型来检测垃圾邮件,实验结果显示优化微调的RoBERTa达到了99.84% 的高准确率。

研究机构:孟加拉国 BGC 信托大学、爱丁堡纳皮耶大学、伊迪斯科文大学

论文地址:https://arxiv.org/abs/2405.08026

2. Deciphering Oracle Bone Language with Diffusion Models

研究工作:现代人工智能技术的出现神秘东方密码甲骨文解码提供了新的方向,挑战了严重依赖大型文本语料库的传统NLP方法,介绍了一种采用图像生成技术的新方法。利用基于条件扩散的策略,OBSD生成重要的线索进行破译。

研究机构:华中科技大学、阿德莱德大学、安阳师范学院、华南理工大学

论文地址:https://arxiv.org/abs/2406.00684

3. Causal Estimation of Memorisation Profiles

研究工作:提出了一种高效的记忆估计方法,只观察模型整个训练过程中的一小部分实例行为绘出模型的记忆特征。

研究机构:剑桥大学、苏黎世联邦理工学院

论文地址:https://arxiv.org/abs/2406.04327

4.Aya Model: An Instruction Finetuned Open-Access Multilingual Language Model

研究工作:推出了一个大规模多语言生成语言模型 Aya,遵循 101 种语言的指令,覆盖语言种类增加了两倍,引入了广泛的新评估套件,扩展99种语言的多语言评估技术。

研究机构:Cohere For AI、布朗大学、Cohere、Cohere For AI Community、麻省理工学院、卡内基梅隆大学

论文地址:https://arxiv.org/abs/2402.07827

5. Mission: lmpossible Language Models

研究工作:研究人员合成了一系列复杂的、不存在的语言,并评估 GPT-2 模型对这些语言的学习能力,相比于学习英语,GPT-2 在学习不可能语言方面存在困难。

研究机构:斯坦福大学、加州大学、德克萨斯大学

论文地址:https://arxiv.org/abs/2401.06416

6.Semisupervised Neural Proto-Language Reconstructior

研究工作:研究人员提出了一个半监督的历史重建任务,只在少量标记数据和大量未标记数据上进行训练,以及一个比较重建的神经架构结合语言学家比较方法的基本见解,能够利用未标记的同源词集,在新任务上的性能优于强半监督基线。

研究机构:卡内基梅隆大学、南加州大学

论文地址:https://arxiv.org/abs/2406.05930

7. Why are Sensitive Functions Hard for Transformers

研究工作:Transformer架构的损失景观受输入空间敏感性制约。这一理论通过理论分析和实证研究,成功统一了关于Transformer学习能力和偏见的多项实证观察结果。

研究机构:德国萨尔大学

论文地址:https://arxiv.org/abs/2402.09963

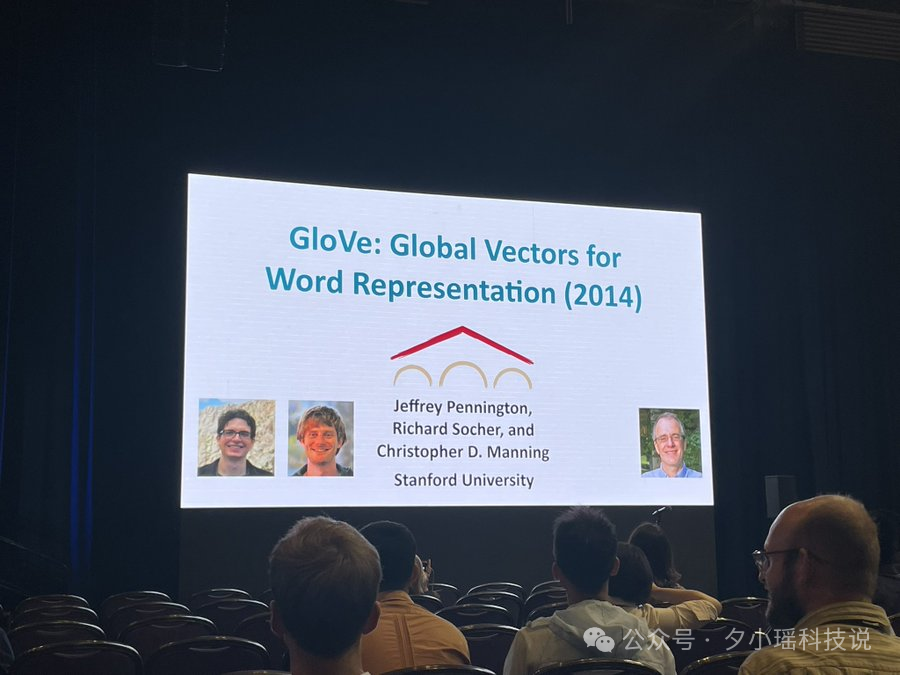

时间检验奖 (Test of Time Award)

时间检验奖同样也是一个非常重量级奖项,为的是表彰那些在计算机语言学领域产生长期影响的研究论文,一般获奖论文是领域内的经典之作。

今年的时间检验奖颁给了我们的老熟人——GloVe!

来自2014年发表的《GloVe: Global Vectors for Word Representation》!

各位NLPer几乎没有不知道GloVe的吧,它是词向量的重要里程碑之一,与 Word2Vec 并列为最常用的词向量模型。在Bert还没出世的时候,GloVe已经在大杀四方!

论文地址:https://aclanthology.org/D14-1162.pdf

最佳社会影响力论文奖(Best Social Impact Paper Awards)

社会影响力旨在表彰那些在计算语言学领域中对社会产生积极影响的研究工作,今年获奖的论文为以下三篇:

1. How Johnny Can Persuade LLMs to Jailbreak Them: Rethinking Persuasion to Challenge AI Safety by Humanizing LLMs

研究工作:通过应用源自社会科学的说服分类法生成的对抗提示(PAP),能显著提高LLM越狱的成功率,在Llama 2-7b Chat、GPT-3.5和GPT-4上的攻击成功率均超过92%,优于基于算法的攻击。本文还探讨了PAP防御机制,发现现有防御存在重大缺口,呼吁为高度互动的LLM提供更根本的缓解措施。

研究机构:弗吉尼亚理工大学、中国人民大学、加州大学、斯坦福大学

论文地址:https://arxiv.org/abs/2401.06373

2. DIALECTBENCH: A NLP Benchmark for Dialects, Varieties, and Closely-Related Languages

研究工作:大多数NLP基准测试仅限于标准语言。为填补这一空白,本文提出了首个大规模的变体NLP基准,涵盖了281种变体、涉及10个文本级任务的数据集。这使得NLP系统在不同语言变体上的性能得以全面评估。研究提供了标准语言与非标准语言变体之间性能差异的充分证据,并识别出在不同任务中表现差异显著的语言集群。

研究机构:乔治梅森大学,华盛顿大学,圣母大学,阿基米德研究所雅典研究中心

论文地址:https://arxiv.org/abs/2403.11009

3.Having Beer after Prayer? Measuring Cultural Bias in Large Language Models

研究工作:尽管多语言能力有所提升,但在设计时未充分考虑文化差异,本文提出了CAMeL,一个包含628个自然提示和20,368个实体的资源,跨越8种类型,比较阿拉伯文化与西方文化。CAMeL为评估语言模型中的文化偏见提供了基础。

研究机构:乔治亚理工学院

论文地址:https://arxiv.org/abs/2305.14456

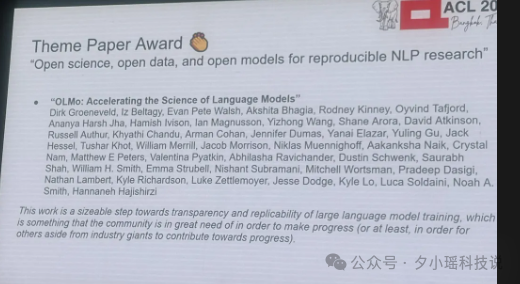

最佳主题论文奖

OLMo: Accelerating the Science of Language Models

研究工作:随着商业价值的增长,最先进的大语言模型常被封闭在专有接口后,未公开关键细节。因此,研究人员创建了OLMo,一个开放且具有竞争力的语言模型,发布了训练数据及完整的训练和评估代码,以促进科学研究和创新。

研究机构:艾伦人工智能研究所,华盛顿大学,耶鲁大学, 纽约大学,内基梅隆大学

论文地址:https://arxiv.org/pdf/2402.00838

最佳资源论文奖

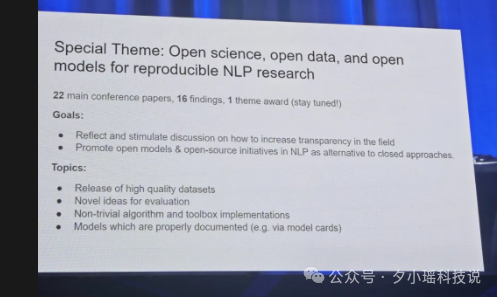

ACL2024首次增加了特别专题【Open science, open data, and open models for reproducible NLP research】,专门用于接受开源的数据集、模型、软件的研究成果,来鼓励开源。

今年获得最佳资源论文奖项的是:

1. AppWorld: A Controllable World of Apps and People for Benchmarking Interactive Coding Agents

研究工作:构建了AppWorld引擎,这是一个高质量的执行环境(60K行代码),包含9个可通过457个API操作的日常应用程序,并填充了模拟约100个虚构用户生活的真实数字活动。

研究机构:石溪大学、艾伦人工智能研究所、萨尔大学

论文地址:https://arxiv.org/abs/2407.18901

2. Latxa: An Open Language Model and Evaluation Suite for Basque研究工作:开放了一个包含 7 到 70 亿参数的巴斯克语大型语言模型系列。Latxa 基于 Llama 2,在一个包含 430 万份文档和 42 亿个词元的新巴斯克语语料库上继续预训练。

研究机构:巴斯克大学

论文地址:https://arxiv.org/abs/2403.20266

3. Dolma: an Open Corpus of Three Trillion Tokens for Language Model Pretraining Research

研究工作:包含三万亿标记的英语语料库,由多样化的网络内容、科学论文、代码、公共领域书籍、社交媒体和百科材料构建而成。我们对Dolma进行了详尽的文档记录,包括其设计原则、构建细节以及内容摘要。我们还展示了Dolma中间状态的分析和实验结果。

研究机构:艾伦人工智能研究所 加利福尼亚大学伯克利分校 卡内基梅隆大学 斯皮菲人工智能 麻省理工学院 华盛顿大学

论文地址:https://arxiv.org/abs/2402.00159

小伙伴们,在后台回复「ACL 2024」即可下载所有获奖论文~

256

256

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?