论文来源:AAAI2020

作者:浙大&海康研究院

概述:

该论文通过引入了一个时空可变形融合方案来对目标帧及其相邻的参考帧进行融合来对压缩视频进行增强,取得了当时的sota效果。

先通过一个U-Net结构的偏移量预测网络来输出可变形卷积的偏移量,偏移量预测网络以目标帧和其前后R帧(共2R+1帧)作为输入,通过U-Net的多尺度特征融合以及编解码器结构能够增加感受野的特性,可以更加容易地获取到运动物体的特征,有利于偏移量的估计。得到偏移量后即可应用可变形卷积对输入的所有帧提取时空特征,隐式地估计光流,从而能够在不同帧上提取运动物体的特征,用高质量帧中细节清晰的部分来补偿低质量帧中的模糊细节,然后用一个包含L个卷积层的质量增强网络来进行增强操作,最后以残差连接的方式将增强结果与输入相加得到最后的结果。

本文的网络结构较为简单,主要亮点在于可以对输入的多帧图像自适应的学习可变形卷积偏移量来解决运动目标的特征对齐问题。

Abstract

近年来,深度学习方法在提高压缩视频质量方面取得了显著的成功。为了更好地挖掘时间信息,现有的方法通常估计光流进行时间运动补偿。然而,由于压缩视频可能被各种压缩伪影导致严重失真,因此估计的光流往往不准确和不可靠,从而导致无效的质量增强。此外,对于连续帧的光流估计通常是以成对的方式进行的,这是计算开销大且效率低的。在本文中,我们提出了一种快速而有效的压缩视频质量增强方法,通过引入新的时空可变形融合(STDF)方案来聚合时间信息。具体地说,所提出的STDF以目标帧及其相邻参考帧作为输入,共同预测偏移场以使卷积的时空采样位置变形。结果,来自目标和参考帧的互补信息可以在单个时空可变形卷积(STDC)操作内融合。大量实验表明,该方法在准确率和效率上都达到了压缩视频质量增强的最新水平。

1 Introduction

如今,视频内容已成为数字网络流量的主要部分,并且仍在增长。为了在有限的带宽下传输视频,视频压缩大幅度降低码率是必不可少的。然而,压缩算法,如hash.264/AVC和H.265/HEVC,经常在压缩视频中引入各种伪影,尤其是在低比特率下。如图1所示,这样的伪影可能显著降低视频质量,导致体验质量(QoE)的降低。低质量压缩视频中的失真内容也可能降低低带宽应用中后续视觉任务(例如,识别、检测、跟踪)的性能;因此,研究压缩视频质量增强(VQE)是非常必要的。

在过去的几十年中,人们对单个压缩图像的伪影去除或质量增强进行了大量的研究。传统方法通过优化特定压缩标准的变换系数来减少伪影,因此很难扩展到其他压缩方案。随着卷积神经网络(CNN)的最新进展,基于CNN的方法也出现了图像质量增强。他们通常通过学习非线性映射,从大量的训练数据中直接回归出无伪影的图像,从而得到令人印象深刻的高效率的结果。然而,这些方法不能直接扩展到压缩视频,因为它们独立处理帧,因此无法利用时间信息。

另一方面,对压缩视频质量增强的研究还很有限。Yang et al.首先提出了多帧质量增强(MFQE 1.0)方法,以利用VQE的时间信息。具体地说,利用压缩视频中的高质量帧作为参考帧,通过一种新的多帧CNN(MF-CNN)来提高相邻低质量目标帧的质量。最近,一个升级版MFQE2.0被引入,进一步提高了MF-CNN的效率,实现了最先进的性能。为了聚合来自目标帧和参考帧的信息,两种MFQE方法都采用了广泛使用的时间融合方案,该方案结合了用于运动补偿的密集光流。然而,这种时间融合方案在VQE任务中可能是次优的。由于压缩伪影会严重扭曲视频内容并破坏帧间像素级的对应关系,因此估计的光流往往不准确和不可靠,从而导致无效的质量增强。此外,需要以成对的方式对不同的参考目标帧对重复执行光流估计,这涉及实质性地增加计算成本以探索更多的参考帧。

为了解决上述问题,我们提出了一种时空可变形融合(STDF)方案。具体来说,我们建议学习一种新的时空可变形卷积(STDC)来聚集时间信息,同时避免显式光流估计。STDC的主要思想是自适应地对卷积的时空采样位置进行变形,从而捕获最相关的上下文,排除噪声内容,提高目标帧的质量。为此,我们采用了一种基于CNN的预测器,对目标和参考帧之间的对应关系进行联合建模,并相应地在一次推理过程中对这些采样位置进行回归。论文的主要贡献总结如下:

我们提出了一种基于端到端CNN的VQE任务处理方法,该方法结合了一种新的STDF方案来聚合时态信息。

通过分析和实验比较,证明了该算法具有较高的灵活性和鲁棒性。

我们在VQE基准数据集上对该方法进行了定量和定性的评价,结果表明该方法在准确性和效率方面达到了最先进的水平。

2 Related Work

Image and Video Quality Enhancement.

在过去的十年中,越来越多的作品关注于压缩图像的质量增强。其中,基于CNN的端到端方法取得了近期最先进的性能。具体来说,Dong等人首先引入了一种4层AR-CNN来去除各种JPEG压缩伪影。后来,Zhang等人成功地学习了一个非常深的DnCNN,并针对多个图像恢复任务使用了残差学习方案。最近,Zhang等人提出了一种更深的网络RNAN,它具有残差非局部注意机制,可以捕获像素之间的长依赖关系,并建立了一种新的图像质量增强技术。这些方法倾向于使用大型的cnn来捕获图像中的特征,从而导致大量的计算和参数。另一方面,mfqe1.0率先应用多帧CNN来利用时间信息进行压缩视频质量增强,其中高质量帧用于帮助增强相邻低质量帧的质量。为了利用长距离时间信息,Yang等人后来引入了一种改进的卷积长-短期记忆网络,用于视频质量增强。最近,Guan等人提出了MFQE2.0,以升级MFQE1.0的几个关键组件,并在准确性和速度方面取得了最先进的性能。

Leveraging Temporal Information.

在视频相关的任务中,跨多个帧利用互补信息是至关重要的。Karpathy等人首先介绍了几种基于卷积的融合方案,以结合时空信息进行视频分类。Kappeler等人后来研究了用于底层视觉任务的融合方案,并通过基于全变分(TV)的光流估计算法补偿连续帧间的运动来提高精度。Caballero等人进一步将基于全变分的光流估计替换为CNN以支持端到端训练。从那时起,带有运动补偿的时间融合被广泛应用于各种视觉任务。然而,这些方法严重依赖于精确的光流,由于一般问题(例如遮挡、大运动)或任务特定问题(例如压缩伪影),很难获得精确的光流。为了解决这一问题,人们进行了绕过显式光流估计的工作。Niklaus、Mai和Liu提出AdaConv通过隐式利用运动线索进行视频帧插值,自适应生成卷积核。Shi et al.引入了ConvLSTM网络,以利用来自长范围相邻帧的上下文信息。在这项工作中,我们提出了结合运动线索和卷积来有效地聚集时空信息,这也省略了光流的显式估计。

Deformable Convolution.

Dai等人首次提出用可学习的采样偏移量来增强规则卷积,从而为目标检测建模复杂的几何变换。后来,一些作品将其沿时间范围进行扩展,以隐式捕获视频相关应用的运动线索,并取得了比传统方法更好的性能。然而,这些方法以成对的方式执行可变形卷积,因此无法完全探索跨多个帧的时间对应。在这项工作中,我们提出了STDC来共同考虑一个视频片段,而不是将其分割成多个参考目标帧对,从而更有效地利用上下文信息。

3 Proposed Method

3.1 Overview

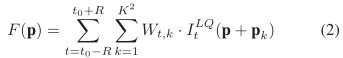

对于被压缩伪影失真的压缩视频,我们的方法的目标是去除这些伪影,从而提高视频质量。具体来说,我们分别对在t0时刻的每个压缩帧![]() 进行增强。为了利用时间信息,我们以前后R帧为参考来帮助提高每个目标

进行增强。为了利用时间信息,我们以前后R帧为参考来帮助提高每个目标![]() 的质量。增强结果

的质量。增强结果![]() 可以表示为

可以表示为

![]()

其中Fθ(·) 表示提出的质量增强模型,θ 是可学习的参数。

图2展示了我们的方法框架,它由一个时空可变形融合(STDF)模块和一个质量增强(QE)模块组成。STDF模块以目标帧和参考帧为输入,通过时空可变形卷积融合上下文信息,其中可变形偏移由偏移预测网络自适应生成。然后,利用融合后的特征映射,QE模块结合一个全卷积增强网络来计算增强结果。由于STDF模块和QE模块都是卷积的,因此我们的统一框架可以以端到端的方式进行训练。

3.2 STDF Module

Spatio-Temporal Deformable Convolution.

对于压缩视频剪辑![]() ,最直接的时间融合方案,即早期融合(EF),可以表示为直接应用于压缩帧的多信道卷积,如下所示:

,最直接的时间融合方案,即早期融合(EF),可以表示为直接应用于压缩帧的多信道卷积,如下所示:

其中F是得到的特征映射,K表示卷积核的大小,![]() 是卷积核的第t个通道,p表示任意空间位置,pk表示规则采样偏移量。例如,pk∈ {(−1,−1),(−1,0),····,(1,1)}对于K=3。尽管效率很高,但EF很容易引入噪声内容,并由于时间运动而降低后续增强的性能,如图3所示。受Dai等人的启发,为了解决这个问题,我们引入了一种新的时空可变形卷积(STDC)算法,用额外的可学习偏移量

是卷积核的第t个通道,p表示任意空间位置,pk表示规则采样偏移量。例如,pk∈ {(−1,−1),(−1,0),····,(1,1)}对于K=3。尽管效率很高,但EF很容易引入噪声内容,并由于时间运动而降低后续增强的性能,如图3所示。受Dai等人的启发,为了解决这个问题,我们引入了一种新的时空可变形卷积(STDC)算法,用额外的可学习偏移量![]() 来增强规则采样偏移量:

来增强规则采样偏移量:

![]()

值得注意的是,可变形偏移δ(t、 p)是位置特定的,即被分配给以时空位置(t,p)为中心的每个卷积窗口的δ(t、 p)都是独特的。因此,视频片段中的空间变形和时间动态可以同时建模,如图3所示。由于可学习的偏移可以是分数,因此我们遵循Dai等人将可微双线性插值应用于采样亚像素![]() 。

。

与以往的VQE方法不同,在融合前进行显式运动补偿以减轻时间运动的影响,STDC在融合时隐式地将运动线索与位置特定采样相结合。这导致了更高的灵活性和健壮性,因为相邻的卷积窗口可以独立地对内容进行采样,如图4所示。

Joint Deformable Offset Prediction.

与一次只处理一个参考帧对的光流估计不同,我们提出了一种将整个剪辑考虑在内,同时联合预测所有可变形偏移量的方法。为此,对于视频剪辑中的所有时空位置,我们应用偏移量预测网络![]() 预测偏移场

预测偏移场![]()

![]()

其中帧作为输入连接在一起。由于连续帧是高度相关的,因此一帧的偏移预测可以受益于其他帧,从而比成对方案更有效地利用时间信息。此外,联合预测的计算效率更高,因为所有可变形的偏移量都可以在一次推理过程中获得。

如图2-(a)所示,我们采用基于U-Net的网络(Ronneberger、Fischer和Brox 2015)进行偏移量预测,以扩大感受野,从而捕获大的时间动态。步长为2的卷积层和反卷积层(Zeiler和Fergus 2014)分别用于下采样和上采样。对于步长为1的卷积层,采用零填充来保持特征尺寸。为简单起见,我们设置所有的卷积层的卷积核数量为C1。除了最后一个之后是线性激活以回归偏移场Δ,校正线性单元(ReLU)是所有层的激活函数. 我们在网络中不使用任何规范化层。

3.3 QE Module

QE模块的主要思想是充分挖掘融合特征映射F中的互补信息,从而生成增强的目标帧![]() 。为了利用残差学习,我们首先学习非线性映射

。为了利用残差学习,我们首先学习非线性映射![]() 预测增强残差:

预测增强残差:![]()

增强的目标帧可以表示为:![]()

如图2-(c)所示,我们通过另一个CNN实现了![]() ,CNN由L个步幅为1的卷积层组成。除最后一个层外,所有层都有c2个卷积滤波器,然后再用ReLU激活。最后一个卷积层输出增强残差。这种简单的QE网络,不必吹毛求疵,就能达到令人满意的增强效果。

,CNN由L个步幅为1的卷积层组成。除最后一个层外,所有层都有c2个卷积滤波器,然后再用ReLU激活。最后一个卷积层输出增强残差。这种简单的QE网络,不必吹毛求疵,就能达到令人满意的增强效果。

3.4 Training Scheme

由于STDF模块和QE模块是完全卷积的,因此是可微的,我们以端到端的方式联合优化θop和θqe。总损失函数L被设置为增强目标帧![]() 和原始

和原始![]() 之间的平方误差之和(SSE):

之间的平方误差之和(SSE):![]()

注意,由于不存在可变形偏移的ground truth,偏移预测网络![]() 的学习完全不受监督,完全由最终损失L驱动,这与以往将辅助损失纳入约束光流估计的工作不同。

的学习完全不受监督,完全由最终损失L驱动,这与以往将辅助损失纳入约束光流估计的工作不同。

4 Experiments

4.1 Datasets

遵循MFQE2.0,我们从Xiph(Xiph.org)和VQEG(VQEG)两个数据库收集了130个不同分辨率和内容的未压缩视频,其中106个用于训练,其余用于验证。为了进行测试,我们采用了来自视频编码联合协作团队的数据集,其中包含18个未压缩视频。这些测试视频被广泛用于视频质量评估,每个视频大约有450帧。在Low Delay P(LDP)配置下,我们使用最新的H.265/HEVC参考软件HM16.52压缩上述所有视频,与之前的工作一样。在4个不同的量化参数(QPs)下进行压缩,即22、27、32、37,以便评估在不同压缩水平下的性能。

4.2 Implementation Details

该方法基于PyTorch框架,并参考MMDetection工具箱实现了可变形卷积。为了训练,我们在原始视频和相应压缩视频上随机裁剪了64*64的剪辑作为训练样本。进一步使用数据增强(即旋转或翻转)来更好地利用这些训练样本。我们使用β1= 0.9, β2=0.999,![]() 的Adam optimizer。学习率初始设置为10−4并在整个训练过程中不变。我们从零开始分别为4个QPs训练4个模型。对于评价,与以前的工作一样,我们只对YUV/YCbCr空间中的Y通道(即亮度分量)进行了质量增强。我们采用增量峰值信噪比(ΔPSNR)和结构相似性(ΔSSIM)来评估质量增强性能,它衡量增强视频相对于压缩视频的改善程度。我们还从参数和计算成本的角度评估了质量增强方法的复杂性。

的Adam optimizer。学习率初始设置为10−4并在整个训练过程中不变。我们从零开始分别为4个QPs训练4个模型。对于评价,与以前的工作一样,我们只对YUV/YCbCr空间中的Y通道(即亮度分量)进行了质量增强。我们采用增量峰值信噪比(ΔPSNR)和结构相似性(ΔSSIM)来评估质量增强性能,它衡量增强视频相对于压缩视频的改善程度。我们还从参数和计算成本的角度评估了质量增强方法的复杂性。

4.3 Comparison to State-of-the-arts

我们将提出的方法与最新的图像/视频质量增强方法、AR-CNN、DnCNN、RNAN,MFQE 1.0和MFQE 2.0进行了比较。为了公平比较,所有的图像质量增强方法都是在我们的训练集上重新训练的。视频质量增强方法的结果引用自。评估了我们的方法的三种不同配置的变体(有关详细信息,请参阅上一节)。1) STDF-R1,R=1,C1=32,C2=48,L=8。2)STDF-R3,R=3,C1=32,C2=48,L=8。3)STDF-R3L,R=3,C1=64,C2=64,L=16。

Quantitative Results.

表1和表2分别给出了精度和模型复杂度的定量结果。可以观察到,我们的方法在18个测试视频上始终优于所有比较的方法的平均ΔPSNR和ΔSSIM。更具体地说,在QP37,我们的STDF-R1优于mfqe2.0对大多数视频,并且拥有更快的处理速度和差不多的参数。我们注意到,我们的STDF-R1只是将前面和后面的帧作为参考,不像mfqe2.0使用高质量的相邻帧,从而节省了预先搜索那些高质量帧的计算成本。随着时间半径R增加到3,我们的STDF-R3设法利用更多的时间信息,从而进一步提高平均值ΔPSNR为0.75db,比mfqe2.0高34%,比mfqe1.0高63%,比RNAN高70%。由于所提出的STDF模块的高效率,STDF-R3的总体速度仍然比mfqe2.0快。此外,扩容后的STDF-R3L的ΔPSNR达到0.83db,表明该方法仍有改进的空间。类似的结果可以在ΔSSIM以及其他QP。

Qualitative Results.

图5提供了4个测试视频的定性结果。可以看出,压缩帧被各种压缩伪影严重扭曲(例如,和服中的铃声和四人中的模糊)。 尽管图像质量增强方法可以适当地减少这些伪影,产生的帧通常会变得过于模糊和缺乏细节。另一方面,视频质量增强方法在参考帧的帮助下取得了更好的增强效果。与mfqe2.0相比,我们的STDF模型对压缩伪影具有更强的鲁棒性,能够更好地挖掘时空信息,从而更好地恢复结构细节。

Quality Fluctuation.

据观察,压缩视频中存在显著的质量波动,这可能严重破坏时间一致性并降低QoE。为了研究我们的方法如何有助于这一点,我们在图6中绘制了两个序列的PSNR曲线。可以看出,我们的STDF-R1模型可以有效地增强大多数低质量帧并缓解质量波动。通过将时间半径R扩大到3,我们的STDF-R3模型成功地利用了相邻的高质量帧,从而获得了比其他方法更好的性能。

4.4 Analysis and Discussions

在本节中,我们进行了消融研究和进一步的分析。为了公平比较,我们只对融合方案进行了消融实验,并将QE网络固定为L=8,C2=48,所有模型都按照相同的协议和规则进行训练ΔPSNR/ΔSSIM在qp37对从B类到E类的所有测试视频进行平均。使用在480p视频上计算的浮点运算(FLOPs)来评估计算成本。

Effectiveness of STDF .

为了证明STDF对时间融合的有效性,我们将其与之前的两种融合方案进行了比较,即早期融合(EF)和早期运动补偿融合(EFMC)。具体来说,对于EFMC方案,我们选择了两个基于CNN的光流估计器进行运动补偿。1) EF_STMC,MFQE 2.0中使用的轻型空间变压器运动补偿(STMC)网络。2) EF_FlowNetS,FlowNet中使用的较大网络。我们在不同的时间半径R下训练模型来评估可伸缩性。

图7显示了比较结果。我们可以观察到,所有参考帧的方法都优于单帧baseline,证明了使用时间信息的有效性。当R=1时,STDF在ΔPSNR性能上显著优于EF和EFMC且计算量相当,说明STDF可以更好地利用时间信息。随着R的进一步增加,有趣的是ΔEF-STMC的峰值信噪比反而下降,EF-FlowNetS的峰值信噪比仅略有提高。我们认为原因是双重的。首先,光流估计器很难捕捉到长时间间隔的运动,这导致了附加参考帧的无效使用。其次,不同运动强度的训练样本可能会使光流估计器产生混淆,特别是对于容量相对较低的EF-STMC。相比之下,所提出的STDF考虑了整个视频片段,迫使偏移预测网络同时学习不同强度的运动。因此,STDF的ΔPSNR随着R的增加而不断提高。此外,随着R的增加,STDF的计算速度比EF-STMC和EF-FlowNetS慢得多,说明STDF的效率更高。

Effectiveness of STDC.

所提出的STDC具有特定于位置的采样特性,比传统的运动补偿融合方法具有更高的灵活性和鲁棒性。为了验证这一点,我们引入了一种方法的变体,用EFMC替换STDC。具体地说,EFMC中的光流估计器是从偏移预测网络修改而来的,其中网络的输出层被修改为用于流估计而不是偏移预测。根据表3,虽然用EFMC代替STDC时参数和触发器略有改善,但总体上R=1和R=3时的ΔPSNR分别下降0.04 dB和0.08 dB。这证明了所提出的STDC的有效性。

Effectiveness of Joint Offset Prediction.

提出了一种联合预测方法来生成STDC的可变形偏移量。为了证明其有效性,我们将其替换为成对预测方案。具体地说,我们修改了偏移预测网络的输入层和输出层,分别对每个参考目标对进行偏移预测。从表3我们可以看出ΔPSNR和ΔSSIM采用两两方案的联合预测方案在减少的同时,大大提高了FLOPs,表明该联合预测方案能够更好地利用时间信息,具有较高的效率。

5 Conclusion

我们提出了一种快速而有效的压缩视频质量增强方法,该方法结合了一种新颖的时空可变形卷积技术来聚集连续帧的时间信息。在基准数据集上,我们的方法在准确性和效率上都优于以前的方法。我们相信所提出的时空可变形卷积也可以扩展到其他与视频相关的低层次视觉任务,包括超分辨率、复原和帧合成,以实现高效的时间信息融合。

328

328

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?