一准备本地系统文件

1、在/home目录里创建test.txt

2、单词用空格分隔

3、执行命令:start-dfs.sh

4、将test.txt上传到HDFS的/park目录里

5、查看文件内容

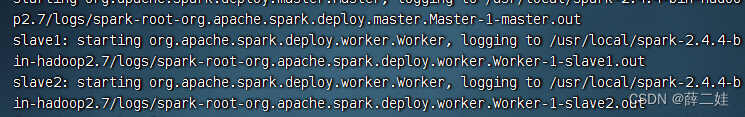

二启动Spark Shell

1、录执行命令:start-all.sh

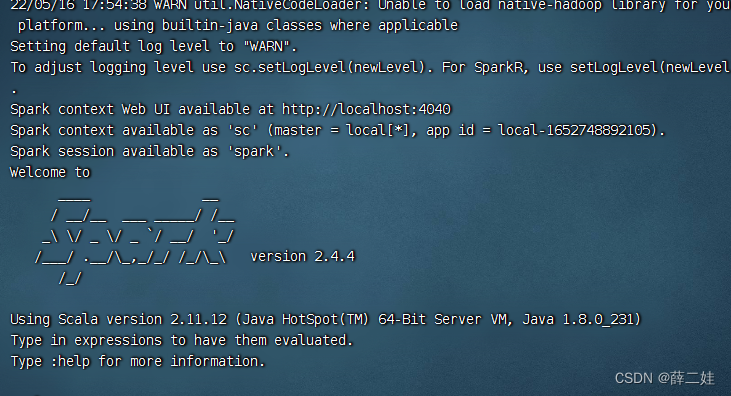

2、启动Spark Shell

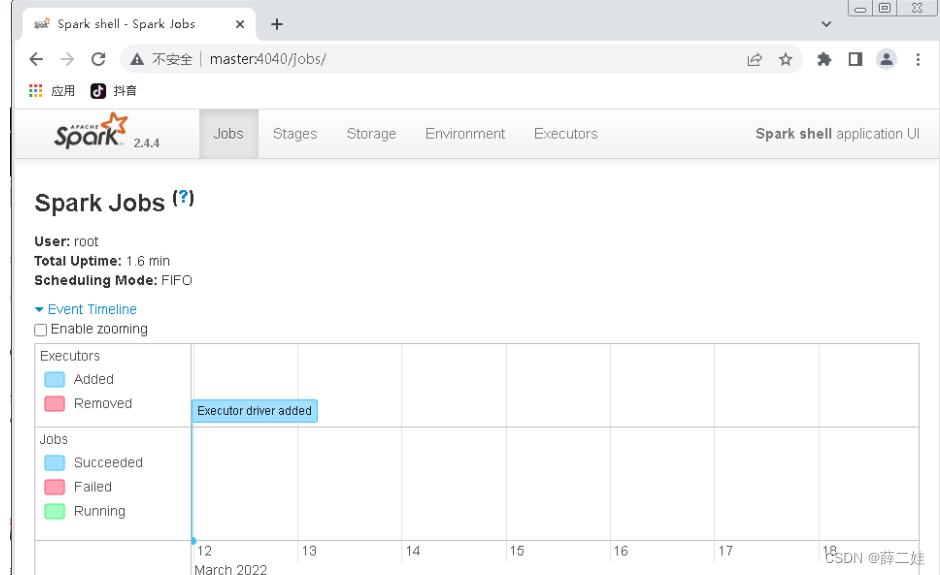

3、查看Spark Shell的WebUI界面

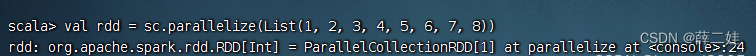

三、创建RDD

1、执行命令:val rdd = sc.parallelize(List(1, 2, 3, 4, 5, 6, 7, 8))

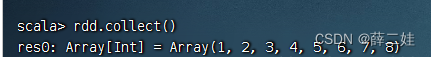

2、执行命令:rdd.collect(),收集rdd数据进行显示

3、执行命令:rdd.collect(),收集rdd数据进行显示

![]()

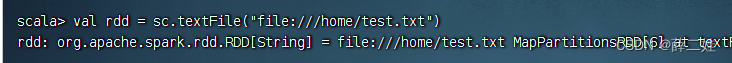

4、执行命令:val rdd = sc.textFile("file:///home/test.txt")

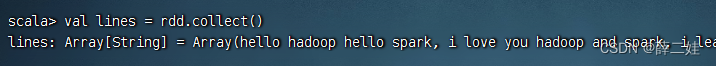

5、执行命令:val lines = rdd.collect(),查看RDD中的内容,保存到常量lines

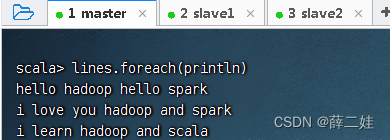

6、执行命令:lines.foreach(println)(利用foreach遍历算子)

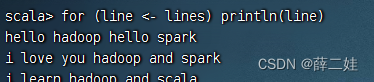

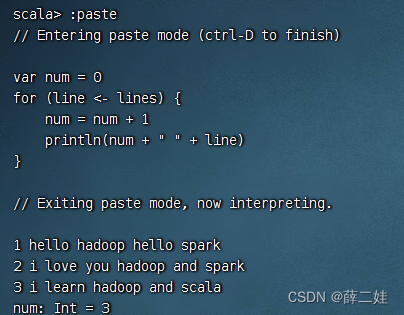

7、执行命令:for (line <- lines) println(line)

8、执行命令:for (line <- lines) println(line)

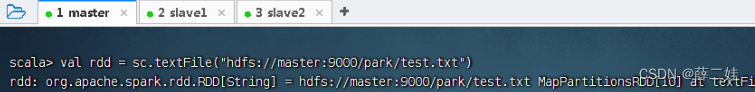

9、执行命令:val rdd = sc.textFile("hdfs://master:9000/park/test.txt")

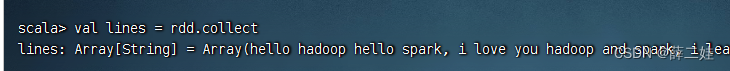

10、执行命令:val lines = rdd.collect,查看RDD中的内容

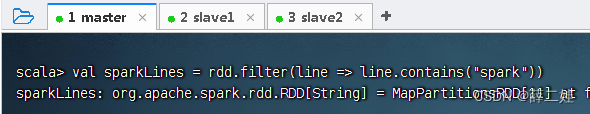

11、获取包含spark的行,执行命令:val sparkLines = rdd.filter((line) => line.contains("spark"))(filter是一个转换算子[transformation operator])

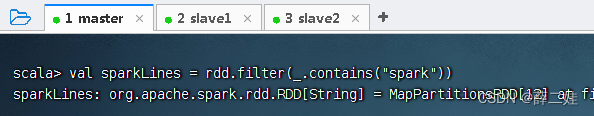

12、其实,有更简单的写法,执行命令:val sparkLines = rdd.filter(_.contains("spark"))

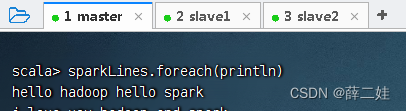

13、利用遍历算子显示sparkLines内容

本文档介绍了如何在Spark Shell中创建RDD,包括从HDFS读取数据,执行基本操作如显示、过滤和转换。首先,将文本文件上传到HDFS,然后启动Spark Shell并加载文件为RDD。通过各种命令,如`collect`、`foreach`和`filter`,展示了RDD数据处理的流程。

本文档介绍了如何在Spark Shell中创建RDD,包括从HDFS读取数据,执行基本操作如显示、过滤和转换。首先,将文本文件上传到HDFS,然后启动Spark Shell并加载文件为RDD。通过各种命令,如`collect`、`foreach`和`filter`,展示了RDD数据处理的流程。

1845

1845

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?