1 贝叶斯(bayes)概率的思考过程

- 我觉得,bayes公式需要先理解条件概率,全概率公式才行

- 纯从bayes公式的角度,其实是从 条件概率P(B | A) 开始,推导到联合概率P(AB) / P(A) ,然后再展开条件概率本身为全概率,逐步得到的

1.1 我的思维导图

1.2 条件概率

- P(B | A) =P(AB) / P(A)

- B事件在A事件已经发生基础上的条件概率 = AB的联合概率(交集) / 条件A发生的概率

- P(A) ,就是条件A,已经发生的事件A,的概率

1.3 计算作为分母的条件的全部概率(使用全概率公式)

巧妙的地方:主要实现了条件概率的两个事件反转!

- 全概率公式,实现了一个转换,或者说反转

- 就是把1个事件的概率,P(A) = 转化为,另外一群事件B1...Bn的概率*条件概率,就是另外一个完备划分的条件B1...Bn概率*条件B1...Bn的概率的和。

- 首先,要用来计算全概率的,那些事件有2个要求,第1,要能做成一个完备样本空间S,第2,互相之间互斥不相交

- 某概率= ∑ 联合概率

- P(B)=P(BA1)+P(BA2)+...+P(BAn)

- 某概率= ∑ 条件概率* 条件发生概率

- P(B) =P(B|A1)P(A1) + P(B|A2)P(A2) + ... + P(B|An)P(An)=P(BA1)+P(BA2)+...+P(BAn)

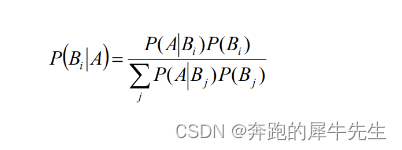

1.4 贝叶斯公式,bayes概率

- 条件概率= 联合概率/全概率 = 先验概率 * 条件概率 / 全概率

- 推导步骤

- 第1步,条件概率= 联合概率 :P(A|B) = P(AB) / P(B)

- 第2步,条件概率= 展开为基于其他事件Ai的条件概率*其他事件Ai概率

- P(A|B) = P(A1B) / P(B) = P(B|A1)* P(A1) / P(B)

- P(A|B) = P(AB) / P(B) = P(A|B)* P(B) / P(B) = P(A|B) 你也可以这样展开,恒等式展开没意义

- 第3步,其他事件概率展开为基于A1...Ai的全概率公式

- P(A|B) = P(A1B) / P(B) = P(B|A1)* P(A1) /P(B|A1)P(A1) + P(B|A2)P(A2) + ... + P(B|An)P(An)

2 bayes公式和bayes概率的理解

2.1 bayes公式的理解

- 条件概率= 联合概率/全概率

- = 先验概率 * 条件概率 / 全概率

- P(A|B) = 交叉部分 P(AB) / p(B)

- 因为条件概率好获得,联合概率其实挺难知道?所以下面转化为 条件概率,并且A和B的条件关系互换了!

- P(A|B) = P(A) * P(B|A)/P(B)

- 后验概率 先验概率 * 调整系数

- P(A|B) = P(A) * P(B|A) / P(A) * P(B|A)+P(A') * P(B|A')

- 这公式正好说明了,P(A|B) = P(A) * P(B|A)+P(A') * P(B|A') 的前面那一部分P(A) * P(B|A) 占整个乘积之和 : P(A) * P(B|A)+P(A') * P(B|A') 的比例

- 即 P(A|B) = 条件概率*条件1本身 / 条件概率*条件1~n的概率之和 (就是一个占比关系)

2.2 先验概率, 后验概率, 似然系数

下图为网图,知乎找的图

按这些术语,Bayes法则可表述为:

- P(A|B)称为后验概率(posterior)

- P(A)称为先验概率(prior), 根据经验+已有信息(但默认不含最新信息)对A发生概率的估计

- P(B|A)称为似然系数(likelihood)

- 在事件A发生的情况下,事件B(或evidence)的条件概率有多大

- P(B)称为证据(evidence),即无论A事件如何,事件B(或evidence)本身的可能性有多大,为啥这个叫证据?因为 P(B) 和P(A) 是2个不同的事件?

- 有的也把 P(B|A)/P(B) 统一成为似然系数

- 后验概率 = (似然度 * 先验概率) / 条件事件本身的概率

- 后验概率 =先验概率 * (似然度 / 证据 )

- 后验概率与先验概率和似然度的乘积成正比。

- 比例Pr(B|A)/Pr(B)也有时被称作标准似然度(standardised likelihood),

- Bayes法则可表述为:后验概率 = 标准似然度 * 先验概率。

似然度=可能性系数=似然度系数 的意义

- 如果"可能性函数"P(B|A)/P(B)>1,意味着"先验概率"被增强,事件A的发生的可能性变大;

- 如果"可能性函数"=1,意味着B事件无助于判断事件A的可能性;

- 如果"可能性函数"<1,意味着"先验概率"被削弱,事件A的可能性变小

3 贝叶斯公式的意义

3.1 没有贝叶斯概率之前: 都是正向思考和正向概率?

- 再bayes之前概率,可能主要是古典模型

- 古典模型已经假设了均等概率,也就知道了概率分布,推论后面实验N次发生XX事件的概率,是比较清晰的,相当于是一个演绎逻辑。

- 也就是,知道了真实先验概率(先验概率是真实的)的分布了再计算问题

- 上帝视角

- 演绎逻辑

- 正向概率 :上帝视角,知道所有信息后,往下推,可以很准

- 正向概率,可以通过多次重复做实验验证

- 也就是可以用 实验结果的频率,去验证先验概率,确实是对的

- 大样本下 概率=频率

3.2 贝叶斯公式的出发点:逆向概率,用客观去修正主观

- 现实中,信息不全

- 知道结果,反过来去推论发生的原因

- 生活视角,知道了结果,去预测未来?

- 有些实验无法反复做,比如今天是否下雨,无法像时间循环穿越电影那样永远测试同一天,因为只能用过去的统计数据来预测今天是否下雨,不过预测对错,今天过去了就也无法再实验今天,马上又遇到一个崭新的问题:明天是否下雨?

- 贝叶斯概率,是一种逆向思维,逆概率

- 为啥叫逆概率:因为是知道了结果去推原因?

- 非上帝视角的逆推,溯源思考?

- 比如,我从N个袋子里摸出一个球,那么这个球来自其中一个袋子的概率是多少呢?是1/N吗?1/N是一般的先验概率,我们没有更多信息,只能假设随机拿1个球,来自各个袋子的概率是均等的,和丢硬币一样。所以只能假设为1/N

- 所以,用这个例子解释

- 先验概率就是主观的,而获得其他信息都是客观信息,最终能修正主观概率P(A) ,得到更准确的相对客观一些的 P(A|B)

- 所以 bayes概率,是偏统计的,归纳逻辑?

3.3 关于先验概率的思考:什么叫先验概率?

- 实验发生以前,人根据自己以前的经验的对某事件发生概率的估计

- 既然先验是主干的,那么就应该是可以人人不一样的

- 比如,孩子对1个事情概率的估计和成年人就应该不同,不同文化的人的主观先验概率有差别也应该很正常

- 但是很多概率题目,习惯默认大家必须有一样的先验概率,这个是为什么呢?我想了想,一个是因为,纯主观问题就不好讨论的,另外一个原因,就是大概bayes开始时,以前比较经典的就是等概率的古典模型,所以默认大家都主观的选择 等概率模型把,哈哈。

- 不过,等概率模型,确实是人对概率这个东西一个很朴素的概念!同意

- 但是其实,还是有点瑕疵的

3.4 学习和预期修正的例子

- 预期修正

- 学习

- 例子

- 比如,我从N个袋子里摸出一个球,那么这个球来自其中一个袋子的概率是多少呢?是1/N吗?1/N是一般的先验概率,我们没有更多信息,只能假设随机拿1个球,来自各个袋子的概率是均等的,和丢硬币一样。所以只能假设为1/N

- 但是一旦知道,每个袋子里球的多少,甚至黑球白球多少,以及拿道是黑球白球就可以展开进一步的推论,这个过程,是预期修正,是学习过程?

- 比如知道N个袋子为2个袋子,A袋子?个球,B个袋子?个球,随意摸1个,来自A的概率50%

- 比如知道N个袋子为2个袋子,A袋子8个球,B袋子2个球,随意摸1个,来自A的概率

- P(任一|来自A)= 1/2*8 /(1/2*8+1/2*2) =4/5=80%

- 如果有黑球白球之分就更能分辨了

4 哪些情况下,需要用到bayes概率原理?

在已经某些事件已经发生的条件下,贝叶斯公式可用来寻找导致发生的各种原因的概率,或者选择相关其他事件的发生概率。

- 根据已经发生的事件,作为结果去推测原因

- 根据已经发生的事件,作为条件,去推测相关联事件的概率

- 根据已经发生事件,不断修正,对某事件概率P的认知

4.1 情况1:我们经常需要根据 结果去推测原因,因为结果好观测,但是原因往往不可观测

- 从结果去反推原因

- 比如,下雨100%就有乌云 ,但是那有乌云下雨概率多大呢?

- 乌云是下雨的必要条件,但是不是下雨的充分条件,所以不能从乌云100%推导出下雨,但需要从乌云去推测下雨的概率,就需要用贝叶斯的思想。

4.2 情况2 用于预测未来

- 呃,这用啥例子?

- 大概是先验概率,是过去的经验总结

- 后验概率,是为了预测未来可能发生的事情吧

- 比如,丢骰子,买彩票,根据先验概率去预测 自己这次要不要买彩票?呃

4.3 情况3: 视角转换

- 知道一些东西的规律,根据这个,去推测我们不知道的不好测量的内容

- 生活中,经常容易得到P(B|A),但是我们更想知道P(A|B)

- 比如实验室可以做实验得到某些药品的有效率,甚至误测率

- 但是想知道,试纸测出的效果多少概率表示背后对应的症状,这个得用bayes概率思想

4.4 其他

- bayes思想确实很牛逼

- 还有没有其他情况,咱也不知道,咱也不敢说,先写在这等等把 ^ ^

5 贝叶斯定理作用

- 提高先验概率,可以有效的提高后验概率 ?

- 只按经验有先验概率,根据其他信息的暴露越多,可以修正先验概率,接近更真实的概率本身?

- 能说明支撑某个说法的事情,发生的越多,那么这个说法是真的可能性就越大。

5.1 要点1:逆向思考

贝叶斯就是逆概率问题!

- 正向概率 :上帝视角,知道所有信息后,往下推,可以很准

- 贝叶斯概率是逆向概率,知道结果,反过来去推论发生的原因 ,或者是知道一些过去经验,去推测我们不知道的不好测量的内容,或者是预测未来。

5.2 要点2:预期修正

贝叶斯概率,可以通过不断增加信息,修改似然系数,提高对后验概率准确度

- 可以通过增加信息,通过行为的次数增多判断这个人的品质

- 一直做好事的更容易是好人

5.3 认知迭代和学习

我们和机器都可以通过beyes思路,进行认知迭代和学习

- 据说人的大脑就是一种贝叶斯思考的模式

- 现在人工智能,AI 也在使用bayes概率的思考模式,用大量的素材去训练AI,进行认知迭代,变得更智能,从而达到认知更新和迭代

- 贝叶斯规则给出了一个规则,即将一些先验的信念(贝叶斯认为概率是对某种信念的度量)与观察到的数据结合起来,来更新信念,这个过程也称为“学习”。或者说,我们的信念随着获得的信息增多而发生改变

- 例子

- 比如,我从N个袋子里摸出一个球,那么这个球来自其中一个袋子的概率是多少呢?是1/N吗?1/N是一般的先验概率,我们没有更多信息,只能假设随机拿1个球,来自各个袋子的概率是均等的,和丢硬币一样。所以只能假设为1/N

- 但是一旦知道,每个袋子里球的多少,甚至黑球白球多少,以及拿道是黑球白球就可以展开进一步的推论,这个过程,是预期修正,是学习过程?

5.4 bayes公式:主观思考和客观世界的桥梁

- bayes公式:主观思考和客观世界的桥梁 ,理论上我没太理解这个

- 但是有一个题目的例子让我勉强理解这个意思

- 比如常见题

- A袋子里有2黑2白,B袋子有1黑3白

- 如果随机取1个黑球,问来自袋子A的概率多大?

- 如果随机取出来的是一个球,而不知道是黑球,那么这个球来自A和B的概率,我们没有更多信息,只能盲猜是50%,这个就是先验概率吧?

- 但是如果知道取出来的这个球,是黑球,就可以计算来自A袋子的概率

- P(来自A| 随机取到1个黑球) = P( 随机取到1个黑球| 来自A) / P(随机取到1个黑球)

- = P( 随机取到1个黑球| 来自A) / P(随机取到1个黑球)

- =(2/4*1/2) / (2/4*1/2+1/4*)=2/3

- 先验概率

- P(来自A| 随机取到1个球) =1/2

- 后验概率

- P(来自A| 随机取到1个黑球) =2/3

- 似然系数,就是两个袋子里球的分布吧,这个也是有用的信息

- 大概这么解释是对的吧,呃 ~ ~

6 其他例子

- 网上有一些处理垃圾邮件的贝叶斯思路例子,学习,挺有意思

- 下图来源网上,搜垃圾邮件,贝叶斯可以搜到,暂存以后学习

2019

2019

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?