文章目录

一、主机设置

1、修改主机名称

master是修改后的主机名,根据自己的需求进行修改

hostnamectl set-hostname master

可以通过hostname查看主机名,修改完成后重启节点

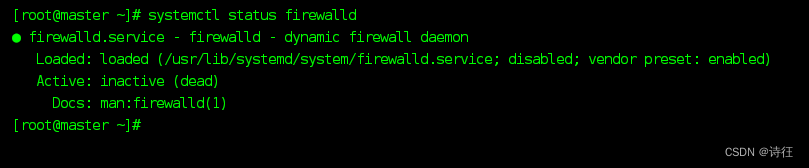

2、关闭防火墙

先关闭三个节点的防火墙

#关闭防火墙

systemctl stop firewalld

#关闭开机自启动模式

systemctl disable firewalld

查看防火墙信息

systemctl status firewalld

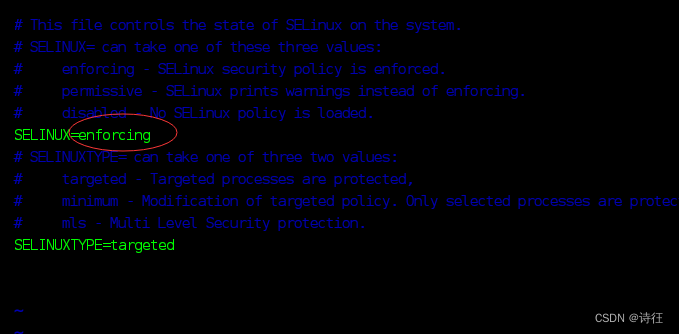

修改三台主机安全机制

vim /etc/sysconfig/selinux

将enforcing修改为disabled

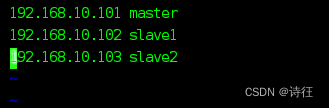

3、配置主机映射

vim /etc/hosts

这里根据自己的连接ip和主机名做调整

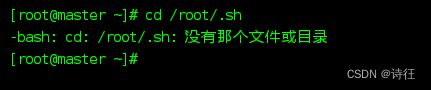

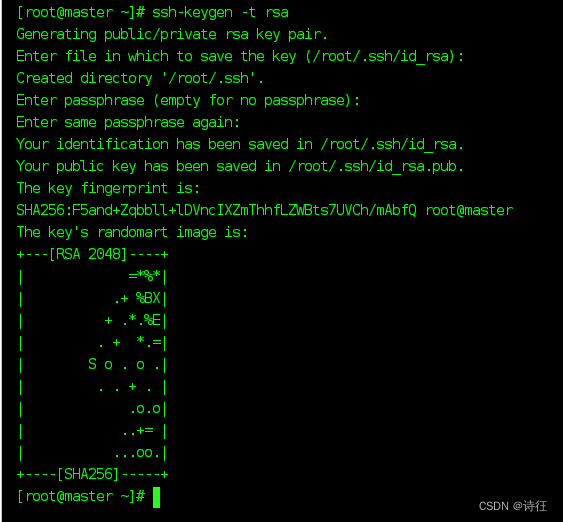

4、设置免密登录

cd /root/.sh

遇到这个问题直接跳过,做好下一步就会刷新出来

ssh-keygen -t rsa

连续敲三下回车

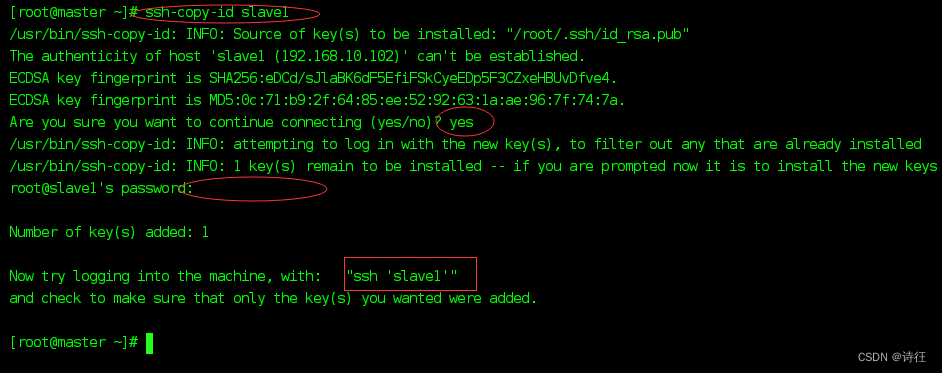

拷贝三台主机公钥

ssh-copy-id root@主机名

回车之后会提示你是否继续设置免密,我们输入yes,然后会让你输入你的节点密码

输入密码时看不见,只管输入就行

当出现ssh 节点名时,这个节点就可以免密登录了

三个节点都是用同样方法连接到其他两个节点

免密登录

#登录

ssh 节点名

#登出

exit

二、安装jdk

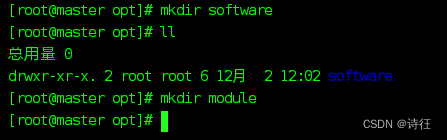

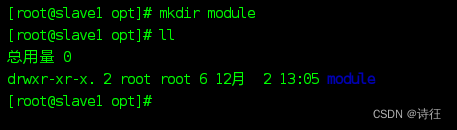

1、创建存放位置

在opt下创建module和software两个文件夹

#用于存放压缩文件

mkdir software

#用于存放解压位置

mkdir module

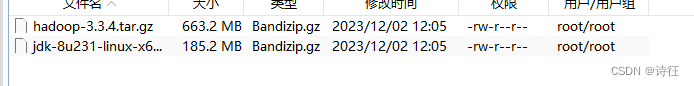

将我们要用的包上传到software

2、解压文件

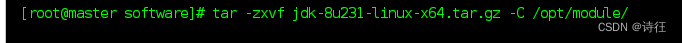

在software目录下输入:

tar -zxvf jdk-8u231-linux-x64.tar.gz -C /opt/module/

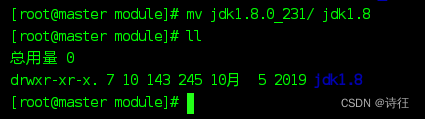

修改文件名,因为这里文件名长而且复杂,我们修改一下,方便后面配置

进入module目录下,输入:

#mv 原文件名 修改后的名称

mv jdk1.8.0_231/ jdk1.8

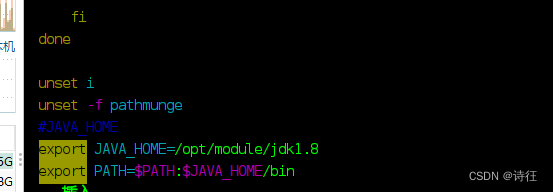

3 、配置jdk环境变量

vim /etc/profile

在最下面加上这三句

#JAVA_HOME

export JAVA_HOME=/opt/module/jdk1.8

export PATH=$PATH:$JAVA_HOME/bin

保存配置

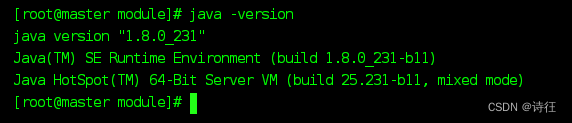

source /etc/profile

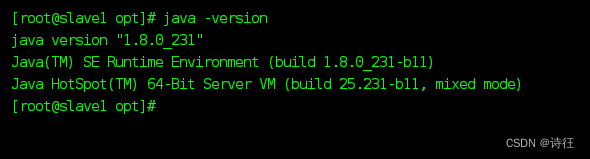

查看是否配置成功

java -version

出现版本号就表示jdk配置成功了

4、分发jdk

提前在slave1和slave2/opt下

将jdk文件发到slave1和slave2

scp -r /opt/module/jdk1.8 root@slave1:/opt/module/

scp -r /opt/module/jdk1.8 root@slave2:/opt/module/

分发配置文件

scp -r /etc/profile root@slave1:/etc/profile

scp -r /etc/profile root@slave2:/etc/profile

到slave1和slave2中保存配置信息

source /etc/profile

验证分发之后的jdk

三、安装hadoop

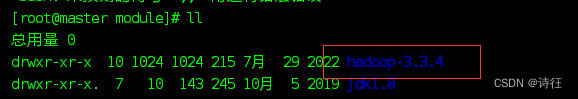

1、解压hadoop文件

进入software目录下输入:

tar -zxvf hadoop-3.3.4.tar.gz -C /opt/module/

2、配置环境变量

vim /etc/profile

在最下面加上这几条

#HADOOP_HOME

export HADOOP_HOME=/opt/module/hadoop-3.3.4

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin:PATH

保存配置

source /etc/profile

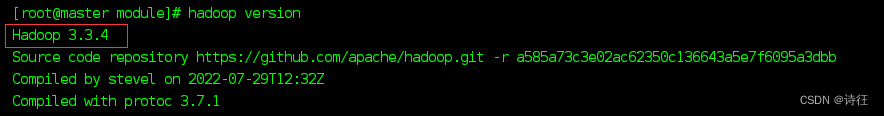

测试hadoop是否安装成功

hadoop version

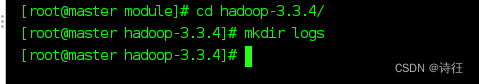

在hadoop下创建logs目录

进入Hadoop下输入:

mkdir logs

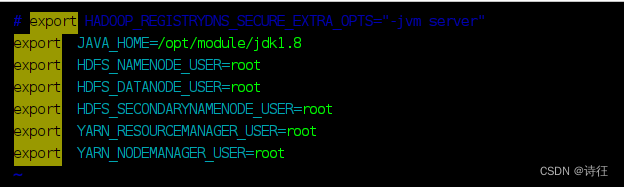

3、修改Hadoop配置文件 hadoop-env.sh

cd $HADOOP_HOME/etc/hadoop #进入环境配置目录下,配置Hadoop集群

配置 hadoop-env.sh

vim hadoop-env.sh

将以下代码写入

export JAVA_HOME=/opt/module/jdk1.8

export HDFS_NAMENODE_USER=root

export HDFS_DATANODE_USER=root

export HDFS_SECONDARYNAMENODE_USER=root

export YARN_RESOURCEMANAGER_USER=root

export YARN_NODEMANAGER_USER=root

4、修改Hadoop配置文件 core-site.xml

vim core-site.xml

在中输入以下内容

<property>

<name>fs.defaultFS</name>

<value>hdfs://master:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/module/hadoop-3.3.4/tmp</value>

</property>

<property>

<name>hadoop.proxyuser.root.hosts</name>

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.root.groups</name>

<value>*</value>

</property>

5、HDFS配置文件hdfs-site.xml

vim hdfs-site.xml

在中输入以下内容

<property>

<name>dfs.namenode.name.dir</name>

<value>/opt/module/hadoop-3.3.4/tmp/name</value>

<final>true</final>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/opt/module/hadoop-3.3.4/tmp/data</value>

<final>true</final>

</property>

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

<property>

<name>dfs.permissions.enabled</name>

<value>false</value>

</property>

6、YARN配置文件yarn-site.xml

vim yarn-site.xml

在中输入以下内容

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.vmem-check-enabled</name>

<value>false</value>

</property>

<property>

<name>yarn.nodemanager.pmem-check-enabled</name>

<value>false</value>

</property>

7、 MapReduce 配置文件mapred-site.xml

vim mapred-site.xml

在中输入以下内容

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

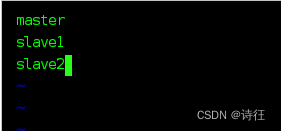

8、配置workers

vim workers

将Hadoop分发给slave1、slave2

scp -r /opt/module/hadoop-3.3.4 root@slave1:/opt/module

scp -r /opt/module/hadoop-3.3.4 root@slave2:/opt/module

将Hadoop配置分发给slave1、slave2

scp -r /etc/profile root@slave1:/etc/profile

scp -r /etc/profile root@slave2:/etc/profile

保存配置

source /etc/profile

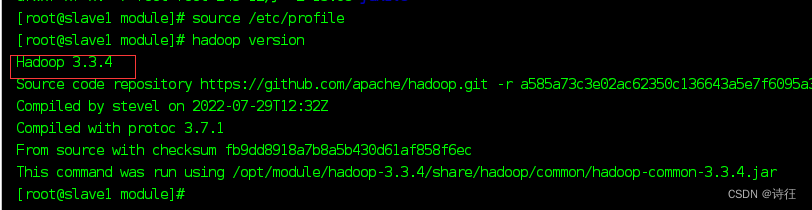

查看slave1和slave2是否成功安装hadoop

将集群配置分发给slave1、slave2

scp -r $HADOOP_HOME root@slave1:/opt/module

scp -r $HADOOP_HOME root@slave2:/opt/module

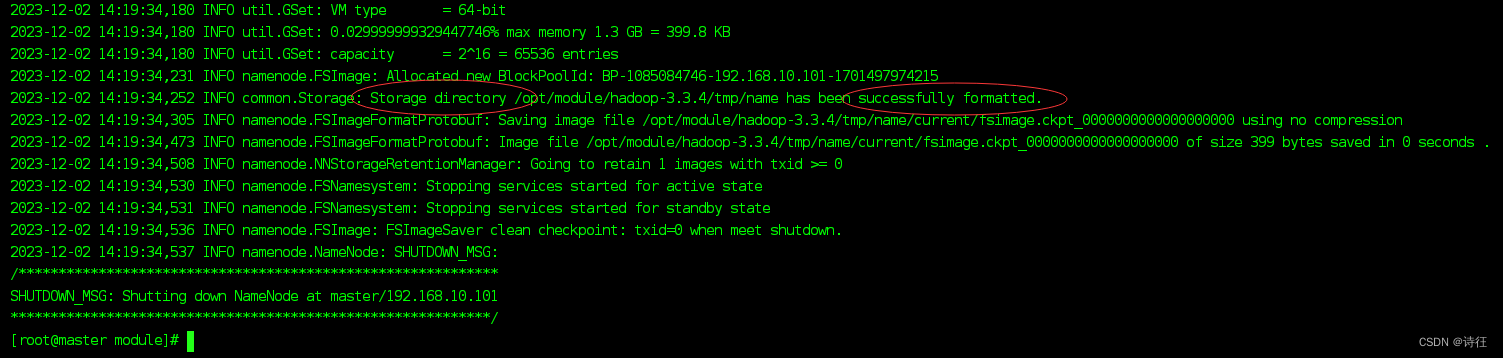

9、进行初始化Hadoop3

hdfs namenode -format

10、启动Hadoop

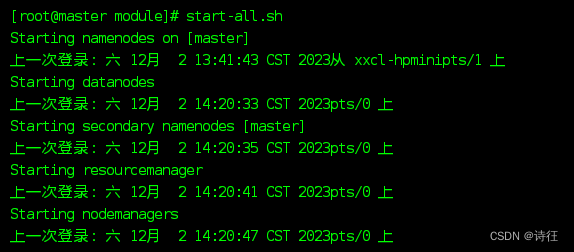

start-all.sh

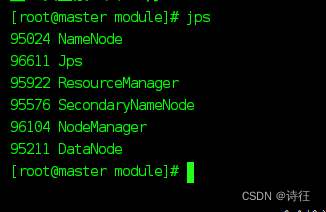

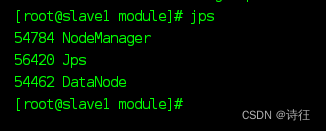

查看进程,主节点有6个进程,其他两个节点三个进程

11、关闭Hadoop

stop-all.sh

707

707

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?