问题1:求解 l1,∞ 范数子问题。

即求解在文献2中,有公式(10):

minw12||w−v||22+λ^||w||∞问题1

因为二次函数的共轭是仍然是二次函数,

l∞

范数的共轭是

l1

障碍函数。因此得到公式(10)的对偶形式为如下公式(11):

mina12||a−v||22s.t.||a||1≤λ^

其中 a=v−w .

公式(10)到公式(11)是怎么推导的呢?(由于 α 打不出矢量的形式(粗体),我们使用 a 代替)

疑问:一说到函数的对偶,一般就是拉格朗日对偶,即有约束的函数才有对偶形式,公式(10)是无约束的情况,如何求解其对偶函数呢?

突破口:将无约束的问题转换为有约束的问题。从题中可以看到,公式(11)多了一个等式条件:

解:

参照文献1中17.4.2 Dual construction via conjugates of pairs of functions

我们将公式(10),引入约束

a=v−w

,则

w=v−a

,将其带入公式(10)中的第二个公式得到;

minw,a12||w−v||22+λ^||v−a||∞s.t.w=v−a

写成拉格朗日的形式为:

g(u)=minw,a12||w−v||22+λ^||v−a||∞+uT(v−w−a)

进行变量的分解:

g(u)=minw12||w−v||22−uTw+minaλ^||v−a||∞−uT(a−v)

转换为求最大值:

g(u)=−maxwuTw−12||w−v||22−maxauT(a−v)−λ^||v−a||∞

进行变量的替换,化简第二项:

g(u)=−maxwuTw−12||w−v||22−maxa−uT(v−a)−λ^||v−a||∞g(u)=−maxwuTw−12||w−v||22−maxw−uT(w)−λ^||w||∞

因此,由共轭函数的定义,上述可以表示成共轭形式,其中令 f1(w)=12||w−v||22 , f2(a)=λ^||a||∞ :

maxug(u)=maxu−f∗1(u)−f∗2(−u)

即为:

argminug(u)=argminuf∗1(u)+f∗2(−u)

由2范数的平方的共轭函数是其本身,范数的共轭函数是其对偶范数单位球的示性函数[参见凸优化102页,例3.26]。并且由范数的性质:

||−x||=||x||

我们最终得到公式(11)。

还有一点是,函数 f(x)=||x|| 的共轭函数是:

f∗(y)={0∞||y||∗≤1其他情况

那么函数 f(x)=λ||x|| 的共轭函数是:

f∗(y)={0∞||y||∗≤λ其他情况

其可以通过参考: http://blog.csdn.net/raby_gyl/article/details/53178467

中的一维情况来理解(此时 y,λ 均相当于线的斜率)。

问题2:求解 l1,2 范数子问题

即求解问题:

minw12||w−v||22+λ^||w||2问题2

可能可行的求解方法:上面是关于 w 的二次函数,如果我们直接对 f(w) 关于 w 求偏导,然后令其等于0.

∂f(w)∂w=w−v+λ^w||w||2=0

显然,通过上的公式我们很难化简出来 w .

可行的方法: 和上面类似,我们引入一个等式约束,然后利用求解带有等式约束的拉格朗日对偶函数。

等式约束:

a=v−w

同上面类似,范数平方的共轭是其本身,而范数的共轭是对偶范数在单位球上的示性函数,并且将最大化问题转化为共轭的问题,因此转化为下面的优化问题:

mina12||a−v||22s.t.||a||2≤λ^

其中 a=v−w 。

很显然,如果 ||v||2≤λ^ ,则 a=v ,则 w=v−v=0 。

在观察一下公式问题2,假定存在一个 w∗ 使得问题2最小化,并且 w∗ 与 v 不共向,即不满足:

w∗≠kv

,则必然存在另外一个向量

w0

,其大小和

w∗

相同,方向和

v

相同,即满足:

w0=v||v||2∗||w∗||

.

那么必有 f(w0)<f(w∗) ,与已知相矛盾,所以可得最优解 w∗ 与 v 同方向,即满足:

w∗=kv

那么 a 也与 v 同向,即满足:

a=k′v

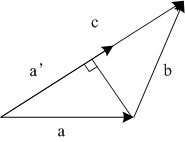

如上图,向量b=c-a,令向量c代表v,向量a代表w,那么我们总能找到一个a’,其大小与a相同,方向与c同向,可知道|c-a’|<|c-a|=|b|.

现在我们已知的条件有:

minw12||a−v||22s.t.||a||2≤λ^a=k′v

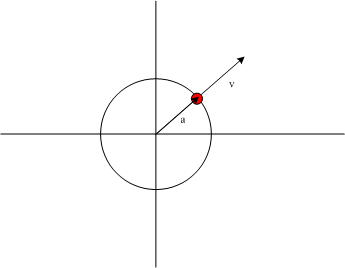

我们可以通过画图的方式简单的求解:

点 v 或者说向量 v 到圆内最近投影肯定在圆的边界上,并且投影后的矢量与 v 同向,即图中红色的点所示,其大小为圆的半径,其方向为 v 的方向,因此有:

a=尺度∗方向=λ^v||v||2

则 w=v−λ^v||v|| .

因此最后的最优解为:

w∗=⎧⎩⎨⎪⎪(1−λ^||v||2)v0||v||2>λ^||v||2≤λ^

参考文献:

1. 10-725: Optimization Fall 2012

Lecture 17: October 23

Lecturer: Geoff Gordon/Ryan Tibshirani Scribes: Yifei Ma, Mahdi Pakdaman Naeini

2. Accelerated Gradient Method for Multi-Task Sparse Learning Problem

8914

8914

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?