高并发系统实战课

场景

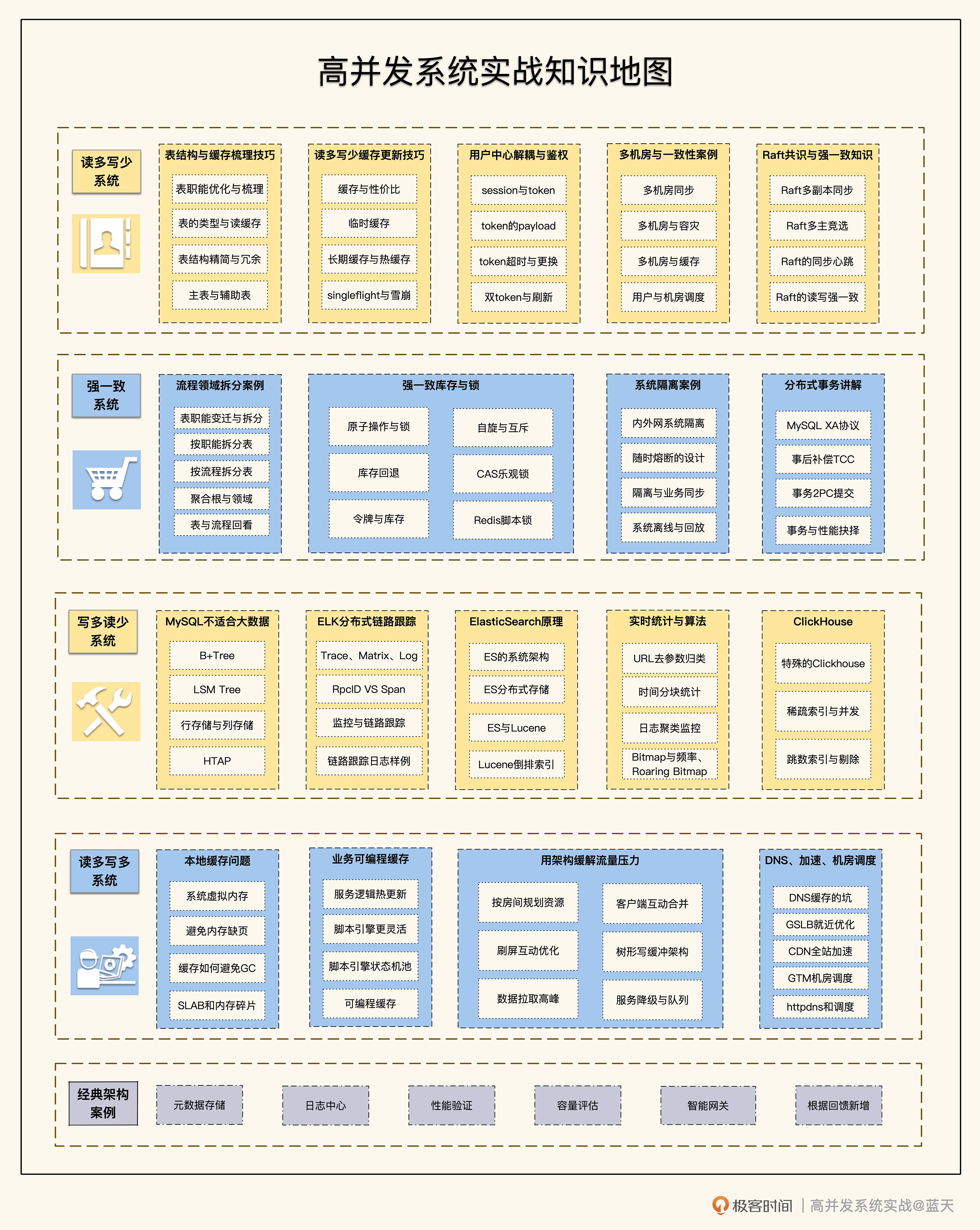

读多写少

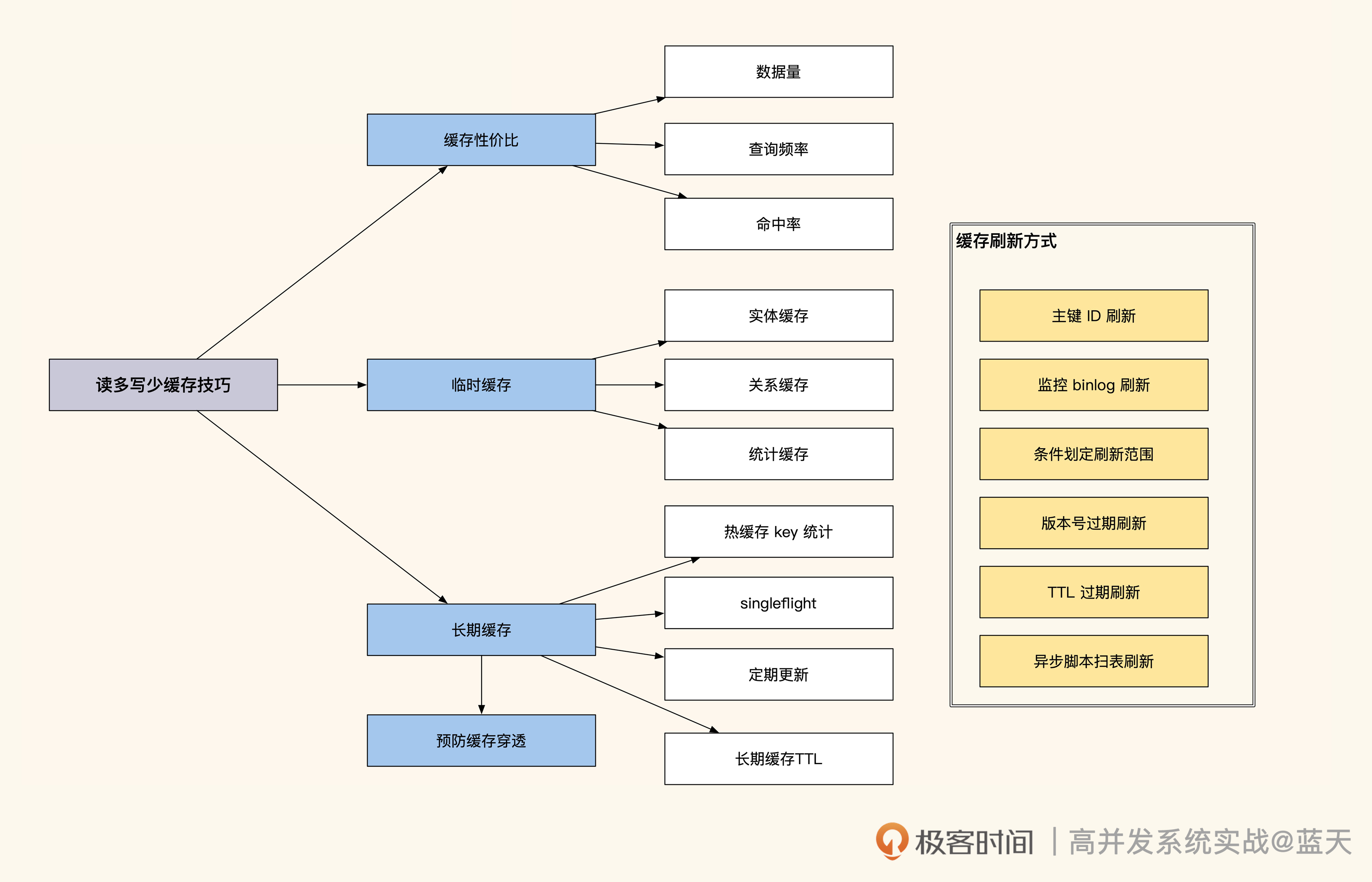

我会以占比最高的“读多写少”系统带你入门,梳理和改造用户中心项目。这类系统的优化工作会聚焦于如何通过缓存分担数据库查询压力,所以我们的学习重点就是做好缓存,包括但不限于数据梳理、做数据缓存、加缓存后保证数据一致性等等工作。

另外,为了帮你从单纯的业务实现思想中“跳出来”,我们还会一起拓展下主从同步延迟和多机房同步的相关知识,为后续学习分布式和强一致打好基础。

强一致性

这类系统的主要挑战是承接高并发流量的同时,还要做好系统隔离性、事务一致性以及库存高并发争抢不超卖。我会和你详细讨论拆分实践的要点,让你加深对系统隔离、同步降级和库存锁等相关内容的认识,弄明白分布式事务组件的运作规律。了解这些,你会更容易看透一些基础架构组件的设计初衷。

写多读少

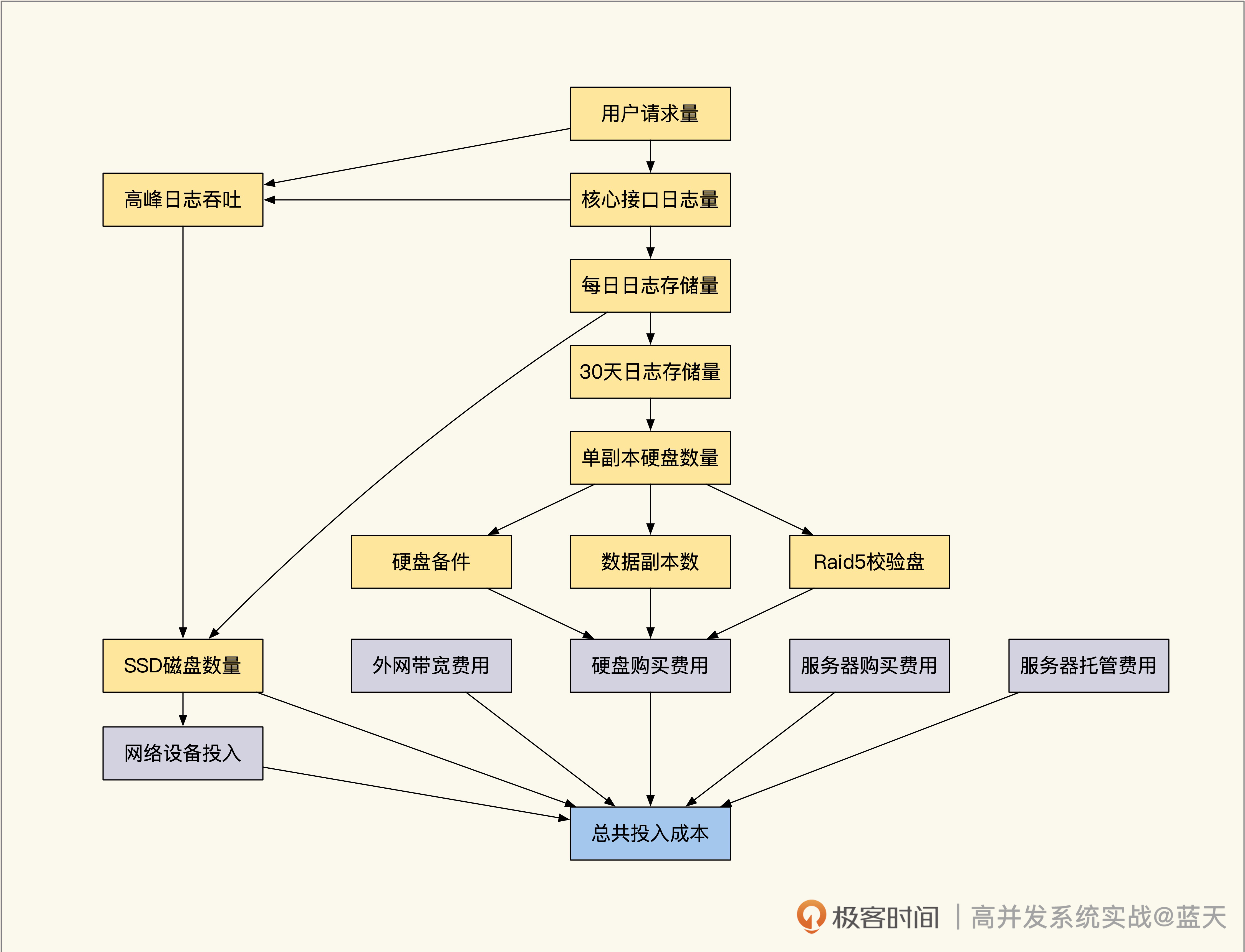

接下来是高并发写系统,它涉及大量数据如何落盘、如何传输、存储、压缩,还有冷热数据的切换备份、索引查询等多方面问题,我会一一为你展开分析。我还会给你分享一个全量日志分布式链路跟踪系统的完整案例,帮你熟悉并发写场景落地的方方面面。

读多写多

读多写多系统是最复杂的系统类型,就像最火热的游戏、直播服务都属于这个类型。其中很多技术都属于行业天花板级别,毕竟线上稍有点问题,都极其影响用户体验。

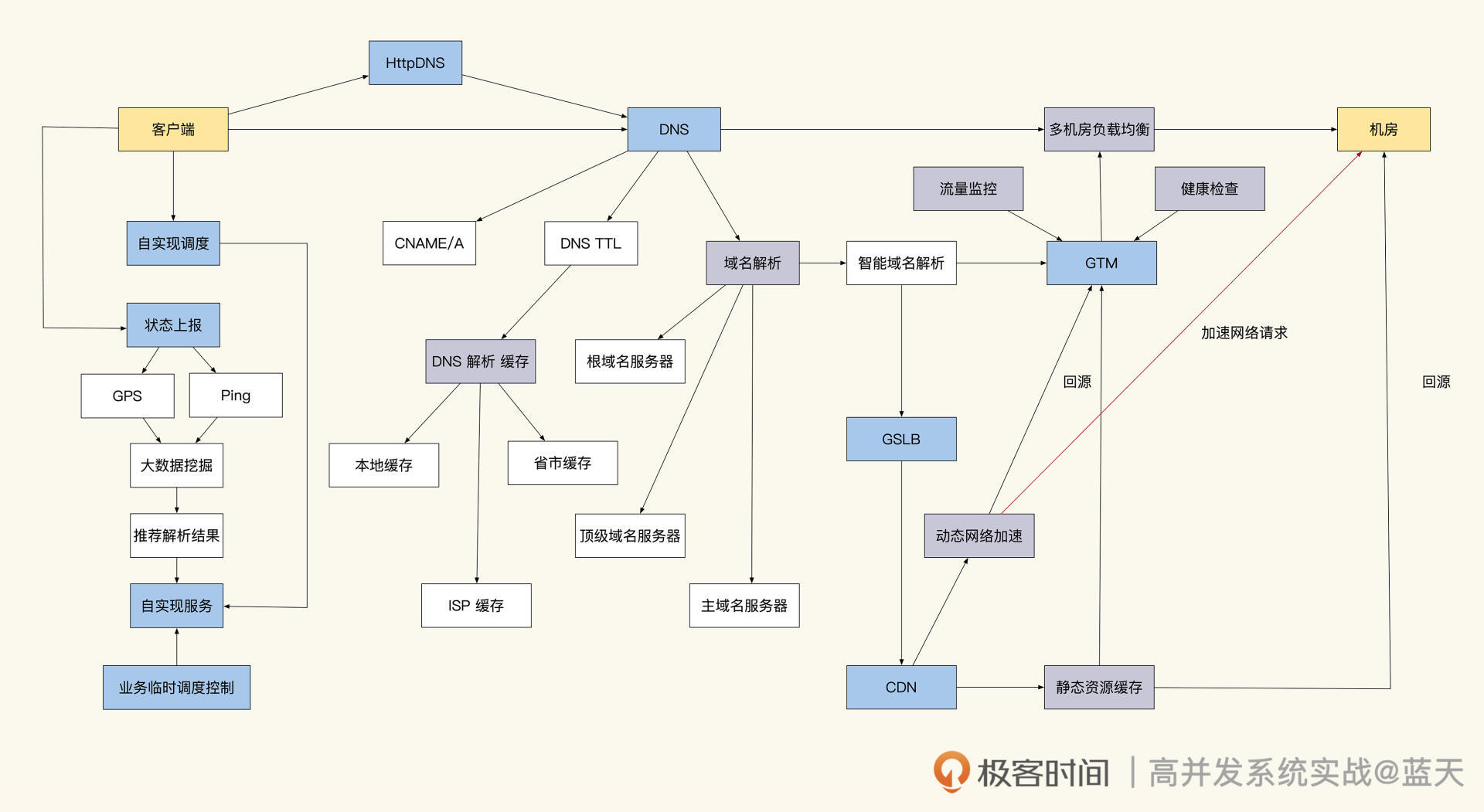

这类系统数据基本都是在内存中直接对外服务,同时服务都要拆成很小的单元,数据是周期落到磁盘或数据库,而不是实时更新到数据库。因此我们的学习重点是如何用内存数据做业务服务、系统无需重启热更新、脚本引擎集成、脚本与服务互动交换数据、直播场景高并发优化、一些关于网络优化 CDN 和 DNS、知识以及业务流量调度、客户端本地缓存等相关知识。

用户中心:读多写少的系统高并发优化实践

结构梳理:大并发下,你的数据库表可能成为性能隐患

因为老系统在使用数据库的时候存在很多问题,比如实体表字段过多、表查询维度和用途多样、表之间关系混乱且存在 m:n 情况……这些问题会让缓存改造十分困难,严重拖慢改造进度。

如果我们从数据结构出发,先对一些场景进行改造,然后再去做缓存,会让之后的改造变得简单很多。所以先梳理数据库结构,再对系统进行高并发改造是很有帮助的。

精简数据会有更好的性能

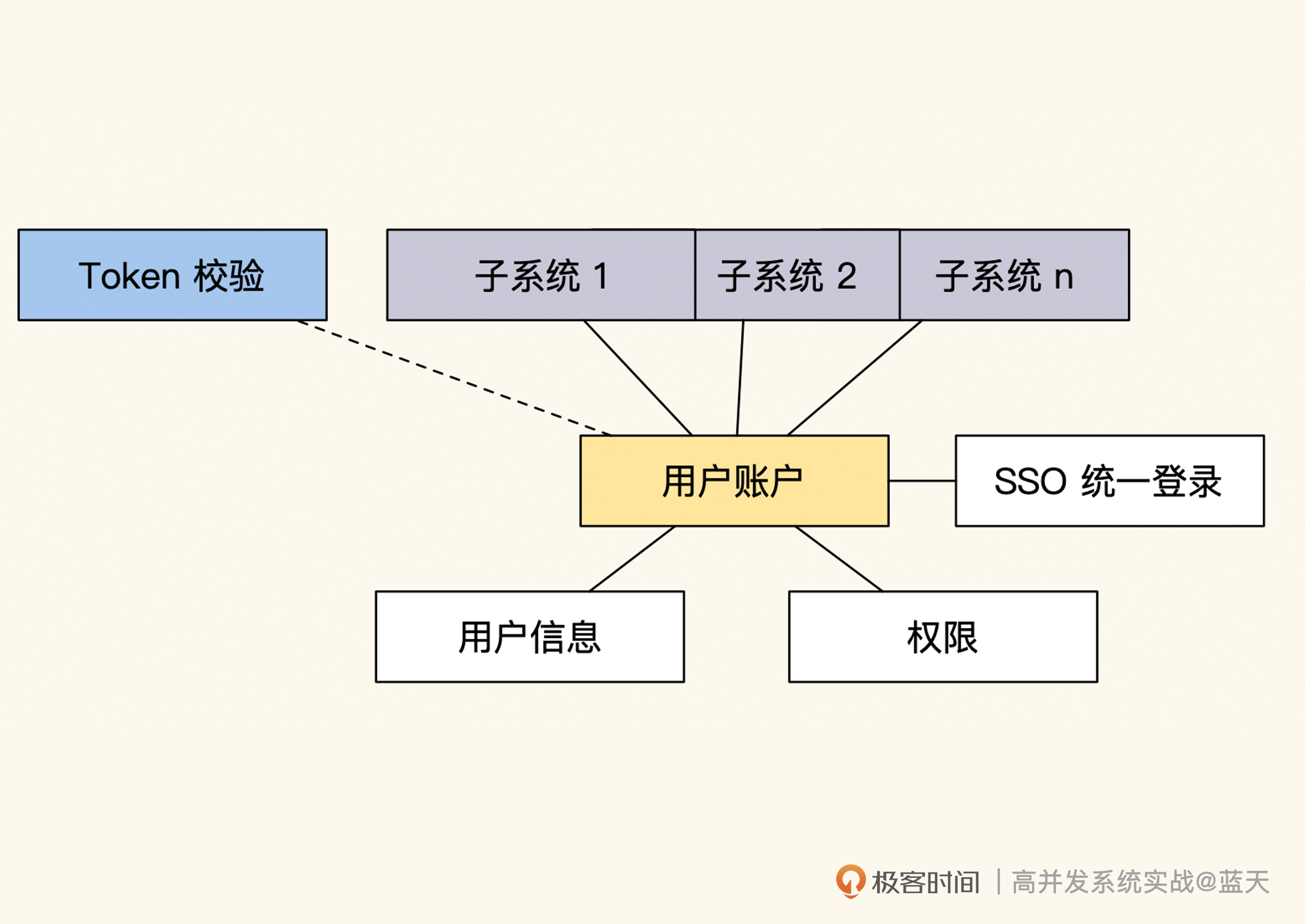

用户中心的主要功能是维护用户信息、用户权限和登录状态,它保存的数据大部分都属于读多写少的数据。用户中心常见的优化方式主要是将用户中心和业务彻底拆开,不再与业务耦合,并适当增加缓存来提高系统性能。

我举一个简单的例子:当时整表内有接近 2000 万的账号信息,我对表的功能和字段进行了业务解耦和精简,让用户中心的账户表里只会保留用户登陆所需的账号、密码:

CREATE TABLE `account` (

`id` int(10) NOT NULL AUTO_INCREMENT,

`account` char(32) COLLATE utf8mb4_unicode_ci NOT NULL,

`password` char(32) COLLATE utf8mb4_unicode_ci NOT NULL,

`salt` char(16) COLLATE utf8mb4_unicode_ci NOT NULL,

`status` tinyint(3) NOT NULL DEFAULT '0',

`update_time` int(10) NOT NULL,

`create_time` int(10) NOT NULL,

PRIMARY KEY (`id`),

UNIQUE KEY `login_account` (`account`)

) ENGINE=InnoDB DEFAULT CHARSET=utf8mb4 COLLATE=utf8mb4_unicode_ci;

我们知道数据库是系统的核心,如果它缓慢,那么我们所有的业务都会受它影响,我们的服务很少能超过核心数据库的性能上限。而我们减少账号表字段的核心在于,长度小的数据在吞吐、查询、传输上都会很快,也会更好管理和缓存。

精简后的表拥有更少的字段,对应的业务用途也会比较单纯。其业务主要功能就是检测用户登陆账号密码是否正确,除此之外平时不会有其他访问,也不会被用于其他范围查询上。可想而知这种表的性能一定极好,虽然存储两千万账号,但是整体表现很不错。

不过你要注意,精简数据量虽然能换来更好的响应速度,但不提倡过度设计。因为表字段如果缺少冗余会导致业务实现更为繁琐,比如账户表如果把昵称和头像删减掉,我们每次登录就需要多读取一次数据库,并且需要一直关注账户表的缓存同步更新;但如果我们在账户表中保留用户昵称和头像,在登陆验证后直接就可以继续其他业务逻辑了,无需再查询一次数据库。

所以你看,有些查询往往会因为精简一两个字段就多查一次数据库,并且还要考虑缓存同步问题,实在是得不偿失,因此我们要在“更多的字段”和“更少的职能”之间找到平衡。

数据的归类及深入整理

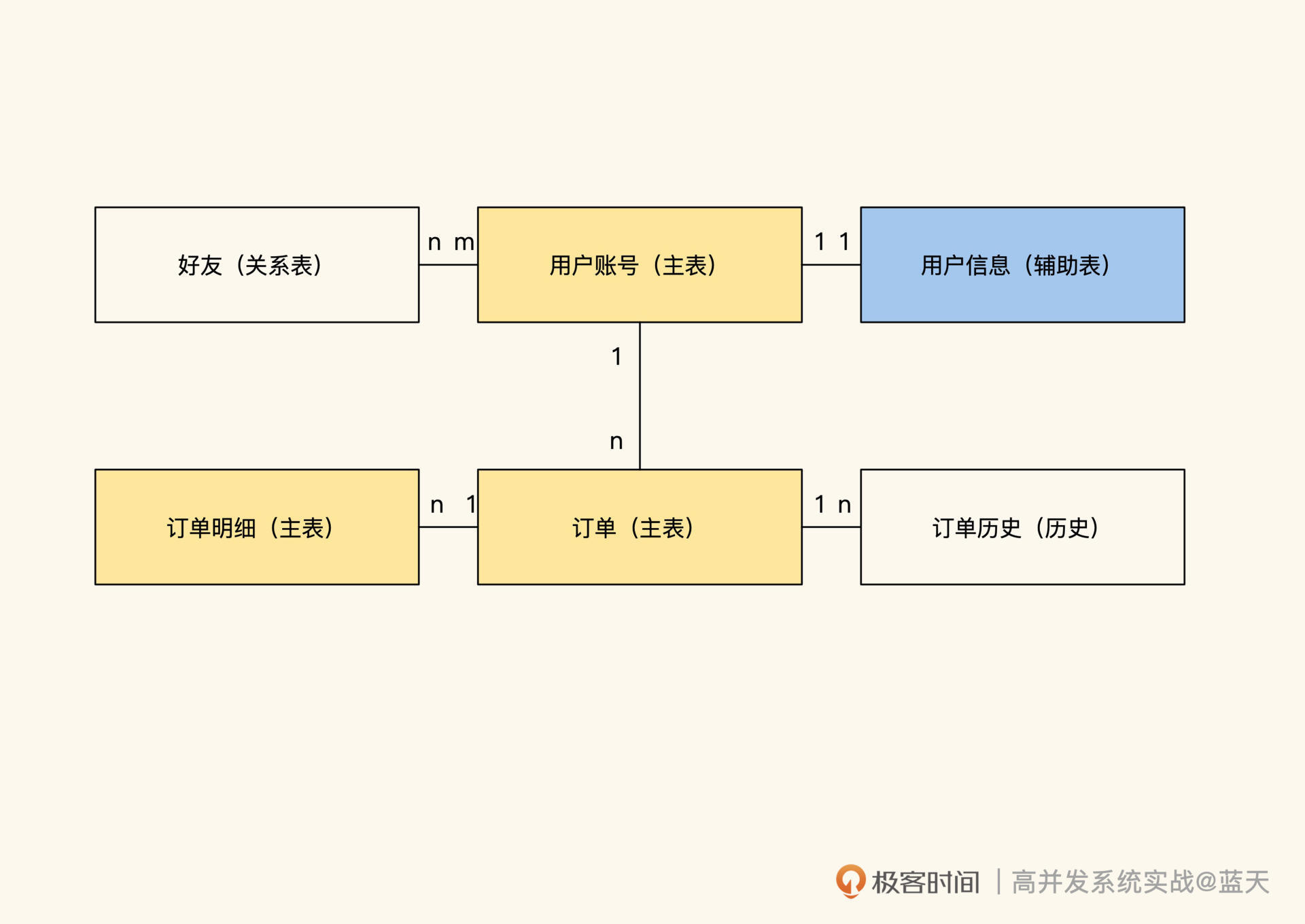

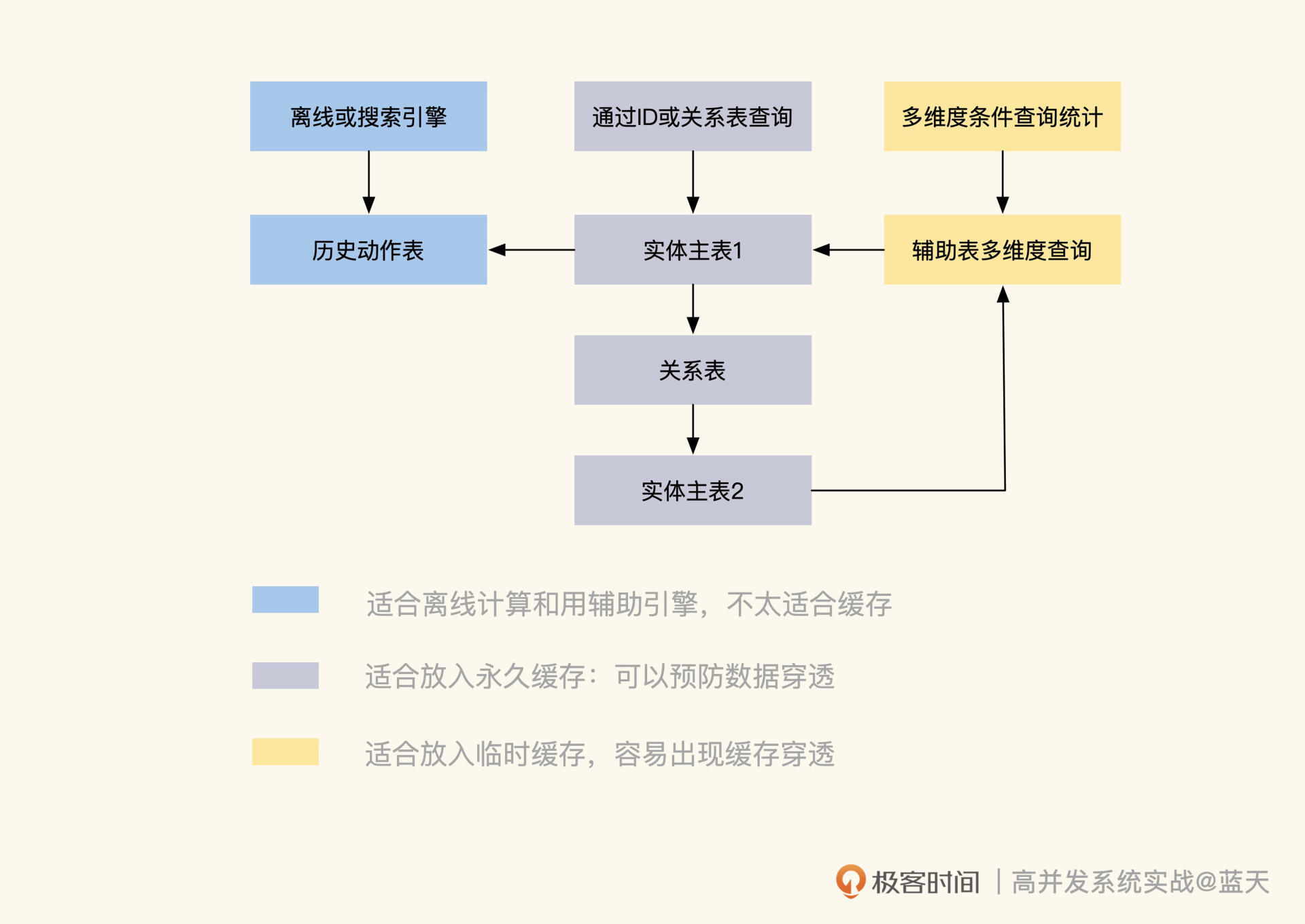

除了通过精简表的职能来提高表的性能和维护性外,我们还可以针对不同类型的表做不同方向的缓存优化,如下图用户中心表例子:

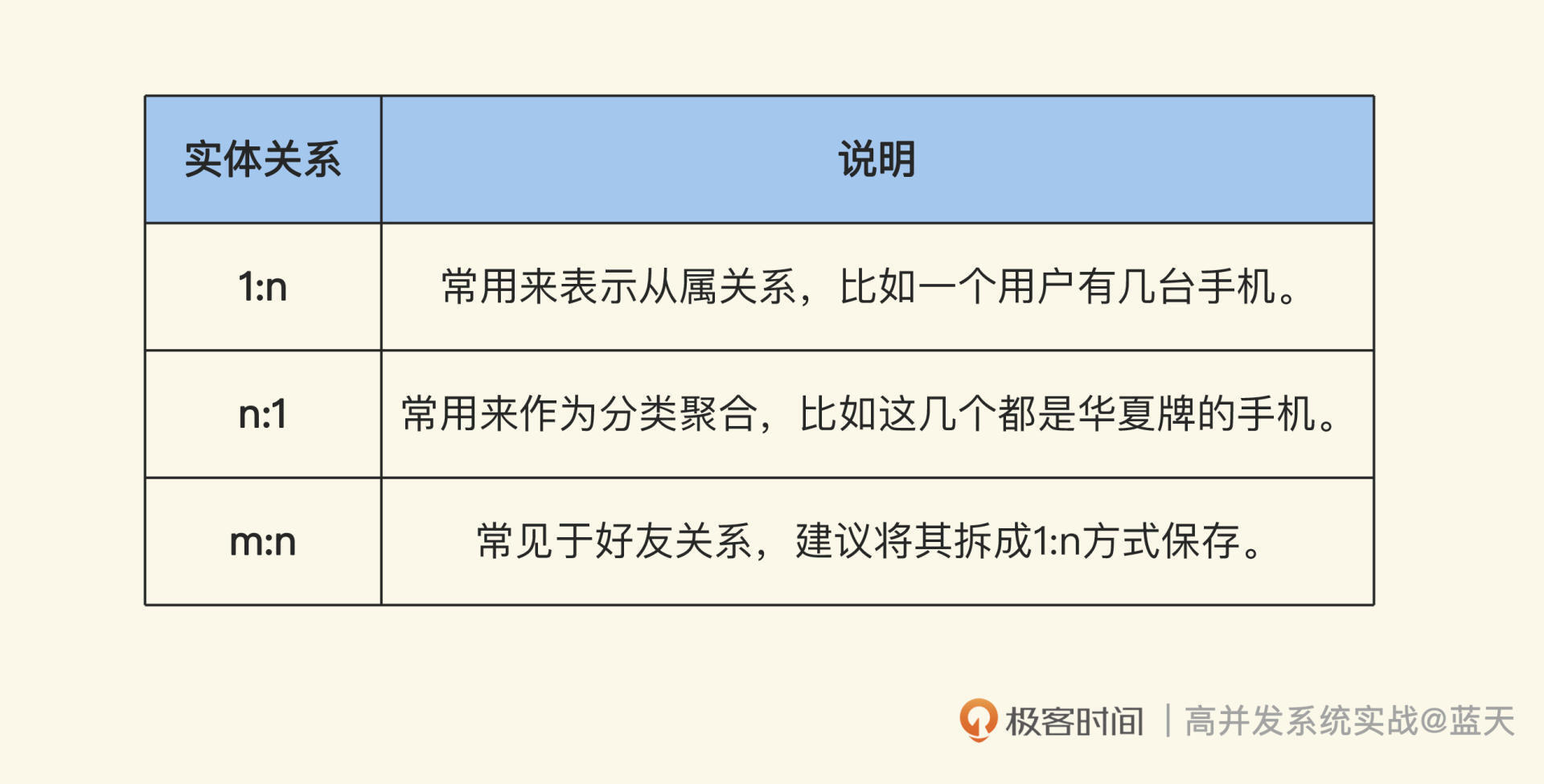

数据主要有四种:实体对象主表、辅助查询表、实体关系和历史数据,不同类型的数据所对应的缓存策略是不同的,如果我们将一些职能拆分不清楚的数据硬放在缓存中,使用的时候就会碰到很多烧脑的问题。

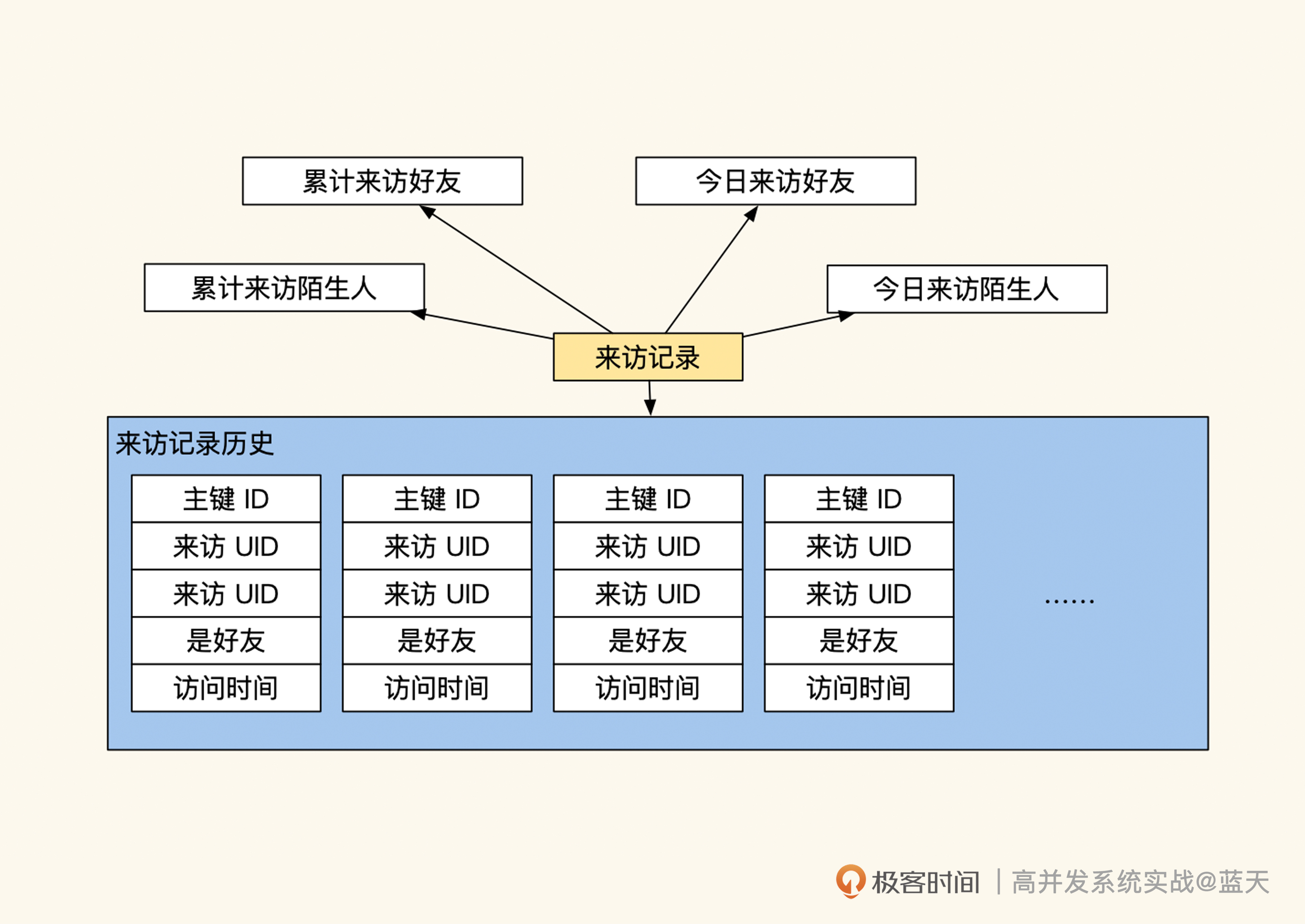

我之前就碰到过这样的错误做法——将用户来访记录这种持续增长的操作历史放到缓存里,这个记录的用途是统计有多少好友来访、有多少陌生人来访,但它同时保存着和用户是否是好友的标志。这也就意味着,一旦用户关系发生变化,这些历史数据就需要同步更新,否则里面的好友关系就“过时”了。

将历史记录和需要实时更新的好友状态混在一起,显然不合理。如果我们做归类梳理的话,应该拆分成三个职能表,分别进行管理:

- 历史记录表,不做缓存,仅展示最近几条,极端情况临时缓存;

- 好友关系(缓存关系,用于统计有几个好友);

- 来访统计数字(临时缓存)。

数据实体表

先看一下用户账号表,这个表是一个实体表,实体表一般会作为主表 ,它的一行数据代表一个实体,每个实体都拥有一个独立且唯一的 ID 作为标识。其中,“实体”代表一个抽象的事物,具体的字段表示的是当前实体实时的状态属性。

这个 ID 对于高并发环境下的缓存很重要,用户登录后就需要用自己账户的 ID 直接查找到对应的订单、昵称头像和好友列表信息。如果我们的业务都是通过这样的方式查找,性能肯定很好,并且很适合做长期缓存。

但是业务除了按 ID 查找外,还有一些需要通过组合条件查询的,比如:

- 在 7 月 4 日下单购买耳机的订单有哪些?

- 天津的用户里有多少新注册的用户?有多少老用户?

- 昨天是否有用户名前缀是 rick 账户注册?

这种根据条件查询统计的数据是不太容易做缓存的,因为高并发服务缓存的数据通常是能够快速通过 Hash 直接匹配的数据,而这种带条件查询统计的数据很容易出现不一致、数据量不确定导致的性能不稳定等问题,并且如果涉及的数据出现变化,我们很难通过数据确定同步更新哪些缓存。

因此,这类数据只适合存在关系数据库或提前预置计算好结果放在缓存中直接使用,做定期更新。

除了组合条件查询不好缓存外,像 count() 、sum() 等对数据进行实时计算也有更新不及时的问题,同样只能定期缓存汇总结果,不能频繁查询。所以,我们应该在后续的开发过程中尽量避免使用数据库做计算。

回到刚才的话题,我们继续讨论常见的数据实体表的设计。其实这类表是针对业务的主要查询需求而设计的,如果我们没有按照这个用途来查询表的时候,性能往往会很差。

比如前面那个用于账户登录的表,当我们拿它查询用户昵称中是否有“极客”两个字的时候,需要做很多额外的工作,需要对“用户昵称”这个字段增加索引,同时这种 like 查询会扫描全表数据进行计算。

如果这种查询的频率比较高,就会严重影响其他用户的登陆,而且新增的昵称索引还会额外降低当前表插入数据的性能,这也是为什么我们的后台系统往往会单独分出一个从库,做特殊索引。

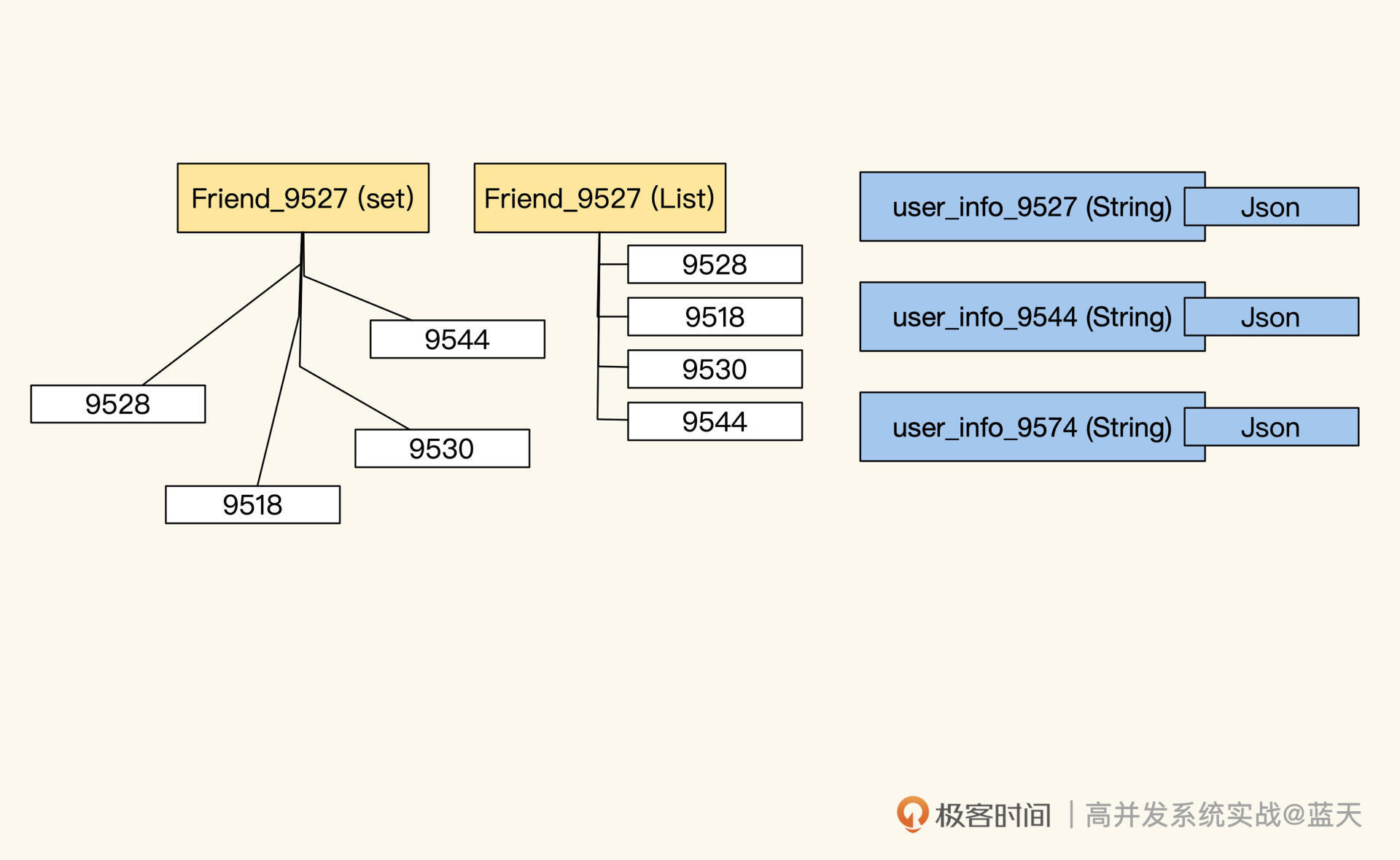

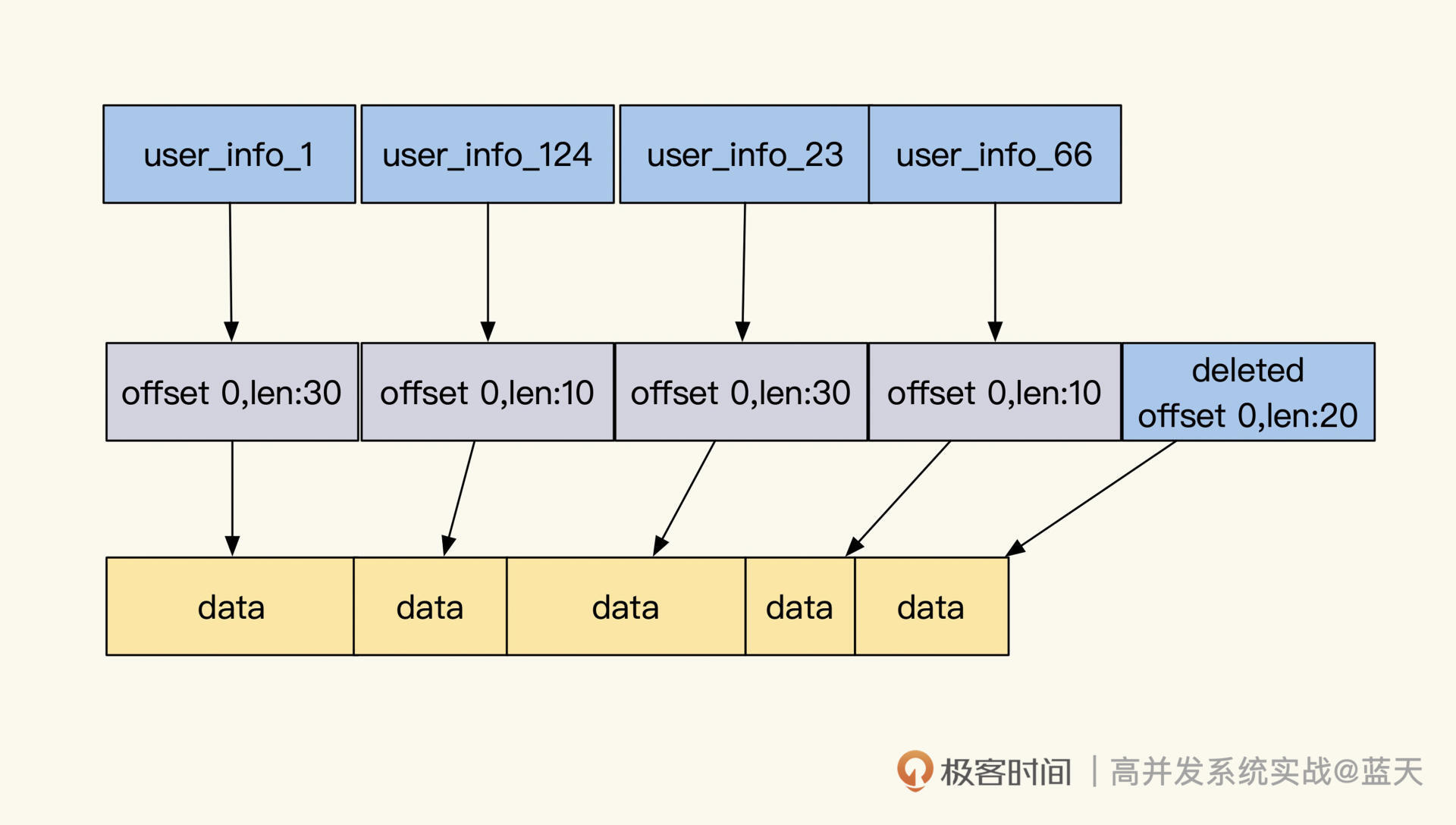

一般来说,高并发用缓存来优化读取的性能时,缓存保存的基本都是实体数据。那常见的方法是先通过“key 前缀 + 实体 ID”获取数据(比如 user_info_9527),然后通过一些缓存中的关联关系再获取指定数据,比如我们通过 ID 就可以直接获取用户好友关系 key,并且拿到用户的好友 ID 列表。通过类似的方式,我们可以在 Redis 中实现用户常见的关联查询操作。

总体来说,实体数据是我们业务的主要承载体,当我们找到实体主体的时候,就可以根据这个主体在缓存中查到所有和它有关联的数据,来服务用户。现在我们来稍微总结一下,我们整理实体表的核心思路主要有以下几点:

- 精简数据总长度;

- 减少表承担的业务职能;

- 减少统计计算查询;

- 实体数据更适合放在缓存当中;

- 尽量让实体能够通过 ID 或关系方式查找;

- 减少实时条件筛选方式的对外服务。

实体辅助表

为了精简数据且方便管理,我们经常会根据不同用途对主表拆分,常见的方式是做纵向表拆分。

纵向表拆分的目的一般有两个,一个是**把使用频率不高的数据摘出来。**常见主表字段很多,经过拆分,可以精简它的职能,而辅助表的主键通常会保持和主表一致或通过记录 ID 进行关联,它们之间的常见关系为 1:1。

而放到辅助表的数据,一般是主要业务查询中不会使用的数据,这些数据只有在极个别的场景下才会取出使用,比如用户账号表为主体用于做用户登陆使用,而辅助信息表保存家庭住址、省份、微信、邮编等平时不会展示的信息。

辅助表的另一个用途是辅助查询,当原有业务数据结构不能满足其他维度的实体查询时,可以通过辅助表来实现。

比如有一个表是以“教师”为主体设计的,每次业务都会根据“当前教师 ID+ 条件”来查询学生及班级数据,但从学生的角度使用系统时,需要高频率以“学生和班级”为基础查询教师数据时,就只能先查出 “学生 ID”或“班级 ID”,然后才能查找出老师 ID”,这样不仅不方便,而且还很低效,这时候就可以把学生和班级的数据拆分出来,额外做一个辅助表包含所有详细信息,方便这种查询。

另外,我还要提醒一下,因为拆分的辅助表会和主体出现 1:n 甚至是 m:n 的数据关系,所以我们要定期地对数据整理核对,通过这个方式保证我们冗余数据的同步和完整。

不过,非 1:1 数据关系的辅助表维护起来并不容易,因为它容易出现数据不一致或延迟的情况,甚至在有些场景下,还需要刷新所有相关关系的缓存,既耗时又耗力。如果这些数据的核对通过脚本去定期执行,通过核对数据来找出数据差异,会更简单一些。

此外,在很多情况下我们为了提高查询效率,会把同一个数据冗余在多个表内,有数据更新时,我们需要同步更新冗余表和缓存的数据。

这里补充一点,行业里也会用一些开源搜索引擎,辅助我们做类似的关系业务查询,比如用 ElasticSearch 做商品检索、用 OpenSearch 做文章检索等。这种可横向扩容的服务能大大降低数据库查询压力,但唯一缺点就是很难实现数据的强一致性,需要人工检测、核对两个系统的数据。

实体关系表

在对 1:n 或 m:n 关系的数据做缓存时,我们建议提前预估好可能参与的数据量,防止过大导致缓存缓慢。同时,通常保存这个关系在缓存中会把主体的 ID 作为 key,在 value 内保存多个关联的 ID 来记录这两个数据的关联关系。而对于读取特别频繁的的业务缓存,才会考虑把数据先按关系组织好,然后整体缓存起来,来方便查询和使用。需要注意的是,这种关联数据很容易出现多级依赖,会导致我们整理起来十分麻烦。当相关表或条件更新的时候,我们需要及时同步这些数据在缓存中的变化。所以,这种多级依赖关系很难在并发高的系统中维护,很多时候我们会降低一致性要求来满足业务的高并发情况。总的来说,只有通过 ID 进行关联的数据的缓存是最容易管理的,其他的都需要特殊维护,我会在下节课给你介绍怎么维护缓存的更新和一致性,这里就不展开说了。现在我们简单总结一下,到底什么样的数据适合做缓存。一般来说,根据 ID 能够精准匹配的数据实体很适合做缓存;而通过 String、List 或 Set 指令形成的有多条 value 的结构适合做(1:1、1:n、m:n)辅助或关系查询;最后还有一点要注意,虽然 Hash 结构很适合做实体表的属性和状态,但是 Hgetall 指令性能并不好,很容易让缓存卡顿,建议不要这样做。

动作历史表

介绍到这里,我们已经完成了大部分的整理,同时对于哪些数据可以做缓存,你也有了较深理解。为了加深你的印象,我再介绍一些反例。一般来说,动作历史数据表记录的是数据实体的动作或状态变化过程,比如用户登陆日志、用户积分消费获取记录等。这类数据会随着时间不断增长,它们一般用于记录、展示最近信息,不建议用在业务的实时统计计算上。你可能对我的这个建议存有疑虑,我再给你举个简单的例子。如果我们要从一个有 2000 万条记录的积分领取记录表中,检测某个用户领取的 ID 为 15 的商品个数:

CREATE TABLE `user_score_history` (

`id` int(10) unsigned NOT NULL AUTO_INCREMENT,

`uid` int(10) NOT NULL DEFAULT '',

`action` varchar(32) NOT NULL,

`action_id` char(16) NOT NULL,

`status` tinyint(3) NOT NULL DEFAULT '0'

`extra` TEXT NOT NULL DEFAULT '',

`update_time` int(10) NOT NULL DEFAULT '0',

`create_time` int(10) NOT NULL DEFAULT '0',

PRIMARY KEY (`id`),

KEY uid(`uid`,`action`),

) ENGINE=InnoDB AUTO_INCREMENT=1

DEFAULT CHARSET=utf8mb4

COLLATE=utf8mb4_unicode_ci;

select uid, count(*) as action_count, product_id

from user_score_history

where uid = 9527 and action = "fetch_gift"

and action_id = 15 and status = 1

group by uid,action_id

不难看出,这个表数据量很大,记录了大量的实体动作操作历史,并且字段和索引不适合做这种查询。当我们要计算某个用户领取的 ID 为 15 的商品个数,只能先通过 UID 索引过滤数据,缩小范围。但是,这样筛选出的数据仍旧会很大。并且随着时间的推移,这个表的数据会不断增长,它的查询效率会逐渐降低。

所以,对于这种基于大量的数据统计后才能得到的结论数据,我不建议对外提供实时统计计算服务,因为这种查询会严重拖慢我们的数据库,影响服务稳定。即使使用缓存临时保存统计结果,这也属于临时方案,建议用其他的表去做类似的事情,比如实时查询领取记录表,效果会更好。

总结

在项目初期,数据表的职能设计往往都会比较简单,但随着时间的推移和业务的发展变化,表经过多次修改后,其使用方向和职能都会发生较大的变化,导致我们的系统越来越复杂。

所以,当流量超过数据库的承受能力需要做缓存改造时,我们建议先根据当前的业务逻辑对数据表进行职能归类,它能够帮你快速识别出,表中哪些字段和功能不适合在特定类型的表内使用,这会让数据在缓存中有更好的性价比。

一般来说,数据可分为四类:实体表、实体辅助表、关系表和历史表,而判断是否适合缓存的核心思路主要是以下几点:

- 能够通过 ID 快速匹配的实体,以及通过关系快速查询的数据,适合放在长期缓存当中;

- 通过组合条件筛选统计的数据,也可以放到临时缓存,但是更新有延迟;

- 数据增长量大或者跟设计初衷不一样的表数据,这种不适合、也不建议去做做缓存。

缓存一致:读多写少时,如何解决数据更新缓存不同步?

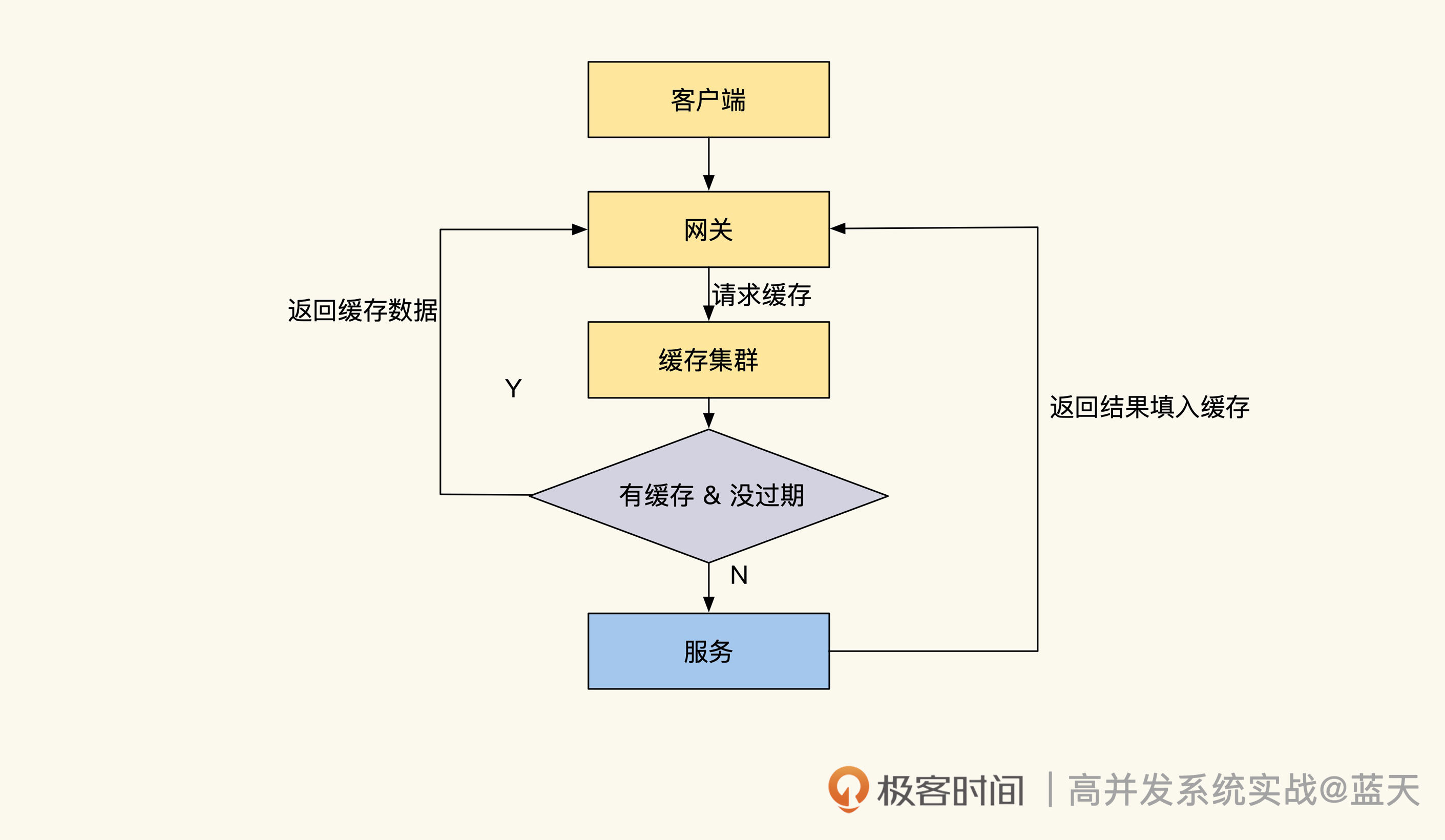

而对于用户中心的业务来说,这个比例会更大一些,毕竟用户不会频繁地更新自己的信息和密码,所以这种读多写少的场景特别适合做读取缓存。通过缓存可以大大降低系统数据层的查询压力,拥有更好的并发查询性能。但是,使用缓存后往往会碰到更新不同步的问题,下面我们具体看一看。

缓存性价比

就像刚才所说,我们认为用户信息放进缓存可以快速提高性能,所以在优化之初,我们第一个想到的就是将用户中心账号信息放到缓存。这个表有 2000 万条数据,主要用途是在用户登录时,通过用户提交的账号和密码对数据库进行检索,确认用户账号和密码是否正确,同时查看账户是否被封禁,以此来判定用户是否可以登录:

# 表结构

CREATE TABLE `accounts` (

`id` int(10) unsigned NOT NULL AUTO_INCREMENT,

`account` varchar(15) NOT NULL DEFAULT '',

`password` char(32) NOT NULL,

`salt` char(16) NOT NULL,

`status` tinyint(3) NOT NULL DEFAULT '0'

`update_time` int(10) NOT NULL DEFAULT '0',

`create_time` int(10) NOT NULL DEFAULT '0',

PRIMARY KEY (`id`),

) ENGINE=InnoDB AUTO_INCREMENT=1 DEFAULT CHARSET=utf8mb4 COLLATE=utf8mb4_unicode_ci;

# 登录查询

select id, account, update_time from accounts

where account = 'user1'

and password = '6b9260b1e02041a665d4e4a5117cfe16'

and status = 1

这是一个很简单的查询,你可能会想:如果我们将 2000 万的用户数据放到缓存,肯定能提供性能很好的服务。

这个想法是对的,但不全对,因为它的性价比并不高:这个表查询的场景主要用于账号登录,用户即使频繁登录,也不会造成太大的流量冲击。因此,缓存在大部分时间是闲置状态,我们没必要将并发不高的数据放到缓存当中,浪费我们的预算。

这就牵扯到了一个很核心的问题,我们做缓存是要考虑性价比的。如果我们费时费力地把一些数据放到缓存当中,但并不能提高系统的性能,反倒让我们浪费了大量的时间和金钱,那就是不合适的。我们需要评估缓存是否有效,一般来说,只有热点数据放到缓存才更有价值。

临时热缓存

推翻将所有账号信息放到缓存这个想法后,我们把目标放到会被高频查询的信息上,也就是用户信息。

用户信息的使用频率很高,在很多场景下会被频繁查询展示,比如我们在论坛上看到的发帖人头像、昵称、性别等,这些都是需要频繁展示的数据,不过这些数据的总量很大,全部放入缓存很浪费空间。

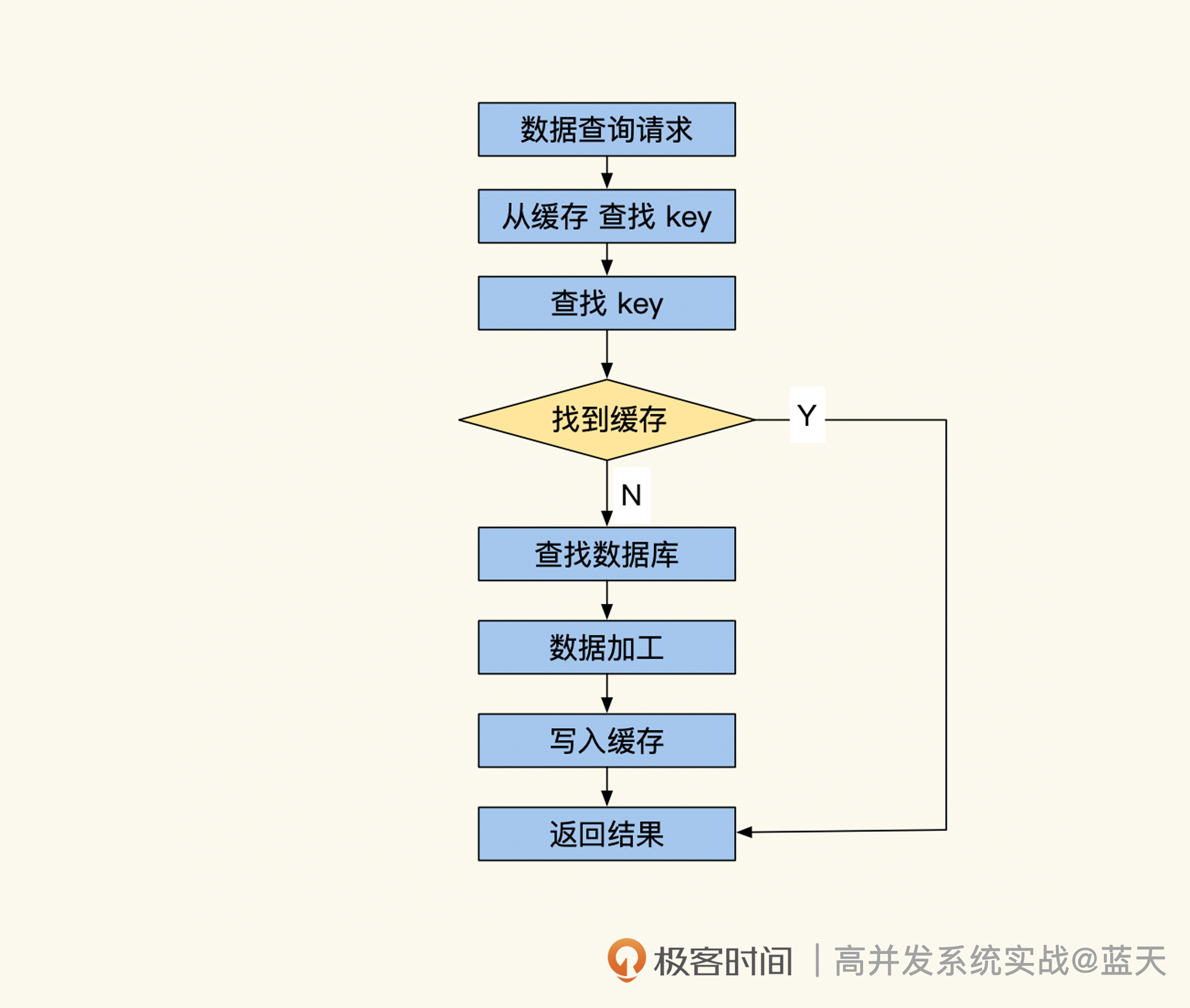

对于这种数据,我建议使用临时缓存方式,就是在用户信息第一次被使用的时候,同时将数据放到缓存当中,短期内如果再次有类似的查询就可以快速从缓存中获取。这个方式能有效降低数据库的查询压力。常见方式实现的临时缓存的代码如下:

// 尝试从缓存中直接获取用户信息

userinfo, err := Redis.Get("user_info_9527")

if err != nil {

return nil, err

}

//缓存命中找到,直接返回用户信息

if userinfo != nil {

return userinfo, nil

}

//没有命中缓存,从数据库中获取

userinfo, err := userInfoModel.GetUserInfoById(9527)

if err != nil {

return nil, err

}

//查找到用户信息

if userinfo != nil {

//将用户信息缓存,并设置TTL超时时间让其60秒后失效

Redis.Set("user_info_9527", userinfo, 60)

return userinfo, nil

}

// 没有找到,放一个空数据进去,短期内不再问数据库

// 可选,这个是用来预防缓存穿透查询攻击的

Redis.Set("user_info_9527", "", 30)

return nil, nil

可以看到,我们的数据只是临时放到缓存,等待 60 秒过期后数据就会被淘汰,如果有同样的数据查询需要,我们的代码会将数据重新填入缓存继续使用。这种临时缓存适合表中数据量大,但热数据少的情况,可以降低热点数据的压力。

而之所以给缓存设置数据 TTL,是为了节省我们的内存空间。当数据在一段时间内不被使用后就会被淘汰,这样我们就不用购买太大的内存了。这种方式相对来说有极高的性价比,并且维护简单,很常用。

缓存更新不及时问题

临时缓存是有 TTL 的,如果 60 秒内修改了用户的昵称,缓存是不会马上更新的。最糟糕的情况是在 60 秒后才会刷新这个用户的昵称缓存,显然这会给系统带来一些不必要的麻烦。其实对于这种缓存数据刷新,可以分成几种情况,不同情况的刷新方式有所不同,接下来我给你分别讲讲。

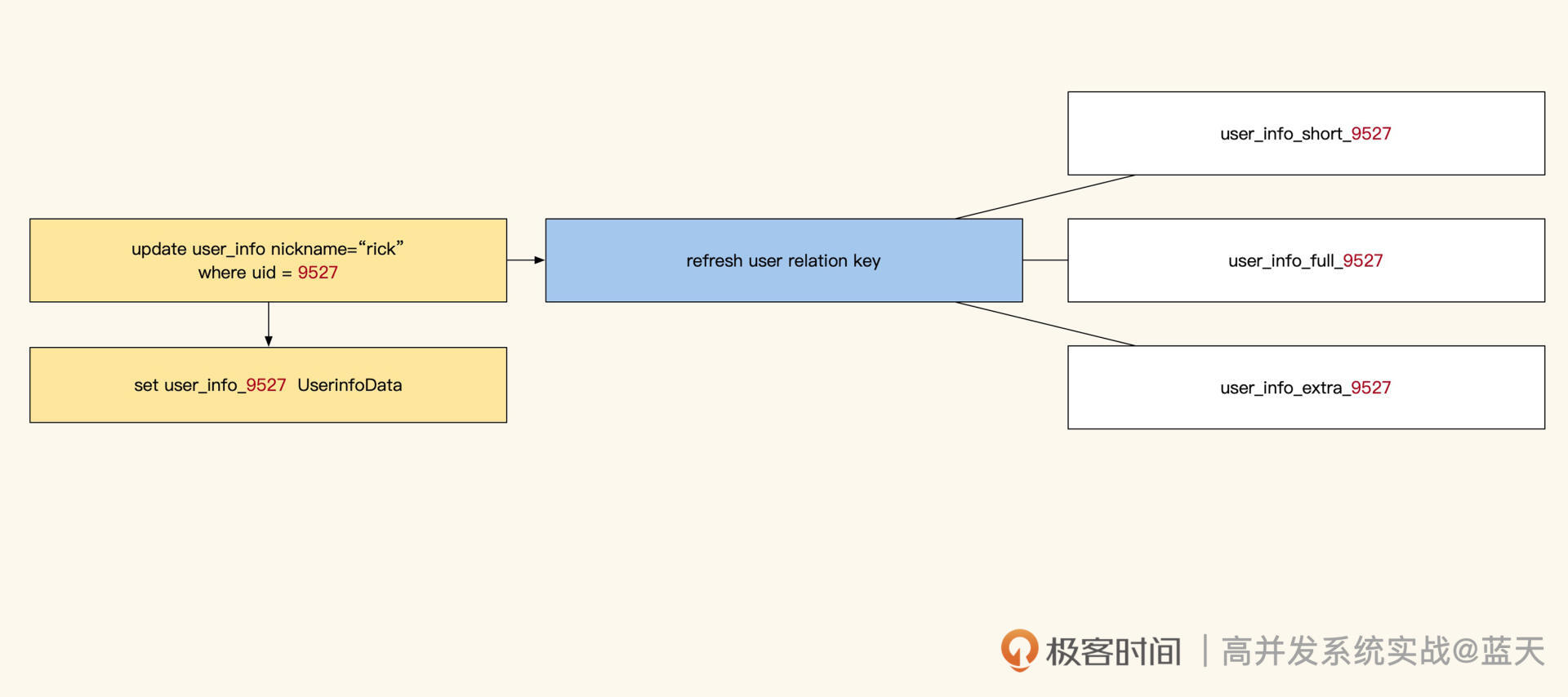

1. 单条实体数据缓存刷新

单条实体数据缓存更新是最简单的一个方式,比如我们缓存了 9527 这个用户的 info 信息,当我们对这条数据做了修改,我们就可以在数据更新时同步更新对应的数据缓存:

Type UserInfo struct {

Id int `gorm:"column:id;type:int(11);primary_key;AUTO_INCREMENT" json:"id"`

Uid int `gorm:"column:uid;type:int(4);NOT NULL" json:"uid"`

NickName string `gorm:"column:nickname;type:varchar(32) unsigned;NOT NULL" json:"nickname"`

Status int16 `gorm:"column:status;type:tinyint(4);default:1;NOT NULL" json:"status"`

CreateTime int64 `gorm:"column:create_time;type:bigint(11);NOT NULL" json:"create_time"`

UpdateTime int64 `gorm:"column:update_time;type:bigint(11);NOT NULL" json:"update_time"`

}

//更新用户昵称

func (m *UserInfo)UpdateUserNickname(ctx context.Context, name string, uid int) (bool, int64, error) {

//先更新数据库

ret, err := m.db.UpdateUserNickNameById(ctx, uid, name)

if ret {

//然后清理缓存,让下次读取时刷新缓存,防止并发修改导致临时数据进入缓存

//这个方式刷新较快,使用很方便,维护成本低

Redis.Del("user_info_" + strconv.Itoa(uid))

}

return ret, count, err

}

整体来讲就是先识别出被修改数据的 ID,然后根据 ID 删除被修改的数据缓存,等下次请求到来时,再把最新的数据更新到缓存中,这样就会有效减少并发操作把脏数据带入缓存的可能性。

除此之外,我们也可以给队列发更新消息让子系统更新,还可以开发中间件把数据操作发给子系统,自行决定更新的数据范围。

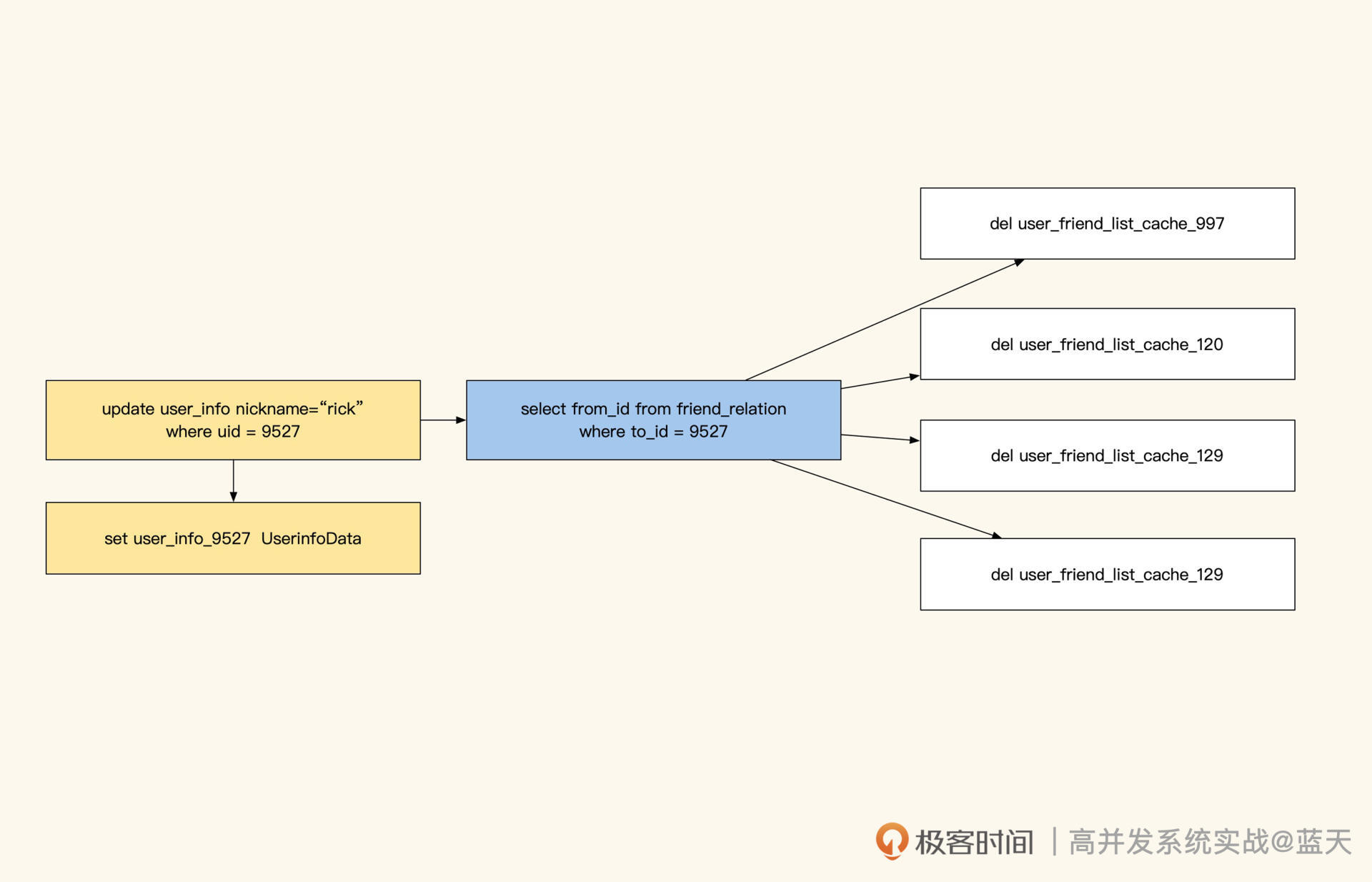

不过,通过队列更新消息这一步,我们还会碰到一个问题——条件批量更新的操作无法知道具体有多少个 ID 可能有修改,常见的做法是:先用同样的条件把所有涉及的 ID 都取出来,然后 update,这时用所有相关 ID 更新具体缓存即可。

2. 关系型和统计型数据缓存刷新

首先是人工维护缓存方式。我们知道,关系型数据或统计结果缓存刷新存在一定难度,核心在于这些统计是由多条数据计算而成的。当我们对这类数据更新缓存时,很难识别出需要刷新哪些关联缓存。对此,我们需要人工在一个地方记录或者定义特殊刷新逻辑来实现相关缓存的更新。

不过这种方式比较精细,**如果刷新缓存很多,那么缓存更新会比较慢,并且存在延迟。**而且人工书写还需要考虑如何查找到新增数据关联的所有 ID,因为新增数据没有登记在 ID 内,人工编码维护会很麻烦。

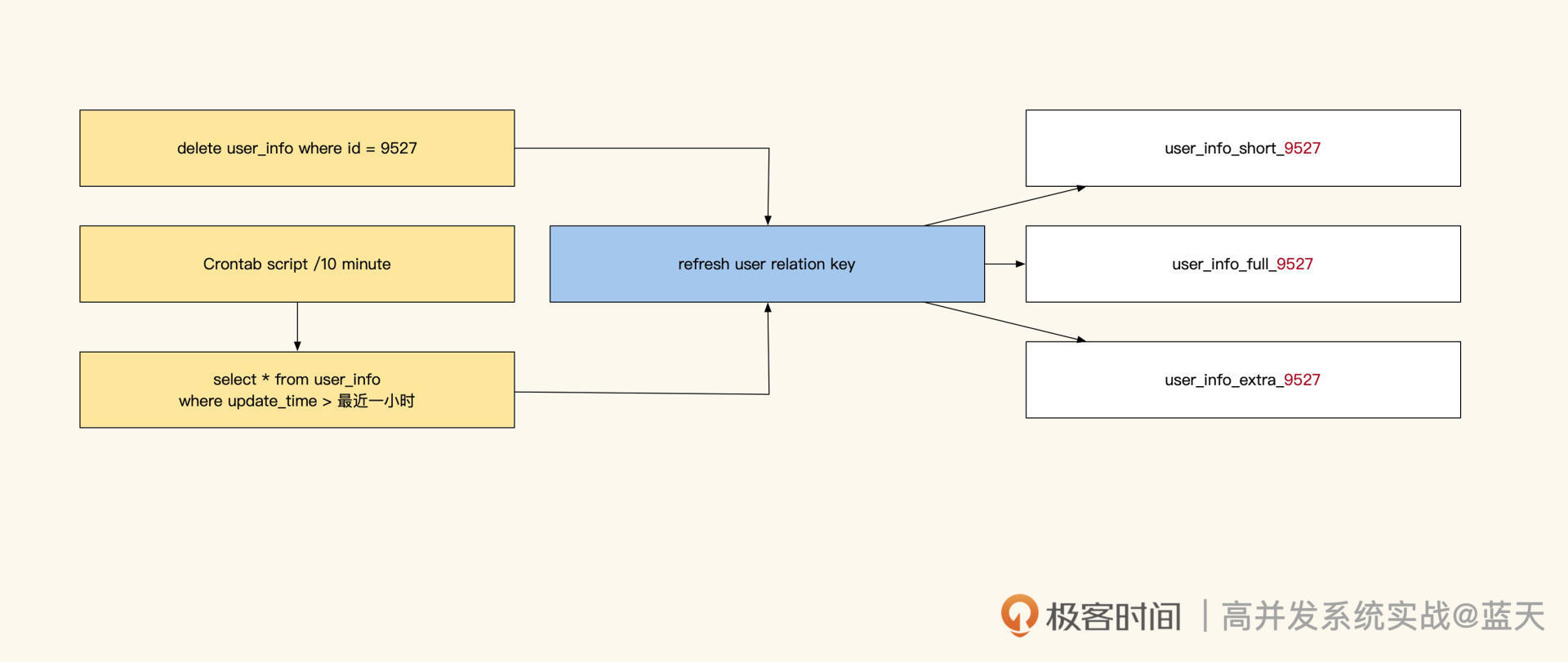

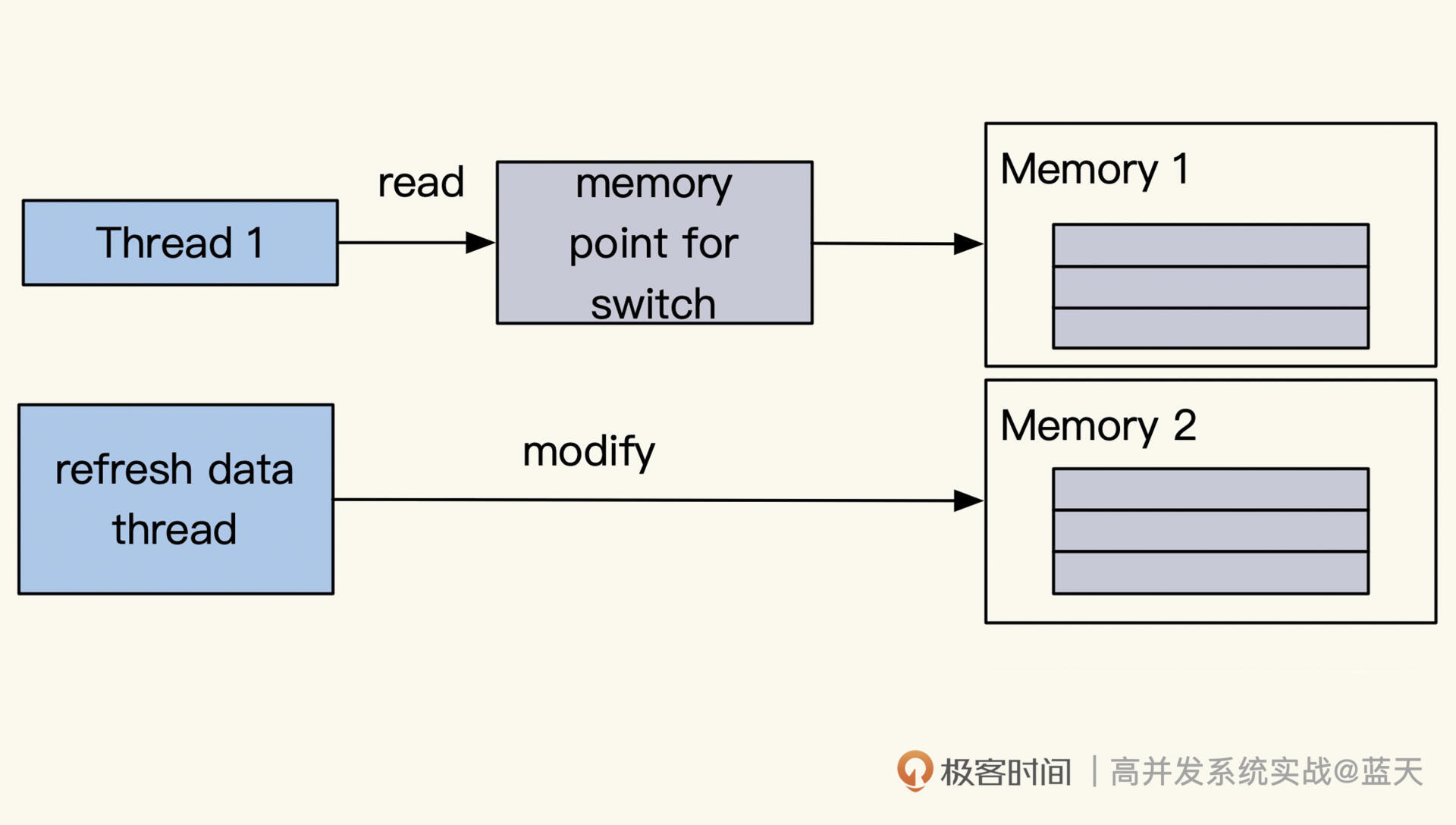

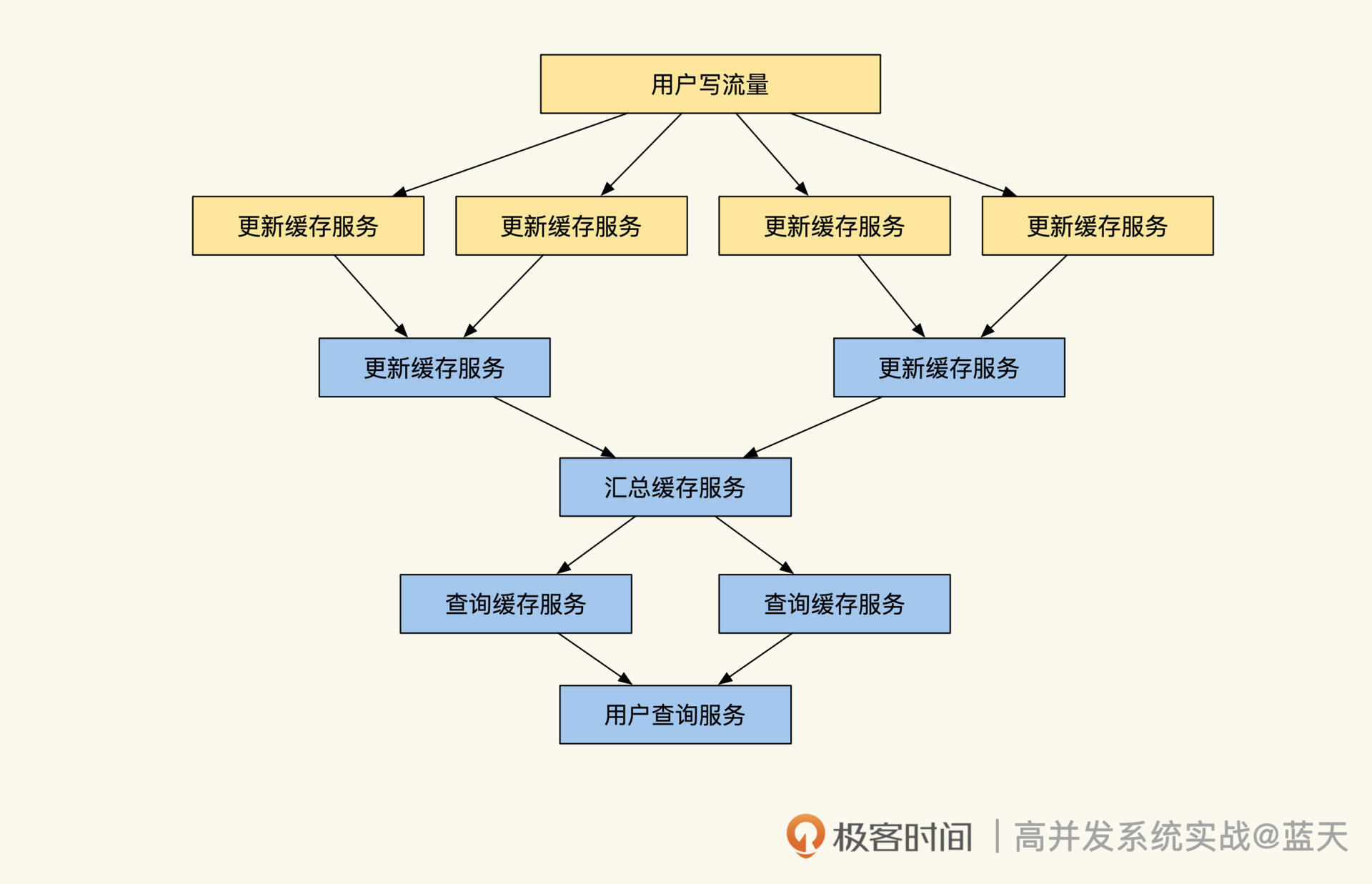

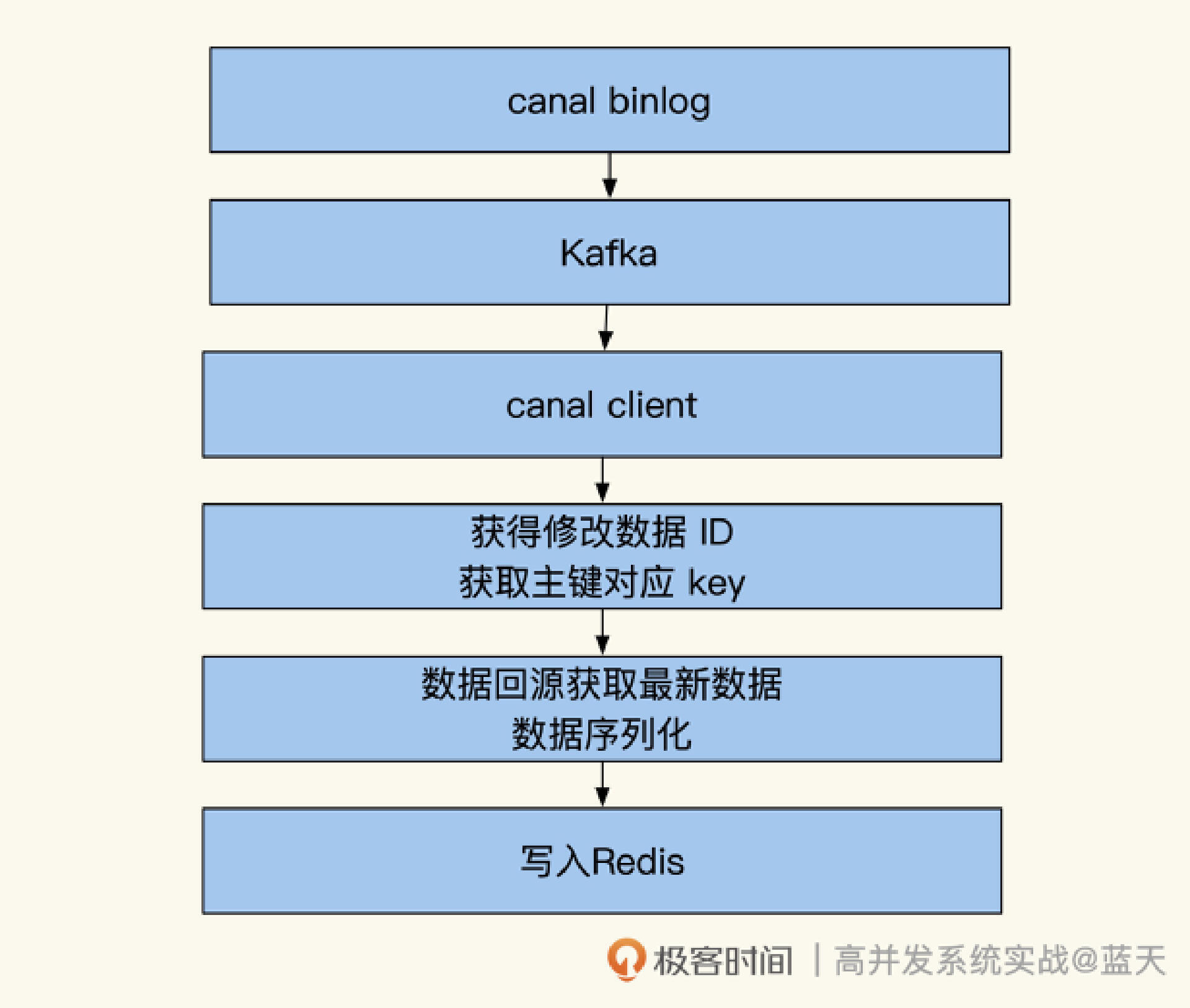

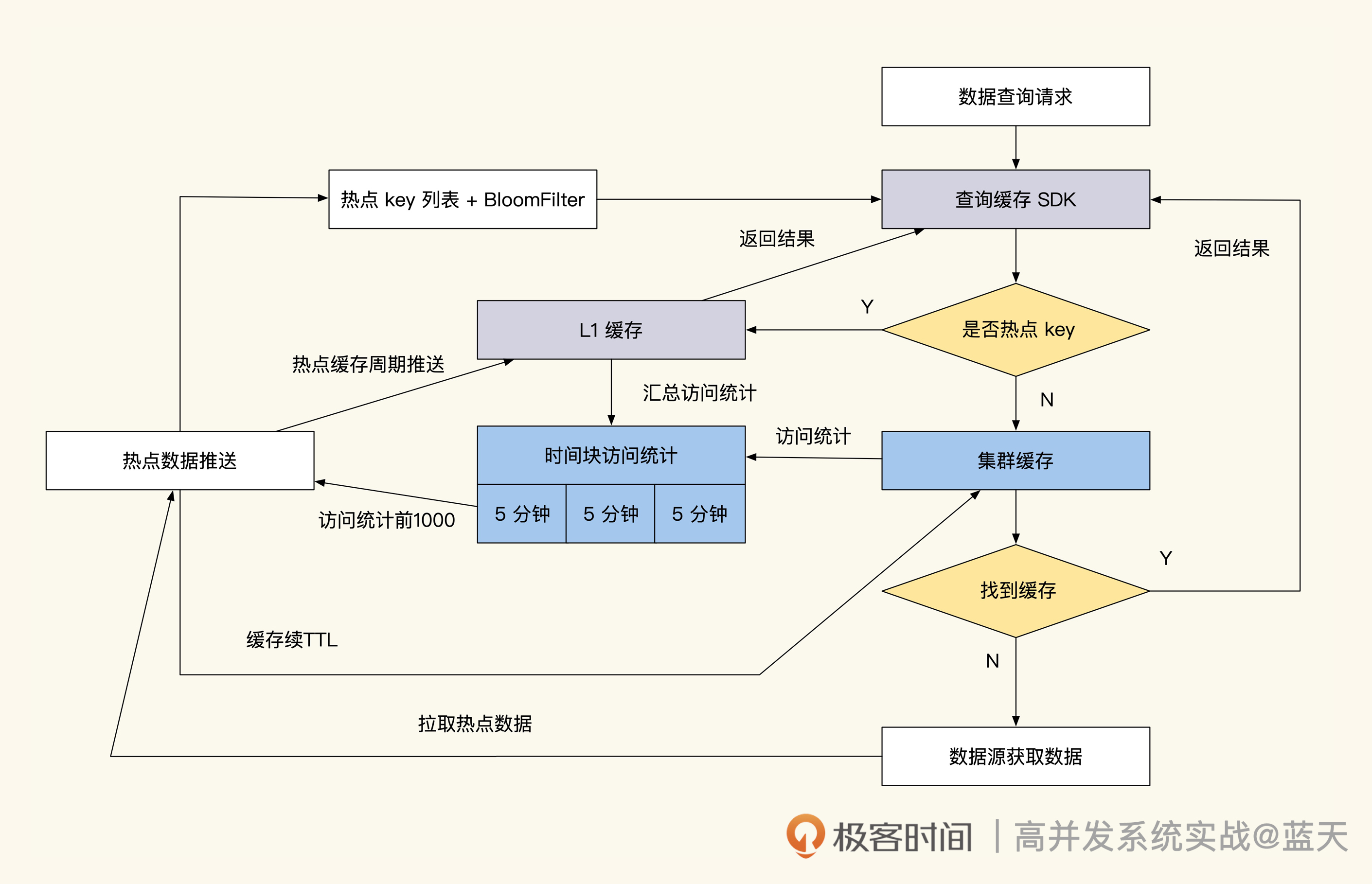

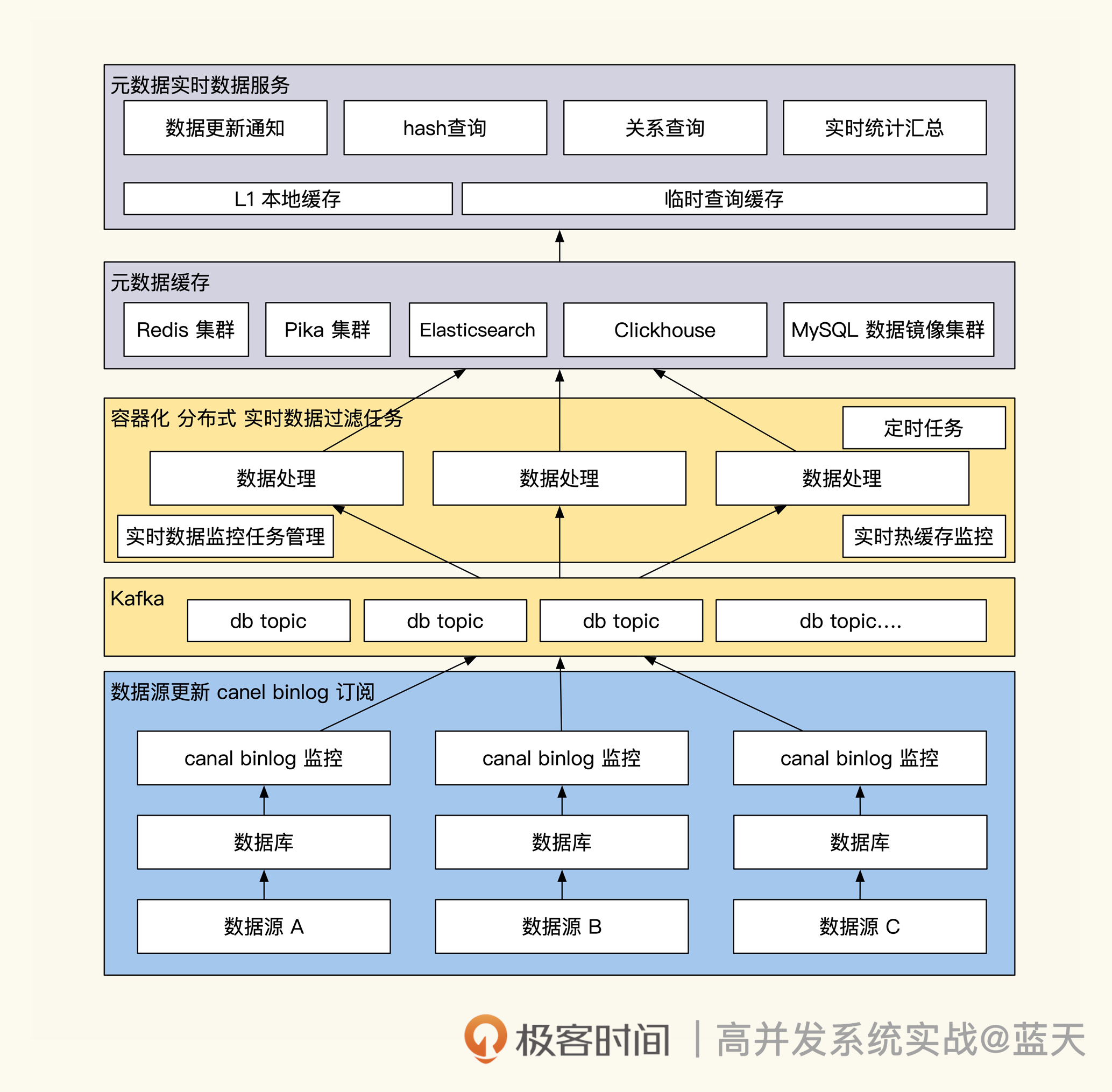

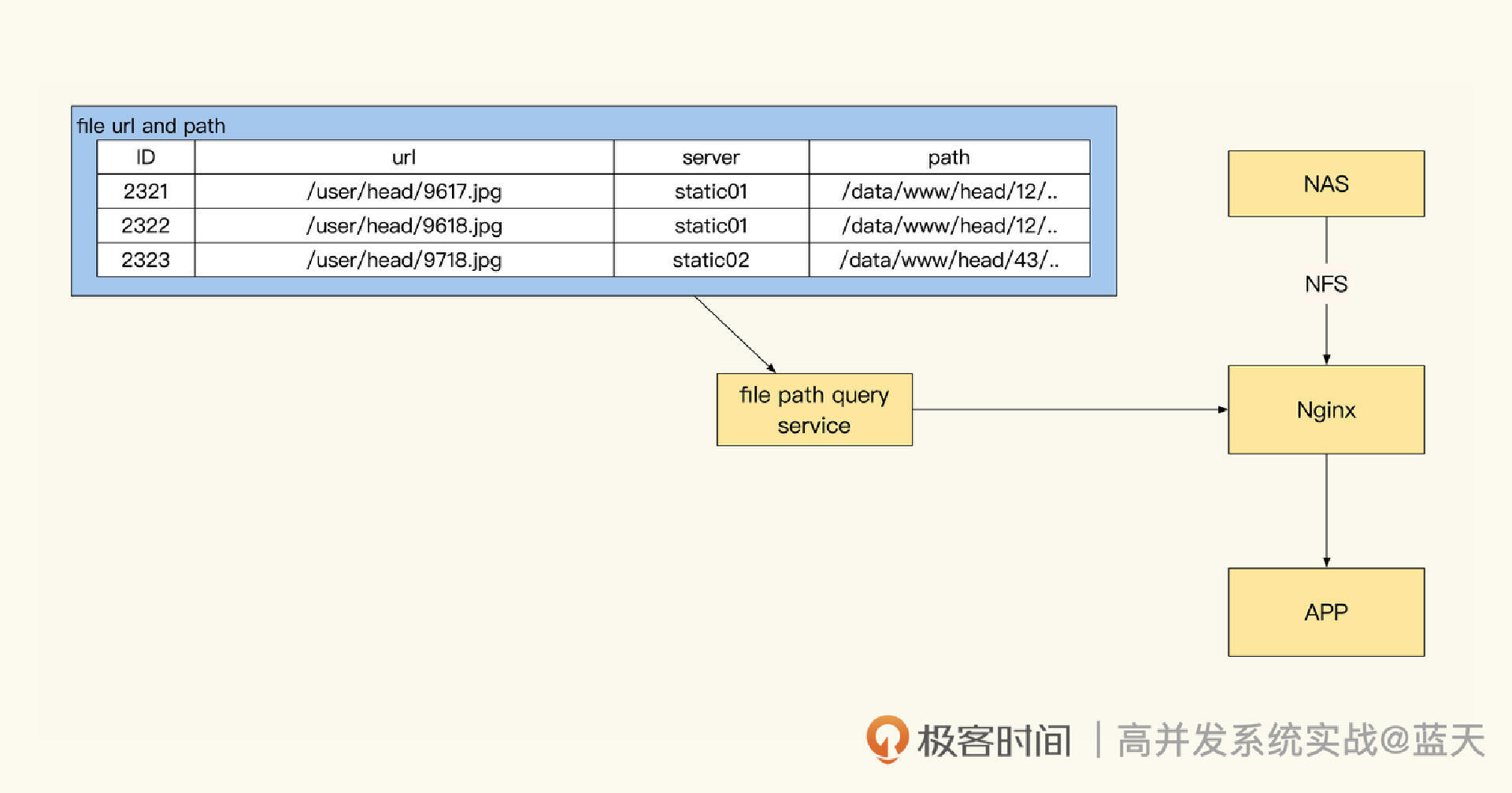

除了人工维护缓存外,还有一种方式就是通过**订阅数据库来找到 ID 数据变化。**如下图,我们可以使用 Maxwell 或 Canal,对 MySQL 的更新进行监控。

这样变更信息会推送到 Kafka 内,我们可以根据对应的表和具体的 SQL 确认更新涉及的数据 ID,然后根据脚本内设定好的逻辑对相 关 key 进行更新。例如用户更新了昵称,那么缓存更新服务就能知道需要更新 user_info_9527 这个缓存,同时根据配置找到并且删除其他所有相关的缓存。

很显然,这种方式的好处是能及时更新简单的缓存,同时核心系统会给子系统广播同步数据更改,代码也不复杂;缺点是复杂的关联关系刷新,仍旧需要通过人工写逻辑来实现。

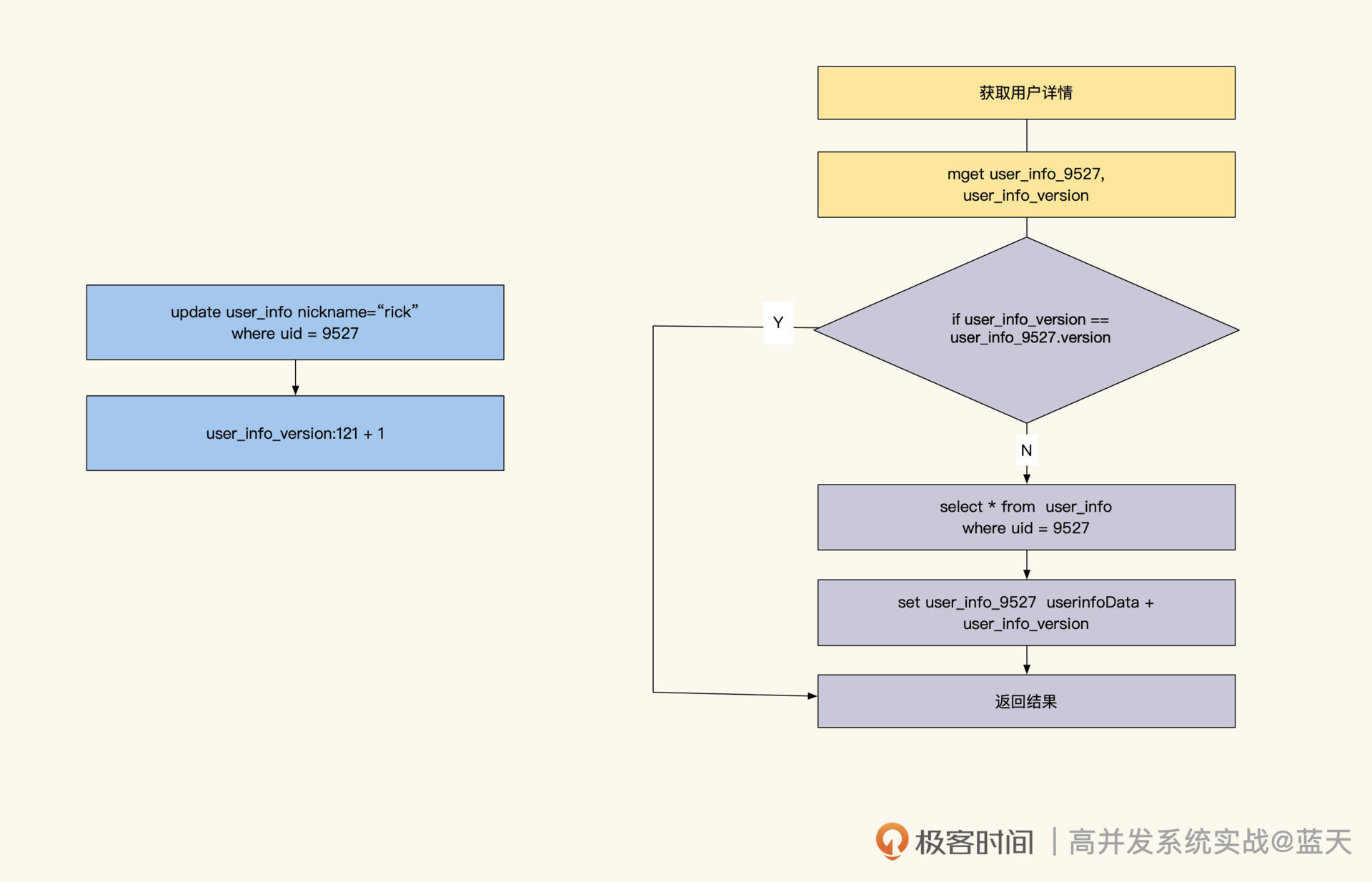

如果我们表内的数据更新很少,那么可以采用版本号缓存设计。

这个方式比较狂放:一旦有任何更新,整个表内所有数据缓存一起过期。比如对 user_info 表设置一个 key,假设是 user_info_version,当我们更新这个表数据时,直接对 user_info_version 进行 incr +1。而在写入缓存时,同时会在缓存数据中记录 user_info_version 的当前值。

当业务要读取 user_info 某个用户的信息的时候,业务会同时获取当前表的 version。如果发现缓存数据内的版本和当前表的版本不一致,那么就会更新这条数据。但如果 version 更新很频繁,就会严重降低缓存命中率,所以这种方案适合更新很少的表。

当然,我们还可以对这个表做一个范围拆分,比如按 ID 范围分块拆分出多个 version,通过这样的方式来减少缓存刷新的范围和频率

版本号方式刷新缓存

此外,关联型数据更新还可以通过识别主要实体 ID 来刷新缓存。这要保证其他缓存保存的 key 也是主要实体 ID,这样当某一条关联数据发生变化时,就可以根据主要实体 ID 对所有缓存进行刷新。这个方式的缺点是,我们的缓存要能够根据修改的数据反向找到它关联的主体 ID 才行。

通过主要实体id刷新缓存

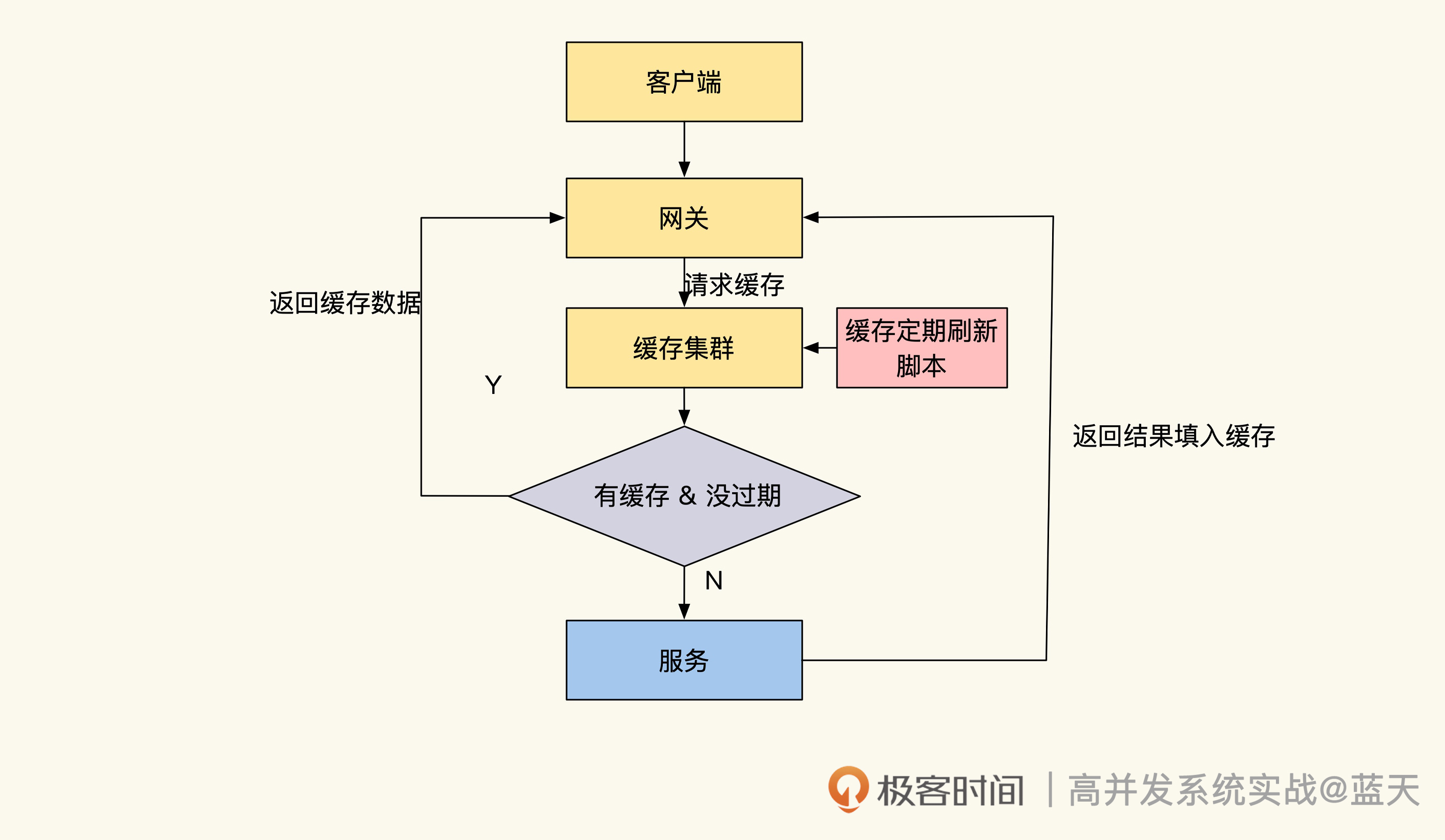

最后,我再给你介绍一种方式:**异步脚本遍历数据库刷新所有相关缓存。**这个方式适用于两个系统之间同步数据,能够减少系统间的接口交互;缺点是删除数据后,还需要人工删除对应的缓存,所以更新会有延迟。但如果能配合订阅更新消息广播的话,可以做到准同步。

遍历数据库刷新缓存

长期热数据缓存

到这里,我们再回过头看看之前的临时缓存伪代码,它虽然能解决大部分问题,但是请你想一想,当 TTL 到期时,**如果大量缓存请求没有命中,透传的流量会不会打沉我们的数据库?**这其实就是行业里常提到的缓存穿透问题,如果缓存出现大规模并发穿透,那么很有可能导致我们服务宕机。

所以,数据库要是扛不住平时的流量,我们就不能使用临时缓存的方式去设计缓存系统,只能用长期缓存这种方式来实现热点缓存,以此避免缓存穿透打沉数据库的问题。不过,要想实现长期缓存,就需要我们人工做更多的事情来保持缓存和数据表数据的一致性。

要知道,长期缓存这个方式自 NoSQL 兴起后才得以普及使用,主要原因在于长期缓存的实现和临时缓存有所不同,它要求我们的业务几乎完全不走数据库,并且服务运转期间所需的数据都要能在缓存中找到,同时还要保证使用期间缓存不会丢失。

由此带来的问题就是,我们需要知道缓存中具体有哪些数据,然后提前对这些数据进行预热。当然,如果数据规模较小,那我们可以考虑把全量数据都缓存起来,这样会相对简单一些。

为了加深理解,同时展示特殊技巧,下面我们来看一种“临时缓存 + 长期热缓存”的一个有趣的实现,这种方式会有小规模缓存穿透,并且代码相对复杂,不过总体来说成本是比较低的:

// 尝试从缓存中直接获取用户信息

userinfo, err := Redis.Get("user_info_9527")

if err != nil {

return nil, err

}

//缓存命中找到,直接返回用户信息

if userinfo != nil {

return userinfo, nil

}

//set 检测当前是否是热数据

//之所以没有使用Bloom Filter是因为有概率碰撞不准

//如果key数量超过千个,建议还是用Bloom Filter

//这个判断也可以放在业务逻辑代码中,用配置同步做

isHotKey, err := Redis.SISMEMBER("hot_key", "user_info_9527")

if err != nil {

return nil, err

}

//如果是热key

if isHotKey {

//没有找到就认为数据不存在

//可能是被删除了

return "", nil

}

//没有命中缓存,并且没被标注是热点,被认为是临时缓存,那么从数据库中获取

//设置更新锁set user_info_9527_lock nx ex 5

//防止多个线程同时并发查询数据库导致数据库压力过大

lock, err := Redis.Set("user_info_9527_lock", "1", "nx", 5)

if !lock {

//没抢到锁的直接等待1秒 然后再拿一次结果,类似singleflight实现

//行业常见缓存服务,读并发能力很强,但写并发能力并不好

//过高的并行刷新会刷沉缓存

time.sleep( time.second)

//等1秒后拿数据,这个数据是抢到锁的请求填入的

//通过这个方式降低数据库压力

userinfo, err := Redis.Get("user_info_9527")

if err != nil {

return nil, err

}

return userinfo,nil

}

//拿到锁的查数据库,然后填入缓存

userinfo, err := userInfoModel.GetUserInfoById(9527)

if err != nil {

return nil, err

}

//查找到用户信息

if userinfo != nil {

//将用户信息缓存,并设置TTL超时时间让其60秒后失效

Redis.Set("user_info_9527", userinfo, 60)

return userinfo, nil

}

// 没有找到,放一个空数据进去,短期内不再问数据库

Redis.Set("user_info_9527", "", 30)

return nil, nil

可以看到,这种方式是长期缓存和临时缓存的混用。当我们要查询某个用户信息时,如果缓存中没有数据,长期缓存会直接返回没有找到,临时缓存则直接走更新流程。此外,我们的用户信息如果属于热点 key,并且在缓存中找不到的话,就直接返回数据不存在。

在更新期间,为了防止高并发查询打沉数据库,我们将更新流程做了简单的 singleflight(请求合并)优化,只有先抢到缓存更新锁的线程,才能进入后端读取数据库并将结果填写到缓存中。而没有抢到更新锁的线程先 sleep 1 秒,然后直接读取缓存返回结果。这样可以保证后端不会有多个线程读取同一条数据,从而冲垮缓存和数据库服务(缓存的写并发没有读性能那么好)。

另外,hot_key 列表(也就是长期缓存的热点 key 列表)会在多个 Redis 中复制保存,如果要读取它,随机找一个分片就可以拿到全量配置。

这些热缓存 key,来自于统计一段时间内数据访问流量,计算得出的热点数据。那长期缓存的更新会异步脚本去定期扫描热缓存列表,通过这个方式来主动推送缓存,同时把 TTL 设置成更长的时间,来保证新的热数据缓存不会过期。当这个 key 的热度过去后,热缓存 key 就会从当前 set 中移除,腾出空间给其他地方使用。

当然,如果我们拥有一个很大的缓存集群,并且我们的数据都属于热数据,那么我们大可以脱离数据库,将数据都放到缓存当中直接对外服务,这样我们将获得更好的吞吐和并发。

最后,还有一种方式来缓解热点高并发查询,在每个业务服务器上部署一个小容量的 Redis 来保存热点缓存数据,通过脚本将热点数据同步到每个服务器的小 Redis 上,每次查询数据之前都会在本地小 Redis 查找一下,如果找不到再去大缓存内查询,通过这个方式缓解缓存的读取性能。

总结

通过这节课,我希望你能明白:不是所有的数据放在缓存就能有很好的收益,我们要从数据量、使用频率、缓存命中率三个角度去分析。读多写少的数据做缓存虽然能降低数据层的压力,但要根据一致性需求对其缓存的数据做更新。其中,单条实体数据最容易实现缓存更新,但是有条件查询的统计结果并不容易做到实时更新。

除此之外,如果数据库承受不了透传流量压力,我们需要将一些热点数据做成长期缓存,来防止大量请求穿透缓存,这样会影响我们的服务稳定。同时通过 singleflight 方式预防临时缓存被大量请求穿透,以防热点数据在从临时缓存切换成热点之前,击穿缓存,导致数据库崩溃。

读多写少的缓存技巧我还画了一张导图,如下所示:

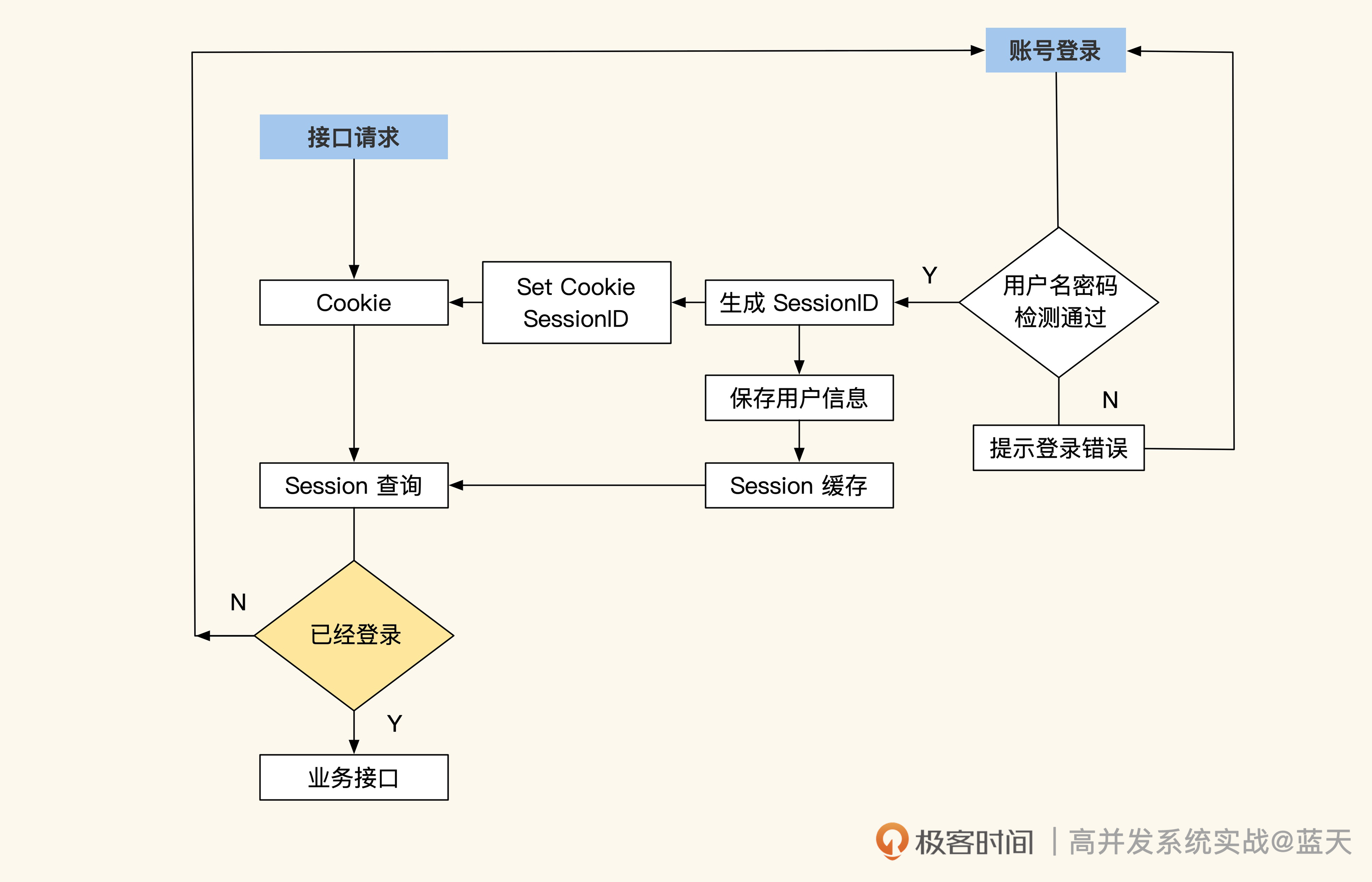

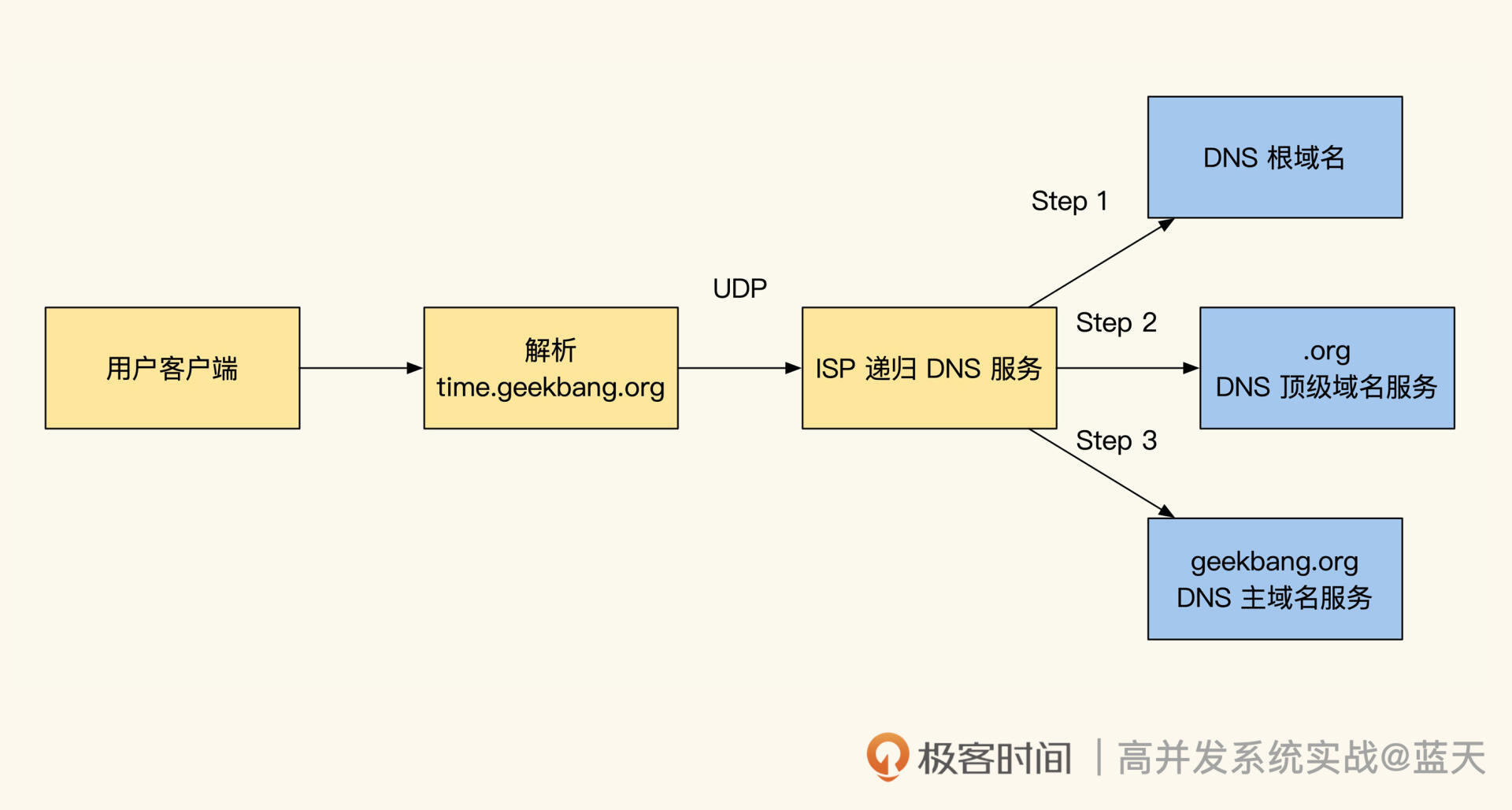

Token:如何降低用户身份鉴权的流量压力?

很多网站初期通常会用 Session 方式实现登录用户的用户鉴权,也就是在用户登录成功后,将这个用户的具体信息写在服务端的 Session 缓存中,并分配一个 session_id 保存在用户的 Cookie 中。该用户的每次请求时候都会带上这个 ID,通过 ID 可以获取到登录时写入服务端 Session 缓存中的记录。

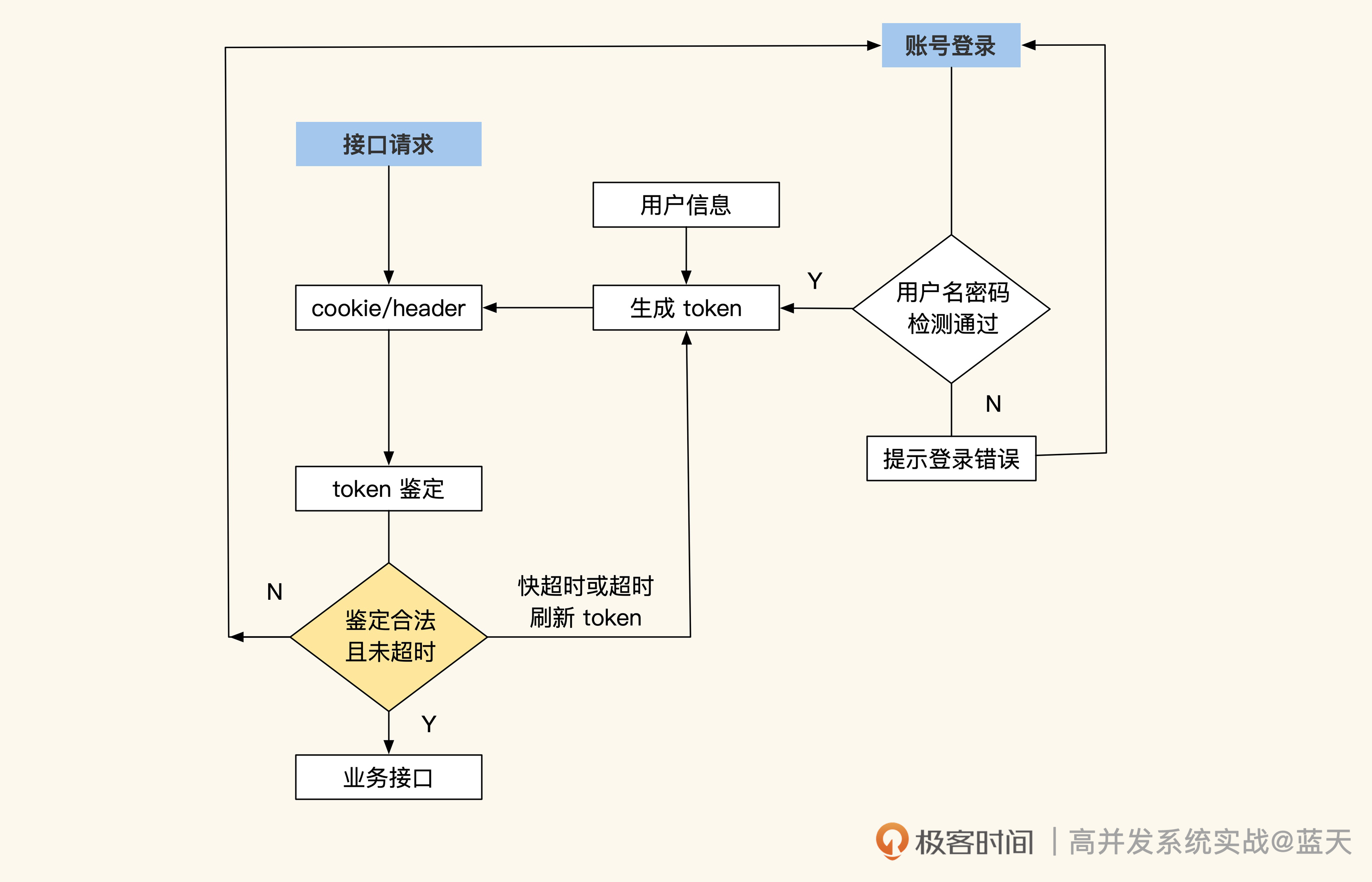

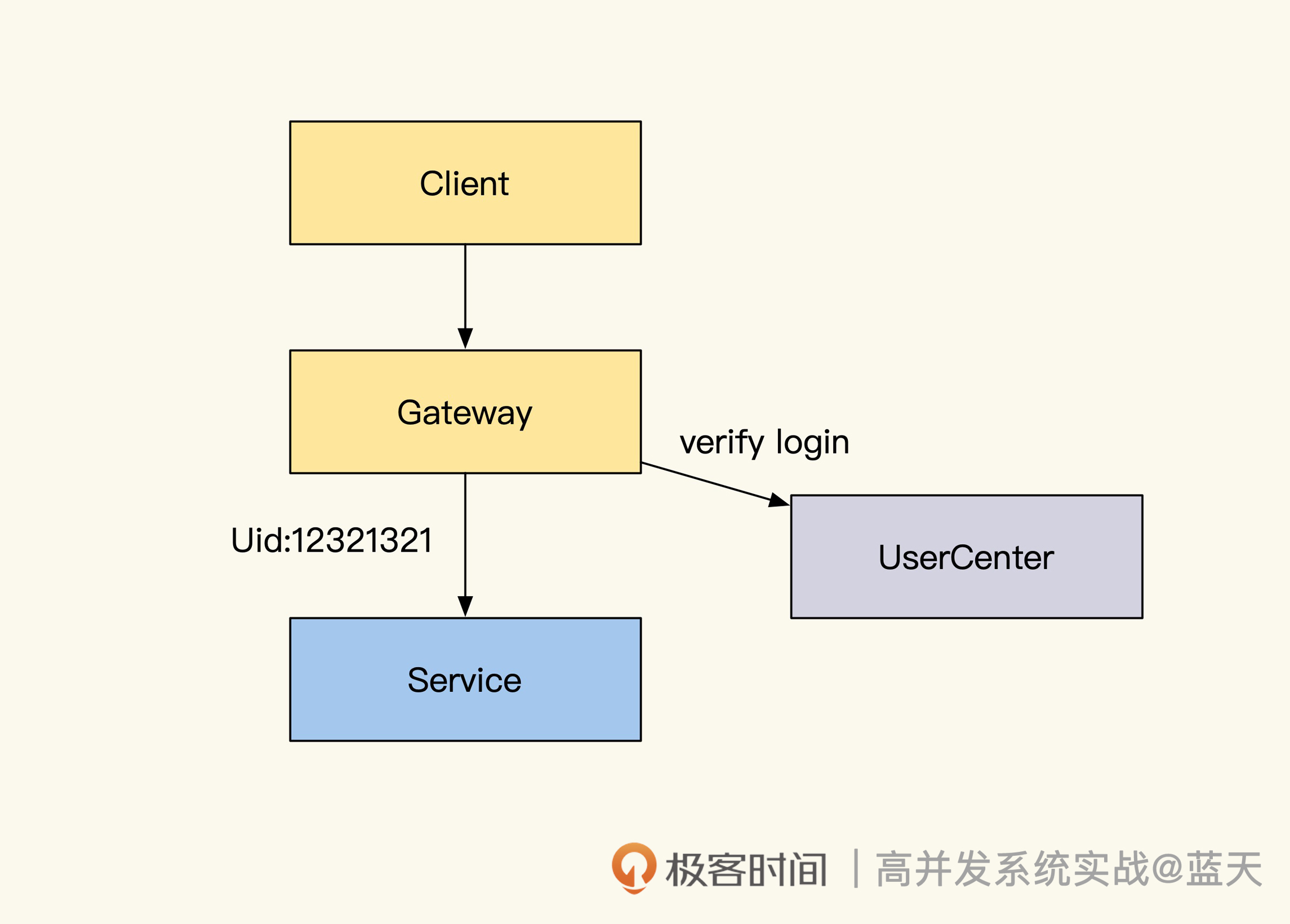

流程图如下所示:

Session Cache实现的用户鉴权

种方式的好处在于信息都在服务端储存,对客户端不暴露任何用户敏感的数据信息,并且每个登录用户都有共享的缓存空间(Session Cache)。

但是随着流量的增长,这个设计也暴露出很大的问题——用户中心的身份鉴权在大流量下很不稳定。因为用户中心需要维护的 Session Cache 空间很大,并且被各个业务频繁访问,那么缓存一旦出现故障,就会导致所有的子系统无法确认用户身份,进而无法正常对外服务。

这主要是由于 Session Cache 和各个子系统的耦合极高,全站的请求都会对这个缓存至少访问一次,这就导致缓存的内容长度和响应速度,直接决定了全站的 QPS 上限,让整个系统的隔离性很差,各子系统间极易相互影响。

那么,如何降低用户中心与各个子系统间的耦合度,提高系统的性能呢?我们一起来看看。

JWT 登陆和 token 校验

常见方式是采用签名加密的 token,这是登录的一个行业标准,即 JWT(JSON Web Token):

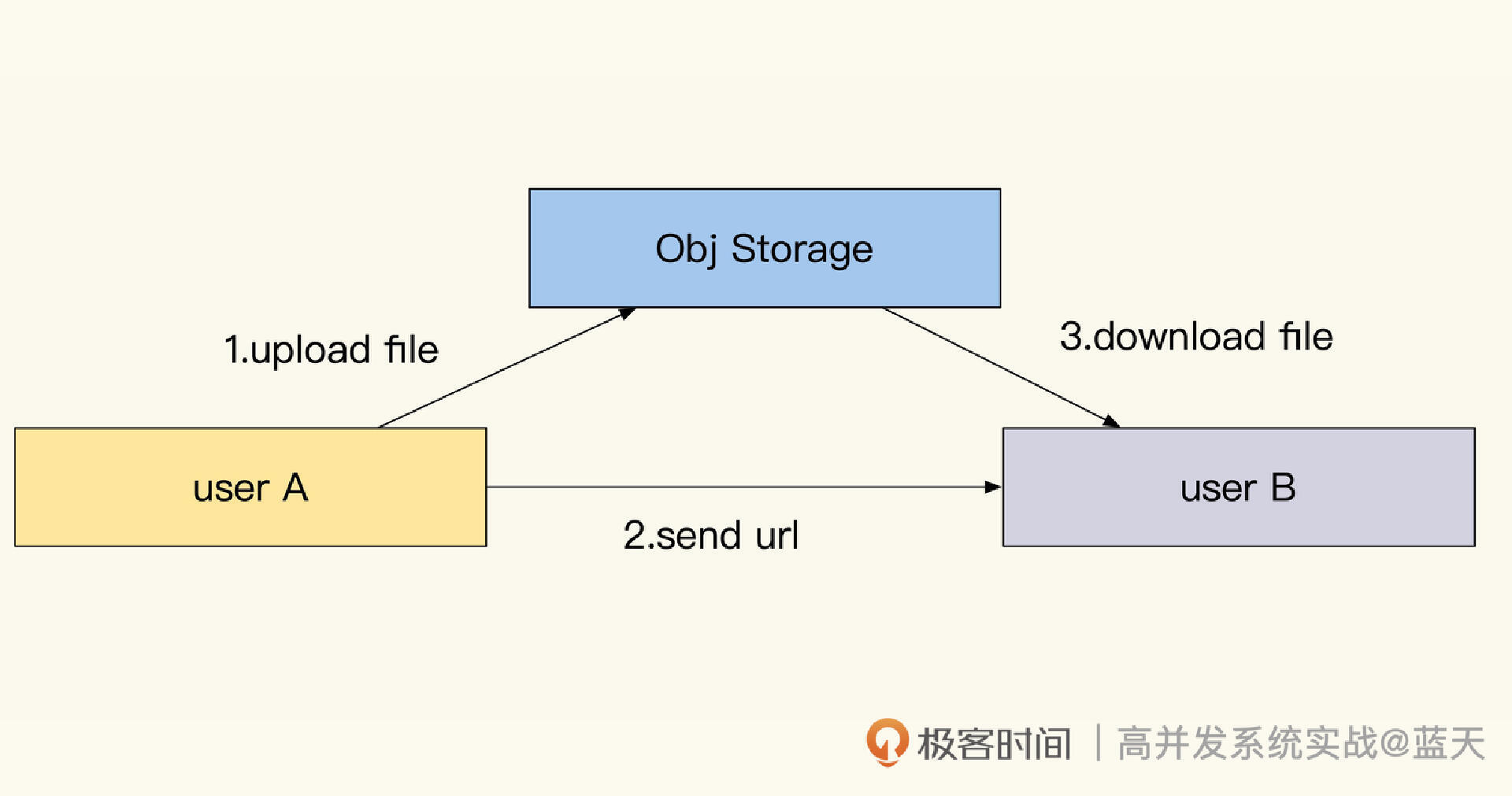

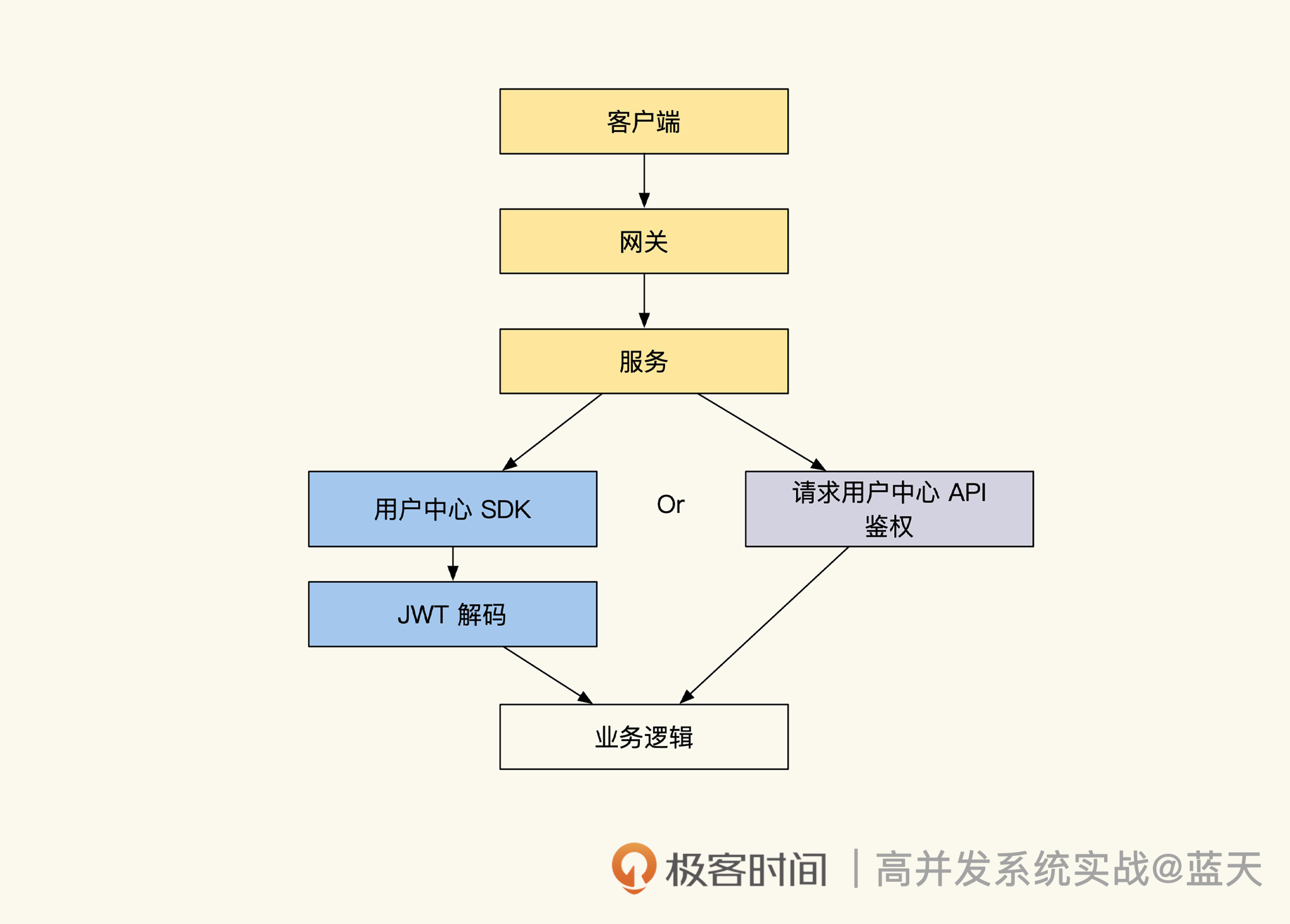

token流程上图就是 JWT 的登陆流程,用户登录后会将用户信息放到一个加密签名的 token 中,每次请求都把这个串放到 header 或 cookie 内带到服务端,服务端直接将这个 token 解开即可直接获取到用户的信息,无需和用户中心做任何交互请求。

token 生成代码如下:

import "github.com/dgrijalva/jwt-go"

//签名所需混淆密钥 不要太简单 容易被破解

//也可以使用非对称加密,这样可以在客户端用公钥验签

var secretString = []byte("jwt secret string 137 rick")

type TokenPayLoad struct {

UserId uint64 `json:"userId"` //用户id

NickName string `json:"nickname"` //昵称

jwt.StandardClaims //私有部分

}

// 生成JWT token

func GenToken(userId uint64, nickname string) (string, error) {

c := TokenPayLoad{

UserId: userId, //uid

NickName: nickname, //昵称

//这里可以追加一些其他加密的数据进来

//不要明文放敏感信息,如果需要放,必须再加密

//私有部分

StandardClaims: jwt.StandardClaims{

//两小时后失效

ExpiresAt: time.Now().Add(2 * time.Hour).Unix(),

//颁发者

Issuer: "geekbang",

},

}

//创建签名 使用hs256

token := jwt.NewWithClaims(jwt.SigningMethodHS256, c)

// 签名,获取token结果

return token.SignedString(secretString)

}

可以看到,这个 token 内部包含过期时间,快过期的 token 会在客户端自动和服务端通讯更换,这种方式可以大幅提高截取客户端 token 并伪造用户身份的难度。

同时,服务端也可以和用户中心解耦,业务服务端直接解析请求带来的 token 即可获取用户信息,无需每次请求都去用户中心获取。而 token 的刷新可以完全由 App 客户端主动请求用户中心来完成,而不再需要业务服务端业务请求用户中心去更换。

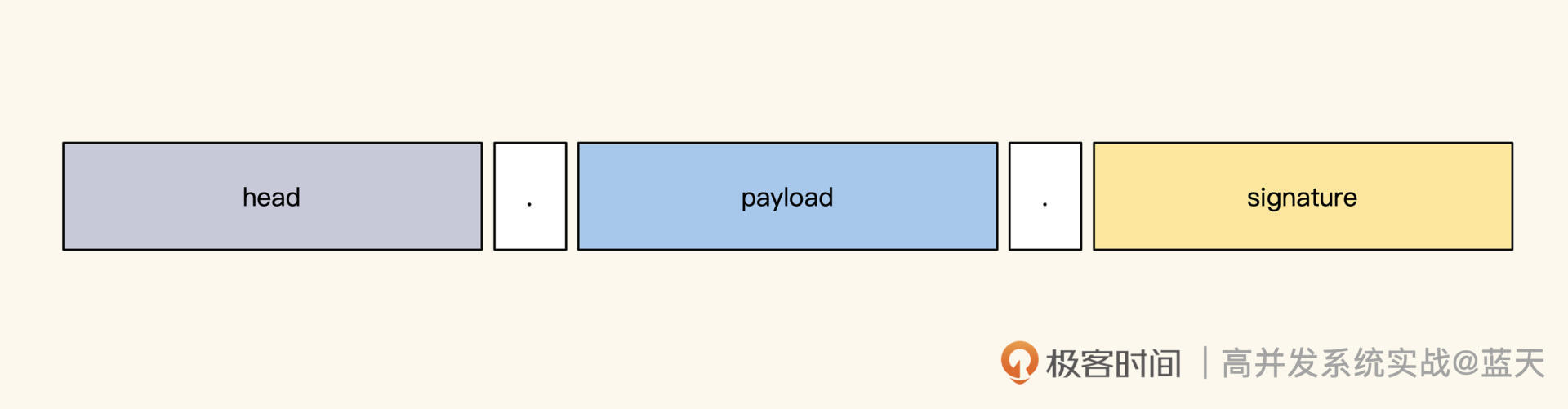

JWT 是如何保证数据不会被篡改,并且保证数据的完整性呢,我们先看看它的组成。

如上图所示,加密签名的 token 分为三个部分,彼此之间用点来分割,其中,Header 用来保存加密算法类型;PayLoad 是我们自定义的内容;Signature 是防篡改签名。

JWT token 解密后的数据结构如下图所示:

//header

//加密头

{

"alg": "HS256", // 加密算法,注意检测个别攻击会在这里设置为none绕过签名

"typ": "JWT" //协议类型

}

//PAYLOAD

//负载部分,存在JWT标准字段及我们自定义的数据字段

{

"userid": "9527", //我们放的一些明文信息,如果涉及敏感信息,建议再次加密

"nickname": "Rick.Xu", // 我们放的一些明文信息,如果涉及隐私,建议再次加密

"iss": "geekbang",

"iat": 1516239022, //token发放时间

"exp": 1516246222, //token过期时间

}

//签名

//签名用于鉴定上两段内容是否被篡改,如果篡改那么签名会发生变化

//校验时会对不上

JWT 如何验证 token 是否有效,还有 token 是否过期、是否合法,具体方法如下:

func DecodeToken(token string) (*TokenPayLoad, error) {

token, err := jwt.ParseWithClaims(token, &TokenPayLoad{}, func(tk *jwt.Token) (interface{}, error) {

return secret, nil

})

if err != nil {

return nil, err

}

if decodeToken, ok := token.Claims.(*TokenPayLoad); ok && token.Valid {

return decodeToken, nil

}

return nil, errors.New("token wrong")

}

JWT 的 token 解密很简单,第一段和第二段都是通过 base64 编码的。直接解开这两段数据就可以拿到 payload 中所有的数据,其中包括用户昵称、uid、用户权限和 token 过期时间。要验证 token 是否过期,只需将其中的过期时间和本地时间对比一下,就能确认当前 token 是不是有效。

而验证 token 是否合法则是通过签名验证完成的,任何信息修改都会无法通过签名验证。要是通过了签名验证,就表明 token 没有被篡改过,是一个合法的 token,可以直接使用。

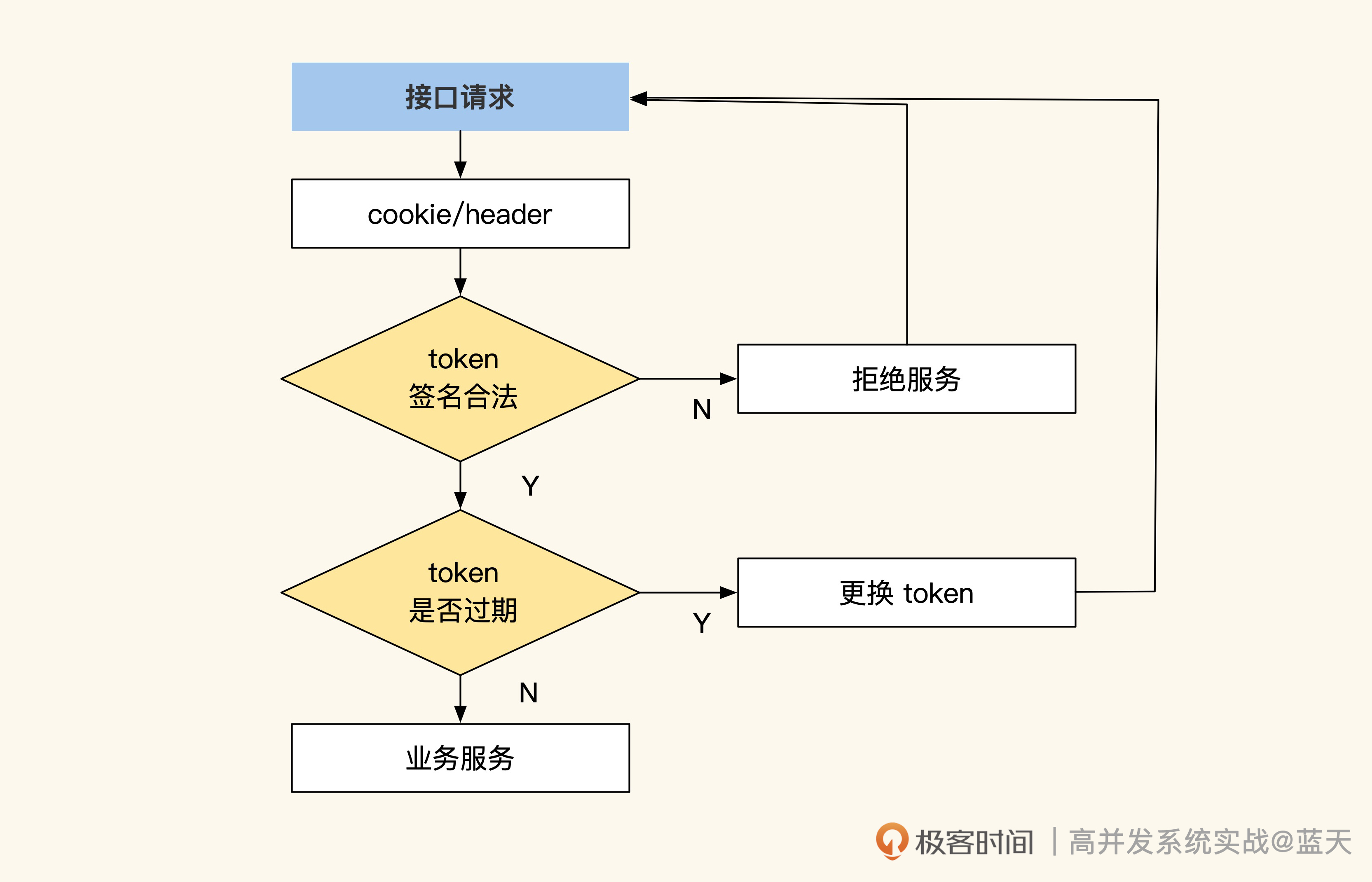

这个过程如下图所示:

我们可以看到,通过 token 方式,用户中心压力最大的接口可以下线了,每个业务的服务端只要解开 token 验证其合法性,就可以拿到用户信息。不过这种方式也有缺点,就是用户如果被拉黑,客户端最快也要在 token 过期后才能退出登陆,这让我们的管理存在一定的延迟。

我们可以看到,通过 token 方式,用户中心压力最大的接口可以下线了,每个业务的服务端只要解开 token 验证其合法性,就可以拿到用户信息。不过这种方式也有缺点,就是用户如果被拉黑,客户端最快也要在 token 过期后才能退出登陆,这让我们的管理存在一定的延迟。

如果我们希望对用户进行实时管理,可以把新生成的 token 在服务端暂存一份,每次用户请求就和缓存中的 token 对比一下,但这样很影响性能,极少数公司会这么做。同时,为了提高 JWT 系统的安全性,token 一般会设置较短的过期时间,通常是十五分钟左右,过期后客户端会自动更换 token。

token 的更换和离线

那么如何对 JWT 的 token 进行更换和离线验签呢?

具体的服务端换签很简单,只要客户端检测到当前的 token 快过期了,就主动请求用户中心更换 token 接口,重新生成一个离当前还有十五分钟超时的 token。

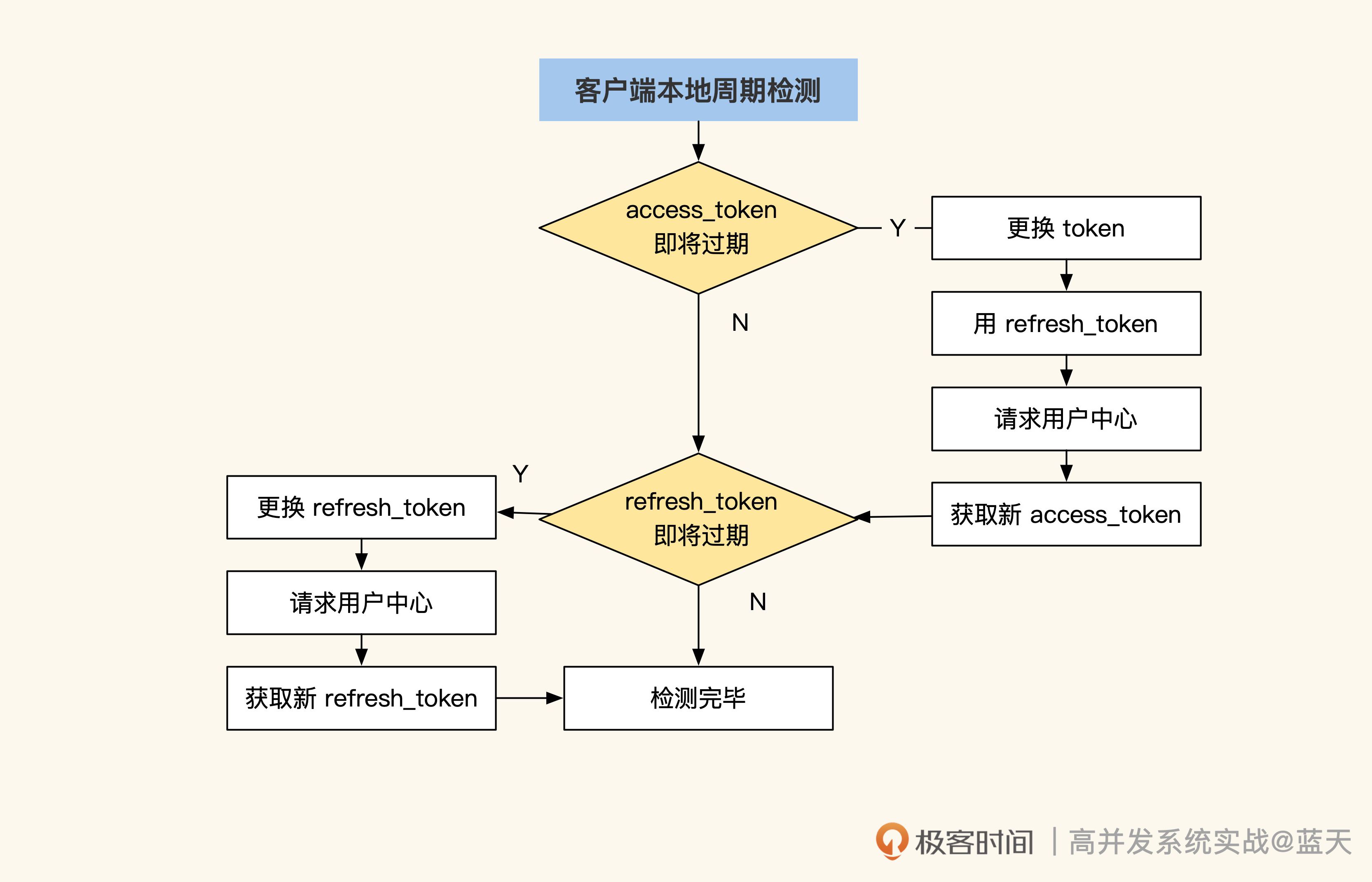

但是期间如果超过十五分钟还没换到,就会导致客户端登录失败。为了减少这类问题,同时保证客户端长时间离线仍能正常工作,行业内普遍使用双 token 方式,具体你可以看看后面的流程图:

可以看到,这个方案里有两种 token:**一种是 refresh_token,用于更换 access_token,有效期是 30 天;另一种是 access_token,用于保存当前用户信息和权限信息,每隔 15 分钟更换一次。**如果请求用户中心失败,并且 App 处于离线状态,只要检测到本地 refresh_token 没有过期,系统仍可以继续工作,直到 refresh_token 过期为止,然后提示用户重新登陆。这样即使用户中心坏掉了,业务也能正常运转一段时间。

用户中心检测更换 token 的实现如下:

//如果还有五分钟token要过期,那么换token

if decodeToken.StandardClaims.ExpiresAt < TimestampNow() - 300 {

//请求下用户中心,问问这个人禁登陆没

//....略具体

//重新发放token

token, err := GenToken(.....)

if err != nil {

return nil, err

}

//更新返回cookie中token

resp.setCookie("xxxx", token)

}

这段代码只是对当前的 token 做了超时更换。JWT 对离线 App 端十分友好,因为 App 可以将它保存在本地,在使用用户信息时直接从本地解析出来即可。

安全建议

最后我再啰嗦几句,除了上述代码中的注释外,在使用 JWT 方案的时候还有一些关键的注意事项,这里分享给你。

第一,通讯过程必须使用 HTTPS 协议,这样才可以降低被拦截的可能。

第二,要注意限制 token 的更换次数,并定期刷新 token,比如用户的 access_token 每天只能更换 50 次,超过了就要求用户重新登陆,同时 token 每隔 15 分钟更换一次。这样可以降低 token 被盗取后给用户带来的影响。第三,Web 用户的 token 保存在 cookie 中时,建议加上 httponly、SameSite=Strict 限制,以防止 cookie 被一些特殊脚本偷走。

总结

传统的 Session 方式是把用户的登录信息通过 SessionID 统一缓存到服务端中,客户端和子系统每次请求都需要到用户中心去“提取”,这就会导致用户中心的流量很大,所有业务都很依赖用户中心。

为了降低用户中心的流量压力,同时让各个子系统与用户中心脱耦,我们采用信任“签名”的 token,把用户信息加密发放到客户端,让客户端本地拥有这些信息。而子系统只需通过签名算法对 token 进行验证,就能获取到用户信息。

这种方式的核心是**把用户信息放在服务端外做传递和维护,以此解决用户中心的流量性能瓶颈。**此外,通过定期更换 token,用户中心还拥有一定的用户控制能力,也加大了破解难度,可谓一举多得。

其实,还有很多类似的设计简化系统压力,比如文件 crc32 校验签名可以帮我们确认文件在传输过程中是否损坏;通过 Bloom Filter 可以确认某个 key 是否存在于某个数据集合文件中等等,这些都可以大大提高系统的工作效率,减少系统的交互压力。这些技巧在硬件能力腾飞的阶段,仍旧适用。

同城双活:如何实现机房之间的数据同步?

在业务初期,考虑到投入成本,很多公司通常只用一个机房提供服务。但随着业务发展,流量不断增加,我们对服务的响应速度和可用性有了更高的要求,这时候我们就要开始考虑将服务分布在不同的地区来提供更好的服务,这是互联网公司在流量增长阶段的必经之路。

之前我所在的公司,流量连续三年不断增长。一次,机房对外网络突然断开,线上服务全部离线,网络供应商失联。因为没有备用机房,我们经过三天紧急协调,拉起新的线路才恢复了服务。这次事故影响很大,公司损失达千万元。

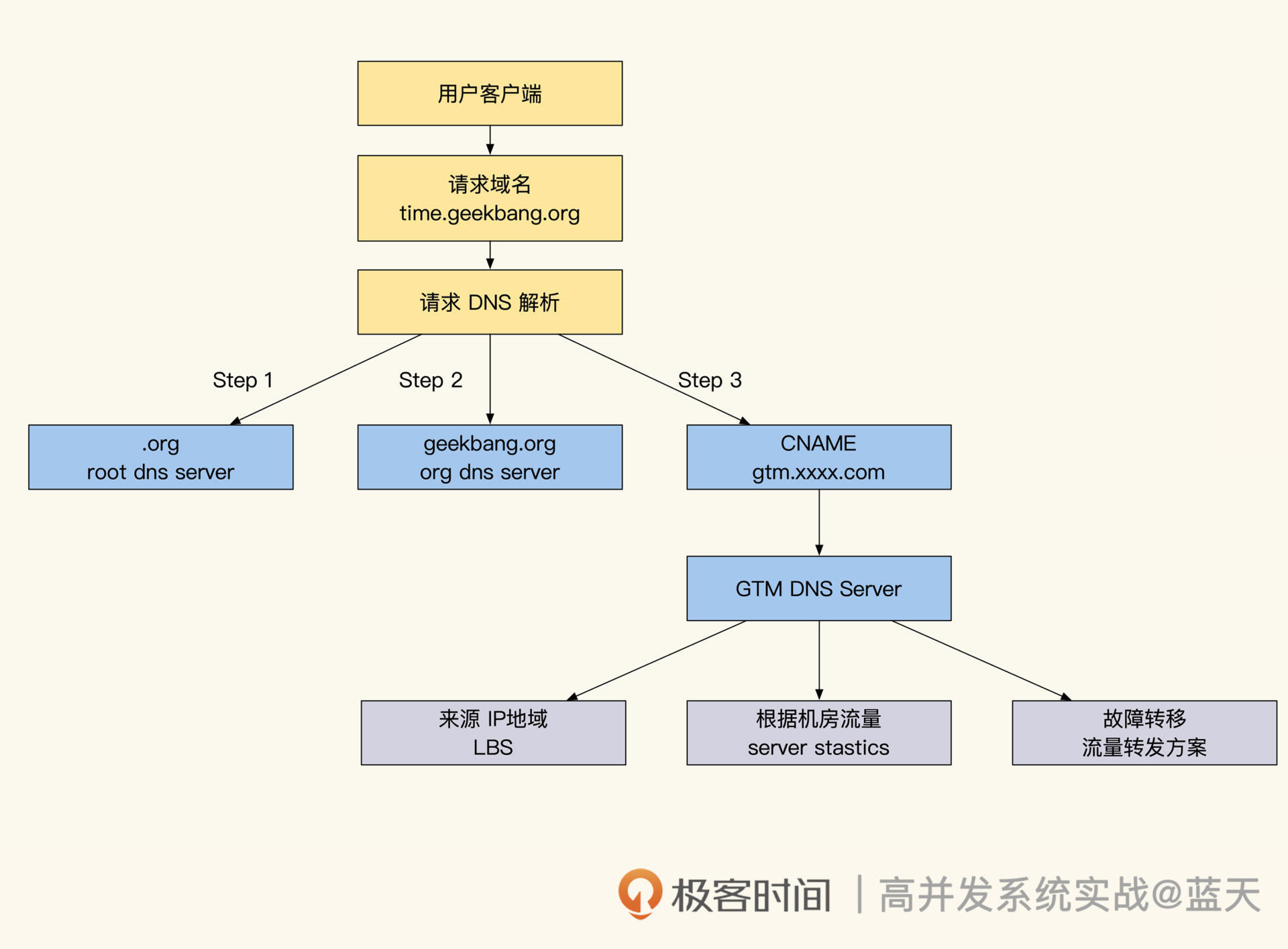

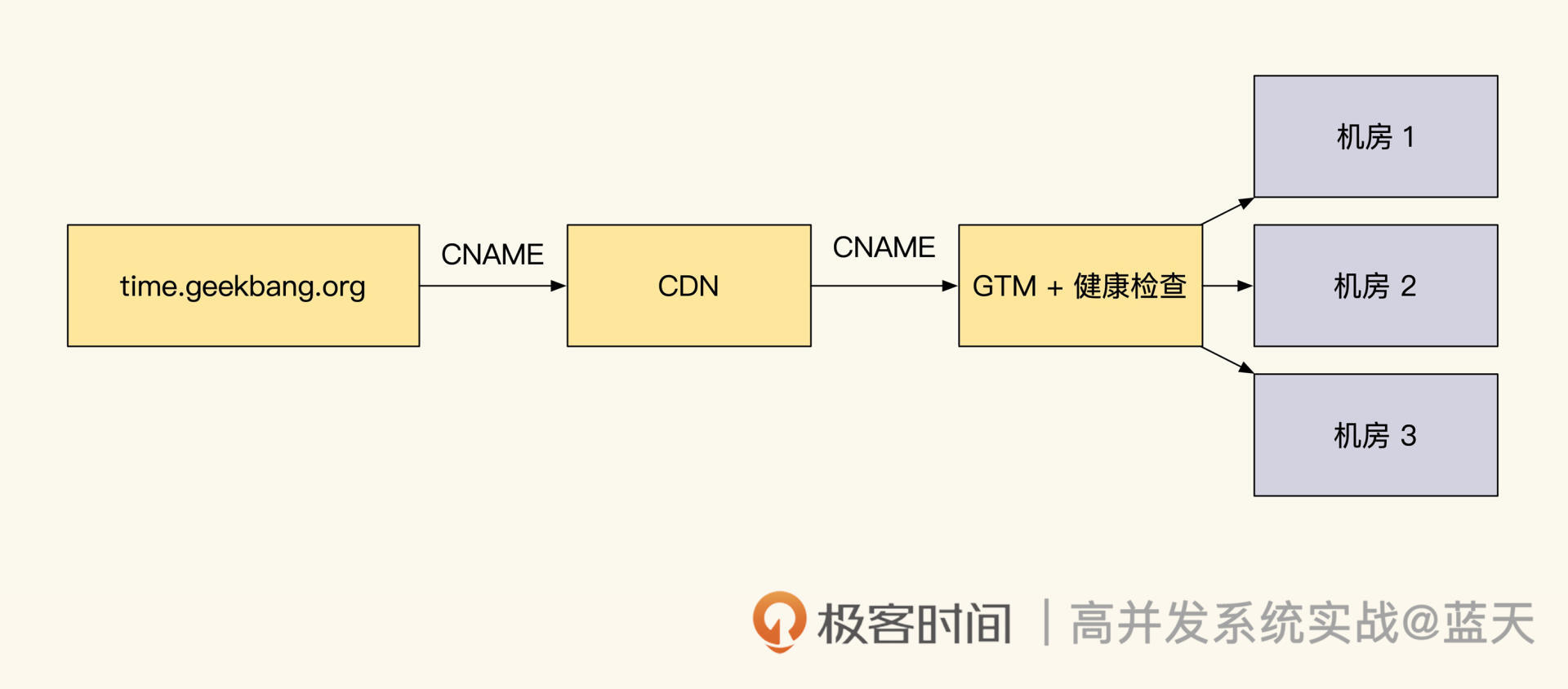

经过这次惨痛的教训,我们将服务迁移到了大机房,并决定在同城建设双机房提高可用性。这样当一个机房出现问题无法访问时,用户端可以通过 HttpDNS 接口快速切换到无故障机房。

为了保证在一个机房损坏的情况下,另外一个机房能直接接手流量,这两个机房的设备必须是 1:1 采购。但让其中一个机房长时间冷备不工作过于浪费,因此我们期望两个机房能同时对外提供服务,也就是实现同城双机房双活。

对此,我们碰到的一个关键问题就是,如何实现同城双活的机房数据库同步?

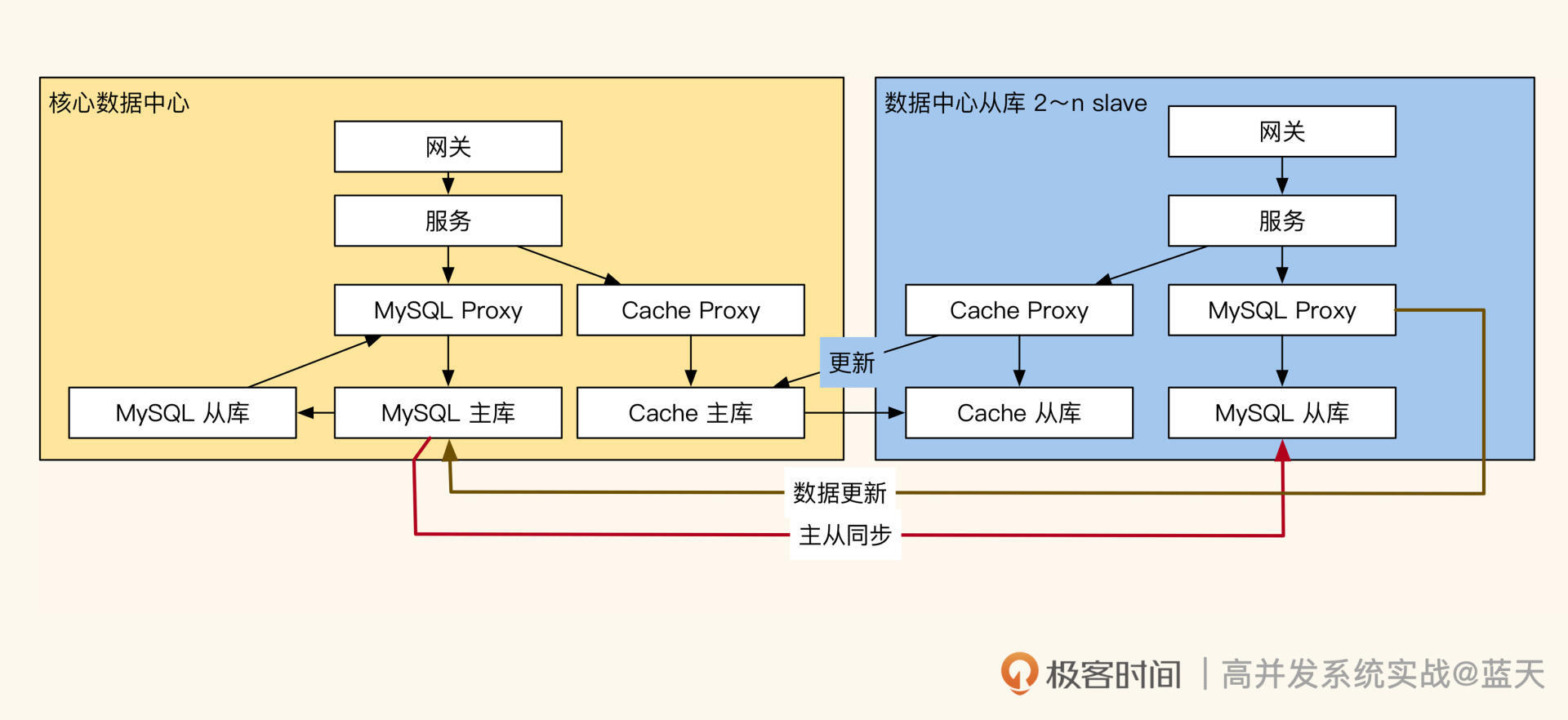

核心数据中心设计

因为数据库的主从架构,全网必须只能有一个主库,所以我们只能有一个机房存放更新数据的主库,再由这个机房同步给其他备份机房。虽然机房之间有专线连接,但并不能保证网络完全稳定。如果网络出现故障,我们要想办法确保机房之间能在网络修复后快速恢复数据同步。

有人可能会说,直接采用分布式数据库不就得了。要知道改变现有服务体系,投入到分布式数据库的大流中需要相当长的时间,成本也非常高昂,对大部分公司来说是不切实际的。所以我们要看看怎么对现有系统进行改造,实现同城双活的机房数据库同步,这也是我们这节课的目标。

核心数据库中心方案是常见的实现方式,这种方案只适合相距不超过 50 公里的机房。

同城双活单向同步

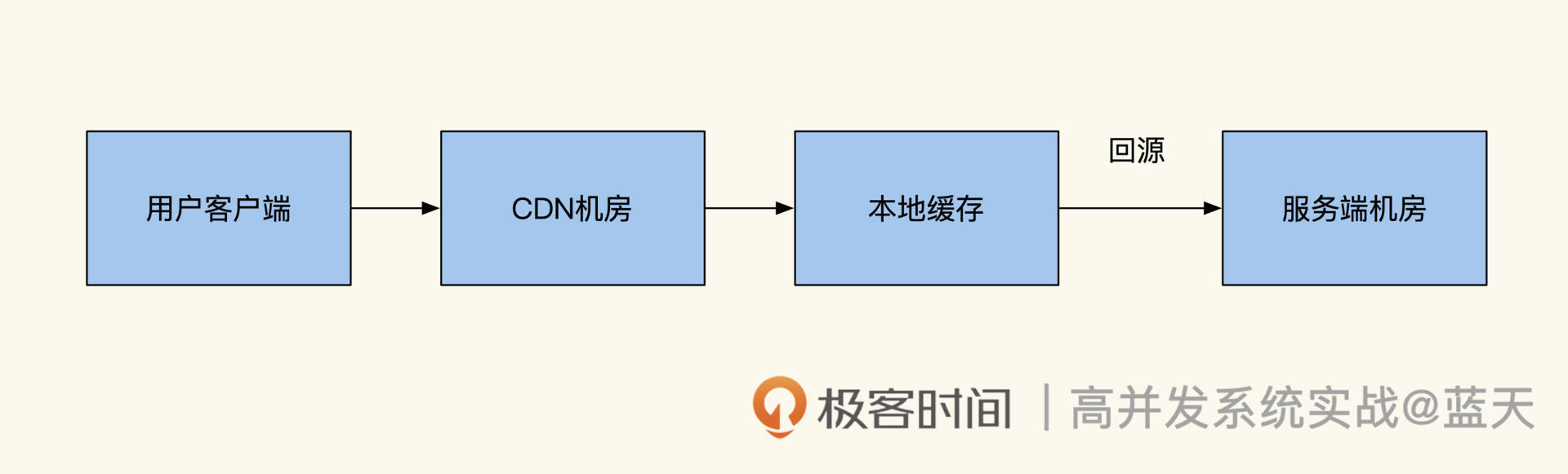

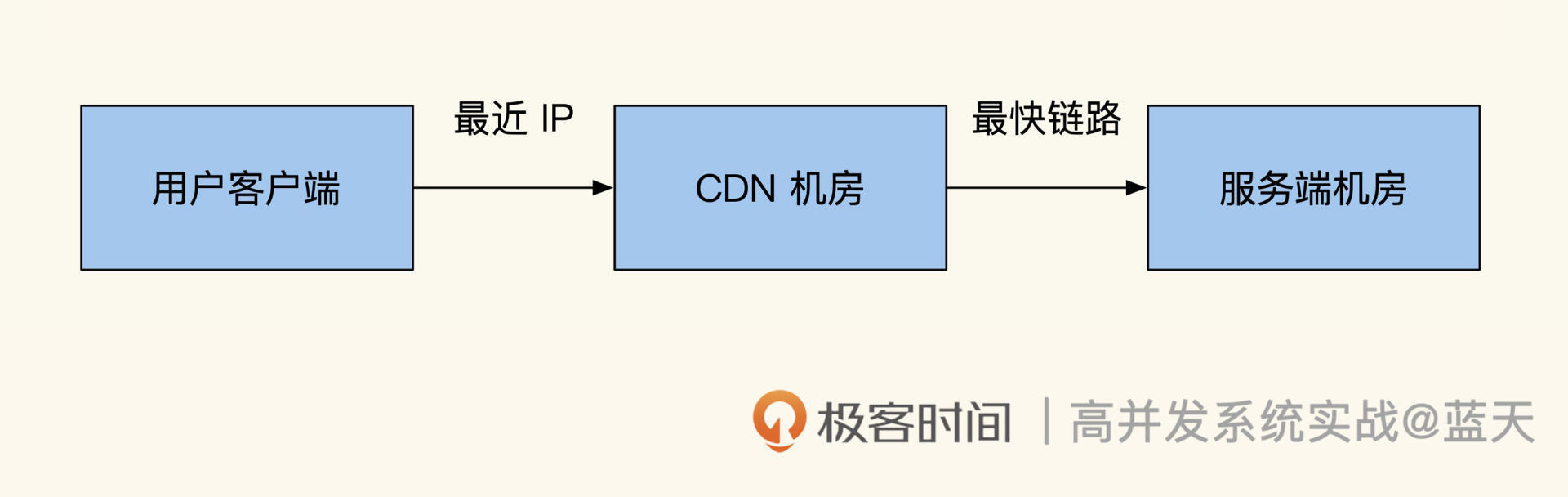

在这个方案中,数据库主库集中在一个机房,其他机房的数据库都是从库。当有数据修改请求时,核心机房的主库先完成修改,然后通过数据库主从同步把修改后的数据传给备份机房的从库。由于用户平时访问的信息都是从缓存中获取的,为了降低主从延迟,备份机房会把修改后的数据先更新到本地缓存。

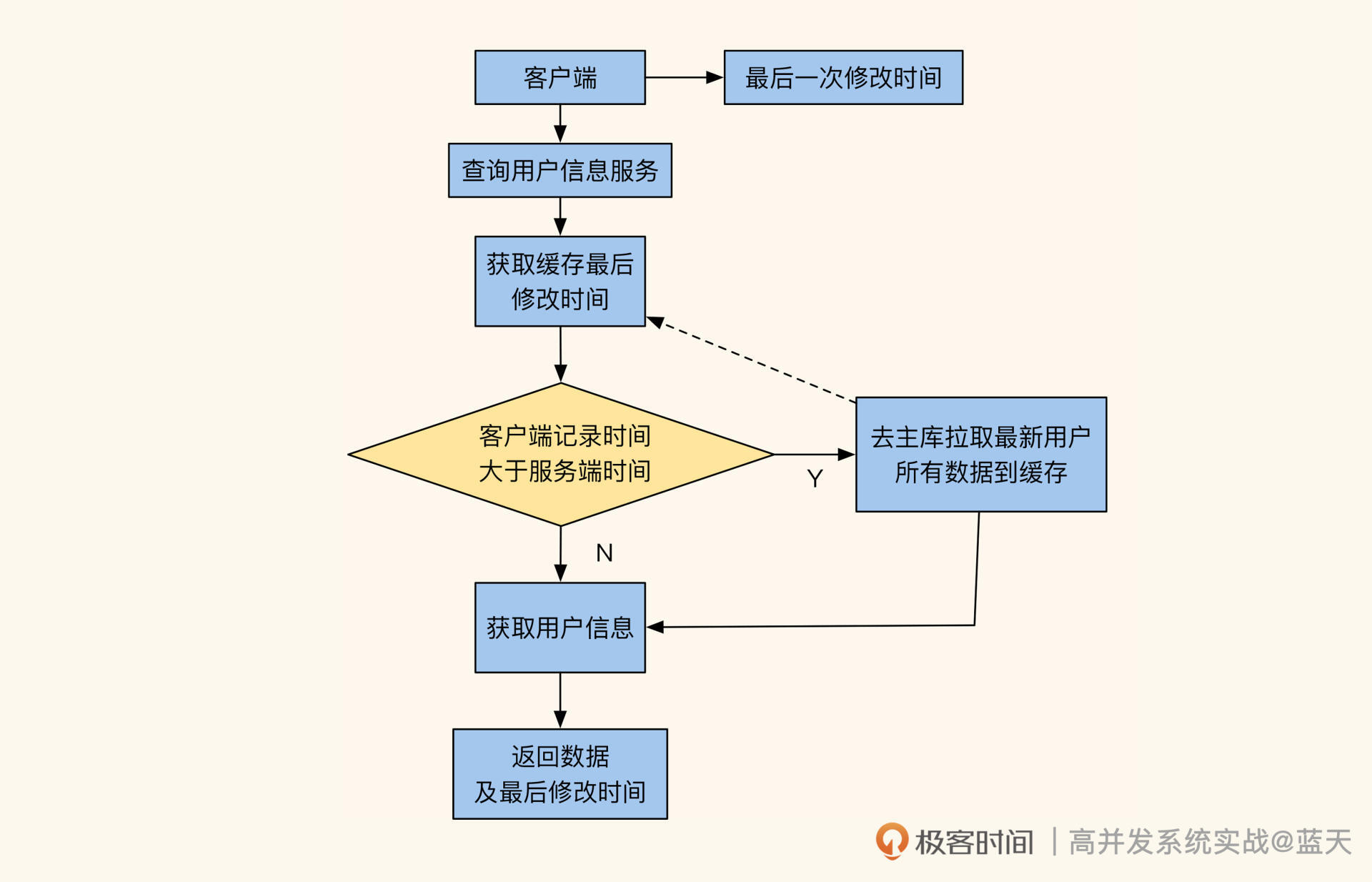

与此同时,客户端会在本地记录下数据修改的最后时间戳(如果没有就取当前时间)。当客户端请求服务端时,服务端会自动对比缓存中对应数据的更新时间,是否小于客户端本地记录的修改时间。

如果缓存更新时间小于客户端内的修改时间,服务端会触发同步指令尝试在从库中查找最新数据;如果没有找到,就把从主库获取的最新数据放到被访问机房的缓存中。这种方式可以避免机房之间用户数据更新不及时的问题。

客户端切换强迫服务端刷新本地缓存逻辑

除此之外,客户端还会通过请求调度接口,让一个用户在短期内只访问一个机房,防止用户在多机房间来回切换的过程中,数据在两个机房同时修改引发更新合并冲突。

总体来看,这是一个相对简单的设计,但缺点也很多。比如如果核心机房离线,其他机房就无法更新,故障期间需要人工切换各个 proxy 内的主从库配置才能恢复服务,并且在故障过后还需要人工介入恢复主从同步。

此外,因为主从同步延迟较大,业务中刚更新的数据要延迟一段时间,才能在备用机房查到,这会导致我们业务需要人工兼顾这种情况,整体实现十分不便。

这里我给你一个常见的网络延迟参考:

- 同机房服务器:0.1 ms

- 同城服务器(100 公里以内) :1ms(10 倍 同机房)

- 北京到上海: 38ms(380 倍 同机房)

- 北京到广州:53ms(530 倍 同机房)

注意,上面只是一次 RTT 请求,而机房间的同步是多次顺序地叠加请求。如果要大规模更新数据,主从库的同步延迟还会加大,所以这种双活机房的数据量不能太大,并且业务不能频繁更新数据。

此外还要注意,如果服务有强一致性的要求,所有操作都必须在主库“远程执行”,那么这些操作也会加大主从同步延迟。

除了以上问题外,双机房之间的专线还会偶发故障。我碰到过机房之间专线断开两小时的情况,期间只能临时用公网保持同步,但公网同步十分不稳定,网络延迟一直在 10ms~500ms 之间波动,主从延迟达到了 1 分钟以上。好在用户中心服务主要以长期缓存的方式存储数据,业务的主要流程没有出现太大问题,只是用户修改信息太慢了。

有时候,双机房还会偶发主从同步断开,对此建议做告警处理。一旦出现这种情况,就发送通知到故障警报群,由 DBA 人工修复处理。

另外,我还碰到过主从不同步期间,有用户注册自增 ID 出现重复,导致主键冲突这种情况。这里我推荐将自增 ID 更换为“由 SnowFlake 算法计算出的 ID”,这样可以减少机房不同步导致的主键冲突问题。

可以看到,核心数据库的中心方案虽然实现了同城双机房双活,但是人力投入很大。DBA 需要手动维护同步,主从同步断开后恢复起来也十分麻烦,耗时耗力,而且研发人员需要时刻关注主从不同步的情况,整体维护起来十分不便,所以我在这里推荐另外一个解决方案:数据库同步工具 Otter。

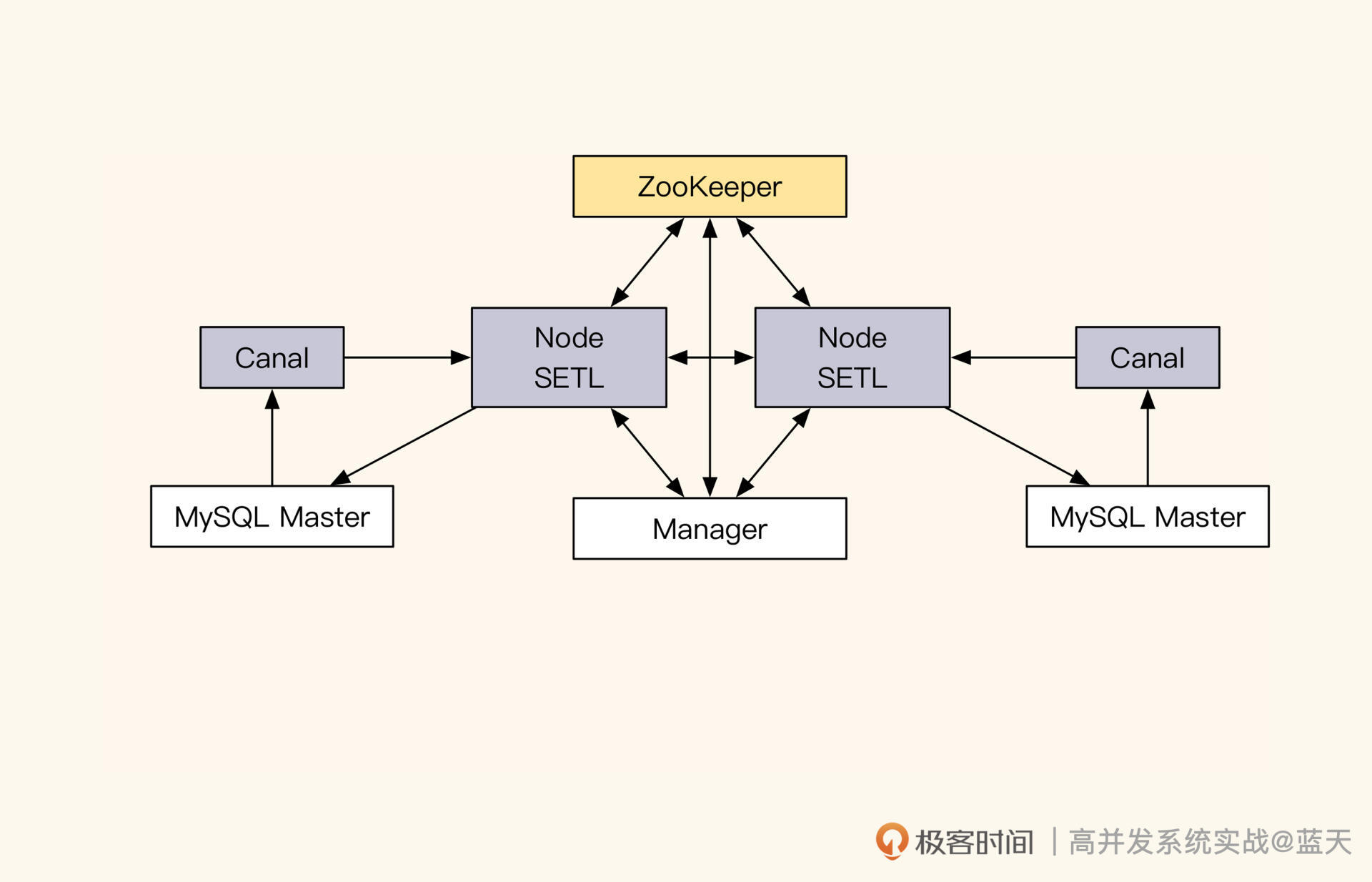

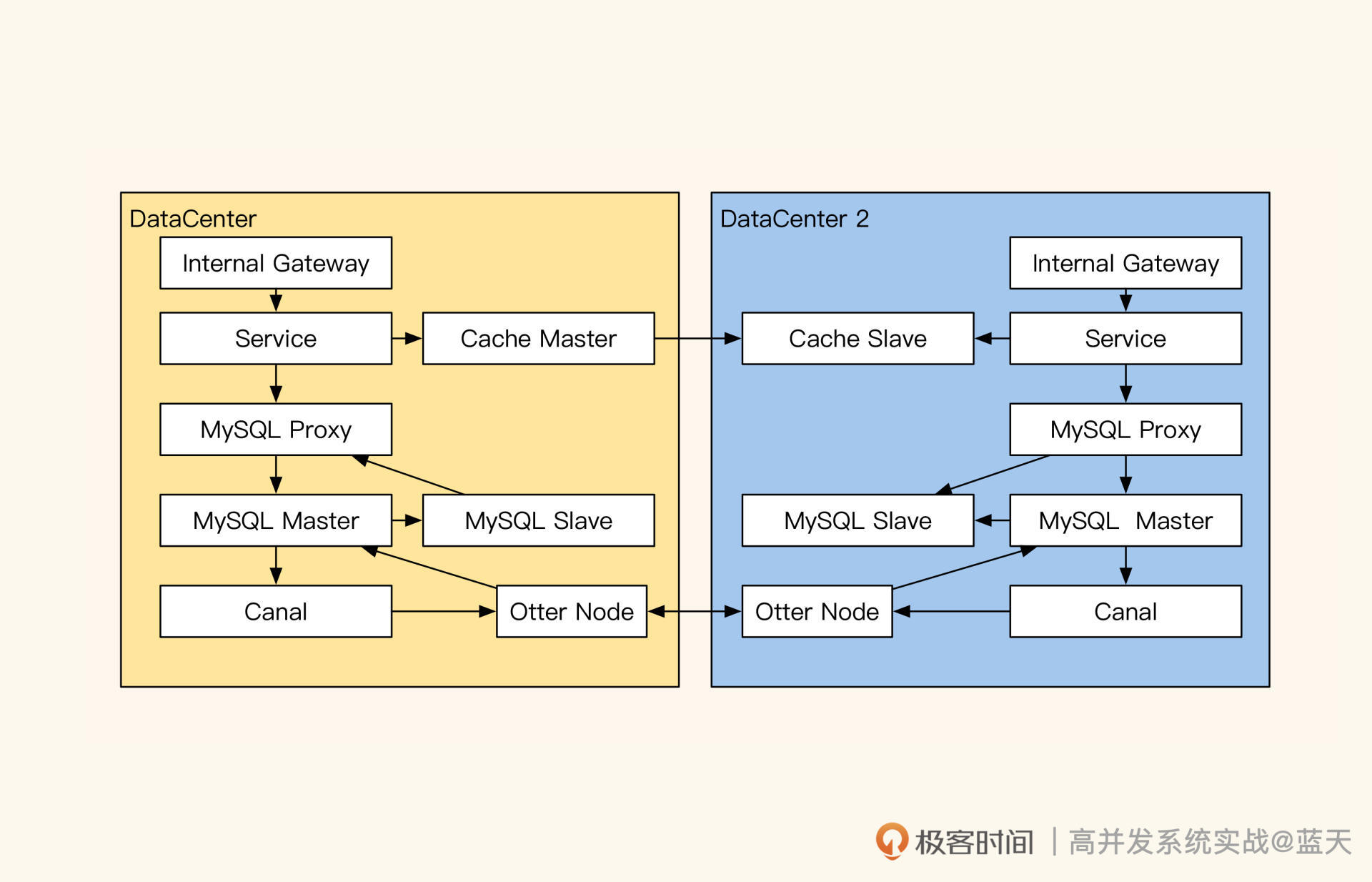

跨机房同步神器:Otter

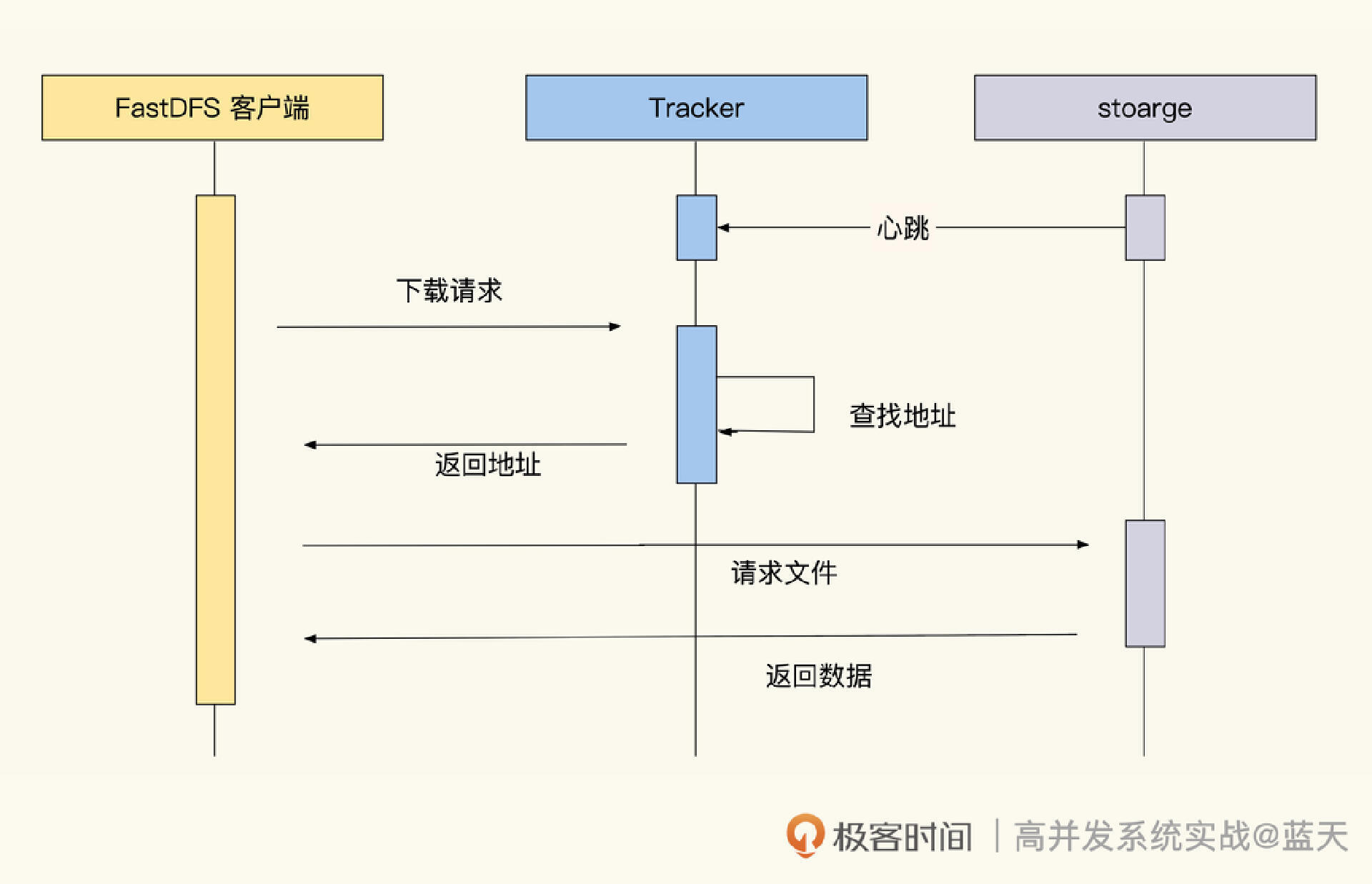

Otter 是阿里开发的数据库同步工具,它可以快速实现跨机房、跨城市、跨国家的数据同步。如下图所示,其核心实现是通过 Canal 监控主库 MySQL 的 Row binlog,将数据更新并行同步给其他机房的 MySQL。

Otter主要部署结构

因为我们要实现同城双机房双活,所以这里我们用 Otter 来实现同城双主(注意:双主不通用,不推荐一致要求高的业务使用),这样双活机房可以双向同步:

同城双活双向同步方案

如上图,每个机房内都有自己的主库和从库,缓存可以是跨机房主从,也可以是本地主从,这取决于业务形态。Otter 通过 Canal 将机房内主库的数据变更同步到 Otter Node 内,然后经由 Otter 的 SETL 整理后,再同步到对面机房的 Node 节点中,从而实现双机房之间的数据同步。

讲到这里不得不说一下,Otter 是怎么解决两个机房同时修改同一条数据所造成的冲突的。

在 Otter 中数据冲突有两种:一种是行冲突,另一种是字段冲突。行冲突可以通过对比数据修改时间来解决,或者是在冲突时回源查询覆盖目标库;对于字段冲突,我们可以根据修改时间覆盖或把多个修改动作合并,比如 a 机房 -1,b 机房 -1,合并后就是 -2,以此来实现数据的最终一致性。

但是请注意,这种合并方式并不适合库存一类的数据管理,因为这样会出现超卖现象。如果有类似需求,建议用长期缓存解决。

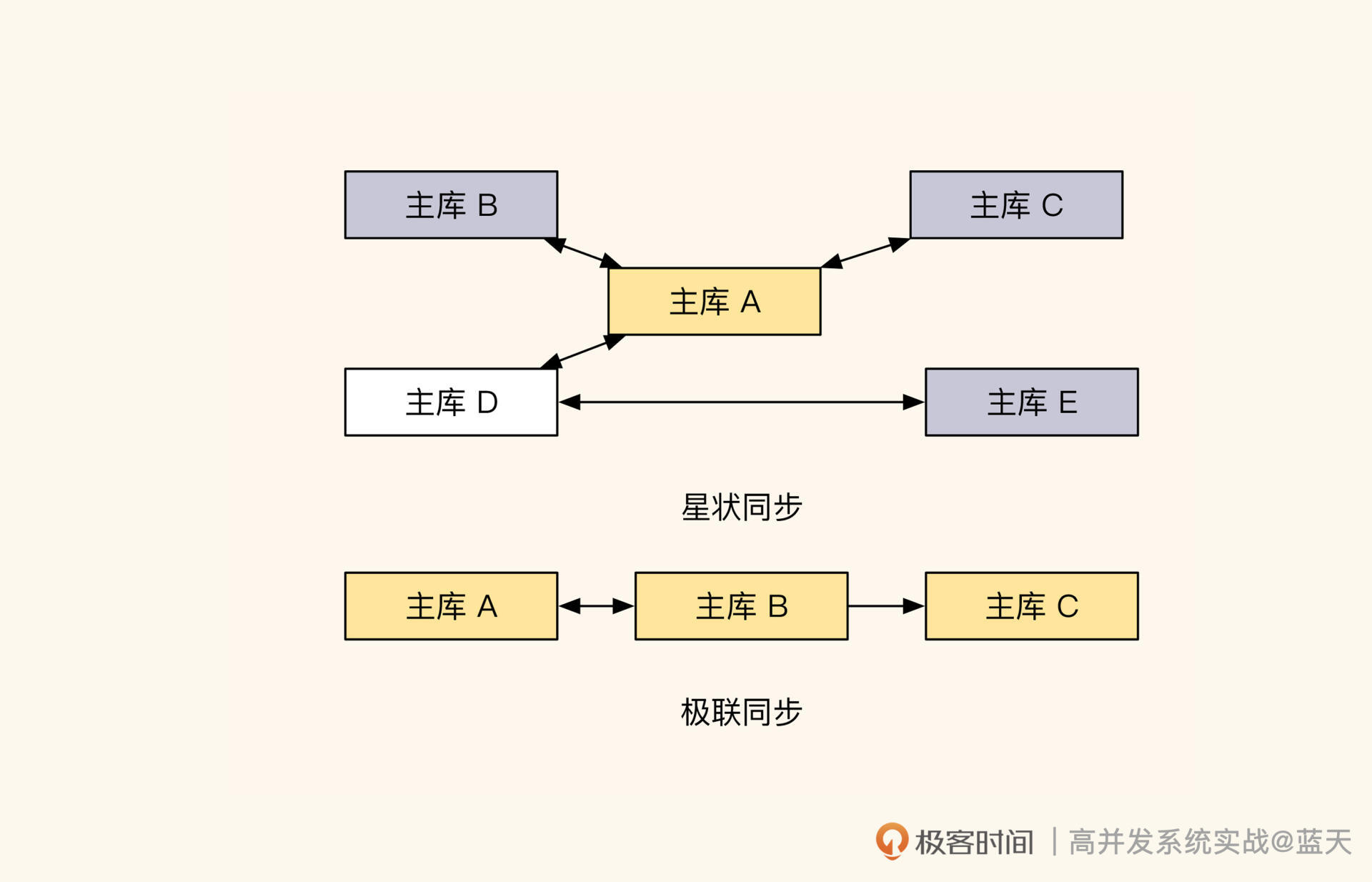

Otter 不仅能支持双主机房,还可以支持多机房同步,比如星形双向同步、级联同步(如下图)等。但是这几种方式并不实用,因为排查问题比较困难,而且当唯一决策库出现问题时,恢复起来很麻烦。所以若非必要,不推荐用这类复杂的结构。

另外,我还要强调一点,我们讲的双活双向同步方案只适合同城。一般来说,50~100 公里以内的机房同步都属于同城内。

超过这个距离的话,建议只做数据同步备份,因为同步延迟过高,业务需要在每一步关注延迟的代价过大。如果我们的业务对一致性的要求极高,那么建议在设计时,把这种一致性要求限制在同一个机房内,其他数据库只用于保存结果状态。

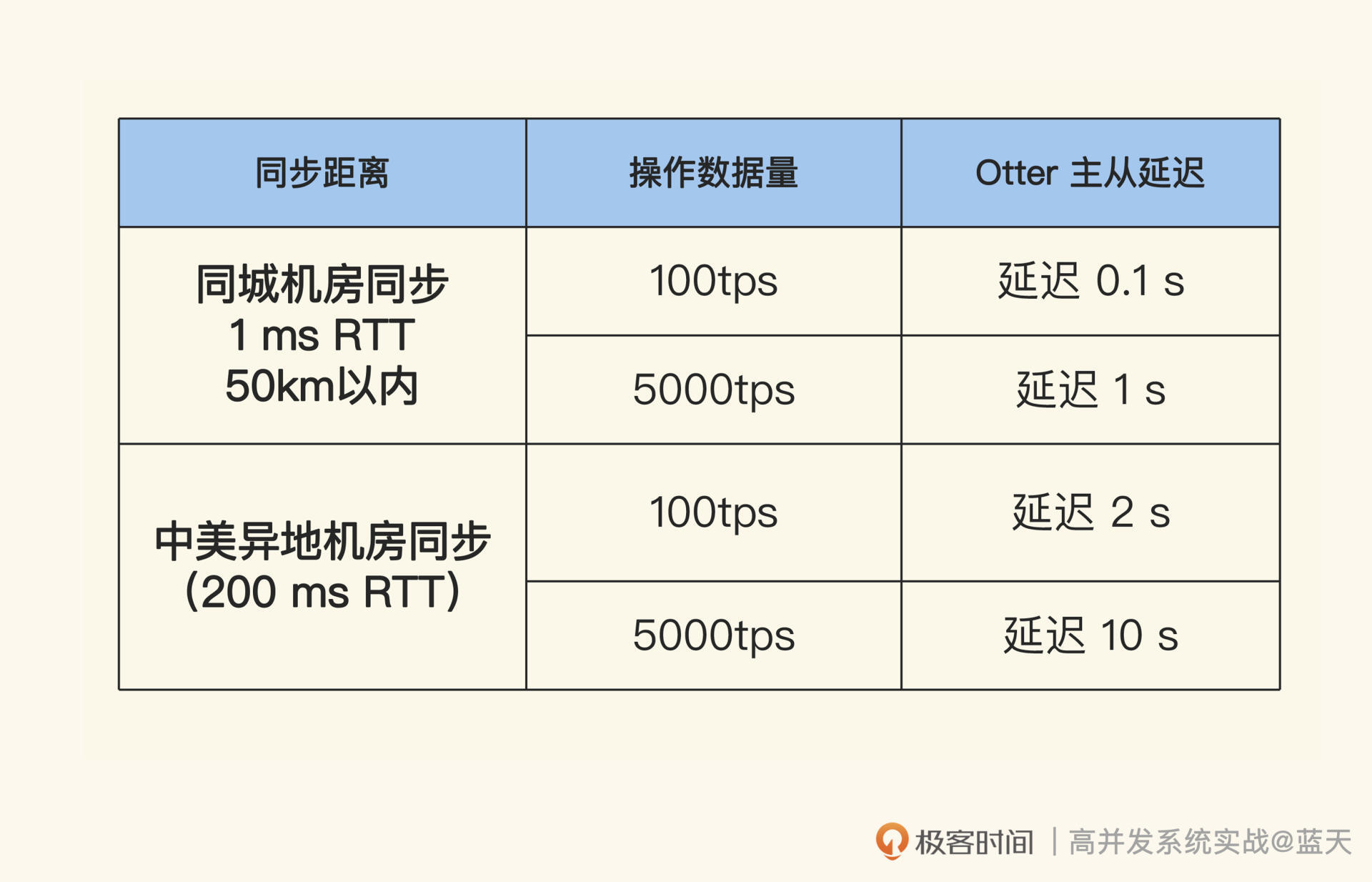

那为什么机房间的距离必须是 100 公里以内呢?你看看 Otter 对于不同距离的同步性能和延迟参考,应该就能理解了。

具体表格如下所示:

为了提高跨机房数据同步的效率,Otter 对用于主从同步的操作日志做了合并,把同一条数据的多次修改合并成了一条日志,同时对网络传输和同步策略做了滑窗并行优化。

对比 MySQL 的同步,Otter 有 5 倍的性能提升。通过上面的表格可以看到,通过 Otter 实现的数据同步并发性能好、延迟低,只要我们将用户一段时间内的请求都控制在一个机房内不频繁切换,那么相同数据的修改冲突就会少很多。

用 Otter 实现双向同步时,我们的业务不需要做太多改造就能适应双主双活机房。具体来说,业务只需要操作本地主库,把“自增主键”换成“snowflake 算法生成的主键”、“唯一索引互斥”换成“分布式互斥锁”,即可满足大部分需求。

但是要注意,采用同城双活双向同步方案时,数据更新不能过于频繁,否则会出现更大的同步延迟。当业务操作的数据量不大时,才会有更好的效果。

说到这里,我们再讲一讲 Otter 的故障切换。目前 Otter 提供了简单的主从故障切换功能,在 Manager 中点击“切换”,即可实现 Canal 和数据库的主从同步方式切换。如果是同城双活,那关于数据库操作的原有代码我们不需要做更改,因为这个同步是双向的。

当一个机房出现故障时,先将故障机房的用户流量引到正常运转的机房,待故障修复后再恢复数据同步即可,不用切换业务代码的 MySQL 主从库 IP。切记,如果双活机房有一个出现故障了,其他城市的机房只能用于备份或临时独立运行,不要跨城市做双活,因为同步延迟过高会导致业务数据损坏的后果。

最后,我再啰嗦一下使用 Otter 的注意事项:第一,为了保证数据的完整性,变更表结构时,我们一般会先从从库修改表结构,因此在设置 Otter 同步时,建议将 pipeline 同步设置为忽略 DDL 同步错误;第二,数据库表新增字段时,只能在表结尾新增,不能删除老字段,并且建议先把新增字段同步到目标库,然后再同步到主库,因为只有这样才不会丢数据;第三,双向同步的表在新增字段时不要有默认值,同时 Otter 不支持没有主键的表同步。

总结

机房之间的数据同步一直是行业里的痛,因为高昂的实现代价,如果不能做到双活,总是会有一个 1:1 机器数量的机房在空跑,而且发生故障时,没有人能保证冷备机房可以马上对外服务。

但是双活模式的维护成本也不低,机房之间的数据同步常常会因为网络延迟或数据冲突而停止,最终导致两个机房的数据不一致。好在 Otter 对数据同步做了很多措施,能在大多数情况下保证数据的完整性,并且降低了同城双活的实现难度。

即使如此,在业务的运转过程中,我们仍然需要人工梳理业务,避免多个机房同时修改同一条数据。对此,我们可以通过 HttpDNS 调度,让一个用户在某一段时间内只在一个机房内活跃,这样可以降低数据冲突的情况。

而对于修改频繁、争抢较高的服务,一般都会在机房本地做整体事务执行,杜绝跨机房同时修改导致同步错误的发生。

共识Raft:如何保证多机房数据的一致性?

如果机房 A 对某一条数据做了更改,B 机房同时修改,Otter 会用合并逻辑对冲突的数据行或字段做合并。为了避免类似问题,我们在上节课对客户端做了要求:用户客户端在一段时间内只能访问一个机房。

但如果业务对“事务 + 强一致”的要求极高,比如库存不允许超卖,那我们通常只有两种选择:一种是将服务做成本地服务,但这个方式并不适合所有业务;另一种是采用多机房,但需要用分布式强一致算法保证多个副本的一致性。

在行业里,最知名的分布式强一致算法要属 Paxos,但它的原理过于抽象,在使用过程中经过多次修改会和原设计产生很大偏离,这让很多人不确定自己的修改是不是合理的。而且,很多人需要一到两年的实践经验才能彻底掌握这个算法。

随着我们对分布式多副本同步的需求增多,过于笼统的 Paxos 已经不能满足市场需要,于是,Raft 算法诞生了。相比 Paxos,Raft 不仅更容易理解,还能保证数据操作的顺序,因此在分布式数据服务中被广泛使用,像 etcd、Kafka 这些知名的基础组件都是用 Raft 算法实现的。

那今天这节课我们就来探寻一下 Raft 的实现原理,可以说了解了 Raft,就相当于了解了分布式强一致性数据服务的半壁江山。几乎所有关于多个数据服务节点的选举、数据更新和同步都是采用类似的方式实现的,只是针对不同的场景和应用做了一些调整。

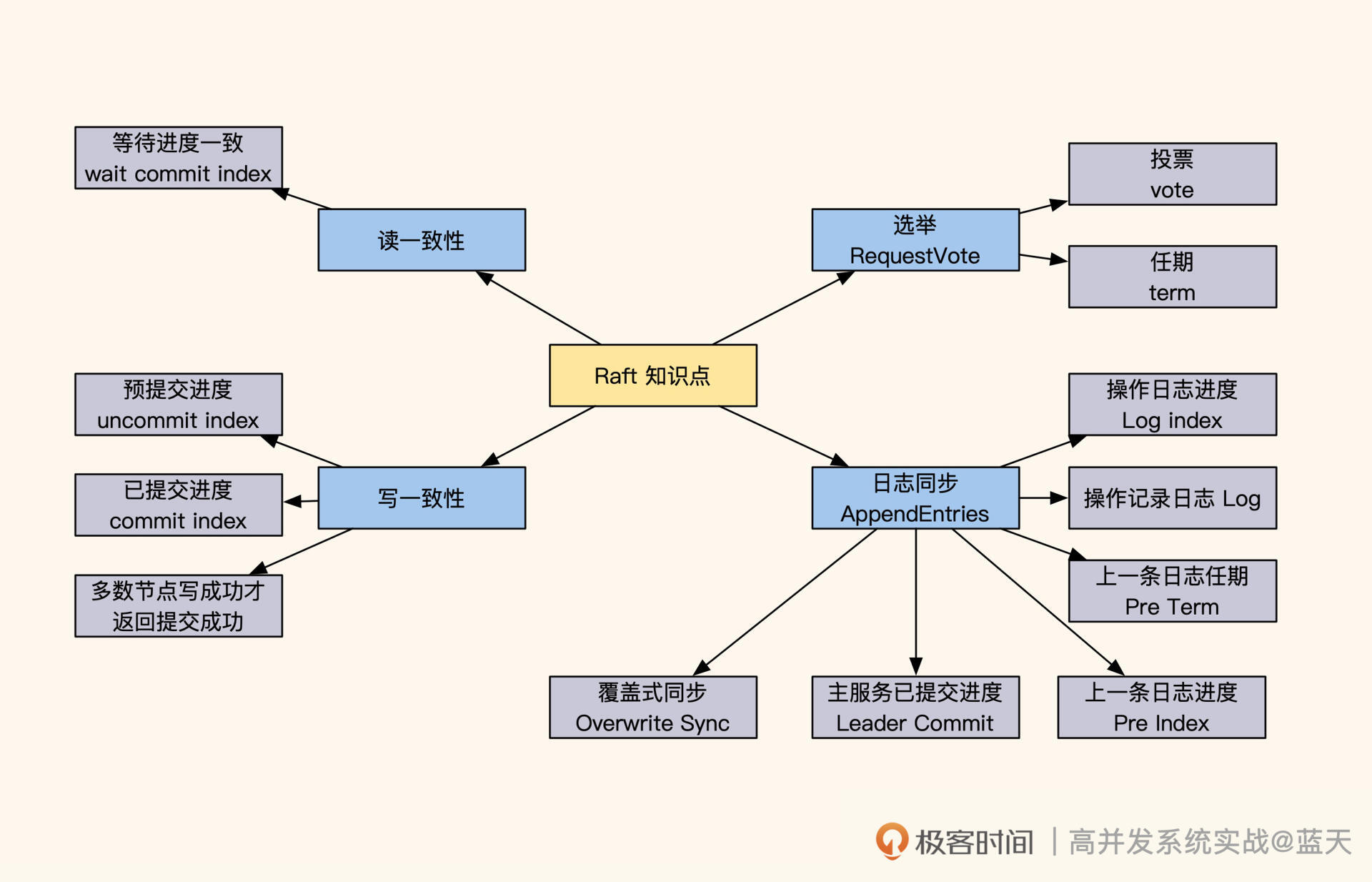

如何选举 Leader?

为了帮你快速熟悉 Raft 的实现原理,下面我会基于 Raft 官方的例子,对 Raft 进行讲解。

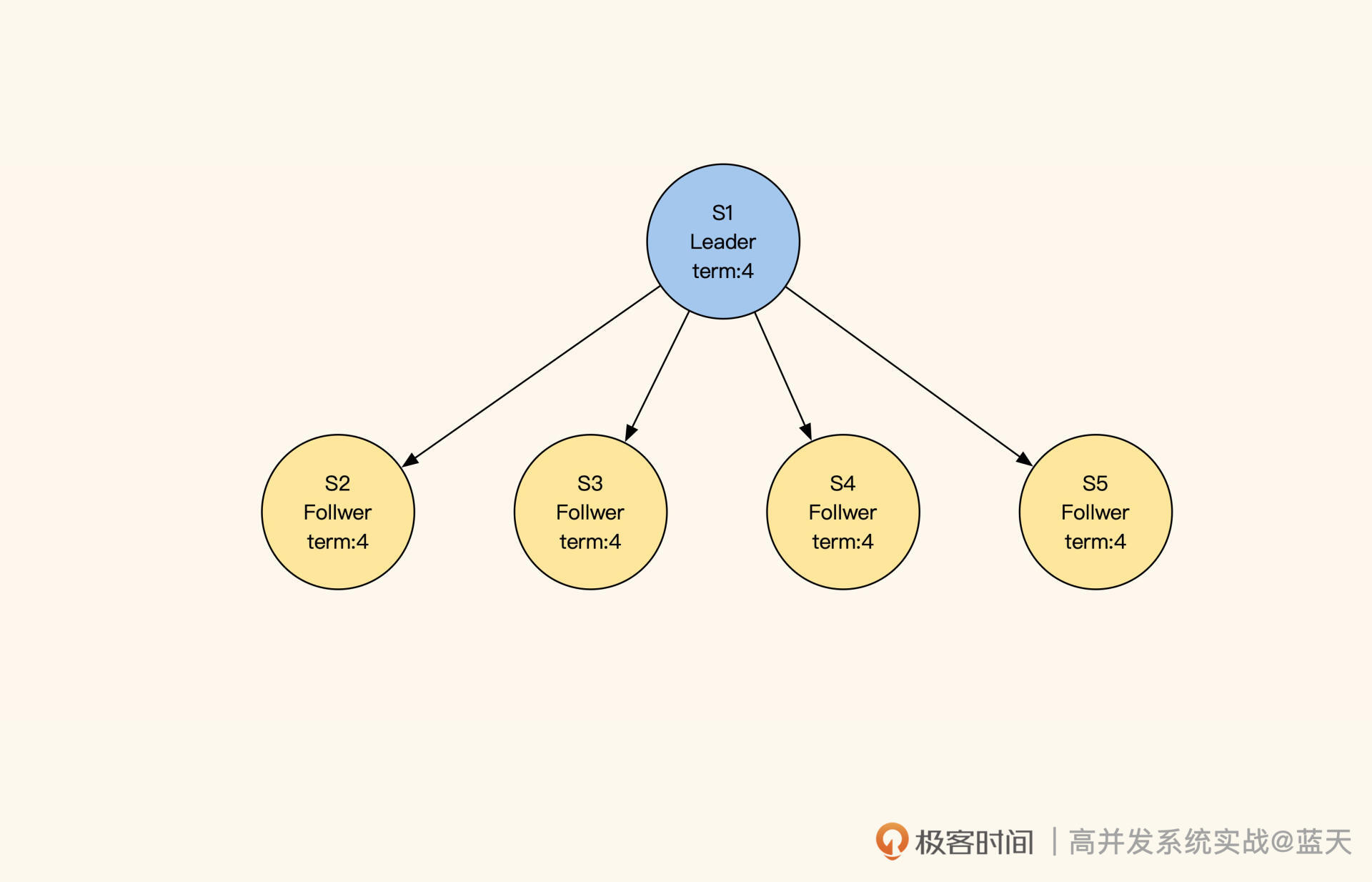

Raft服务状态角色、调用关系、日志

如图所示,我们启动五个 Raft 分布式数据服务:S1、S2、S3、S4、S5,每个节点都有以下三种状态:

- Leader:负责数据修改,主动同步修改变更给 Follower;

- Follower:接收 Leader 推送的变更数据;

- Candidate:集群中如果没有 Leader,那么进入选举模式。

如果集群中的 Follower 节点在指定时间内没有收到 Leader 的心跳,那就代表 Leader 损坏,集群无法更新数据。这时候 Follower 会进入选举模式,在多个 Follower 中选出一个 Leader,保证一组服务中一直存在一个 Leader,同时确保数据修改拥有唯一的决策进程。

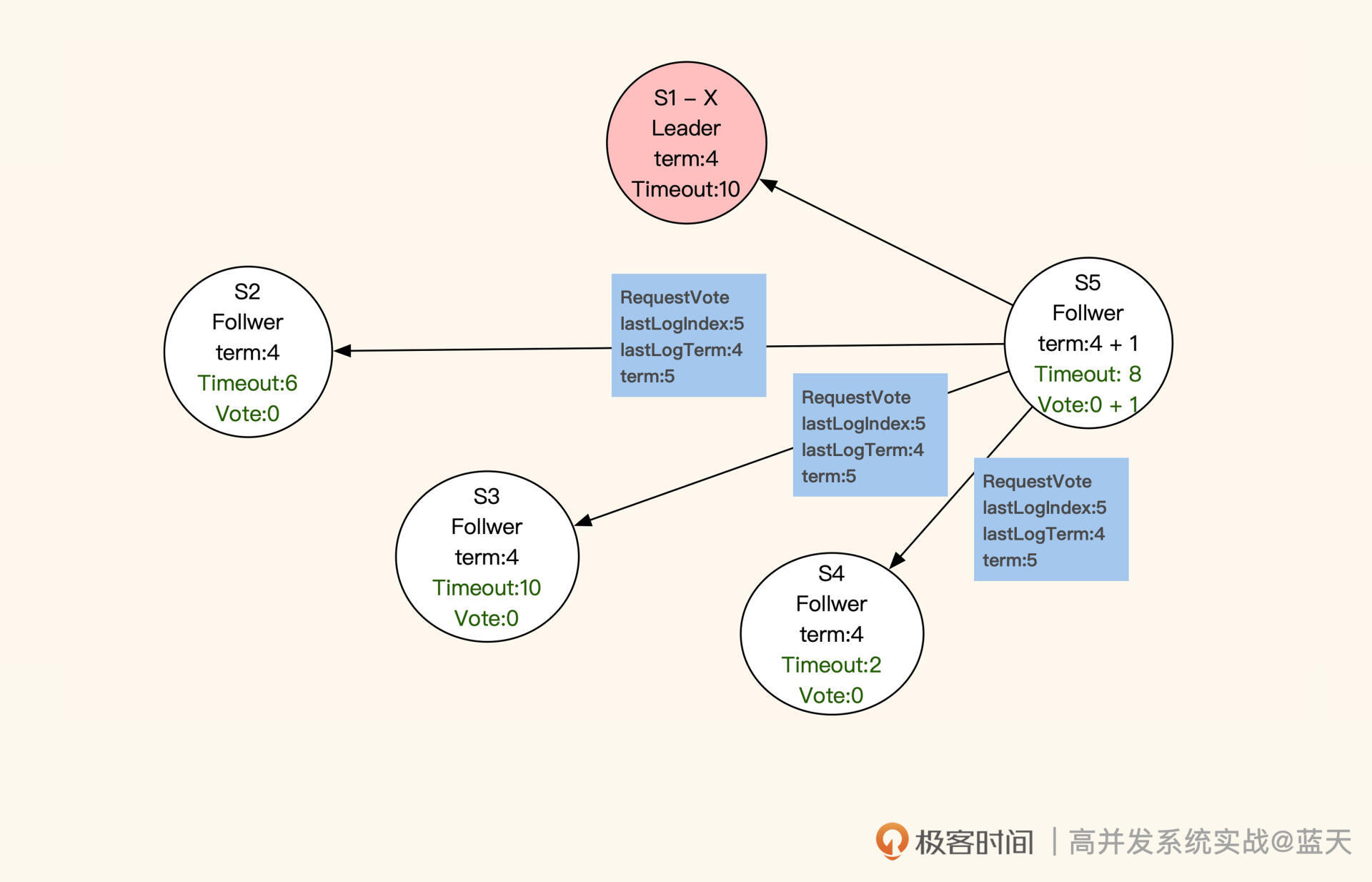

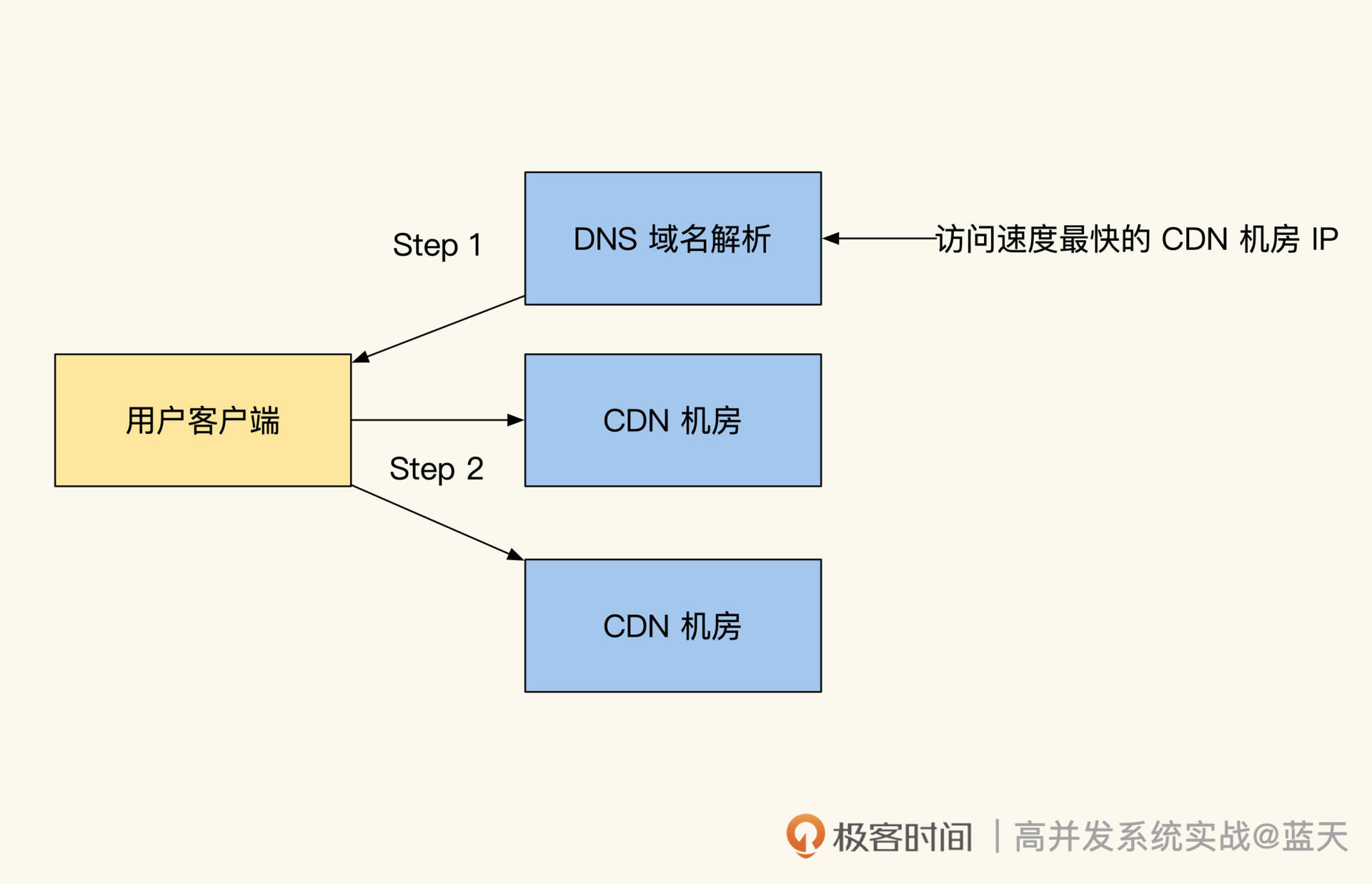

那 Leader 服务是如何选举出来的呢?进入选举模式后,这 5 个服务会随机等待一段时间。等待时间一到,当前服务先投自己一票,并对当前的任期“term”加 1 (上图中 term:4 就代表第四任 Leader),然后对其他服务发送 RequestVote RPC(即请求投票)进行拉票。

S1失去联系,S5最先超时发起选举

收到投票申请的服务,并且申请服务(即“发送投票申请的服务”)的任期和同步进度都比它超前或相同,那么它就会投申请服务一票,并把当前的任期更新成最新的任期。同时,这个收到投票申请的服务不再发起投票,会等待其他服务邀请。

注意,每个服务在同一任期内只投票一次。如果所有服务都没有获取到多数票(三分之二以上服务节点的投票),就会等当前选举超时后,对任期加 1,再次进行选举。最终,获取多数票且最先结束选举倒计时的服务会被选为 Leader。

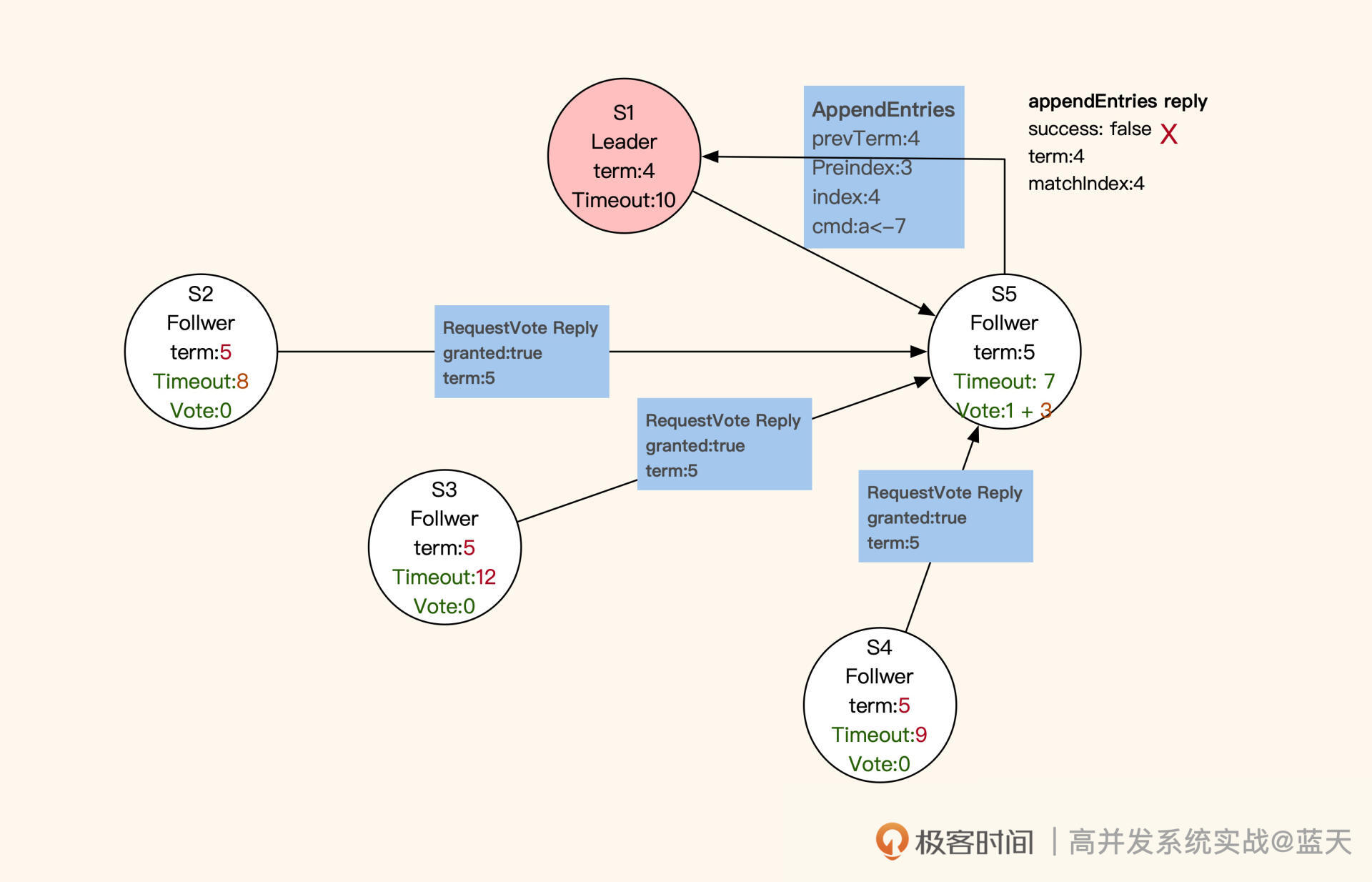

被选为 Leader 的服务会发布广播通知其他服务,并向其他服务同步新的任期和其进度情况。同时,新任 Leader 会在任职期间周期性发送心跳,保证各个子服务(Follwer)不会因为超时而切换到选举模式。在选举期间,若有服务收到上一任 Leader 的心跳,则会拒绝(如下图 S1)。

投票结果返回

选举结束后,所有服务都进入数据同步状态。

如何保证多副本写一致?

在数据同步期间,Follower 会与 Leader 的日志完全保持一致。不难看出,Raft 算法采用的也是主从方式同步,只不过 Leader 不是固定的服务,而是被选举出来的。

这样当个别节点出现故障时,是不会影响整体服务的。不过,这种机制也有缺点:如果 Leader 失联,那么整体服务会有一段时间忙于选举,而无法提供数据服务。

通常来说,客户端的数据修改请求都会发送到 Leader 节点(如下图 S1)进行统一决策,如果客户端请求发送到了 Follower,Follower 就会将请求重定向到 Leader。那么,Raft 是怎么实现同分区数据备份副本的强一致性呢?

多副本同步

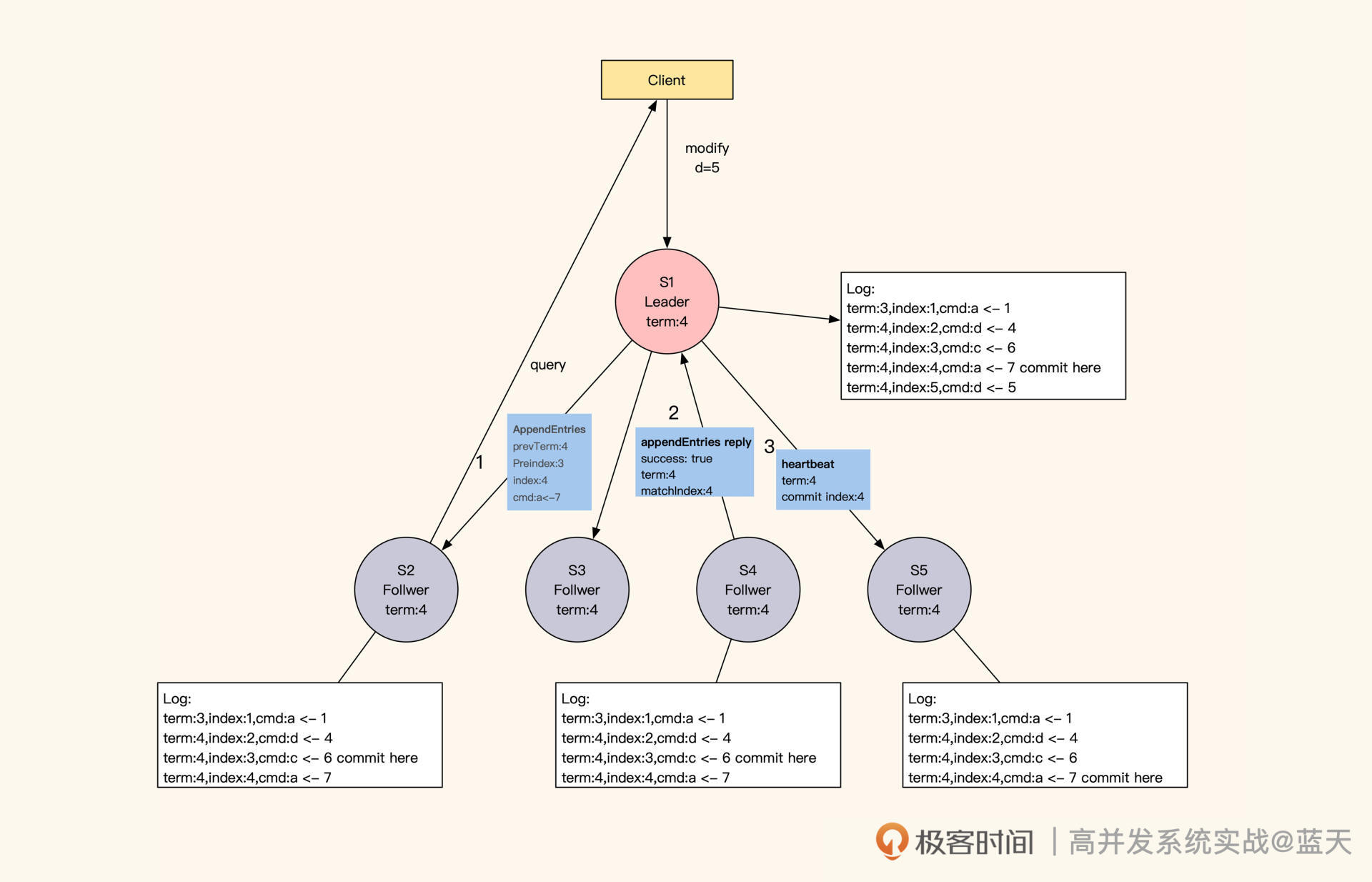

具体来讲,Leader 成功修改数据后,会产生对应的日志,然后 Leader 会给所有 Follower 发送单条日志同步信息。只要大多数 Follower 返回同步成功,Leader 就会对预提交的日志进行 commit,并向客户端返回修改成功。

接着,Leader 在下一次心跳时(消息中 leader commit 字段),会把当前最新 commit 的 Log index(日志进度)告知给各 Follower 节点,然后各 Follower 按照这个 index 进度对外提供数据,未被 Leader 最终 commit 的数据则不会落地对外展示。

如果在数据同步期间,客户端还有其他的数据修改请求发到 Leader,那么这些请求会排队,因为这时候的 Leader 在阻塞等待其他节点回应。

通过日志同步,同时同步Follower目前Leader 的commit index

不过,这种阻塞等待的设计也让 Raft 算法对网络性能的依赖很大,因为每次修改都要并发请求多个节点,等待大部分节点成功同步的结果。

最惨的情况是,返回的 RTT 会按照最慢的网络服务响应耗时(“两地三中心”的一次同步时间为 100ms 左右),再加上主节点只有一个,一组 Raft 的服务性能是有上限的。对此,我们可以减少数据量并对数据做切片,提高整体集群的数据修改性能。

请你注意,当大多数 Follower 与 Leader 同步的日志进度差异过大时,数据变更请求会处于等待状态,直到一半以上的 Follower 与 Leader 的进度一致,才会返回变更成功。当然,这种情况比较少见。

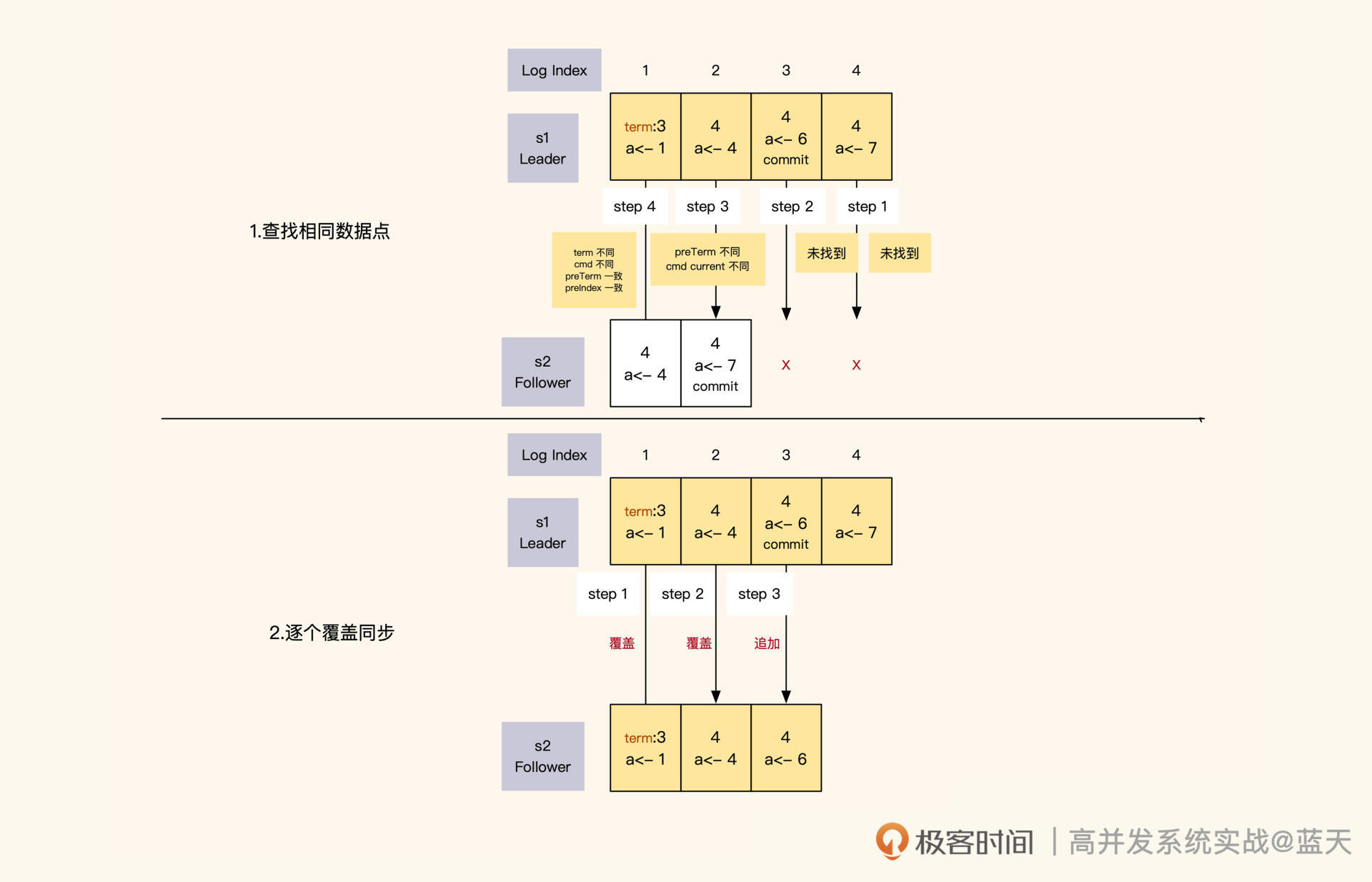

服务之间如何同步日志进度?

讲到这我们不难看出,在 Raft 的数据同步机制中,日志发挥着重要的作用。在同步数据时,Raft 采用的日志是一个有顺序的指令日志 WAL(Write Ahead Log),类似 MySQL 的 binlog。该日志中记录着每次修改数据的指令和修改任期,并通过 Log Index 标注了当前是第几条日志,以此作为同步进度的依据。

日志格式

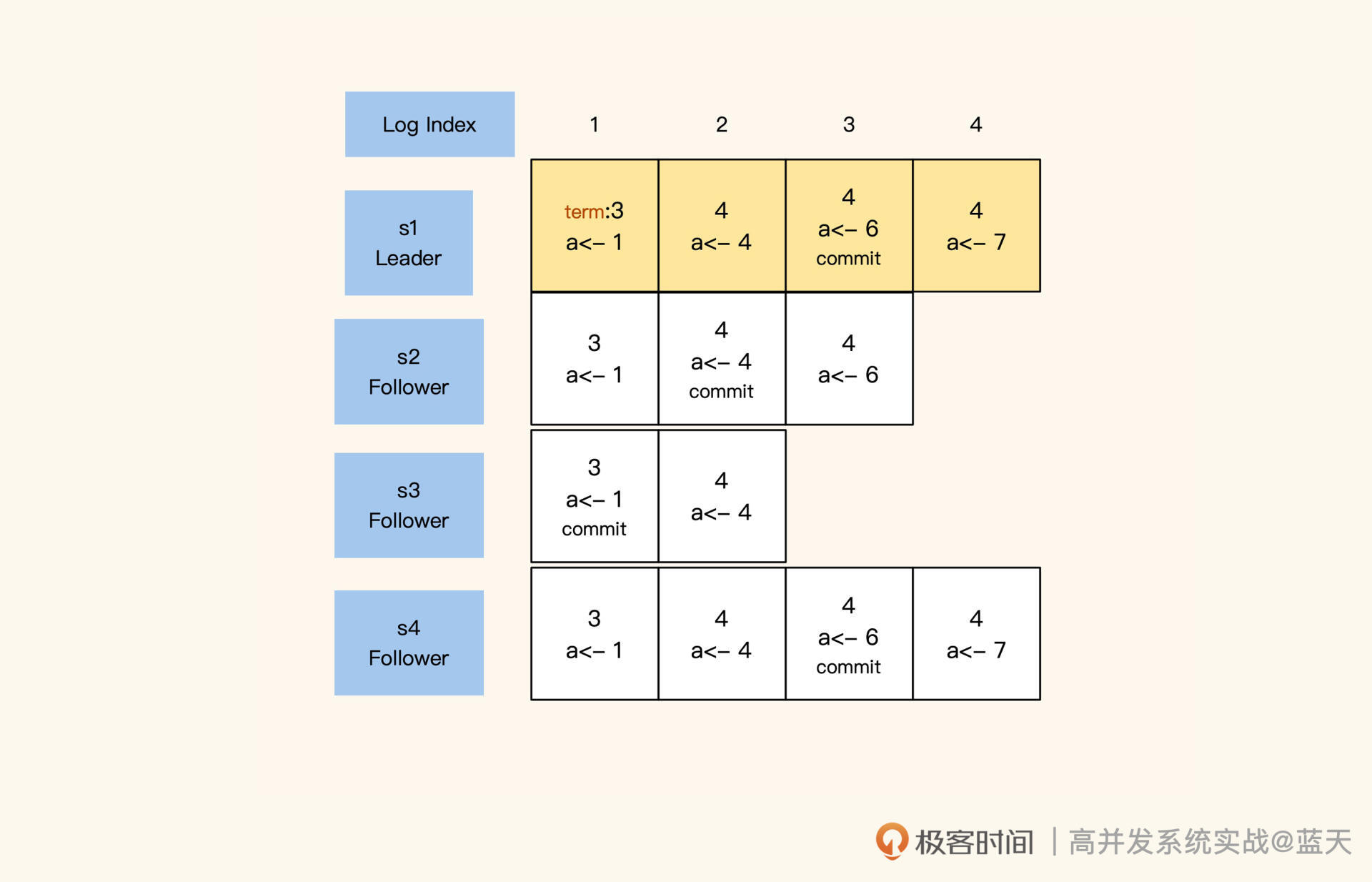

其中,Leader 的日志永远不会删除,所有的 Follower 都会保持和 Leader 完全一致,如果存在差异也会被强制覆盖。同时,每个日志都有“写入”和“commit”两个阶段,在选举时,每个服务会根据还未 commit 的 Log Index 进度,优先选择同步进度最大的节点,以此保证选举出的 Leader 拥有最新最全的数据。

Leader 在任期内向各节点发送同步请求,其实就是按顺序向各节点推送一条条日志。如果 Leader 同步的进度比 Follower 超前,Follower 就会拒绝本次同步。

Leader 收到拒绝后,会从后往前一条条找出日志中还未同步的部分或者有差异的部分,然后开始一个个往后覆盖实现同步。

第一阶段找到共同进度点,第二阶段覆盖+追加同步进度

Leader 和 Follower 的日志同步进度是通过日志 index 来确认的。Leader 对日志内容和顺序有绝对的决策权,当它发现自己的日志和 Follower 的日志有差异时,为了确保多个副本的数据是完全一致的,它会强制覆盖 Follower 的日志。

那么 Leader 是怎么识别出 Follower 的日志与自己的日志有没有差异呢?实际上,Leader 给 Follower 同步日志的时候,会同时带上 Leader 上一条日志的任期和索引号,与 Follower 当前的同步进度进行对比。

对比分为两个方面:一方面是对比 Leader 和 Follower 当前日志中的 index、多条操作日志和任期;另一方面是对比 Leader 和 Follower 上一条日志的 index 和任期。

如果有任意一个不同,那么 Leader 就认为 Follower 的日志与自己的日志不一致,这时候 Leader 会一条条倒序往回对比,直到找到日志内容和任期完全一致的 index,然后从这个 index 开始正序向下覆盖。同时,在日志数据同步期间,Leader 只会 commit 其所在任期内的数据,过往任期的数据完全靠日志同步倒序追回。

你应该已经发现了,这样一条条推送同步有些缓慢,效率不高,这导致 Raft 对新启动的服务不是很友好。所以 Leader 会定期打快照,通过快照合并之前修改日志的记录,来降低修改日志的大小。而同步进度差距过大的 Follower 会从 Leader 最新的快照中恢复数据,按快照最后的 index 追赶进度。

如何保证读取数据的强一致性?

通过前面的讲解,我们知道了 Leader 和 Follower 之间是如何做到数据同步的,那从 Follower 的角度来看,它又是怎么保证自己对外提供的数据是最新的呢?

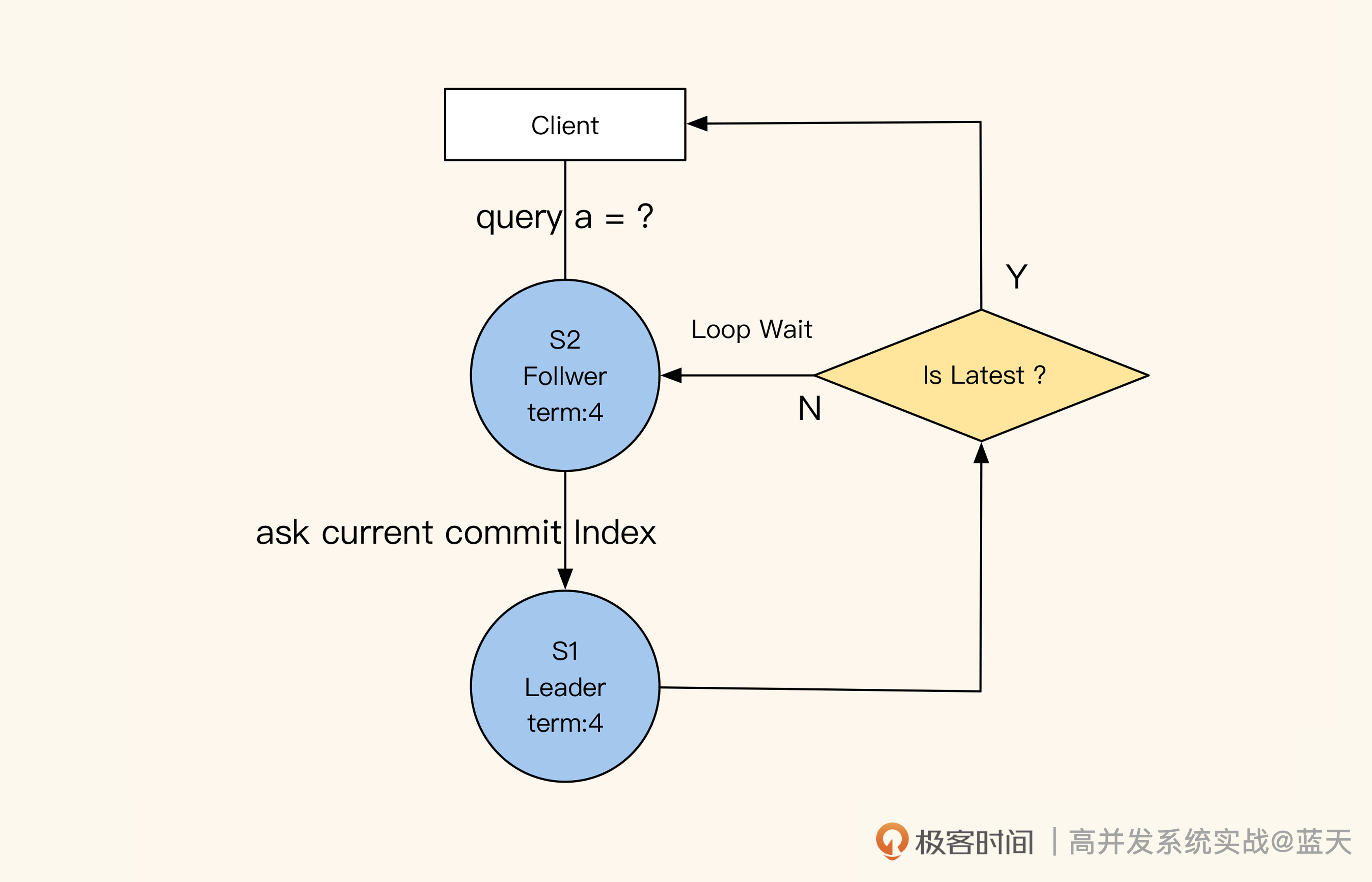

这里有个小技巧,就是 Follower 在收到查询请求时,会顺便问一下 Leader 当前最新 commit 的 log index 是什么。如果这个 log index 大于当前 Follower 同步的进度,就说明 Follower 的本地数据不是最新的,这时候 Follower 就会从 Leader 获取最新的数据返回给客户端。可见,保证数据强一致性的代价很大。

Follower保持与Leader进度一致的方式,保证读到的数据和Leader强一致

你可能会好奇:如何在业务使用时保证读取数据的强一致性呢?其实我们之前说的 Raft 同步等待 Leader commit log index 的机制,已经确保了这一点。我们只需要向 Leader 正常提交数据修改的操作,Follower 读取时拿到的就一定是最新的数据。

总结

很多人都说 Raft 是一个分布式一致性算法,但实际上 Raft 算法是一个共识算法(多个节点达成共识),它通过任期机制、随机时间和投票选举机制,实现了服务动态扩容及服务的高可用。

通过 Raft 采用强制顺序的日志同步实现多副本的数据强一致同步,如果我们用 Raft 算法实现用户的数据存储层,那么数据的存储和增删改查,都会具有跨机房的数据强一致性。这样一来,业务层就无需关心一致性问题,对数据直接操作,即可轻松实现多机房的强一致同步。

由于这种方式的同步代价和延迟都比较大,建议你尽量在数据量和修改量都比较小的场景内使用,行业里也有很多针对不同场景设计的库可以选择,如:parallel-raft、multi-paxos、SOFAJRaft 等,更多请参考 Raft 的底部开源列表。

电商系统:强一致性系统如何改造

领域拆分:如何合理地拆分系统?

一般来说,强一致性的系统都会牵扯到“锁争抢”等技术点,有较大的性能瓶颈,而电商时常做秒杀活动,这对系统的要求更高。业内在对电商系统做改造时,通常会从三个方面入手:系统拆分、库存争抢优化、系统隔离优化。

今天这节课我们先来热个身,学习一些系统拆分的技巧。我们知道,电商系统有很多功能需要保持数据的强一致性,我们一般会用锁确保同一时间只有一个线程在修改。

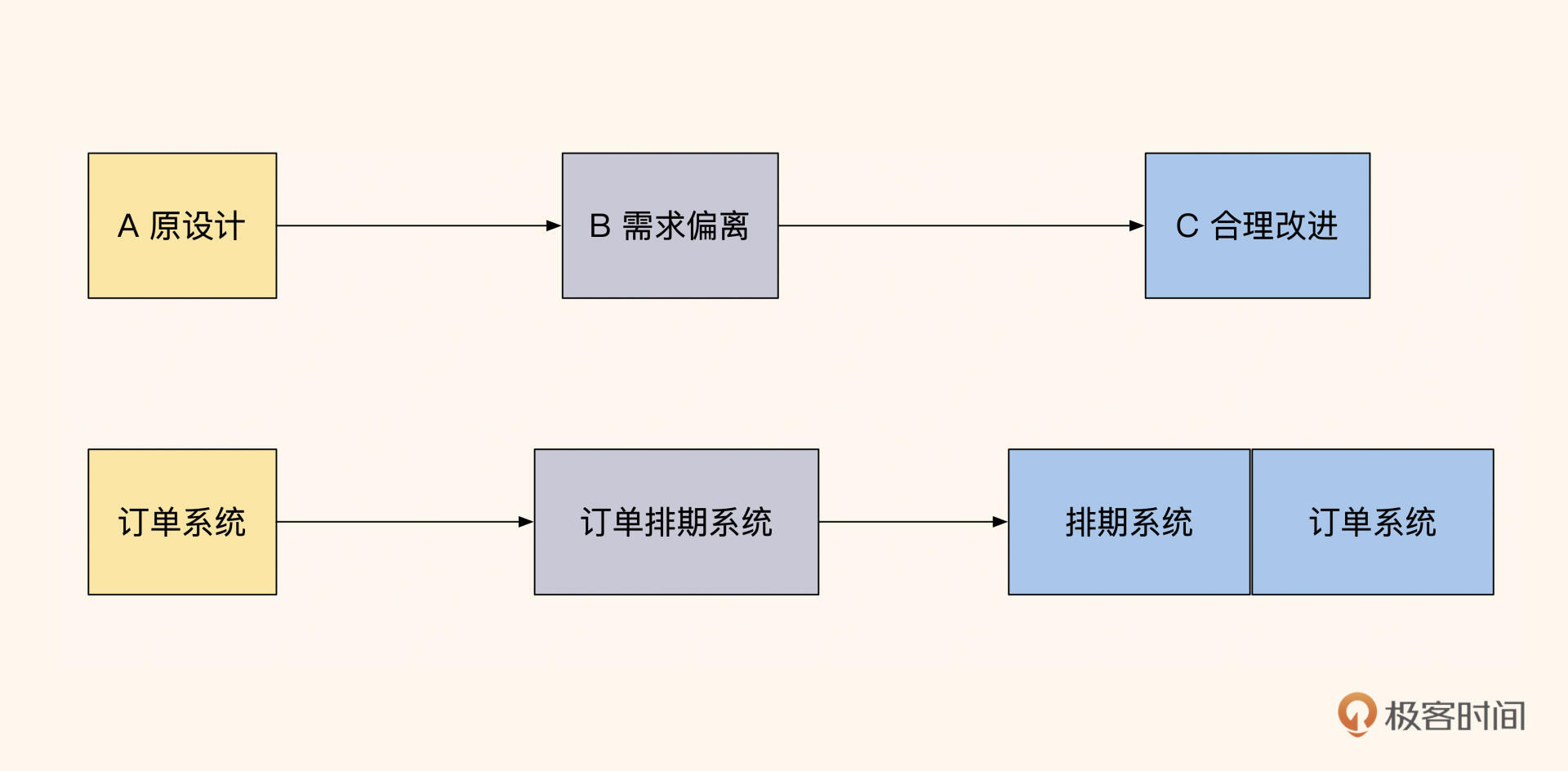

但这种方式会让业务处理的并行效率很低,还很容易影响系统的性能。再加上这类系统经常有各种个性活动需求,相关功能支撑需要不断更新迭代,而这些变更往往会导致系统脱离原来的设计初衷,所以在开发新需求的同时,我们要对系统定期做拆分整理,避免系统越跑越偏。这时候,如何根据业务合理地拆分系统就非常重要了。

案例背景

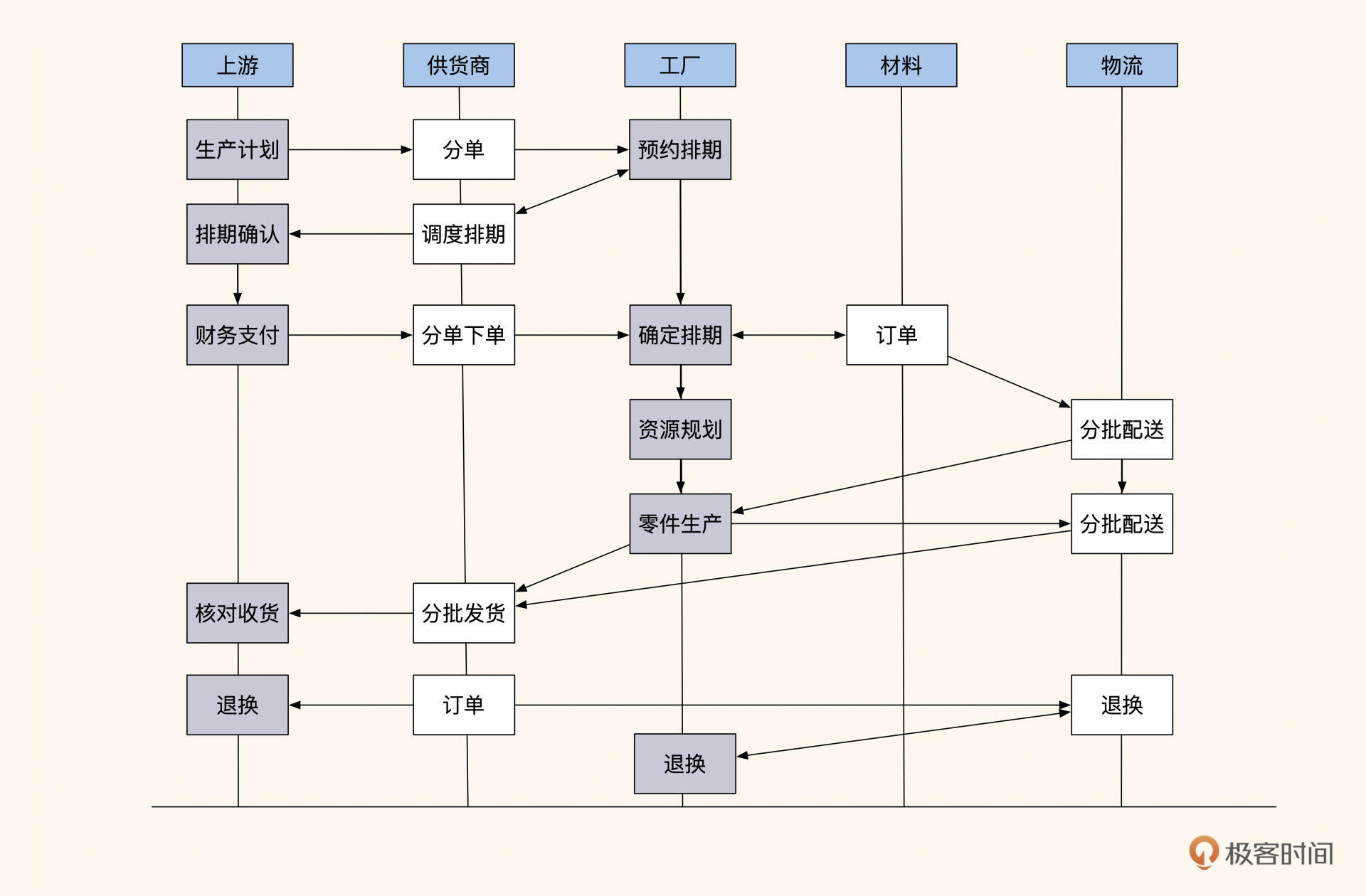

他们是某行业知名电商的供货商,供应链比较长,而且供应品类和规格复杂。为确保生产计划平滑运转,系统还需要调配多个子工厂和材料商的生产排期。

原本调配订单需要电话沟通,但这样太过随机。为了保证生产链稳定供货,同时提高协调效率,朋友基于订单预订系统增加了排期协商功能,具体就是将 “排期” 作为下订单主流程里的一个步骤,并将协商出的排期按照日历样式来展示,方便上游供应商和各个工厂以此协调生产周期。

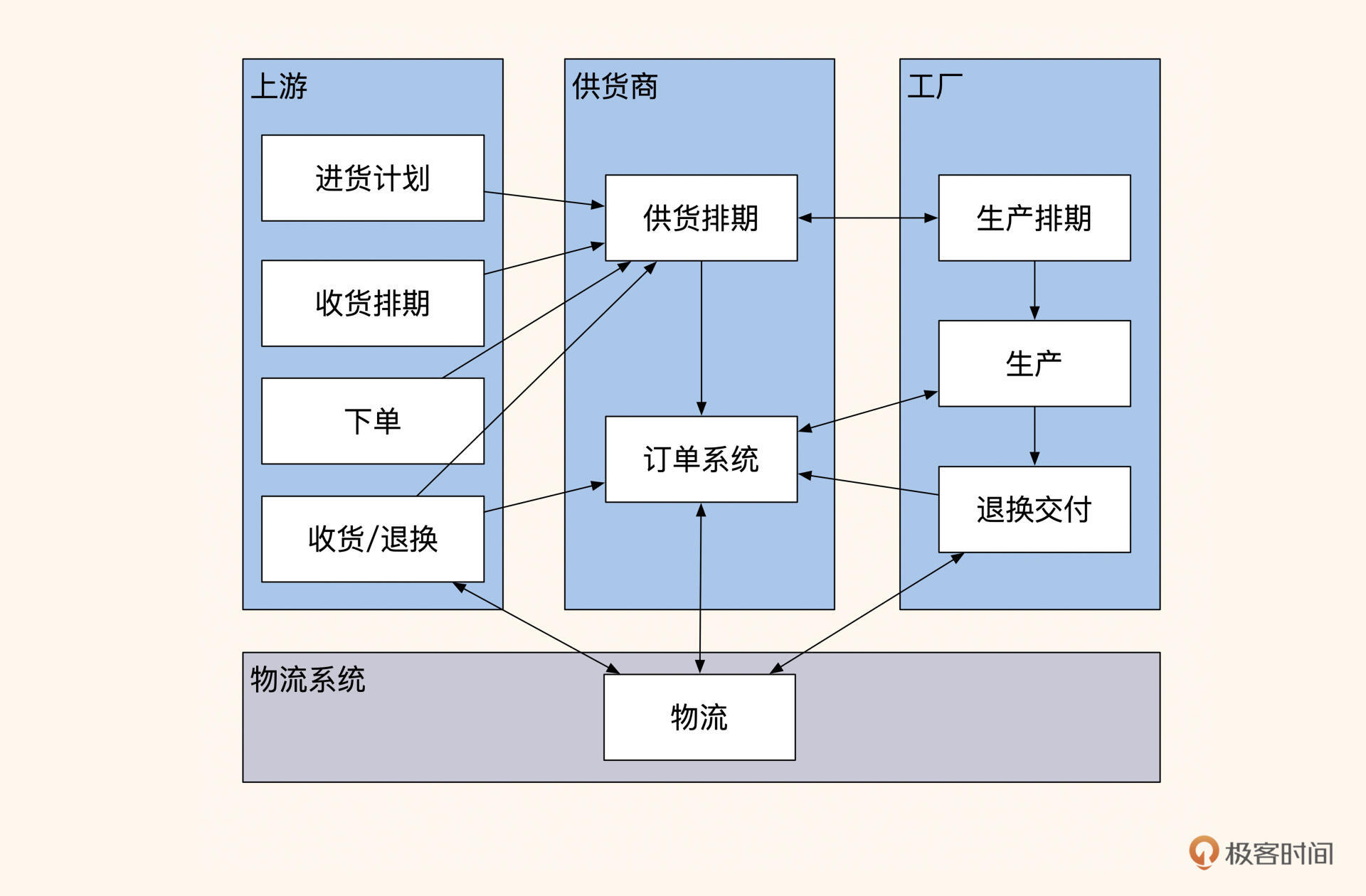

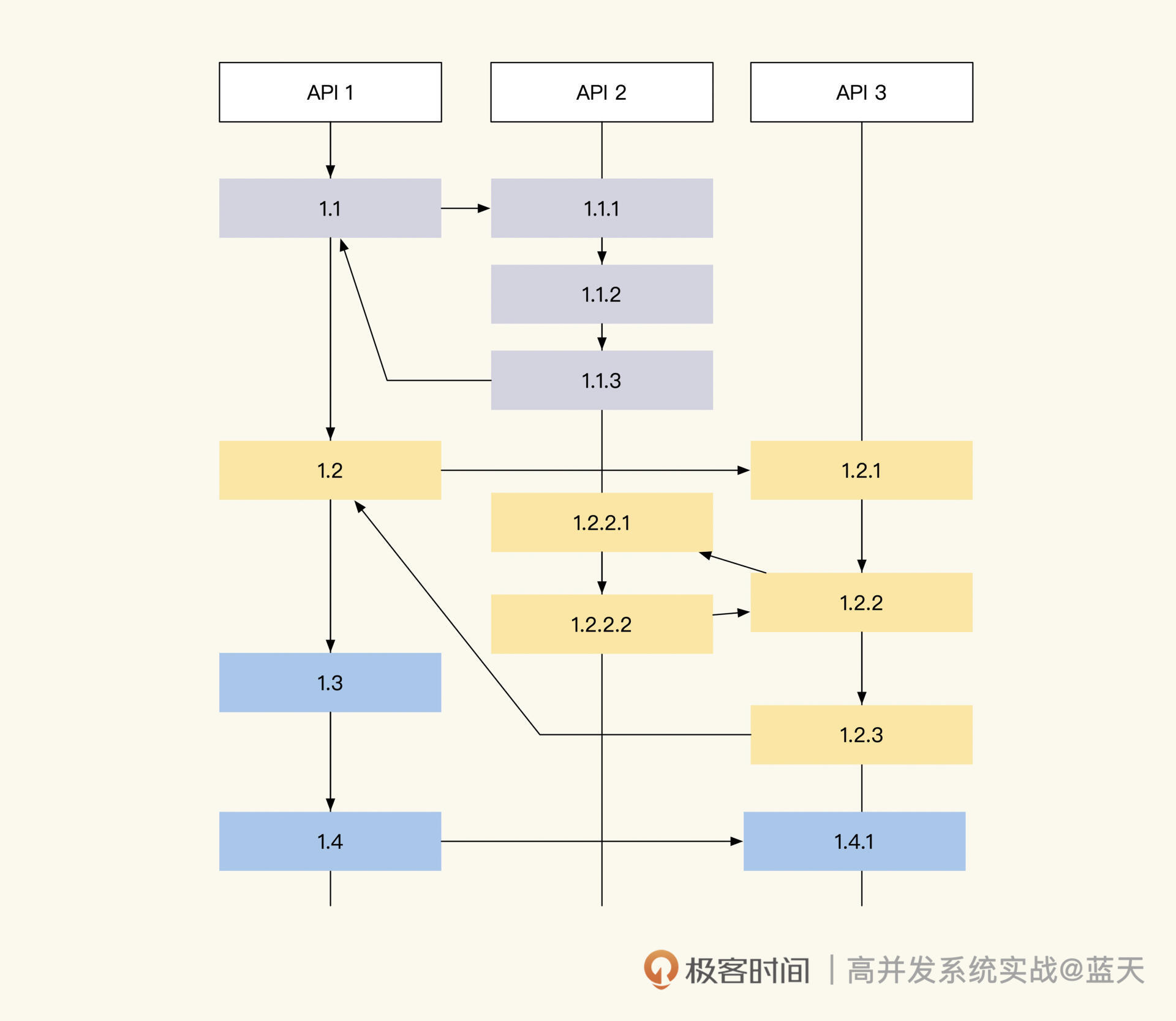

整个供货协商流程如下图所示:

图1:供货商供货协商流程

如图,上游项目会先发布生产计划(或采购计划),供货商根据计划拆分采购列表(分单),并联系不同的工厂协调做预排期(预约排期)。之后,上游采购方对工厂产品进行质量审核,然后下单支付、确认排期。

工厂根据确认好的排期制定采购材料计划,并通知材料供货商分批供货,开始分批生产制造产品。每当制造好一批产品后,工厂就会通知物流按批次发货到采购方(即供货商),同时更新供货商系统内的分批订单信息。接着,上游对产品进行验收,将不合格的产品走退换流程。

但系统运行了一段时间后朋友发现,由于之前系统是以订单为主体的,增加排期功能后还是以主订单作为聚合根(即主要实体),这就导致上游在发布计划时需要创建主订单。

而主订单一直处于开启状态,随着排期不断调整和新排期的不断加入,订单数据就会持续增加,一年内订单数据量达到了一亿多条。因为数据过多、合作周期长,并且包含了售后环节,所以这些数据无法根据时间做归档,导致整个系统变得越来越慢。

考虑到这是核心业务,如果持续存在问题影响巨大,因此朋友找我取经,请教如何对数据进行分表拆分。但根据我的理解,这不是分表分库维护的问题,而是系统功能设计不合理导致了系统臃肿。于是经过沟通,我们决定对系统订单系统做一次领域拆分。流程分析整理。

流程分析整理

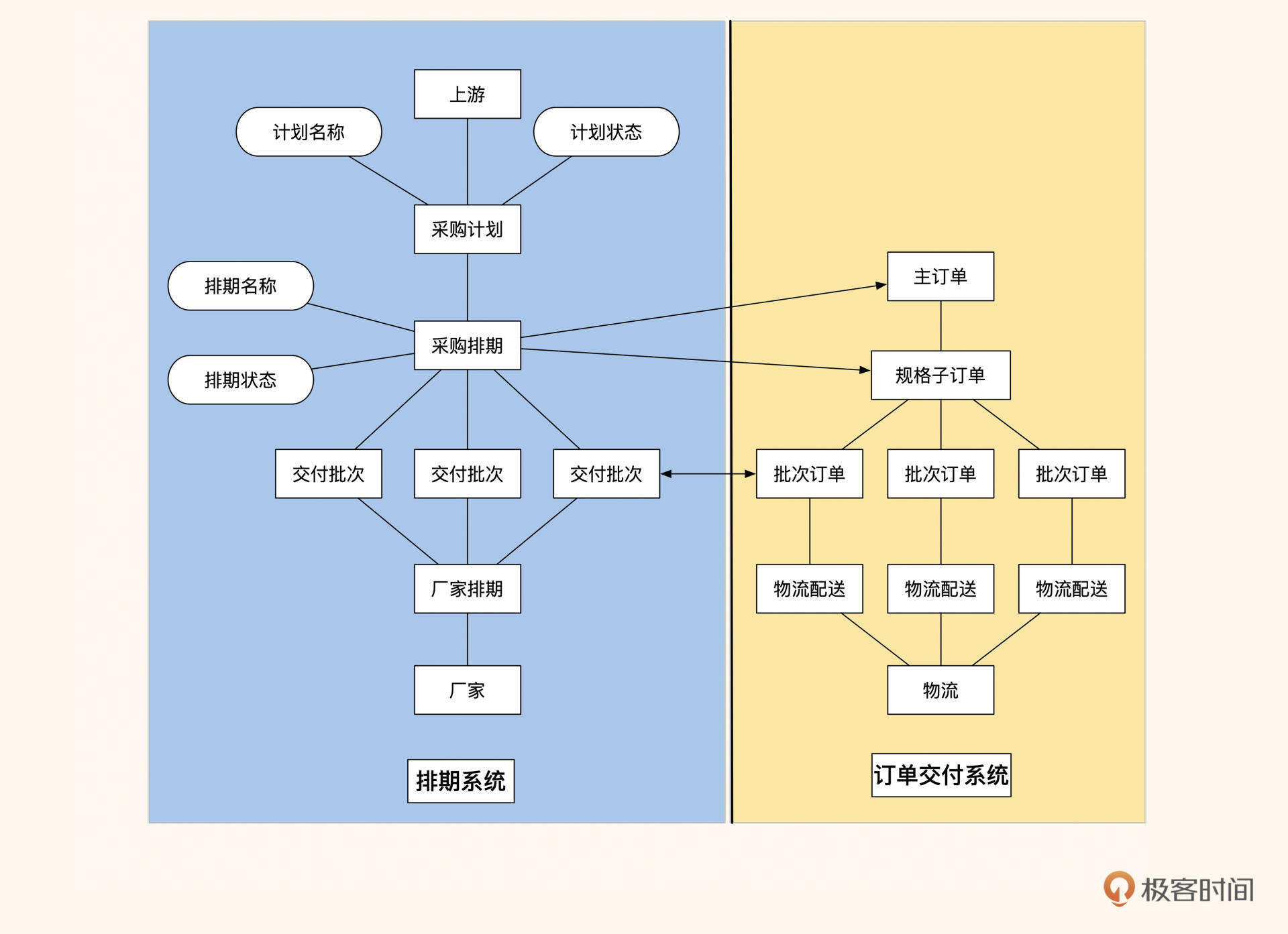

我先梳理了主订单的 API 和流程,从上到下简单绘制了流程和订单系统的关系,如下图所示:

图2:角色动作与系统

可以看到,有多个角色在使用这个“订单排期系统”。通过这张图与产品、研发团队进行沟通,来确认我理解的主要流程的数据走向和系统数据依赖关系都没有问题。

接着我们将目光放在了订单表上,订单表承载的职能过多,导致多个流程依赖订单表无法做数据维护,而且订单存在多个和订单业务无关的状态,比如排期周期很长,导致订单一直不能关闭。我们在第 1 节课讲过,一个数据实体不要承担太多职能,否则很难管理,所以我们需要对订单和排期的主要实体职能进行拆分。

经过分析我们还发现了另一个问题,现在系统的核心并不是订单,而是计划排期。原订单系统在改造前是通过自动匹配功能实现上下游订单分单的,所以系统的主要模块都是围绕订单来流转的。而增加排期功能后,系统的核心就从围绕订单实现匹配分单,转变成了围绕排期产生订单的模式,这更符合业务需要。

排期和订单有关联关系,但职能上有不同的方向用途,排期只是计划,而订单只为工厂后续生产运输和上游核对结果使用。这意味着系统的模块和表的设计核心已经发生了偏移,我们需要拆分模块才能拥有更好的灵活性。

综上所述,我们总体的拆分思路是:要将排期流程和订单交付流程完全拆分开。要知道在创业公司,我们做的项目一开始的设计初衷常常会因为市场需求变化,逐渐偏离原有设计,这就需要我们不断重新审视我们的系统,持续改进,才能保证系统的完善。

因为担心研发团队摆脱不了原有系统的思维定势,拆分做得不彻底,导致改版失败,所以我对角色和流程做了一次梳理,明确了各个角色的职责和流程之间的关系。我按角色及其所需动作画出多个框,将他们需要做的动作和数据流穿插起来,如下图所示:

图3:按角色及其动作整理

基于这个图,我再次与研发、产品沟通,找出了订单与排期在功能和数据上的拆分点。具体来讲,就是将上游的职能拆分为:发布进货计划、收货排期、下单、收货 / 退换;而供货商主要做协调排期分单,同时提供订单相关服务;工厂则主要负责生产排期、生产和售后。这样一来,系统的流程就可以归类成几个阶段:

- 计划排期协调阶段

- 按排期生产供货 + 周期物流交付阶段

- 售后服务调换阶段

可以看到,第一个阶段不牵扯订单,主要是上游和多个工厂的排期协调;第二、三阶段是工厂生产供货和售后,这些服务需要和订单交互,而上游、工厂和物流的视角是完全不同的。

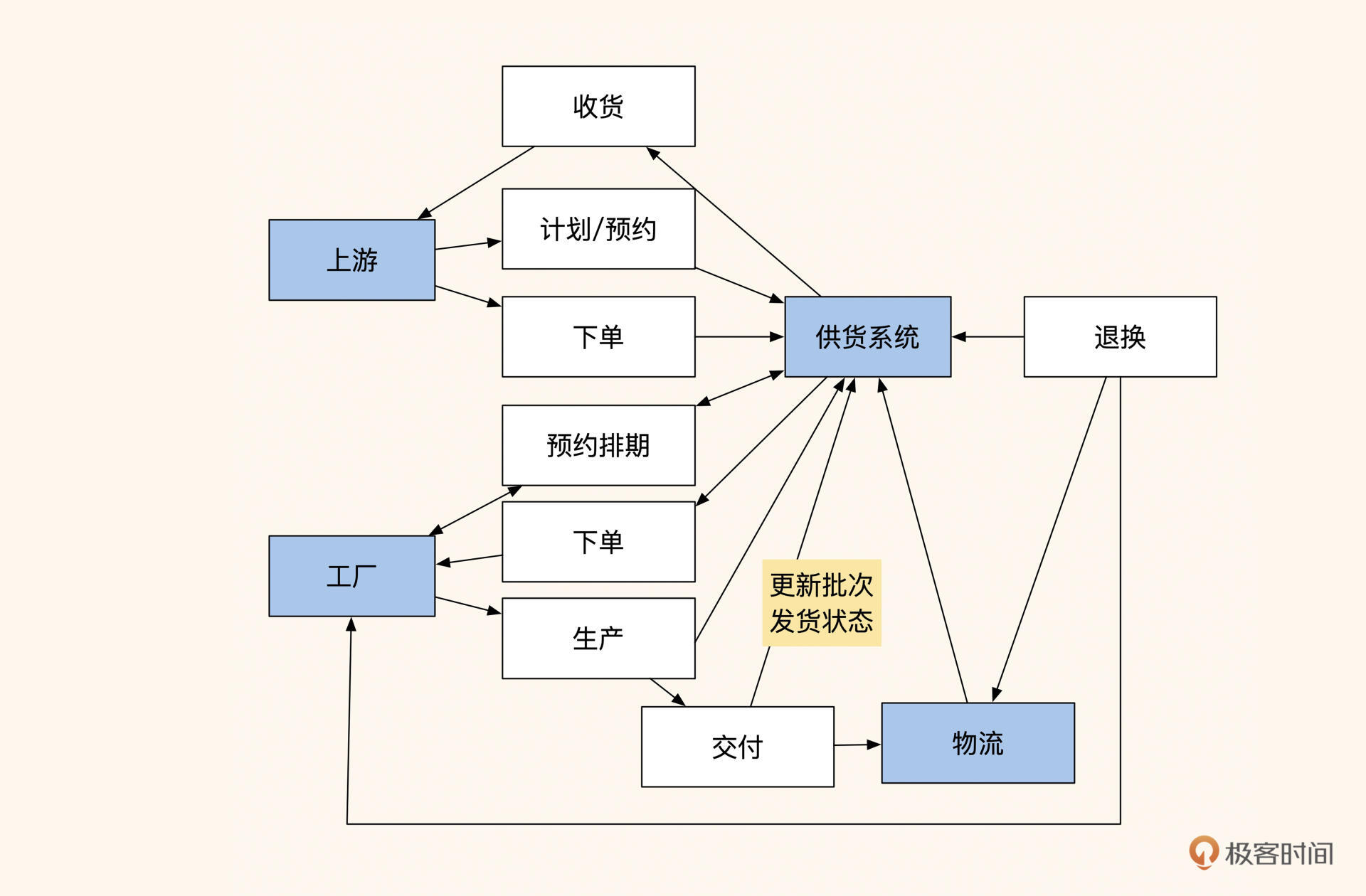

基于这个结论,我们完全可以根据数据的主要实体和主要业务流程(订单 ID 做聚合根,将流程分为订单和排期两个领域)将系统拆分成两个子系统:排期调度系统、订单交付系统。

在计划排期协调阶段,上游先在排期调度系统内提交进货计划和收货排期,然后供货商根据上游的排期情况和进货需求,与多家合作工厂协调分单和议价。多方达成一致后,上游对计划排期和工厂生产排期进行预占。

待上游正式签署协议、支付生产批次定金后,排期系统会根据排期和工厂下单在订单系统中产生对应的订单。同时,上游、供货商和工厂一旦达成合作,后续可以持续追加下单排期,而不是将合作周期限制在订单内。

在排期生产供货阶段,排期系统在调用订单系统的同时,会传递具体的主订单号和订单明细。订单明细内包含着计划生产的品类、个数以及每期的交付量,工厂可以根据自己的情况调整生产排期。产品生产完毕后,工厂分批次发送物流进行派送,并在订单系统内记录交付时间、货物量和物流信息。同时,订单系统会生成财务信息,与上游财务和仓库分批次地对账。

图4:拆分成两大流程后的系统

这么拆分后,两个系统把采购排期和交付批次作为聚合根,进行了数据关联,这样一来,整体的订单流程就简单了很多。

总体来讲,前面对业务的梳理都以流程、角色和关键动作这三个元素作为分析的切入点,然后将不同流程划分出不同阶段来归类分析,根据不同阶段拆分出两个业务领域:排期和订单,同时找出两个业务领域的聚合根。经过这样大胆的拆分后,再与产品和研发论证可行性。

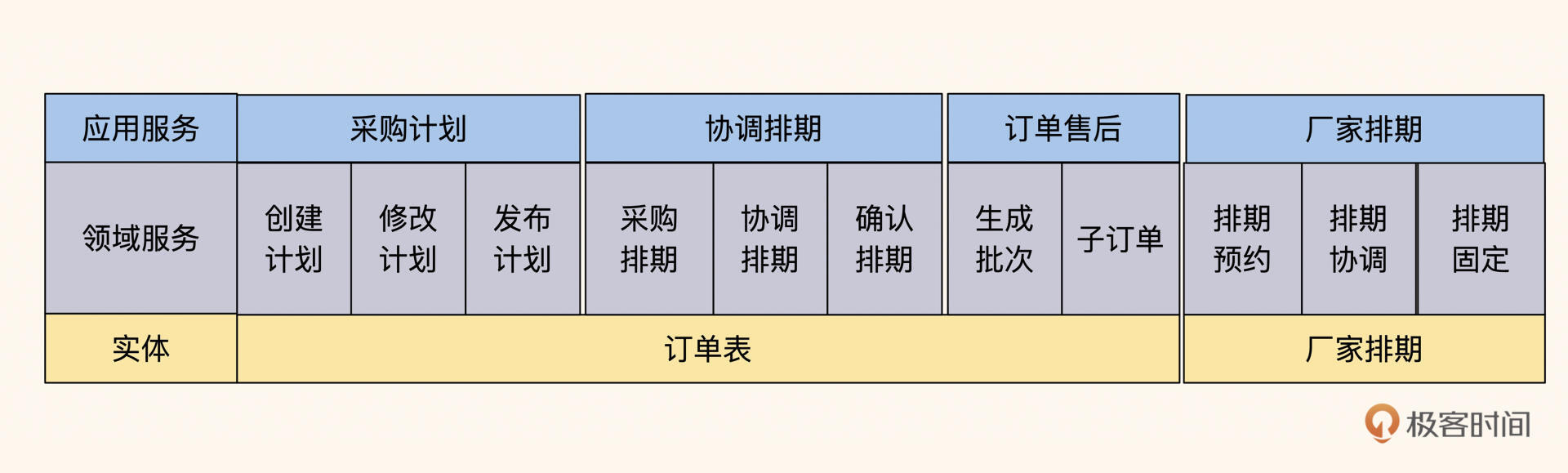

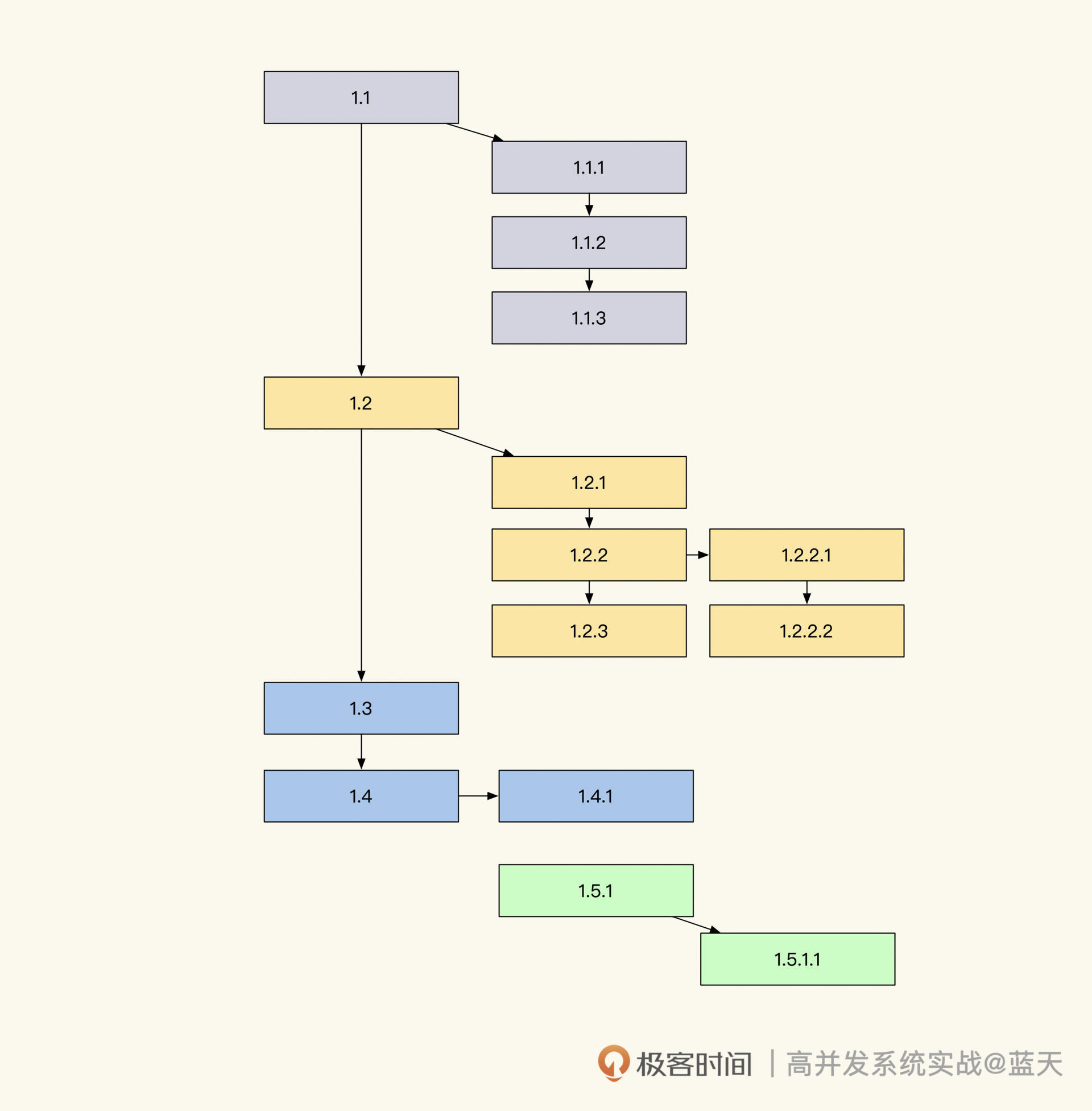

系统拆分从表开始

经历了上面的过程,相信你对按流程和阶段拆分实体职责的方法,已经有了一定的感觉,这里我们再用代码和数据库表的视角复盘一下该过程。

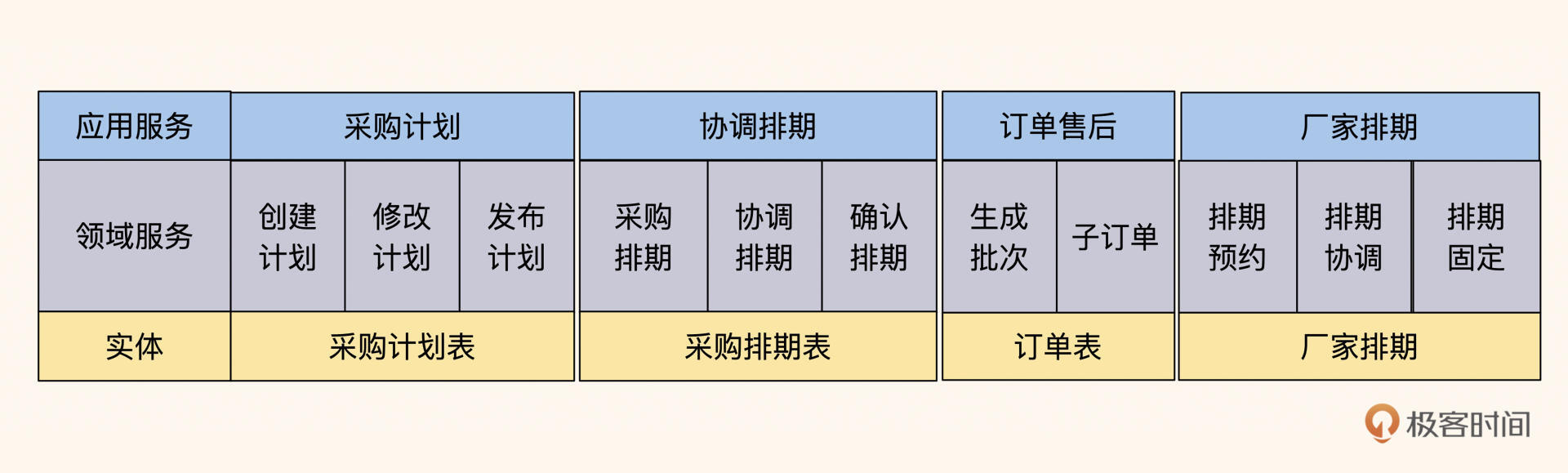

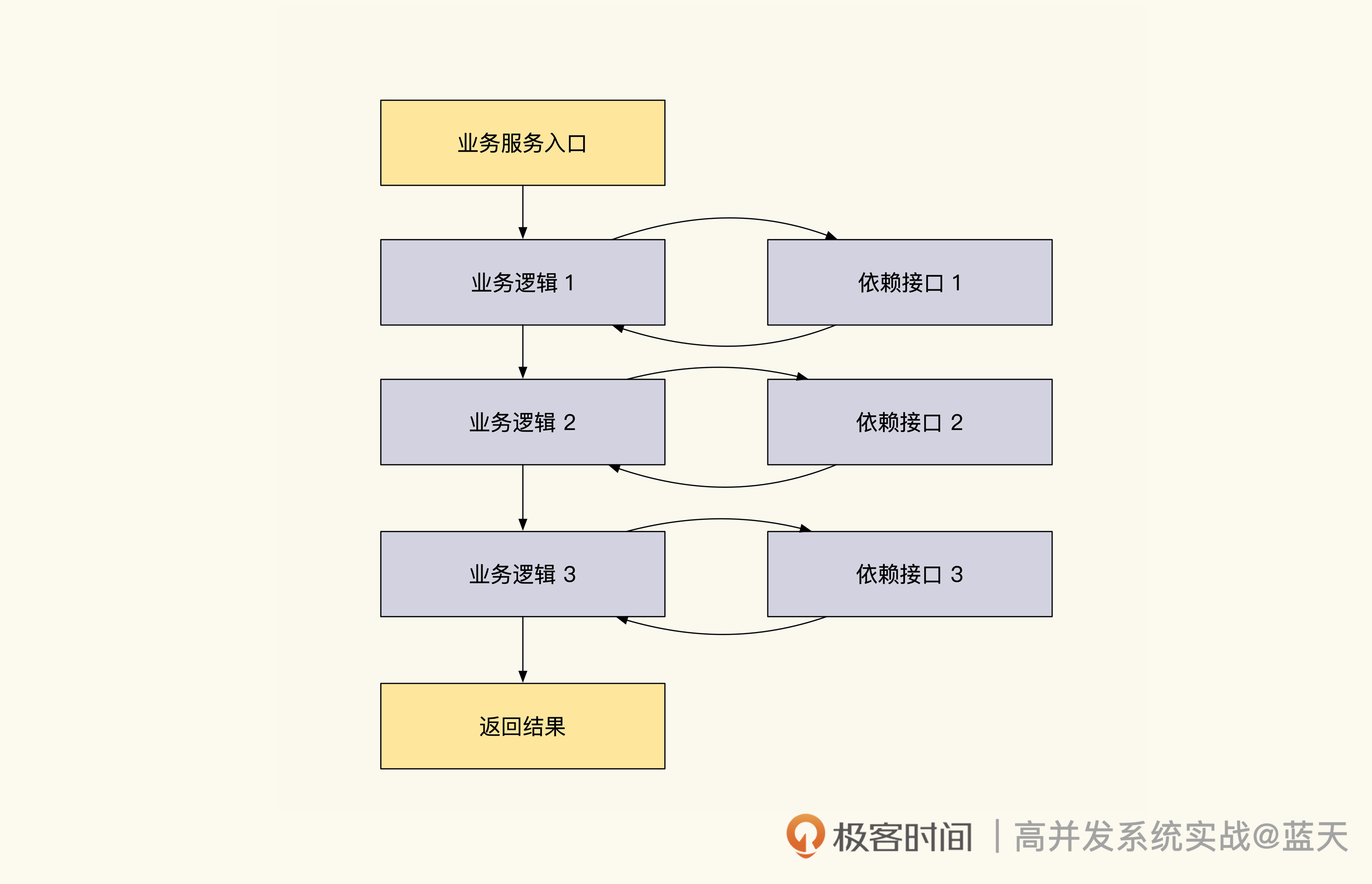

一般来说,系统功能从表开始拆分,这是最容易实现的路径,因为我们的业务流程往往都会围绕一个主要的实体表运转,并关联多个实体进行交互。在这个案例中,我们将订单表内关于排期的数据和状态做了剥离,拆分之前的代码分层如下图所示:

图5:拆分之前,订单表承担计划、排期协调、订单售后的职责

拆分之后,代码分层变成了这样:

图6:拆分之后,分为计划表、排期协调表和订单售后表

可以看到,最大的变化就是订单实体表的职责被拆分了,我们的系统代码随之变得更加简单,而且同一个订单实体被多个角色交叉调用的情况也完全消失了。在拆分过程中,我们的依据有三个:

- 数据实体职能只做最核心的一件事,比如订单只管订单的生老病死(包括创建、流程状态更改、退货、订单结束);

- 业务流程归类按涉及实体进行归类,看能否分为多个阶段,比如“协调排期流程进行中”、“生产流程”、“售后服务阶段”;

- 由数据依赖交叉的频率决定把订单划分成几个模块,如果两个模块业务流程上交互紧密,并且有数据关联关系,比如 Join、调用 A 必然调用 B 这种,就把这两个模块合并,同时保证短期内不会再做更进一步的拆分。

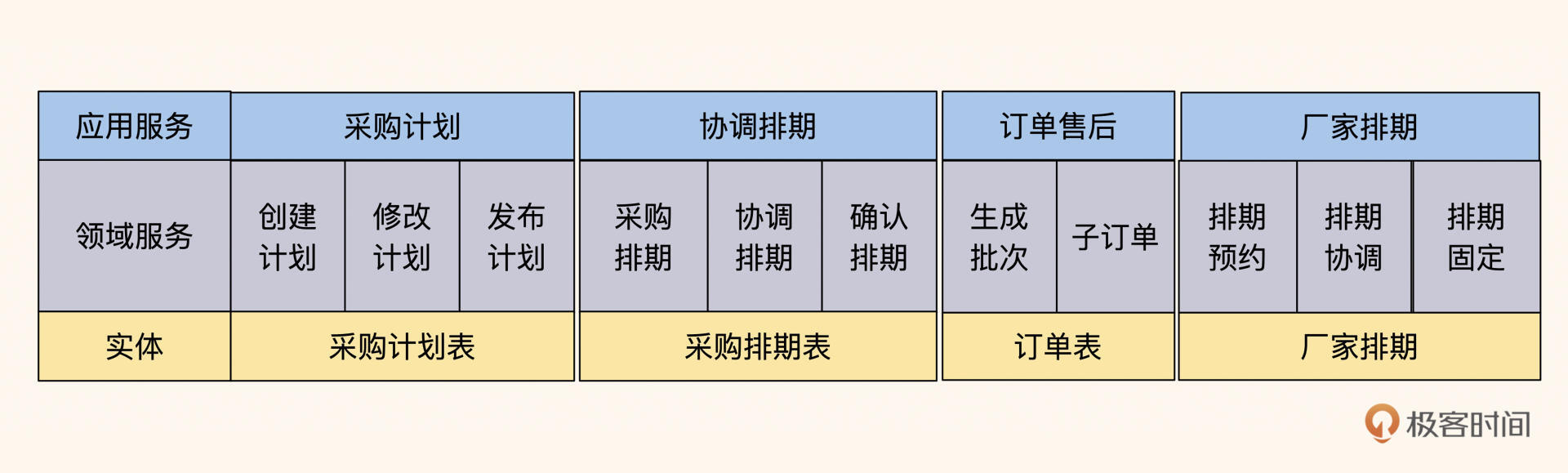

图7:从下往上按数据实体设计和从流程往下按领域流程设计DDD

一个核心的系统,如果按实体表职责进行拆分整理,那么它的流程和修改难度都会大大降低。

而模块的拆分,也可以通过图 6,从下往上去看。如果它们之间的数据交互不是特别频繁,比如没有出现频繁的 Join,我们就将系统分成四个模块。如图 7 所示,可以看到这四个模块之间相对独立,各自承担一个核心的职责。同时,两个实体之间交互没有太大的数据关联,每个模块都维护着某个阶段所需的全部数据,这么划分比较清晰,也易于统一管理。

到这里,我们只需要将数据和流程关系都梳理一遍,确保它们之间的数据在后续的统计分析中没有频繁数据 Join,即可完成对表的拆分。

但如果要按业务划分模块,我还是建议从上到下去看业务流程,来决定数据实体拆分(领域模型设计 DDD)的领域范围,以及各个模块的职责范围。

越是底层服务越要抽象

除了系统的拆分外,我们还要注意一下服务的抽象问题。很多服务经常因业务细节变更需要经常修改,而越是底层服务,越要减少变更。如果服务的抽象程度不够,一旦底层服务变更,我们很难确认该变更对上游系统的影响范围。

所以,我们要搞清楚哪些服务可以抽象为底层服务,以及如何对这些服务做更好的抽象。

因为电商类系统经常对服务做拆分和抽象,所以我就以这类系统为例为你进行讲解。你可能感到疑惑:电商系统为什么要经常做系统拆分和服务抽象呢?

这是因为电商系统最核心且最复杂的地方就是订单系统,电商商品有多种品类(sku+spu),不同品类的筛选维度、服务、计量单位都不同,这就导致系统要记录大量的冗余品类字段,才能保存好用户下单时的交易快照。所以我们需要频繁拆分整理系统,避免这些独有特性影响到其他商品。

此外,电商系统不同业务的服务流程是不同的。比如下单购买食品,与下单定制一个柜子完全不同。在用户购买食品时,电商只需要通知仓库打包、打物流单、发货、签收即可;而用户定制柜子则需要厂家上门量尺寸、复尺、定做、运输、后续调整等。所以,我们需要做服务抽象,让业务流程更标准、更通用,避免变更过于频繁。

正是由于业务服务形态存在不同的差异,订单系统需要将自己的职能控制在“一定范围”内。对此,我们应该考虑如何在满足业务需求的情况下,让订单表的数据职能最小。

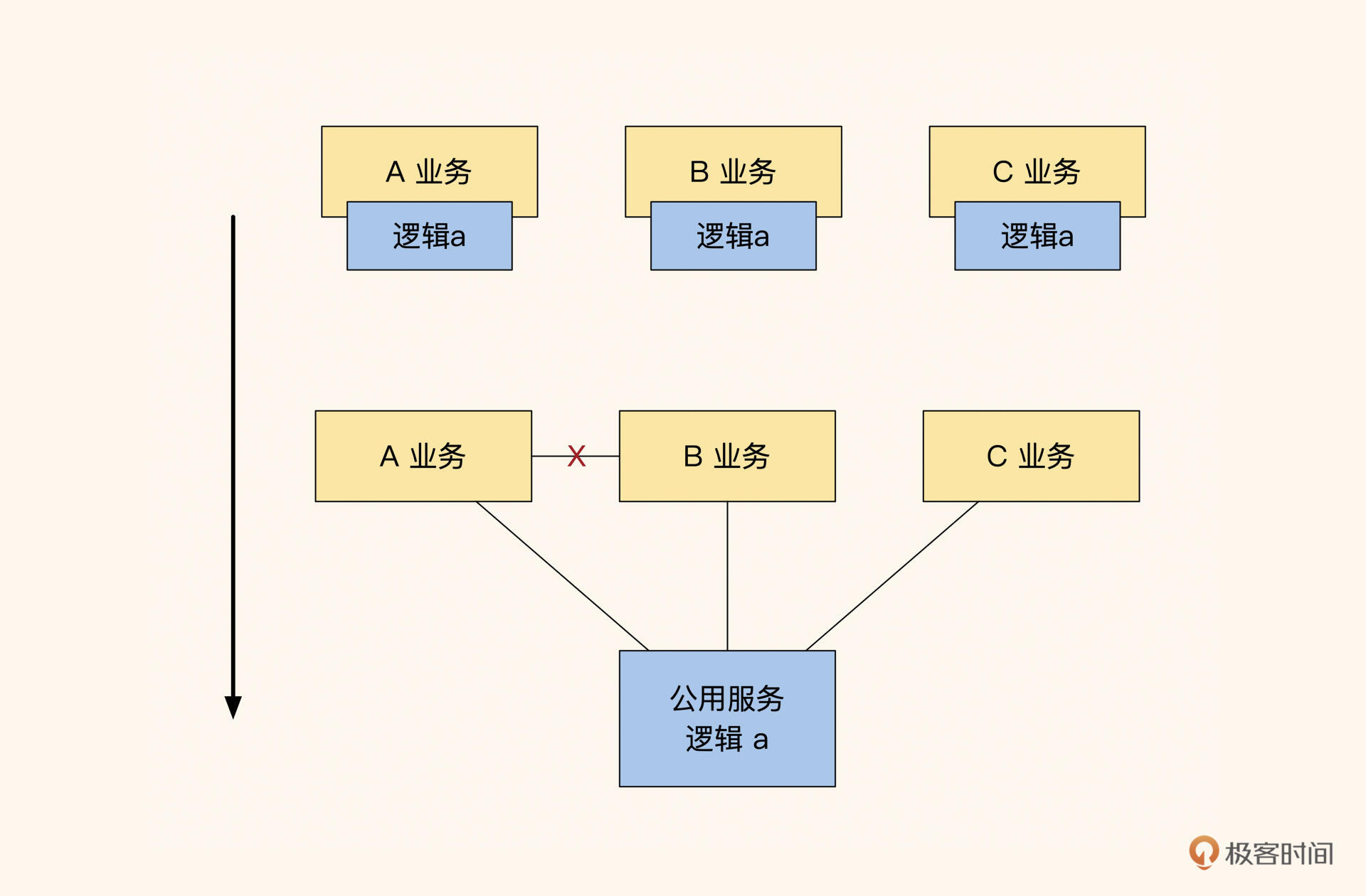

被动抽象法

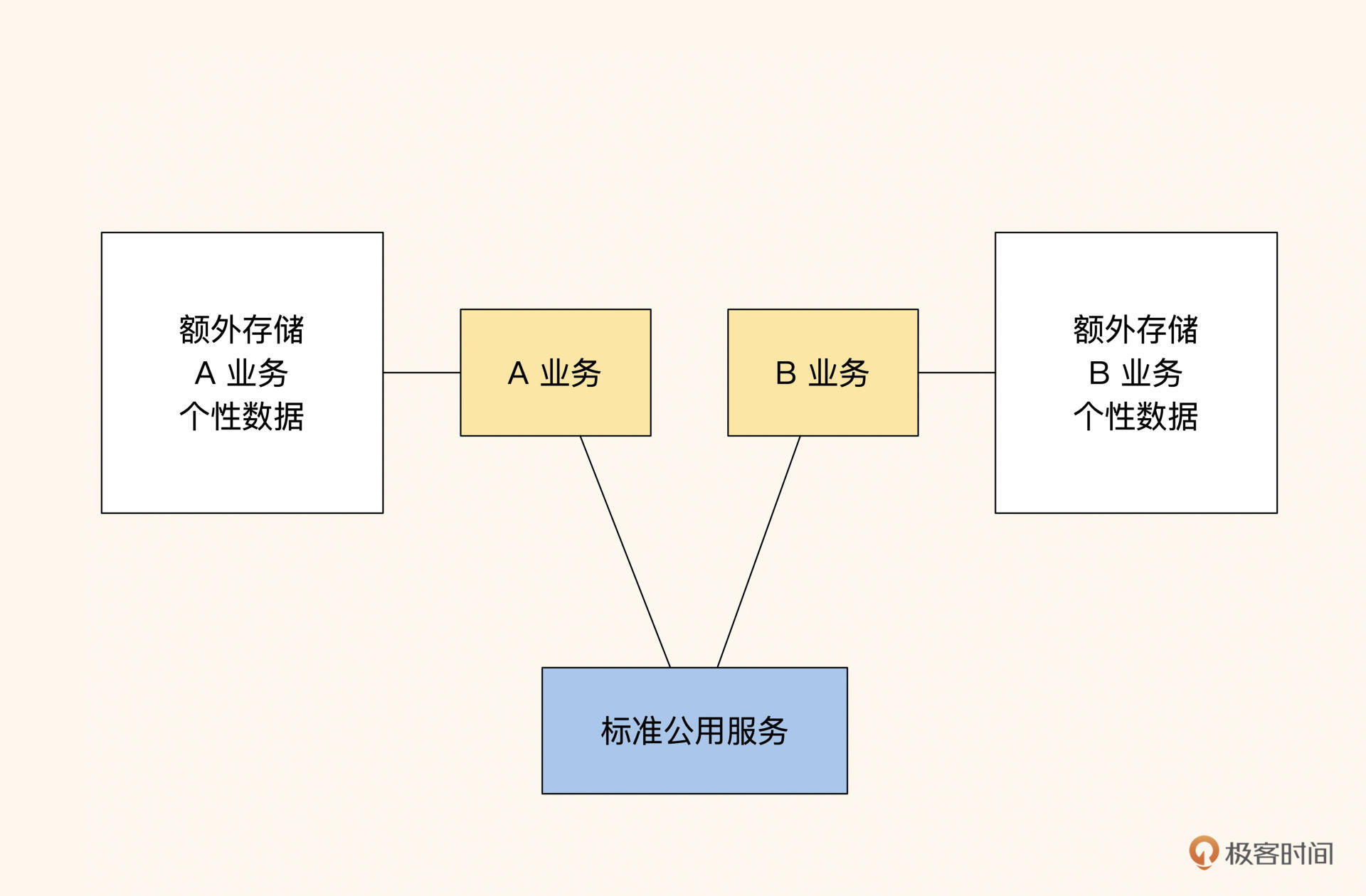

如果两个或多个服务使用同一个业务逻辑,就把这个业务逻辑抽象成公共服务。比如业务 A 更新了逻辑 a,业务 B 也会同步使用新的逻辑 a,那么就将这个逻辑 a 放到底层抽象成一个公共服务供两个服务调用。这种属于比较被动的抽象方式,很常见,适合代码量不大、维护人员很少的系统。

对于创业初期主脉络不清晰的系统,利用被动抽象法很容易做抽象。不过,它的缺点是抽象程度不高,当业务需要大量变更时,需要一定规模的重构。

总的来说,虽然这种方式的代码结构很贴近业务,但是很麻烦,而且代码分层没有规律。所以,被动抽象法适用于新项目的探索阶段。

图8:都用的服务才抽象成服务,个性部分放自身,决策权在业务。

这里说一个题外话,同层级之间的模块是禁止相互调用的。如果调用了,就需要将两个服务抽象成公共服务,让上层对两个服务进行聚合,如上图中的红 X,拆分后如下图所示:

图9:同层有交叉调用的服务

这么做是为了让系统结构从上到下是一个倒置的树形,保证不会出现引用交叉循环的情况,否则会让项目难以排查问题,难以迭代维护,如果前期有大量这样的调用,当我们做系统改造优化时只能投入大量资源才能解决这个问题。

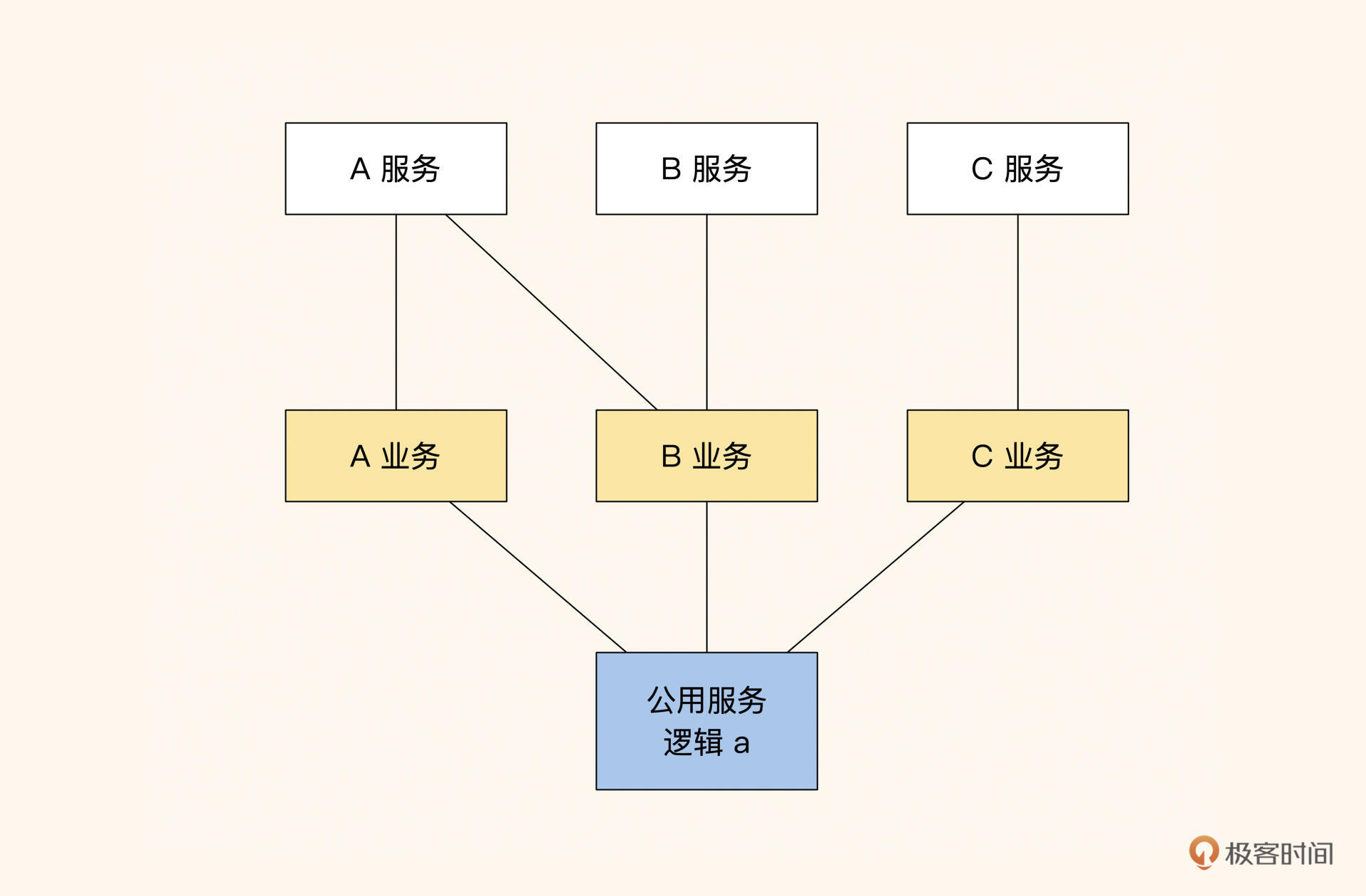

动态辅助表方式

这个方式适用于规模稍微大一点的团队或系统,它的具体实现是这样的:当订单系统被几个开发小组共同使用,而不同业务创建的主订单有不同的 type,不同的 type 会将业务特性数据存储在不同的辅助表内,比如普通商品保存在表 order 和表 order_product_extra 中,定制类商品的定制流程状态保存在 order_customize_extra 中。

这样处理的好处是更贴近业务,方便查询。但由于辅助表有其他业务数据,业务的隔离性比较差,所有依赖订单服务的业务常会受到影响,而且订单需要时刻跟着业务改版。所以,通过这种方式抽象出来的订单服务已经形同虚设,一般只有企业的核心业务才会做类似的定制。

图10:动态辅助表方式

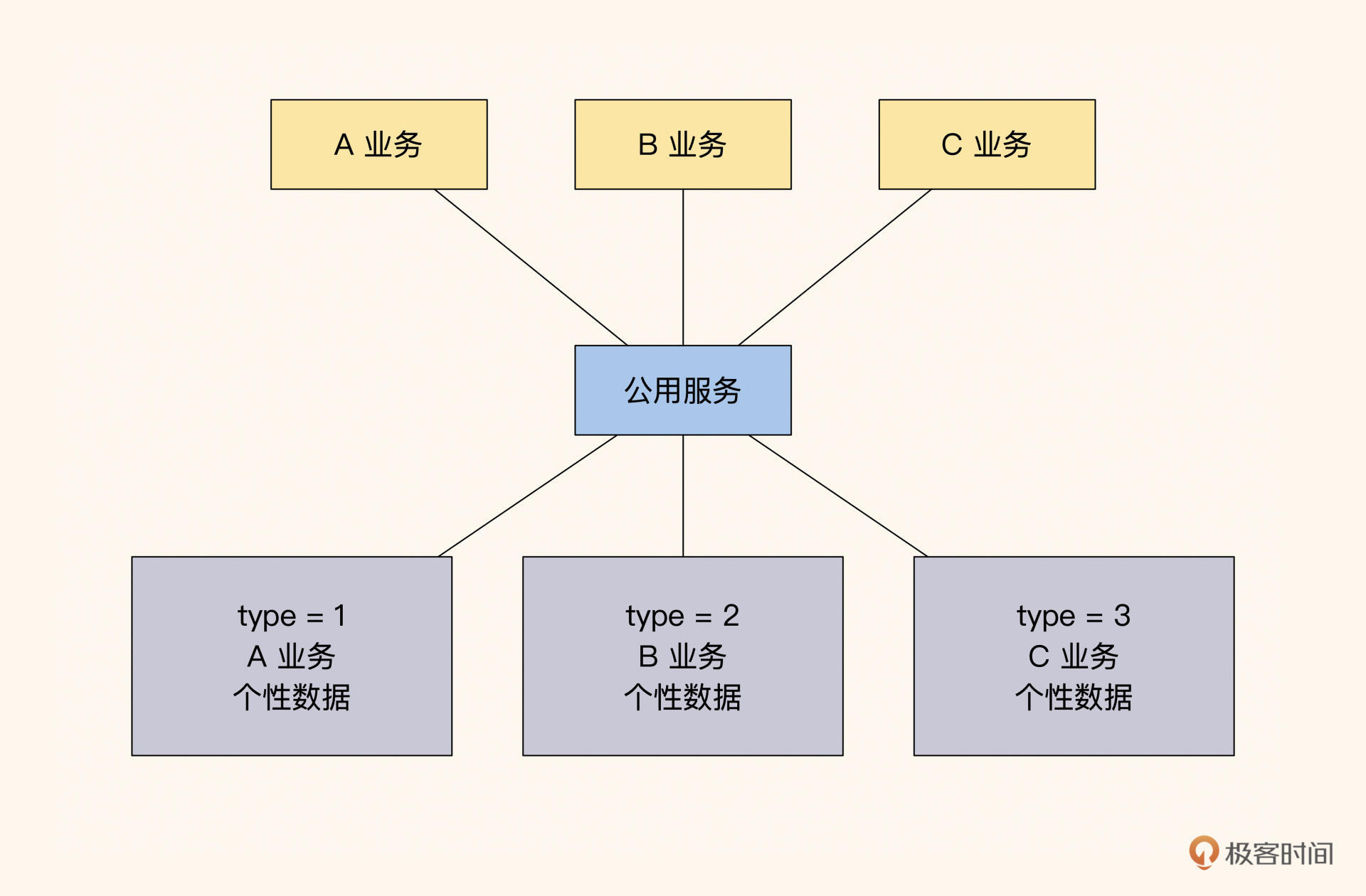

强制标准接口方式

这种方式在大型企业比较常见,其核心点在于:底层服务只做标准的服务,业务的个性部分都由业务自己完成,比如订单系统只有下单、等待支付、支付成功、发货和收货功能,展示的时候用前端对个性数据和标准订单做聚合。

用这种方式抽象出的公共服务订单对业务的耦合性是最小的,业务改版时不需要订单跟随改版,订单服务维护起来更容易。只是上层业务交互起来会很难受,因为需要在本地保存很多附加的信息,并且一些流转要自行实现。不过,从整体来看,对于使用业务多的系统来说,因为业务导致的修改会很少。

图11:只提供标准的公共服务,业务隔离性最好

通过上面三种方式可以看出,业务的稳定性取决于服务的抽象程度。如果底层经常更改,那么整个业务就需要不断修改,最终会导致业务混乱。所以,我个人还是推荐你使用强制标准接口方式,这也是很多公司的常见做法。虽然很难用,但比起经常重构整个系统总要好一些。

你可能很奇怪,为什么不把第一种方式一口气设计好呢?这是因为大部分的初创业务都不稳定,提前设计虽然能让代码结构保持统一,但是等两年后再回头看,你会发现当初的设计已经面目全非,我们最初信心满满的设计,最后会成为业务的绊脚石。

所以,这种拆分和架构设计需要我们不定期回看、自省、不断调整。毕竟技术是为业务服务的,业务更重要,没有人可以保证项目初期设计的个人中心不会被改成交友的个人门户。

总之,每一种方法并非绝对正确,我们需要根据业务需求来决策用哪一种方式。

总结

结业务拆分的方法有很多,最简单便捷的方式是:先从上到下做业务流程梳理,将流程归类聚合;然后从不同的领域聚合中找出交互所需主要实体,根据流程中主要实体之间的数据依赖程度决定是否拆分(从下到上看);把不同的实体和动作拆分成多个模块后,再根据业务流程归类,划分出最终的模块(最终汇总)。

这个拆分过程用一句话总结就是:从上往下看流程,从下往上看模块,最后综合考虑流程和模块的产出结果。用这种方式能快速拆出模块范围,拆分出的业务也会十分清晰。

图12:拆分理论总结

除了拆分业务外,我们还要关注如何抽象服务。如果底层业务变更频繁,就会导致上层业务频繁修改,甚至出现变更遗漏的情况。所以,我们要确保底层服务足够抽象,具体有很多种办法,比如被动拆分法、动态辅助表方式、标准抽象方式。这几种方式各有千秋,需要我们根据业务来决策。

图13:系统在不断改进的同时,需要不断做核心修正

通常,我们的业务系统在初期都会按照一个特定的目标来设计,但是随着市场需求的变化,业务系统经过不断改版,往往会偏离原有的设计。

虽然我们每次改版都实现了既定需求,但也很容易带来许多不合理的问题。所以,在需求稳定后,一般都会做更合理的改造,保证系统的完整性,提高可维护性。很多时候,第一版本不用做得太过精细,待市场验证后明确了接下来的方向,再利用留出足够的空间改进,这样设计的系统才会有更好的扩展性。

强一致锁:如何解决高并发下的库存争抢问题?

这节课我会给你详细讲一讲高并发下的库存争抢案例,我相信很多人都看到过相关资料,但是在实践过程中,仍然会碰到具体的实现无法满足需求的情况,比如说有的实现无法秒杀多个库存,有的实现新增库存操作缓慢,有的实现库存耗尽时会变慢等等。

这是因为对于不同的需求,库存争抢的具体实现是不一样的,我们需要详细深挖,理解各个锁的特性和适用场景,才能针对不同的业务需要做出灵活调整。

由于秒杀场景是库存争抢非常经典的一个应用场景,接下来我会结合秒杀需求,带你看看如何实现高并发下的库存争抢,相信在这一过程中你会对锁有更深入的认识。

锁争抢的错误做法

在开始介绍库存争抢的具体方案之前,我们先来了解一个小知识——并发库存锁。还记得在我学计算机的时候,老师曾演示过一段代码:

public class ThreadCounter {

private static int count = 0;

public static void main(String[] args) throws Exception {

Runnable task = new Runnable() {

public void run() {

for (int i = 0; i < 1000; ++i) {

count += 1;

}

}

};

Thread t1 = new Thread(task);

t1.start();

Thread t2 = new Thread(task);

t2.start();

t1.join();

t2.join();

cout << "count = " << count << endl;

}

}

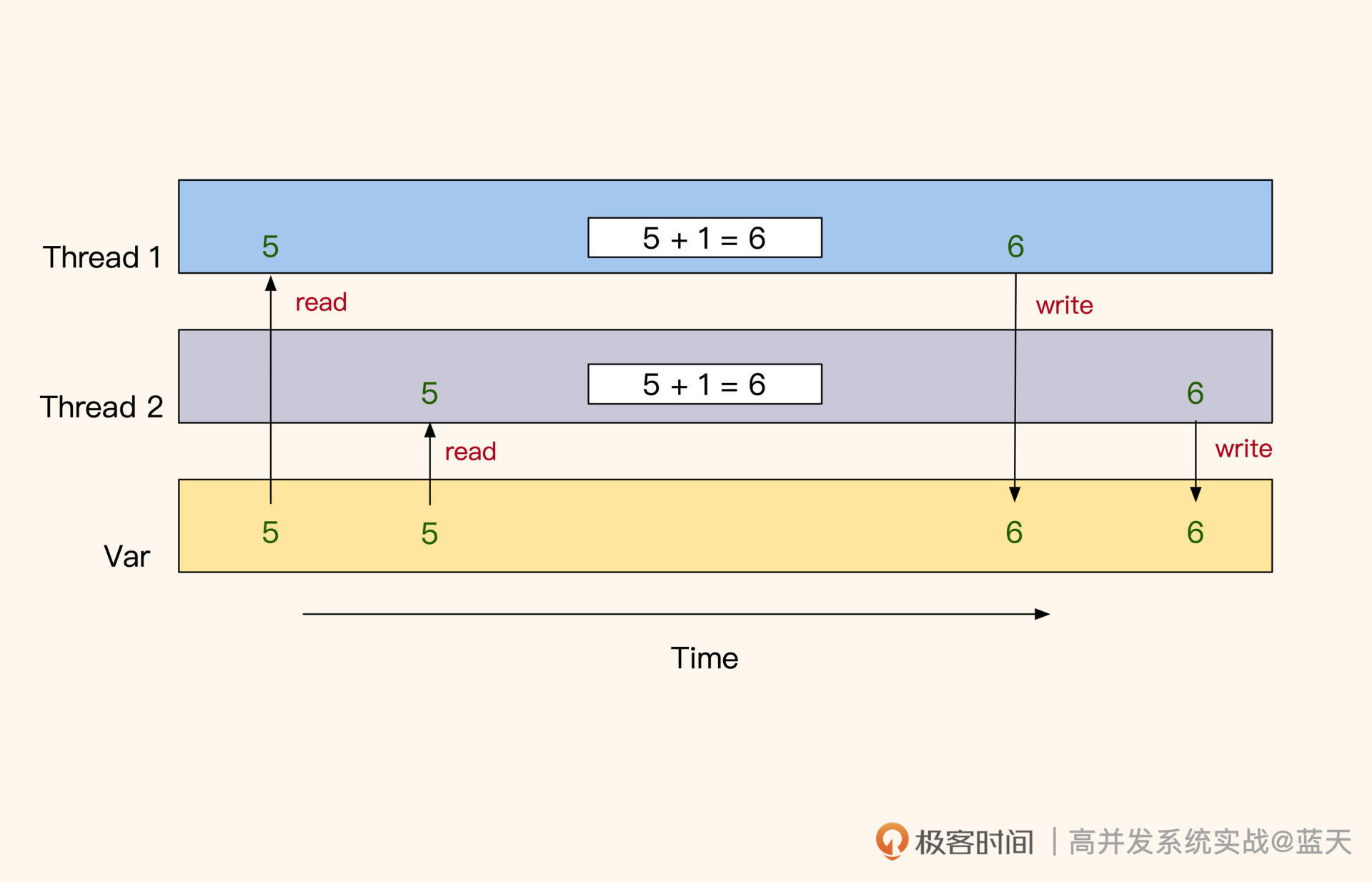

从代码来看,我们运行后结果预期是 2000,但是实际运行后并不是。为什么会这样呢?

当多线程并行对同一个公共变量读写时,由于没有互斥,多线程的 set 会相互覆盖或读取时容易读到其他线程刚写一半的数据,这就导致变量数据被损坏。反过来说,我们要想保证一个变量在多线程并发情况下的准确性,就需要这个变量在修改期间不会被其他线程更改或读取。

对于这个情况,我们一般都会用到锁或原子操作来保护库存变量:

- 如果是简单 int 类型数据,可以使用原子操作保证数据准确;

- 如果是复杂的数据结构或多步操作,可以加锁来保证数据完整性。

考虑到我们之前的习惯会有一定惯性,为了让你更好地理解争抢,这里我再举一个我们常会犯错的例子。因为扣库存的操作需要注意原子性,我们实践的时候常常碰到后面这种方式:

redis> get prod_1475_stock_1

15

redis> set prod_1475_stock_1 14

OK

也就是先将变量从缓存中取出,对其做 -1 操作,再放回到缓存当中,这是个错误做法。

如上图,原因是多个线程一起读取的时候,多个线程同时读到的是 5,set 回去时都是 6,实际每个线程都拿到了库存,但是库存的实际数值并没有累计改变,这会导致库存超卖。如果你需要用这种方式去做,一般建议加一个自旋互斥锁,互斥其他线程做类似的操作。

不过锁操作是很影响性能的,在讲锁方式之前,我先给你介绍几个相对轻量的方式。

原子操作

在高并发修改的场景下,用互斥锁保证变量不被错误覆盖性能很差。让一万个用户抢锁,排队修改一台服务器的某个进程保存的变量,这是个很糟糕的设计。

因为锁在获取期间需要自旋循环等待,这需要不断地循环尝试多次才能抢到。而且参与争抢的线程越多,这种情况就越糟糕,这期间的通讯过程和循环等待很容易因为资源消耗造成系统不稳定。

对此,我会把库存放在一个独立的且性能很好的内存缓存服务 Redis 中集中管理,这样可以减少用户争抢库存导致其他服务的抖动,并且拥有更好的响应速度,这也是目前互联网行业保护库存量的普遍做法。

同时,我不建议通过数据库的行锁来保证库存的修改,因为数据库资源很珍贵,使用数据库行锁去管理库存,性能会很差且不稳定。

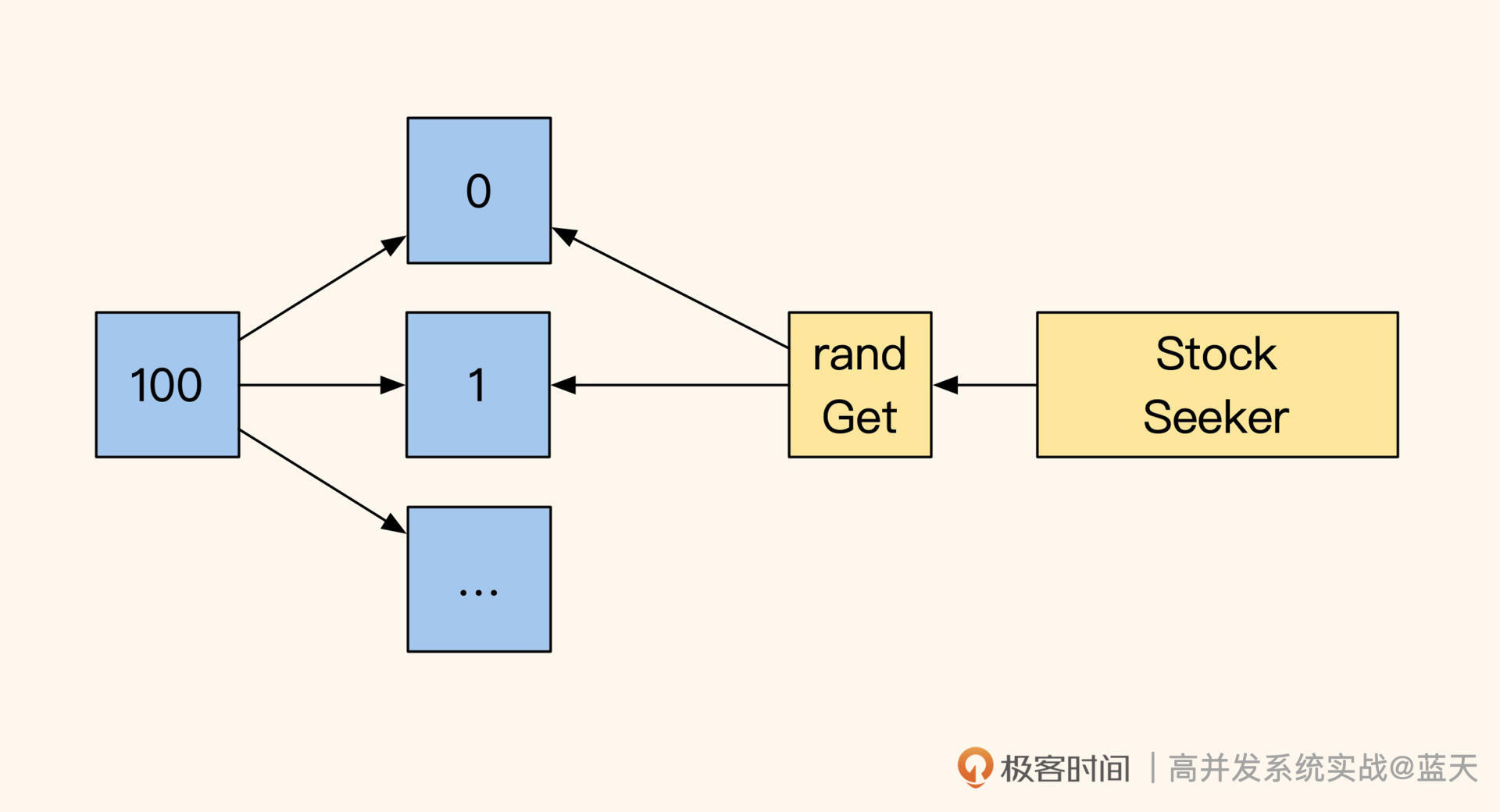

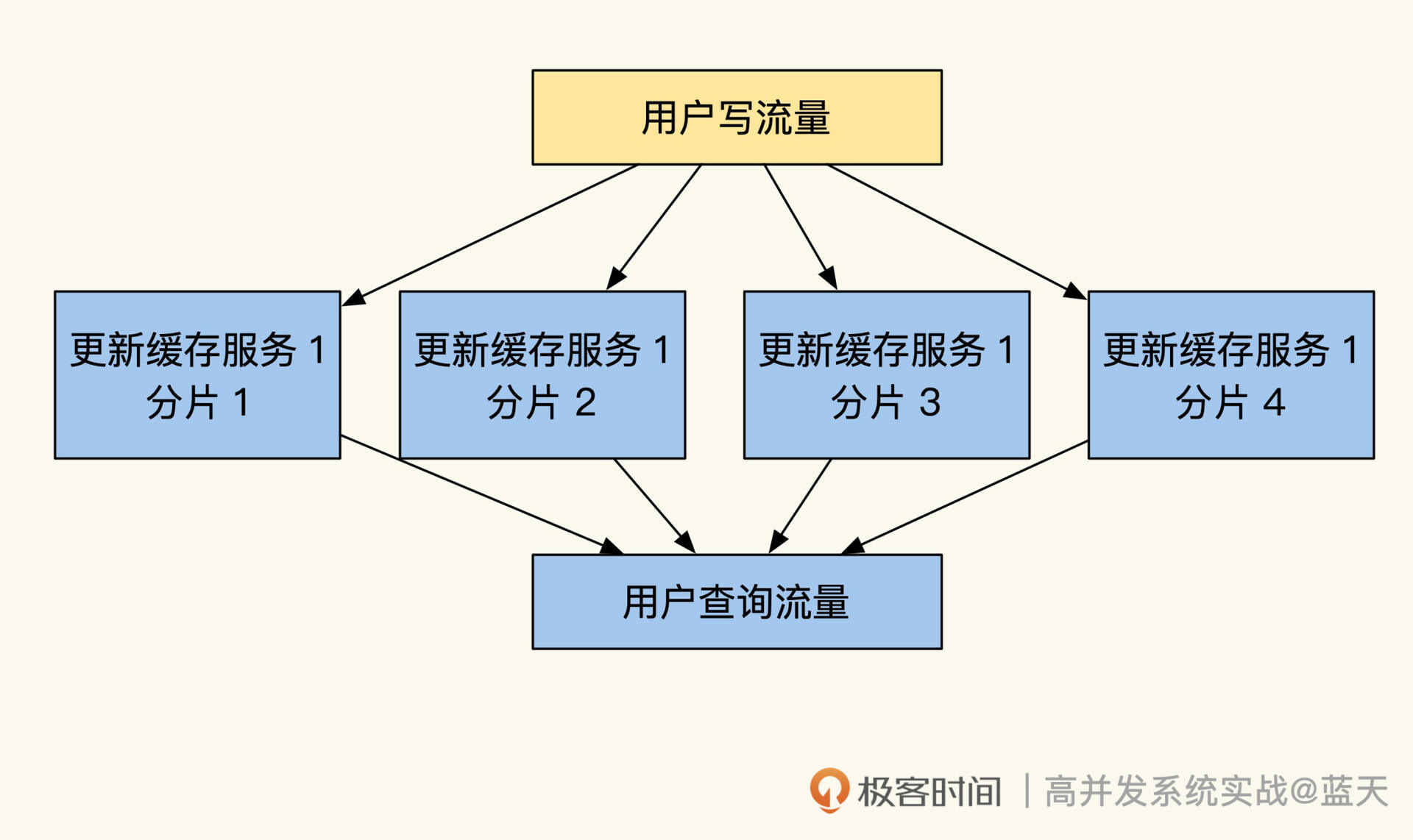

前面我们提到当有大量用户去并行修改一个变量时,只有用锁才能保证修改的正确性,但锁争抢性能很差,那怎么降低锁的粒度、减少锁的争枪呢?

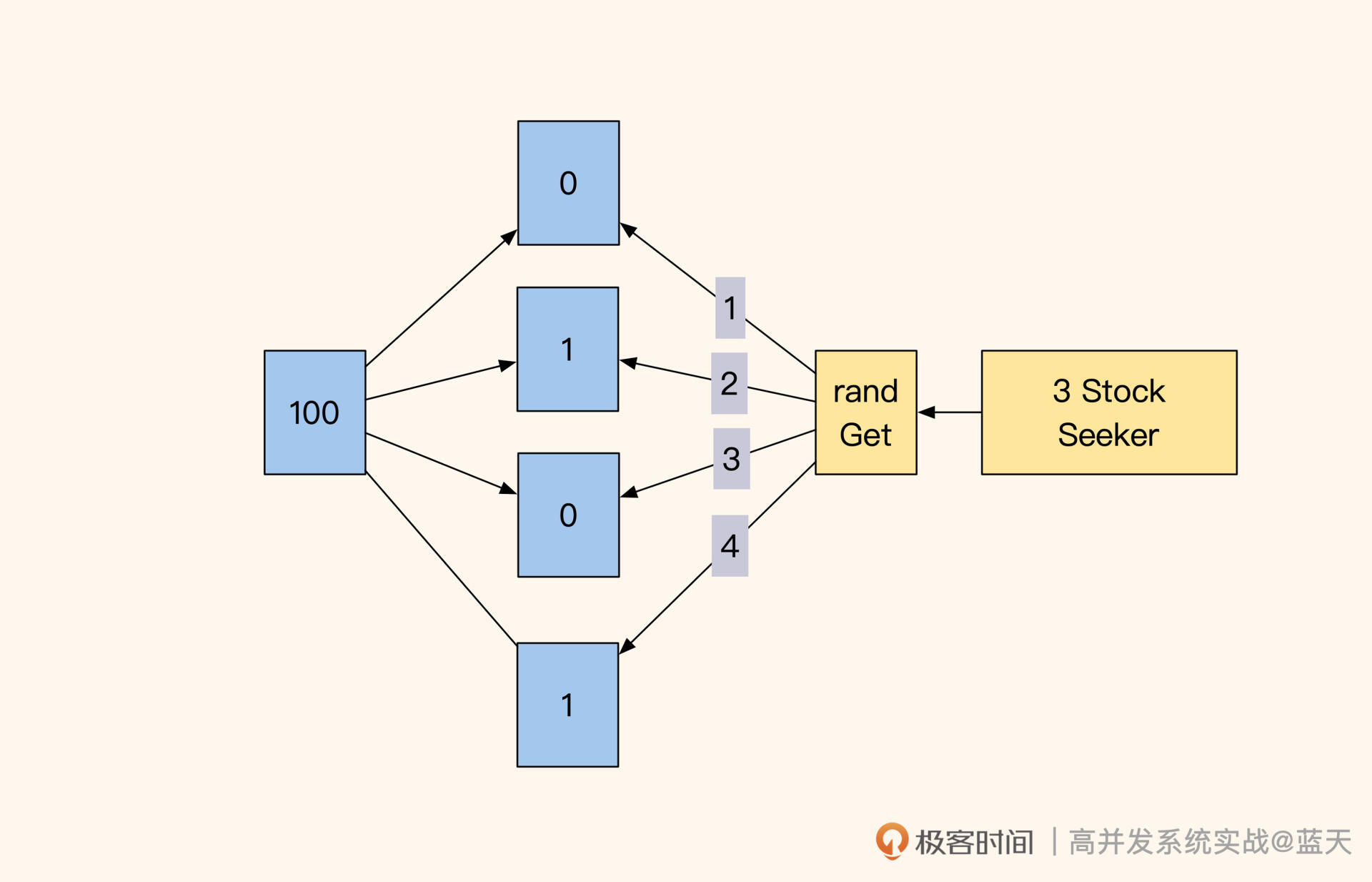

举个例子,当前商品库存有 100 个,我们可以把它放在 10 个 key 中用不同的 Redis 实例保存,每个 key 里面保存 10 个商品库存,当用户下单的时候可以随机找一个 key 进行扣库存操作。如果没库存,就记录好当前 key 再随机找剩下的 9 个 key,直到成功扣除 1 个库存。

除了这种方法以外,我个人更推荐的做法是使用 Redis 的原子操作,因为原子操作的粒度更小,并且是高性能单线程实现,可以做到全局唯一决策。而且很多原子操作的底层实现都是通过硬件实现的,性能很好,比如文稿后面这个例子:

redis> decr prod_1475_stock_1

14

incr、decr 这类操作就是原子的,我们可以根据返回值是否大于 0 来判断是否扣库存成功。但是这里你要注意,如果当前值已经为负数,我们需要考虑一下是否将之前扣除的补偿回来。并且为了减少修改操作,我们可以在扣减之前做一次值检测,整体操作如下:

//读取当前库存,确认是否大于零

//如大于零则继续操作,小于等于拒绝后续

redis> get prod_1475_stock_1

1

//开始扣减库存、如返回值大于或等于0那么代表扣减成功,小于0代表当前已经没有库存

//可以看到返回-2,这可以理解成同时两个线程都在操作扣库存,并且都没拿到库存

redis> decr prod_1475_stock_1

-2

//扣减失败、补偿多扣的库存

//这里返回0是因为同时两个线程都在做补偿,最终恢复0库存

redis> incr prod_1475_stock

0

这看起来是个不错的保护库存量方案,不过它也有缺点,相信你已经猜到了,这个库存的数值准确性取决于我们的业务是否能够返还恢复之前扣除的值。如果在服务运行过程中,“返还”这个操作被打断,人工修复会很难,因为你不知道当前有多少库存还在路上狂奔,只能等活动结束后所有过程都落地,再来看剩余库存量。

而要想完全保证库存不会丢失,我们习惯性通过事务和回滚来保障。但是外置的库存服务 Redis 不属于数据库的缓存范围,这一切需要通过人工代码去保障,这就要求我们在处理业务的每一处故障时都能处理好库存问题。

所以,很多常见秒杀系统的库存在出现故障时是不返还的,并不是不想返还,而是很多意外场景做不到。

提到锁,也许你会想到使用 Setnx 指令或数据库 CAS 的方式实现互斥排他锁,以此来解决库存问题。但是这个锁有自旋阻塞等待,并发高的时候用户服务需要循环多次做尝试才能够获取成功,这样很浪费系统资源,对数据服务压力较大,不推荐这样去做(这里附上锁性能对比参考)。

令牌库存

除了这种用数值记录库存的方式外,还有一种比较科学的方式就是“发令牌”方式,通过这个方式可以避免出现之前因为抢库存而让库存出现负数的情况。

具体是使用 Redis 中的 list 保存多张令牌来代表库存,一张令牌就是一个库存,用户抢库存时拿到令牌的用户可以继续支付:

//放入三个库存

redis> lpush prod_1475_stock_queue_1 stock_1

redis> lpush prod_1475_stock_queue_1 stock_2

redis> lpush prod_1475_stock_queue_1 stock_3

//取出一个,超过0.5秒没有返回,那么抢库存失败

redis> brpop prod_1475_stock_queue_1 0.5

在没有库存后,用户只会拿到 nil。当然这个实现方式只是解决抢库存失败后不用再补偿库存的问题,在我们对业务代码异常处理不完善时仍会出现丢库存情况。

同时,我们要注意 brpop 可以从 list 队列“右侧”中拿出一个令牌,如果不需要阻塞等待的话,使用 rpop 压测性能会更好一些。

不过,当我们的库存成千上万的时候,可能不太适合使用令牌方式去做,因为我们需要往 list 中推送 1 万个令牌才能正常工作来表示库存。如果有 10 万个库存就需要连续插入 10 万个字符串到 list 当中,入库期间会让 Redis 出现大量卡顿。

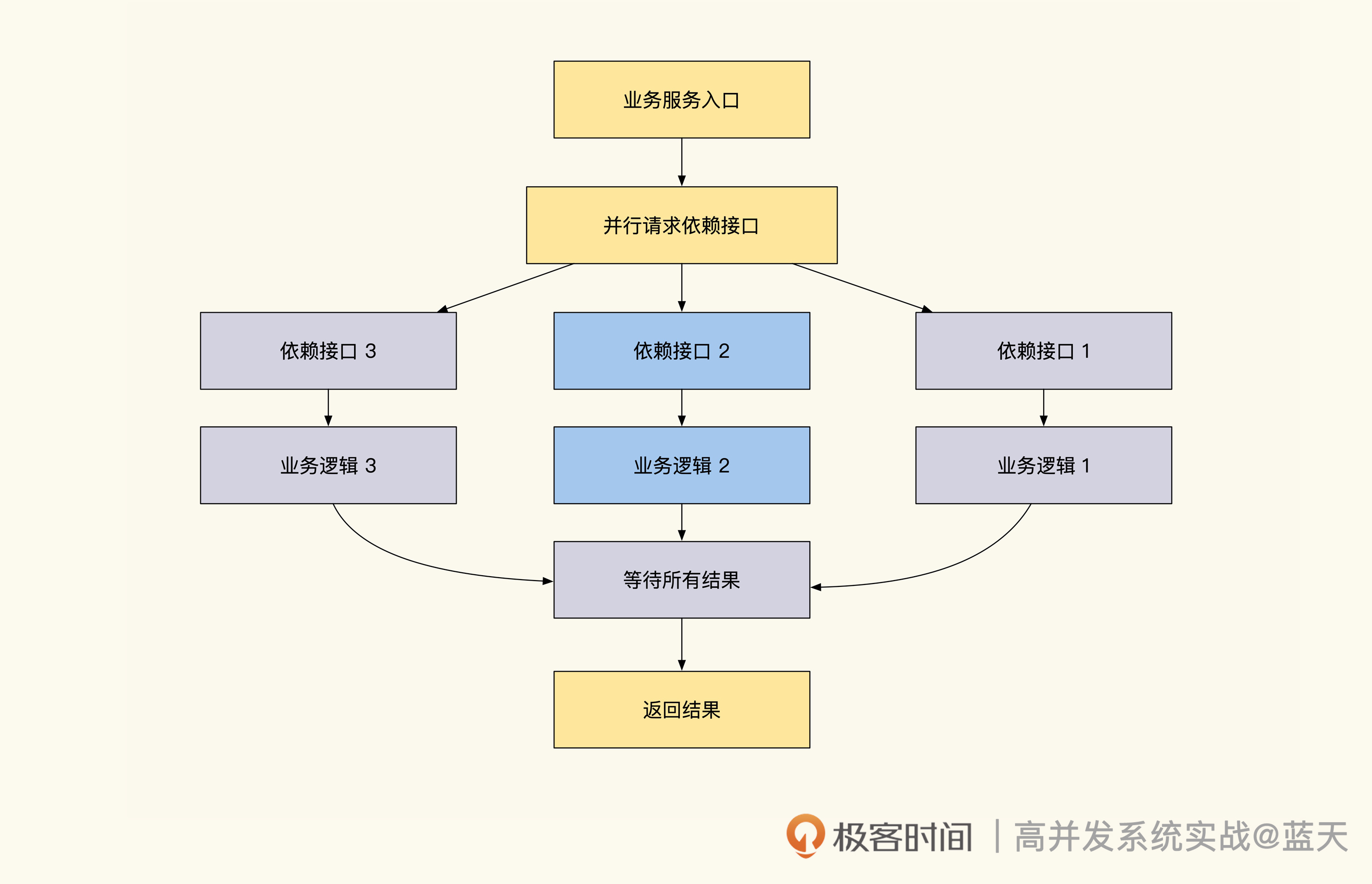

到这里,关于库存的设计看起来已经很完美了,不过请你想一想,如果产品侧提出“一个商品可以抢多个库存”这样的要求,也就是一次秒杀多个同种商品(比如一次秒杀两袋大米),我们利用多个锁降低锁争抢的方案还能满足吗?

多库存秒杀

其实这种情况经常出现,这让我们对之前的优化有了更多的想法。对于一次秒杀多个库存,我们的设计需要做一些调整。

之前我们为了减少锁冲突把库存拆成 10 个 key 随机获取,我们设想一下,当库存剩余最后几个商品时,极端情况下要想秒杀三件商品(如上图),我们需要尝试所有的库存 key,然后在尝试 10 个 key 后最终只拿到了两个商品库存,那么这时候我们是拒绝用户下单,还是返还库存呢?

这其实就要看产品的设计了,同时我们也需要加一个检测:如果商品卖完了就不要再尝试拿 10 个库存 key 了,毕竟没库存后一次请求刷 10 次 Redis,对 Redis 的服务压力很大(Redis O(1) 指令性能理论可以达到 10w OPS,一次请求刷 10 次,那么理想情况下抢库存接口性能为 1W QPS,压测后建议按实测性能 70% 漏斗式限流)。

这时候你应该发现了,在“一个商品可以抢多个库存”这个场景下,拆分并没有减少锁争抢次数,同时还加大了维护难度。当库存越来越少的时候,抢购越往后性能表现越差,这个设计已经不符合我们设计的初衷(由业务需求造成我们底层设计不合适的情况经常会碰到,这需要我们在设计之初,多挖一挖产品具体的需求)。

那该怎么办呢?我们不妨将 10 个 key 合并成 1 个,改用 rpop 实现多个库存扣减,但库存不够三个只有两个的情况,仍需要让产品给个建议看看是否继续交易,同时在开始的时候用 LLEN(O(1))指令检查一下我们的 List 里面是否有足够的库存供我们 rpop,以下是这次讨论的最终设计:

//取之前看一眼库存是否空了,空了不继续了(llen O(1))

redis> llen prod_1475_stock_queue

3

//取出库存3个,实际抢到俩

redis> rpop prod_1475_stock_queue 3

"stock_1"

"stock_2"

//产品说数量不够,不允许继续交易,将库存返还

redis> lpush prod_1475_stock_queue stock_1

redis> lpush prod_1475_stock_queue stock_2

通过这个设计,我们已经大大降低了下单系统锁争抢压力。要知道,Redis 是一个性能很好的缓存服务,其 O(1) 类复杂度的指令在使用长链接的情况下多线程压测,5.0 版本的 Redis 就能够跑到 10w OPS,而 6.0 版本的网络性能会更好。

这种利用 Redis 原子操作减少锁冲突的方式,对各个语言来说是通用且简单的。不过你要注意,不要把 Redis 服务和复杂业务逻辑混用,否则会影响我们的库存接口效率。

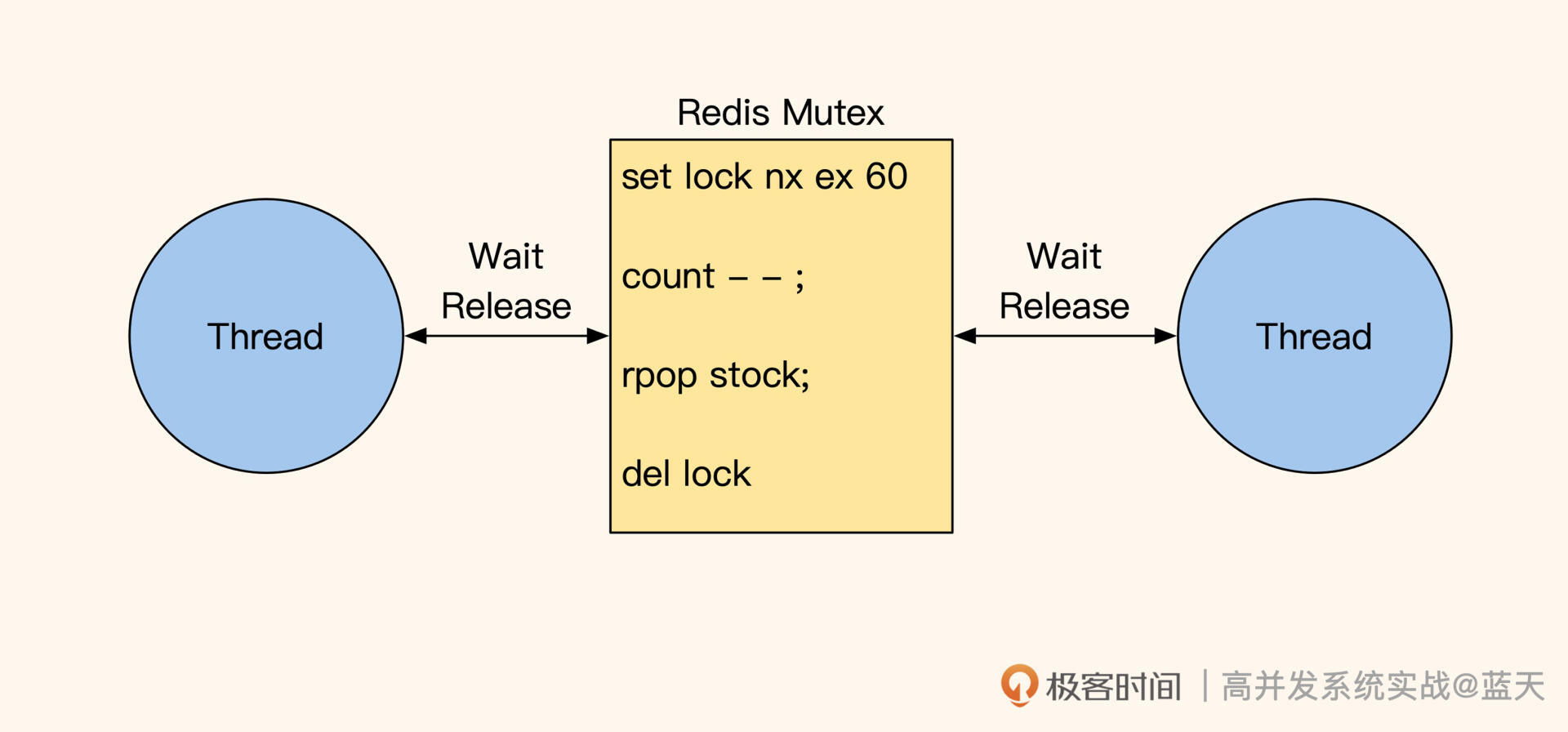

自旋互斥超时锁

如果我们在库存争抢时需要操作多个决策 key 才能够完成争抢,那么原子这种方式是不适合的。因为原子操作的粒度过小,无法做到事务性地维持多个数据的 ACID。

这种多步操作,适合用自旋互斥锁的方式去实现,但流量大的时候不推荐这个方式,因为它的核心在于如果我们要保证用户的体验,我们需要逻辑代码多次循环抢锁,直到拿到锁为止,如下:

//业务逻辑需要循环抢锁,如循环10次,每次sleep 10ms,10次失败后返回失败给用户

//获取锁后设置超时时间,防止进程崩溃后没有释放锁导致问题

//如果获取锁失败会返回nil

redis> set prod_1475_stock_lock EX 60 NX

OK

//抢锁成功,扣减库存

redis> rpop prod_1475_stock_queue 1

"stock_1"

//扣减数字库存,用于展示

redis> decr prod_1475_stock_1

3

// 释放锁

redis> del prod_1475_stock_lock

两个线程在等待锁

这种方式的缺点在于,在抢锁阶段如果排队抢的线程越多,等待时间就越长,并且由于多线程一起循环 check 的缘故,在高并发期间 Redis 的压力会非常大,如果有 100 人下单,那么有 100 个线程每隔 10ms 就会 check 一次,此时 Redis 的操作次数就是:

100线程×(1000ms÷10ms)次=10000ops

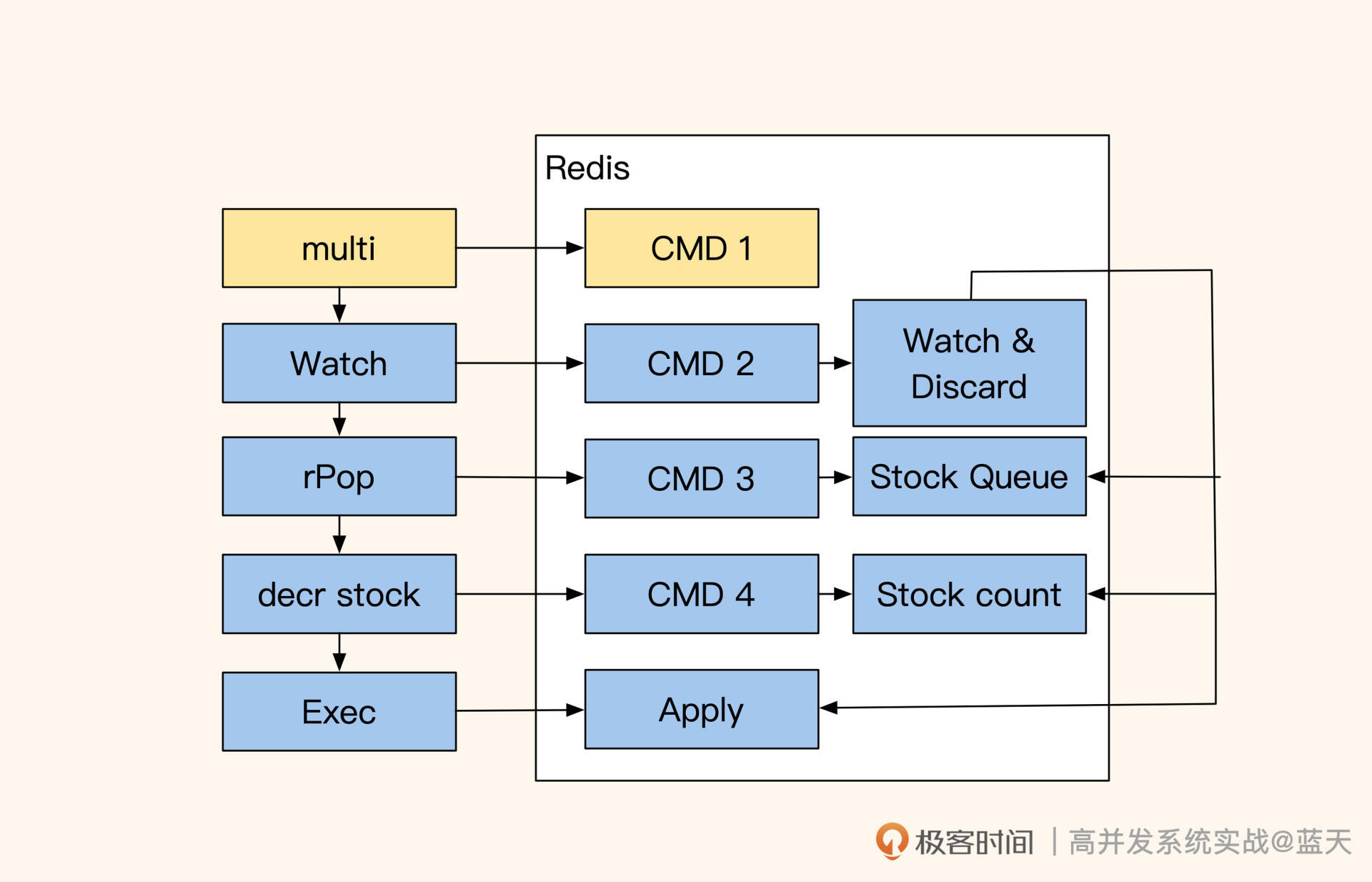

CAS 乐观锁:锁操作后置

除此之外我再推荐一个实现方式:CAS 乐观锁。相对于自旋互斥锁来说,它在并发争抢库存线程少的时候效率会更好。通常,我们用锁的实现方式是先抢锁,然后,再对数据进行操作。这个方式需要先抢到锁才能继续,而抢锁是有性能损耗的,即使没有其他线程抢锁,这个消耗仍旧存在。

CAS 乐观锁的核心实现为:记录或监控当前库存信息或版本号,对数据进行预操作。

如上图,在操作期间如果发现监控的数值有变化,那么就回滚之前操作;如果期间没有变化,就提交事务的完成操作,操作期间的所有动作都是事务的。

//开启事务

redis> multi

OK

// watch 修改值

// 在exec期间如果出现其他线程修改,那么会自动失败回滚执行discard

redis> watch prod_1475_stock_queue prod_1475_stock_1

//事务内对数据进行操作

redis> rpop prod_1475_stock_queue 1

QUEUED

//操作步骤2

redis> decr prod_1475_stock_1

QUEUED

//执行之前所有操作步骤

//multi 期间 watch有数值有变化则会回滚

redis> exec

3

可以看到,通过这个方式我们可以批量地快速实现库存扣减,并且能大幅减少锁争抢时间。它的好处我们刚才说过,就是争抢线程少时效率特别好,但争抢线程多时会需要大量重试,不过即便如此,CAS 乐观锁也会比用自旋锁实现的性能要好。

当采用这个方式的时候,我建议内部的操作步骤尽量少一些。同时要注意,如果 Redis 是 Cluster 模式,使用 multi 时必须在一个 slot 内才能保证原子性。

Redis Lua 方式实现 Redis 锁

与“事务 + 乐观锁”类似的实现方式还有一种,就是使用 Redis 的 Lua 脚本实现多步骤库存操作。因为 Lua 脚本内所有操作都是连续的,这个操作不会被其他操作打断,所以不存在锁争抢问题。

而且、可以根据不同的情况对 Lua 脚本做不同的操作,业务只需要执行指定的 Lua 脚本传递参数即可实现高性能扣减库存,这样可以大幅度减少业务多次请求等待的 RTT。

为了方便演示怎么执行 Lua 脚本,我使用了 PHP 实现:

<?php

$script = <<<EOF

// 获取当前库存个数

local stock=tonumber(redis.call('GET',KEYS[1]));

//没找到返回-1

if stock==nil

then

return -1;

end

//找到了扣减库存个数

local result=stock-ARGV[1];

//如扣减后少于指定个数,那么返回0

if result<0

then

return 0;

else

//如果扣减后仍旧大于0,那么将结果放回Redis内,并返回1

redis.call('SET',KEYS[1],result);

return 1;

end

EOF;

$redis = new \Redis();

$redis->connect('127.0.0.1', 6379);

$result = $redis->eval($script, array("prod_stock", 3), 1);

echo $result;

通过这个方式,我们可以远程注入各种连贯带逻辑的操作,并且可以实现一些补库存的操作。

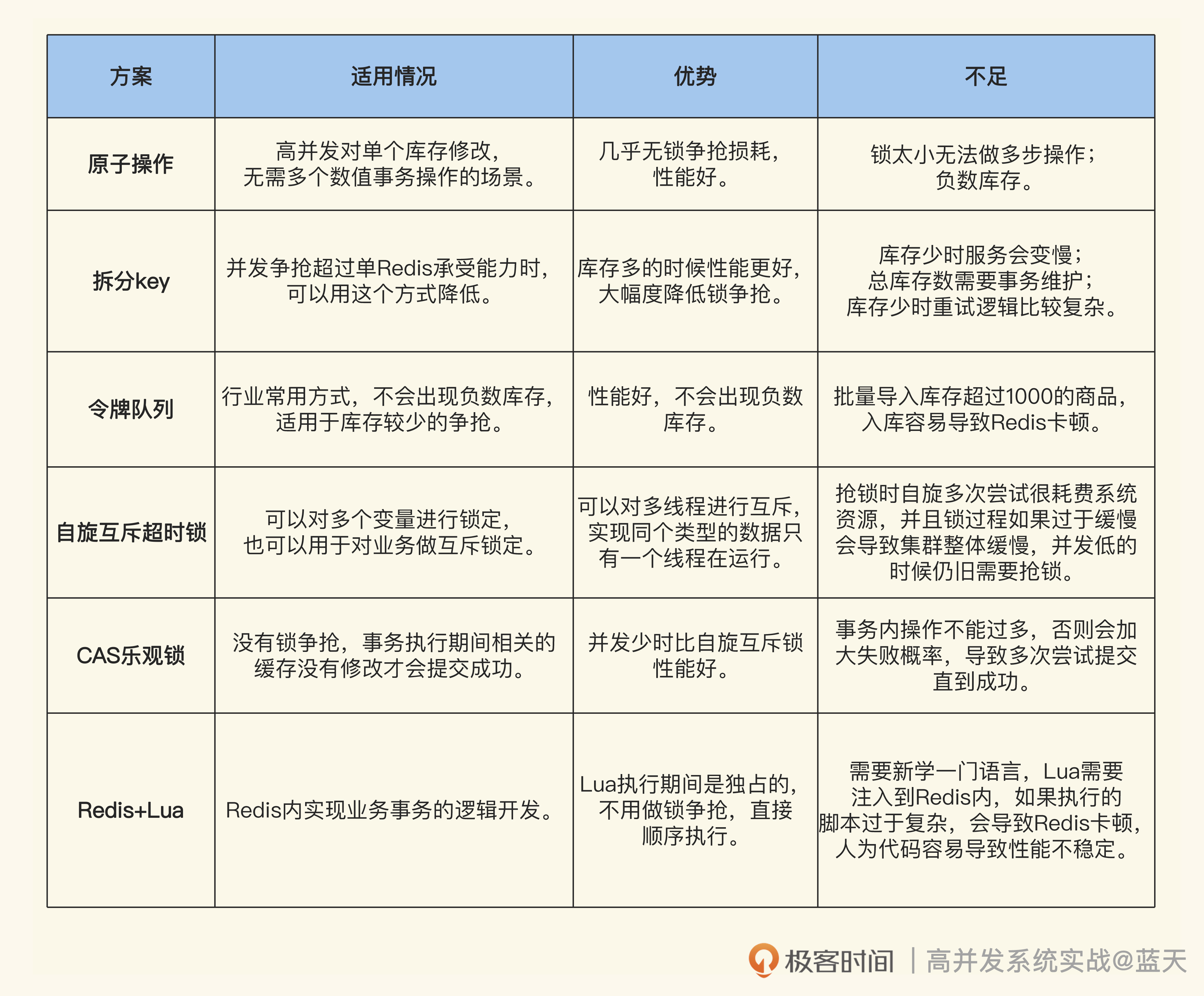

总结这节课,我们针对库存锁争抢的问题,通过 Redis 的特性实现了六种方案,不过它们各有优缺点

以上这些方法可以根据业务需要组合使用。

其实,我们用代码去实现锁定扣库存也能够实现库存争抢功能,比如本地 CAS 乐观锁方式,但是一般来说,我们自行实现的代码会和其他业务逻辑混在一起,会受到多方因素影响,业务代码会逐渐复杂,性能容易失控。而 Redis 是独立部署的,会比我们的业务代码拥有更好的系统资源去快速解决锁争抢问题。

你可能发现我们这节课讲的方案大多数只有一层“锁”,但很多业务场景实际存在多个锁的情况,并不是我不想介绍,而是十分不推荐,因为多层锁及锁重入等问题引入后会导致我们系统很难维护,一个小粒度的锁能解决我们大部分问题,何乐而不为呢?

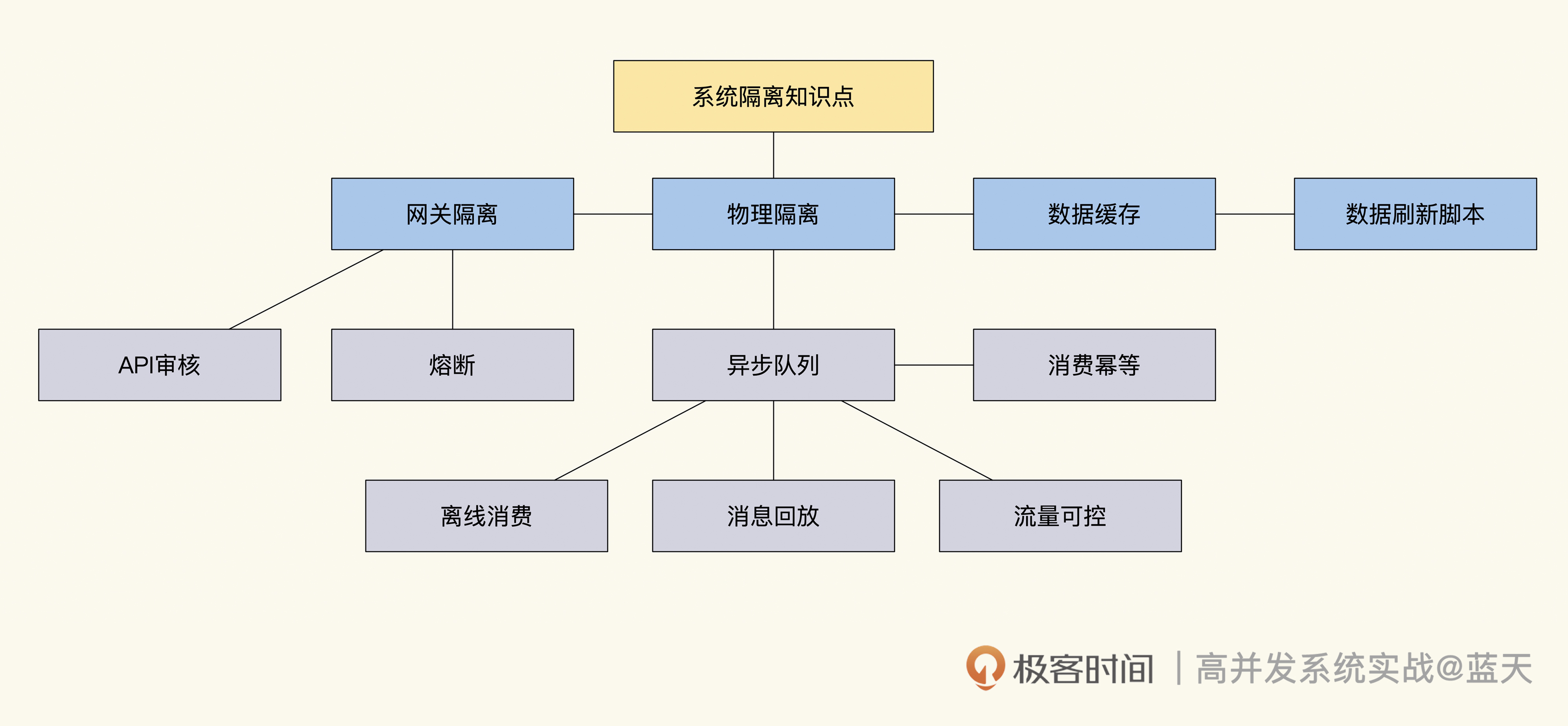

系统隔离:如何应对高并发流量冲击?

我曾经在一家教育培训公司做架构师,在一次续报活动中,我们的系统出现了大规模崩溃。在活动开始有五万左右的学员同时操作,大量请求瞬间冲击我们的服务器,导致服务端有大量请求堆积,最终系统资源耗尽停止响应。我们不得不重启服务,并对接口做了限流,服务才恢复正常。

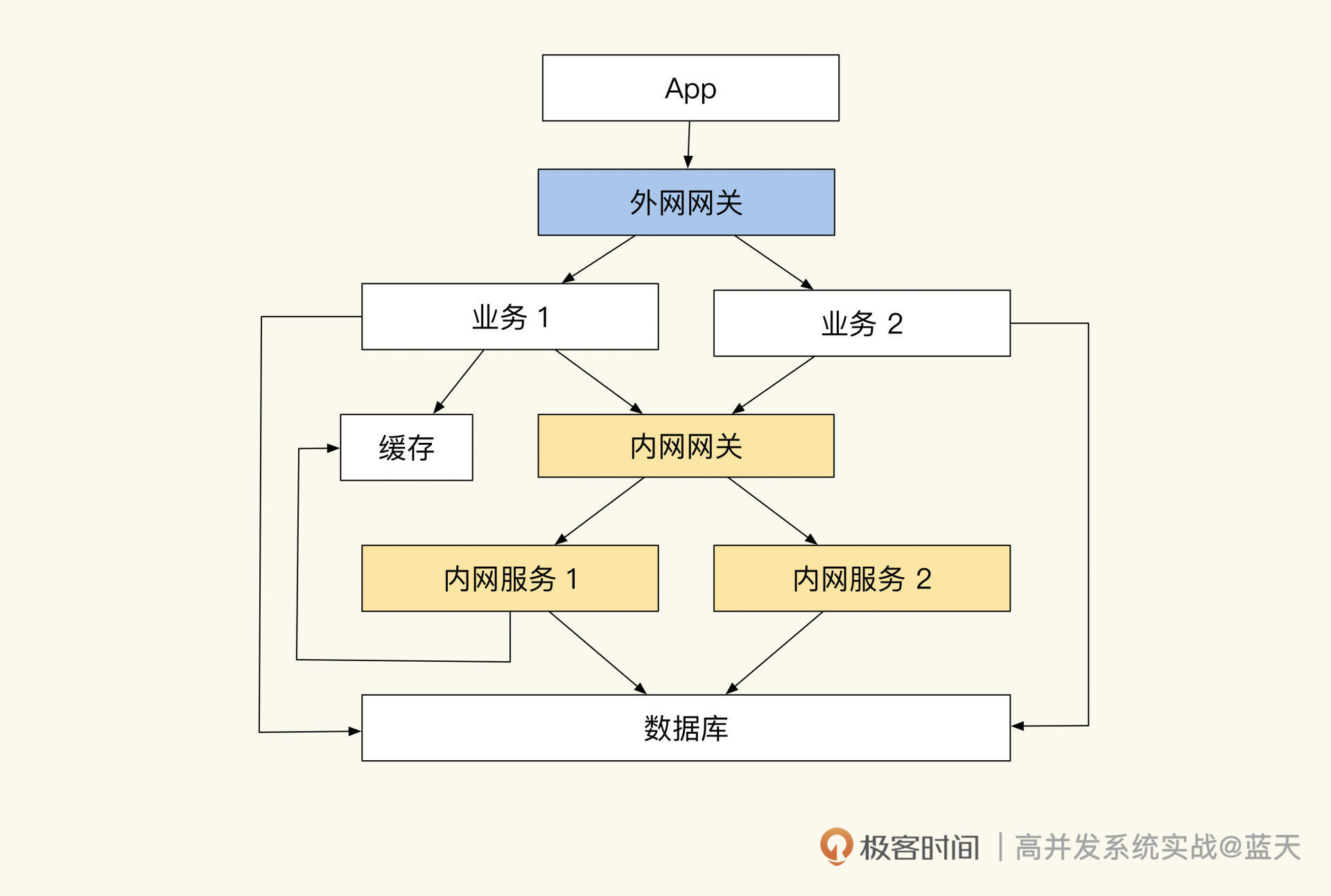

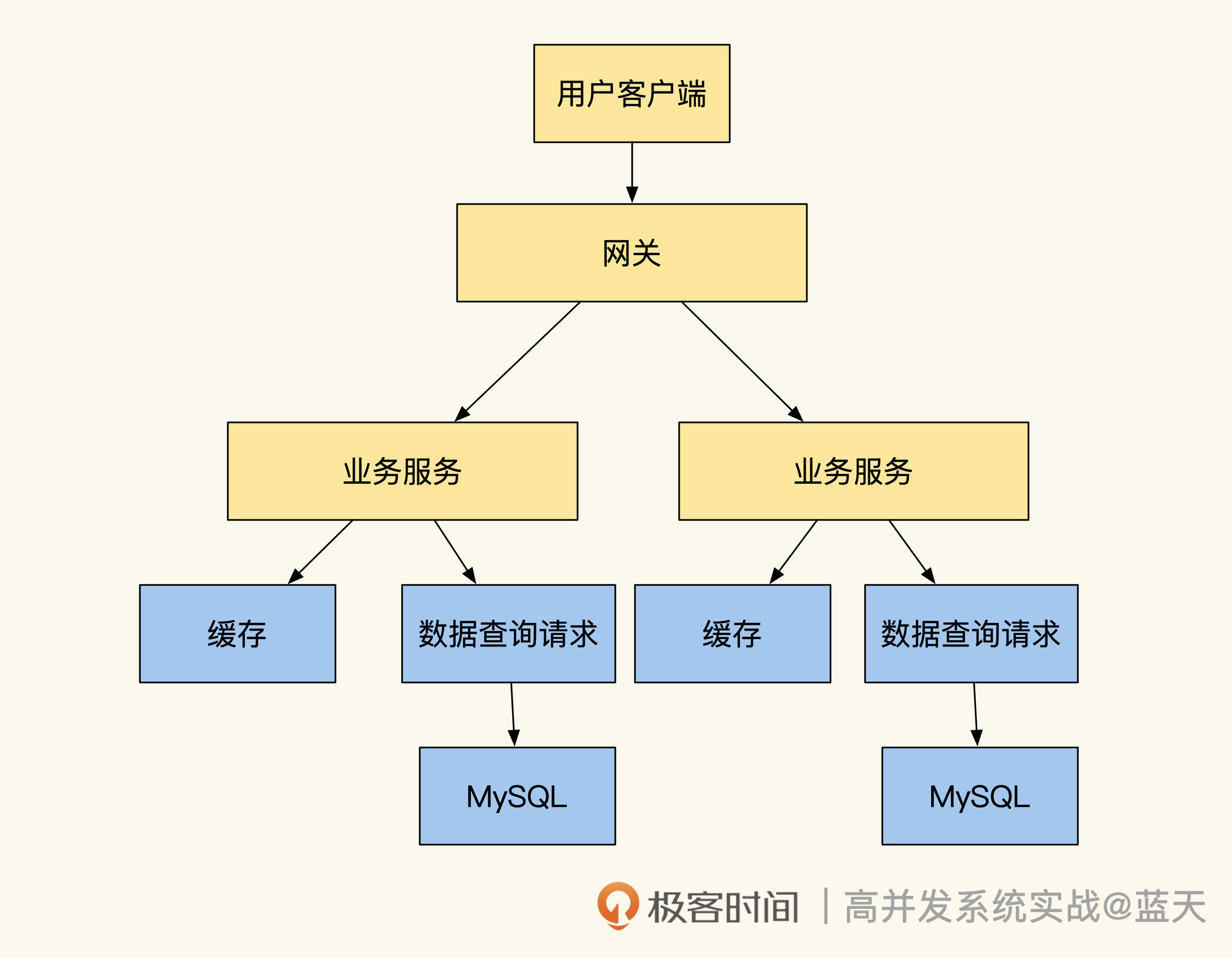

究其原因,我们习惯性地将公用的功能和数据做成了内网服务,这种方式虽然可以提高服务的复用性,但也让我们的服务非常依赖内网服务。当外网受到流量冲击时,内网也会受到放大流量的冲击,过高的流量很容易导致内网服务崩溃,进而最终导致整个网站无法响应。

事故后我们经过详细复盘,最终一致认为这次系统大规模崩溃,核心还是在于系统隔离性做得不好,业务极易相互影响。

改造前的系统部署结构

如果系统隔离性做得好,在受到大流量冲击时,只会影响被冲击的应用服务,即使某个业务因此崩溃,也不会影响到其他业务的正常运转。这就要求我们的架构要有能力隔离多个应用,并且能够隔离内外网流量,只有如此才能够保证系统的稳定。

拆分部署和物理隔离

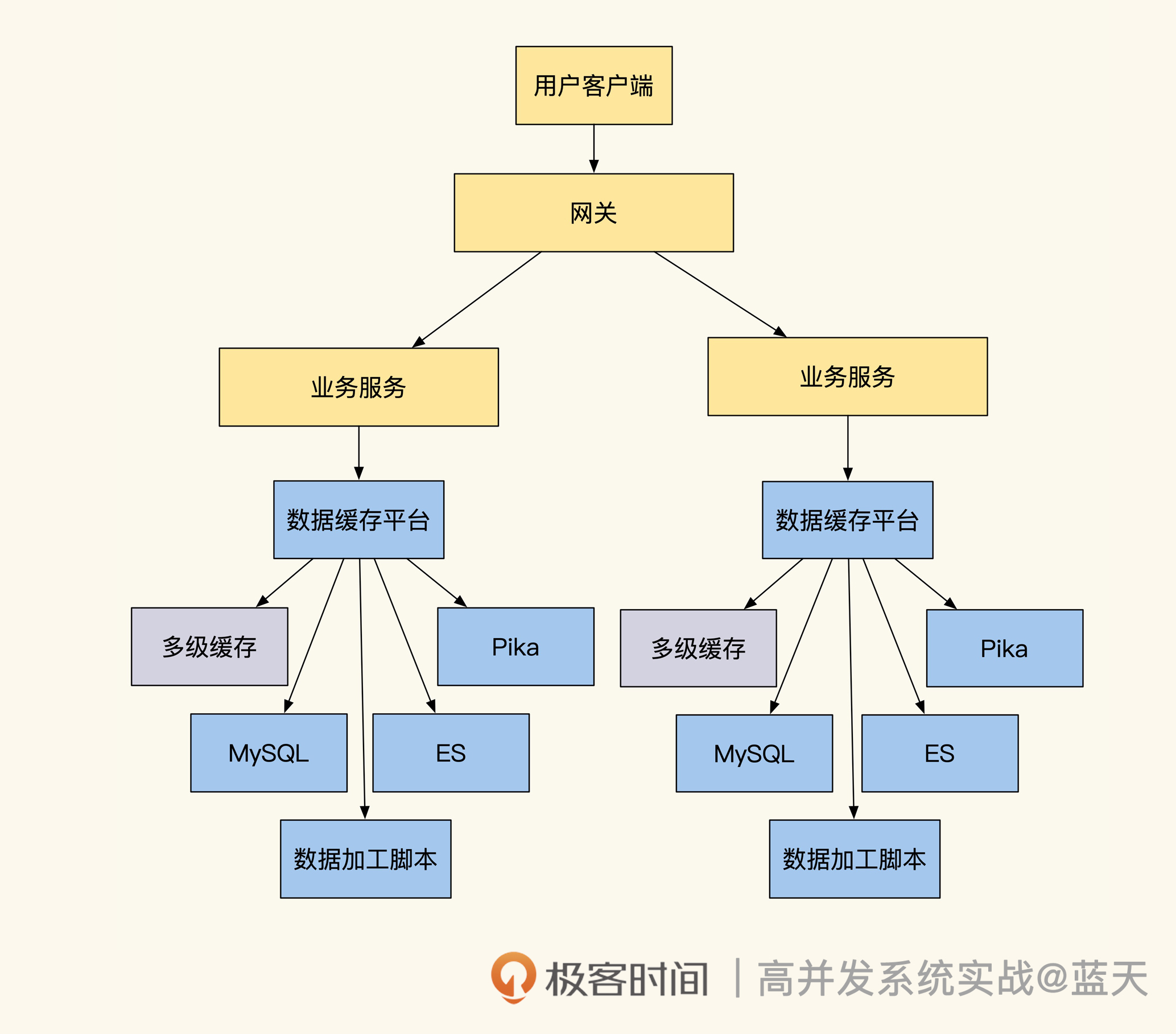

为了提高系统的稳定性,我们决定对系统做隔离改造,具体如下图:

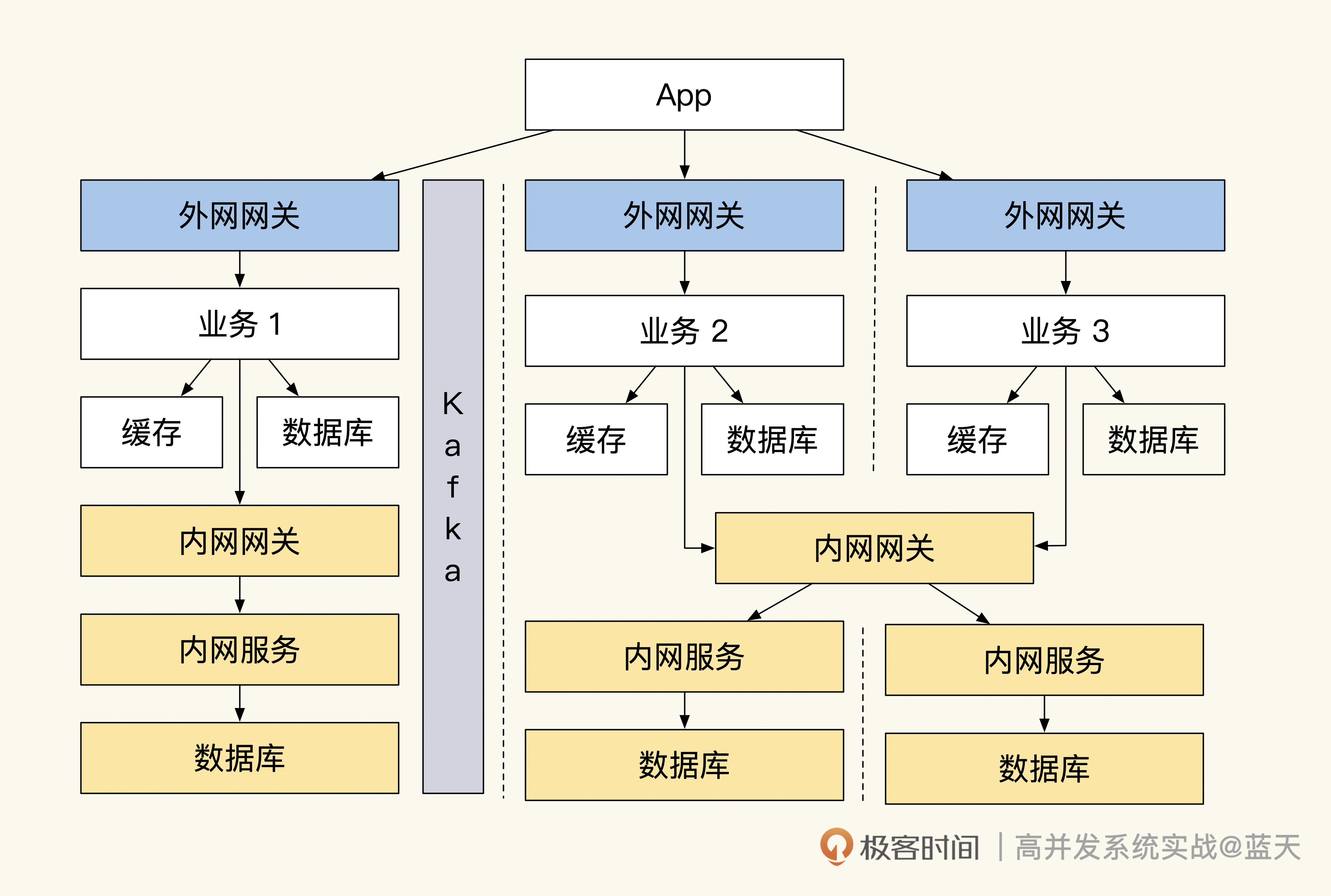

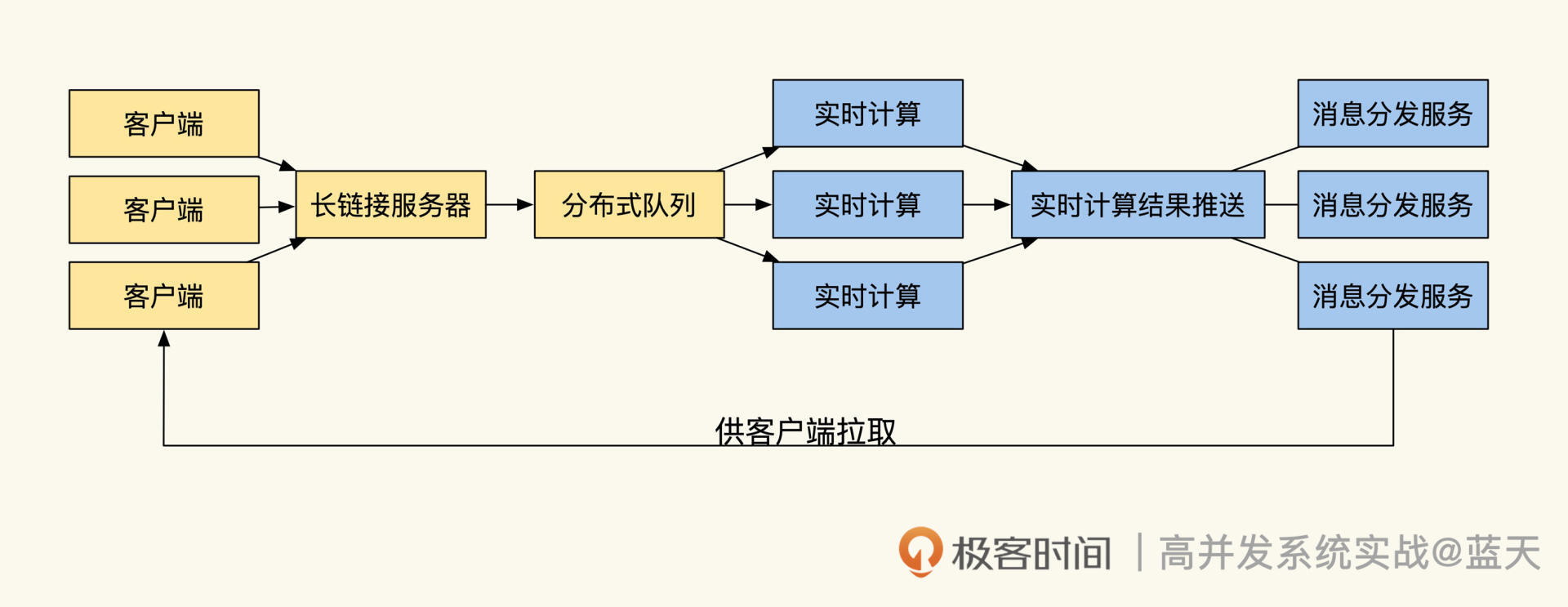

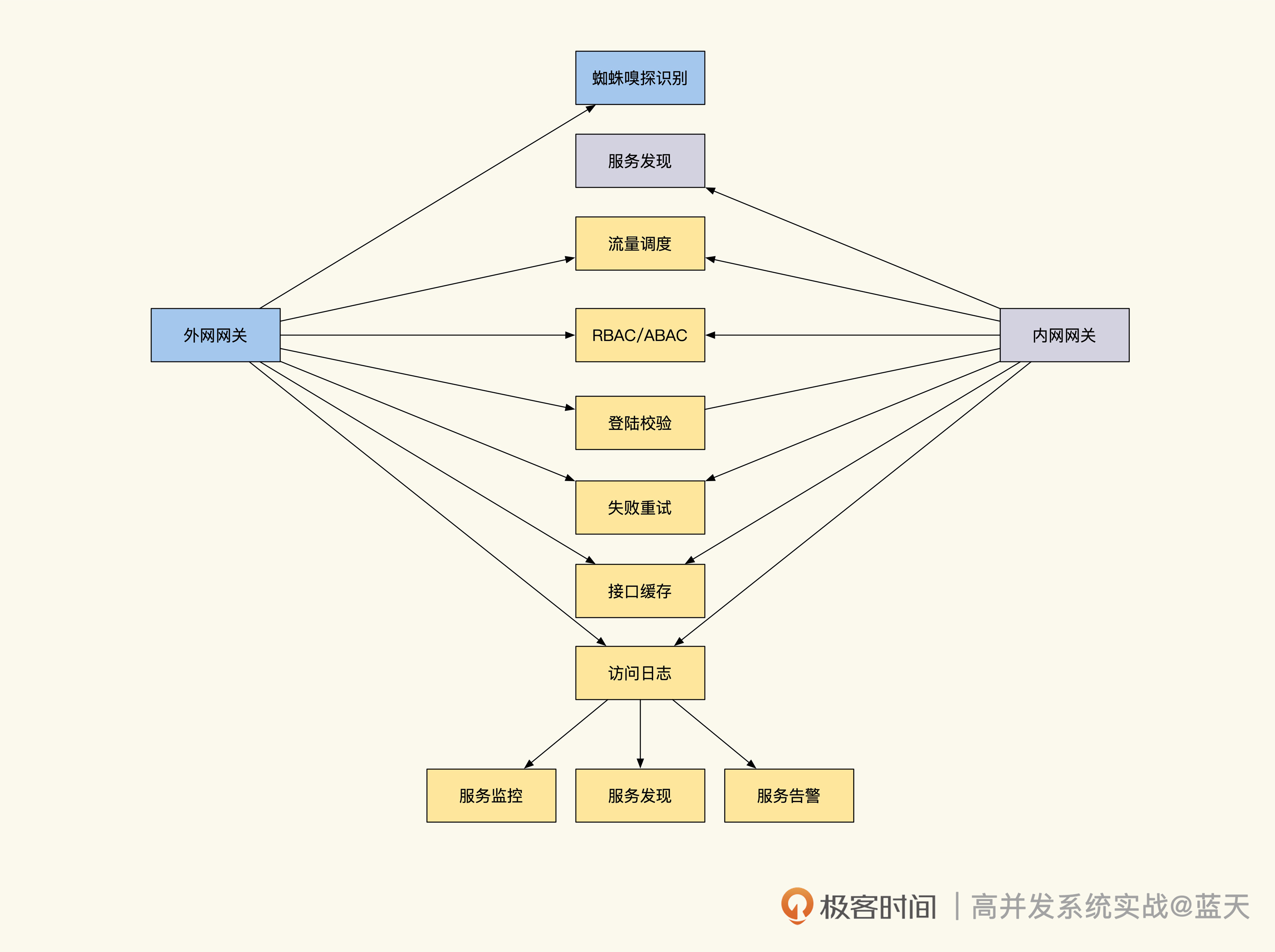

也就是说,每个内、外网服务都会部署在独立的集群内,同时每个项目都拥有自己的网关和数据库。而外网服务和内网必须通过网关才能访问,外网向内网同步数据是用 Kafka 来实现的。

网关隔离和随时熔断

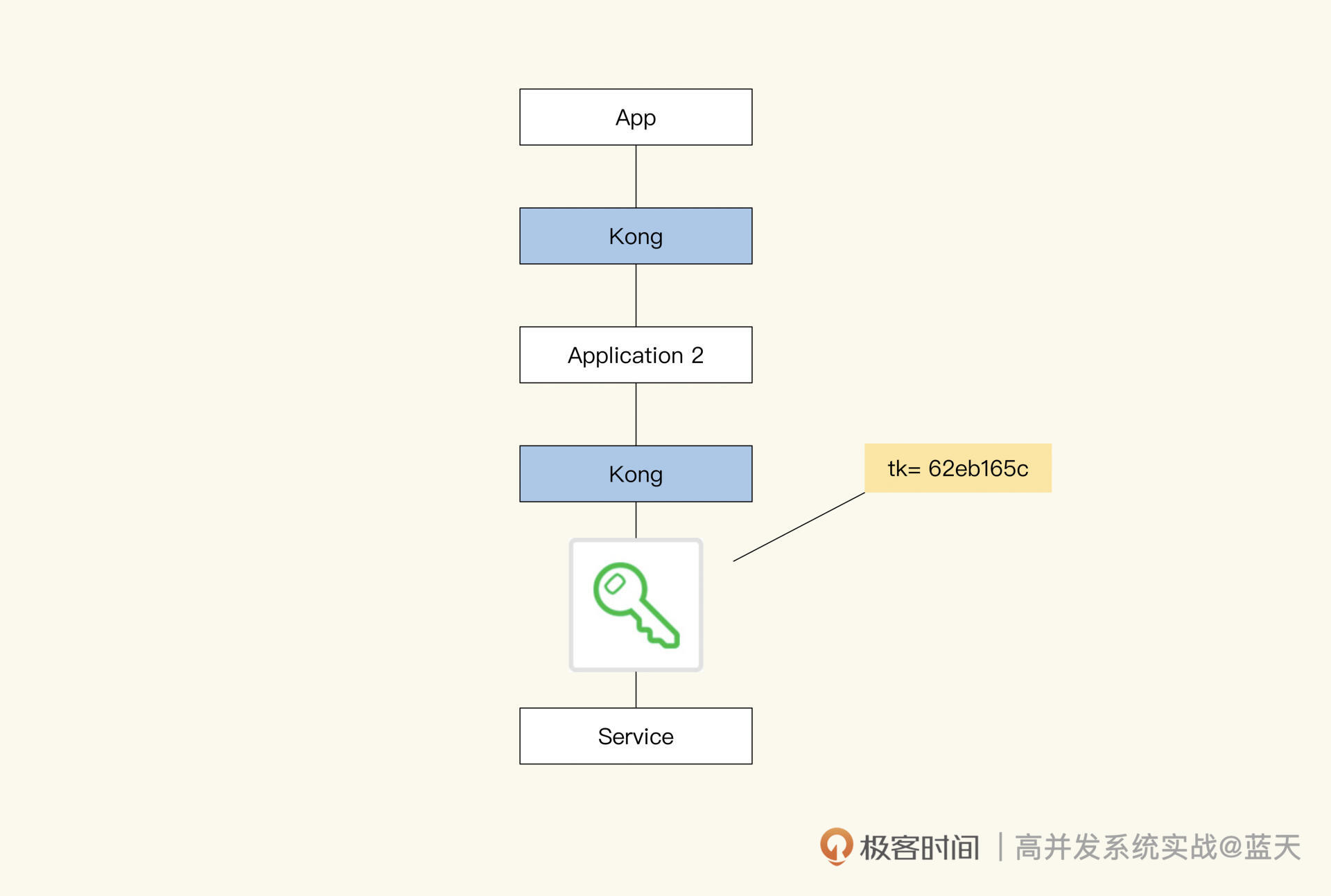

在这个改造方案中有两种网关:外网网关和内网网关。每个业务都拥有独立的外网网关(可根据需要调整)来对外网流量做限流。当瞬时流量超过系统承受能力时,网关会让超编的请求排队阻塞一会儿,等服务器 QPS 高峰过后才会放行,这个方式比起直接拒绝客户端请求来说,可以给用户更好的体验。

外网调用内网的接口必须通过内网网关。外网请求内网接口时,内网网关会对请求的来源系统和目标接口进行鉴权,注册授权过的外网服务只能访问对其授权过的内网接口,这样可以严格管理系统之间的接口调用。

同时,我们在开发期间要时刻注意,内网网关在流量增大的时候要做熔断,这样可以避免外网服务强依赖内网接口,保证外网服务的独立性,确保内网不受外网流量冲击。并且外网服务要保证内网网关断开后,仍旧能正常独立运转一小时以上。

但是你应该也发现了,这样的隔离不能实时调用内网接口,会给研发造成很大的困扰。要知道常见外网业务需要频繁调用内网服务获取基础数据才能正常工作,而且内网、外网同时对同一份数据做决策的话,很容易出现混乱。

减少内网 API 互动

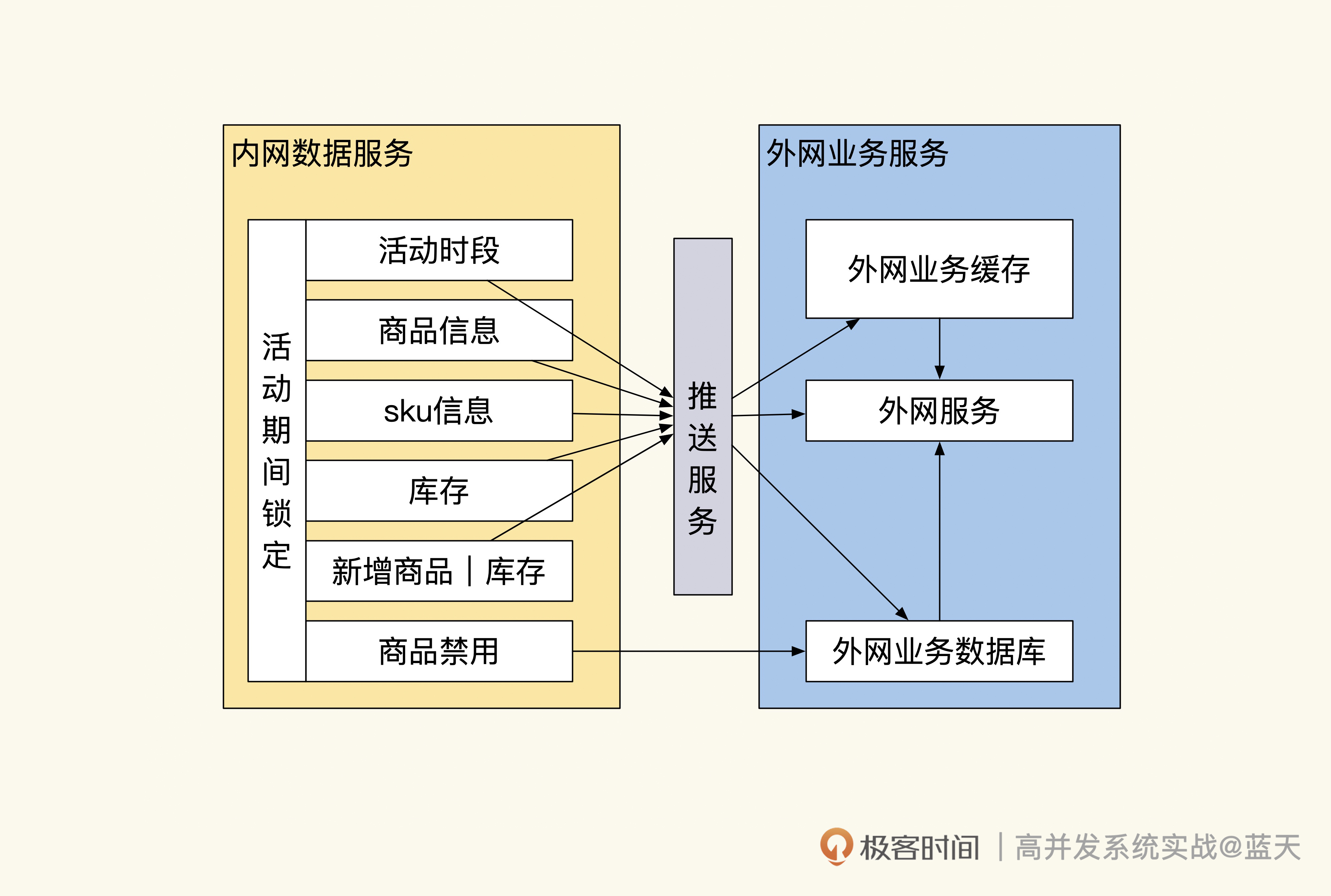

为了防止共享的数据被多个系统同时修改,我们会在活动期间把参与活动的数据和库存做推送,然后自动锁定,这样做可以防止其他业务和后台对数据做修改。若要禁售,则可以通过后台直接调用前台业务接口来操作;活动期间也可以添加新的商品到外网业务中,但只能增不能减。

通过缓存推送实现商品数据的同步

这样的实现方式既可以保证一段时间内数据决策的唯一性,也可以保证内外网的隔离性。

不过你要注意,这里的锁定操作只是为了保证数据同步不出现问题,活动高峰过后数据不能一直锁定,否则会让我们的业务很不灵活。

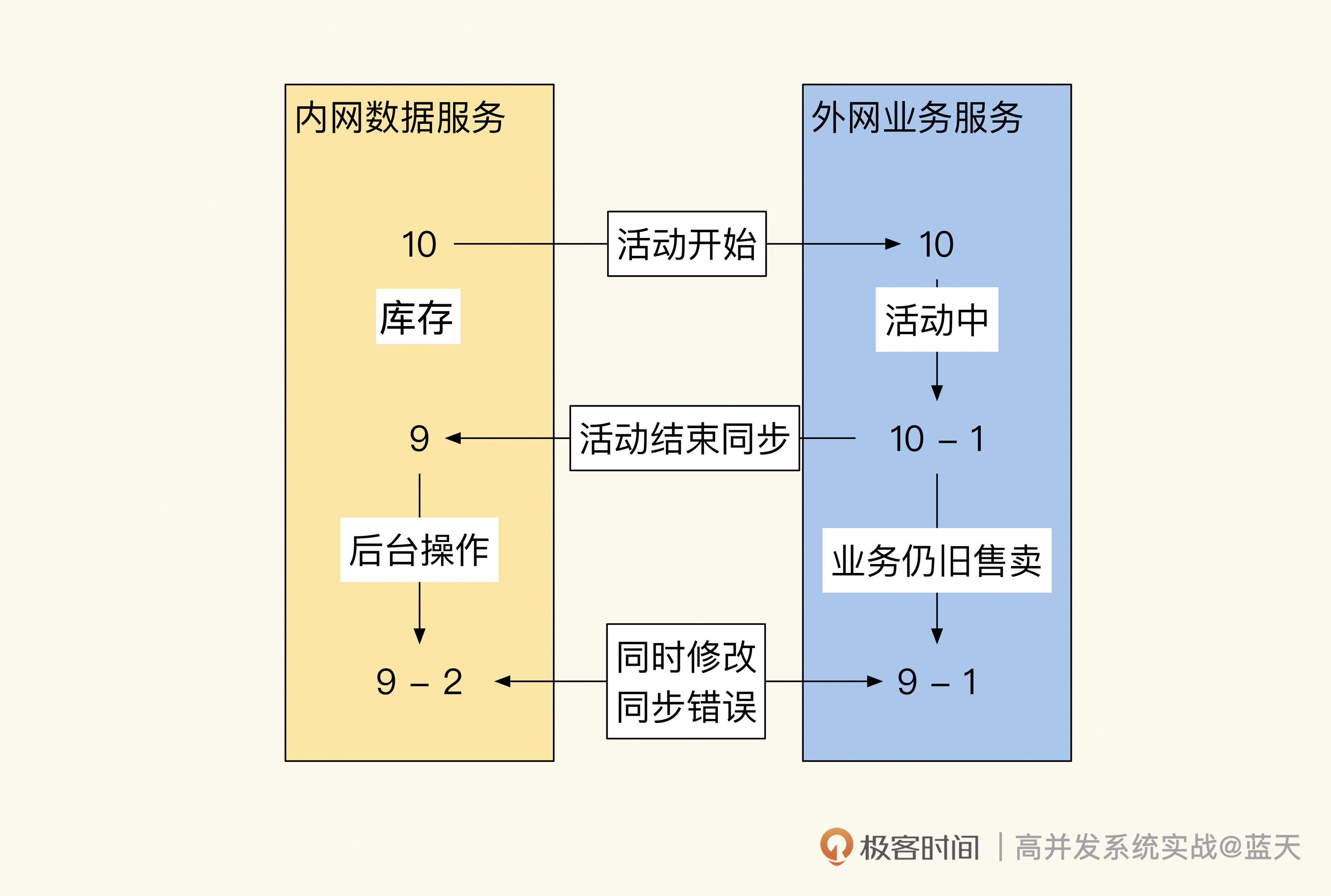

因为我们需要把活动交易结果同步回内网,而同步期间外网还是能继续交易的。如果不保持锁定,数据的流向不小心会成为双向同步,这种双向同步很容易出现混乱,系统要是因此出现问题就很难修复,如下图:

并发决策会导致数据无法决策同步

我们从图中可以看到,两个系统因为没有实时互动的接口,数据是完全独立的,但是在回传外网数据到内网时,库存如果在两个系统之间来回传递,就很容易出现同步冲突进而导致混乱。那怎么避免类似的问题呢?

其实只有保证数据同步是单向的,才能取消相互锁定操作。我们可以规定所有库存决策由外网业务服务决定,后台对库存操作时必须经过外网业务决策后才能继续操作,这样的方式比锁定数据更加灵活。而外网交易后要向内网同步交易结果,只能通过队列方式推送到内网。

事实上,使用队列同步数据并不容易,其中有很多流程和细节需要我们去打磨,以减少不同步的情况。好在我们使用的队列很成熟,提供了很多方便的特性帮助我们降低同步风险。

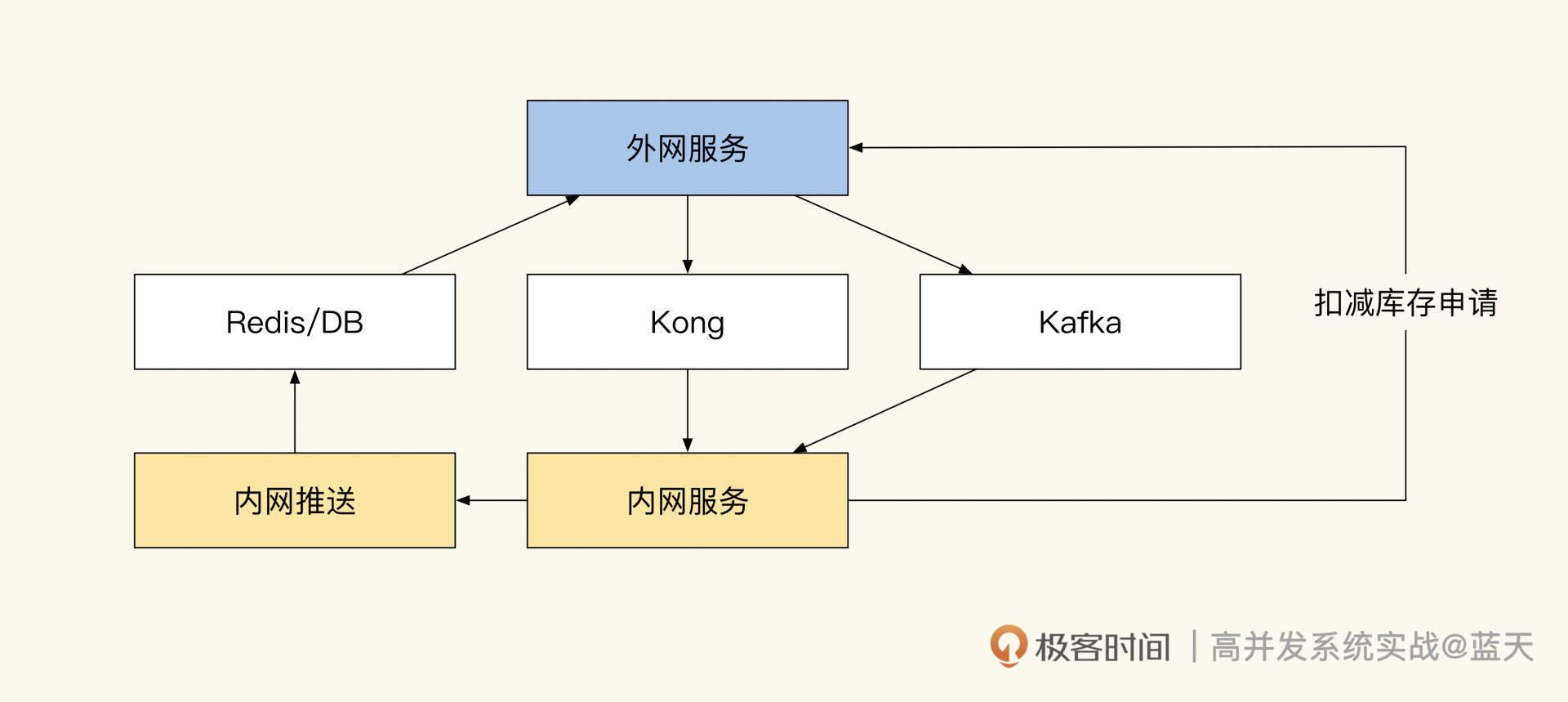

在我们来看下整体的数据流转,如下图:

数据流转

后台系统推送数据到 Redis 或数据库中,外网服务通过 Kafka 把结果同步到内网,扣减库存需通知外网服务扣减成功后方可同步操作。

分布式队列控流和离线同步

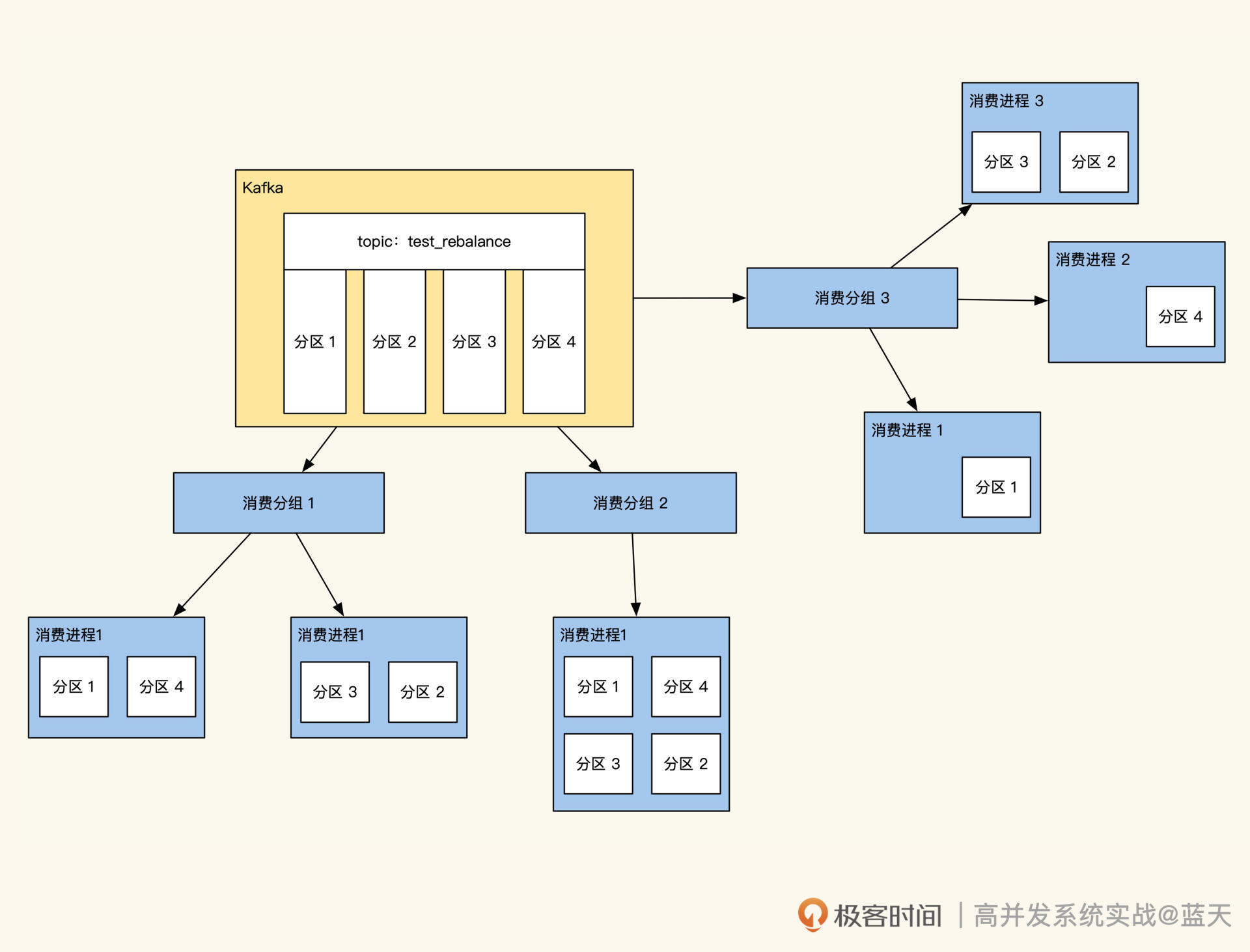

我们刚才提到,外网和内网做同步用的是 Kafka 分布式队列,主要因为它有以下几个优点:

- 队列拥有良好吞吐并且能够动态扩容,可应对各种流量冲击场景;

- 可通过动态控制内网消费线程数,从而实现内网流量可控;

- 内网消费服务在高峰期可以暂时离线,内网服务可以临时做一些停机升级操作;

- 内网服务如果出现 bug,导致消费数据丢失,可以对队列消息进行回放实现重新消费;

- Kafka 是分区消息同步,消息是顺序的,很少会乱序,可以帮我们实现顺序同步;

- 消息内容可以保存很久,加入 TraceID 后查找方便并且透明,利于排查各种问题。

两个系统之间的数据同步是一件很复杂、很繁琐的事情,而使用 Kafka 可以把这个实时过程变成异步的,再加上消息可回放,流量也可控,整个过程变得轻松很多。

在“数据同步”中最难的一步就是保证顺序,接下来我具体介绍一下我们当时是怎么做的。

当用户在外网业务系统下单购买一个商品时,外网服务会扣减本地缓存中的库存。库存扣减成功后,外网会创建一个订单并发送创建订单消息到消息队列中。当用户在外网业务支付订单后,外网业务订单状态会更新为“已支付”,并给内网发送支付成功的消息到消息队列中,发送消息实现如下:

type ShopOrder struct {

TraceId string `json:trace_id` // trace id 方便跟踪问题

OrderNo string `json:order_no` // 订单号

ProductId string `json:"product_id"` // 课程id

Sku string `json:"sku"` // 课程规格 sku

ClassId int32 `json:"class_id"` // 班级id

Amount int32 `json:amount,string` // 金额,分

Uid int64 `json:uid,string` // 用户uid

Action string `json:"action"` // 当前动作 create:创建订单、pay:支付订单、refund:退费、close:关闭订单

Status int16 `json:"status"` // 当前订单状态 0 创建 1 支付 2 退款 3 关闭

Version int32 `json:"version"` // 版本,会用当前时间加毫秒生成一个时间版本,方便后端对比操作版本,如果收到消息的版本比上次操作的时间还小忽略这个事件

UpdateTime int32 `json:"update_time"` // 最后更新时间

CreateTime int32 `json:"create_time"` // 订单创建日期

}

//发送消息到内网订单系统

resp, err := sendQueueEvent("order_event", shopOrder{...略}, 消息所在分区)

if err != nil {

return nil, err

}

return resp, nil

可以看到,我们在发送消息的时候已经通过某些依据(如订单号、uid)算出这条消息应该投放到哪个分区内,Kafka 同一个分区内的消息是顺序的。

那为什么要保证消费顺序呢?其实核心在于我们的数据操作必须按顺序执行,如果不按顺序,就会出现很多奇怪的场景。

比如“用户执行创建订单、支付订单、退费”这一系列操作,消费进程很有可能会先收到退费消息,但由于还没收到创建订单和支付订单的消息,退费操作在此时就无法进行。

当然,这只是个简单的例子,如果碰到更多步骤乱序的话,数据会更加混乱。所以我们如果想做好数据同步,就要尽量保证数据是顺序的。

不过,我们在前面讲 Kafka 的优点时也提到了,队列在大部分时间是能够保证顺序性的,但是在极端情况下仍会有乱序发生。为此,我们在业务逻辑上需要做兼容,即使无法自动解决,也要记录好相关日志以方便后续排查问题。

不难发现,因为这个“顺序”的要求,我们的数据同步存在很大难度,好在 Kafka 是能够长时间保存消息的。如果在同步过程中出现问题,除了通过日志对故障进行修复外,我们还可以将故障期间的流量进行重放(重放要保证同步幂等)。

这个特性让我们可以做很多灵活的操作,甚至可以在流量高峰期,暂时停掉内网消费服务,待系统稳定后再开启,落地用户的交易。

除了数据同步外,我们还需要对内网的流量做到掌控,我们可以通过动态控制线程数来实现控制内网流量的速度。好,今天这节课就讲到这里,相信你已经对“如何做好系统隔离”这个问题有了比较深入的理解,期望你在生产过程中能具体实践一下这个方案。

总结

系统的隔离需要我们投入大量的时间和精力去打磨,这节课讲了很多会对系统稳定性产生影响的关键特性,让我们整体回顾一下。

为了实现系统的隔离,我们在外网服务和内网服务之间设立了接口网关,只有通过网关才能调用内网接口服务。并且我们设定了在大流量冲击期间,用熔断内网接口的交互方式来保护内网。而外网所需的所有数据,在活动开始之前都要通过内网脚本推送到商城本地的缓存中,以此来保证业务的运转。

同时,外网成功成交的订单和同步信息通过分布式、可实时扩容和可回放的消息队列投递到了内网,内网会根据内部负载调整消费线程数来实现流量可控的消息消费。由此,我们实现了两个系统之间的同步互动。

我把这节课的关键知识画成了导图,供你参考:

分布式事务:多服务的2PC、TCC都是怎么实现的?

目前业界流行微服务,DDD 领域驱动设计也随之流行起来。DDD 是一种拆分微服务的方法,它从业务流程的视角从上往下拆分领域,通过聚合根关联多个领域,将多个流程聚合在一起,形成独立的服务。相比由数据表结构设计出的微服务,DDD 这种方式更加合理,但也加大了分布式事务的实现难度。

在传统的分布式事务实现方式中,我们普遍会将一个完整的事务放在一个独立的项目中统一维护,并在一个数据库中统一处理所有的操作。这样在出现问题时,直接一起回滚,即可保证数据的互斥和统一性。

不过,这种方式的服务复用性和隔离性较差,很多核心业务为了事务的一致性只能聚合在一起。

为了保证一致性,事务在执行期间会互斥锁定大量的数据,导致服务整体性能存在瓶颈。而非核心业务要想在隔离要求高的系统架构中,实现跨微服务的事务,难度更大,因为核心业务基本不会配合非核心业务做改造,再加上核心业务经常随业务需求改动(聚合的业务过多),结果就是非核心业务没法做事务,核心业务也无法做个性化改造。

也正因为如此,多个系统要想在互动的同时保持事务一致性,是一个令人头疼的问题,业内很多非核心业务无法和核心模块一起开启事务,经常出现操作出错,需要人工补偿修复的情况。

尤其在微服务架构或用 DDD 方式实现的系统中,服务被拆分得更细,并且都是独立部署,拥有独立的数据库,这就导致要想保持事务一致性实现就更难了,因此跨越多个服务实现分布式事务已成为刚需。

好在目前业内有很多实现分布式事务的方式,比如 2PC、3PC、TCC 等,但究竟用哪种比较合适呢?这是我们需要重点关注的。因此,这节课我会带你对分布式事务做一些讨论,让你对分布式事务有更深的认识,帮你做出更好的决策。

XA 协议

XA 协议是一个很流行的分布式事务协议,可以很好地支撑我们实现分布式事务,比如常见的 2PC、3PC 等。这个协议适合在多个数据库中,协调分布式事务,目前 Oracle、DB2、MySQL 5.7.7 以上版本都支持它(虽然有很多 bug)。而理解了 XA 协议,对我们深入了解分布式事务的本质很有帮助。

支持 XA 协议的数据库可以在客户端断开的情况下,将执行好的业务结果暂存起来,直到另外一个进程确认才会最终提交或回滚事务,这样就能轻松实现多个数据库的事务一致性。

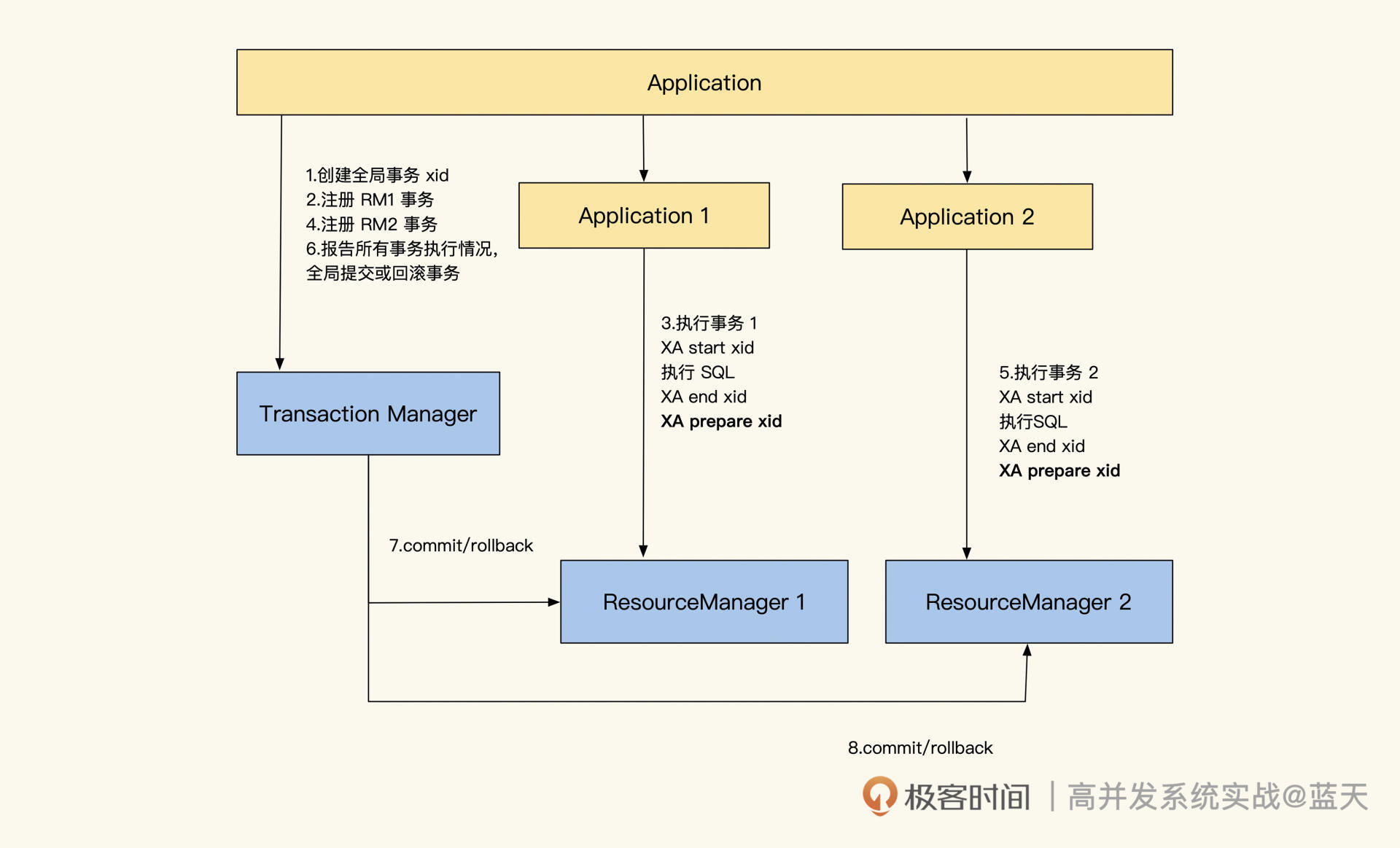

在 XA 协议里有三个主要的角色:

- 应用(AP):应用是具体的业务逻辑代码实现,业务逻辑通过请求事务协调器开启全局事务,在事务协调器注册多个子事务后,业务代码会依次给所有参与事务的子业务下发请求。待所有子业务提交成功后,业务代码根据返回情况告诉事务协调器各个子事务的执行情况,由事务协调器决策子事务是提交还是回滚(有些实现是事务协调器发请求给子服务)。

- 事务协调器(TM):用于创建主事务,同时协调各个子事务。事务协调器会根据各个子事务的执行情况,决策这些子事务最终是提交执行结果,还是回滚执行结果。此外,事务协调器很多时候还会自动帮我们提交事务;

- 资源管理器(RM):是一种支持事务或 XA 协议的数据资源,比如 MySQL、Redis 等。

另外,XA 还对分布式事务规定了两个阶段:Prepare 阶段和 Commit 阶段。

在 Prepare 阶段,事务协调器会通过 xid(事务唯一标识,由业务或事务协调器生成)协调多个资源管理器执行子事务,所有子事务执行成功后会向事务协调器汇报。

这时的子事务执行成功是指事务内 SQL 执行成功,并没有执行事务的最终 commit(提交),所有子事务是提交还是回滚,需要等事务协调器做最终决策。

接着分布式事务进入 Commit 阶段:当事务协调器收到所有资源管理器成功执行子事务的消息后,会记录事务执行成功,并对子事务做真正提交。如果 Prepare 阶段有子事务失败,或者事务协调器在一段时间内没有收到所有子事务执行成功的消息,就会通知所有资源管理器对子事务执行回滚的操作。

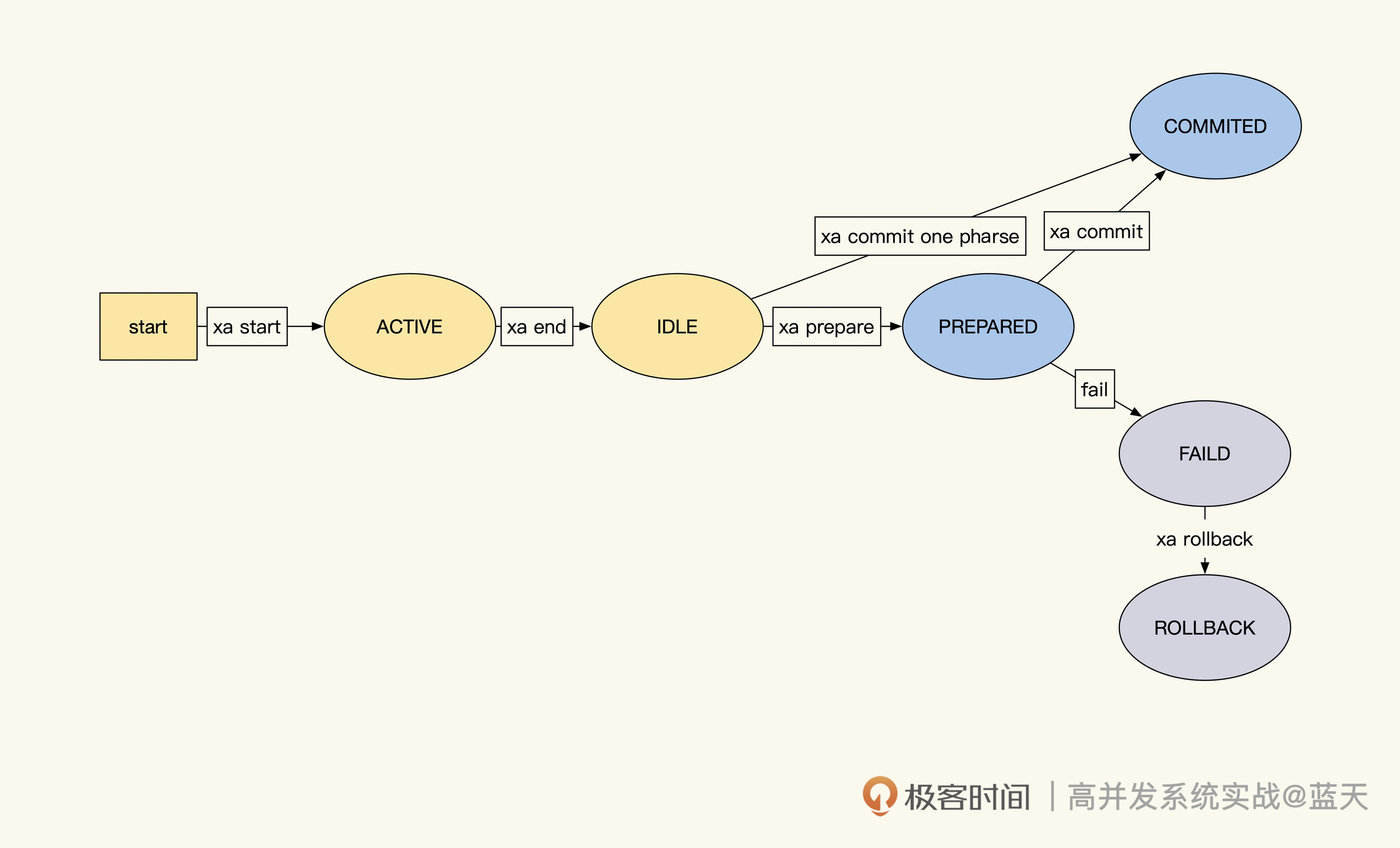

需要说明的是,每个子事务都有多个状态,每个状态的流转情况如下图所示:

如上图,子事务有四个阶段的状态:

- ACTIVE:子事务 SQL 正在执行中;

- IDLE:子事务执行完毕等待切换 Prepared 状态,如果本次操作不参与回滚,就可以直接提交完成;

- PREPARED:子事务执行完毕,等待其他服务实例的子事务全部 Ready。

- COMMITED/FAILED:所有子事务执行成功 / 失败后,一起提交或回滚。

下面我们来看 XA 协调两个事务的具体流程,这里我拿最常见的 2PC 方式为例进行讲解。

XA 协调两个服务的分布式事务过程

如上图所示,在协调两个服务 Application 1 和 Application 2 时,业务会先请求事务协调器创建全局事务,同时生成全局事务的唯一标识 xid,然后再在事务协调器里分别注册两个子事务,生成每个子事务对应的 xid。这里说明一下,xid 由 gtrid+bqual+formatID 组成,多个子事务的 gtrid 是相同的,但其他部分必须区分开,防止这些服务在一个数据库下。

那么有了子事务的 xid,被请求的服务会通过 xid 标识开启 XA 子事务,让 XA 子事务执行业务操作。当事务数据操作都执行完毕后,子事务会执行 Prepare 指令,将子事务标注为 Prepared 状态,然后以同样的方式执行 xid2 事务。

所有子事务执行完毕后,Prepared 状态的 XA 事务会暂存在 MySQL 中,即使业务暂时断开,事务也会存在。这时,业务代码请求事务协调器通知所有申请的子事务全部执行成功。与此同时,TM 会通知 RM1 和 RM2 执行最终的 commit(或调用每个业务封装的提交接口)。

至此,整个事务流程执行完毕。而在 Prepare 阶段,如果有子事务执行失败,程序或事务协调器,就会通知所有已经在 Prepared 状态的事务执行回滚。

以上就是 XA 协议实现多个子系统的事务一致性的过程,可以说大部分的分布式事务都是使用类似的方式实现的。下面我们通过一个案例,看看 XA 协议在 MySQL 中的指令是如何使用的。

MySQL XA 的 2PC 分布式事务

在进入案例之前,你可以先了解一下 MySQL 中,所有关 XA 协议的指令集,以方便接下来的学习:

# 开启一个事务Id为xid的XA子事务

# gtrid是事务主ID,bqual是子事务标识

# formatid是数据类型标注 类似format type

XA {START|BEGIN} xid[gtrid[,bqual[,format_id]]] [JOIN|RESUME]

# 结束xid的子事务,这个事务会标注为IDLE状态

# 如果IDEL状态直接执行XA COMMIT提交那么就是 1PC

XA END xid [SUSPEND [FOR MIGRATE]]

# 让子事务处于Prepared状态,等待其他子事务处理后,后续统一最终提交或回滚

# 另外 在这个操作之前如果断开链接,之前执行的事务都会回滚

XA PREPARE xid

# 上面不同子事务 用不同的xid(gtrid一致,如果在一个实例bqual必须不同)

# 指定xid子事务最终提交

XA COMMIT xid [ONE PHASE]

XA ROLLBACK xid 子事务最终回滚

# 查看处于Prepared状态的事务

# 我们用这个来确认事务进展情况,借此决定是否整体提交

# 即使提交链接断开了,我们用这个仍旧能看到所有的PrepareD状态的事务

#

XA RECOVER [CONVERT XID]

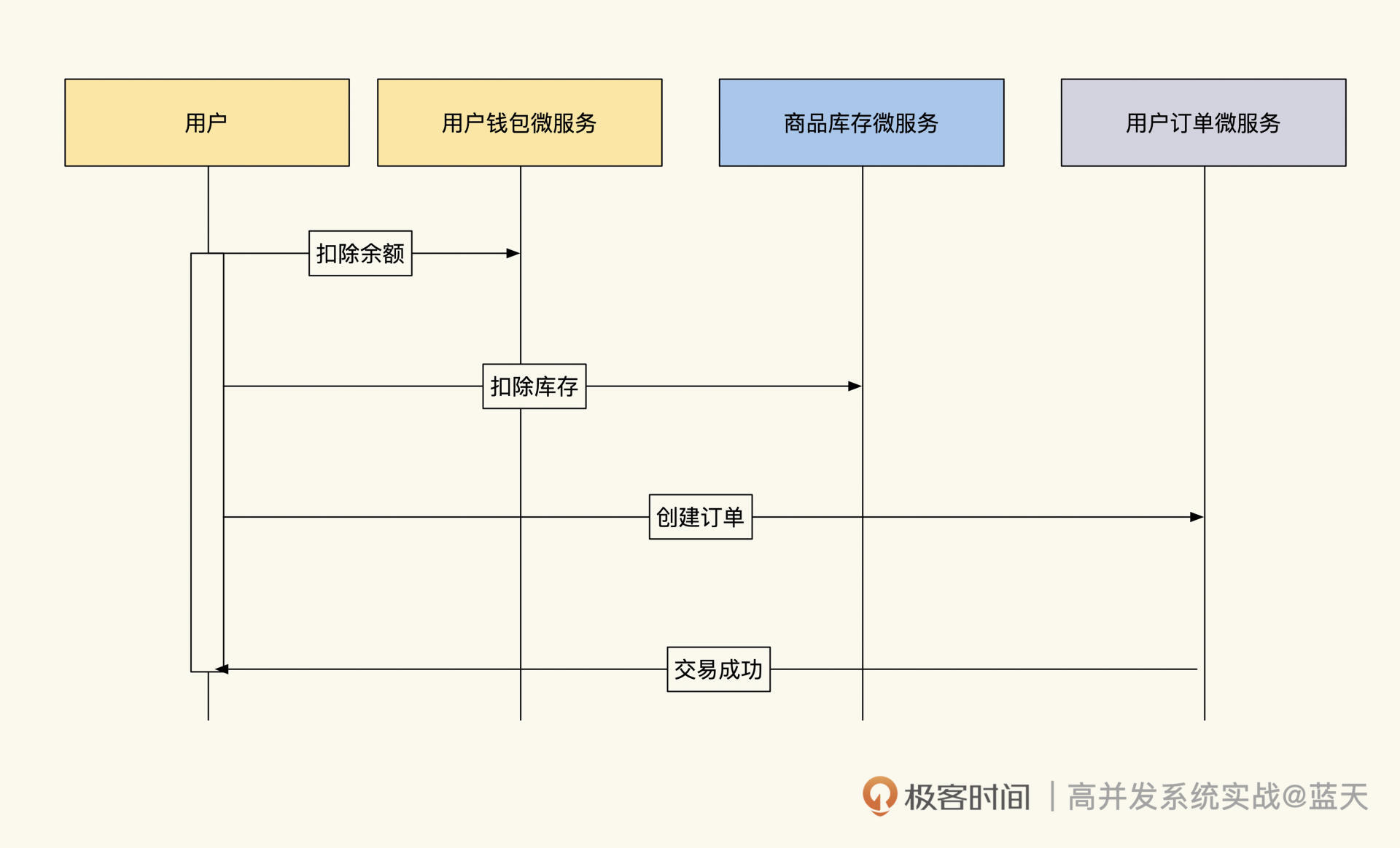

言归正传,我们以购物场景为例,在购物的整个事务流程中,需要协调的服务有三个:用户钱包、商品库存和用户购物订单,它们的数据都放在私有的数据库中。

用户购物

按照业务流程,用户在购买商品时,系统需要执行扣库存、生成购物订单和扣除用户账户余额的操作 。其中,“扣库存”和“扣除用户账户余额”是为了保证数据的准确和一致性,所以扣减过程中,要在事务操作期间锁定互斥的其他线程操作保证一致性,然后通过 2PC 方式,对三个服务实现事务协调。

具体实现代码如下:

package main

import (

"database/sql"

"fmt"

_ "github.com/go-sql-driver/mysql"

"strconv"

"time"

)

func main() {

// 库存的连接

stockDb, err := sql.Open("mysql", "root:paswd@tcp(127.0.0.1:3306)/shop_product_stock")

if err != nil {

panic(err.Error())

}

defer stockDb.Close()

//订单的连接

orderDb, err := sql.Open("mysql", "root:paswd@tcp(127.0.0.1:3307)/shop_order")

if err != nil {

panic(err.Error())

}

defer orderDb.Close()

//钱包的连接

moneyDb, err := sql.Open("mysql", "root:paswd@tcp(127.0.0.1:3308)/user_money_bag")

if err != nil {

panic(err.Error())

}

defer moneyDb.Close()

// 生成xid(如果在同一个数据库,子事务不能使用相同xid)

xid := strconv.FormatInt(time.Now().UnixMilli(), 10)

//如果后续执行过程有报错,那么回滚所有子事务

defer func() {

if err := recover(); err != nil {

stockDb.Exec("XA ROLLBACK ?", xid)

orderDb.Exec("XA ROLLBACK ?", xid)

moneyDb.Exec("XA ROLLBACK ?", xid)

}

}()

// 第一阶段 Prepare

// 库存 子事务启动

if _, err = stockDb.Exec("XA START ?", xid); err != nil {

panic(err.Error())

}

//扣除库存,这里省略了数据行锁操作

if _, err = stockDb.Exec("update product_stock set stock=stock-1 where id =1"); err != nil {

panic(err.Error())

}

//事务执行结束

if _, err = stockDb.Exec("XA END ?", xid); err != nil {

panic(err.Error())

}

//设置库存任务为Prepared状态

if _, err = stockDb.Exec("XA PREPARE ?", xid); err != nil {

panic(err.Error())

}

// 订单 子事务启动

if _, err = orderDb.Exec("XA START ?", xid); err != nil {

panic(err.Error())

}

//创建订单

if _, err = orderDb.Exec("insert shop_order(id,pid,xx) value (1,2,3)"); err != nil {

panic(err.Error())

}

//事务执行结束

if _, err = orderDb.Exec("XA END ?", xid); err != nil {

panic(err.Error())

}

//设置任务为Prepared状态

if _, err = orderDb.Exec("XA PREPARE ?", xid); err != nil {

panic(err.Error())

}

// 钱包 子事务启动

if _, err = moneyDb.Exec("XA START ?", xid); err != nil {

panic(err.Error())

}

//扣减用户账户现金,这里省略了数据行锁操作

if _, err = moneyDb.Exec("update user_money_bag set money=money-1 where id =9527"); err != nil {

panic(err.Error())

}

//事务执行结束

if _, err = moneyDb.Exec("XA END ?", xid); err != nil {

panic(err.Error())

}

//设置任务为Prepared状态

if _, err = moneyDb.Exec("XA PREPARE ?", xid); err != nil {

panic(err.Error())

}

// 在这时,如果链接断开、Prepared状态的XA事务仍旧在MySQL存在

// 任意一个链接调用XA RECOVER都能够看到这三个没有最终提交的事务

// --------

// 第二阶段 运行到这里没有任何问题

// 那么执行 commit

// --------

if _, err = stockDb.Exec("XA COMMIT ?", xid); err != nil {

panic(err.Error())

}

if _, err = orderDb.Exec("XA COMMIT ?", xid); err != nil {

panic(err.Error())

}

if _, err = moneyDb.Exec("XA COMMIT ?", xid); err != nil {

panic(err.Error())

}

//到这里全部流程完毕

}

可以看到,MySQL 通过 XA 指令轻松实现了多个库或多个服务的事务一致性提交。

可能你会想,为什么在上面的代码中没有看到事务协调器的相关操作?这里我们不妨去掉子业务的具体实现,用 API 调用的方式看一下是怎么回事:

package main

import (

"database/sql"

"fmt"

_ "github.com/go-sql-driver/mysql"

"strconv"

"time"

)

func main() {

// 库存的连接

stockDb, err := sql.Open("mysql", "root:123456@tcp(127.0.0.1:3306)/shop_product_stock")

if err != nil {

panic(err.Error())

}

defer stockDb.Close()

//订单的连接

orderDb, err := sql.Open("mysql", "root:123456@tcp(127.0.0.1:3307)/shop_order")

if err != nil {

panic(err.Error())

}

defer orderDb.Close()

//钱包的连接

moneyDb, err := sql.Open("mysql", "root:123456@tcp(127.0.0.1:3308)/user_money_bag")

if err != nil {

panic(err.Error())

}

defer moneyDb.Close()

// 生成xid

xid := strconv.FormatInt(time.Now().UnixMilli(), 10)

//如果后续执行过程有报错,那么回滚所有子事务

defer func() {

if err := recover(); err != nil {

stockDb.Exec("XA ROLLBACK ?", xid)

orderDb.Exec("XA ROLLBACK ?", xid)

moneyDb.Exec("XA ROLLBACK ?", xid)

}

}()

//调用API扣款,api内执行xa start、sql、xa end、xa prepare

if _, err = API.Call("UserMoneyBagPay", uid, price, xid); err != nil {

panic(err.Error())

}

//调用商品库存扣库存

if _, err = API.Call("ShopStockDecr", productId, 1, xid); err != nil {

panic(err.Error())

}

//调用API生成订单

if _, err = API.Call("ShopOrderCreate",productId, uid, price, xid); err != nil {

panic(err.Error())

}

// --------

// 第二阶段 运行到这里没有任何问题

// 那么执行 commit

// --------

if _, err = stockDb.Exec("XA COMMIT ?", xid); err != nil {

panic(err.Error())

}

if _, err = orderDb.Exec("XA COMMIT ?", xid); err != nil {

panic(err.Error())

}

if _, err = moneyDb.Exec("XA COMMIT ?", xid); err != nil {

panic(err.Error())

}

//到这里全部流程完毕

}

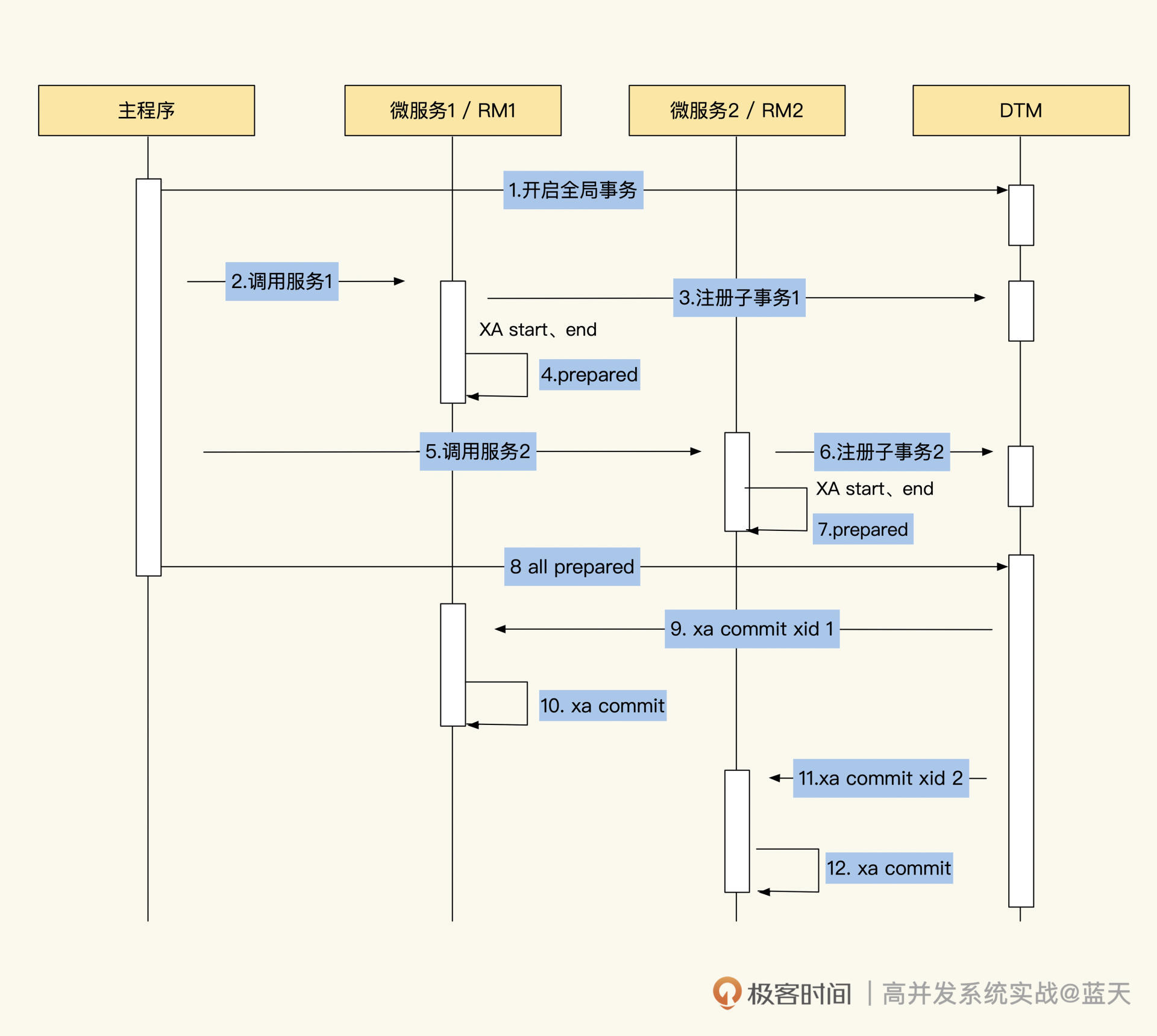

我想你已经知道了,当前程序本身就已经实现了事务协调器的功能。其实一些开源的分布式事务组件,比如 seata或 dtm 等,对事务协调器有一个更好的抽象封装,如果你感兴趣的话可以体验测试一下。

而上面两个演示代码的具体执行过程如下图所示:

整体流程图

通过流程图你会发现,2PC 事务不仅容易理解,实现起来也简单。

不过它最大的缺点是在 Prepare 阶段,很多操作的数据需要先做行锁定,才能保证数据的一致性。并且应用和每个子事务的过程需要阻塞,等整个事务全部完成才能释放资源,这就导致资源锁定时间比较长,并发也不高,常有大量事务排队。

除此之外,在一些特殊情况下,2PC 会丢数据,比如在 Commit 阶段,如果事务协调器的提交操作被打断了,XA 事务就会遗留在 MySQL 中。

而且你应该已经发现了,2PC 的整体设计是没有超时机制的,如果长时间不提交遗留在 MySQL 中的 XA 子事务,就会导致数据库长期被锁表。

在很多开源的实现中,2PC 的事务协调器会自动回滚或强制提交长时间没有提交的事务,但是如果进程重启或宕机,这个操作就会丢失了,此时就需要人工介入修复了。

3PC 简述

另外提一句,分布式事务的实现除了 2PC 外,还有 3PC。与 2PC 相比,3PC 主要多了事务超时、多次重复尝试,以及提交 check 的功能。但因为确认步骤过多,很多业务的互斥排队时间会很长,所以 3PC 的事务失败率要比 2PC 高很多。

为了减少 3PC 因资源锁定等待超时导致的重复工作,3PC 做了预操作,整体流程分成三个阶段:

- CanCommit 阶段:为了减少因等待锁定数据导致的超时情况,提高事务成功率,事务协调器会发送消息确认资源管理器的资源锁定情况,以及所有子事务的数据库锁定数据的情况。

- PreCommit 阶段:执行 2PC 的 Prepare 阶段;

- DoCommit 阶段:执行 2PC 的 Commit 阶段。

总体来说,3PC 步骤过多,过程比较复杂,整体执行也更加缓慢,所以在分布式生产环境中很少用到它,这里我就不再过多展开了。

TCC 协议

事实上,2PC 和 3PC 都存在执行缓慢、并发低的问题,这里我再介绍一个性能更好的分布式事务 TCC。

TCC 是 Try-Confirm-Cancel 的缩写,从流程上来看,它比 2PC 多了一个阶段,也就是将 Prepare 阶段又拆分成了两个阶段:Try 阶段和 Confirm 阶段。TCC 可以不使用 XA,只使用普通事务就能实现分布式事务。

首先在 Try 阶段,业务代码会预留业务所需的全部资源,比如冻结用户账户 100 元、提前扣除一个商品库存、提前创建一个没有开始交易的订单等,这样可以减少各个子事务锁定的数据量。业务拿到这些资源后,后续两个阶段操作就可以无锁进行了。

在 Confirm 阶段,业务确认所需的资源都拿到后,子事务会并行执行这些业务。执行时可以不做任何锁互斥,也无需检查,直接执行 Try 阶段准备的所有资源就行。

请注意,协议要求所有操作都是幂等的,以支持失败重试,因为在一些特殊情况下,比如资源锁争抢超时、网络不稳定等,操作要尝试执行多次才会成功。

最后在 Cancel 阶段:如果子事务在 Try 阶段或 Confirm 阶段多次执行重试后仍旧失败,TM 就会执行 Cancel 阶段的代码,并释放 Try 预留的资源,同时回滚 Confirm 期间的内容。注意,Cancel 阶段的代码也要做幂等,以支持多次执行。

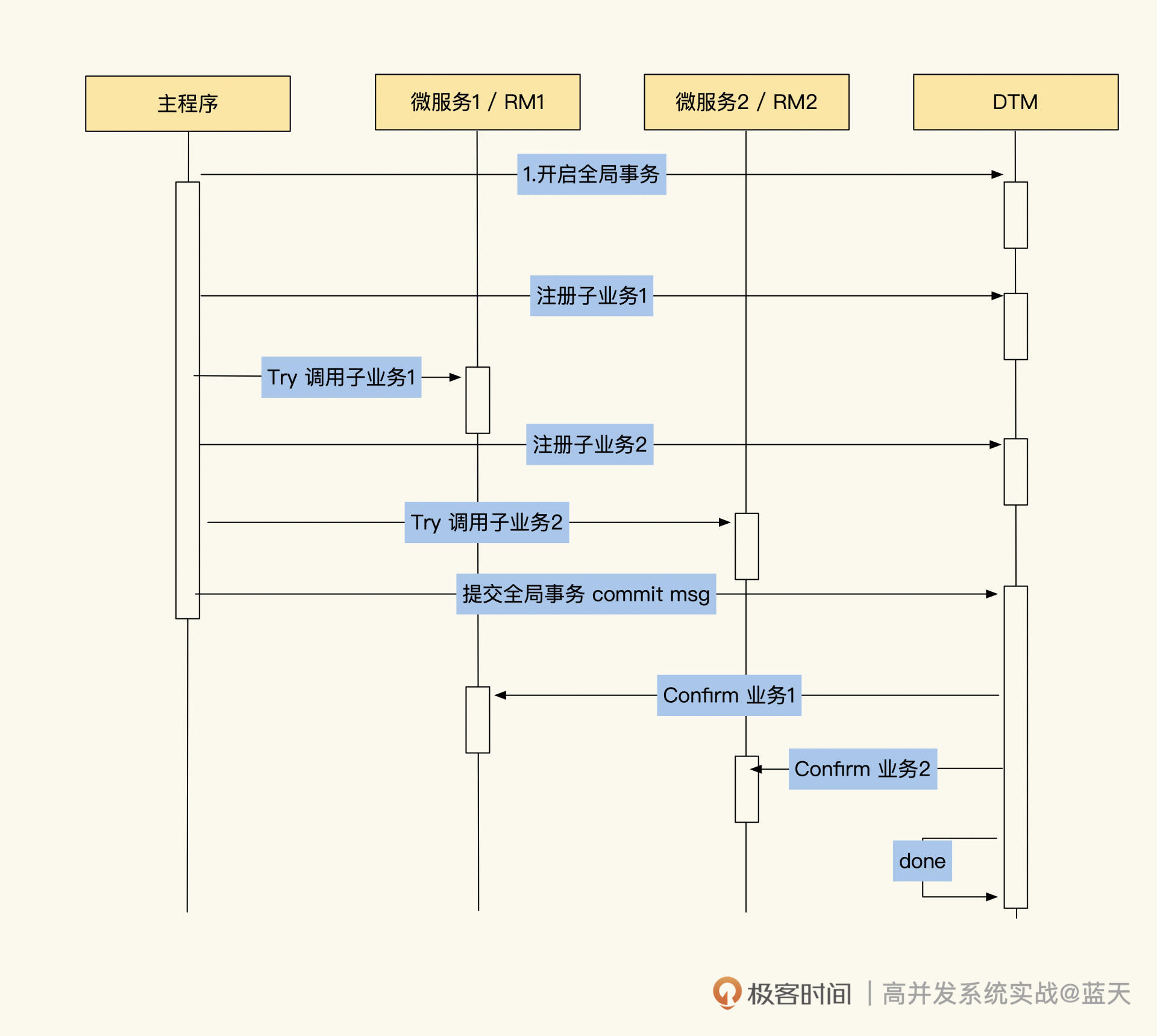

上述流程图如下:

TCC的实现

最后,我们总结一下 TCC 事务的优点:

- 并发能力高,且无长期资源锁定;

- 代码入侵实现分布式事务回滚,开发量较大,需要代码提供每个阶段的具体操作;

- 数据一致性相对来说较好;

- 适用于订单类业务,以及对中间状态有约束的业务。

当然,它的缺点也很明显:

- 只适合短事务,不适合多阶段的事务;

- 不适合多层嵌套的服务;

- 相关事务逻辑要求幂等;

- 存在执行过程被打断时,容易丢失数据的情况。

总结

通常来讲,实现分布式事务要耗费我们大量的精力和时间,硬件上的投入也不少,但当业务真的需要分布式事务时,XA 协议可以给我们提供强大的数据层支撑。

分布式事务的实现方式有多种,常见的有 2PC、3PC、TCC 等。其中,2PC 可以实现多个子事务统一提交回滚,但因为要保证数据的一致性,所以它的并发性能不好。而且 2PC 没有超时的机制,经常会将很多 XA 子事务遗漏在数据库中。

3PC 虽然有超时的机制,但是因为交互过多,事务经常会出现超时的情况,导致事务的性能很差。如果 3PC 多次尝试失败超时后,它会尝试回滚,这时如果回滚也超时,就会出现丢数据的情况。

TCC 则可以提前预定事务中需要锁定的资源,来减少业务粒度。它使用普通事务即可完成分布式事务协调,因此相对地 TCC 的性能很好。但是,提交最终事务和回滚逻辑都需要支持幂等,为此需要人工要投入的精力也更多。

目前,市面上有很多优秀的中间件,比如 DTM、Seata,它们对分布式事务协调做了很多的优化,比如过程中如果出现打断情况,它们能够自动重试、AT 模式根据业务修改的 SQL 自动生成回滚操作的 SQL,这个相对来说会智能一些。

此外,这些中间件还能支持更复杂的多层级、多步骤的事务协调,提供的流程机制也更加完善。所以在实现分布式事务时,建议使用成熟的开源加以辅助,能够让我们少走弯路。

基础服务:写多读少的链路跟踪系统

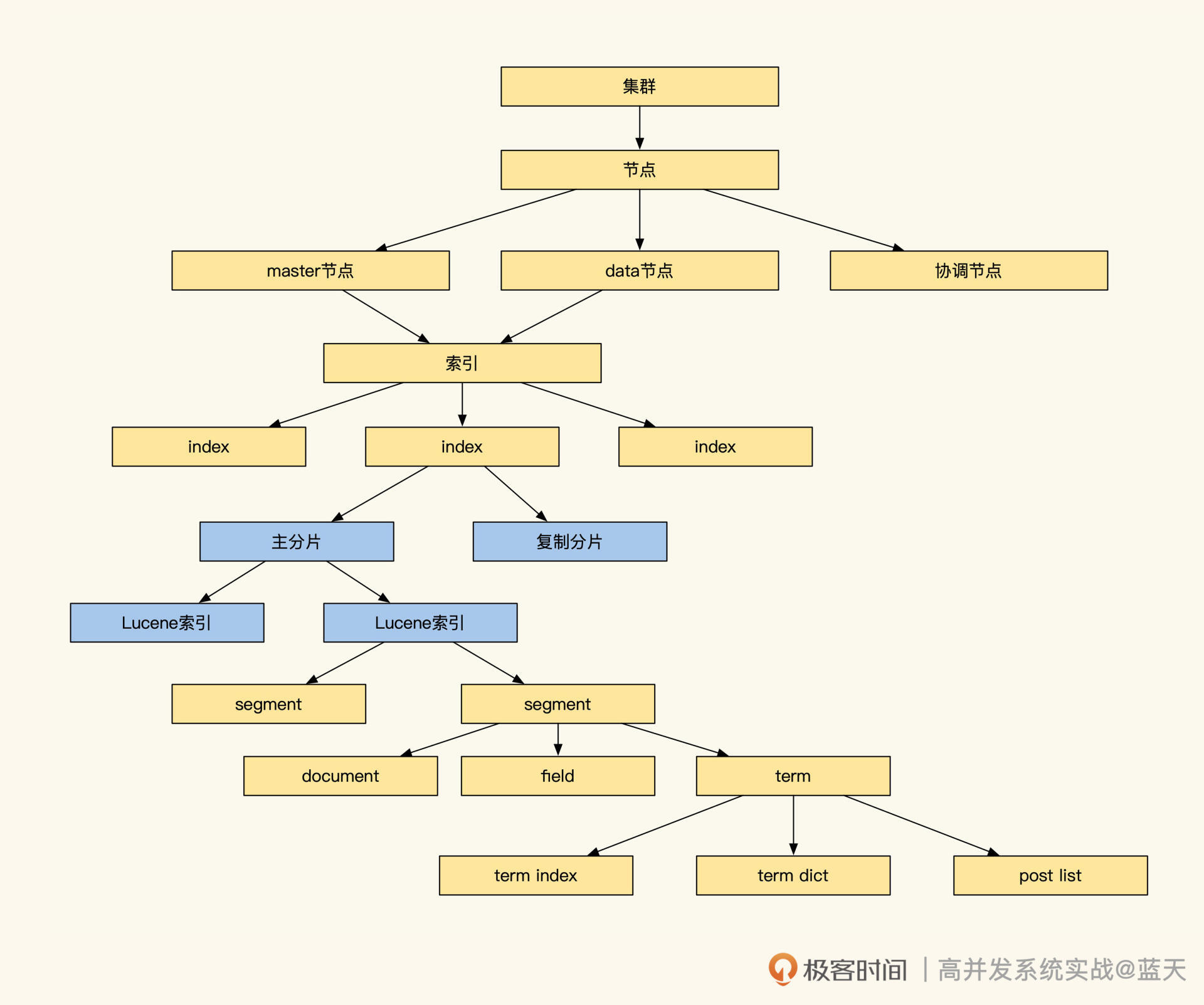

稀疏索引:为什么高并发写不推荐关系数据库?

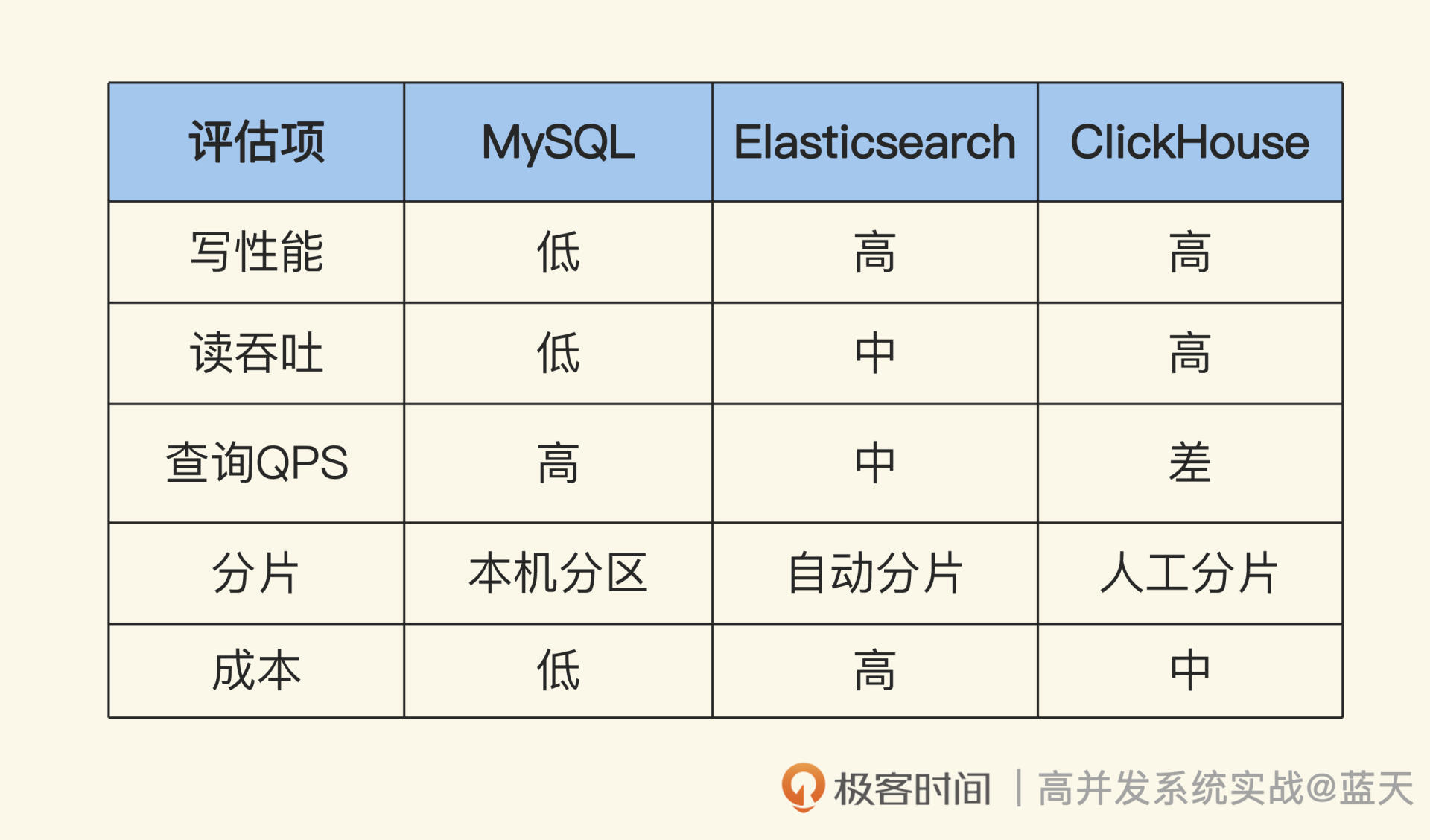

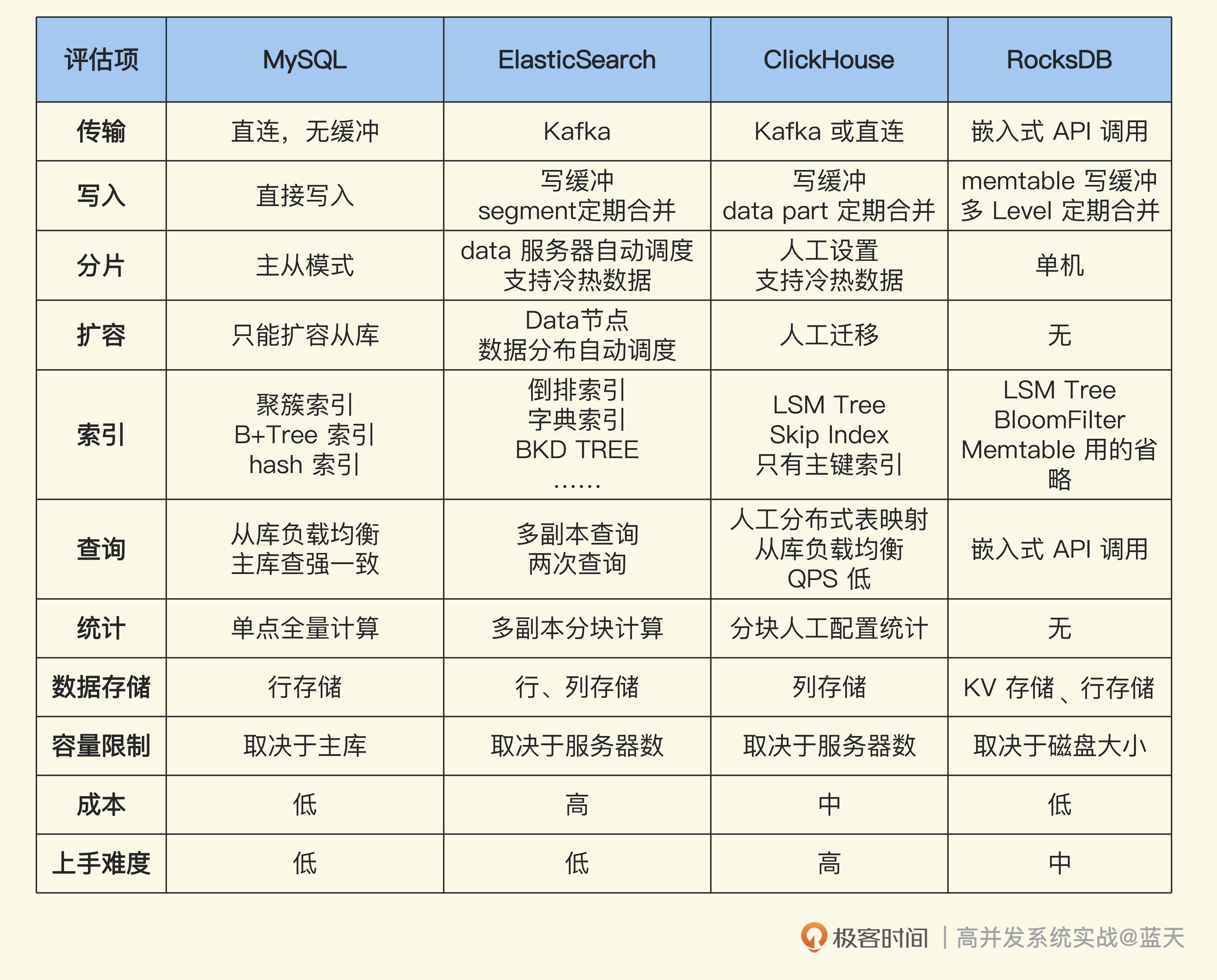

从这一章起,我们来学习如何优化写多读少的系统。说到高并发写,就不得不提及新分布式数据库 HTAP,它实现了 OLAP 和 OLTP 的融合,可以同时提供数据分析挖掘和关系查询。

事实上,HTAP 的 OLAP 并不是大数据,或者说它并不是我们印象中每天拿几 T 的日志过来用于离线分析计算的那个大数据。这里更多的是指数据挖掘的最后一环,也就是数据挖掘结果对外查询使用的场景。

对于这个范围的服务,在行业中比较出名的实时数据统计分析的服务有 ElasticSearch、ClickHouse,虽然它们的 QPS 不高,但是能够充分利用系统资源,对大量数据做统计、过滤、查询。但是,相对地,为什么 MySQL 这种关系数据库不适合做类似的事情呢?这节课我们一起分析分析。

B+Tree 索引与数据量

MySQL 我们已经很熟悉了,我们常常用它做业务数据存储查询以及信息管理的工作。相信你也听过“一张表不要超过 2000 万行数据”这句话,为什么会有这样的说法呢?

核心在于 MySQL 数据库的索引,实现上和我们的需求上有些冲突。具体点说,我们对外的服务基本都要求实时处理,在保证高并发查询的同时,还需要在一秒内找出数据并返回给用户,这意味着对数据大小以及数据量的要求都非常高高。

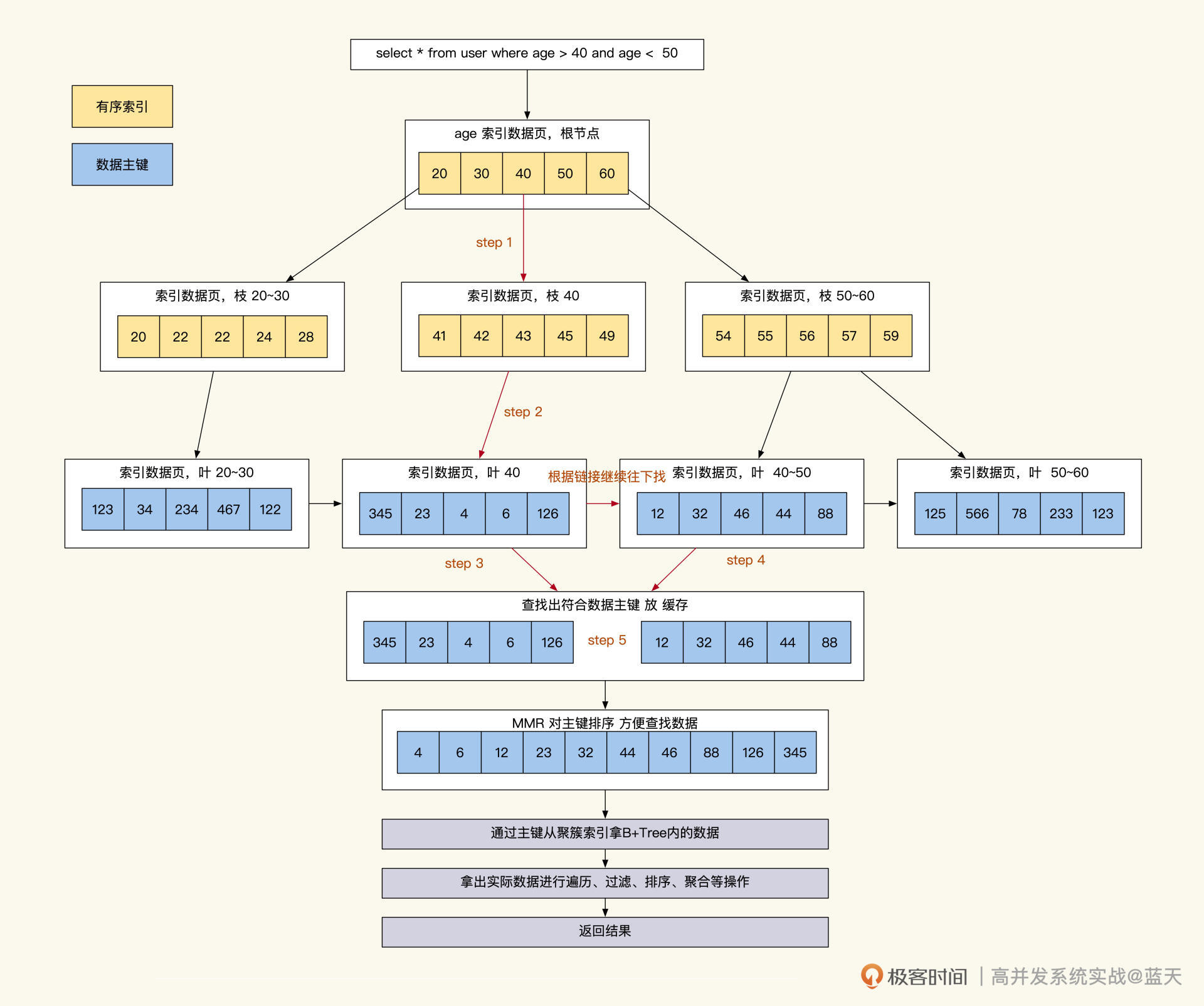

MySQL 为了达到这个效果,几乎所有查询都是通过索引去缩小扫描数据的范围,然后再回到表中对范围内数据进行遍历加工、过滤,最终拿到我们的业务需要的数据。

事实上,并不是 MySQL 不能存储更多的数据,而限制我们的多数是数据查询效率问题。

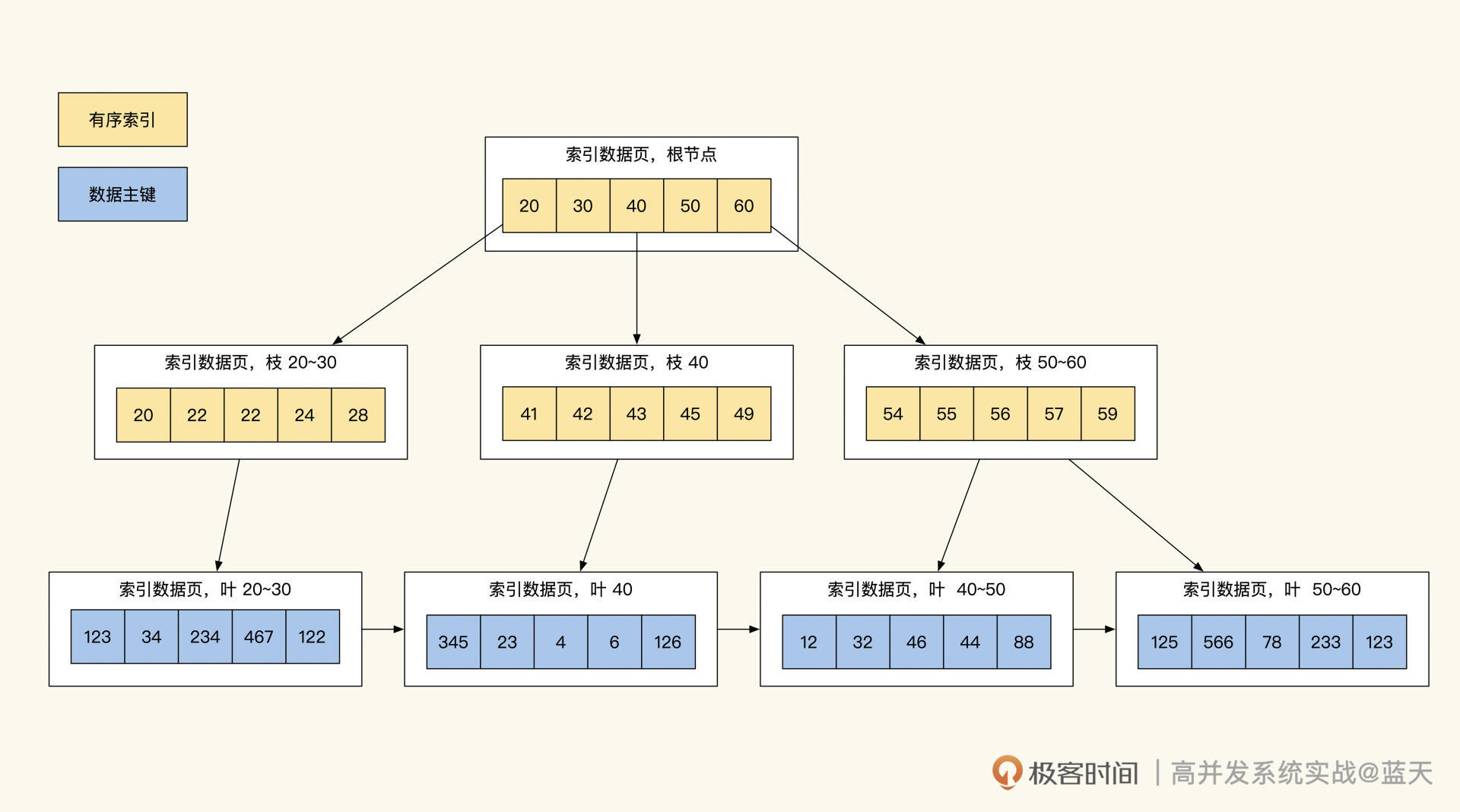

那么 MySQL 限制查询效率的地方有哪些?请看下图:

众所周知,MySQL 的 InnoDB 数据库的索引是 B+Tree,B+Tree 的特点在于只有在最底层才会存储真正的数据 ID,通过这个 ID 就可以提取到数据的具体内容,同时 B+Tree 索引最底层的数据是按索引字段顺序进行存储的。

通过这种设计方式,我们只需进行 1~3 次 IO(树深度决定了 IO 次数)就能找到所查范围内排序好的数据,而树形的索引最影响查询效率的是树的深度以及数据量(数据越独特,筛选的数据范围就越少)。

数据量我么很好理解,只要我们的索引字段足够独特,筛选出来的数据量就是可控的。

但是什么会影响到索引树的深度个数呢?这是因为 MySQL 的索引是使用 Page 作为单位进行存储的,而每页只能存储 16KB(innodb_page_size)数据。如果我们每行数据的索引是 1KB,那么除去 Page 页的一些固定结构占用外,一页只能放 16 条数据,这导致树的一些分支装不下更多数据时,我么就需要对索引的深度再加一层。

我们从这个 Page 就可以推导出:索引第一层放 16 条,树第二层大概能放 2 万条,树第三层大概能放 2400 万条,三层的深度 B+Tree 按主键查找数据每次查询需要 3 次 IO(一层索引在内存,IO 两次索引,最后一次是拿数据)。

不过这个 2000 万并不是绝对的,如果我们的每行数据是 0.5KB,那么大概在 4000 万以后才会出现第四层深度。而对于辅助索引,一页 Page 能存放 1170 个索引节点(主键 bigint8 字节 + 数据指针 6 字节),三层深度的辅助索引大概能记录 10 亿条索引记录。

可以看到,我们的数据存储数量超过三层时,每次数据操作需要更多的 IO 操作来进行查询,这样做的后果就是查询数据返回的速度变慢。所以,很多互联网系统为了保持服务的高效,会定期整理数据。

通过上面的讲解,相信你已经对整个查询有画面感了:当我们查询时,通过 1~3 次 IO 查找辅助索引,从而找到一批数据主键 ID。然后,通过 MySQL 的 MMR 算法将这些 ID 做排序,再回表去聚簇索引按取值范围提取在子叶上的业务数据,将这些数据边取边算或一起取出再进行聚合排序后,之后再返回结果。

可以看到,我们常用的数据库之所以快,核心在于索引用得好。由于加工数据光用索引是无法完成的,我们还需要找到具体的数据进行再次加工,才能得到我们业务所需的数据,这也是为什么我们的字段数据长度和数据量会直接影响我们对外服务的响应速度。

同时请你注意,我们一个表不能增加过多的索引,因为索引太多会影响到表插入的性能。并且我们的查询要遵循左前缀原则来逐步缩小查找的数据范围,而不能利用多个 CPU 并行去查询索引数据。这些大大限制了我们对大数据的处理能力。

另外,如果有数据持续高并发插入数据库会导致 MySQL 集群工作异常、主库响应缓慢、主从同步延迟加大等问题。从部署结构上来说,MySQL 只有主从模式,大批量的数据写操作只能由主库承受,当我们数据写入缓慢时客户端只能等待服务端响应,严重影响数据写入效率。

看到这里,相信你已经理解为什么关系型数据库并不适合太多的数据,其实 OLAP 的数据库也不一定适合大量的数据,正如我提到的 OLAP 提供的服务很多也需要实时响应,所以很多时候这类数据库对外提供服务的时候,计算用的数据也是做过深加工的。但即使如此,OLAP 和 OLTP 底层实现仍旧有很多不同。

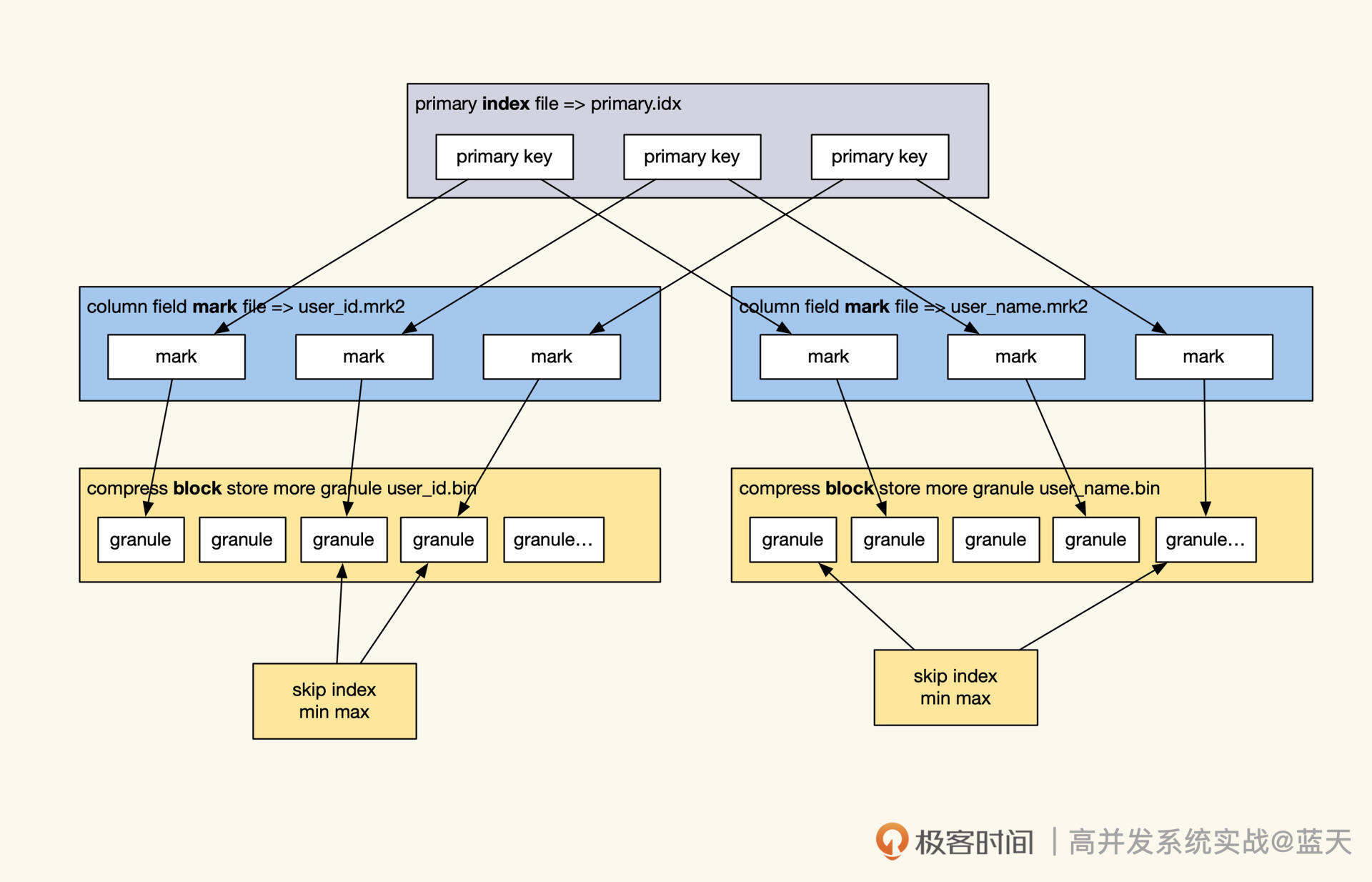

我们先来分析索引的不同。OLTP 常用的是 B+Tree,我们知道,B+tree 索引是一个整体的树,当我们的数据量大时会影响索引树的深度,如果深度过高就会严重影响其工作效率。对于大量数据,OLAP 服务会用什么类型的索引呢?

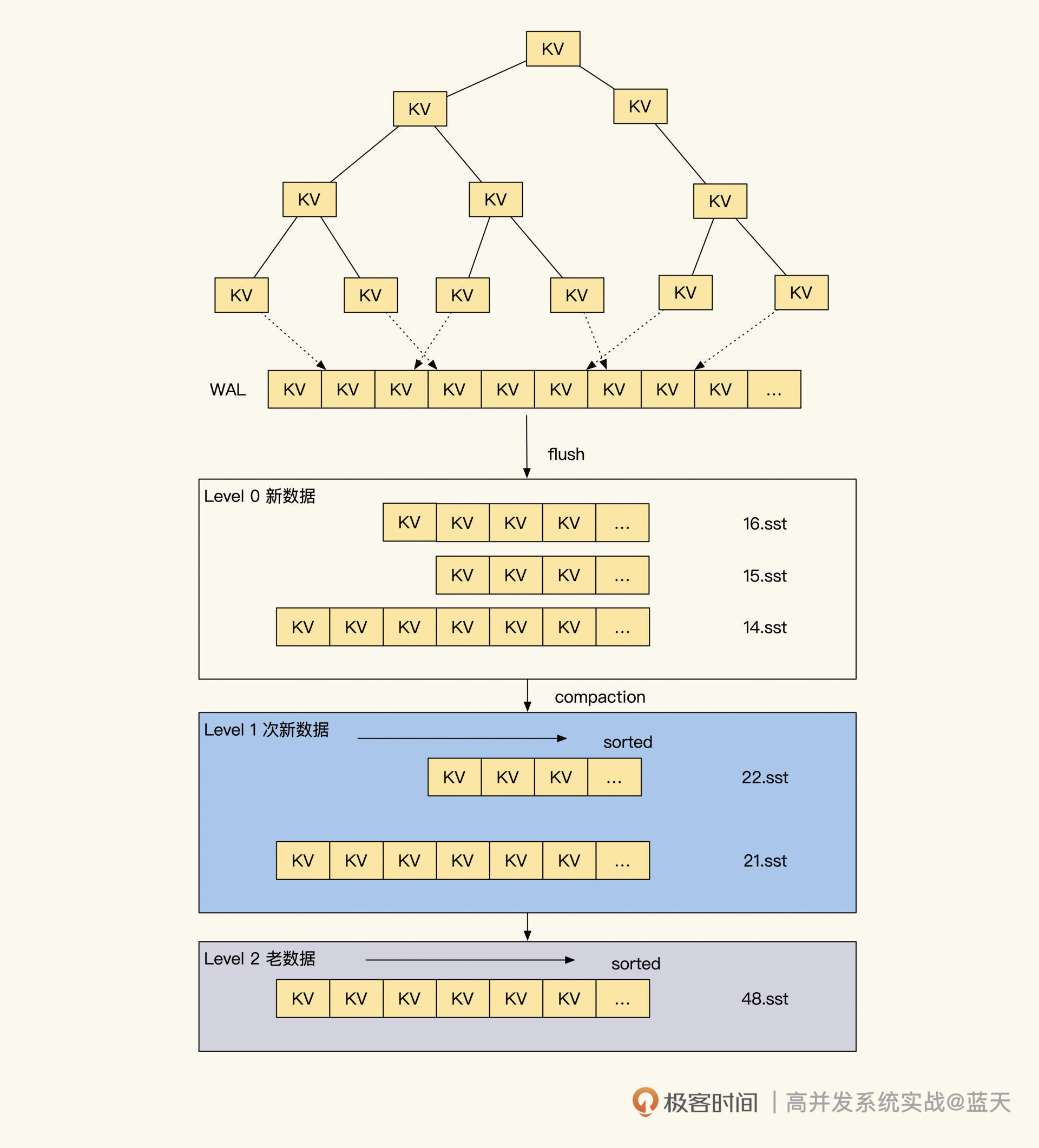

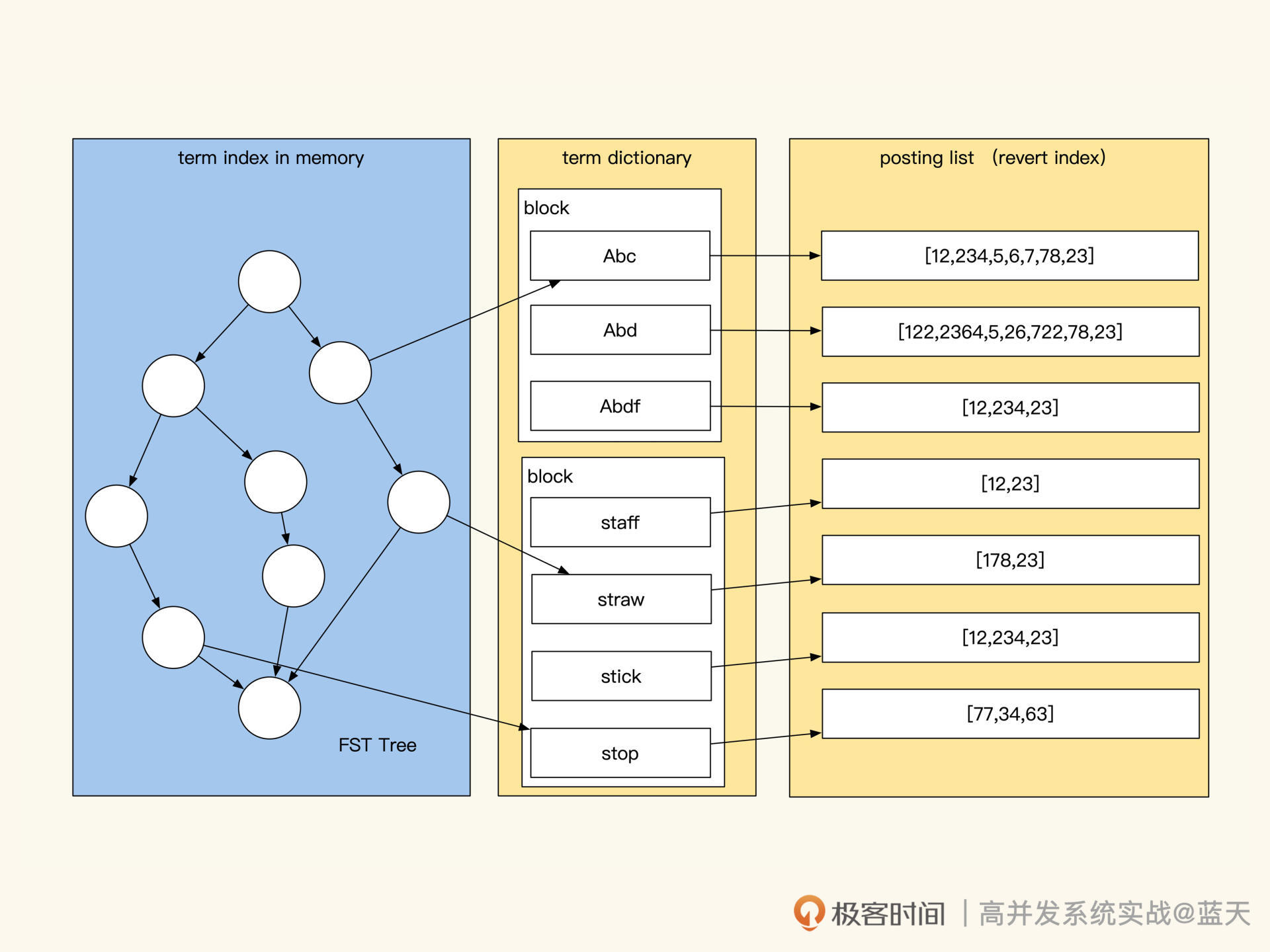

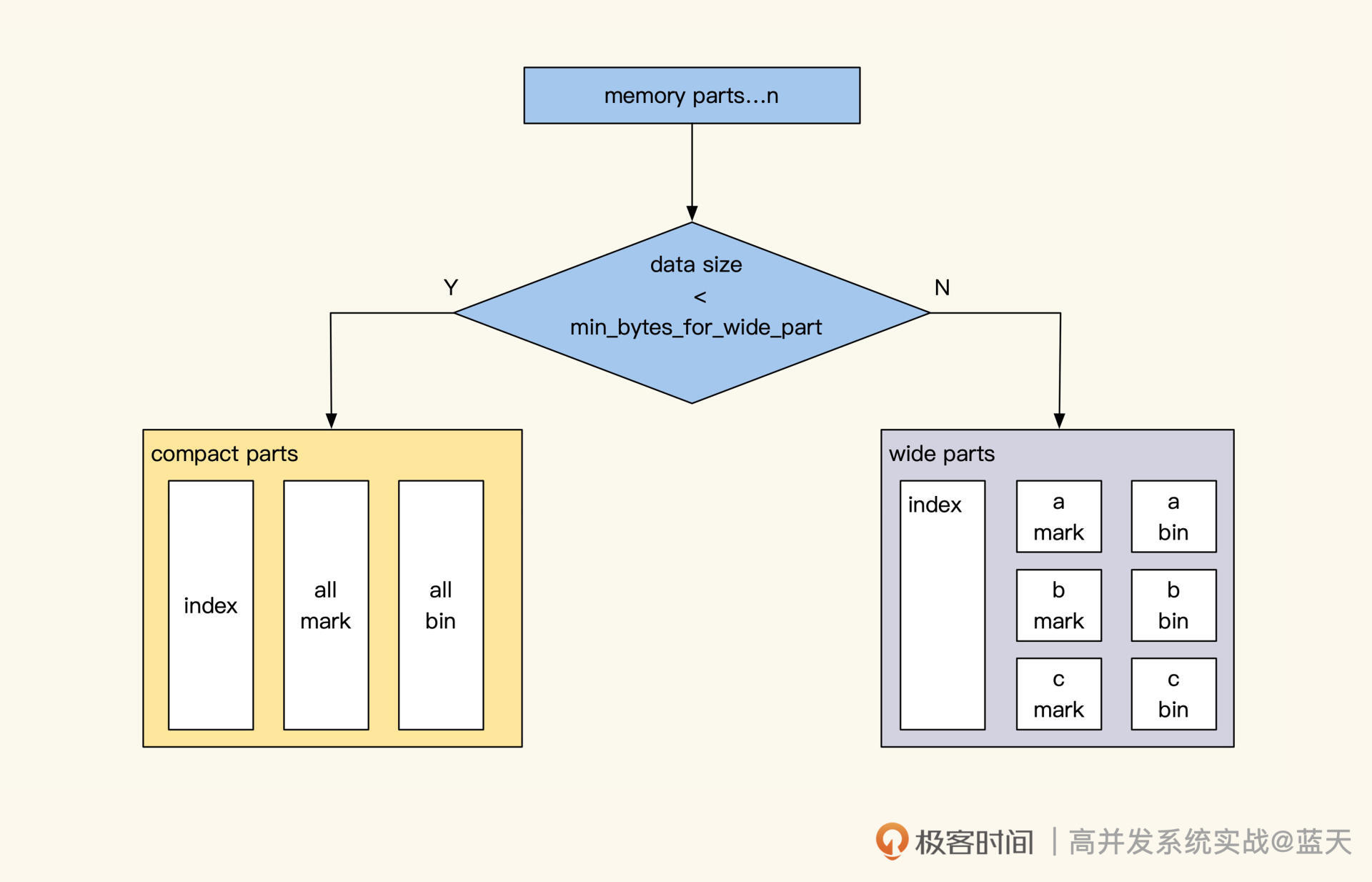

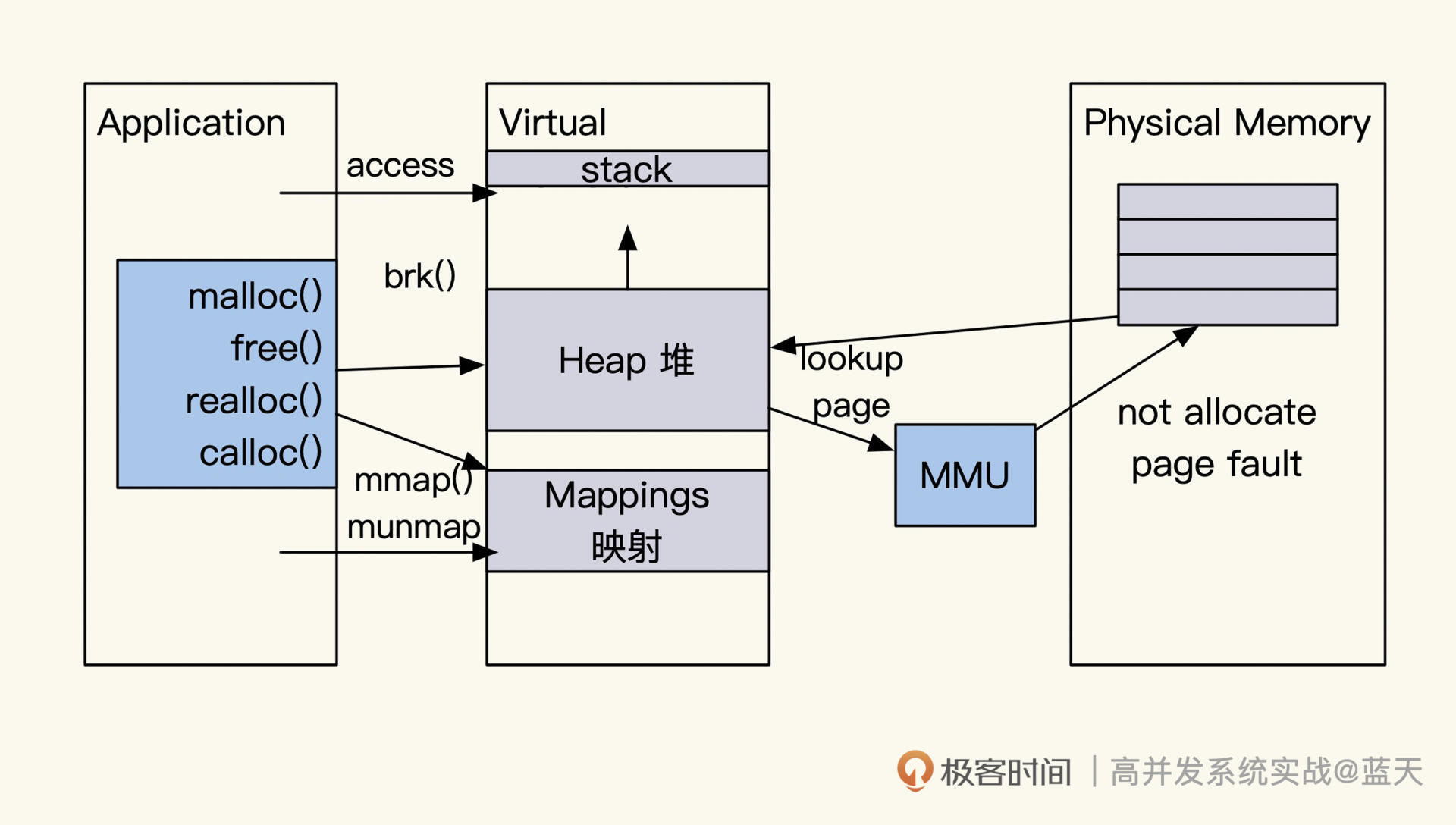

稀疏索引 LSM Tree 与存储

这里重点介绍一下 LSM 索引。我第一次见到 LSM Tree 还是从 RocksDB(以及 LevelDB)上看到的,RocksDB 之所以能够得到快速推广并受到欢迎,主要是因为它利用了磁盘顺序写性能超绝的特性,并以较小的性能查询代价提供了写多读少的 KV 数据存储查询服务,这和关系数据库的存储有很大的不同。

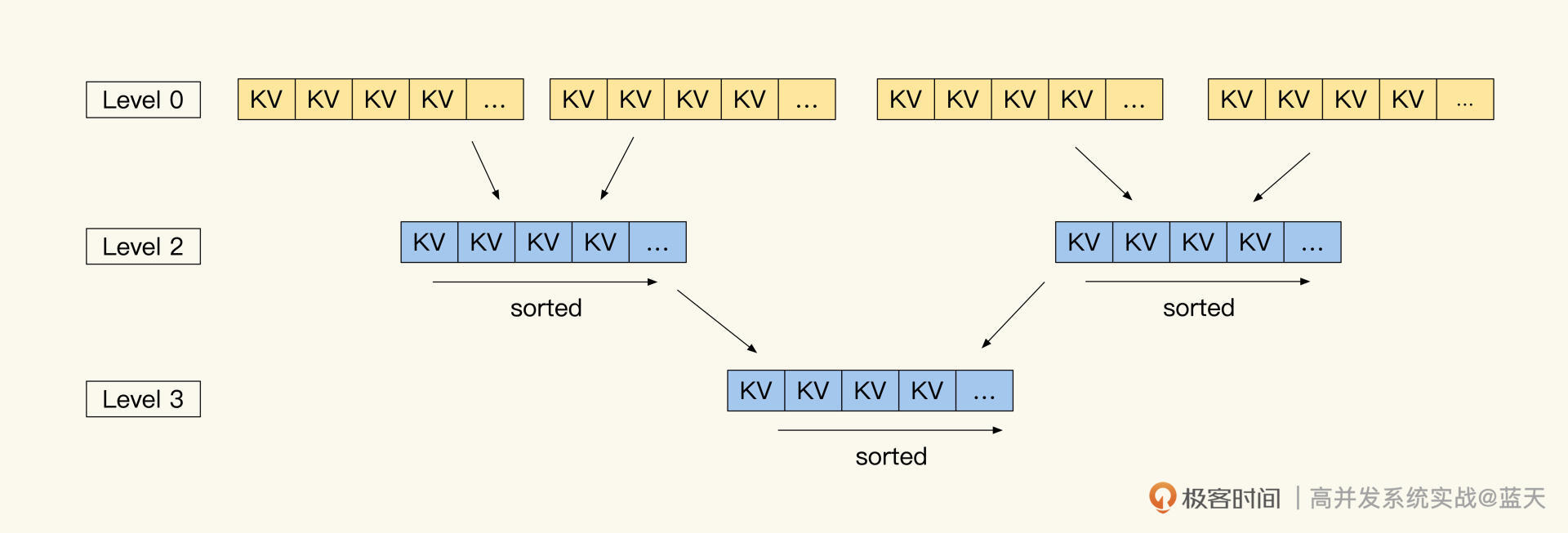

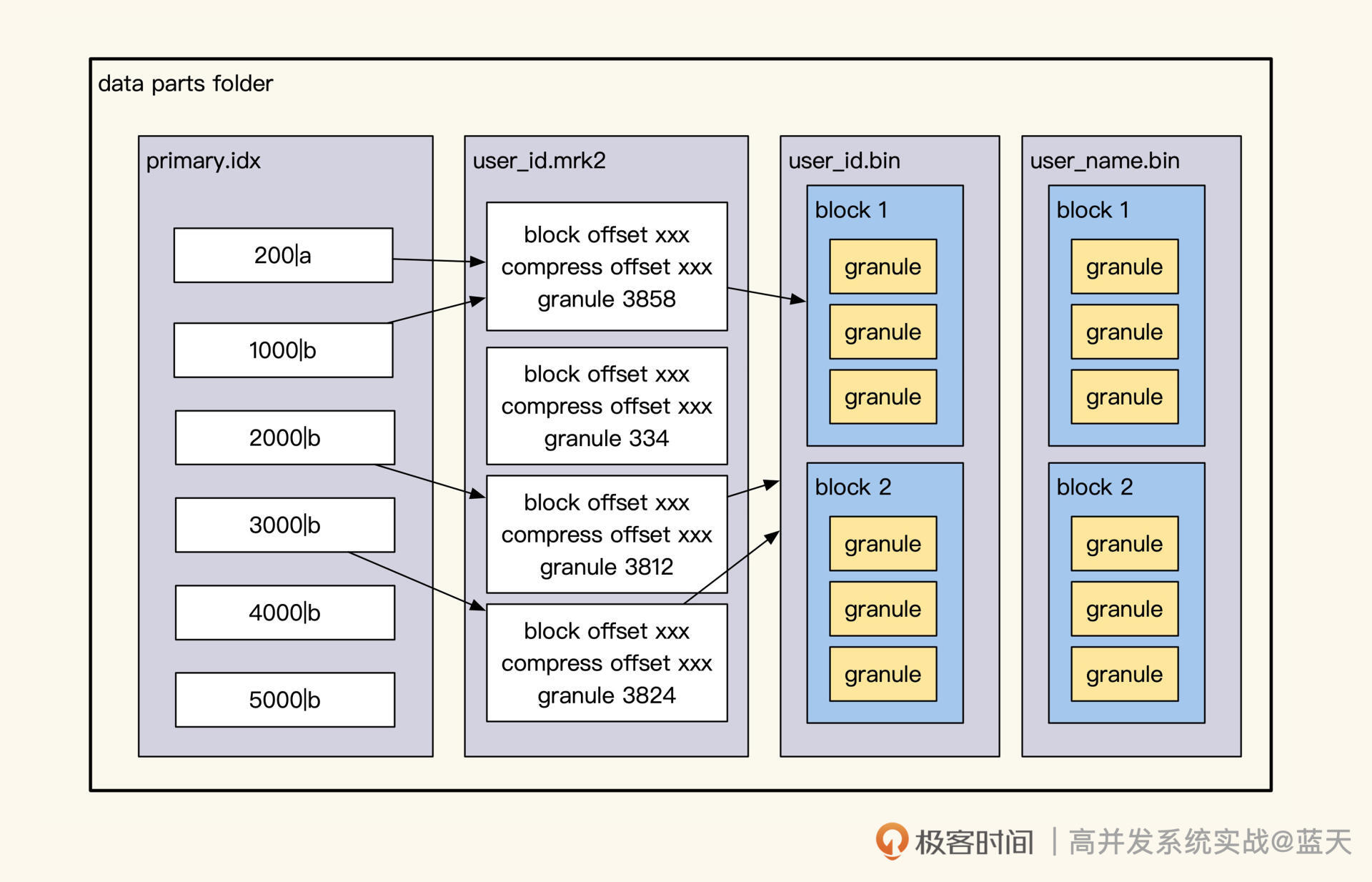

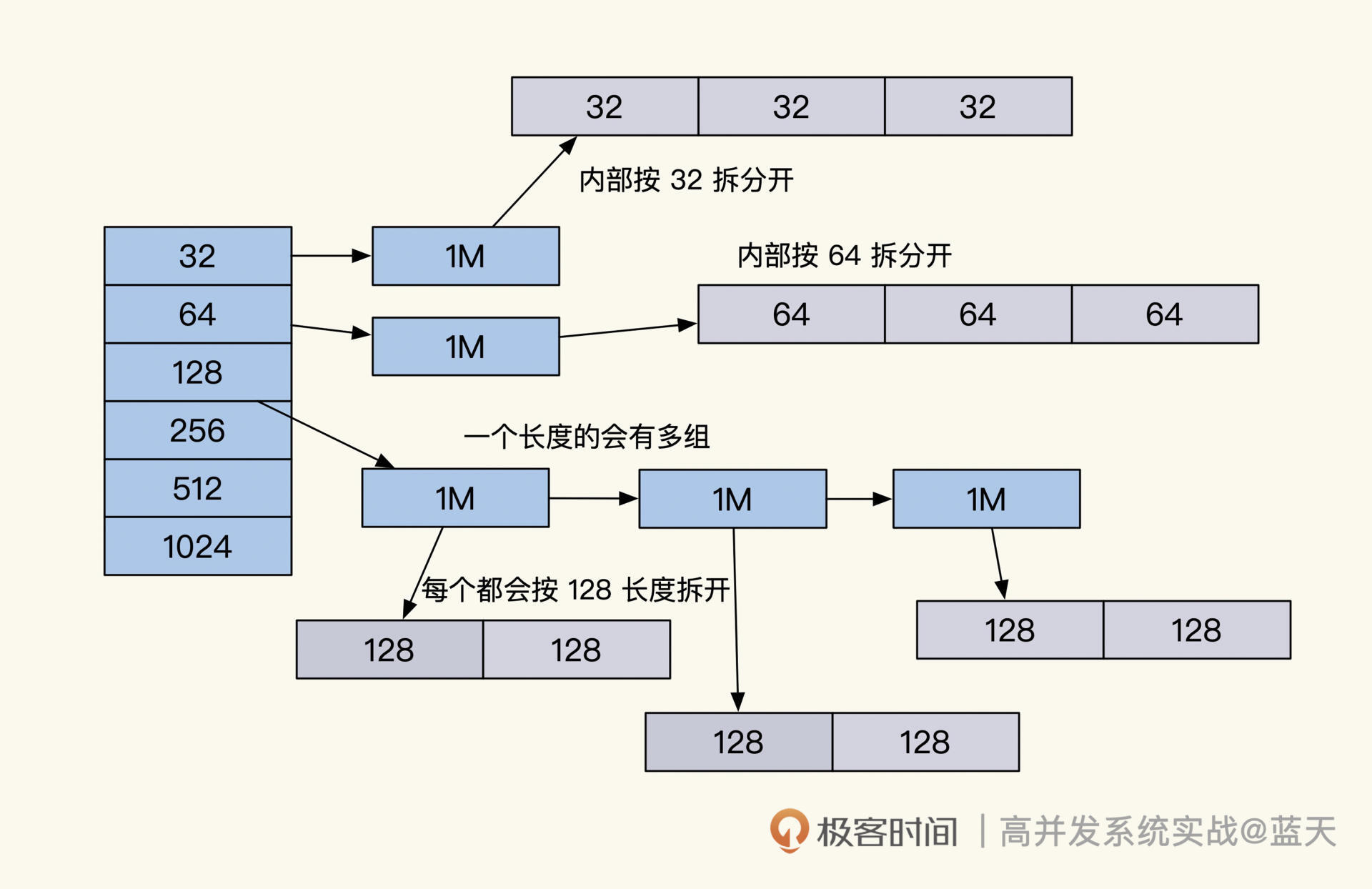

为了更好理解,我们详细讲讲 Rocksdb 稀疏索引是如何实现的,如下图所示:

我们前面讲过,B+Tree 是一个大树,它是一个聚合的完整整体,任何数据的增删改都是在这个整体内进行操作,这就导致了大量的随机读写 IO。

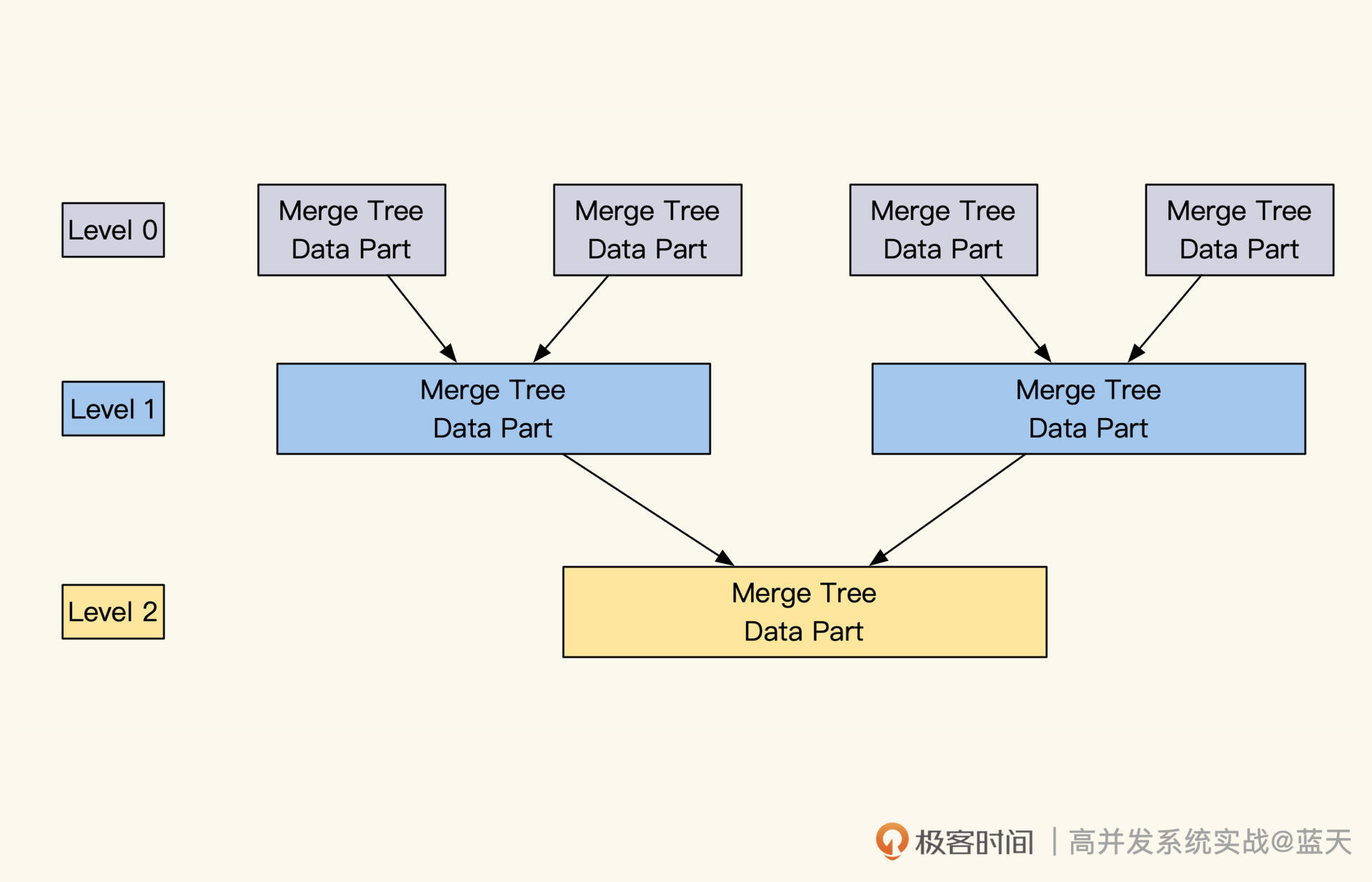

RocksDB LSM 则不同,它是由一棵棵小树组成,当我们新数据写入时会在内存中暂存,这样能够获得非常大的写并发处理能力。而当内存中数据积累到一定程度后,会将内存中数据和索引做顺序写,落地形成一个数据块。

这个数据块内保存着一棵小树和具体的数据,新生成的数据块会保存在 Level 0 层(最大有几层可配置),Level 0 层会有多个类似的数据块文件。结构如下图所示:

每一层的数据块和数据量超过一定程度时,RocksDB 合并不同 Level 的数据,将多个数据块内的数据和索引合并在一起,并推送到 Level 的下一层。通过这个方式,每一层的数据块个数和数据量就能保持一定的数量,合并后的数据会更紧密、更容易被找到。

这样的设计,可以让一个 Key 存在于多个 Level 或者数据块中,但是最新的常用的数据肯定是在 Level 最顶部或内存(0~4 层,0 为顶部)中最新的数据块内。

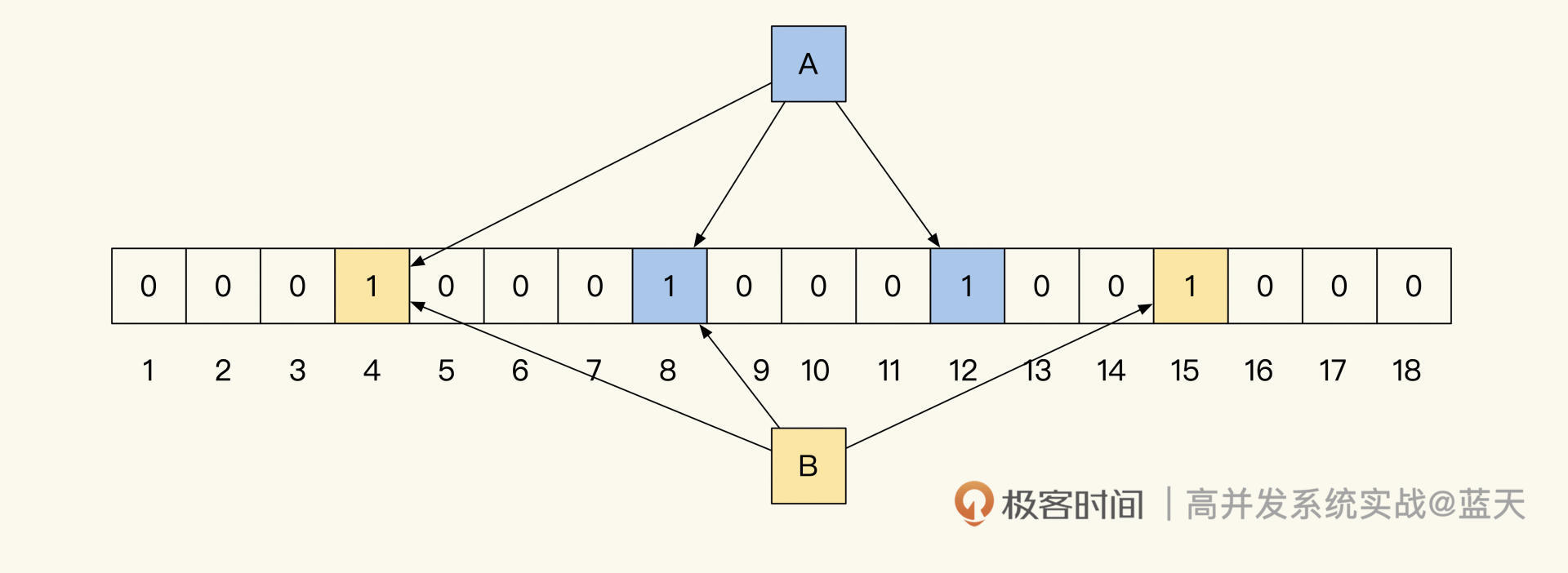

bloomfilter 能辅助确认数据的绝对没有

而当我们查询一个 key 的时候,RocksDB 会先查内存。如果没找到,会从 Level 0 层到下层,每层按生成最新到最老的顺序去查询每层的数据块。同时为了减少 IO 次数,每个数据块都会有一个 BloomFIlter 辅助索引,来辅助确认这个数据块中是否可能有对应的 Key;如果当前数据块没有,那么可以快速去找下一个数据块,直到找到为止。当然,最惨的情况是遍历所有数据块。

可以看到,这个方式虽然放弃了整体索引的一致性,却换来了更高效的写性能。在读取时通过遍历所有子树来查找,减少了写入时对树的合并代价。

LSM 这种方式的数据存储在 OLAP 数据库中很常用,因为 OLAP 多数属于写多读少,而当我们使用 OLAP 对外提供数据服务的时候,多数会通过缓存来帮助数据库承受更大的读取压力。

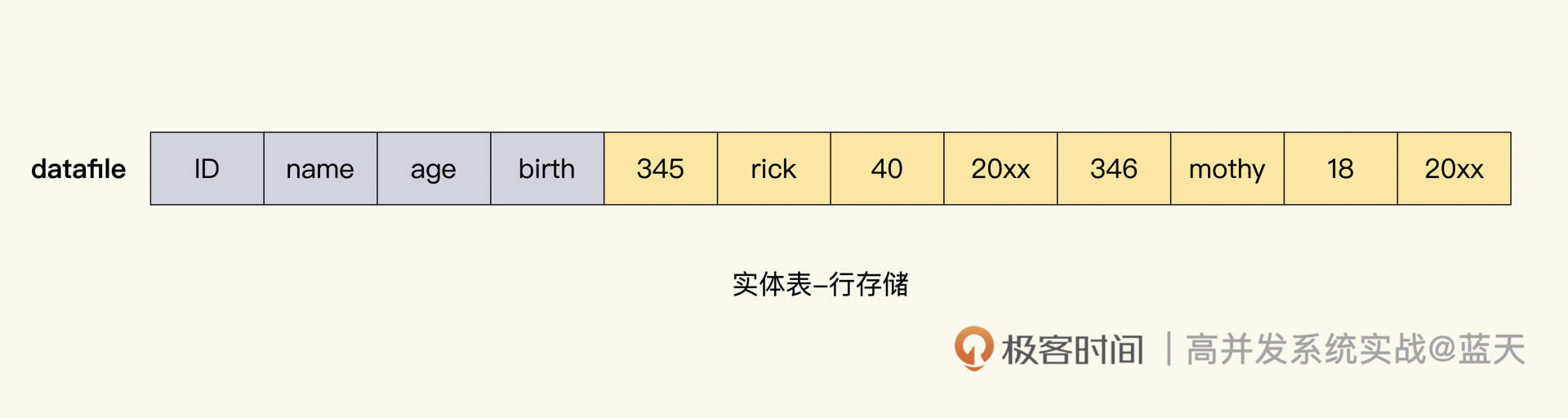

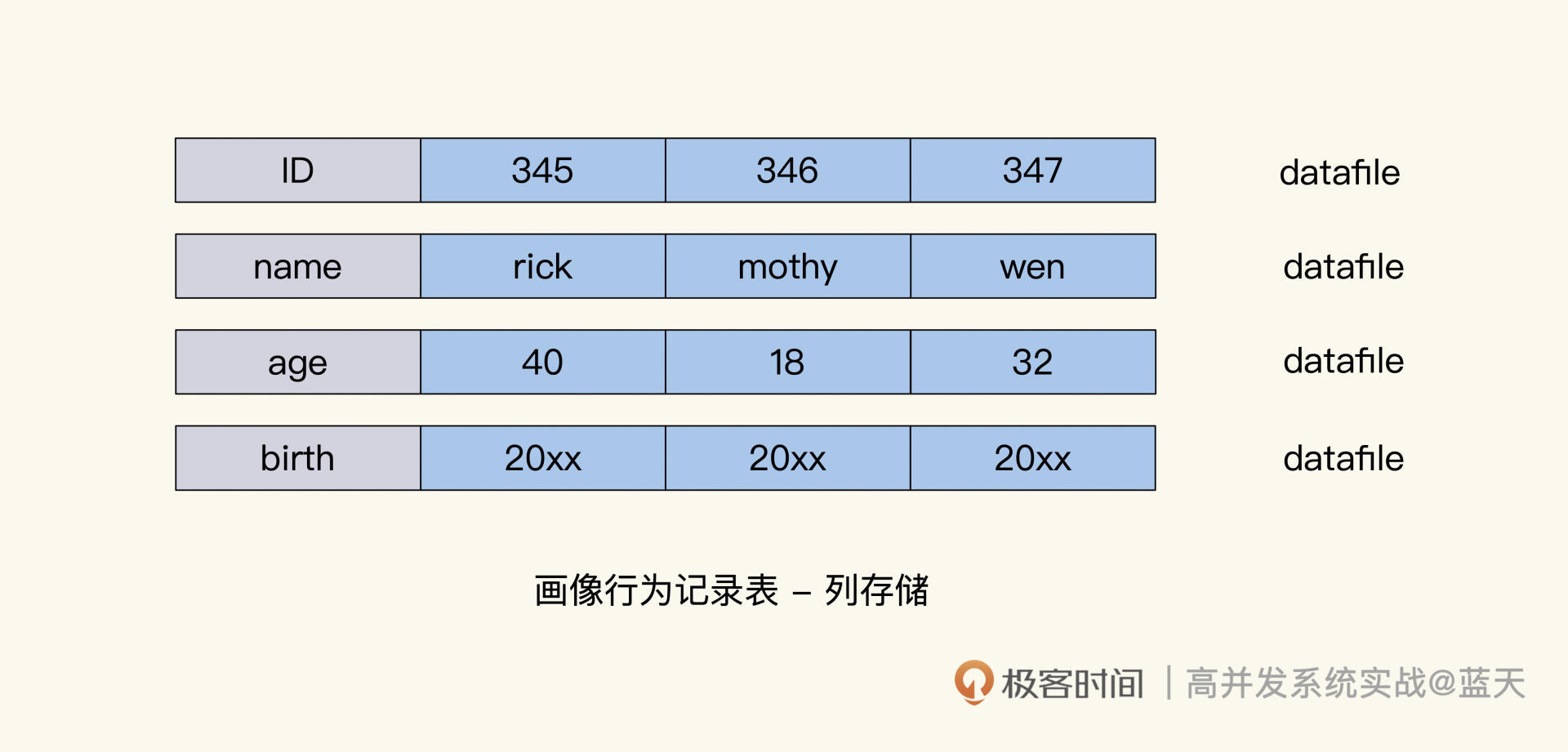

列存储数据库

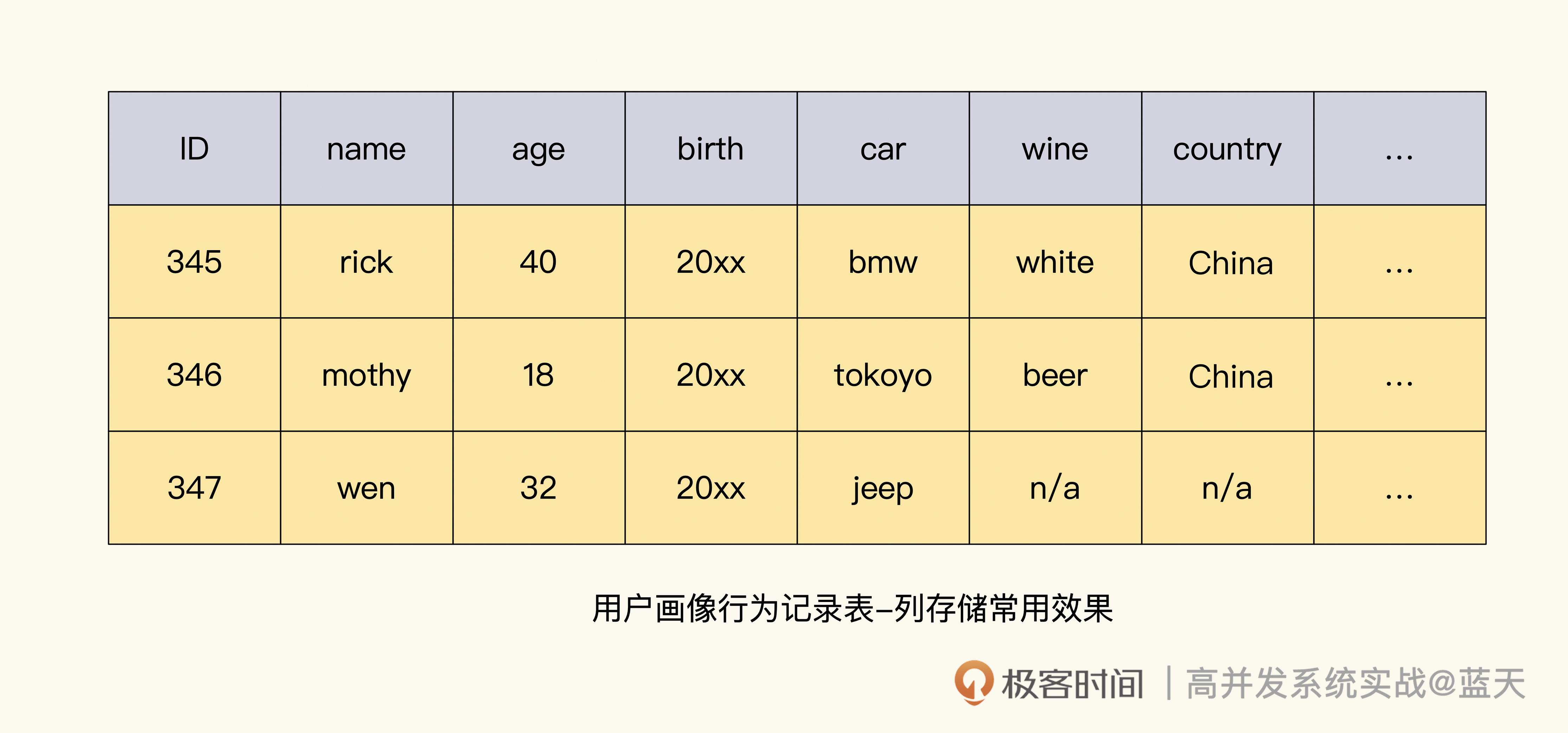

说到这里,不得不提 OLAP 数据库和 OLTP 数据之间的另一个区别。我们常用的关系型数据库,属于行式存储数据库 Row-based,表数据结构是什么样,它就会按表结构的字段顺序进行存储;而大数据挖掘使用的数据库普遍使用列式存储(Column-based),原因在于我们用关系数据库保存的多数是实体属性和实体关系,很多查询每一列都是不可或缺的。

但是,实时数据分析则相反,很多情况下常用一行表示一个用户或主要实体(聚合根),而列保存这个用户或主要实体是否买过某物、使用过什么 App、去过哪里、开什么车、点过什么食品、哪里人等等。

这样组织出来的数据,做数据挖掘、分析对比很方便,不过也会导致一个表有成百上千个字段,如果用行存储的数据引擎,我们对数据的筛选是一行行进行读取的,会浪费大量的 IO 读取。

而列存储引擎可以指定用什么字段读取所需字段的数据,并且这个方式能够充分利用到磁盘顺序读写的性能,大大提高这种列筛选式的查询,并且列方式更好进行数据压缩,在实时计算领域做数据统计分析的时候,表现会更好。

到了这里相信你已经发现,使用场景不同,数据底层的实现也需要不同的方式才能换来更好的性能和性价比。随着行业变得更加成熟,这些需求和特点会不断挖掘、总结、合并到我们的底层服务当中,逐渐降低我们的工作难度和工作量。

HTAP

通过前面的讲解,我么可以看到 OLAP 和 OLTP 数据库各有特点,并且有不同的发展方向,事实上它们对外提供的数据查询服务都是期望实时快速的,而不同在于如何存储和查找索引。

最近几年流行将两者结合成一套数据库集群服务,同时提供 OLAP 以及 OLTP 服务,并且相互不影响,实现行数据库与列数据库的互补。

2022 年国产数据库行业内 OceanBase、PolarDB 等云厂商提供的分布式数据库都在紧锣密鼓地开始支持 HTAP。这让我们可以保存同一份数据,根据不同查询的范围触发不同的引擎,共同对外提供数据服务。

可以看到,未来的某一天,我们的数据库既能快速地实时分析,又能快速提供业务数据服务。逐渐地,数据服务底层会出现多套存储、索引结构来帮助我们更方便地实现数据库。

而目前常见的 HTAP 实现方式,普遍采用一个服务集群内同一套数据支持多种数据存储方式(行存储、列存储),通过对数据提供不同的索引来实现 OLAP 及 OLTP 需求,而用户在查询时,可以指定或由数据库查询引擎根据 SQL 和数据情况,自动选择使用哪个引擎来优化查询。

总结

这节课,我们讨论了 OLAP 和 OLTP 数据库的索引、存储、数据量以及应用的不同场景。

OLAP 相对于关系数据库的数据存储量会更多,并且对于大量数据批量写入支持很好。很多情况下,高并发批量写数据很常见,其表的字段会更多,数据的存储多数是用列式方式存储,而数据的索引用的则是列索引,通过这些即可实现实时大数据计算结果的查询和分析。

相对于离线计算来说,这种方式更加快速方便,唯一的缺点在于这类服务都需要多台服务器做分布式,成本高昂。

可以看出,我们使用的场景不同决定了我们的数据底层如何去做更高效,HTAP 的出现,让我们在不同的场景中有了更多的选择,毕竟大数据挖掘是一个很庞大的数据管理体系,如果能有一个轻量级的 OLAP,会让我们的业务拥有更多的可能。

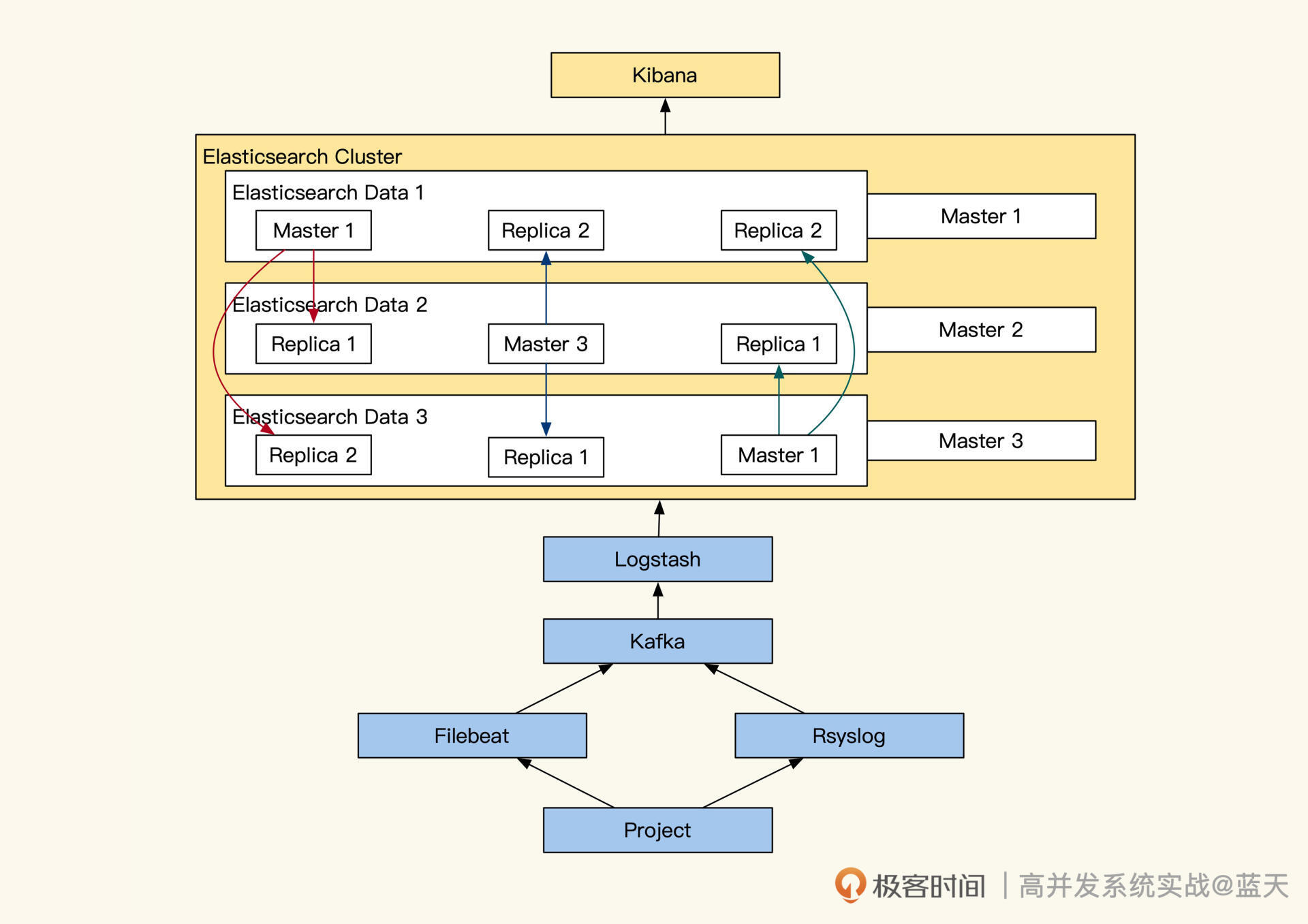

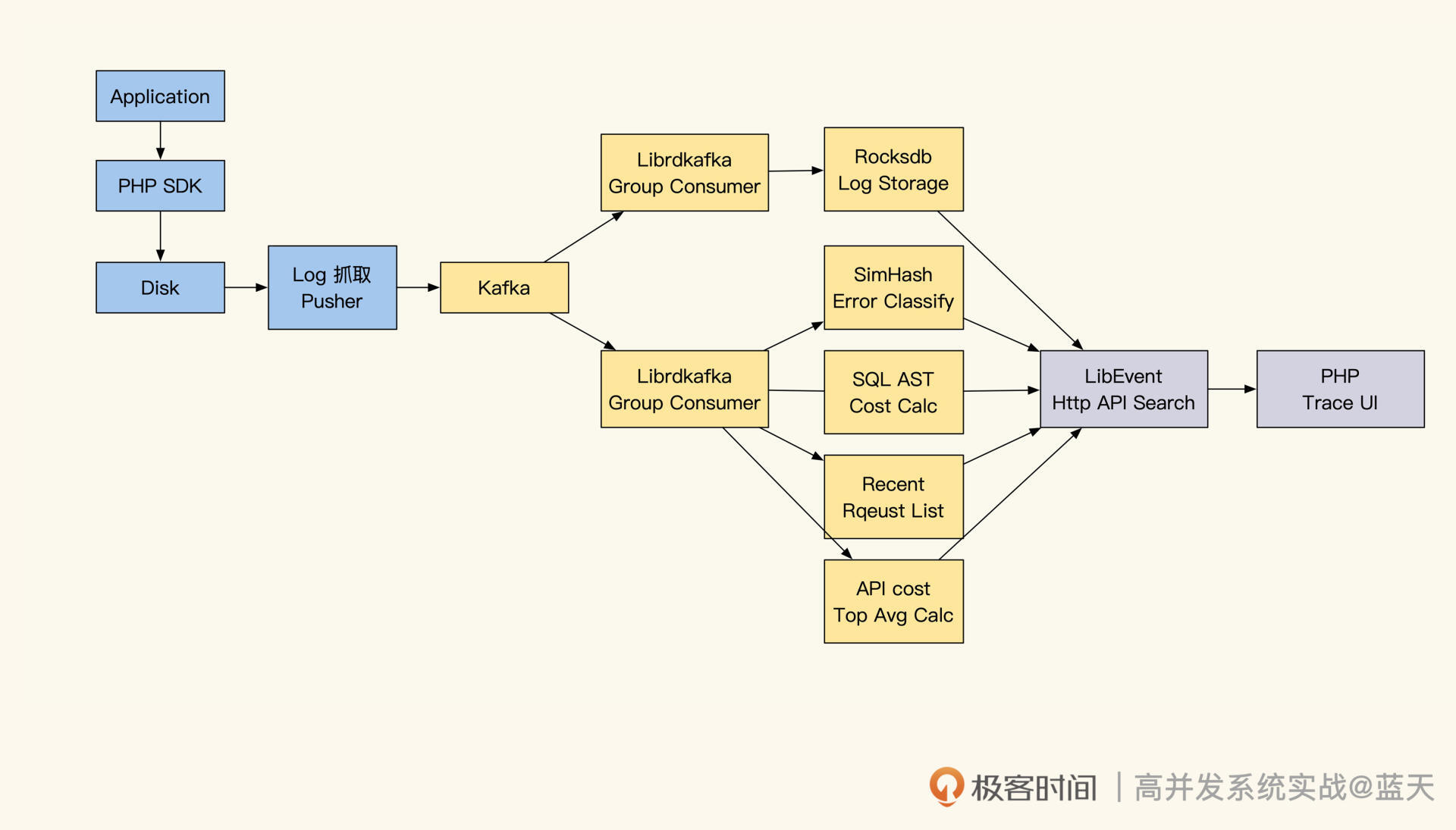

链路追踪:如何定制一个分布式链路跟踪系统 ?

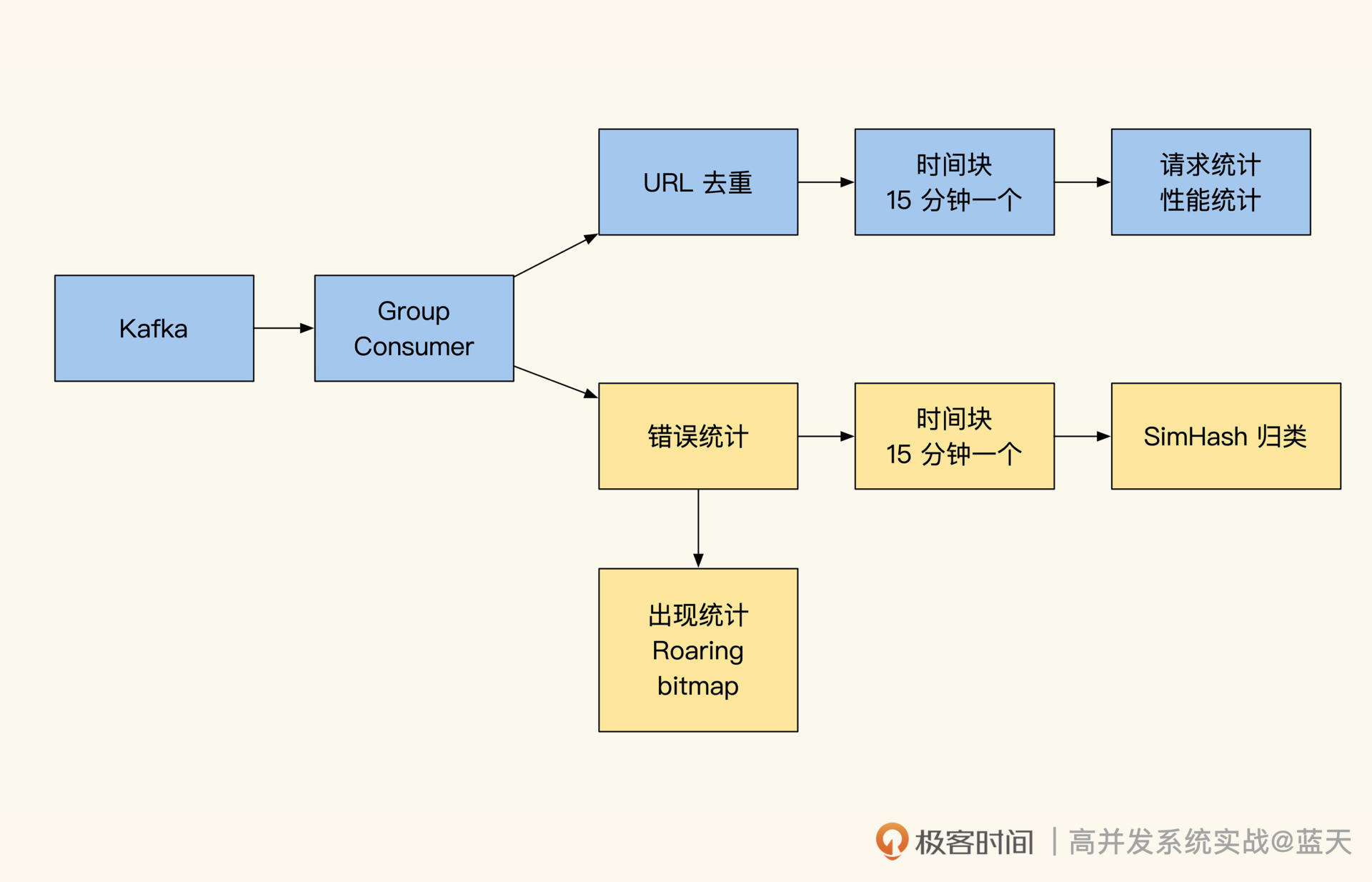

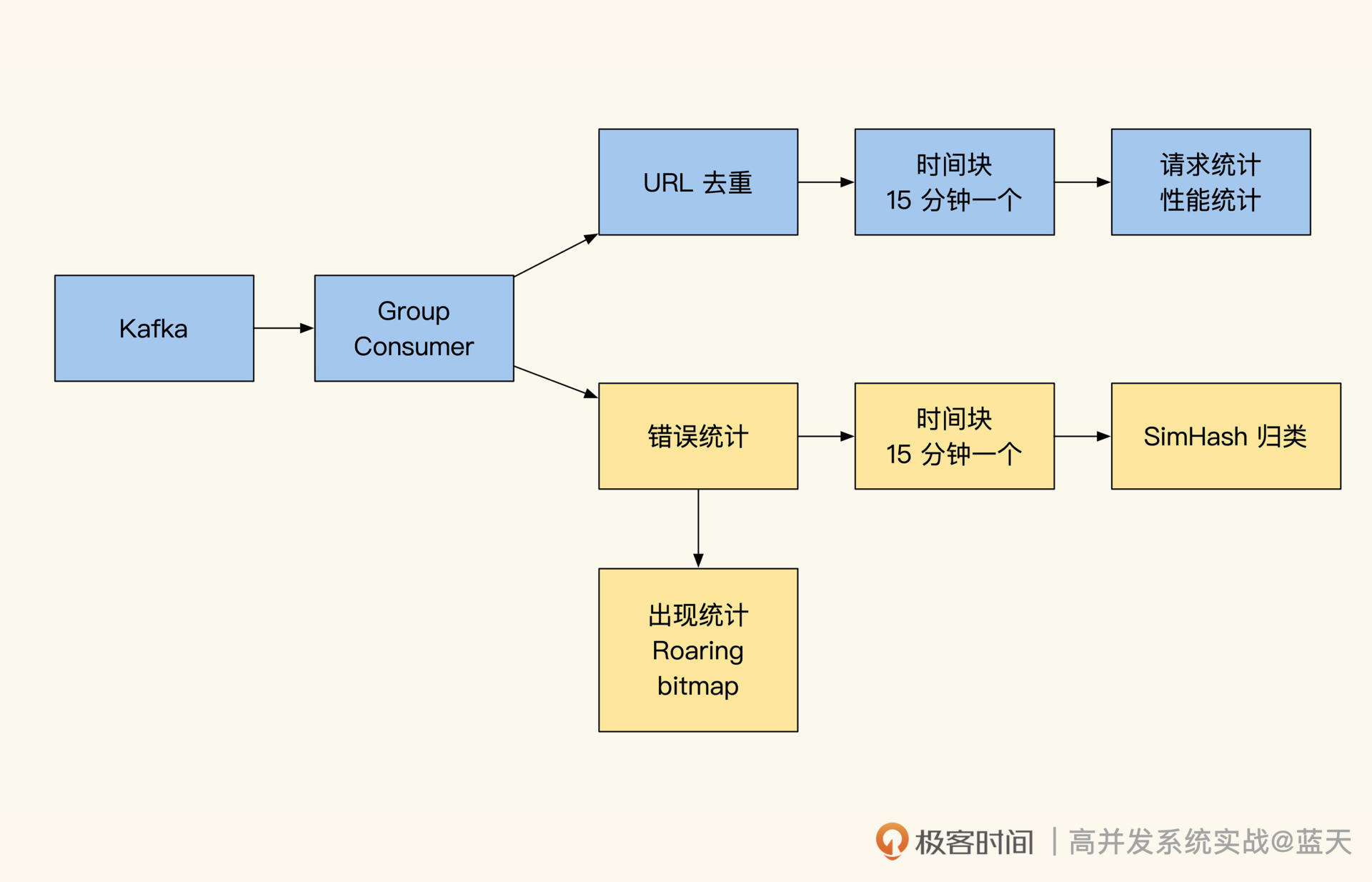

分布式链路跟踪服务属于写多读少的服务,是我们线上排查问题的重要支撑。我经历过的一个系统,同时支持着多条业务线,实际用上的服务器有两百台左右,这种量级的系统想排查故障,难度可想而知。

因此,我结合 ELK 特性设计了一套十分简单的全量日志分布式链路跟踪,把日志串了起来,大大降低了系统排查难度。

目前市面上开源提供的分布式链路跟踪都很抽象,当业务复杂到一定程度的时候,为核心系统定制一个符合自己业务需要的链路跟踪,还是很有必要的。

事实上,实现一个分布式链路跟踪并不难,而是难在埋点、数据传输、存储、分析上,如果你的团队拥有这些能力,也可以很快制作出一个链路跟踪系统。所以下面我们一起看看,如何实现一个简单的定制化分布式链路跟踪。

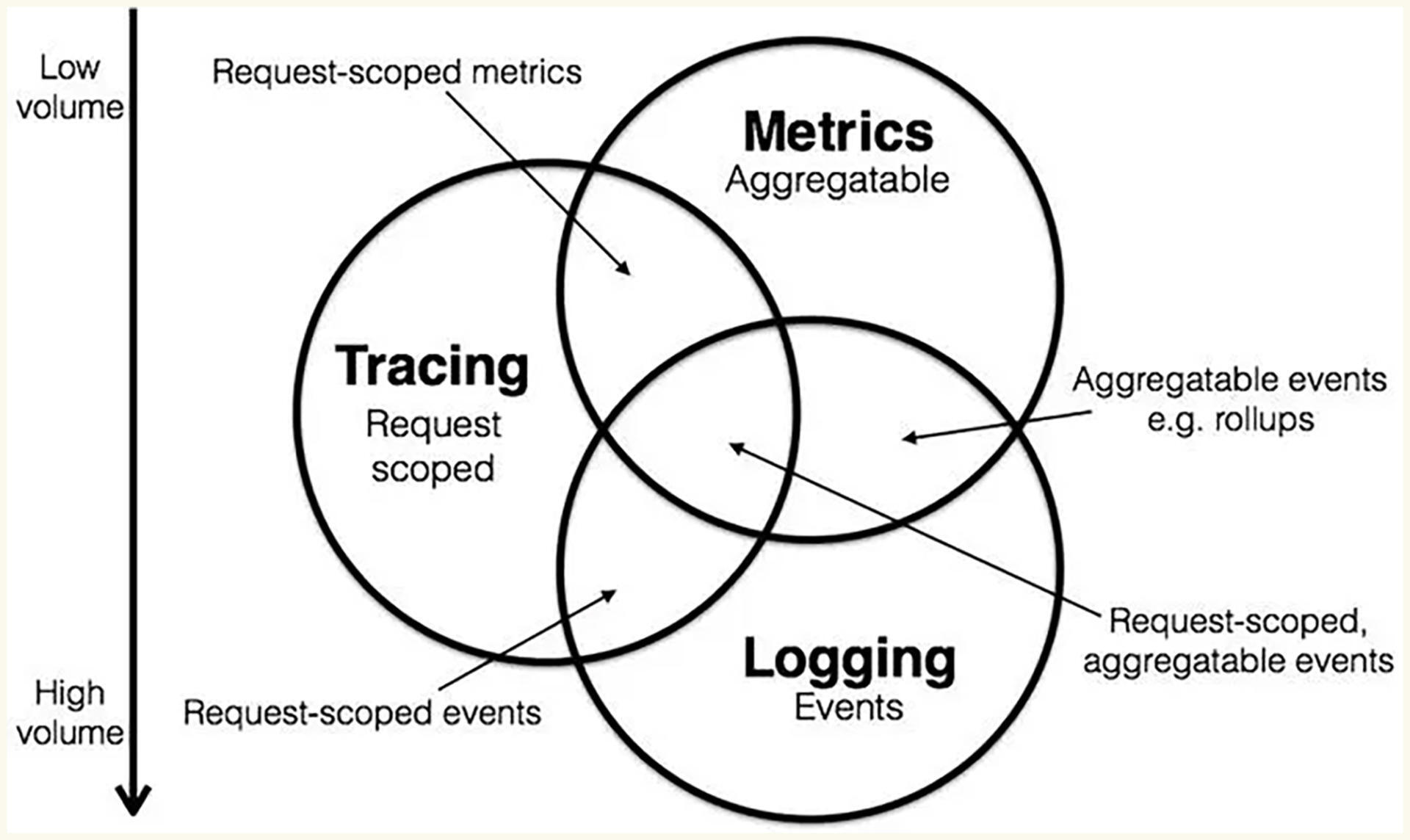

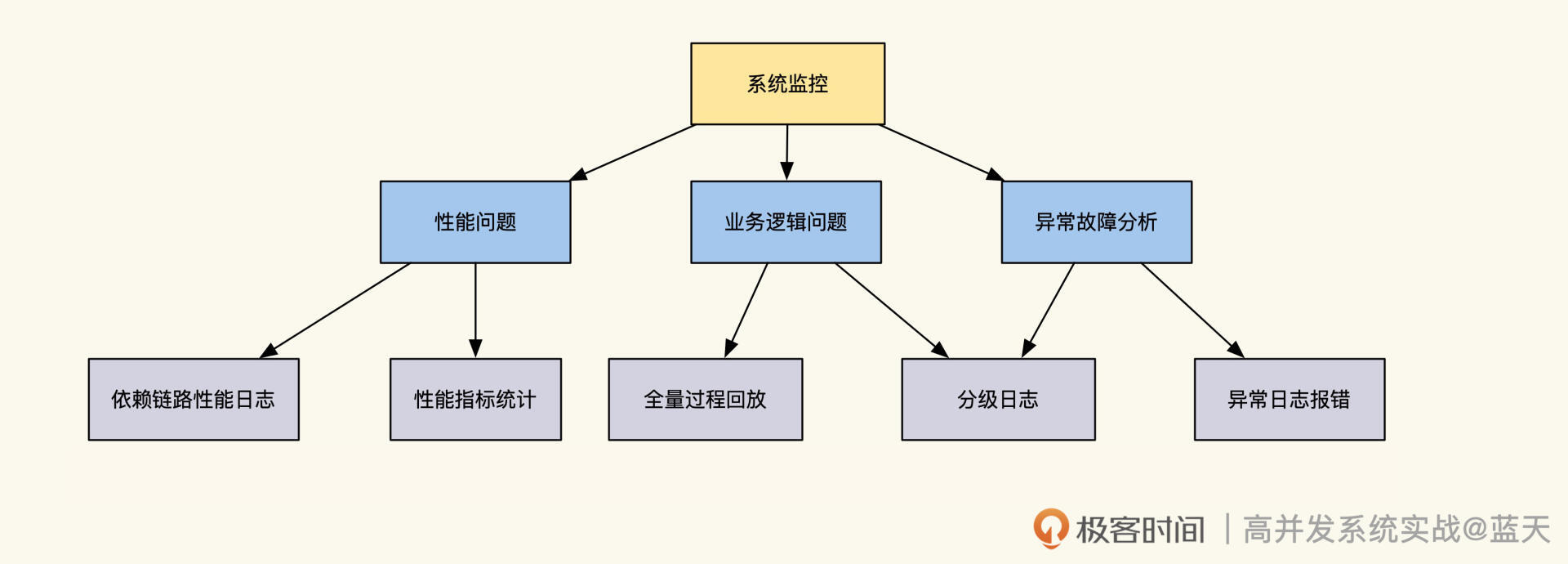

监控行业发展现状

在学习如何制作一个简单的分布式链路跟踪之前,为了更好了解这个链路跟踪的设计特点,我们先简单了解一下监控行业的现状。

最近监控行业有一次大革新,现代的链路跟踪标准已经不拘泥于请求的链路跟踪,目前已经开始进行融合,新的标准和我们定制化的分布式链路跟踪的设计思路很相似,即 Trace、Metrics、日志合并成一套系统进行建设。

在此之前,常见监控系统主要有三种类型:Metrics、Tracing 和 Logging。

常见的开源 Metrics 有 Zabbix、Nagios、Prometheus、InfluxDb、OpenFalcon,主要做各种量化指标汇总统计,比如监控系统的容量剩余、每秒请求量、平均响应速度、某个时段请求量多少。

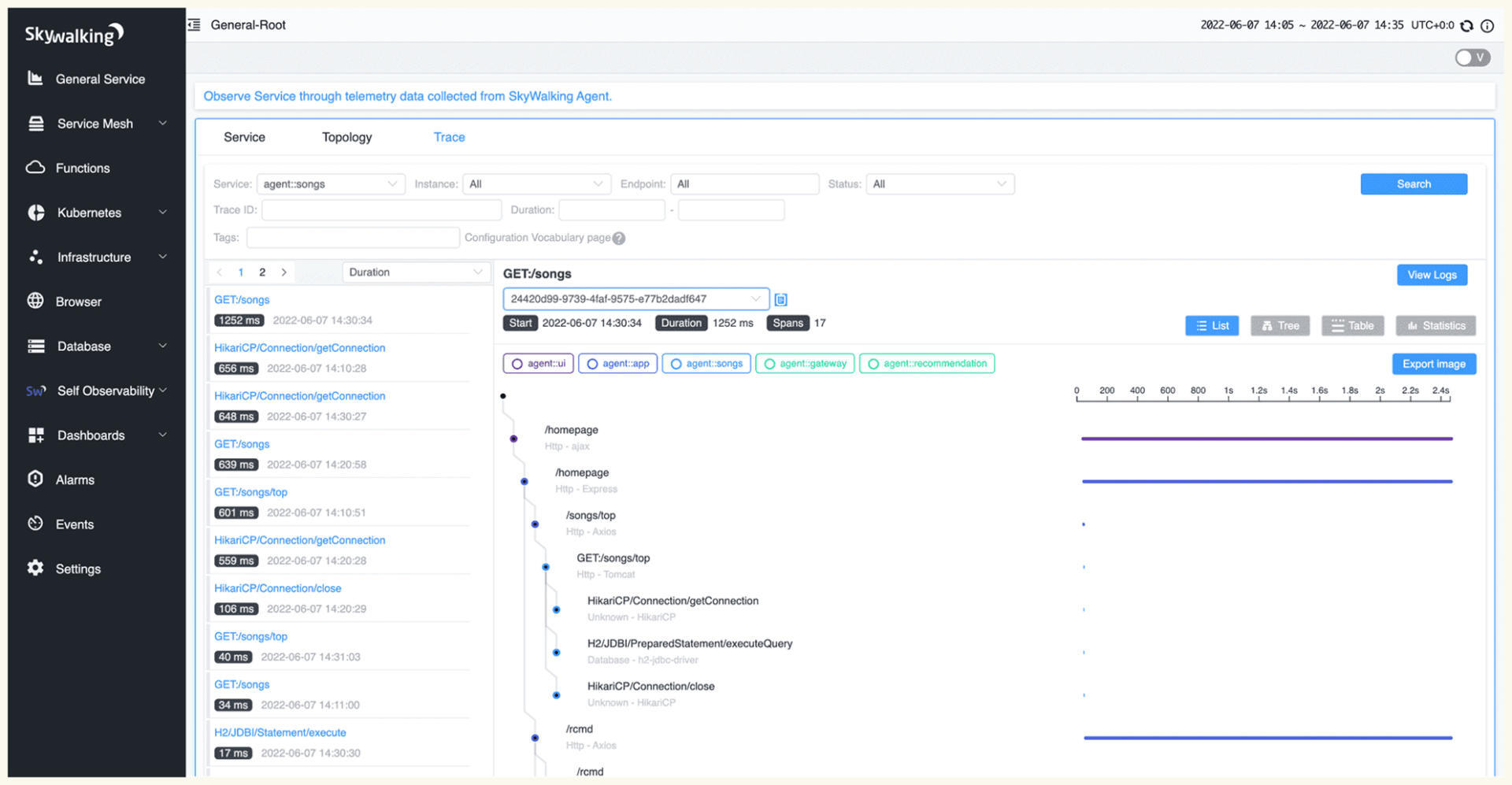

常见的开源链路跟踪有 **Jaeger、Zipkin、Pinpoint、Skywalking,**主要是通过分析每次请求链路监控分析的系统,我么可以通过 TraceID 查找一次请求的依赖及调用链路,分析故障点和传导过程的耗时。

Skywalking官方trace界面

Skywalking官方trace界面

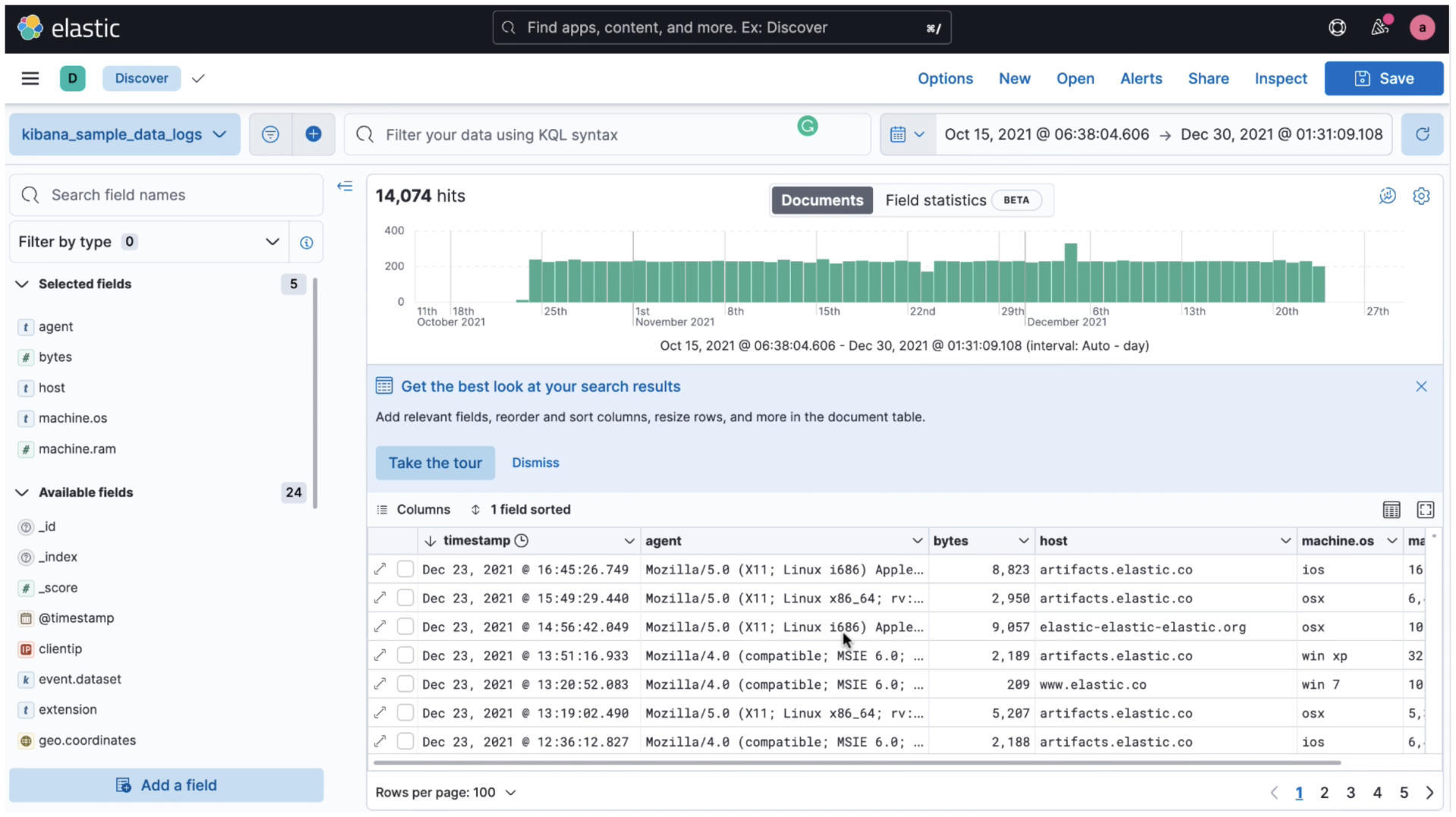

kibana(ELK)官网,日志查找

而常见的开源 Logging 有 ELK、Loki、Loggly,主要是对文本日志的收集归类整理,可以对错误日志进行汇总、警告,并分析系统错误异常等情况。

这三种监控系统可以说是大服务集群监控的主要支柱,它们各有优点,但一直是分别建设的。这让我们的系统监控存在一些割裂和功能重复,而且每一个标准都需要独立建设一个系统,然后在不同界面对同一个故障进行分析,排查问题时十分不便。

随着行业发展,三位一体的标准应运而生,这就是 OpenTelemetry 标准(集成了 OpenCensus、OpenTracing 标准)。这个标准将 Metrics+Tracing+Logging 集成一体,这样我们监控系统的时候就可以通过三个维度综合观测系统运转情况。

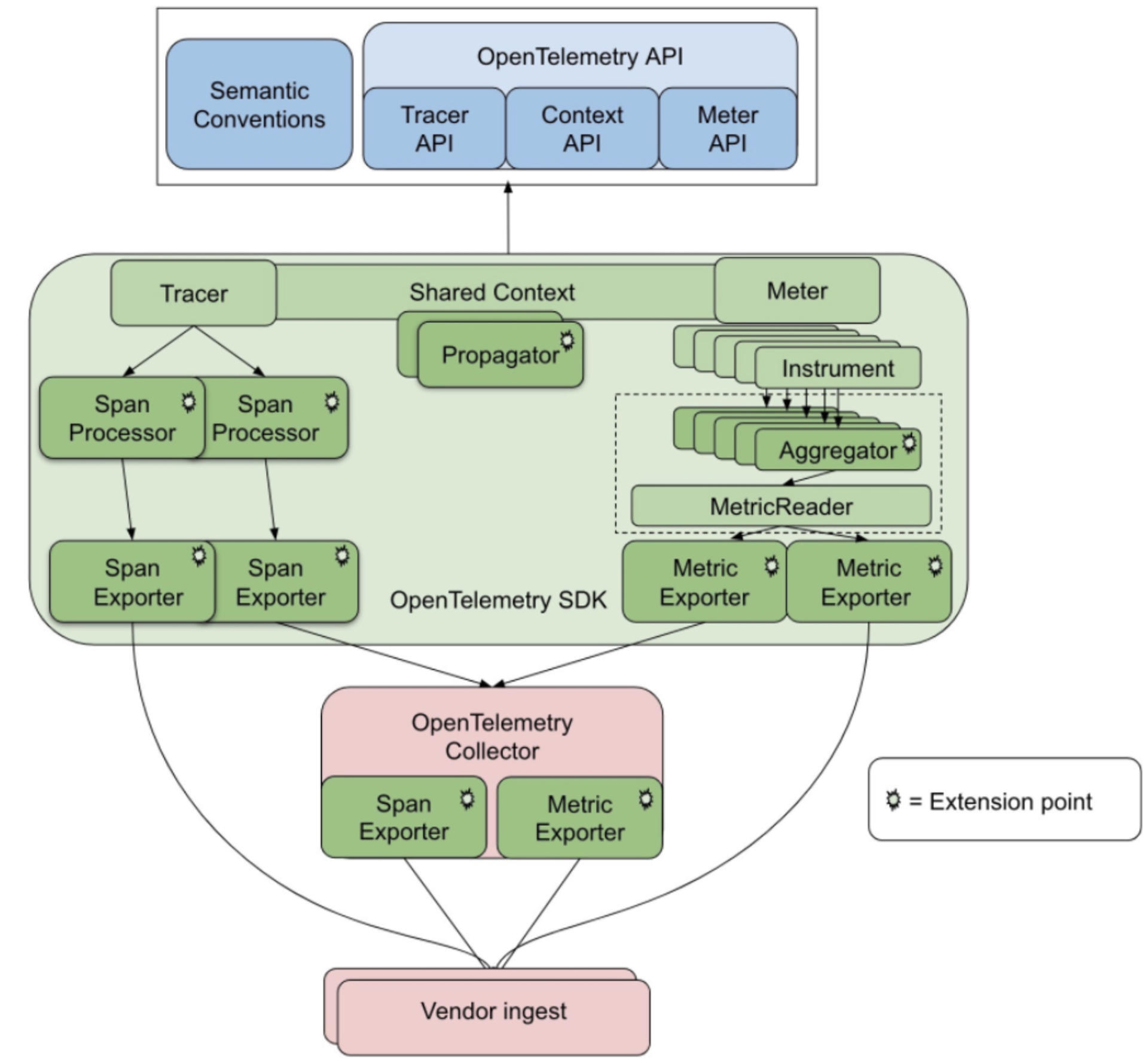

常见 OpenTelemetry 开源项目中的 Prometheus、Jaeger 正在遵循这个标准逐步改进实现 OpenTelemetry 实现的结构如下图所示:

OpenTelemetry标准架构

事实上,分布式链路跟踪系统及监控主要提供了以下支撑服务:

- 监控日志标准

- 埋点 SDK(AOP 或侵入式)

- 日志收集

- 分布式日志传输

- 分布式日志存储

- 分布式检索计算

- 分布式实时分析

- 个性化定制指标盘

- 系统警告

我建议使用 ELK 提供的功能去实现分布式链路跟踪系统,因为它已经完整提供了如下功能:

- 日志收集(Filebeat)

- 日志传输(Kafka+Logstash)

- 日志存储(Elasticsearch)

- 检索计算(Elasticsearch + Kibana)

- 实时分析(Kibana)

- 个性定制表格查询(Kibana)

这样一来,我只需要制定日志格式、埋点 SDK,即可实现一个具有分布式链路跟踪、Metrics、日志分析系统。

事实上,Log、Metrics、trace 三种监控体系最大的区别就是日志格式标准,底层实现其实是很相似的。既然 ELK 已提供我们需要的分布式相关服务,下面我简单讲讲日志格式和 SDK 埋点,通过这两个点我们就可以窥见分布式链路跟踪的全貌。

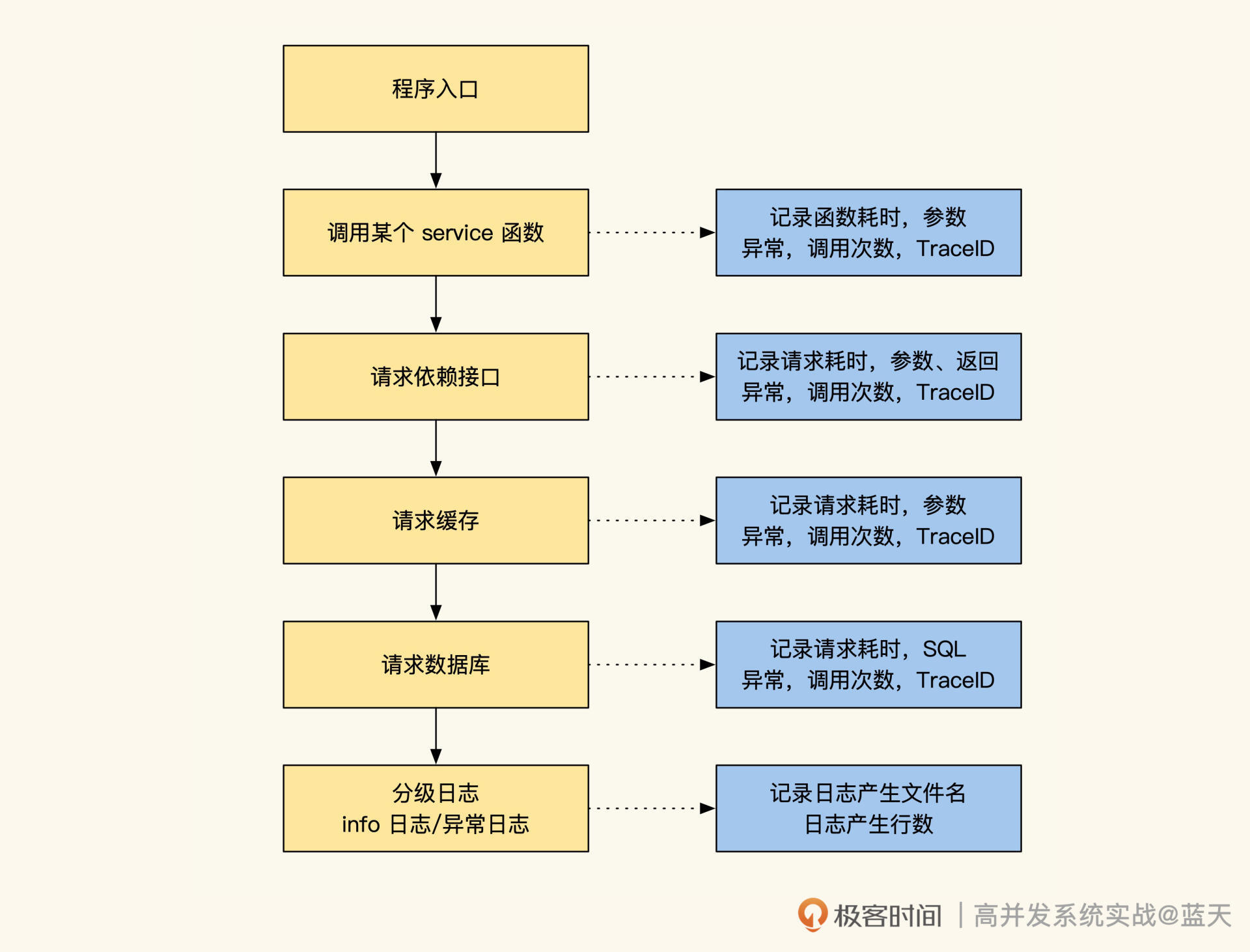

TraceID 单次请求标识

可以说,要想构建一个简单的 Trace 系统,我们首先要做的就是生成并传递 TraceID。

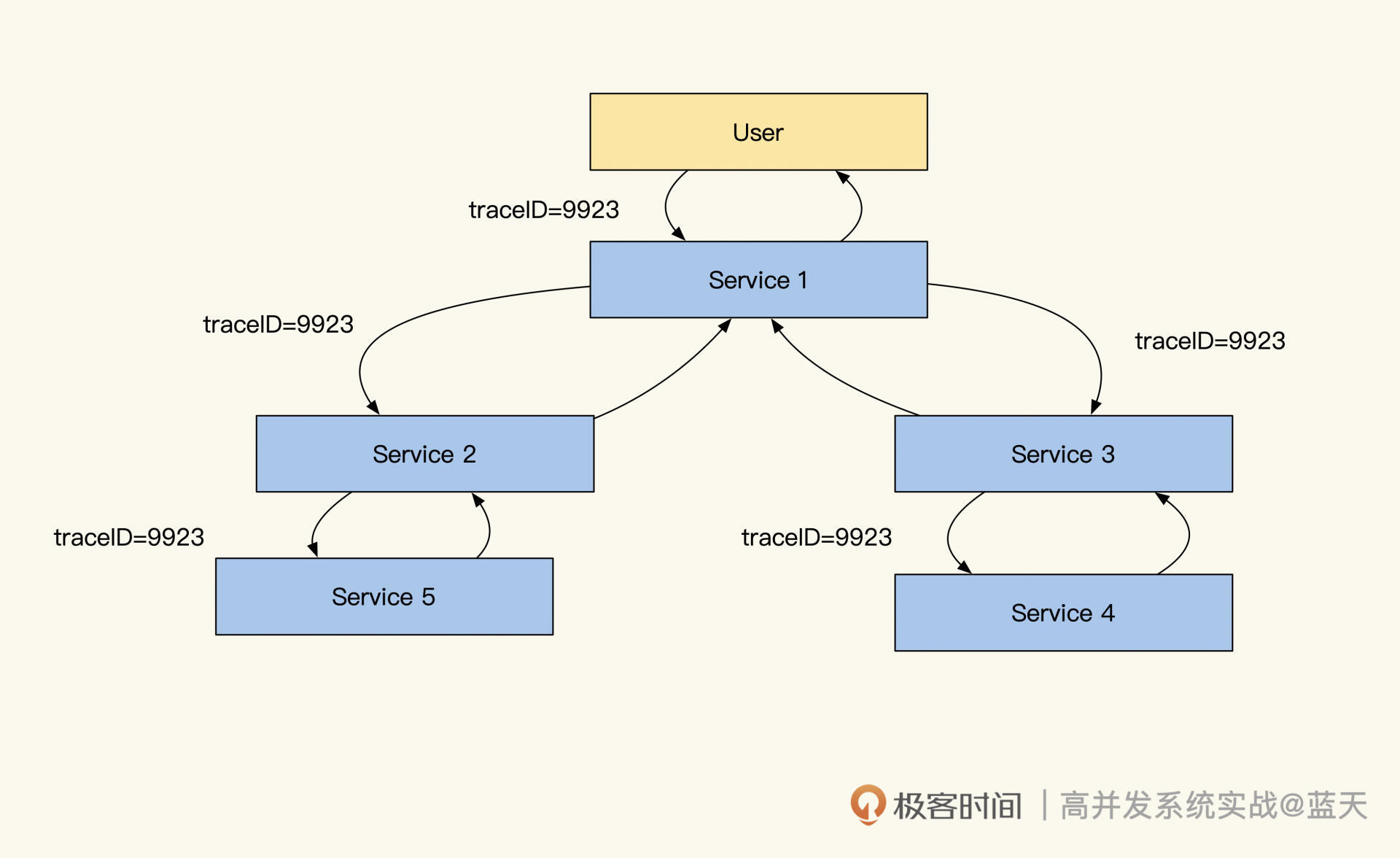

TraceID在各个服务中的传递

分布式链路跟踪的原理其实很简单,就是在请求发起方发送请求时或服务被请求时生成一个 UUID,被请求期间的业务产生的任何日志(Warning、Info、Debug、Error)、任何依赖资源请求(MySQL、Kafka、Redis)、任何内部接口调用(Restful、Http、RPC)都会带上这个 UUID。

这样,当我们把所有拥有同样 UUID 的日志收集起来时,就可以根据时间(有误差)、RPCID(后续会介绍 RPCID)或 SpanID,将它们按依赖请求顺序串起来。

只要日志足够详细,我们就能监控到系统大部分的工作状态,比如用户请求一个服务会调用多少个接口,每个数据查询的 SQL 以及具体耗时调用的内网请求参数是什么、调用的内网请求返回是什么、内网被请求的接口又做了哪些操作、产生了哪些异常信息等等。

同时,我们可以通过对这些日志做归类分析,分析项目之间的调用关系、项目整体健康程度、对链路深挖自动识别出故障点等,帮助我们主动、快速地查找问题。

“RPCID” VS “SpanID 链路标识”

那么如何将汇总起来的日志串联起来呢?有两种方式:span(链式记录依赖)和 RPCID(层级计数器)。我们在记录日志带上 UUID 的同时,也带上 RPCID 这个信息,通过它帮我们把日志关联关系串联起来,那么这两种方式有什么区别呢?

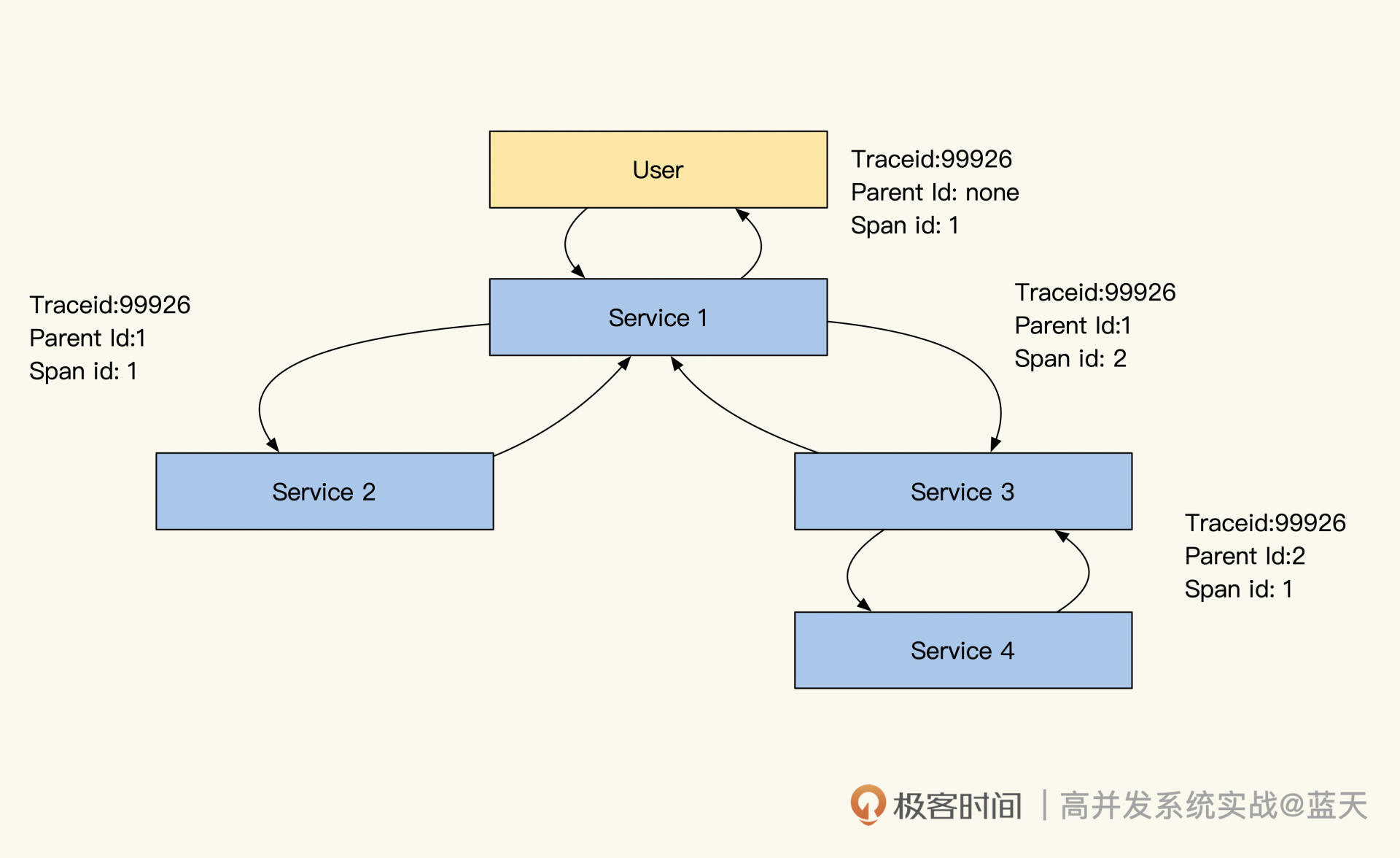

我们先看看 span 实现,具体如下图:

结合上图,我们分析一下 span 的链式依赖记录方式。对于代码来说,写的很多功能会被封装成功能模块(Service、Model),我们通过组合不同的模块实现业务功能,并且记录这两个模块、两个服务间或是资源的调用依赖关系。

span 这个设计会通过记录自己上游依赖服务的 SpanID 实现上下游关系关联(放在 Parent ID 中),通过整理 span 之间的依赖关系就能组合成一个调用链路树。

那 RPCID 方式是什么样的呢?RPCID 也叫层级计数器,我在微博和好未来时都用过,为了方便理解,我们来看下面这张图:

RPCID层级依赖计数器

你看,RPCID 的层级计数器实现很简单,第一个接口生成 RPCID 为 1.1 ,RPCID 的前缀是 1,计数器是 1(日志记录为 1.1)。

当所在接口请求其他接口或数据服务(MySQL、Redis、API、Kafka)时,计数器+1,并在请求当中带上 1.2 这个数值(因为当前的前缀 + “.” + 计数器值 = 1.2),等到返回结果后,继续请求下一个资源时继续 +1,期间产生的任何日志都会记录当前 前缀+“.”+计数器值。

每一层收到了前缀后,都在后面加了一个累加的计数器,实际效果如下图所示:

而被请求的接口收到请求时,如果请求传递了 TraceID,那么被请求的服务会继续使用传递过来的 TraceID,如果请求没有 TraceID 则自己生成一个。同样地,如果传递了 RPCID,那么被请求的服务会将传递来的 RPCID 当作前缀,计数器从 1 开始计数。

相对于 span,通过这个层级计数器做出来的 RPCID 有两个优点。

第一个优点是我们可以记录请求方日志,如果被请求方没有记录日志,那么还可以通过请求方日志观测分析被调用方性能(MySQL、Redis)。

另一个优点是哪怕日志收集得不全,丢失了一些,我们还可以通过前缀有几个分隔符,判断出日志所在层级进行渲染。举个例子,假设我们不知道上图的 1.5.1 是谁调用的,但是根据它的 UUID 和层级 1.5.1 这些信息,渲染的时候,我们仍旧可以渲染它大概的链路位置。

除此之外,我们可以利用 AOP 顺便将各个模块做一个 Metrics 性能统计分析,分析各个模块的耗时、调用次数做周期统计。

同时,通过这个维度采样统计数据,能够帮助我们分析这个模块的性能和错误率。由于 Metrics 这个方式产生的日志量很小,有些统计是每 10 秒才会产生一条 Metrics 统计日志,统计的数值很方便对比,很有参考价值。

但是你要注意,对于一个模块内有多个分支逻辑时,Metrics 很多时候取的是平均数,偶发的超时在平均数上看不出来,所以我们需要另外记录一下最大最小的延迟,才可以更好地展现。同时,这种统计只是让我们知道这个模块是否有性能问题,但是无法帮助我们分析具体的原因。

回到之前的话题,我们前面提到,请求和被请求方通过传递 TraceID 和 RPCID(或 SpanID)来实现链路的跟踪,我列举几个常见的方式供你参考:

- HTTP 协议放在 Header;

- RPC 协议放在 meta 中传递;

- 队列可以放在消息体的 Header 中,或直接在消息体中传递;

- 其他特殊情况下可以通过网址请求参数传递。

那么应用内多线程和多协程之间如何传递 TraceID 呢?一般来说,我们会通过复制一份 Context 传递进入线程或协程,并且如果它们之前是并行关系,我们复制之后需要对下发之前的 RPCID 计数器加 1,并把前缀和计数器合并成新的前缀,以此区分并行的链路。

除此之外,我们还做了一些特殊设计,当我们的请求中带一个特殊的密语,并且设置类似 X-DEBUG Header 等于 1 时,我们可以开启在线 debug 模式,在被调用接口及所有依赖的服务都会输出 debug 级别的日志,这样我们临时排查线上问题会更方便。

日志类型定义

可以说,只要让日志输出当前的 TraceId 和 RPCID(SpanID),并在请求所有依赖资源时把计数传递给它们,就完成了大部分的分布式链路跟踪。下面是我定制的一些日志类型和日志格式,供你参考:

## 日志类型

* request.info 当前被请求接口的相关信息,如被请求接口,耗时,参数,返回值,客户端信息

* mysql.connect mysql连接时长

* mysql.connect.error mysql链接错误信息

* mysql.request mysql执行查询命令时长及相关信息

* mysql.request.error mysql操作时报错的相关信息

* redis.connect redis 链接时长

* redis.connect.error redis链接错误信息

* redis.request redis执行命令

* redis.request.error redis操作时错误

* memcache.connect

* memcache.connect.error

* memcache.request.error

* http.get 另外可以支持restful操作get put delete

* http.post

* http.*.error

## Metric日志类型

* metric.counter

...略

## 分级日志类型

* log.debug: debug log

* log.trace: trace log

* log.notice: notice log

* log.info: info log

* log.error: application error log

* log.alarm: alarm log

* log.exception: exception log

你会发现,所有对依赖资源的请求都有相关日志,这样可以帮助我们分析所有依赖资源的耗时及返回内容。此外,我们的分级日志也在 trace 跟踪范围内,通过日志信息可以更好地分析问题。而且,如果我们监控的是静态语言,还可以像之前说的那样,对一些模块做 Metrics,定期产生日志。

日志格式样例

日志建议使用 JSON 格式,所有字段除了标注为 string 的都建议保存为字符串类型,每个字段必须是固定数据类型,选填内容如果没有内容就直接不输出。

这样设计其实是为了适配 Elasticsearch+Kibana,Kibana 提供了日志的聚合、检索、条件检索和数值聚合,但是对字段格式很敏感,不是数值类型就无法聚合对比。

下面我给你举一个例子用于链路跟踪和监控,你主要关注它的类型和字段用途。

{

"name": "string:全量字段介绍,必填,用于区分日志类型,上面的日志列表内容写这里",

"trace_id": "string:traceid,必填",

"rpc_id": "string:RPCID,服务端链路必填,客户端非必填",

"department":"部门缩写如client_frontend 必填",

"version": "string:当前服务版本 cpp-client-1.1 php-baseserver-1.4 java-rti-1.9,建议都填",

"timestamp": "int:日志记录时间,单位秒,必填",

"duration": "float:消耗时间,浮点数 单位秒,能填就填",

"module": "string:模块路径,建议格式应用名称_模块名称_函数名称_动作,必填",

"source": "string:请求来源 如果是网页可以记录ref page,选填",

"uid": "string:当前用户uid,如果没有则填写为 0长度字符串,可选填,能够帮助分析用户一段时间行为",

"pid": "string:进程pid,如果没有填写为 0长度字符串,如果有线程可以为pid-tid格式,可选填",

"server_ip": "string 当前服务器ip,必填",

"client_ip": "string 客户端ip,选填",

"user_agent": "string curl/7.29.0 选填",

"host": "string 链接目标的ip及端口号,用于区分环境12.123.23.1:3306,选填",

"instance_name": "string 数据库连接配置的标识,比如rti的数据库连接,选填",

"db": "string 数据库名称如:peiyou_stastic,选填",

"code": "string:各种驱动或错误或服务的错误码,选填,报错误必填",

"msg": "string 错误信息或其他提示信息,选填,报错误必填",

"backtrace": "string 错误的backtrace信息,选填,报错误必填",

"action": "string 可以是url、sql、redis命令、所有让远程执行的命令,必填",

"param": "string 通用参数模板,用于和script配合,记录所有请求参数,必填",

"file": "string userinfo.php,选填",

"line": "string 232,选填",

"response": "string:请求返回的结果,可以是本接口或其他资源返回的数据,如果数据太长会影响性能,选填",

"response_length": "int:相应内容结果的长度,选填",

"dns_duration": "float dns解析时间,一般http mysql请求域名的时候会出现此选项,选填",

"extra": "json 放什么都可以,用户所有附加数据都扔这里"

}

## 样例

被请求日志

{

"x_name": "request.info",

"x_trace_id": "123jiojfdsao",

"x_rpc_id": "0.1",

"x_version": "php-baseserver-4.0",

"x_department":"tal_client_frontend",

"x_timestamp": 1506480162,

"x_duration": 0.021,

"x_uid": "9527",

"x_pid": "123",

"x_module": "js_game1_start",

"x_user_agent": "string curl/7.29.0",

"x_action": "http://testapi.speiyou.com/v3/user/getinfo?id=9527",

"x_server_ip": "192.168.1.1:80",

"x_client_ip": "192.168.1.123",

"x_param": "json string",

"x_source": "www.baidu.com",

"x_code": "200",

"x_response": "json:api result",

"x_response_len": 12324

}

### mysql 链接性能日志

{

"x_name": "mysql.connect",

"x_trace_id": "123jiojfdsao",

"x_rpc_id": "0.2",

"x_version": "php-baseserver-4",

"x_department":"tal_client_frontend",

"x_timestamp": 1506480162,

"x_duration": 0.024,

"x_uid": "9527",

"x_pid": "123",

"x_module": "js_mysql_connect",

"x_instance_name": "default",

"x_host": "12.123.23.1:3306",

"x_db": "tal_game_round",

"x_msg": "ok",

"x_code": "1",

"x_response": "json:****"

}

### Mysql 请求日志

{

"x_name": "mysql.request",

"x_trace_id": "123jiojfdsao",

"x_rpc_id": "0.2",

"x_version": "php-4",

"x_department":"tal_client_frontend",

"x_timestamp": 1506480162,

"x_duration": 0.024,

"x_uid": "9527",

"x_pid": "123",

"x_module": "js_game1_round_sigup",

"x_instance_name": "default",

"x_host": "12.123.23.1:3306",

"x_db": "tal_game_round",

"x_action": "select * from xxx where xxxx",

"x_param": "json string",

"x_code": "1",

"x_msg": "ok",

"x_response": "json:****"

}

### http 请求日志

{

"x_name": "http.post",

"x_trace_id": "123jiojfdsao",

"x_department":"tal_client_frontend",

"x_rpc_id": "0.3",

"x_version": "php-4",

"x_timestamp": 1506480162,

"x_duration": 0.214,

"x_uid": "9527",

"x_pid": "123",

"x_module": "js_game1_round_win_report",

"x_action": "http://testapi.speiyou.com/v3/game/report",

"x_param": "json:",

"x_server_ip": "192.168.1.1",

"x_msg": "ok",

"x_code": "200",

"x_response_len": 12324,

"x_response": "json:responsexxxx",

"x_dns_duration": 0.001

}

### level log info日志

{

"x_name": "log.info",

"x_trace_id": "123jiojfdsao",

"x_department":"tal_client_frontend",

"x_rpc_id": "0.3",

"x_version": "php-4",

"x_timestamp": 1506480162,

"x_duration": 0.214,

"x_uid": "9527",

"x_pid": "123",

"x_module": "game1_round_win_round_end",

"x_file": "userinfo.php",

"x_line": "232",

"x_msg": "ok",

"x_code": "201",

"extra": "json game_id lesson_num xxxxx"

}

### exception 异常日志

{

"x_name": "log.exception",

"x_trace_id": "123jiojfdsao",

"x_department":"tal_client_frontend",

"x_rpc_id": "0.3",

"x_version": "php-4",

"x_timestamp": 1506480162,

"x_duration": 0.214,

"x_uid": "9527",

"x_pid": "123",

"x_module": "game1_round_win",

"x_file": "userinfo.php",

"x_line": "232",

"x_msg": "exception:xxxxx call stack",

"x_code": "hy20001",

"x_backtrace": "xxxxx.php(123) gotError:..."

}

### 业务自发告警日志

{

"x_name": "log.alarm",

"x_trace_id": "123jiojfdsao",

"x_department":"tal_client_frontend",

"x_rpc_id": "0.3",

"x_version": "php-4",

"x_timestamp": 1506480162,

"x_duration": 0.214,

"x_uid": "9527",

"x_pid": "123",

"x_module": "game1_round_win_round_report",

"x_file": "game_win_notify.php",

"x_line": "123",

"x_msg": "game report request fail! retryed three time..",

"x_code": "201",

"x_extra": "json game_id lesson_num xxxxx"

}

### matrics 计数器

{

"x_name": "metrix.count",

"x_trace_id": "123jiojfdsao",

"x_department":"tal_client_frontend",

"x_rpc_id": "0.3",

"x_version": "php-4",

"x_timestamp": 1506480162,

"x_uid": "9527",

"x_pid": "123",

"x_module": "game1_round_win_click",

"x_extra": "json curl invoke count"

}

这个日志不仅可以用在服务端,还可以用在客户端。客户端每次被点击或被触发时,都可以自行生成一个新的 TraceID,在请求服务端时就会带上它。通过这个日志,我们可以分析不同地域访问服务的性能,也可以用作用户行为日志,仅仅需添加我们的日志类型即可。

上面的日志例子基本把我们依赖的资源情况描述得很清楚了。另外,我补充一个技巧,性能记录日志可以将被请求的接口也记录成一个日志,记录自己的耗时等信息,方便之后跟请求方的请求日志对照,这样可分析出两者之间是否有网络延迟等问题。

除此之外,这个设计还有一个核心要点:研发并不一定完全遵守如上字段规则生成日志,业务只要保证项目范围内输出的日志输出所有必填项目(TraceID,RPCID/SpanID,TimeStamp),同时保证数值型字段功能及类型稳定,即可实现 trace。

我们完全可以汇总日志后,再对不同的日志字段做自行解释,定制出不同业务所需的统计分析,这正是 ELK 最强大的地方。

为什么大部分设计都是记录依赖资源的日志呢?原因在于在没有 IO 的情况下,程序大部分都是可控的(侧重计算的服务除外)。只有 IO 类操作容易出现不稳定因素,并且日志记录过多也会影响系统性能,通过记录对数据源的操作能帮助我们排查业务逻辑的错误。

我们刚才提到日志如果过多会影响接口性能,那如何提高日志的写吞吐能力呢?这里我为你归纳了几个注意事项和技巧:

- 提高写线程的个数,一个线程写一个日志,也可以每个日志文件单独放一个磁盘,但是你要注意控制系统的 IOPS 不要超过 100;

- 当写入日志长度超过 1kb 时,不要使用多个线程高并发写同一个文件。原因参考 append is not Atomic,简单来说就是文件的 append 操作对于写入长度超过缓冲区长度的操作不是原子性的,多线程并发写长内容到同一个文件,会导致日志乱序;

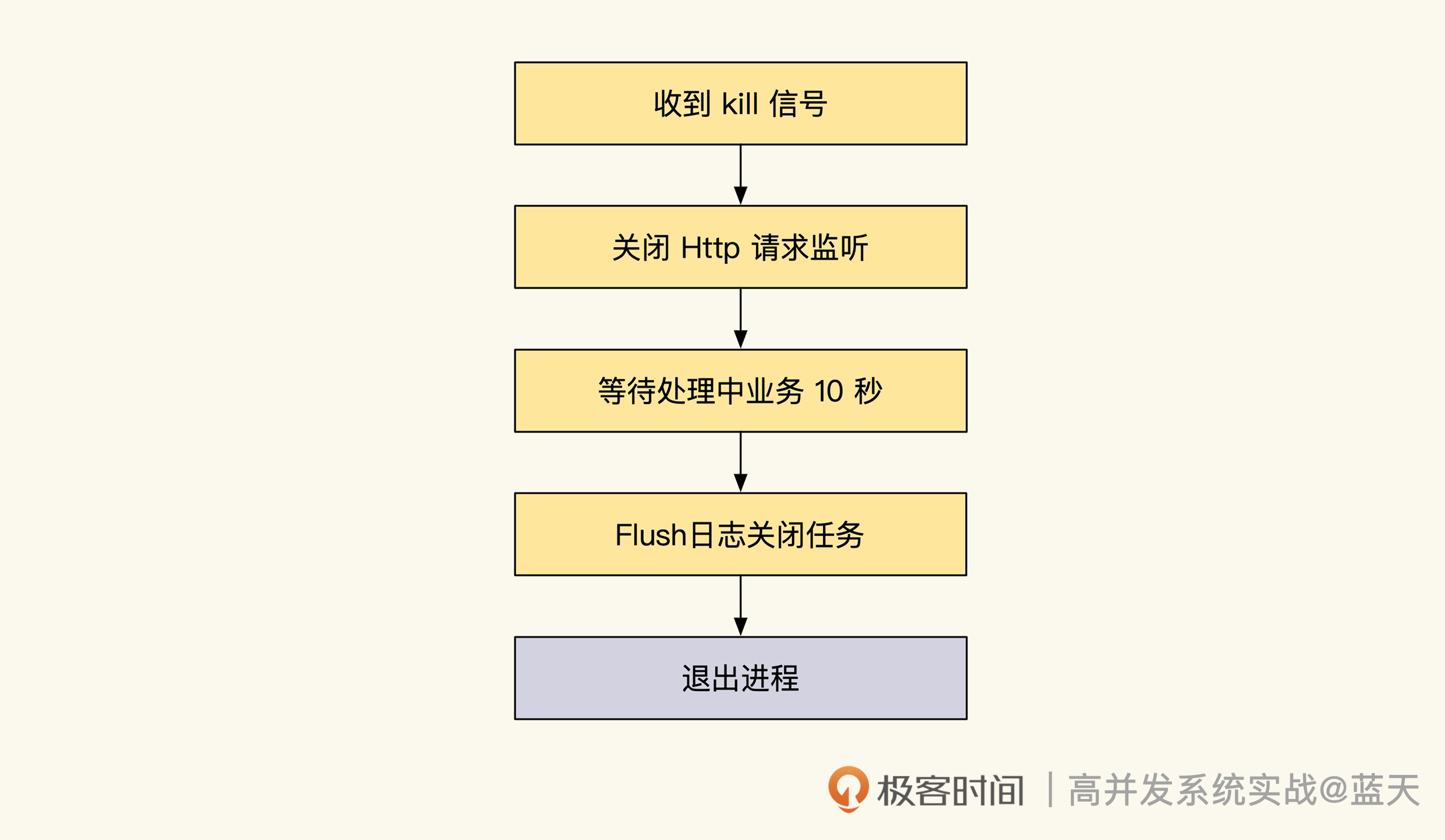

- 日志可以通过内存暂存,汇总达到一定数据量或缓存超过 2 秒后再落盘,这样可以减少过小日志写磁盘系统的调用次数,但是代价是被强杀时会丢日志;

- 日志缓存要提前 malloc 使用固定长度缓存,不要频繁分配回收,否则会导致系统整体缓慢;

- 服务被 kill 时,记得拦截信号,快速 fsync 内存中日志到磁盘,以此减少日志丢失的可能。

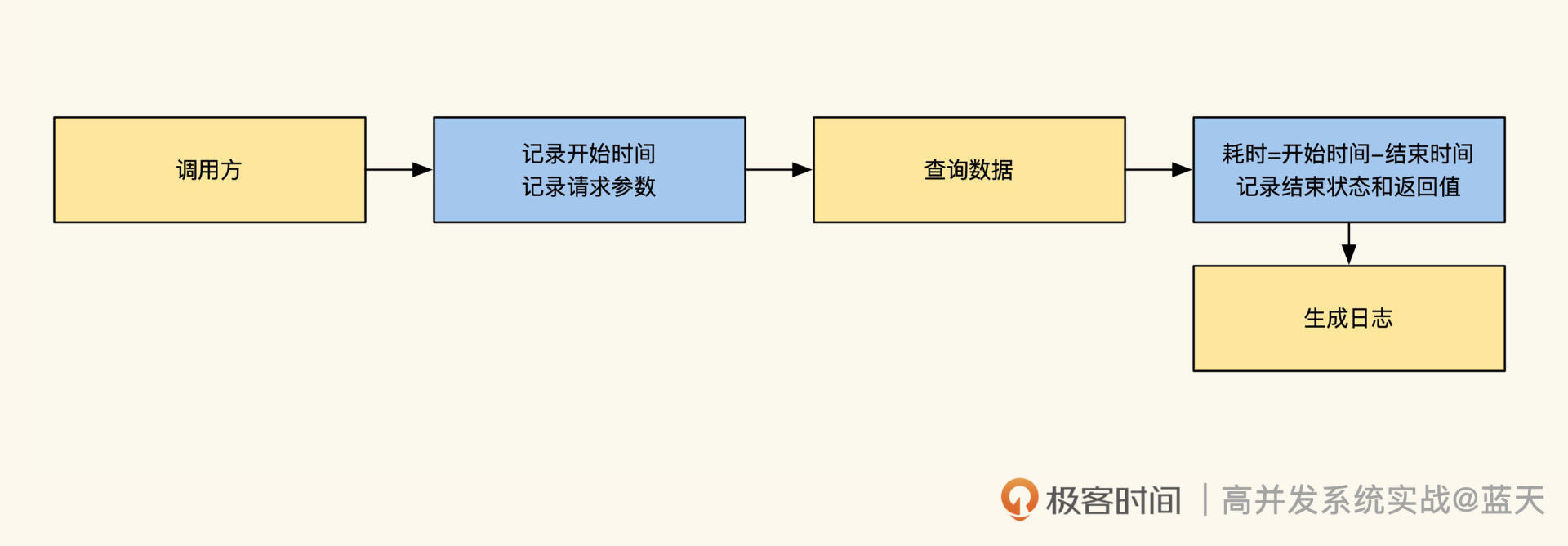

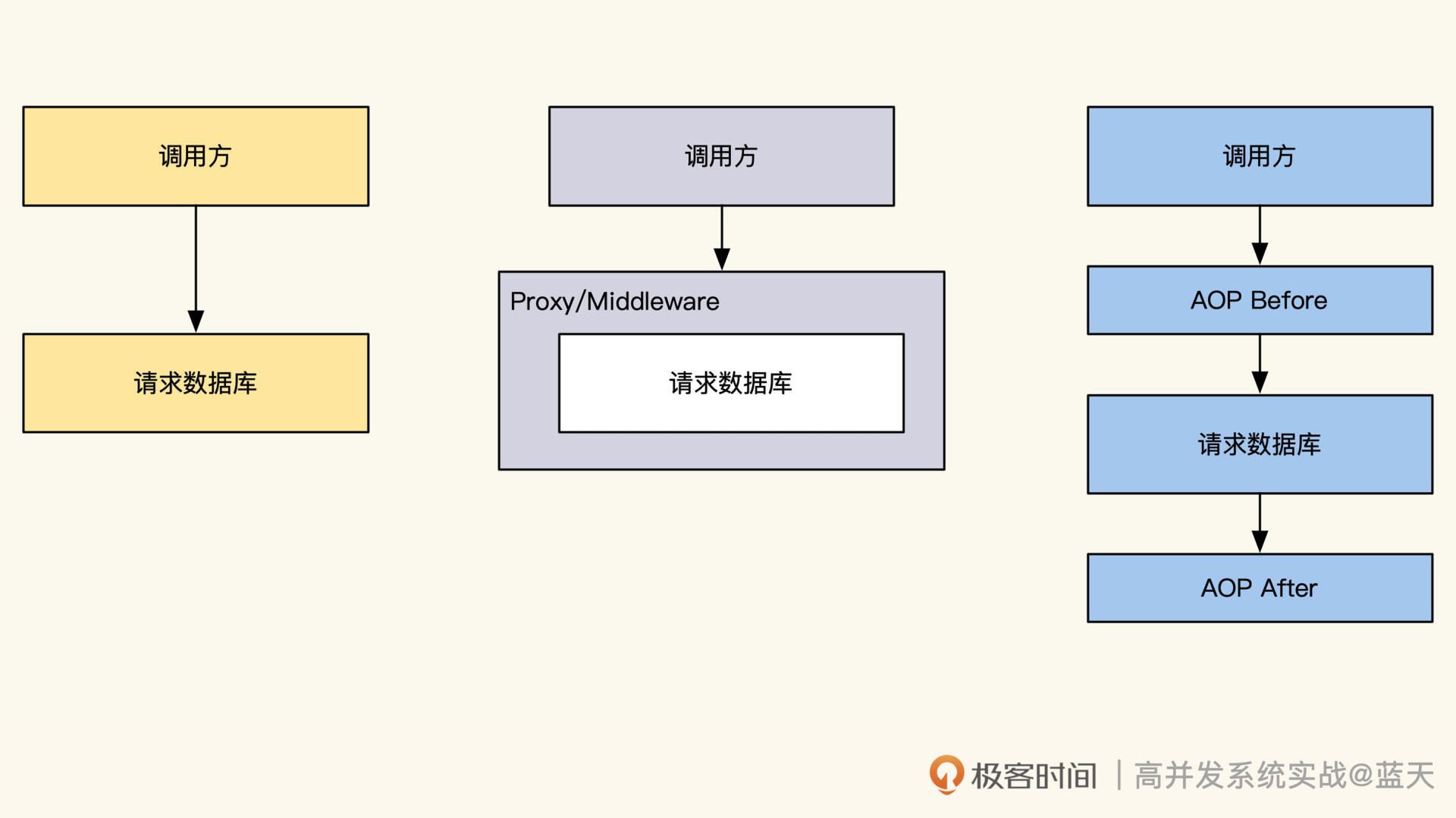

“侵入式埋点 SDK”VS“AOP 方式埋点”

最后,我们再说说 SDK。事实上,使用“ELK+ 自定义的标准”基本上已经能实现大多数的分布式链路跟踪系统,使用 Kibana 可以很快速地对各种日志进行聚合分析统计。

虽然行业中出现过很多链路跟踪系统服务公司,做了很多 APM 等类似产品,但是能真正推广开的服务实际占少数,究其原因,我认为是以下几点:

- 分布式链路跟踪的日志吞吐很大,需要耗费大量的资源,成本高昂;

- 通用分布式链路跟踪服务很难做贴近业务的个性化,不能定制的第三方服务不如用开源;

- 分布式链路跟踪的埋点库对代码的侵入性大,需要研发手动植入到业务代码里,操作很麻烦,而且不够灵活。

- 另外,这种做法对语言也有相关的限制,因为目前只有 Java 通过动态启动注入 agent,才实现了静态语言 AOP 注入。我之前推广时,也是统一了内网项目的开源框架,才实现了统一的链路跟踪。

那么如果底层代码不能更新,如何简单暴力地实现链路跟踪呢?