文章目录

一、概述

AWK 是一种处理文本文件的语言,是一个强大的文本分析工具。它是专门为文本处理设计的编程语言,也是行处理软件,通常用于扫描、过滤、统计汇总工作。数据可以来自标准输入也可以是管道或文件。

20世纪70年代诞生于贝尔实验室,现在centos7用的是gawk之所以叫 AWK 是因为其取了三位创始人 Alfred Aho,Peter Weinberger, 和 Brian Kernighan 的 Family Name 的首字符。AWK:Aho, Weinberger, Kernighan,报告生成器,格式化文本输出,GNU/Linux发布的AWK目前由自由软件基金会(FSF)进行开发和维护,通常也称它为 GNU AWK。

有多种版本:

- AWK:原先来源于 AT & T 实验室的的AWK

- NAWK:New awk,AT & T 实验室的AWK的升级版

- GAWK:即GNU AWK。所有的GNU/Linux发布版都自带GAWK,它与AWK和NAWK完全兼容

二、工作原理

当读到第一行时,匹配条件,然后执行指定动作,再接着读取第二行数据处理,不会默认输出。如果没有定义匹配条件默认是匹配所有数据行,awk隐含循环,条件匹配多少次动作就会执行多少次。逐行读取文本,默认以空格或tab键为分隔符进行分隔,将分隔所得的各个字段保存到内建变量中,并按模式或者条件执行编辑命令。sed命令常用于一整行的处理,而awk比较、倾向于将一行分成多个"字段"然后再进行处理。awk信息的读入也是逐行读取的,执行结果可以通过print的功能将字段数据打印显示。在使用awk命令的过程中,可以使用逻辑操作符" &&“表示"与”、“||表示"或”、"!“表示非”;还可以进行简单的数学的运算,如+、一、、/、%、^分别表示加、减、乘、除、取余和乘方。

三、工作流程

man gawk----》pattern scanning and processing language 模式扫描和处理语言。

pattern [ˈpætn] 模式 ; process [ˈprəʊses] 处理

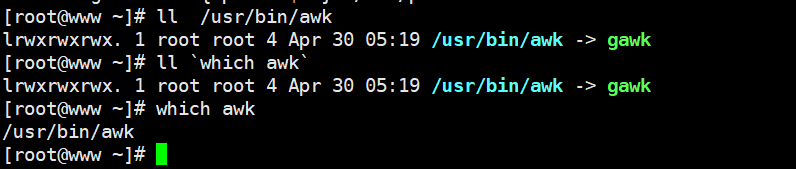

任何 awk 语句都是由模式和动作组成,一个 awk 脚本可以有多个语句。模式决定动作语句的触发条件和触发时间。在 linux 上常用的是 gawk,awk 是 gawk 的链接文件。awk---->gawk 即: gun awk

[root@benet22 opt]# which awk

/usr/bin/awk

[root@benet22 opt]# ll which awk

lrwxrwxrwx. 1 root root 4 8月 19 2022 /usr/bin/awk -> gawk

3.1 运行模式

正则表达式 : /root/ 匹配含有 root 的行 /.root/

关系表达式: < > && || + *

匹配表达式: ~ !~

动作:变量 命令 内置函数 流控制语句它的语法结构如下:

3.2 执行流程

BEGIN 语句设置计数和打印头部信息,在任何动作之前进行。END 语句输出统计结果,在完成动作之后执行。AWK执行的流程非常简单:读(Read)、执行(Execute)与重复(Repeat)。下面的流程图描述出了AWK的工作流程:

awk [options] 'BEGIN{ print "start" } ‘pattern{ commands }’ END{ print "end" }' file

其中:BEGIN END 是 AWK 的关键字部,因此必须大写;这两个部分开始块和结束块是可选的。

从上图我们已经了解了AWK程序的工作流程。接下来我们来看一看AWK程序的结构。顾名思义,开始块就是在程序启动的时候执行的代码部分,并且它在整个过程中只执行一次。一般情况下,我们在开始块中初始化一些变量。BEGIN是AWK的关键字,因此它必须是大写的。不过,开始块部分是可选的,你的程序可以没有开始块部分。对于每一个输入的行,都会执行一次主体部分的命令。默认情况下,对于输入的每一行,AWK都会执行命令。注意:在主体块部分,没有关键字存在。它是在程序结束时执行的代码。END也是AWK的关键字,它也必须大写。与开始块相似,结束块也是可选的。

通过上面我们可以知道AWK 它工作通过三个步骤:

- 读(Read):从文件、管道或标准输入中读入一行然后把它存放到内存中

- 执行(Execute):对每一行数据,根据 AWK 命令按顺序执行。默认情况是处理每一行数据,也可以指定模式

- 重复(Repeat):一直重复上述两个过程直到文件结束

四、基本语法

4.1 命令格式

awk 选项' 模式或条件{操作}' 文件1 文件2 ...

awk -f 脚本文件 文件1 文件2 ..

格式:awk关键字 选项 命令部分 ‘{xxxx}’ 文件名

AWK 支持两种不同类型的变量:内建变量(可直接使用),自定义变量awk 内置变量(预定义变量)如下所示:

- FS:指定每行文本的字段分隔符,默认为空格或制表位。

- NF:当前处理的行的字段个数。在执行过程中对应于当前的字段数,NF:列的个数

- NR:当前处理的行的行号(序数)。 在执行过程中对应于当前的行号

- $0:当前处理的行的整行内容。

- $n:当前处理行的第 n 个字段(第 n 列)。比如: $1 表示第一个字段,$2 表示第二个字段

- FILENAME:被处理的文件名(当前输入文件的名)。

- FNR 各文件分别计数的行号

- OFS 输出字段分隔符(默认值是一个空格)

- ORS 输出记录分隔符(默认值是一个换行符)

- RS:行分隔符。awk从文件上读取资料时,将根据Rs的定义把资料切割成许多条记录, 而awk一次仅读入一条记录,以进行处理。预设值是" \n’

简说:数据记录分隔,默认为\n,即每行为一条记录。

五、实战案例

5.1 开始块(BEGIN block)

主体块(Body Block)结束块(END Block)

内建变量

awk 包含几个特殊的内建变量(可直接用)如下所示:

- FS:指定每行文本的字段分隔符,默认为空格或制表位。

- NF:当前处理的行的字段个数。

- NR:当前处理的行的行号(序数)。

- $0:当前处理的行的整行内容。

- $n:当前处理行的第 n 个字段(第 n 列)。

- FILENAME:被处理的文件名。

- RS:行分隔符。awk从文件上读取资料时,将根据Rs的定义把资料切割成许多条记录, 而awk一次仅读入一条记录,以进行处理。预设值是" \n’

简说:数据记录分隔,默认为\n,即每行为一条记录

5.1.1print

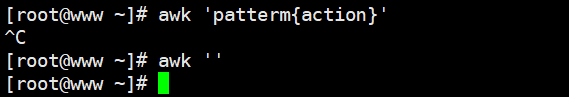

[root@localhost ~]#awk 'patterm{action}'

[root@localhost ~]#awk ' '

什么都不写 空没有效果

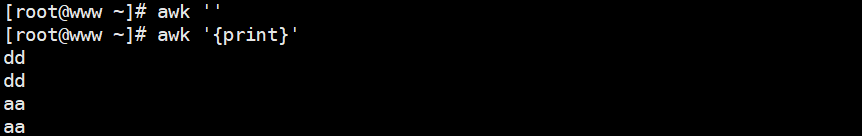

[root@localhost ~]#awk '{print}'

在打印一遍

dd

dd

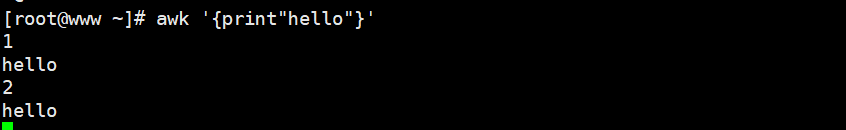

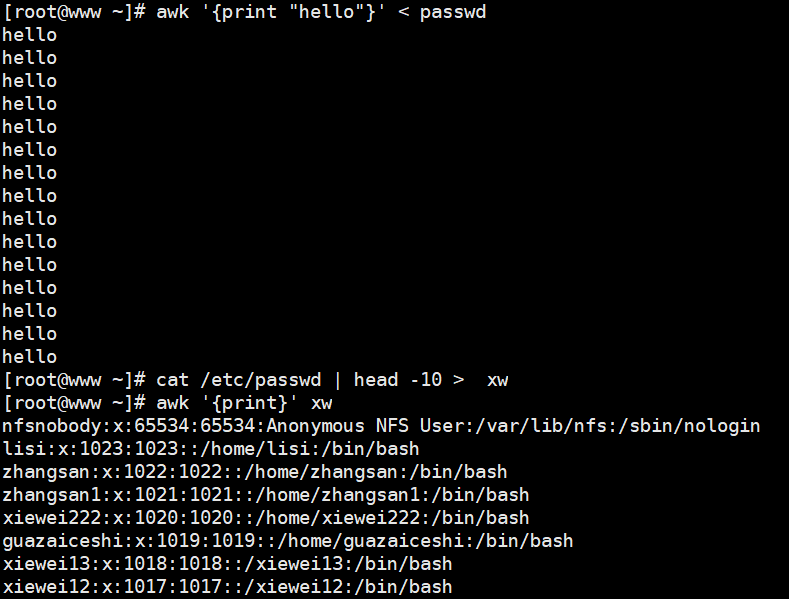

[root@localhost ~]#awk '{print "hello"}'

字符串需要添加双引号,单引号已被使用

1

hello

1

hello

[root@localhost ~]#awk '{print "hello"}' < /etc/passwd

[root@localhost ~]# cat /etc/passwd | head -10 > zz

[root@localhost ~]# awk '{print}' zz

[root@localhost ~]# awk '{print $1}' zz

root:x:0:0:root:/root:/bin/bash

awk默认把这一行当做一列,因为没有被空格分隔,awk默认以空格或tab键分隔

bin:x:1:1:bin:/bin:/sbin/nologin

5.2 内置变量

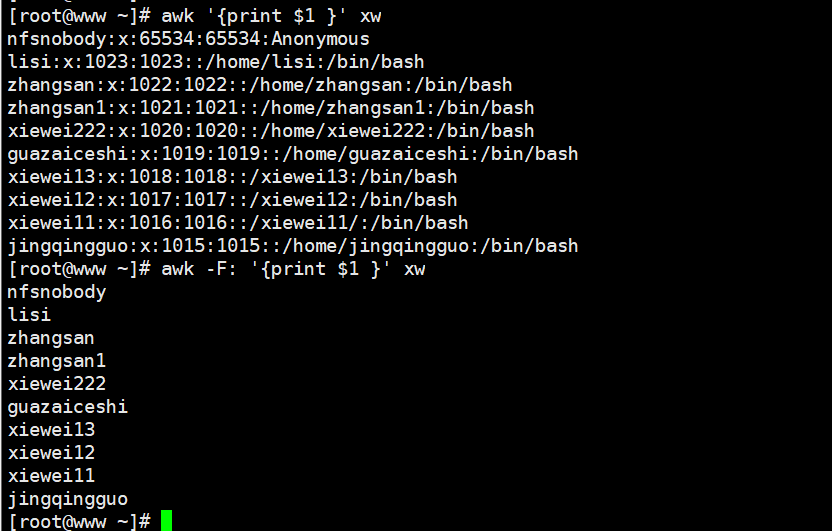

awk常用内置变量:$1、$2

、NF、NR、$0

- $1:代表第一列

- $2:代表第二列以此类推

- $0:代表整行

- NF:一行的列数

- NR:行数

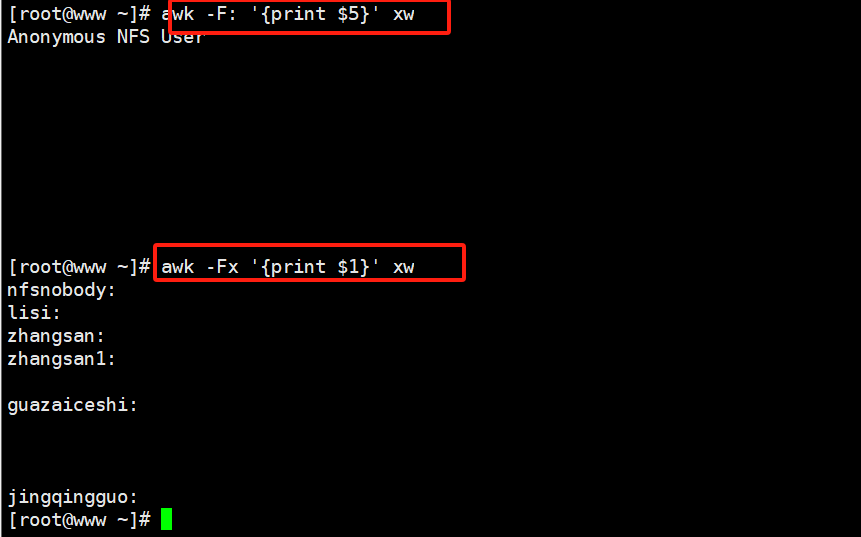

[root@localhost ~]# awk -F: '{print $5}' zz

自定义冒号为分隔符显示分隔之后的第五列

root

bin

[root@localhost ~]# awk -Fx '{print $1}' /etc/passwd

用x作为分隔符

root:

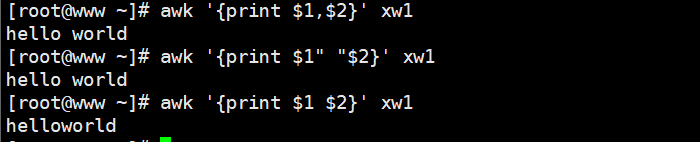

[root@localhost ~]# awk '{print $1 $2}' zz

helloworld

[root@localhost ~]# awk '{print $1""$2}' zz

显示一个空格,空格需要用双引号引起来,如果不用引号默认以变量看待,如果是常量就需要双引号引起来

hello world

[root@localhost ~]# awk '{print $1,$2}' zz

逗号有空格效果

hello world

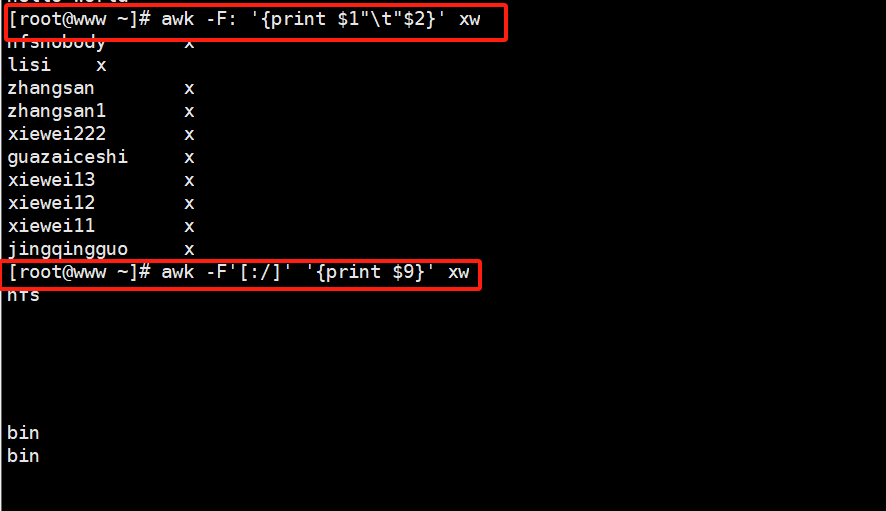

[root@localhost ~]# awk -F: '{print $1"\t"$2}' /etc/passwd

用制表符作为分隔符输出

[root@localhost ~]# awk -F[:/] '{print $9}' zz

定义多个分隔符,只要看到其中一个都算作分隔符

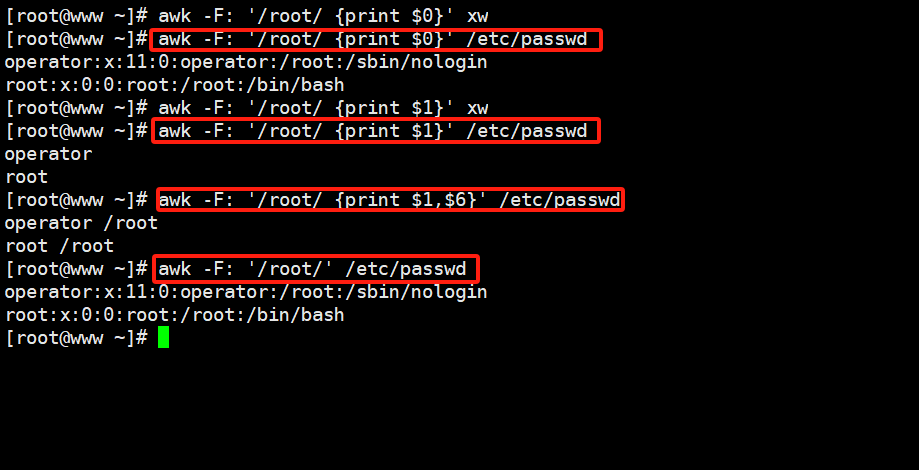

[root@localhost ~]# awk -F: '/root/{print $0}' pass.txt

打印包含root的整行内容

[root@localhost ~]# awk -F: '/root/{print $1}' pass.txt

打印包含root的行的第一列

root

[root@localhost ~]# awk -F: '/root/{print $1,$6}' pass.txt

打印包含root的行的第一列和第六列

root /root

[root@localhost ~]# awk '/root/' /etc/passwd

root:x:0:0:root:/root:/bin/bash

operator:x:11:0:operator:/root:/sbin/nologin

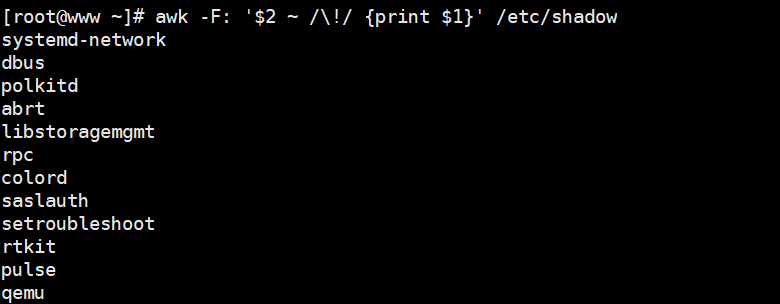

输出shadow文件中以冒号分隔的第二列有感叹号的行的第一列

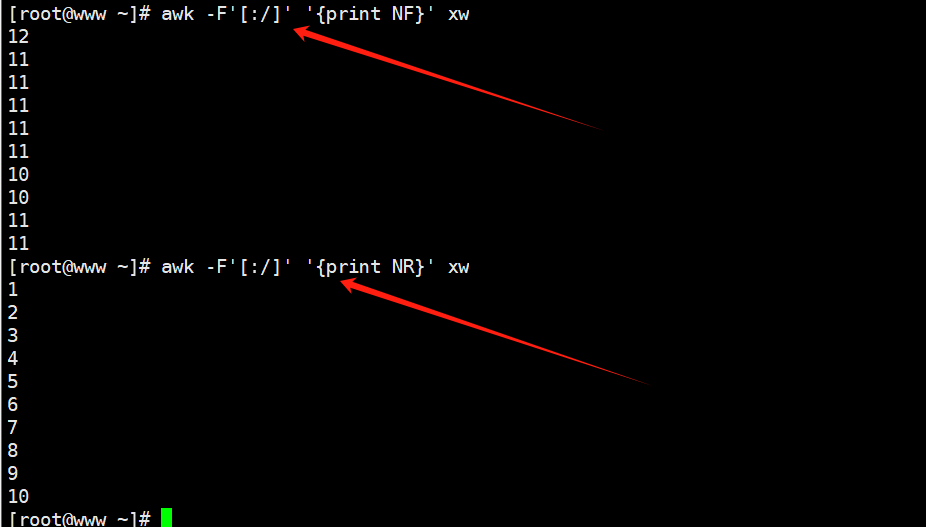

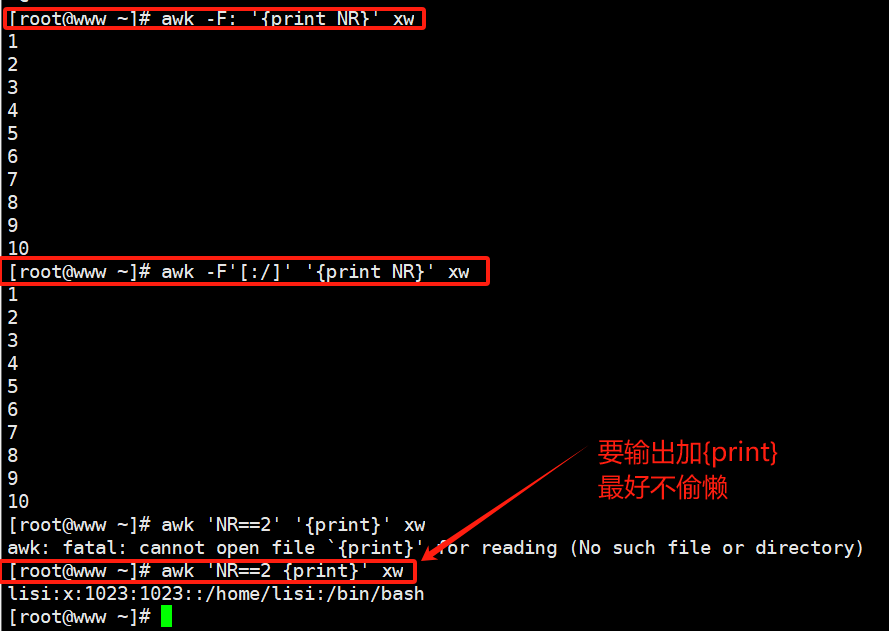

[root@localhost ~]# awk -F[:/] '{print NF}' zz

打印每一行的列数

[root@localhost ~]# awk -F[:/] '{print NR}' zz

显示行号

[root@localhost ~]# awk -F: '{print NR}' pass.txt

[root@localhost ~]# awk -F: '{print NR,$0}' pass.txt

[root@localhost ~]# awk 'NR==2' /etc/passwd

打印第二行,不加print也一样,默认就是打印

[root@localhost ~]# awk 'NR==2{print}' /etc/passwd

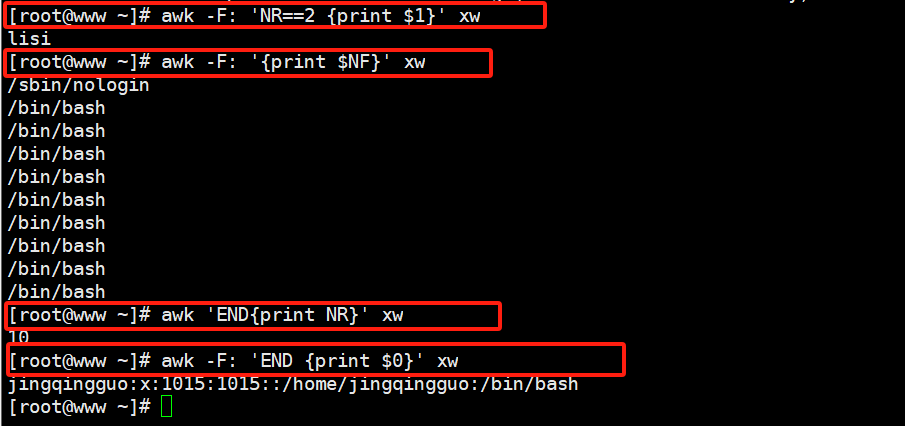

[root@localhost ~]# awk -F: 'NR==2{print $1}' /etc/passwd

[root@localhost ~]# awk -F: '{print $NF}' /etc/passwd

打印最后一列

[root@localhost ~]# awk 'END{print NR}' /etc/passwd

打印总行数

[root@localhost ~]# awk 'END{print $0}' /etc/passwd

打印文件最后一行

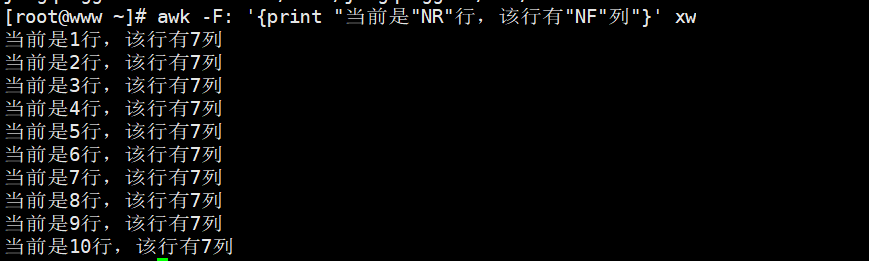

[root@localhost ~]# awk -F: '{print "当前行有"NF"列"}' zz

[root@localhost ~]# awk -F: '{print "第"NR"行有"NF"列"}' /etc/passwd

第几行有几列

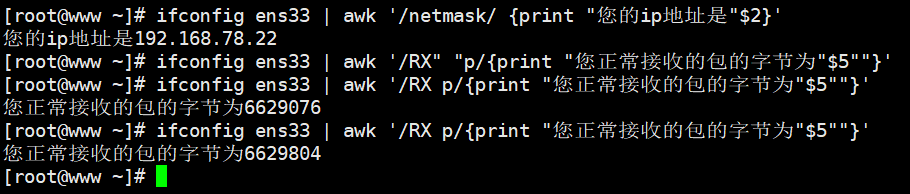

扩展生产案例:网卡的ip、流量

5.3 BEGIN END 运算

逐行执行开始之前执行什么任务,结束之后再执行什么任务,用BEGIN、END。BEGIN一般用来做初始化操作,仅在读取数据记录之前执行一次。END一般用来做汇总操作,仅在读取完数据记录之后执行一次。

5.3.1 扩展生产:网卡的ip、流量

[root@localhost ~]# ifconfig ens33 | awk '/netmask/{print "本机的ip地址是"$2}'

$本机的ip地址是192.168.245.211

[root@localhost ~]# ifconfig ens33 | awk '/RX p/{print $5"字节"}'

8341053字节

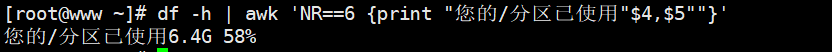

5.3.2 根分区的可用量

[root@localhost ~]# df -h | awk 'NR==2{print $4}'

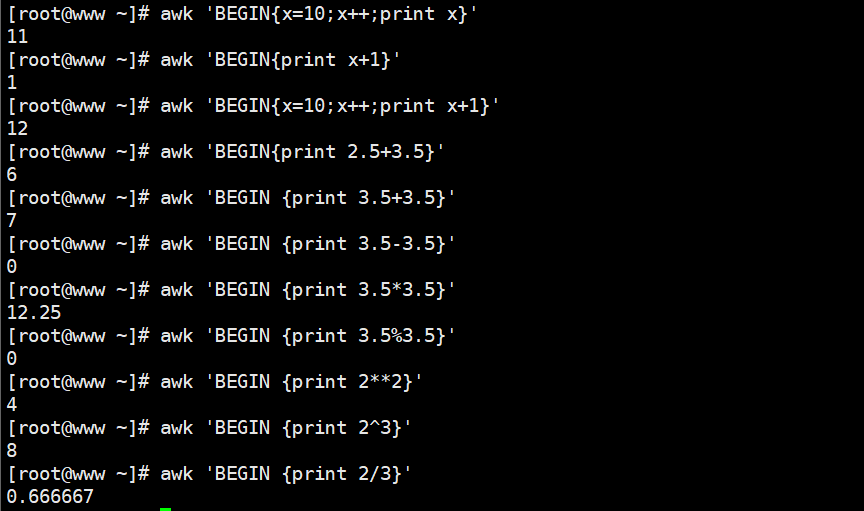

5.3.3 awk的运算:

[root@localhost ~]# awk 'BEGIN{x=10;print x}'

如果不用引号awk就当作一个变量来输出了,所以不需要加$了。

[root@localhost ~]# awk 'BEGIN{x=10;print x+1}'

BEGIN在处理文件之前,所以后面不跟文件名也不影响

[root@localhost ~]# awk 'BEGIN{x=10;x++;print x}'

[root@localhost ~]# awk 'BEGIN{print x+1}'

不指定初始值,初始值就为0,如果是字符串,则默认为空

[root@localhost ~]# awk 'BEGIN{print 2.5+3.5}'

小数也可以运算

[root@localhost ~]# awk 'BEGIN{print 2-1}'

[root@localhost ~]# awk 'BEGIN{print 3*4}'

[root@localhost ~]# awk 'BEGIN{print 32}'

[root@localhost ~]# awk 'BEGIN{print 2^3}'

[root@localhost ~]# awk 'BEGIN{print 1/2}'

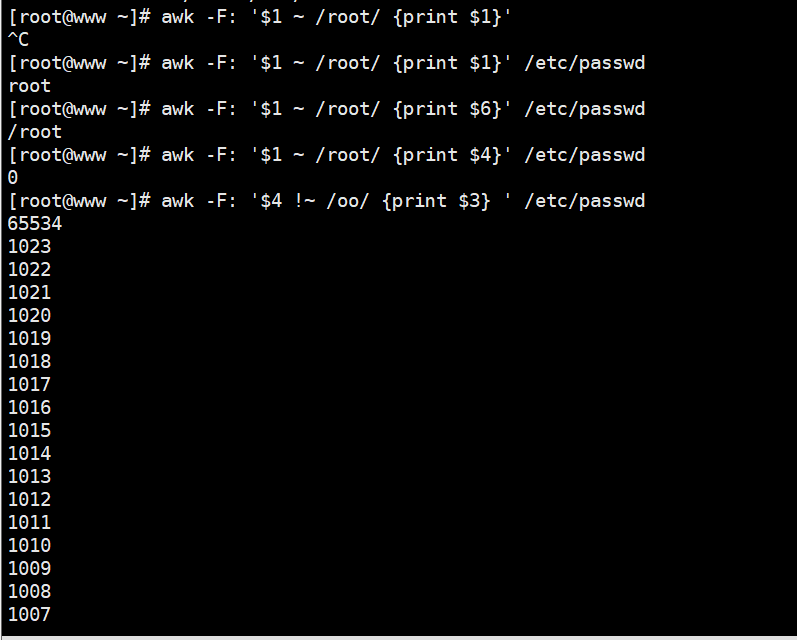

[root@localhost ]# awk -F: '/root/' /etc/passwd

如果后面有具体打印多少列就没法省略print了

模糊匹配,用表示包含,!~表示不包含

[root@localhost ]# awk -F: '$1~/root/' /etc/passwd

[root@localhost ]# awk -F: '$1~/ro/' /etc/passwd

模糊匹配,只要有ro就匹配上

[root@localhost ]# awk -F: '$7!~/nologin$/{print $1,$7}' /etc/pass

wd

关于数值与字符串的比较

比较符号:== != <= >= < >

5.3.4案例

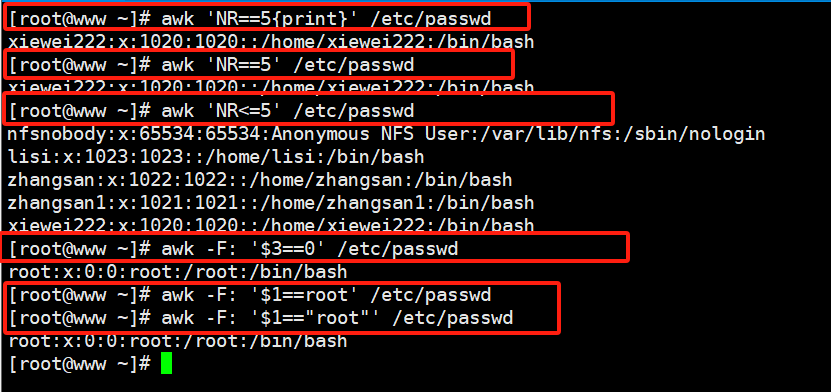

[root@localhost ~]# awk 'NR==5{print}' /etc/passwd

[root@localhost ~]# awk 'NR==5' /etc/passwd

[root@localhost ~]# awk 'NR<5' /etc/passwd

[root@localhost ~]# awk -F: '$3==0' /etc/passwd

[root@localhost ~]# awk -F: '$1==root' /etc/passwd

[root@localhost ~]# awk -F: '$1=="root"' /etc/passwd

精确匹配一定是root

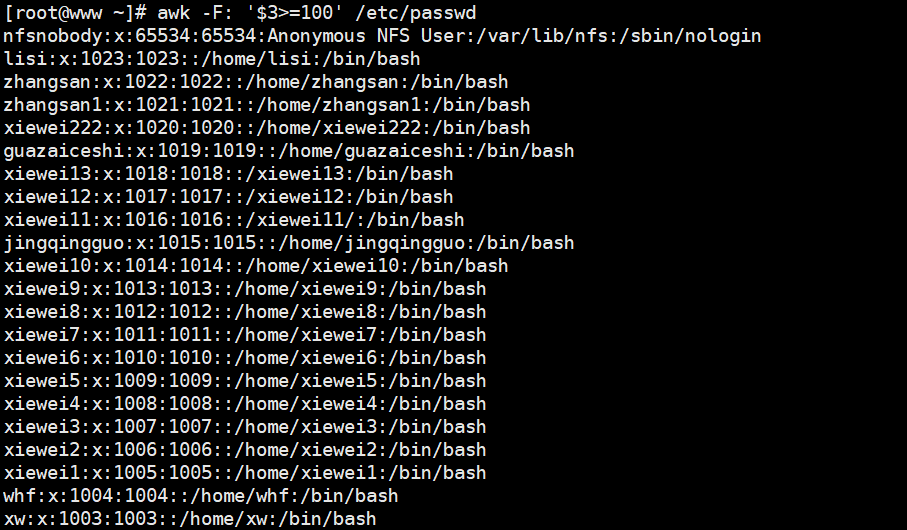

[root@localhost ~]# awk -F: '$3>=1000' /etc/passwd

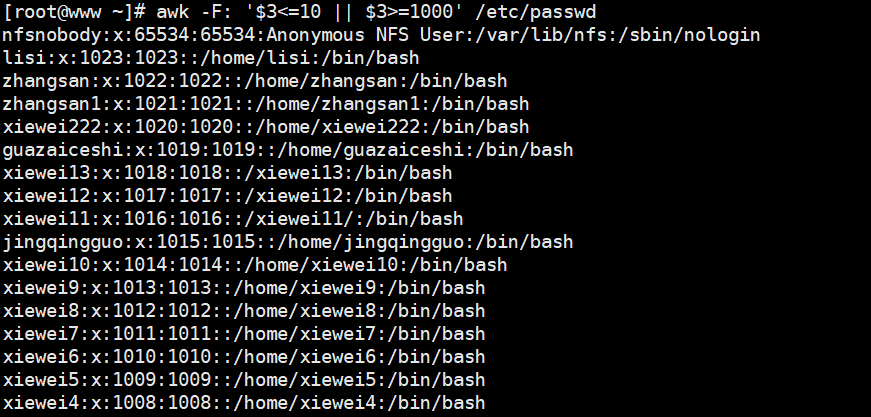

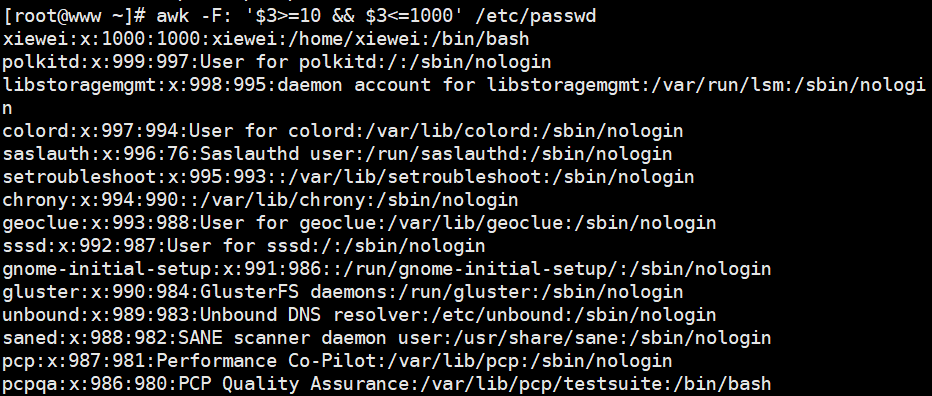

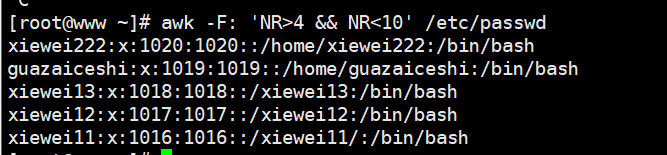

逻辑运算 && ||

&& 和 || 是逻辑运算符,用于组合多个条件并控制程序流程。

&& 要求所有条件都为真时才为真,否则为假。

|| 只要有一个条件为真就为真,全为假时才为假。

[root@localhost ~]# awk -F: '$3<10 || $3>=1000' /etc/passwd

[root@localhost ~]# awk -F: '$3>10 && $3<1000' /etc/passwd

[root@localhost ~]# awk -F: 'NR>4 && NR<10' /etc/passwd

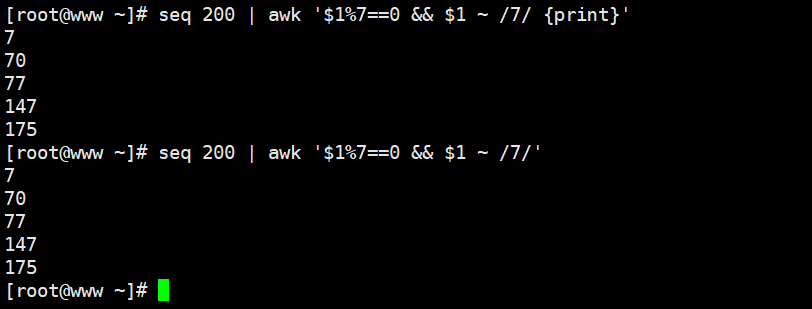

5.3.5 案例

打印1-200之间所有能被7整除并且包含数字7的整数数字

[root@localhost ]# seq 200 | awk '$1%7==0 && $1~/7/'

其他内置变量的用法FS(输入)、OFS、NR、FNR、RS、ORS

- FS:输入字段的分隔符 默认是空格

- OFS:输出字段的分隔符 默认也是空格

- FNR:读取文件的记录数(行号),从1开始,新的文件重新重1开始计数

- RS:输入行分隔符 默认为换行符

- ORS:输出行分隔符 默认也是为换行符

5.3.6 FS

[root@localhost ~]# awk 'BEGIN{FS=":"}{print $1}' pass.txt

在打印之前定义字段分隔符为冒号

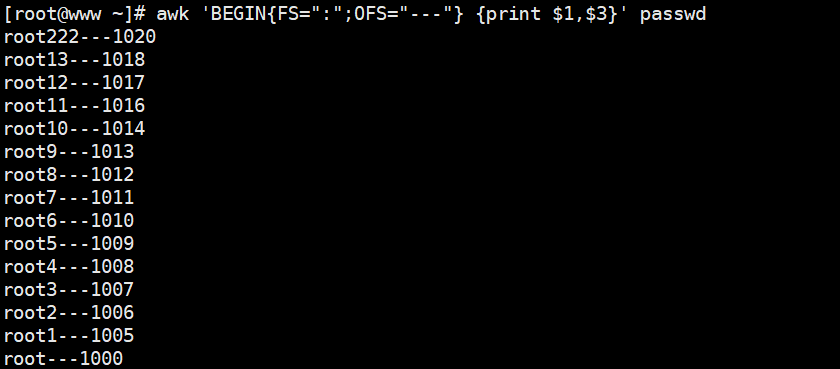

5.3.7 OFS

[root@localhost ~]# awk 'BEGIN{FS=":";OFS="---"}{print $1,$2}' pass.txt

OFS定义了输出时以什么分隔,$1$2中间要用逗号分隔,因为逗号默认被映射为OFS变量,而这个变量默认是空格

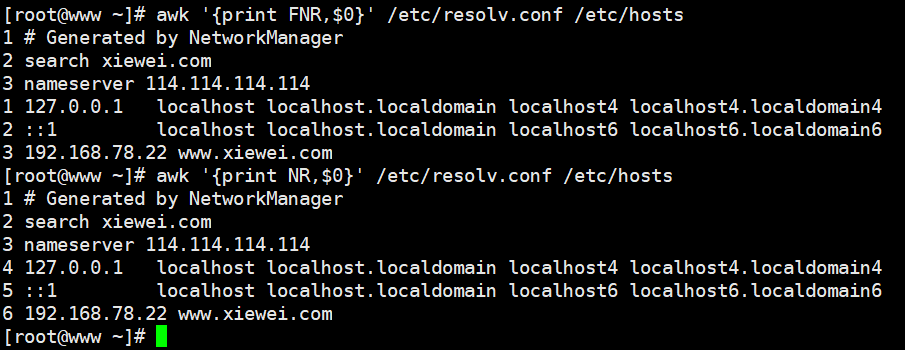

5.3.8 FNR

[root@localhost ~]# awk '{print FNR,$0}' /etc/resolv.conf /etc/hosts

可以看出FNR的行号在追加当有多个文件时

5.3.9 NR

[root@localhost ~]# awk '{print NR,$0}' /etc/resolv.conf /etc/hosts

5.3.10 RS

[root@localhost ~]# awk 'BEGIN{RS=":"}{print $0}' /etc/passwd

RS:指定以什么为换行符,这里指定是冒号,你指定的肯定是原文里存在的字符

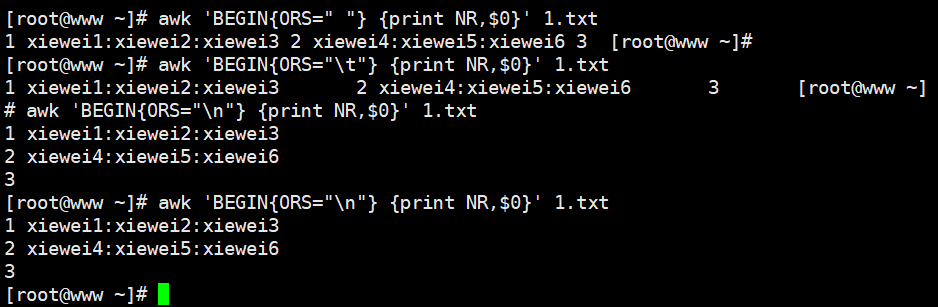

5.3.11 ORS

[root@localhost ~]# awk 'BEGIN{ORS=" "}{print $0}' /etc/passwd

把多行合并成一行输出,输出的时候自定义以空格分隔每行,本来默认的是回车键

5.4 引用变量

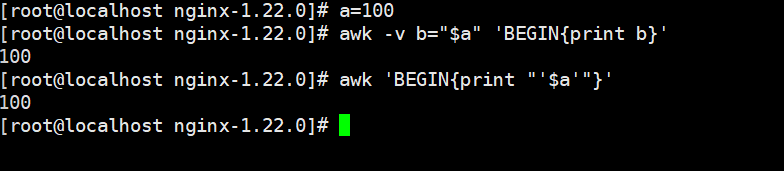

[root@localhost ~]# a=100

[root@localhost ~]# awk -v b="$a" 'BEGIN{print b}'

将系统的变量a,在awk里赋值为变量b,然后调用变量b -v 选项将其传递给 awk

[root@localhost ~]# awk 'BEGIN{print "'$a'"}'

直接调用的话需要先用双引号再用单引号

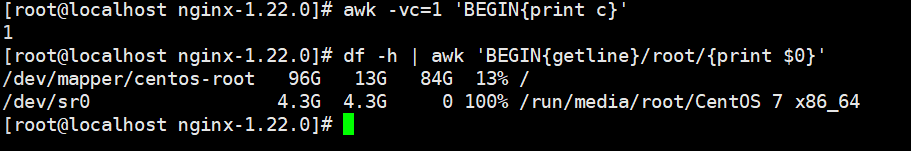

[root@localhost ~]# awk -vc=1 'BEGIN{print c}'

awk直接定义变量并引用

[root@localhost ~]# df -h | awk 'BEGIN{getline}/root/{print $0}'

调用函数getline,读取一行数据的时候并不是得到当前行而是当前行的下一行

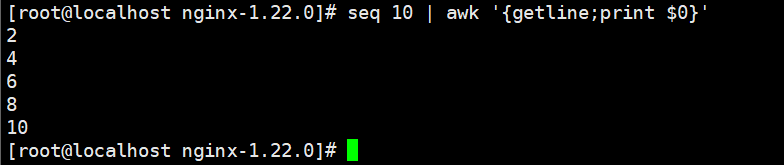

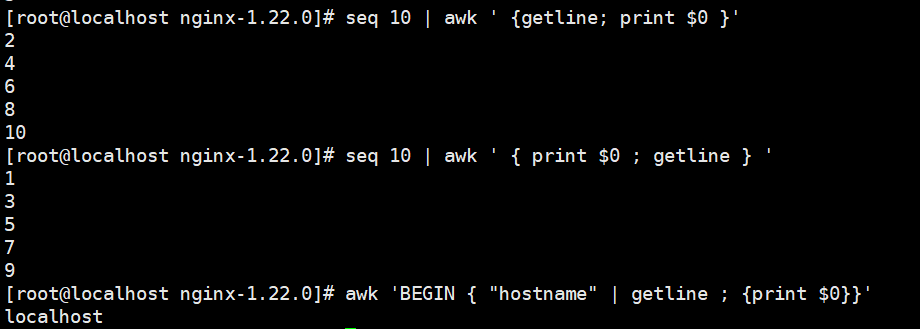

[root@localhost ~]# seq 10 | awk '{getline;print $0}'

显示偶数行

2

4

6

8

10

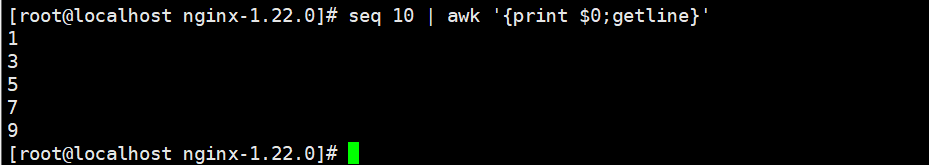

[root@localhost ~]# seq 10 | awk '{print $0;getline}'

显示奇数行

1

3

5

7

9

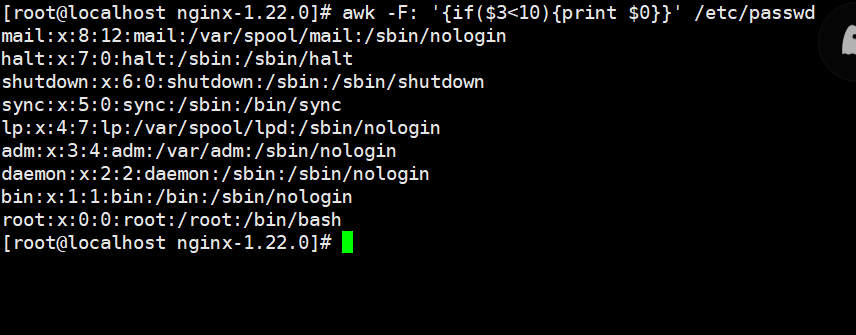

[root@localhost ~]# awk -F: '{if($3<10){print $0}}' /etc/passwd

第三列小于10的打印整行

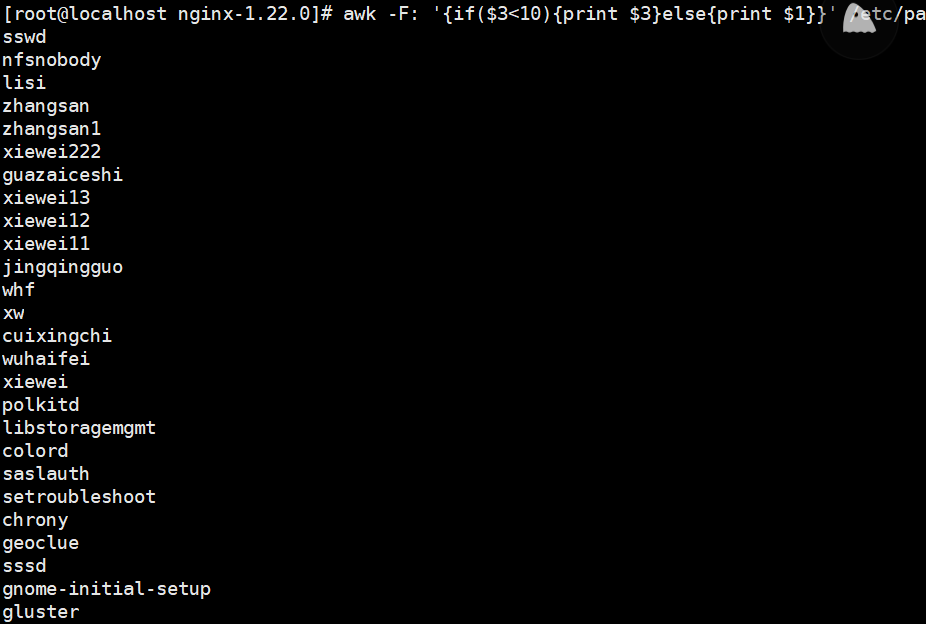

[root@localhost ~]# awk -F: '{if($3<10){print $3}else{print $1}}' /etc/passwd

第三列小于10的打印第三列,否则打印第一列

第二步:从文件或标准输入(stdin)读取一行。然后运行pattern{ commands }语句块,它逐行扫描文件,从第一行到最后一行反复这个过程。直到文件所有被读取完成。

第三步:当读至输入流末尾时,运行END{ commands }语句块。BEGIN语句块在awk开始从输入流中读取行之前被运行,这是一个可选的语句块,比方变量初始化、打印输出表格的表头等语句通常能够写在BEGIN语句块中。END语句块在awk从输入流中读取全然部的行之后即被运行。比方打印全部行的分析结果这类信息汇总都是在END语句块中完毕,它也是一个可选语句块。pattern语句块中的通用命令是最重要的部分,它也是可选的。假设没有提供pattern语句块,则默认运行{ print },即打印每个读取到的行。awk读取的每一行都会运行该语句块。这三个部分缺少任何一部分都可以。

5.4.1案例

[root@localhost ~]#awk 'BEGIN{x=0};//bin/bash$/ {x++;print x,$0};END {print x}' /etc/passwd

统计以/ bin/bash结尾的行数,等同于

[root@localhost ~]#grep -c "/bin/bash$" /etc/passwd

BEGIN模式表示,在处理指定的文本之前,需要先执行BEGIN模式中指定的动作; awk再处理指定的文本,之后再执行END模式中指定的动作,END{}语句块中,往往会放入打印结果等语句

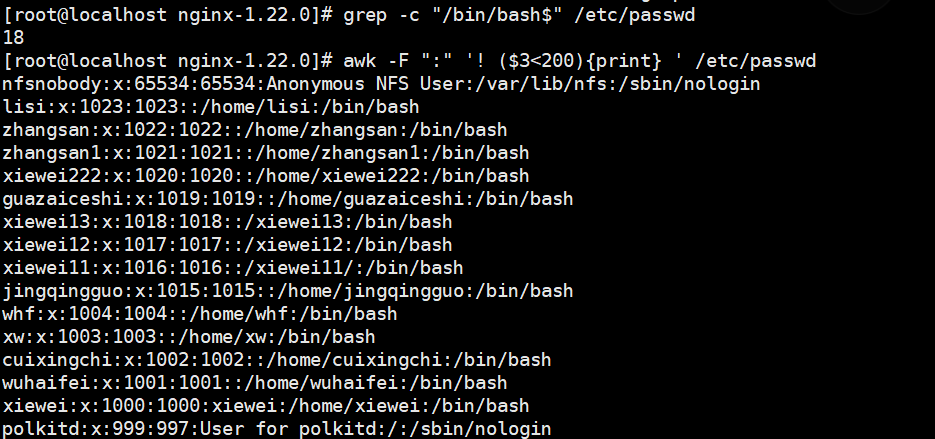

[root@localhost ~]#awk -F ":" '! ($3<200){print} ' /etc/passwd

输出第3个字段的值,不小于200的行

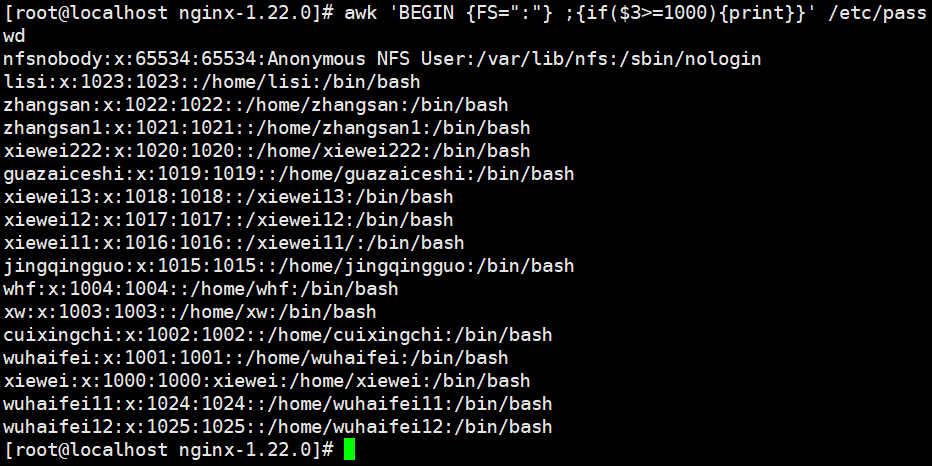

[root@localhost ~]#awk 'BEGIN {FS=":"} ;{if($3>=1000){print}}' /etc/passwd

先处理完BEGIN的内容,再打印文本里面的内容

[root@localhost ~]#awk -F ":" ' {max=($3>=$4) ?$3:$4; {print max}} ' /etc/passwd

(了解)($3>$4)?$3:$4三元运算符,如果第3个字段的值大于等于第4个字段的值,则把第3个字段的值赋给max,否则第4个字段的值赋给max

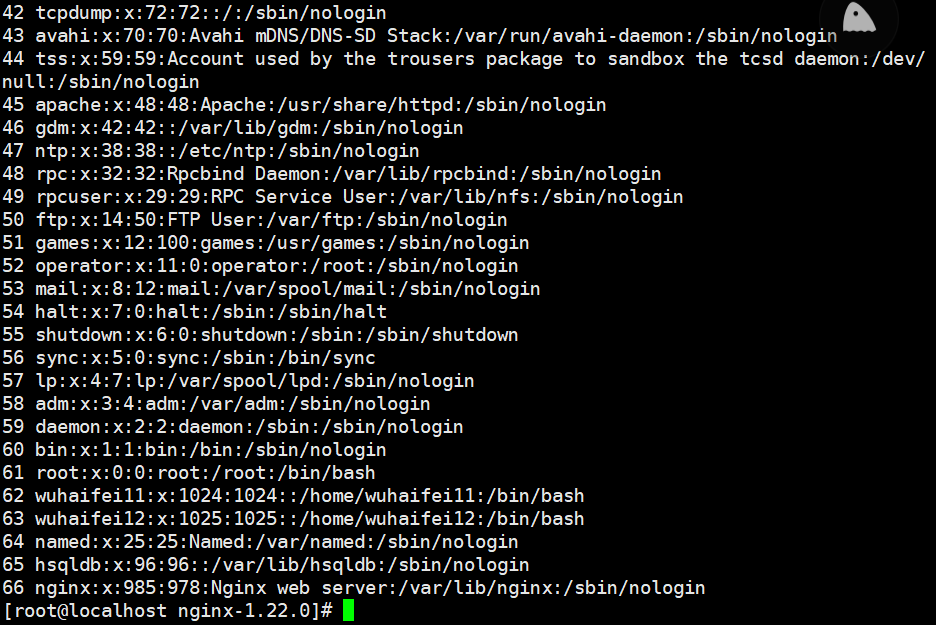

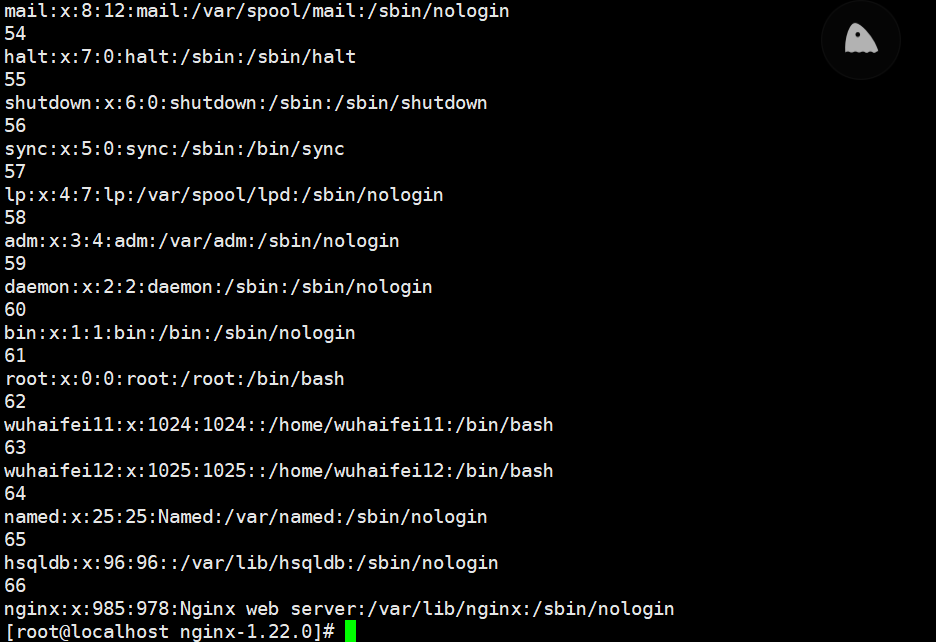

[root@localhost ~]#awk -F ":" '{print NR,$0}' /etc/passwd

输出每行内容和行号,每处理完一条记录,NR值加1

[root@localhost ~]#sed -n '=;p' /etc/passwd

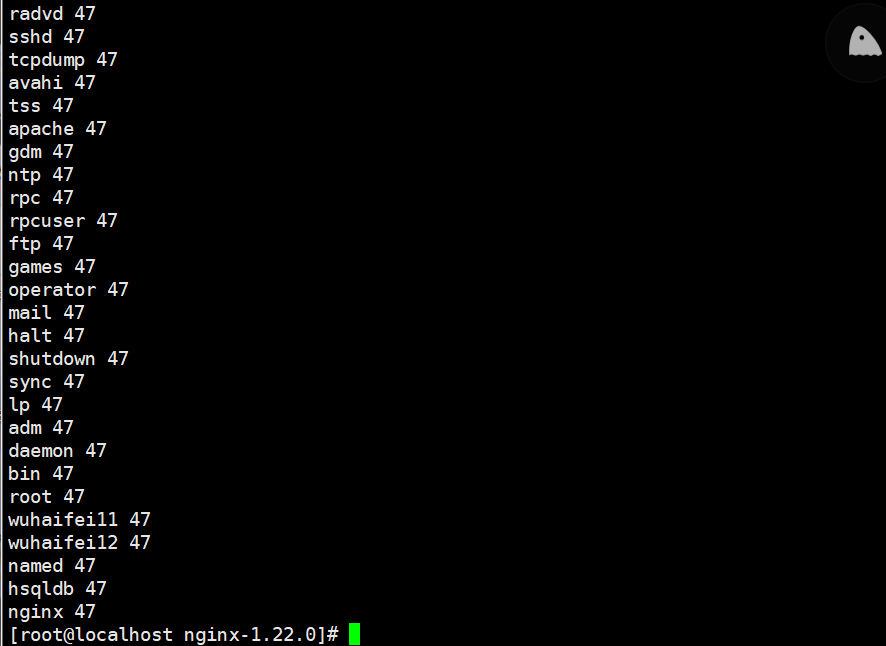

[root@localhost ]#awk -F ":" '$7"bash"{print $1,47}' /etc/passwd

输出以冒号分隔且第7个字段中包含/bash的行的第1个字段

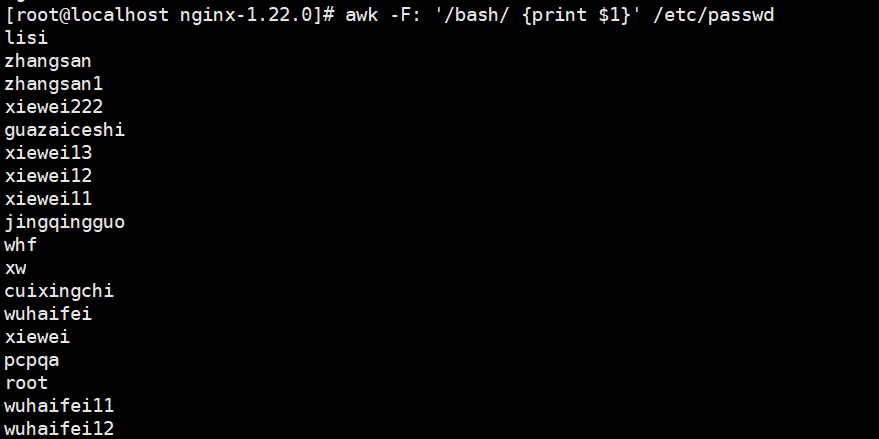

[root@localhost ~]#awk -F: '/bash/ {print $1}' /etc/passwd

[root@localhost ]#awk -F":"'($1"root") && (NF==7) {print $1,$2,$NF } '

/etc/passwd第1个字段中包含root且有7个字段的行的第1、2个字段

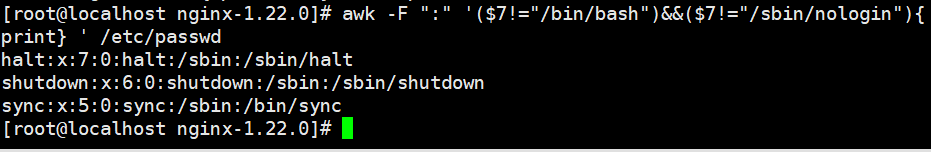

[root@localhost ~]#awk -F ":" '($7!="/bin/bash")&&($7!="/sbin/nologin"){print} ' /etc/passwd

输出第7个字段既不为/bin/bash,也不为/sbin/nologin的所有行

[root@localhost ~]#awk -F: '($NF !=" /bin/bash")&&($NF !=" /sbin/nologin" ){print NR, $0}' passwd

通过管道、双引号调用shell 命令:

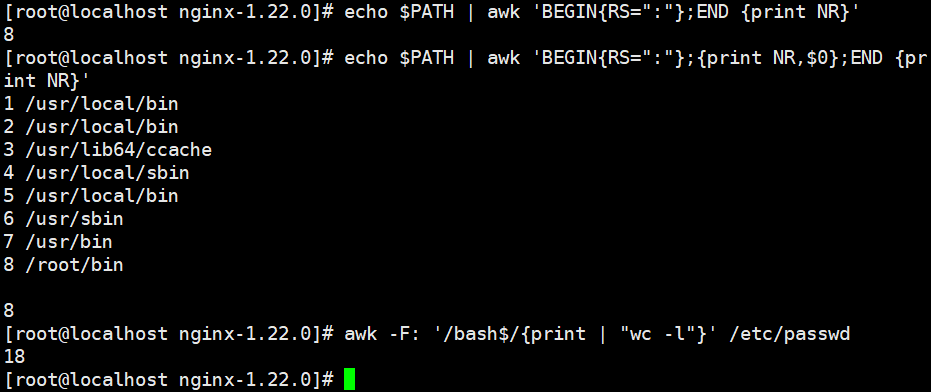

[root@localhost ~]#echo $PATH | awk 'BEGIN{RS=":"};END {print NR}'

统计以冒号分隔的文本段落数,END{ }语句块中,往往会放入打印结果等语句

[root@localhost ~]#echo $PATH | awk 'BEGIN{RS=":"};{print NR,$0};END {print NR}'

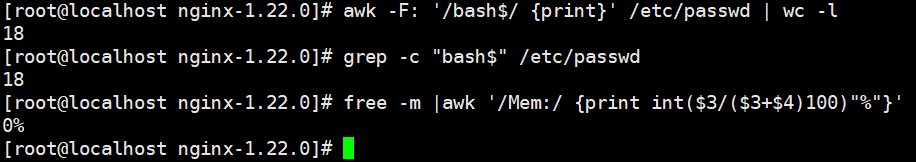

[root@localhost ~]#awk -F: '/bash$/{print | "wc -l"}' /etc/passwd

调用wc -l命令统计使用bash 的用户个数,等同于

[root@localhost ~]#grep -c "bash$" /etc/passwd

[root@localhost ~]#awk -F: '/bash$/ {print}' /etc/passwd | wc -l

[root@localhost ~]#free -m |awk '/Mem:/ {print int($3/($3+$4)100)"%"}'

查看当前内存使用百分比

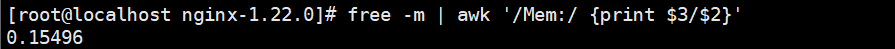

[ root@localhost ~]# free -m | awk '/Mem:/ {print $3/$2}'

0.327869

[root@localhost ~]# free -m | awk '/Mem:/ {print $3/$2100}'

32.7869

[ root@localhost ~]# free -m | awk '/Mem:/ {print int($3/$2100)}'

32

[root@localhost ~]# free -m | awk '/Mem:/ {print int($3/$2100)"%"}'

32%

[root@localhost ~]#free -m | awk '/Mem:/ {print $3/$2*100}' | awk -F. '{print $1"%"}'

top -b -n 1 | grep Cpu | awk -F ',' '{print $4}'| awk '{print $1}'

查看当前CPU空闲率,(-b -n 1表示只需要1次的输出结果)

dao 100%

date -d "$(awk -F "." '{print $1}'/proc/uptime) second ago"+"%F%H:%M:%S"

了解显示上次系统重启时间,等同于uptime; second ago为显示多少秒前的时间,+$” 选日:3N:3S等同于+"3Y-n-%d 3日:8N:8S"的时间格式

date -d "$(awk -F "." '{iprint $1}'/proc/uptime) second ago"+"号F%H:%M:%S"

了解显示上次系统重启时间,等同于uptime; second ago为显示多少秒前的时间,+“F悉日:M::S"等同于+”%1-tm-d 日: 38:8S"的时间格式

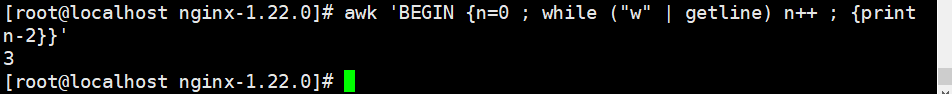

awk 'BEGIN {n=0 ; while ("w" | getline) n++ ; {print n-2}}'

调用w命令,并用来统计在线用户数

5.4.2注:先做如下实验

seq 10 | awk ' {getline; print $0 }'

seq 10 | awk ' { print $0 ; getline } '

awk 'BEGIN { "hostname" | getline ; {print $0}}'

调用hostname,并输出当前的主机名

当getline左右无重定向符"<“或"I"时,awk首先读取到了第一行,就是1,然后getline,就得到了1下面的第二行,就是2,因为getline之后,awk会改变对应的NE,NR,FNR和 O 等内部变量,所以此时的 O等内部变量,所以此时的 O等内部变量,所以此时的O的值就不再是1,而是2了,然后将它打印出来。当getline左右有重定向符”<"或"I"时,getline则作用于定向输入文件,由于该文件是刚打开,并没有被awk读入一行,只是getline读入,那么getline返回的是该文件的第一行,而不是隔行。

5.5CPU使用率(算不)

cpu_us=top -b -n 1 | grep Cpu | awk '{print $2}'

cpu_sy=top -b -n 1 | grep Cpu | awk -F ',' '{print $2}' | awk '{print $1}'

cpu_sum=$(($cpu_us+$cpu_sy))

echo $cpu_sum

vmstat

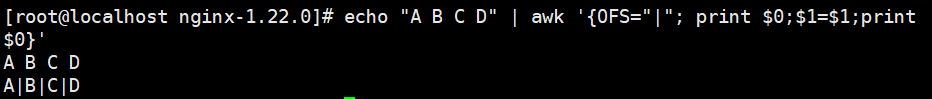

echo "A B C D" | awk '{OFS="|"; print $0;$1=$1;print $0}'

A B C D

A|B|C|D

$1=$1是用来激活$0的重新赋值,也就是说字段$1…和字段数NF的改变会促使awk重新计算$0的值,通常是在改变OFS后而需要输出$0时这样做

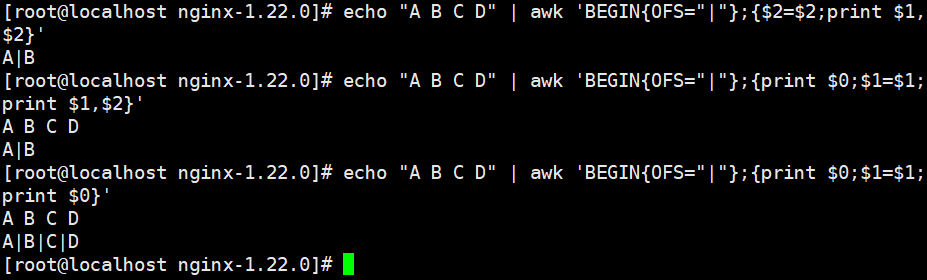

echo "A B C D" | awk 'BEGIN{OFS="|"};{print $0;$1=$1;print $0}'

echo "A B C D" | awk 'BEGIN{OFS="|"};{print $0;$1=$1;print $1,$2}'

echo "A B C D" | awk 'BEGIN{OFS="|"};{$2=$2;print $1,$2}'

六、最后总结

grep 和 egrep 文本过滤 (更适合单纯的查找或匹配文本)

sed 流编辑器 实现编辑的(更适合编辑匹配到的文本)

e左右有重定向符"<"或"I"时,getline则作用于定向输入文件,由于该文件是刚打开,并没有被awk读入一行,只是getline读入,那么getline返回的是该文件的第一行,而不是隔行。

5.5CPU使用率(算不)

cpu_us=top -b -n 1 | grep Cpu | awk '{print $2}'

cpu_sy=top -b -n 1 | grep Cpu | awk -F ',' '{print $2}' | awk '{print $1}'

cpu_sum=$(($cpu_us+$cpu_sy))

echo $cpu_sum

vmstat

echo "A B C D" | awk '{OFS="|"; print $0;$1=$1;print $0}'

A B C D

A|B|C|D

$1=$1是用来激活$0的重新赋值,也就是说字段$1…和字段数NF的改变会促使awk重新计算$0的值,通常是在改变OFS后而需要输出$0时这样做

echo "A B C D" | awk 'BEGIN{OFS="|"};{print $0;$1=$1;print $0}'

echo "A B C D" | awk 'BEGIN{OFS="|"};{print $0;$1=$1;print $1,$2}'

echo "A B C D" | awk 'BEGIN{OFS="|"};{$2=$2;print $1,$2}'

六、最后总结

grep 和 egrep 文本过滤 (更适合单纯的查找或匹配文本)

sed 流编辑器 实现编辑的(更适合编辑匹配到的文本)

awk 文本报告生成器 实现格式化文本输出(更适合格式化文本,对文本进行较复杂格式处理)

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?