Hadoop的优势有四高:

(1) 高可用: Hadoop底层维护多个数据副本,所以即使Hadoop某个计算元 素或存储出现故障,也不会导致数据的丢失

(2) 高扩展: 在集群间分配任务数据,可方便的扩展数以千计的节点

(3) 高效性: 在MapReduce的思想下,Hadoop是并行工作的,以加快任务处 理速度

(4) 高容错性: 能够自动将失败的任务重新分配。

Hadoop组成:

HDFS 架构概述:

Hadoop Distributed File System,简称 HDFS,是一个分布式文件系统。

(1)NameNode(nn):存储文件的元数据,如文件名,文件目录结构,文件属性(生成时间、副本数、 文件权限),以及每个文件的块列表和块所在的DataNode等

2)DataNode(dn):在本地文件系统存储文件块数据,以及块数据的校验和

3)Secondary NameNode(2nn):每隔一段时间对NameNode元数据备份

YARN 架构概述:

Yet Another Resource Negotiator 简称 YARN ,另一种资源协调者,是 Hadoop 的资源管理器。

MapReduce 架构概述 MapReduce 将计算过程分为两个阶段:Map 和 Reduce

1)Map 阶段并行处理输入数据

2)Reduce 阶段对 Map 结果进行汇总

HDFS、YARN、MapReduce 三者关系:

大数据技术生态体系:

1)Sqoop:Sqoop 是一款开源的工具,主要用于在 Hadoop、Hive 与传统的数据库(MySQL) 间进行数据的传递,可以将一个关系型数据库(例如 :MySQL,Oracle 等)中的数据导进 到 Hadoop 的 HDFS 中,也可以将 HDFS 的数据导进到关系型数据库中。

2)Flume:Flume 是一个高可用的,高可靠的,分布式的海量日志采集、聚合和传输的系统, Flume 支持在日志系统中定制各类数据发送方,用于收集数据;

3)Kafka:Kafka 是一种高吞吐量的分布式发布订阅消息系统;

4)Spark:Spark 是当前最流行的开源大数据内存计算框架。可以基于 Hadoop 上存储的大数 据进行计算。

5)Flink:Flink 是当前最流行的开源大数据内存计算框架。用于实时计算的场景较多。

6)Oozie:Oozie 是一个管理 Hadoop 作业(job)的工作流程调度管理系统。

7)Hbase:HBase 是一个分布式的、面向列的开源数据库。HBase 不同于一般的关系数据库, 它是一个适合于非结构化数据存储的数据库。

8)Hive:Hive 是基于 Hadoop 的一个数据仓库工具,可以将结构化的数据文件映射为一张 数据库表,并提供简单的 SQL 查询功能,可以将 SQL 语句转换为 MapReduce 任务进行运 行。其优点是学习成本低,可以通过类 SQL 语句快速实现简单的 MapReduce 统计,不必开 发专门的 MapReduce 应用,十分适合数据仓库的统计分析。

9)ZooKeeper:它是一个针对大型分布式系统的可靠协调系统,提供的功能包括:配置维护、 名字服务、分布式同步、组服务等

Hadoop 运行环境搭建

(1) 安装模板虚拟机,IP 地址 192.168.10.100、主机名称 hadoop100、内存 4G、硬盘 100G

(2) 安装epel-release

(3) 关闭防火墙

(4)创建yhd用户

(5)配置yhd用户拥有root权限,后面sudo执行方便

(6) 创建module和software文件夹用来存放软件包和解压后的程序

(7)修改/opt目录下的属组和属主

(8)卸载虚拟机自带的jdk

rpm -qa | grep -i java | xargs -n1 rpm -e --nodeps

虚拟机克隆 :hadoop102 hadoop103 hadoop104

以hadoop100为模板进行克隆,下面以hadoop102为例进行配置修改如下

(1) 修改IP地址(nmtui 或者vim /etc/sysconfig/network-scripts/ifcfg-ens32)

(2)修改主机名(hostnamectl set-hostname hadoop102)

(3) 修改主机名映射 /etc/hosts

127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4

::1 localhost localhost.localdomain localhost6 localhost6.localdomain6

192.168.10.100 hadoop100

192.168.10.101 hadoop101

192.168.10.102 hadoop102

192.168.10.103 hadoop103

192.168.10.104 hadoop104

192.168.10.105 hadoop105

192.168.10.106 hadoop106

192.168.10.107 hadoop107

192.168.10.108 hadoop108

(4)修改windows的hosts文件,将映射主机信息添加到hosts文科中

192.168.10.100 hadoop100

192.168.10.101 hadoop101

192.168.10.102 hadoop102

192.168.10.103 hadoop103

192.168.10.104 hadoop104

192.168.10.105 hadoop105

192.168.10.106 hadoop106

192.168.10.107 hadoop107

192.168.10.108 hadoop108

(5)hadoop102s上传解压安装jdk和hadoop

[yhd@hadoop102 software]$ ll

total 520600

-rw-r--r--. 1 yhd yhd 338075860 Feb 24 09:00 hadoop-3.1.3.tar.gz

-rw-r--r--. 1 yhd yhd 195013152 Feb 24 09:09 jdk-8u212-linux-x64.tar.gz

[yhd@hadoop102 software]$ ll ../module/

total 0

drwxr-xr-x. 13 yhd yhd 204 Mar 20 19:56 hadoop-3.1.3

drwxr-xr-x. 7 yhd yhd 245 Apr 2 2019 jdk1.8.0_212(6) 配置环境变量并source使其生效

[yhd@hadoop102 ~]$ vim /etc/profile.d/my_env.sh

#JAVA_HOME

export JAVA_HOME=/opt/module/jdk1.8.0_212

export PATH=$PATH:$JAVA_HOME/bin

#HADOOP_HOME

export HADOOP_HOME=/opt/module/hadoop-3.1.3

export PATH=$PATH:$HADOOP_HOME/bin

export PATH=$PATH:$HADOOP_HOME/sbin

[yhd@hadoop102 ~]$ source /etc/profile.d/my_env.sh (7)测试是否生效

(8)查看hadoop的目录结构

[yhd@hadoop102 hadoop-3.1.3]$ ll

total 180

drwxr-xr-x. 2 yhd yhd 183 Sep 12 2019 bin

drwxrwxr-x. 4 yhd yhd 37 Mar 20 19:57 data

drwxr-xr-x. 3 yhd yhd 20 Sep 12 2019 etc

drwxr-xr-x. 2 yhd yhd 106 Sep 12 2019 include

drwxr-xr-x. 3 yhd yhd 20 Sep 12 2019 lib

drwxr-xr-x. 4 yhd yhd 288 Sep 12 2019 libexec

-rw-rw-r--. 1 yhd yhd 147145 Sep 4 2019 LICENSE.txt

drwxrwxr-x. 3 yhd yhd 4096 Mar 20 19:57 logs

-rw-rw-r--. 1 yhd yhd 21867 Sep 4 2019 NOTICE.txt

-rw-rw-r--. 1 yhd yhd 1366 Sep 4 2019 README.txt

drwxr-xr-x. 3 yhd yhd 4096 Sep 12 2019 sbin

drwxr-xr-x. 4 yhd yhd 31 Sep 12 2019 share重要目录

(1)bin 目录:存放对 Hadoop 相关服务(hdfs,yarn,mapred)进行操作的脚本

(2)etc 目录:Hadoop 的配置文件目录,存放 Hadoop 的配置文件

(3)lib 目录:存放 Hadoop 的本地库(对数据进行压缩解压缩功能)

(4)sbin 目录:存放启动或停止 Hadoop 相关服务的脚本

(5)share 目录:存放 Hadoop 的依赖 jar 包、文档、和官方案例

(9) 配置时钟同步(ntp)并设置开机自启

(10) SSH 无密登录配置

yhd和root两个用户都要进行分发公钥

(11) xsync 集群分发脚本

[yhd@hadoop102 ~]$ mkdir bin

[yhd@hadoop102 ~]$ cd bin

[yhd@hadoop102 bin]$ vim xsync

#!/bin/bash

#1. 判断参数个数

if [ $# -lt 1 ]

then

echo Not Enough Arguement!

exit;

fi

#2. 遍历集群所有机器

for host in hadoop102 hadoop103 hadoop104

do

echo ==================== $host ====================

#3. 遍历所有目录,挨个发送

for file in $@

do

#4. 判断文件是否存在

if [ -e $file ]

then

#5. 获取父目录

pdir=$(cd -P $(dirname $file); pwd)

#6. 获取当前文件的名称

fname=$(basename $file)

ssh $host "mkdir -p $pdir"

rsync -av $pdir/$fname $host:$pdir

else

echo $file does not exists!

fi

done

done(12)赋权并执行

(13)将/opt/的软件包和解压文件以及配置信息拷贝分发到103和104上并验证

Hadoop 集群配置

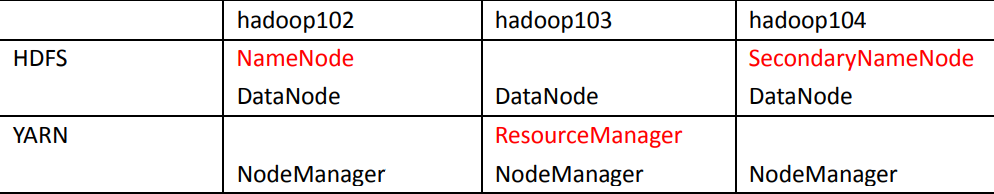

1. 集群部署规划

(1) NameNode 和 SecondaryNameNode 不要安装在同一台服务器

(2)ResourceManager 也很消耗内存,不要和 NameNode、SecondaryNameNode 配置在 同一台机器上

2. 配置文件说明

Hadoop 配置文件分两类:默认配置文件和自定义配置文件,只有用户想修改某一默认 配置值时,才需要修改自定义配置文件,更改相应属性值

默认配置文件:

自定义配置文件:

core-site.xml、hdfs-site.xml、yarn-site.xml、mapred-site.xml 四个配置文件存放在 $HADOOP_HOME/etc/hadoop 这个路径上,用户可以根据项目需求重新进行修改配置。

(1) 配置 core-site.xml

<configuration>

<!-- 指定 NameNode 的地址 -->

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop102:8020</value>

</property>

<!-- 指定 hadoop 数据的存储目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/module/hadoop-3.1.3/data</value>

</property>

</configuration>(2)配置hdfs-site.xml

<configuration>

<!-- nn web 端访问地址-->

<property>

<name>dfs.namenode.http-address</name>

<value>hadoop102:9870</value>

</property>

<!-- 2nn web 端访问地址-->

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>hadoop104:9868</value>

</property>

</configuration>

(3)配置yarn-site.xml

<configuration>

<!-- Site specific YARN configuration properties -->

<!-- 指定 MR 走 shuffle -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<!-- 指定 ResourceManager 的地址-->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>hadoop103</value>

</property>

<!-- 环境变量的继承 -->

<property>

<name>yarn.nodemanager.env-whitelist</name>

<value>JAVA_HOME,HADOOP_COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_MAPRED_HOME</value>

</property>

</configuration>(4) 配置 mapred-site.xml

<configuration>

<!-- 指定 MapReduce 程序运行在 Yarn 上 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>(5)配置works文件

[root@hadoop102 hadoop]# vim workers

hadoop102

hadoop103

hadoop104(6)在集群上分发配置好的 Hadoop 配置文件

[yhd@hadoop102 hadoop]$ xsync /opt/module/hadoop-3.1.3/etc

==================== hadoop102 ====================

sending incremental file list

sent 910 bytes received 19 bytes 1,858.00 bytes/sec

total size is 107,468 speedup is 115.68

==================== hadoop103 ====================

sending incremental file list

etc/

etc/hadoop/

etc/hadoop/workers

sent 993 bytes received 54 bytes 2,094.00 bytes/sec

total size is 107,468 speedup is 102.64

==================== hadoop104 ====================

sending incremental file list

etc/

etc/hadoop/

etc/hadoop/workers

sent 993 bytes received 54 bytes 698.00 bytes/sec

total size is 107,468 speedup is 102.64

[yhd@hadoop102 hadoop]$(7)验证查看

(8) 启动集群

1. 如果集群是第一次启动,需要在 hadoop102 节点格式化 NameNode(注意:格式 化 NameNode,会产生新的集群 id,导致 NameNode 和 DataNode 的集群 id 不一致,集群找 不到已往数据.如果集群在运行过程中报错,需要重新格式化 NameNode 的话,一定要先停 止 namenode 和 datanode 进程,并且要删除所有机器的 data 和 logs 目录,然后再进行格式 化)

[yhd@hadoop102 hadoop-3.1.3]$ hdfs namenode -format

WARNING: /opt/module/hadoop-3.1.3/logs does not exist. Creating.

2021-03-20 19:56:01,526 INFO namenode.NameNode: STARTUP_MSG:

/************************************************************

STARTUP_MSG: Starting NameNode

STARTUP_MSG: host = hadoop102/192.168.10.102

STARTUP_MSG: args = [-format]

STARTUP_MSG: version = 3.1.3

STARTUP_MSG: classpath = /opt/module/hadoop-3.1.3/etc/hadoop:/opt/module/hadoop-3.1.3/share/hadoop/common/lib/accessors-smart-1.2.jar:/opt/module/hadoop-3.1.3/share/hadoop/common/lib/animal-sniffer-annotations-1.17.j

2.启动hdfs

[yhd@hadoop102 hadoop-3.1.3]$ sbin/start-dfs.sh

Starting namenodes on [hadoop102]

Starting datanodes

hadoop103: WARNING: /opt/module/hadoop-3.1.3/logs does not exist. Creating.

hadoop104: WARNING: /opt/module/hadoop-3.1.3/logs does not exist. Creating.

Starting secondary namenodes [hadoop104]

[yhd@hadoop102 hadoop-3.1.3]$ jps

12433 DataNode

12660 Jps

12266 NameNode3.启动yarn(在hadoop103)

[yhd@hadoop103 hadoop]$ sbin/start-yarn.sh

[yhd@hadoop103 hadoop]$ jps

11762 Jps

9801 DataNode

9993 ResourceManager

10126 NodeManager

4. web查看 HDFS 的 NameNode

5. Web 端查看 YARN 的 ResourceManager

(9) 集群测试

上传文件到集群

[yhd@hadoop102 ~]$ hadoop fs -put $HADOOP_HOME/wcinput/word.txt /input

2021-03-20 19:58:39,234 INFO sasl.SaslDataTransferClient: SASL encryption trust check: localHostTrusted = false, remoteHostTrusted = false

[yhd@hadoop102 ~]$hadoop fs -put /opt/software/jdk-8u212-linux-x64.tar.gz /

2021-03-20 19:59:22,656 INFO sasl.SaslDataTransferClient: SASL encryption trust check: localHostTrusted = false, remoteHostTrusted = false

2021-03-20 19:59:24,974 INFO sasl.SaslDataTransferClient: SASL encryption trust check: localHostTrusted = false, remoteHostTrusted = false

6. 上传文件后查看文件存放在什么位置

[yhd@hadoop102 subdir0]$ pwd

/opt/module/hadoop-3.1.3/data/dfs/data/current/BP-510334103-192.168.10.102-1616241362316/current/finalized/subdir0/subdir0

[yhd@hadoop102 subdir0]$ ll

total 192208

-rw-rw-r--. 1 yhd yhd 46 Mar 20 19:58 blk_1073741825

-rw-rw-r--. 1 yhd yhd 11 Mar 20 19:58 blk_1073741825_1001.meta

-rw-rw-r--. 1 yhd yhd 134217728 Mar 20 19:59 blk_1073741826

-rw-rw-r--. 1 yhd yhd 1048583 Mar 20 19:59 blk_1073741826_1002.meta

-rw-rw-r--. 1 yhd yhd 60795424 Mar 20 19:59 blk_1073741827

-rw-rw-r--. 1 yhd yhd 474975 Mar 20 19:59 blk_1073741827_1003.meta

-rw-rw-r--. 1 yhd yhd 38 Mar 20 20:04 blk_1073741834

-rw-rw-r--. 1 yhd yhd 11 Mar 20 20:04 blk_1073741834_1010.meta

-rw-rw-r--. 1 yhd yhd 439 Mar 20 20:04 blk_1073741835

-rw-rw-r--. 1 yhd yhd 11 Mar 20 20:04 blk_1073741835_1011.meta

-rw-rw-r--. 1 yhd yhd 25306 Mar 20 20:04 blk_1073741836

-rw-rw-r--. 1 yhd yhd 207 Mar 20 20:04 blk_1073741836_1012.meta

-rw-rw-r--. 1 yhd yhd 214462 Mar 20 20:04 blk_1073741837

-rw-rw-r--. 1 yhd yhd 1683 Mar 20 20:04 blk_1073741837_1013.meta

[yhd@hadoop102 subdir0]$ 7.查看 HDFS 在磁盘存储文件内容

[yhd@hadoop102 subdir0]$ cat blk_1073741825

hadoop yarn

hadoop mapreduce

atguigu

atguigu8. 执行wordcount程序

[yhd@hadoop102 hadoop-3.1.3]$ hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-3.1.3.jar wordcount /input /output

2021-03-20 20:03:51,652 INFO client.RMProxy: Connecting to ResourceManager at hadoop103/192.168.10.103:8032

2021-03-20 20:03:52,181 INFO mapreduce.JobResourceUploader: Disabling Erasure Coding for path: /tmp/hadoop-yarn/staging/yhd/.staging/job_1616241436786_0001

2021-03-20 20:03:52,272 INFO sasl.SaslDataTransferClient: SASL encryption trust check: localHostTrusted = false, remoteHostTrusted = false

2021-03-20 20:03:52,407 INFO input.FileInputFormat: Total input files to process : 1

2021-03-20 20:03:52,435 INFO sasl.SaslDataTransferClient: SASL encryption trust check: localHostTrusted = false, remoteHostTrusted = false9.查看计算服务运行情况

10.查看hdfs是不是有数据

11.配置历史服务器(上述历史服务器配没有配置,所以history点击跳转失败)

编辑 [yhd@hadoop102 hadoop]$ vim mapred-site.xml

<configuration>

<!-- 指定 MapReduce 程序运行在 Yarn 上 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<!-- 历史服务器端地址 -->

<property>

<name>mapreduce.jobhistory.address</name>

<value>hadoop102:10020</value>

</property>

<!-- 历史服务器 web 端地址 -->

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>hadoop102:19888</value>

</property>

</configuration>分发配置

[yhd@hadoop102 hadoop]$ xsync /opt/module/hadoop-3.1.3/etc/hadoop/mapred-site.xml

==================== hadoop102 ====================

sending incremental file list

sent 64 bytes received 12 bytes 152.00 bytes/sec

total size is 1,170 speedup is 15.39

==================== hadoop103 ====================

sending incremental file list

mapred-site.xml

sent 585 bytes received 47 bytes 1,264.00 bytes/sec

total size is 1,170 speedup is 1.85

==================== hadoop104 ====================

sending incremental file list

mapred-site.xml

sent 585 bytes received 47 bytes 1,264.00 bytes/sec

total size is 1,170 speedup is 1.85

[yhd@hadoop102 hadoop]$ 在 hadoop102 启动历史服务器

[yhd@hadoop102 hadoop-3.1.3]$ bin/mapred --daemon start historyserver

[yhd@hadoop102 hadoop-3.1.3]$ jps

12433 DataNode

15666 JobHistoryServer

12266 NameNode

12733 NodeManager

15725 Jps新建任务

[yhd@hadoop102 hadoop-3.1.3]$ hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-3.1.3.jar wordcount /input /output1

2021-03-20 22:33:14,973 INFO client.RMProxy: Connecting to ResourceManager at hadoop103/192.168.10.103:8032

2021-03-20 22:33:16,139 INFO mapreduce.JobResourceUploader: Disabling Erasure Coding for path: /tmp/hadoop-yarn/staging/yhd/.staging/job_1616241436786_0002

2021-03-20 22:33:16,274 INFO sasl.SaslDataTransferClient: SASL encryption trust check: localHostTrusted = false, remoteHostTrusted = false

2021-03-20 22:33:17,351 INFO input.FileInputFormat: Total input files to process : 1

2021-03-20 22:33:17,405 INFO sasl.SaslDataTransferClient: SASL encryption trust check: localHostTrusted = false, remoteHostTrusted = false

2021-03-20 22:33:17,586 INFO sasl.SaslDataTransferClient: SASL encryption trust check: localHostTrusted = false, remoteHostTrusted = false

2021-03-20 22:33:17,664 INFO mapreduce.JobSubmitter: number of splits:1查看hdfs页面

再次测试历史服务器是否好用

点击logs提示如下,需要配置日志的聚集功能

配置日志聚集功能

日志聚集概念:应用运行完成以后,将程序运行日志信息上传到 HDFS 系统上

日志聚集功能好处:可以方便的查看到程序运行详情,方便开发调试

开启日志聚集功能,需要重新启动 NodeManager 、ResourceManager 和 HistoryServer

配置 [yhd@hadoop102 hadoop]$ vim yarn-site.xml

<!-- 开启日志聚集功能 -->

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<!-- 设置日志聚集服务器地址 -->

<property>

<name>yarn.log.server.url</name>

<value>http://hadoop102:19888/jobhistory/logs</value>

</property>

<!-- 设置日志保留时间为 7 天 -->

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>604800</value>

</property>分发到另外两台服务器上

[yhd@hadoop102 hadoop]$ xsync yarn-site.xml

==================== hadoop102 ====================

sending incremental file list

sent 62 bytes received 12 bytes 148.00 bytes/sec

total size is 1,621 speedup is 21.91

==================== hadoop103 ====================

sending incremental file list

yarn-site.xml

sent 1,034 bytes received 47 bytes 720.67 bytes/sec

total size is 1,621 speedup is 1.50

==================== hadoop104 ====================

sending incremental file list

yarn-site.xml

sent 1,034 bytes received 47 bytes 720.67 bytes/sec

total size is 1,621 speedup is 1.50在102上关闭历史服务器进程

[yhd@hadoop102 hadoop-3.1.3]$ mapred --daemon stop historyserver

[yhd@hadoop102 hadoop-3.1.3]$ jps

12433 DataNode

16617 Jps

12266 NameNode

12733 NodeManager‘在103上关闭yarn进程

[yhd@hadoop103 hadoop-3.1.3]$ jps

12531 Jps

9801 DataNode

9993 ResourceManager

10126 NodeManager

[yhd@hadoop103 hadoop-3.1.3]$ sbin/stop-yarn.sh

Stopping nodemanagers

hadoop102: WARNING: nodemanager did not stop gracefully after 5 seconds: Trying to kill with kill -9

hadoop104: WARNING: nodemanager did not stop gracefully after 5 seconds: Trying to kill with kill -9

Stopping resourcemanager在103上启动yarn

[yhd@hadoop103 hadoop-3.1.3]$ sbin/start-yarn.sh

Starting resourcemanager

Starting nodemanagers

[yhd@hadoop103 hadoop-3.1.3]$ jps

12913 ResourceManager

13046 NodeManager

9801 DataNode

13391 Jps在102上启动历史服务器

[yhd@hadoop102 hadoop-3.1.3]$ mapred --daemon start historyserver

[yhd@hadoop102 hadoop-3.1.3]$ jps

12433 DataNode

17029 Jps

16969 JobHistoryServer

12266 NameNode

16797 NodeManager再执行一个新任务查看验证如下:

[yhd@hadoop102 hadoop-3.1.3]$ hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-3.1.3.jar wordcount /input /output2

2021-03-20 22:55:55,213 INFO client.RMProxy: Connecting to ResourceManager at hadoop103/192.168.10.103:8032

2021-03-20 22:55:55,683 INFO mapreduce.JobResourceUploader: Disabling Erasure Coding for path: /tmp/hadoop-yarn/staging/yhd/.staging/job_1616251848467_0001

2021-03-20 22:55:55,764 INFO sasl.SaslDataTransferClient: SASL encryption trust check: localHostTrusted = false, remoteHostTrusted = false

首先看dnfs上是否成功

再看任务调度运行情况

点击logs进程查看

3669

3669

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?