一、全连接层的网络结构

所谓全连接神经网络,就是由全连接层组成的网络。简单的全连接层网络一般分为三层,分别是输入层,隐含层,输出层。当然在输出层后面还可以添加分类层,或者损失函数等特殊处理层。

对于全连接神经网络来说,网络中每一层的每一个结点都与相邻网络层的每一个结点相连,用来把前边提取到的特征综合起来。由于其全相连的特性,一般全连接层的参数也是最多的。据说能占到整个网络的80%。

抛开CNN,RNN,图像处理等具体的应用场景不说,单纯从网络结构上来讲,假设A层,B层为神经网络中相邻的两个全连接层,数据由A层传向B层。则B层中每个神经元节点的输入,来自于A层中所有神经元节点与其对应的权重边相乘后累加的结果。

参考链接:https://baike.baidu.com/item/%E5%85%A8%E8%BF%9E%E6%8E%A5%E5%B1%82/22689531?fr=aladdin

补充:

神经网络结构多种多样,名称也是多种多样

ANN 人工神经网络

SVM 支持向量机

线性二分类

非线性 对于非线性分类,使用核函数,讲二维映射到高维,用曲面来对数据分类

https://blog.csdn.net/u012151283/article/details/77567528

MLP 多层感知机

全连接 前向神经网络 可使用激活函数

https://blog.csdn.net/xierhacker/article/details/53282038

BP 反向神经网络

二、全连接层的计算原理

下面我们用图示来理解全连接层的计算方法:

上图中给出了a1节点和y节点的计算过程,从图中可以看出:

1. a1节点的输入值是由x1和x2与对应的权重边W1,1和W2,1相乘后相加得出的结果。

2. y节点的输入是由a1,a2,a3与对应的权重边W1,W2,W3相乘后累加得出的结果。

线性全连接层也是最基础的网络结构,没有复杂的变换,也没有激活函数,

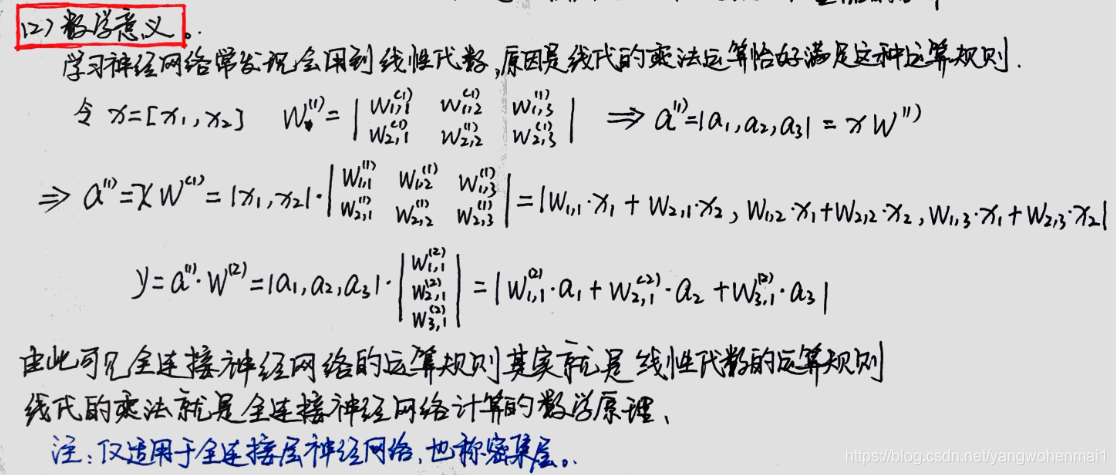

这种计算规则从示意图上很容易看出来,我们更希望用数学表达式的方式来描述这种计算规则。在学习神经网络过程中常会提到线性代数,矩阵这些概念,究其原因是因为矩阵乘法运算规则恰好满足全连接层的计算要求。矩阵乘法描述如下:

通过上面的笔记内容可以看出,全连接层之间的计算过程,其实就是网络层与连接两层之间的权重矩阵做向量乘法。这就是在处理神经网络时常常会用到矩阵运算的原因。

三、附学习笔记

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?