一、MapReduce读取和输出数据:InputFormat

### --- InputFormat

~~~ 运行MapReduce程序时,输入的文件格式包括:基于行的日志文件、二进制格式文件、

~~~ 数据库表等。那么,针对不同的数据类型,MapReduce是如何读取这些数据的呢?### --- InputFormat是MapReduce框架用来读取数据的类。

### --- InputFormat常见子类包括:

~~~ TextInputFormat (普通文本文件,MR框架默认的读取实现类型)

~~~ KeyValueTextInputFormat(读取一行文本数据按照指定分隔符,把数据封装为kv类型)

~~~ NLineInputF ormat(读取数据按照行数进行划分分片)

~~~ CombineTextInputFormat(合并小文件,避免启动过多MapTask任务)

~~~ 自定义InputFormat

二、CombineTextInputFormat案例

### --- CombineTextInputFormat案例

~~~ MR框架默认的TextInputFormat切片机制按文件划分切片,文件无论多小,

~~~ 都是单独一个切片,然后由一个MapTask处理,如果有大量小文件,

~~~ 就对应的会生成并启动大量的 MapTask,而每个MapTask处理的数据

~~~ 量很小大量时间浪费在初始化资源启动收回等阶段,这种方式导致资源利用率不高。

~~~ CombineTextInputFormat用于小文件过多的场景,它可以将多个小文件从逻辑上划分成一个切片,

~~~ 这样多个小文件就可以交给一个MapTask处理,提高资源利用率。### --- 需求

~~~ 将输入数据中的多个小文件合并为一个切片处理

~~~ 运行WordCount案例,准备多个小文件### --- 具体使用方式

// 如果不设置InputFormat,它默认用的是TextInputFormat.class

job.setInputFormatClass(CombineTextInputFormat.class);

//虚拟存储切片最大值设置4m

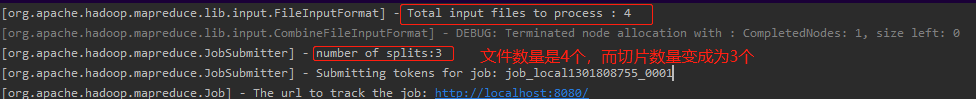

CombineTextInputFormat.setMaxInputSplitSize(job, 4194304);### --- 验证切片数量的变化!!

~~~ CombineTextInputFormat切片原理

~~~ 切片生成过程分为两部分:虚拟存储过程和切片过程

~~~ 假设设置setMaxInputSplitSize值为4M

~~~ # 四个小文件:1.txt -->2M ;2.txt-->7M;3.txt-->0.3M;4.txt--->8.2M

~~~ 虚拟存储过程:把输入目录下所有文件大小,依次和设置的setMaxInputSplitSize值进行比较,如果不大于设置的最大值,逻辑上划分一个块。如果输入文件大于设置的最大值且大于两倍,那么以最大值切割一块;当剩余数据大小超过设置的最大值且不大于最大值2倍,此时将文件均分成2个虚拟存储块(防止出现太小切片)。比如如setMaxInputSplitSize值为4M,输入文件大小为8.02M,则先逻辑上分出一个4M的块。剩余的大小为4.02M,如果按照4M逻辑划分,就会出现0.02M的非常小的虚拟存储文件,所以将剩余的4.02M文件切分成(2.01M和2.01M)两个文件。

~~~ txt-->2M;2M<4M;一个块;

~~~ txt-->7M;7M>4M,但是不大于两倍,均匀分成两块;两块:每块3.5M;

~~~ txt-->0.3M;0.3<4M ,0.3M<4M ,一个块

~~~ txt-->8.2M;大于最大值且大于两倍;一个4M的块,剩余4.2M分成两块,每块2.1M~~~ # 所有块信息:

~~~ 2M,3.5M,3.5M,0.3M,4M,2.1M,2.1M 共7个虚拟存储块。

~~~ # 切片过程

~~~ 判断虚拟存储的文件大小是否大于setMaxInputSplitSize值,大于等于则单独形成一个切片。

~~~ 如果不大于则跟下一个虚拟存储文件进行合并,共同形成一个切片。

~~~ 按照之前输入文件:有4个小文件大小分别为2M、7M、0.3M以及8.2M这四个小文件,则虚拟存储之后形成7个文件块,大小分别为:2M,3.5M,3.5M,0.3M,4M,2.1M,2.1M

~~~ 最终会形成3个切片,大小分别为:(2+3.5)M,(3.5+0.3+4)M,(2.1+2.1)M

~~~ # 注意:虚拟存储切片最大值设置最好根据实际的小文件大小情况来设置具体的值。

三、编程代码

### --- 创建项目:CombineTextInputFormat

### --- workcountmapper

package com.yanqi.mr.CombineTextInputFormat;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.LongWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Mapper;

import java.io.IOException;

//需求:单词计数

//1 继承Mapper类

//2 Mapper类的泛型参数:共4个,2对kv

//2.1 第一对kv:map输入参数类型

//2.2 第二队kv:map输出参数类型

// LongWritable, Text-->文本偏移量(后面不会用到),一行文本内容

//Text, IntWritable-->单词,1

public class WordCountMapper extends Mapper<LongWritable, Text, Text, IntWritable> {

//3 重写Mapper类的map方法

/*

1 接收到文本内容,转为String类型

2 按照空格进行切分

3 输出<单词,1>

*/

//提升为全局变量,避免每次执行map方法都执行此操作

final Text word = new Text();

final IntWritable one = new IntWritable(1);

// LongWritable, Text-->文本偏移量,一行文本内容,map方法的输入参数,一行文本就调用一次map方法

@Override

protected void map(LongWritable key, Text value, Context context) throws IOException, InterruptedException {

// 1 接收到文本内容,转为String类型

final String str = value.toString();

// 2 按照空格进行切分

final String[] words = str.split(" ");

// 3 输出<单词,1>

//遍历数据

for (String s : words) {

word.set(s);

context.write(word, one);

}

}

}### --- wordcountreducer

package com.yanqi.mr.CombineTextInputFormat;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Reducer;

import java.io.IOException;

//继承的Reducer类有四个泛型参数,2对kv

//第一对kv:类型要与Mapper输出类型一致:Text, IntWritable

//第二队kv:自己设计决定输出的结果数据是什么类型:Text, IntWritable

public class WordCountReducer extends Reducer<Text, IntWritable, Text, IntWritable> {

//1 重写reduce方法

//Text key:map方法输出的key,本案例中就是单词,

// Iterable<IntWritable> values:一组key相同的kv的value组成的集合

IntWritable total = new IntWritable();

@Override

protected void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException {

//2 遍历key对应的values,然后累加结果

int sum = 0;

for (IntWritable value : values) {

int i = value.get();

sum += 1;

}

// 3 直接输出当前key对应的sum值,结果就是单词出现的总次数

total.set(sum);

context.write(key, total);

/*

假设map方法:hello 1;hello 1;hello 1

reduce的key和value是什么?

key:hello,

values:<1,1,1>

假设map方法输出:hello 1;hello 1;hello 1,hadoop 1, mapreduce 1,hadoop 1

reduce的key和value是什么?

reduce方法何时调用:一组key相同的kv中的value组成集合然后调用一次reduce方法

第一次:key:hello ,values:<1,1,1>

第二次:key:hadoop ,values<1,1>

第三次:key:mapreduce ,values<1>

*/

}

}### --- workcountcountcombiner

package com.yanqi.mr.CombineTextInputFormat;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.NullWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Reducer;

import java.io.IOException;

//combiner组件的输入和输出类型与map()方法保持一致

public class WordCountCombiner extends Reducer<Text, IntWritable, NullWritable, IntWritable> {

final IntWritable total = new IntWritable();

@Override

protected void reduce(Text key, Iterable<IntWritable> values, Context context) throws IOException, InterruptedException {

int num = 0;

//进行局部汇总,逻辑是与reduce方法保持一致

for (IntWritable value : values) {

final int i = value.get();

num += i;

}

total.set(num);

//输出单词,累加结果

context.write(NullWritable.get(), total);

}

}### --- workcountdriver

package com.yanqi.mr.CombineTextInputFormat;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.lib.input.CombineTextInputFormat;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

import java.io.IOException;

//封装任务并提交运行

public class WordCountDriver {

public static void main(String[] args) throws IOException, ClassNotFoundException, InterruptedException {

/*

1. 获取配置文件对象,获取job对象实例

2. 指定程序jar的本地路径

3. 指定Mapper/Reducer类

4. 指定Mapper输出的kv数据类型

5. 指定最终输出的kv数据类型

6. 指定job处理的原始数据路径

7. 指定job输出结果路径

8. 提交作业

*/

// 1. 获取配置文件对象,获取job对象实例

final Configuration conf = new Configuration();

//针对reduce端输出使用snappy压缩

// conf.set("mapreduce.output.fileoutputformat.compress", "true");

// conf.set("mapreduce.output.fileoutputformat.compress.type", "RECORD");

// conf.set("mapreduce.output.fileoutputformat.compress.codec", "org.apache.hadoop.io.compress.SnappyCodec");

final Job job = Job.getInstance(conf, "WordCountDriver");

// 2. 指定程序jar的本地路径

job.setJarByClass( WordCountDriver.class);

// 3. 指定Mapper/Reducer类

job.setMapperClass( WordCountMapper.class);

job.setReducerClass( WordCountReducer.class);

// 4. 指定Mapper输出的kv数据类型

job.setMapOutputKeyClass(Text.class);

job.setMapOutputValueClass(IntWritable.class);

// 5. 指定最终输出的kv数据类型

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(IntWritable.class);

//设置使用CombinerTextInputFormat读取数据

job.setInputFormatClass( CombineTextInputFormat.class);

//设置虚拟存储切片的最大值,单位为byte

CombineTextInputFormat.setMaxInputSplitSize(job, 4194304);

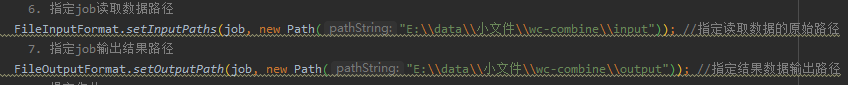

// 6. 指定job读取数据路径

FileInputFormat.setInputPaths(job, new Path("E:\\data\\小文件\\wc-combine\\input")); //指定读取数据的原始路径

// 7. 指定job输出结果路径

FileOutputFormat.setOutputPath(job, new Path("E:\\data\\小文件\\wc-combine\\output")); //指定结果数据输出路径

// 8. 提交作业

final boolean flag = job.waitForCompletion(true);

//jvm退出:正常退出0,非0值则是错误退出

System.exit(flag ? 0 : 1);

}

}

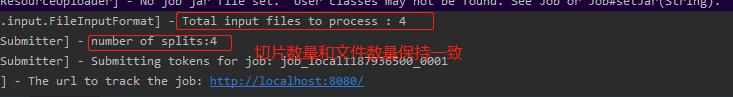

四、打印输出

### --- 打印输出

~~~ 编辑输入输出配置参数

~~~ 输出结果

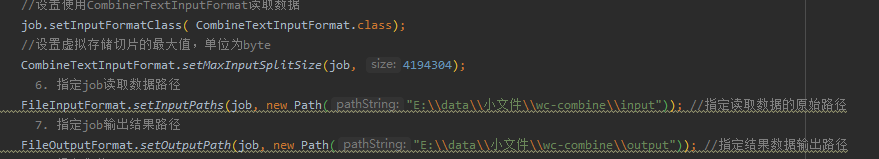

五、设置为InputFormat参数

### --- 编辑wordcountdriver配置文件

### --- 编译打印

//设置使用CombinerTextInputFormat读取数据

job.setInputFormatClass( CombineTextInputFormat.class);

//设置虚拟存储切片的最大值,单位为byte

CombineTextInputFormat.setMaxInputSplitSize(job, 4194304);

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?