本文主要介绍一下CNN的几种经典模型比较。之前自己也用过AlexNet和GoogleNet,网络上关于各种模型的介绍更是形形色色,自己就想着整理一下,以备自己以后查阅方便

LeNet5

先放一张图,我感觉凡是对深度学习有涉猎的人,对这张图一定不会陌生,这就是最早的LeNet5的平面结构图。

Lenet5诞生于1994年,是最早的卷积神经网络之一,并且推动了深度学习的发展。Caffe中LeNet的配置文件,从中我们可以看出Lenet5由两个卷积层,两个池化层,以及两个全连接层组成。卷积都是5*5的filter,步长为1,。池化都是max-pooling

Lenet5特征能够总结为如下几点:

(1)卷积神经网络使用三个层作为一个系列:卷积、池化、非线性

(2)使用卷积提取空间特征

(3)使用映射到空间均值下采样

(4)双曲线(tanh)或s型(sigmoid)形式的非线性

(5)多层神经网络(MLP)作为最后的分类器

(6)层与层之间的稀疏链接矩阵避免大的计算成本

AlexNet

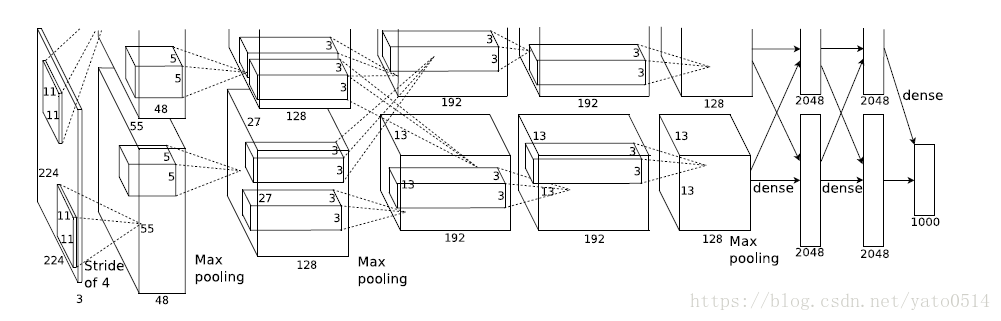

2012年,ImageNet比赛冠军的model–Alexnet,可以说是LeNet的一种更深更宽的版本。AlexNet包含了6亿3000万个连接,6000万个参数和65万个神经元,拥有5个卷积层,其中3个卷积层后面连接了最大池化层,最后还有3个全连接层。AlextNet以显著的优势赢得了ILSVRC比赛的冠军,top-5的错误率从之前的25.8%降低至16.4。 AlexNet的Caffe的model文件

上图之所以分为两层,是因为AlexNet训练时用了两块GPU。

ALexNet的主要技术点在于:

(1)使用RELU作为CNN的激活函数,解决了sigmoid在网络较深时的梯度弥散问题。

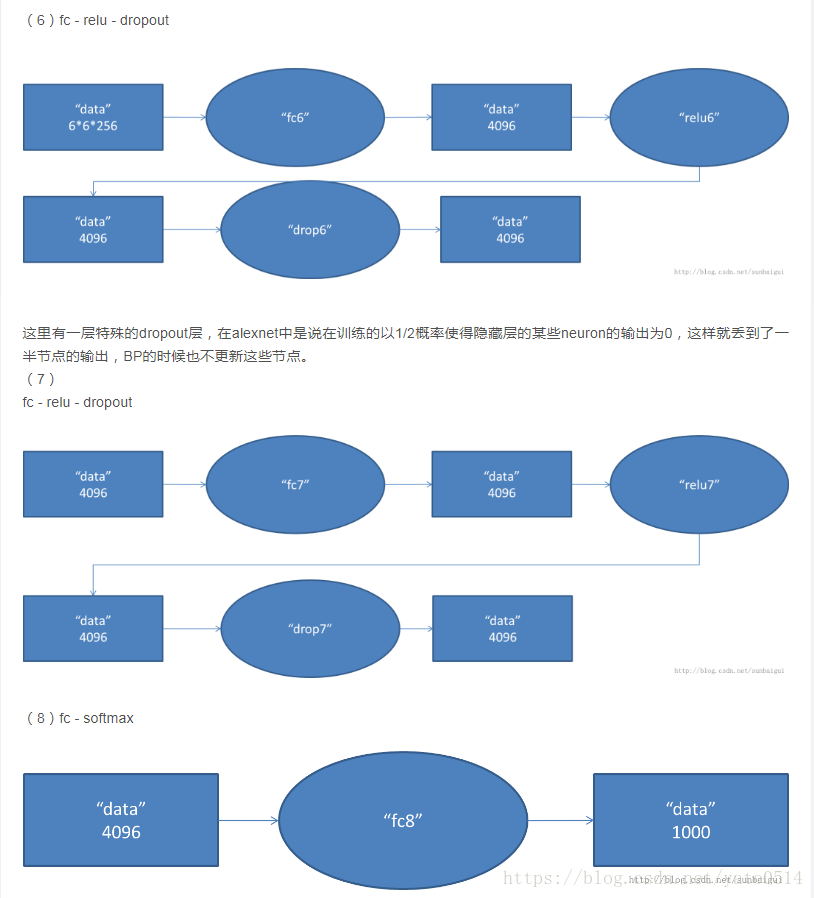

(2)训练时使用了Dropout随机忽略一部分神经元,以避免模型过拟合。

(3)在CNN中使用重叠的最大池化,步长小于池化核,这样输出之间会有重叠和覆盖,提升了特征的丰富性。此前CNN普遍使用平均池化,AlexNet全部使用最大池化,避免平均池化的模糊性效果。

(4)提出了LRN层,对局部神经元的活动创建竞争机制,使得其中响应比较大的值变得相对更大,并抑制其他反馈比较小的神经元,增强了模型的泛化能力。

(5)使用CUDA加速深度卷积网络的训练,利用GPU强大的并行计算能力,处理神经网络训练时大量的矩阵计算。AlexNet使用了两块GTX 580 GPU进行训练,单个GTX 580只有3GB显存,这限制了可训练的网络的最大规模。因此作者将AlexNet分布在两个GPU上,在每个GPU的显存中储存一半的神经元的参数。因为GPU之间通信方便,可以互相访问显存,而不需要通过主机内存,所以同时使用多块GPU也是非常高效的。同时,AlexNet的设计让GPU之间的通信只在网络的某些层进行,控制了通信的性能损耗。

(6)使用数据增强,减轻过拟合,提高泛化能力

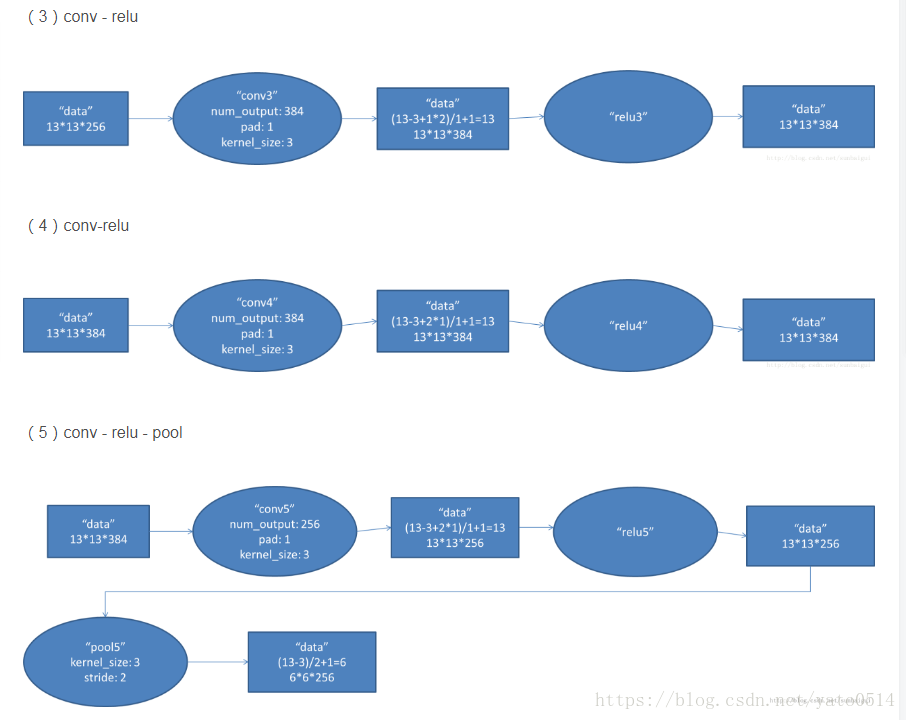

具体打开AlextNet的每一阶段来看:

VGG

VGG是第一个在各个卷积层使用更小的3*3过滤器(filter),并把他们组合作为一个卷积序列进行 处理的网络,它的特点就是连续conv多,计算量巨大。

VGG的巨大进展是通过依次采用多个3*3卷积,能够模拟出更大的感受野

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?