本以为遥遥领先的GPT早就普及了,但小伙伴寻找使用的热度一直高居不下,其实现在很简单了!

国产大模型快200家了,还有很多成熟的国内AI产品,跟官网一样使用,还更加好用~

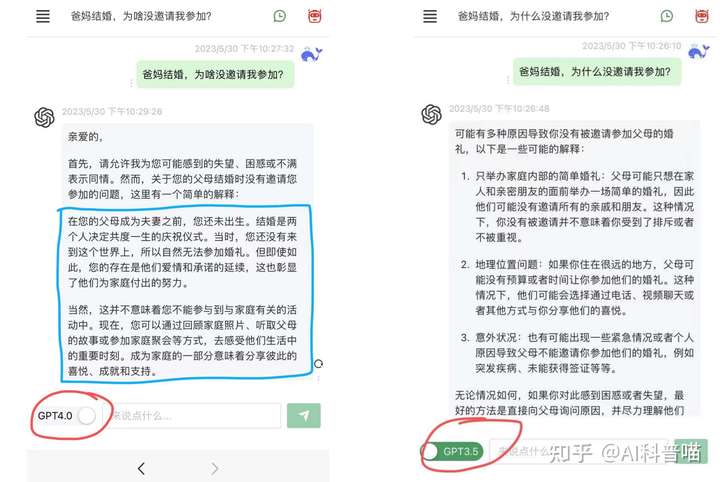

① 3.5 大多数场景是够用的,也领先一众国产大模型,性价比挺好的

② 4.0 在 综合能力方面的确更出色,尤其是 逻辑、推理、创意等方面,能力更出色、更强大。

朋友也给我推荐了一些稳定、方便、好用的AI工具,用了用也还不错~

精选AI工具分享:

① AI 一下:yixiaai.com 最全AI工具,通用ChatGPT,支持3.5和4.0、最新模型GPT-4o、4o mini

② AI Wisland:aiwisland.com AI增强版,支持各种模型、AI画图、AI读图、插件、助手功能

③ 写一下Al:xie.yixia.ai 堪称目前最好的文档类工具,强大的多功能写作,集成GPT、笔记、任务和知识库。

④ AI PPT:ppt.yixiaai.com 一键生成PPT,多种精美ppt模板,支持文件、网址,能编辑、能下载~

⑤ 阿里通义千问:通义大模型 阿里巴巴AI产品,兵马俑跳舞火出圈

⑥ 百度文心一言:文心一言 国产AI自研的第一款产品,百度出品

⑦ 智谱清言:智谱AI 对标ChatGPT,清华出品,360智脑等很多国产AI都接入了它

⑧ Chat File:ChatFile 支持pdf、word、excel、csv、markdown、txt、ppt,所有格式简直通吃

⑨ Chat Excel:ChatExcel 与excel聊天,支持excel计算,排序等

⑩ Chat XMind:ChatMind 通过聊天创建和修改思维导图,一键生成、导出、下载

论文指令小技巧:

① 降重指令:

我想让你充当一位计算机视觉领域的专家,帮助学生进行论文的去重修改。如果文章中连续13个字一样,就算重复。你需要通过调整主谓宾语序替换同义词、增减字数等方法,来达到论文去重的目的。

请你修改下面这段文字:XXXXXXXXXX

ps:查重率5%以下(亲测),可放心使用~

② 润色指令:

直接润色: 请润色以下内容,使其更加正式,更合逻辑,并且具有论文的风格:

描述清楚任务 + 再进行润色: 下面这段话,根据你所掌握的有关XXX和XXX的知识,有没有更好的写法,请帮助润色修改,以便能够用于论文:

③ 翻译指令:

请你翻译下面这段文字: XXXXXXXXXXXXX

ps:比有道、google、百度翻译更精确,尤其是论文里面一些专业术语。

④ 写作指令:

摘要、研究背景、研究意义、文献综述、研究内容框架、研究结论、致谢等。

写摘要: 我开始写论文了,题目是XXXXXX,请你提供更具体的细节,以支持论点或想法,完成800字摘要。

提意见: 我开始写论文了,题目是XXXXXX,现在我完成了摘要部分,但是不确定是否合适,你能帮我看一下,并提出详细具体的修改意见吗?

ps:会自动分段、逻辑清晰、语言表达精炼,检查无误后可使用!

我整理了很多干货,如果有想一起学习、使用、分享的~ 欢迎加入~

如果看完文章有收获,请帮忙【点赞】支持下~

3418

3418

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?