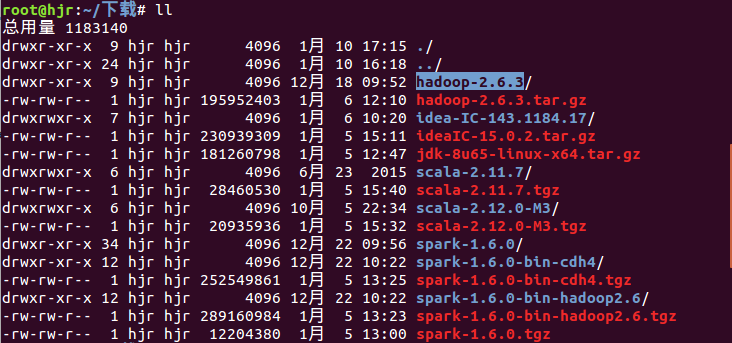

下载 解压Hadoop2.6.3 tar文件

下载链接:

http://hadoop.apache.org/releases.html解压文件,至当前文件夹:

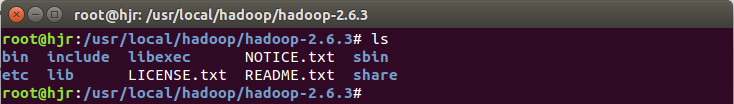

tar -xzvf hadoop-2.6.3.tar.gz 新建自己的Hadoop目录,移动文件至该目录中

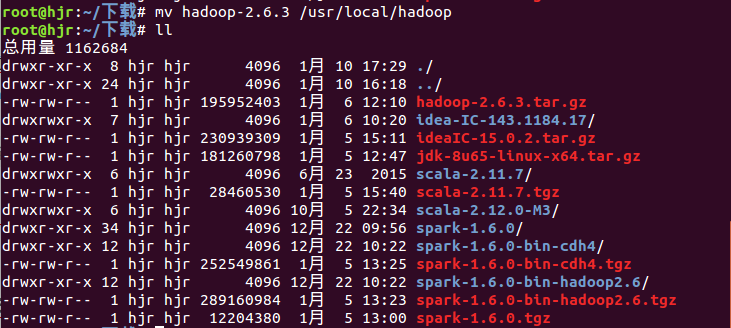

新建hadoop目录

mkdir /usr/local/hadoop移动解压后的文件到自己新建的hadoop目录当中

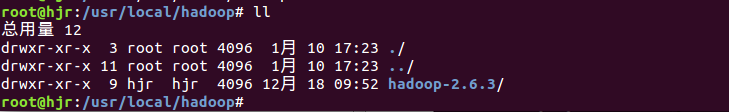

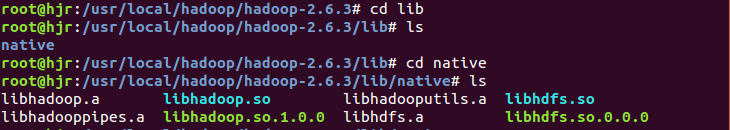

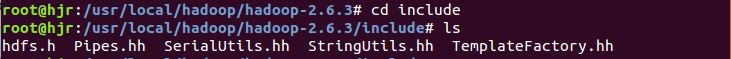

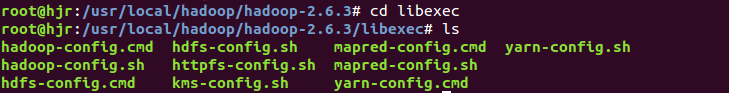

mv hadoop-2.6.3 /usr/local/hadoop查看hadoop目录熟悉hadoop目录文件

配置Hadoop环境

1 配置Hadoop环境变量

首先设置Hadoop运行所需要的环境变量,我们编辑 .bashrc 文件,添加我们的环境变量.

然后我们重新导入~/.bashrc文件中的内容到shell中:

命令:source .bashrc

export HADOOP_HOME=/usr/local/hadoop/hadoop-2.6.3 修改添加hadoop_home到 PATH 环境变量

export PATH=${JAVA_HOME}/bin:${HADOOP_HOME}/bin:$PATH使配置生效:source .bashrc

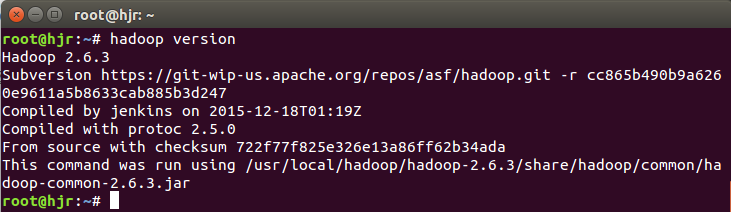

验证Hadoop命令:

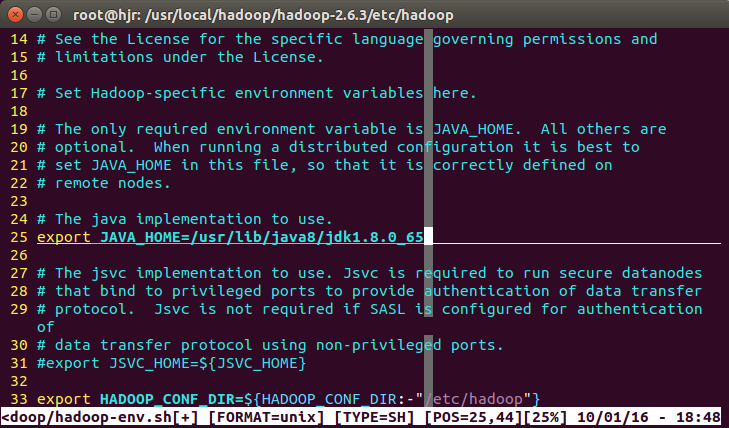

hadoop version2 为Hadoop设置Java环境变量

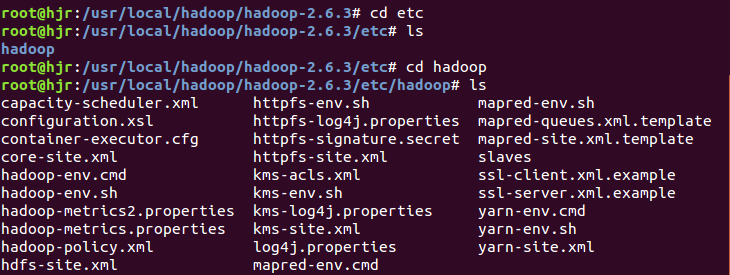

vim /usr/local/hadoop/hadoop-2.6.3/etc/hadoop/hadoop-env.sh3 编辑配置Hadoop配置文件

hadoop-2.6.3的etc/hadoop目录下面有许多配置文件:

-rw-r--r-- 1 hjr hjr 4436 12月 18 09:52 capacity-scheduler.xml

-rw-r--r-- 1 hjr hjr 1335 12月 18 09:52 configuration.xsl

-rw-r--r-- 1 hjr hjr 318 12月 18 09:52 container-executor.cfg

-rw-r--r-- 1 hjr hjr 774 12月 18 09:52 core-site.xml

-rw-r--r-- 1 hjr hjr 3670 12月 18 09:52 hadoop-env.cmd

-rw-r--r-- 1 hjr hjr 4238 1月 10 18:49 hadoop-env.sh

-rw-r--r-- 1 hjr hjr 2598 12月 18 09:52 hadoop-metrics2.properties

-rw-r--r-- 1 hjr hjr 2490 12月 18 09:52 hadoop-metrics.properties

-rw-r--r-- 1 hjr hjr 9683 12月 18 09:52 hadoop-policy.xml

-rw-r--r-- 1 hjr hjr 775 12月 18 09:52 hdfs-site.xml

-rw-r--r-- 1 hjr hjr 1449 12月 18 09:52 httpfs-env.sh

-rw-r--r-- 1 hjr hjr 1657 12月 18 09:52 httpfs-log4j.properties

-rw-r--r-- 1 hjr hjr 21 12月 18 09:52 httpfs-signature.secret

-rw-r--r-- 1 hjr hjr 620 12月 18 09:52 httpfs-site.xml

-rw-r--r-- 1 hjr hjr 3523 12月 18 09:52 kms-acls.xml

-rw-r--r-- 1 hjr hjr 1325 12月 18 09:52 kms-env.sh

-rw-r--r-- 1 hjr hjr 1631 12月 18 09:52 kms-log4j.properties

-rw-r--r-- 1 hjr hjr 5511 12月 18 09:52 kms-site.xml

-rw-r--r-- 1 hjr hjr 11291 12月 18 09:52 log4j.properties

-rw-r--r-- 1 hjr hjr 938 12月 18 09:52 mapred-env.cmd

-rw-r--r-- 1 hjr hjr 1383 12月 18 09:52 mapred-env.sh

-rw-r--r-- 1 hjr hjr 4113 12月 18 09:52 mapred-queues.xml.template

-rw-r--r-- 1 hjr hjr 758 12月 18 09:52 mapred-site.xml.template

-rw-r--r-- 1 hjr hjr 10 12月 18 09:52 slaves

-rw-r--r-- 1 hjr hjr 2316 12月 18 09:52 ssl-client.xml.example

-rw-r--r-- 1 hjr hjr 2268 12月 18 09:52 ssl-server.xml.example

-rw-r--r-- 1 hjr hjr 2237 12月 18 09:52 yarn-env.cmd

-rw-r--r-- 1 hjr hjr 4567 12月 18 09:52 yarn-env.sh

-rw-r--r-- 1 hjr hjr 690 12月 18 09:52 yarn-site.xml

我们配置的是伪分布式环境,所以需要配置以下几个文件:

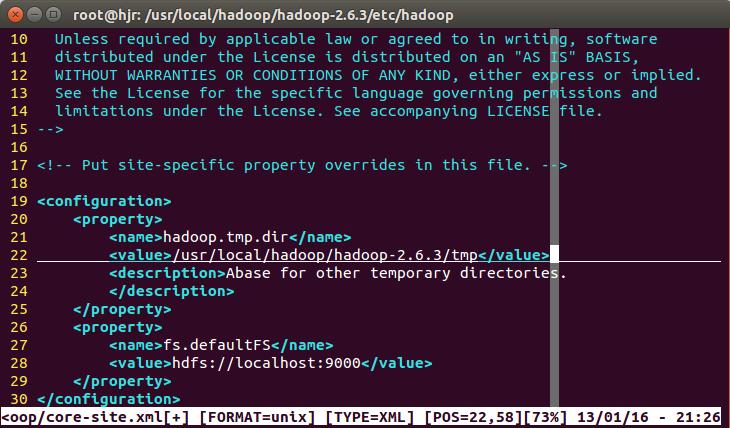

HADOOP的核心配置文件:core-site.xml --- 主要是配置HDFS的地址和端口号

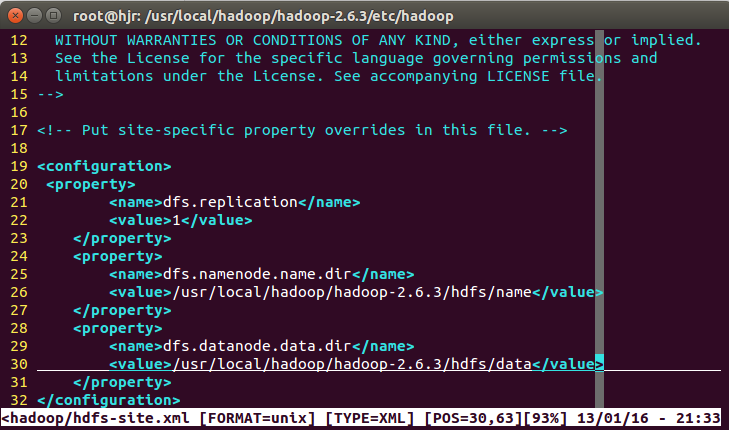

HADOOP的HDFS配置文件:hdfs-site.xml --- 主要是配置replication副本数

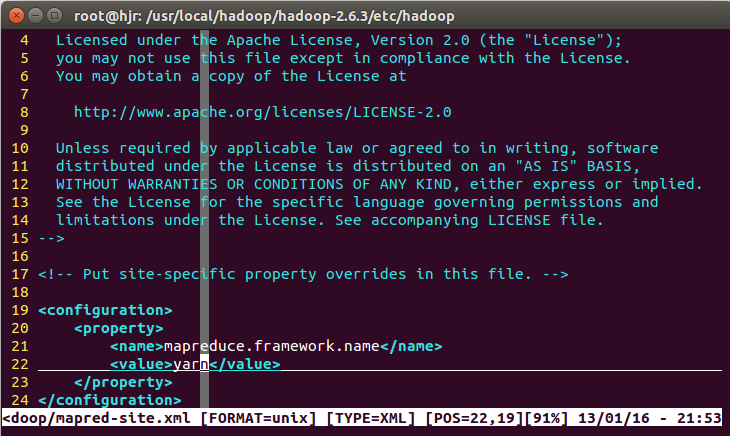

HADOOP的MapReduce配置文件:mapred-site.xml ---主要是

YARN配置文件:yarn-site.xml --- 主要是core-site.xml配置:

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/hadoop/hadoop-2.6.3/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>hdfs-site.xml配置:

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>/usr/local/hadoop/hadoop-2.6.3/hdfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/usr/local/hadoop/hadoop-2.6.3/hdfs/data</value>

</property>

</configuration>mapred-site.xml配置:

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

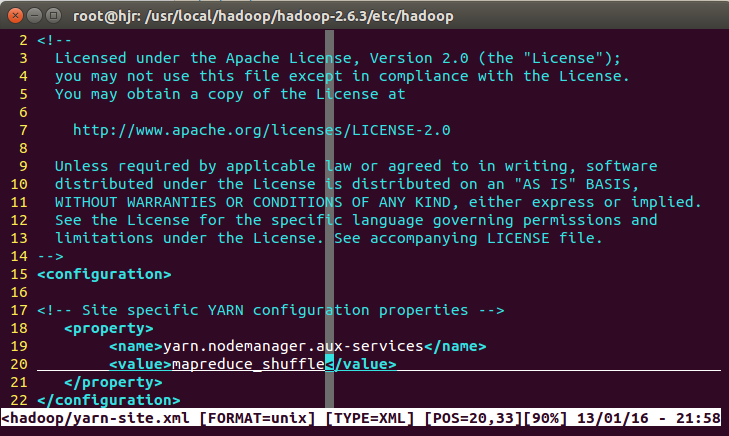

</configuration>yarn-site.xml配置:

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

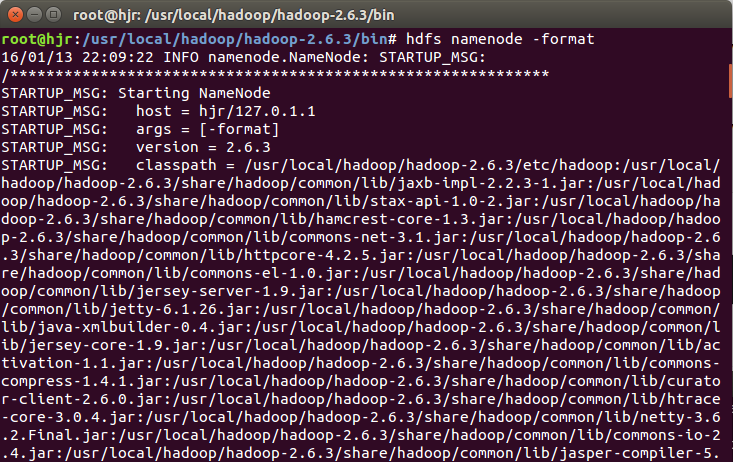

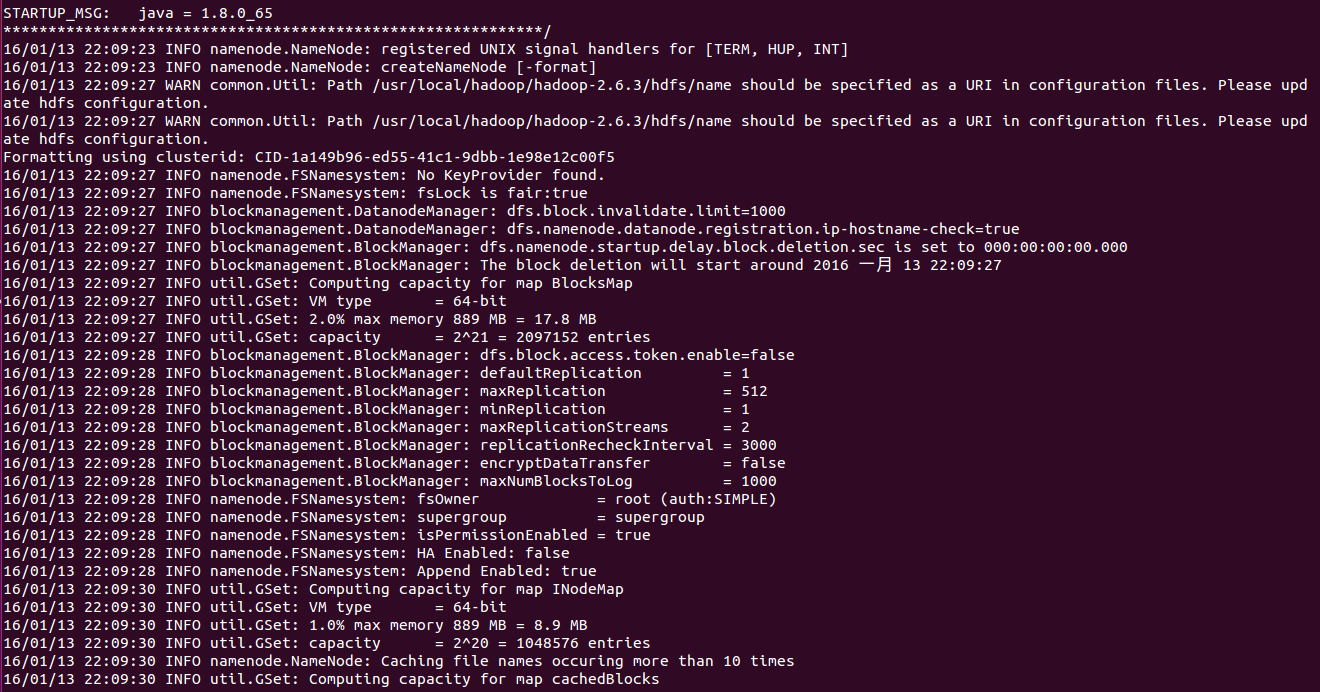

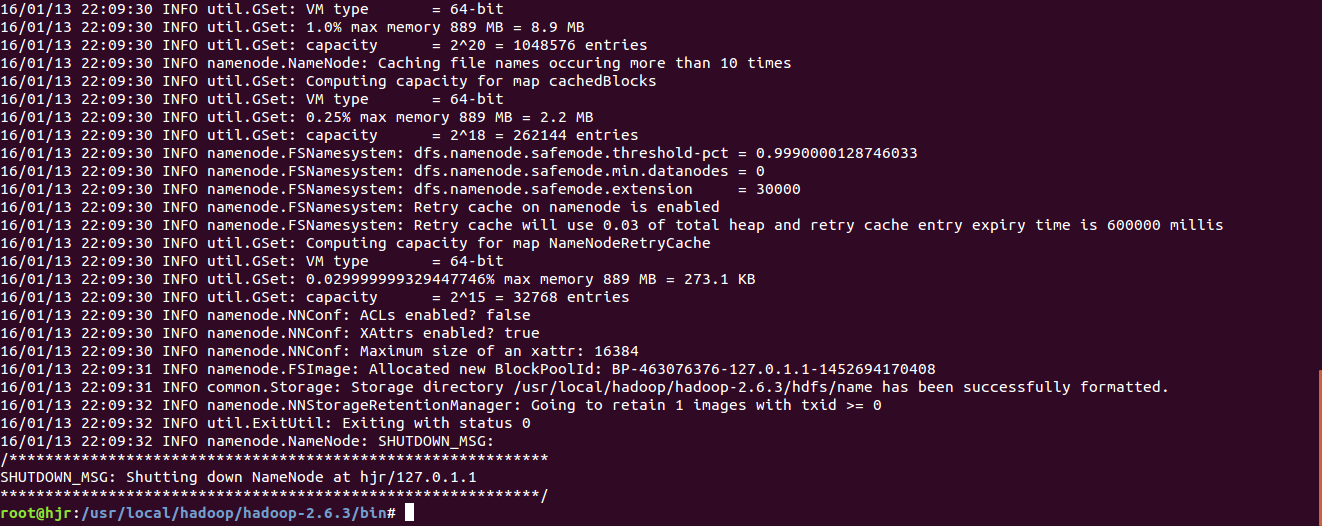

</configuration>4 配置完成,执行 NameNode 的格式化

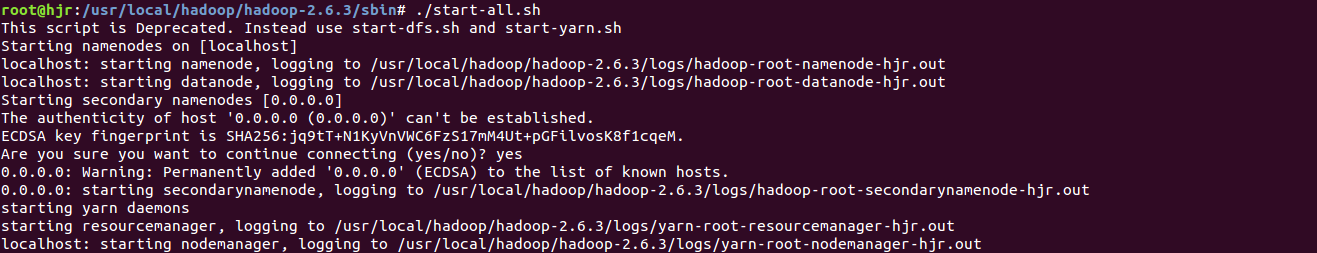

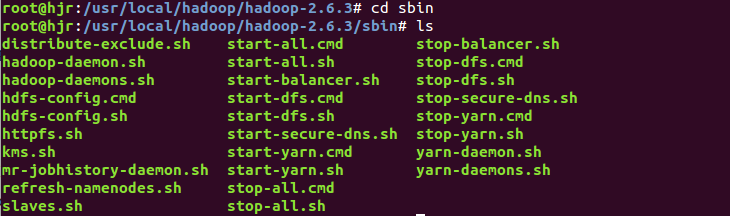

hdfs namenode-format5 启动Hadoop,运行Hadoop示例

./start-all.sh

(This script is Deprecated. Instead use start-dfs.sh and start-yarn.sh)

所有进程:

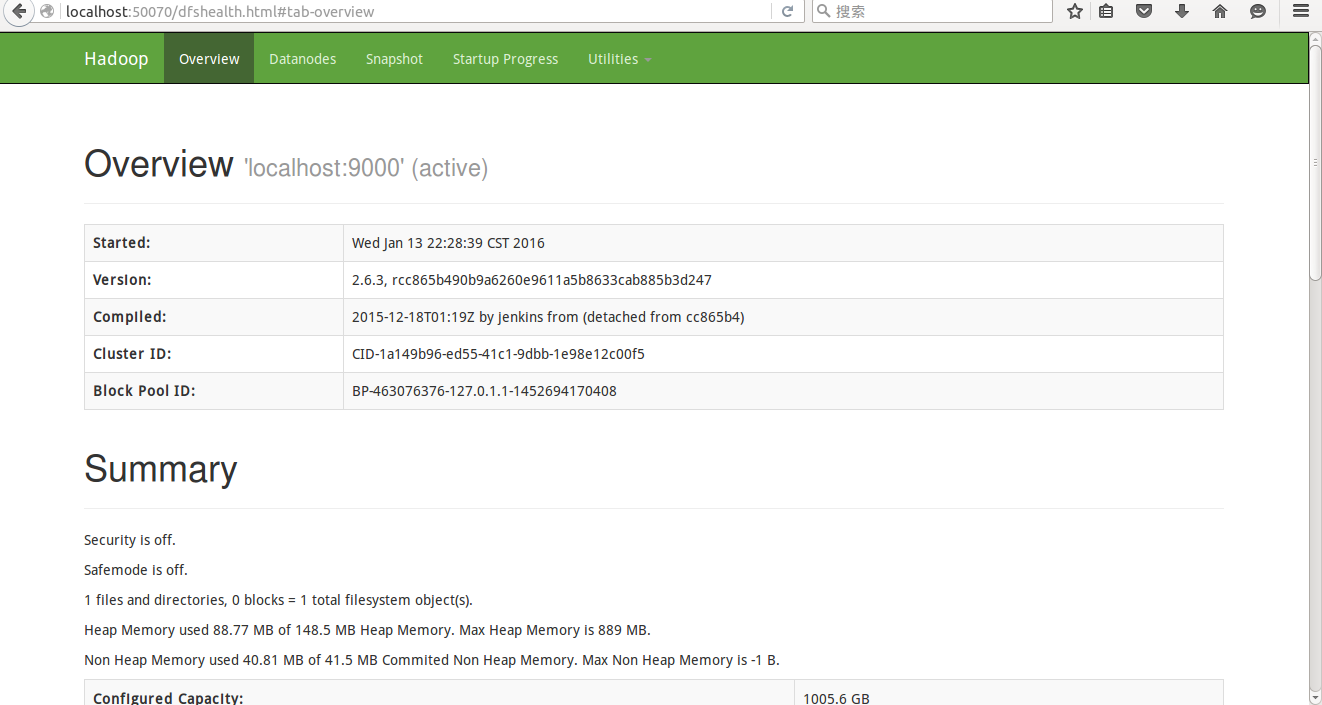

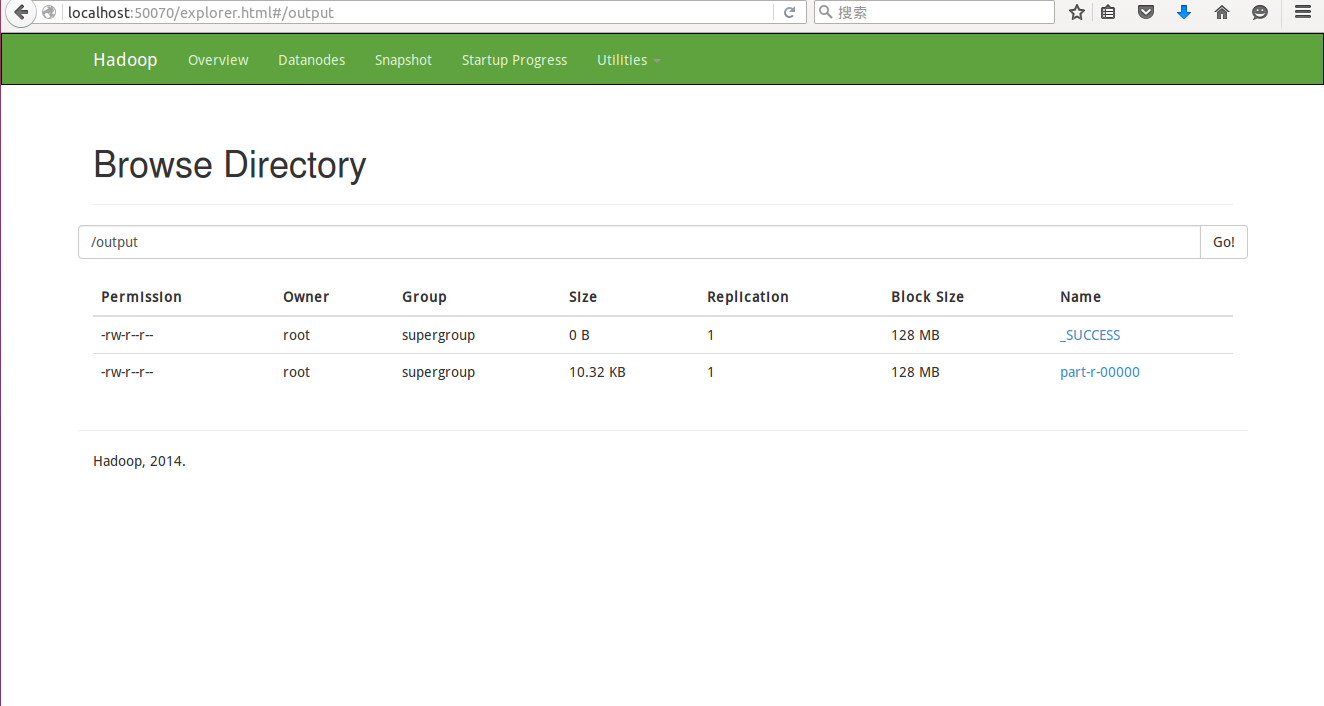

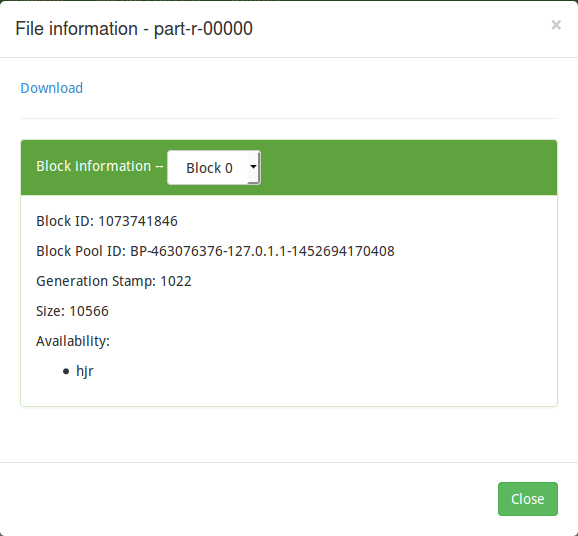

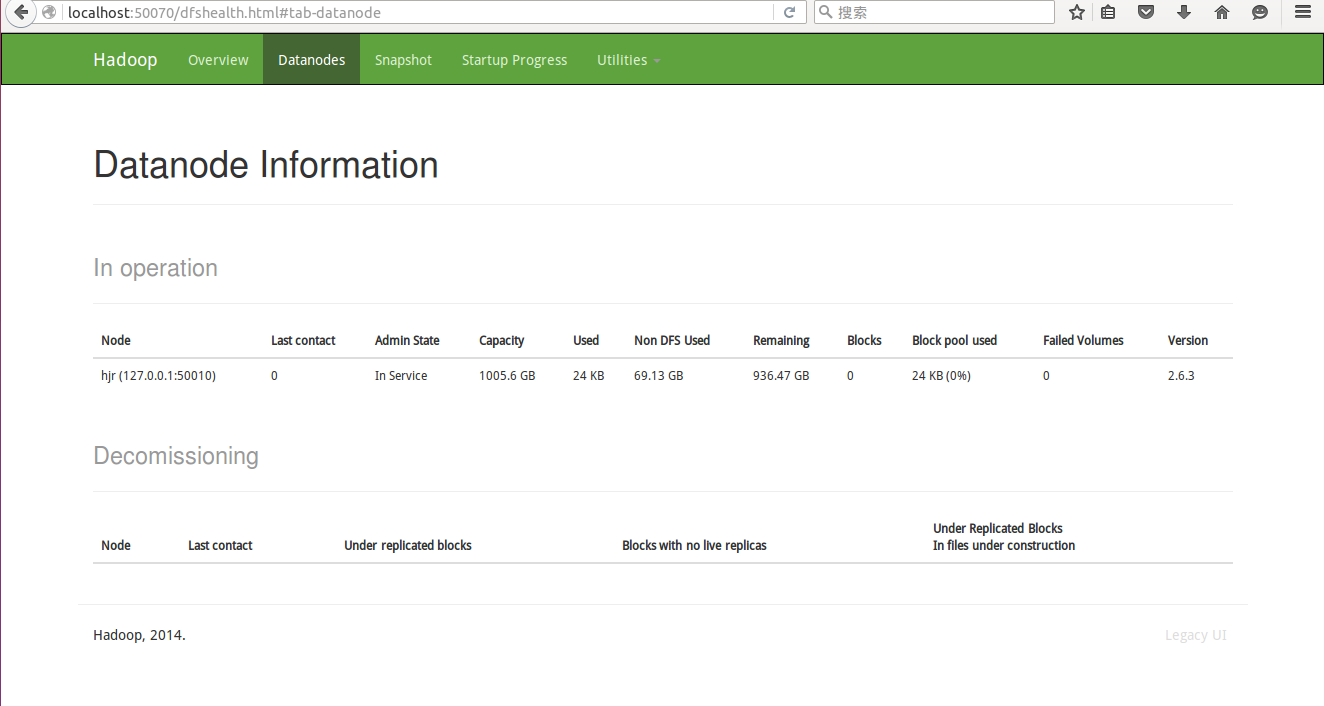

Hadoop Web界面(hdfs):

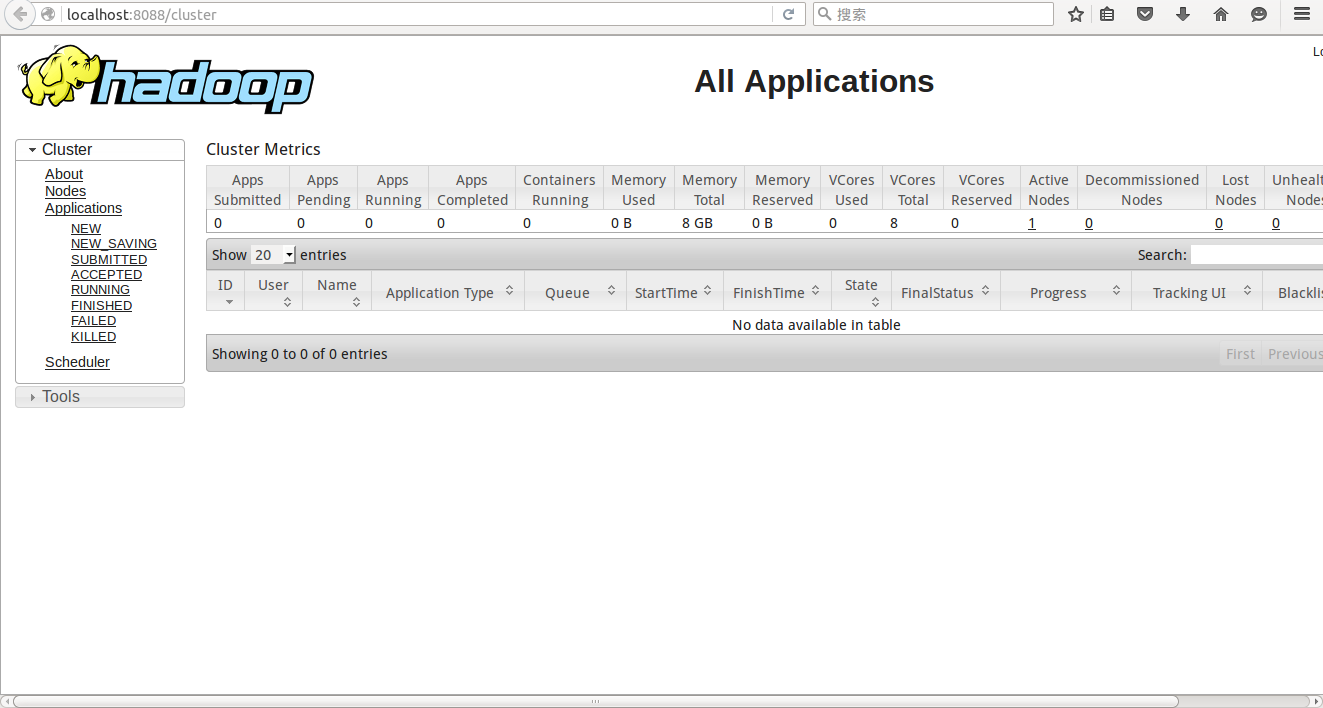

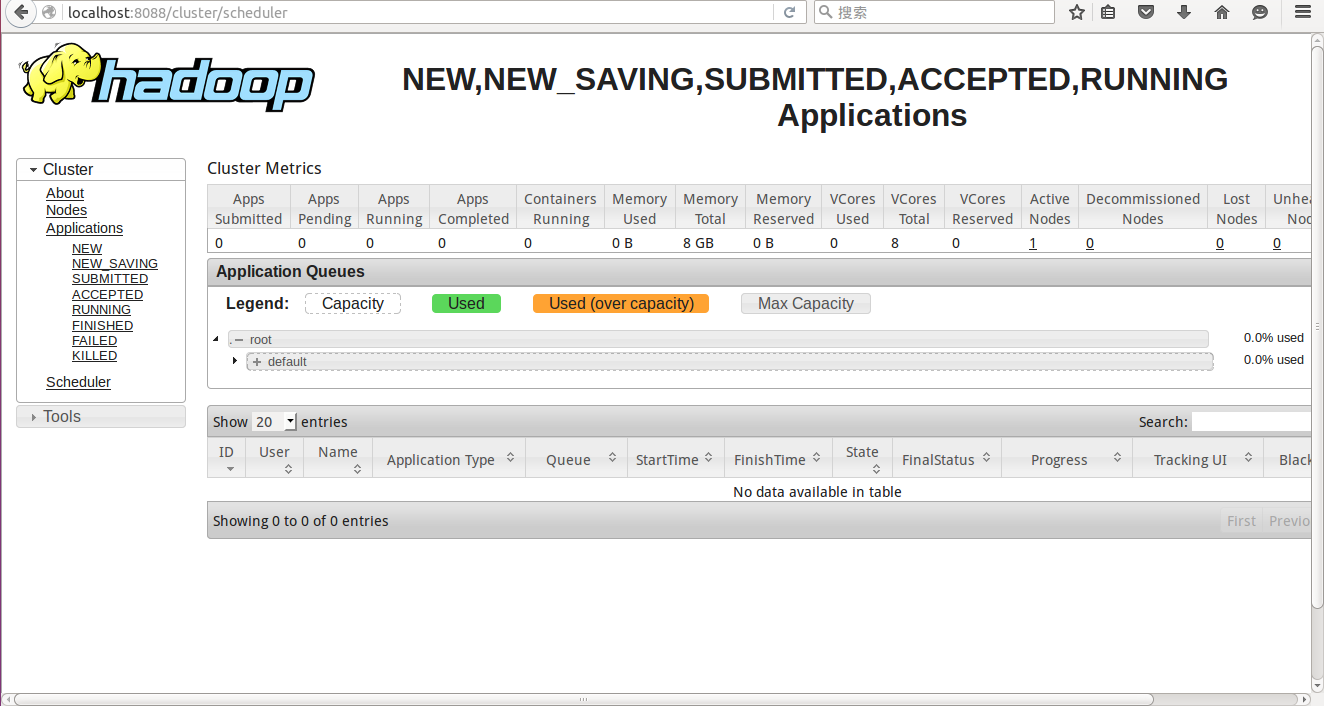

YARN资源管理界面

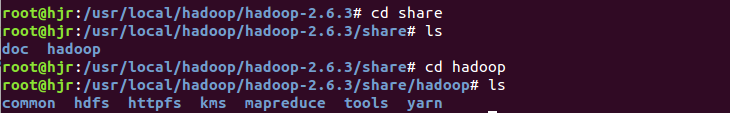

在HDFS上面创建用户目录

hdfs dfs -mkdir -p /user/hadoop

hdfs dfs -mkdir -p /hjr

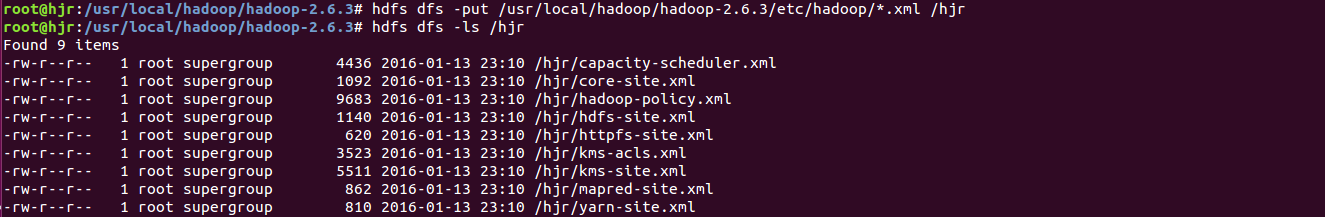

hdfs dfs -mkdir -p /test上传本地文件到HDFS对应用户目录

hdfs dfs -put /usr/local/hadoop/hadoop-2.6.3/etc/hadoop/*.xml /hjr查看HDFS文件列表

hdfs dfs -ls /hjr

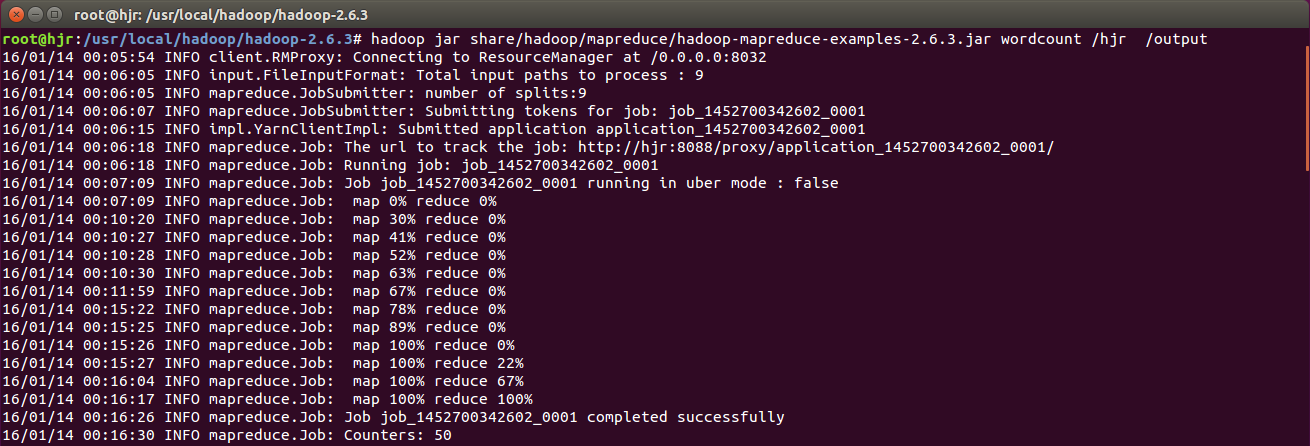

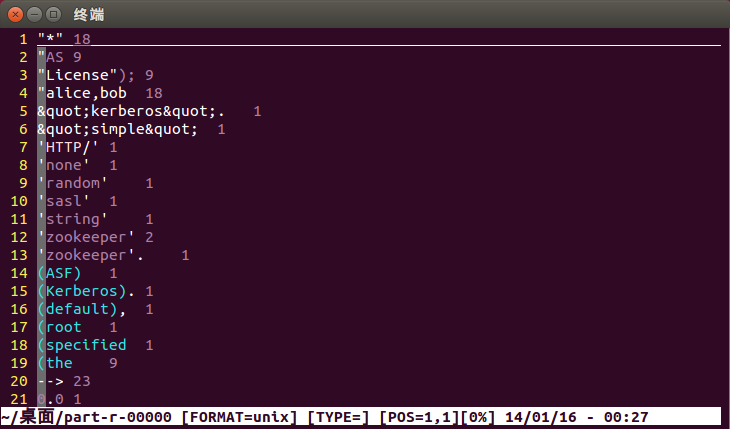

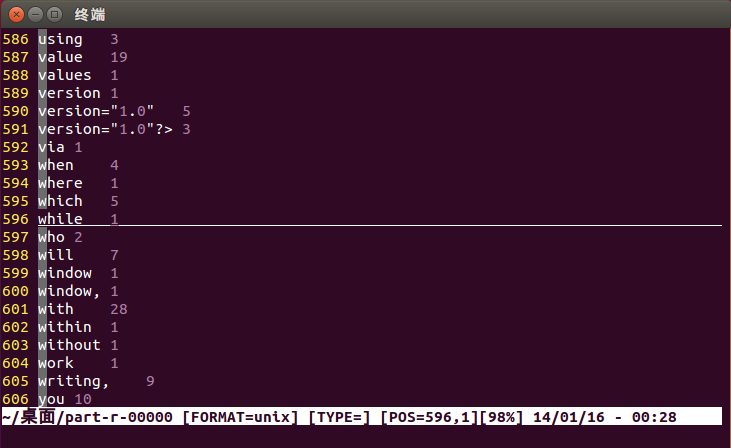

运行wordcount示例

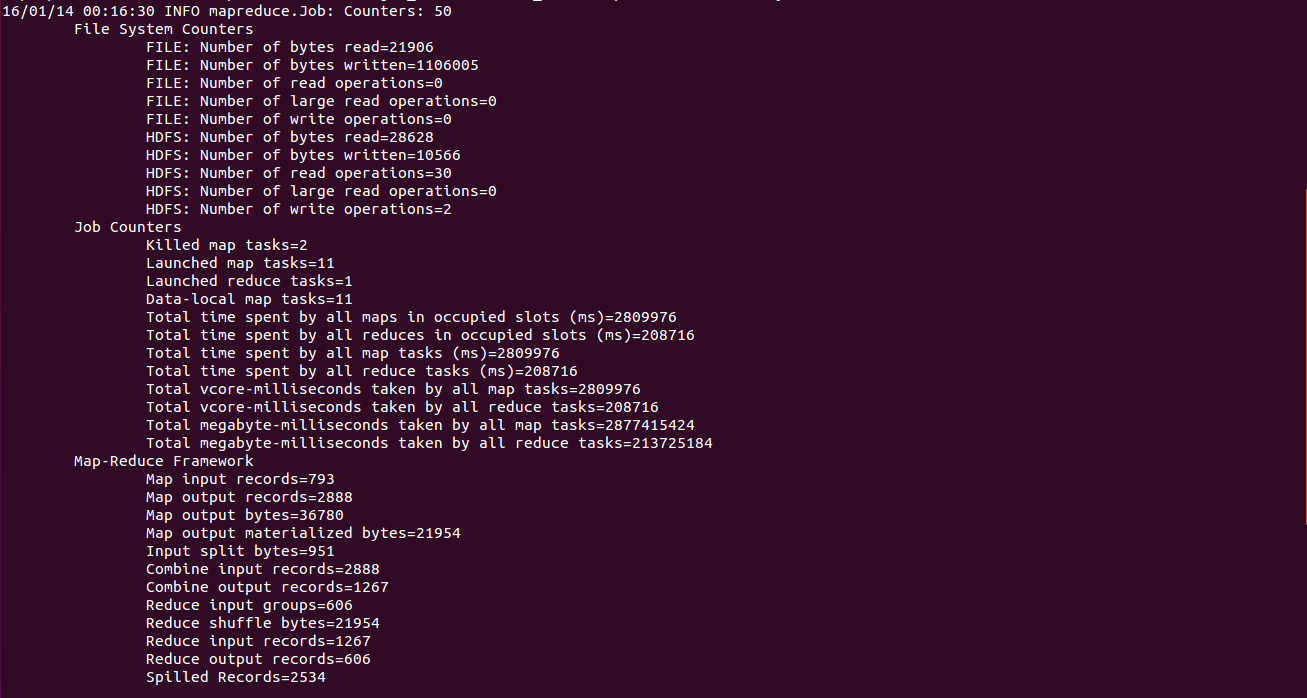

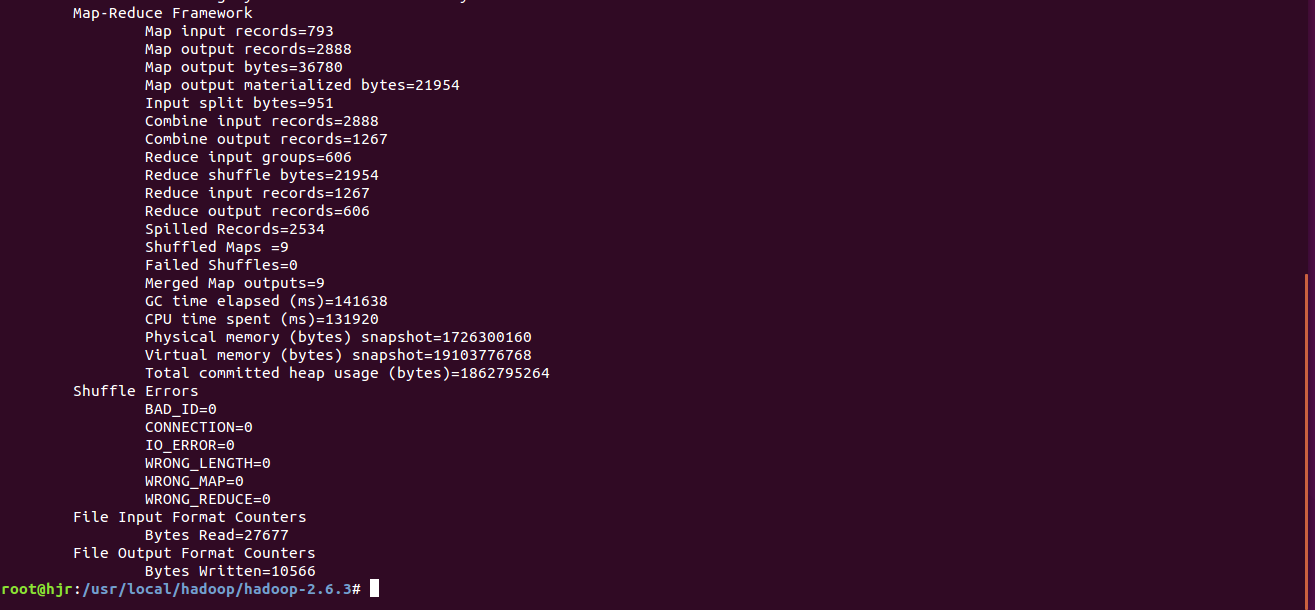

hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.6.3.jar wordcount /hjr /output

1839

1839

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?