你是否感到疑惑:为什么AI能够与你探讨哲学、创作科幻故事,然而在处理财报中隐藏于正常数据下的债务危机,或是剖析法律条款中错综复杂的侵权陷阱时,却无法给出完全精准的答案,如同一位知识面广泛却并非专精的优等生?实际上,这就好比一位全能型学霸,尽管学识渊博,但在面对特定学科的难题时仍需查漏补缺,而模型微调(Fine-tuning)正是让AI实现精准“查漏补缺”的关键技术。

一、模型微调是什么?

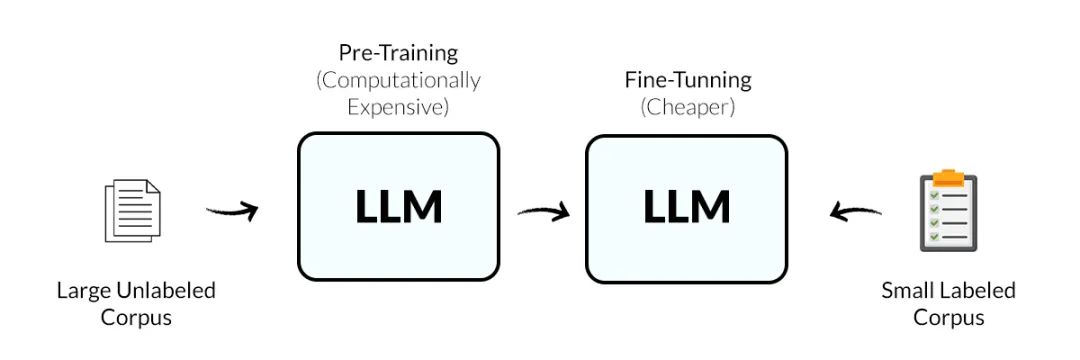

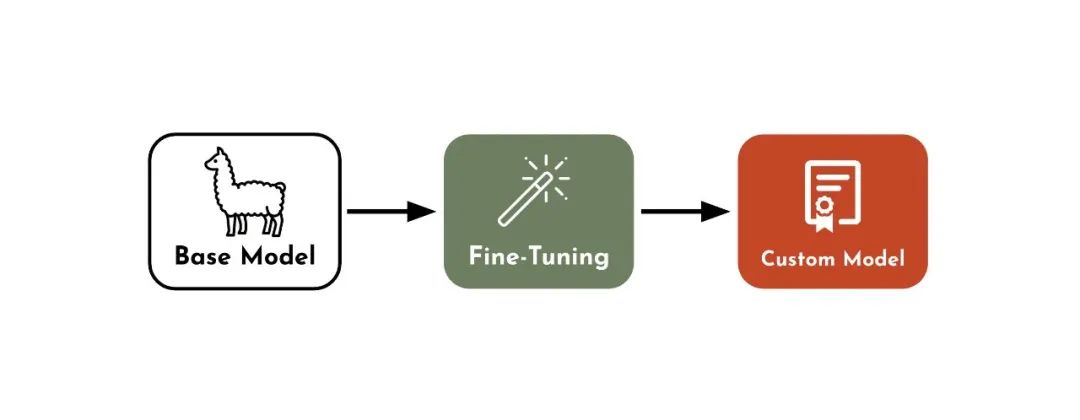

Fine-tuning(模型微调)到底是个啥?模型微调是在预训练大模型(如DeepSeek、LLaMA、Qwen等)的基础上,用特定领域或任务的数据集对模型参数进行二次训练,让大模型“从通才成为专家”。

- 预训练模型: 已在大规模无标注数据上学习通用特征(如语言规则、物体识别)。

- 微调: 注入领域专属知识(如医疗术语、金融逻辑),使模型具备特定场景下的专业能力。

模型微调的本质是通过参数优化、数据适配与领域约束,将通用大模型的能力“聚焦”到特定场景,使其在保持基础能力的同时,精准适配行业需求。

-

参数优化:从普适性到专业性的转变

大模型在预训练阶段吸收了全网海量数据(以拥有6710亿参数的满血版DeepSeek为例),构建起的知识体系具有广泛的通用性。而微调过程则通过对部分参数(通常调整1%-10%的参数比例)进行优化,在保持模型基础能力的同时,着重提升其对特定领域数据的感知与处理能力,实现从“泛化”到“特化”的进阶。 -

数据适配:聚焦领域专属知识

微调环节需要使用特定领域的专属数据(比如法律领域需依托判例库),而不是通用文本语料。在此过程中,数据强调“少而精”的特性,而非盲目追求“多而全”。举例来说,1000条经过专业标注的法律案例数据,在提升模型领域能力方面的效果,可能远超100万条普通通用文本。 -

领域约束:规范输出逻辑

通用模型在生成内容时,可能会出现表面看似合理、实则存在错误的情况(如法律条款引用错误)。通过微调,尤其是设计针对性的损失函数(如增加法律条款一致性的约束条件),能够有效引导模型的输出逻辑,使其更契合专业领域的规范与要求,确保输出内容(如准确引用《民法典》第X条)符合领域逻辑,告别“自由联想”式的随意输出 。

为什么需要Fine-tuning(模型微调)?通用模型难以适配细分场景的专业需求,而微调能以极少量领域数据(1000+标注)和超低计算成本(节省90%+资源),快速定制出高精度、可落地的行业专家模型。

通过合理选择数据策略和微调方法,即使新手也能在1周内完成首个定制化模型。随着QLoRA等PEFT技术的发展,微调门槛持续降低。最新数据显示,80%的企业级AI应用已采用微调方案。

二、技术实现

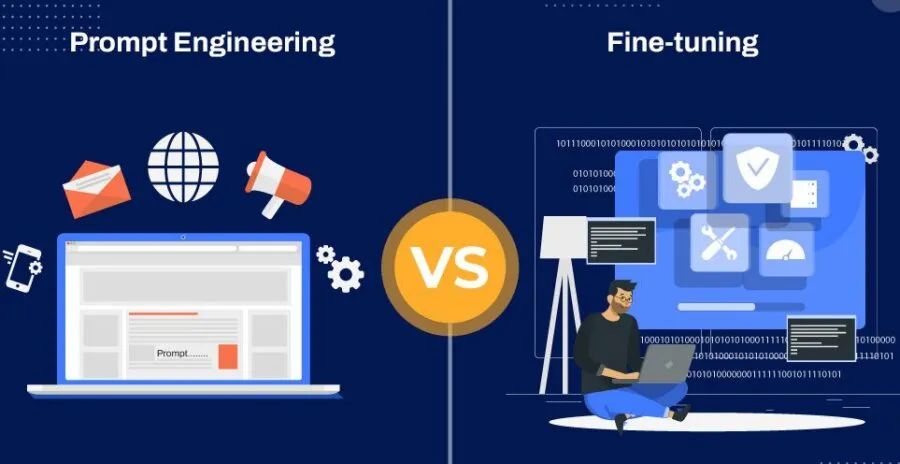

Fine-tuning(模型微调)如何进行技术实现?资源受限时,优先用QLoRA通过‘量化压缩’与‘LoRA精调’降低显存需求;快速验证任务可行性时,用Prompt Engineering低成本试水;LlamaFactory则用“工具箱”实现一站式微调。

1、QLoRA:以 “精准优化” 打破硬件限制

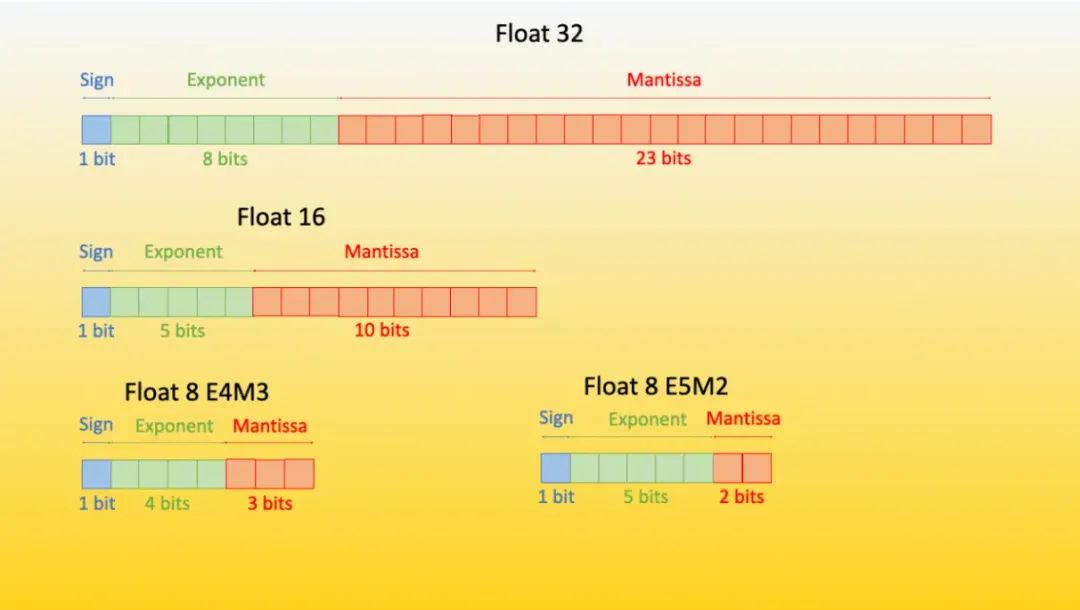

(1)量化处理:通过参数压缩技术,将模型参数从 16 位缩减至 4 位。这一操作显著降低显存占用,330 亿参数模型的显存需求从 128GB 降至 24GB,如同将庞大数据 “压缩打包”,且在推理阶段解压后不会损失精度。

(2)LoRA 优化:对模型参数进行选择性冻结,仅保留 0.1% 的参数可调整,具体在注意力层插入低秩矩阵,新增可调参数仅 200 万个。这种方式大幅减少显存消耗,降幅达 90%,就像为模型配备专用 “聚焦工具”,使其专注于特定任务。

(3)单卡高效微调:借助一张 RTX 4090(24GB 显存)就能对 DeepSeek-70B 模型进行微调。相比传统方式,QLoRA 不仅能维持相同精度,还能实现训练速度提升 3 倍,同时将硬件成本降低 85% 。

2. 提示工程——开启领域能力的"密钥"

(1)任务规范:借助提示词模板引导模型输出指定格式内容,例如在法律人工智能应用中,通过"依据《专利法》第22条展开分析"的指令,使条款引用准确率从55%显著提升至82%。

(2)无参数优化:无需进行模型训练,仅需设计3-5组提示词进行效果比对,实现近乎零成本的优化过程。

3. LlamaFactory——以“一站式工具箱”赋能模型微调

(1)多元策略整合:平台内置LoRA、全量微调、RLHF(偏好对齐)等六种微调策略,支持灵活组合,实现“即插即用”。例如,通过LoRA与RLHF相结合,可显著增强对话内容的连贯性和一致性。

(2)便捷配置训练:用户仅需通过YAML文件配置参数,如设置学习率为1e-5、批次大小为32,即可完成训练设置。无需复杂的代码开发,相较传统方式,效率提升达60% 。

那么,如何系统的去学习大模型LLM?

作为一名从业五年的资深大模型算法工程师,我经常会收到一些评论和私信,我是小白,学习大模型该从哪里入手呢?我自学没有方向怎么办?这个地方我不会啊。如果你也有类似的经历,一定要继续看下去!这些问题啊,也不是三言两语啊就能讲明白的。

所以我综合了大模型的所有知识点,给大家带来一套全网最全最细的大模型零基础教程。在做这套教程之前呢,我就曾放空大脑,以一个大模型小白的角度去重新解析它,采用基础知识和实战项目相结合的教学方式,历时3个月,终于完成了这样的课程,让你真正体会到什么是每一秒都在疯狂输出知识点。

由于篇幅有限,⚡️ 朋友们如果有需要全套 《2025全新制作的大模型全套资料》,扫码获取~

👉大模型学习指南+路线汇总👈

我们这套大模型资料呢,会从基础篇、进阶篇和项目实战篇等三大方面来讲解。

👉①.基础篇👈

基础篇里面包括了Python快速入门、AI开发环境搭建及提示词工程,带你学习大模型核心原理、prompt使用技巧、Transformer架构和预训练、SFT、RLHF等一些基础概念,用最易懂的方式带你入门大模型。

👉②.进阶篇👈

接下来是进阶篇,你将掌握RAG、Agent、Langchain、大模型微调和私有化部署,学习如何构建外挂知识库并和自己的企业相结合,学习如何使用langchain框架提高开发效率和代码质量、学习如何选择合适的基座模型并进行数据集的收集预处理以及具体的模型微调等等。

👉③.实战篇👈

实战篇会手把手带着大家练习企业级的落地项目(已脱敏),比如RAG医疗问答系统、Agent智能电商客服系统、数字人项目实战、教育行业智能助教等等,从而帮助大家更好的应对大模型时代的挑战。

👉④.福利篇👈

最后呢,会给大家一个小福利,课程视频中的所有素材,有搭建AI开发环境资料包,还有学习计划表,几十上百G素材、电子书和课件等等,只要你能想到的素材,我这里几乎都有。我已经全部上传到CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

相信我,这套大模型系统教程将会是全网最齐全 最易懂的小白专用课!!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?