对于个人开发者或体验用户来说,本地部署DeepSeek的方案相对简单,但一旦进入企业级场景,部署流程会涉及更多复杂考量。

企业级部署的第一步,需要结合实际业务场景明确两个核心问题:一是要部署的模型规格(如参数量、功能定位),二是支撑该模型运行所需的服务器资源——这也是资源预估的核心价值。

资源预估完成后,还需判断业务是否需要二次开发:若仅需简单微调就能满足需求,Ollama、LM Studio等工具足以应对;若需深度定制化开发,则需考虑模型的原生部署。

一、服务器资源评估:从参数到配置的精准匹配

评估服务器资源前,需先明确四个关键指标:模型参数量、序列长度、批次大小和量化类型。为简化计算,后文将提供一个通用配置计算器工具,帮助快速生成资源清单。

1. 模型参数量:决定资源基础需求

模型参数量可理解为“模型的知识储备总量”,是神经网络中所有输入权重与输出阈值的总和。参数量越大,模型的“知识储备”越丰富,智能化程度通常越高(但并非绝对,还需结合训练数据质量)。

举例:一个7B参数量的模型适合中小型业务场景,而65B参数量的模型更适合需深度推理的复杂任务(如金融分析、科研辅助)。

参数量直接影响资源消耗:参数量翻倍,所需的显存和计算资源往往需要同步提升。

2. 序列长度:影响业务处理能力

确认模型参数规模后,需根据业务场景评估序列长度——即模型一次能处理的最大Token数(可简单理解为“单次交互的文本容量”)。

- 客服问答场景:用户问题通常较短,序列长度1024-2048Token即可满足;

- 文档分析场景:需处理长文本(如合同、报告),序列长度需4096-8192Token;

若输入文本超出序列长度,模型可能截断内容或分批次处理,影响体验和精度。

3. 量化类型:平衡精度与资源消耗

量化类型是模型参数的存储精度(如FP16、INT8、INT4)。精度越高(如FP16),模型输出越精准,但占用资源越多;精度较低(如INT4),资源消耗减少,但可能损失部分精度。

建议:非核心业务可采用INT8量化(平衡精度与资源),核心业务优先FP16(保证精度)。

4. 服务器资源计算工具

了解上述指标后,可通过配置计算器快速匹配资源。只需输入模型规模(如7B/13B)、序列长度、量化类型,工具会自动生成推荐配置(如CPU、GPU、显存需求)。

你只需要根据上面的概念选择自己的模型规模,便会自动计算出所需要的服务器资源。

二、基于Ollama的DeepSeek部署:轻量高效的快速方案

Ollama是一款跨平台的轻量级大模型运行工具,支持Mac、Linux、Windows系统,适合快速部署并验证模型效果。

1. Ollama安装步骤

- MacOS/Windows:直接访问Ollama官网下载安装包,双击安装即可;

- Linux:通过命令行安装:

curl -fsSL https://ollama.com/install.sh | sudo bash sudo usermod -aG ollama $USER # 添加用户权限 sudo systemctl start ollama # 启动服务

安装完成后,在终端输入ollama -v,若返回版本号(如0.5.7),则表示安装成功。

小贴士:Linux用户若遇权限报错,可尝试sudo chmod 777 /var/lib/ollama临时授予权限(生产环境需谨慎设置权限)。

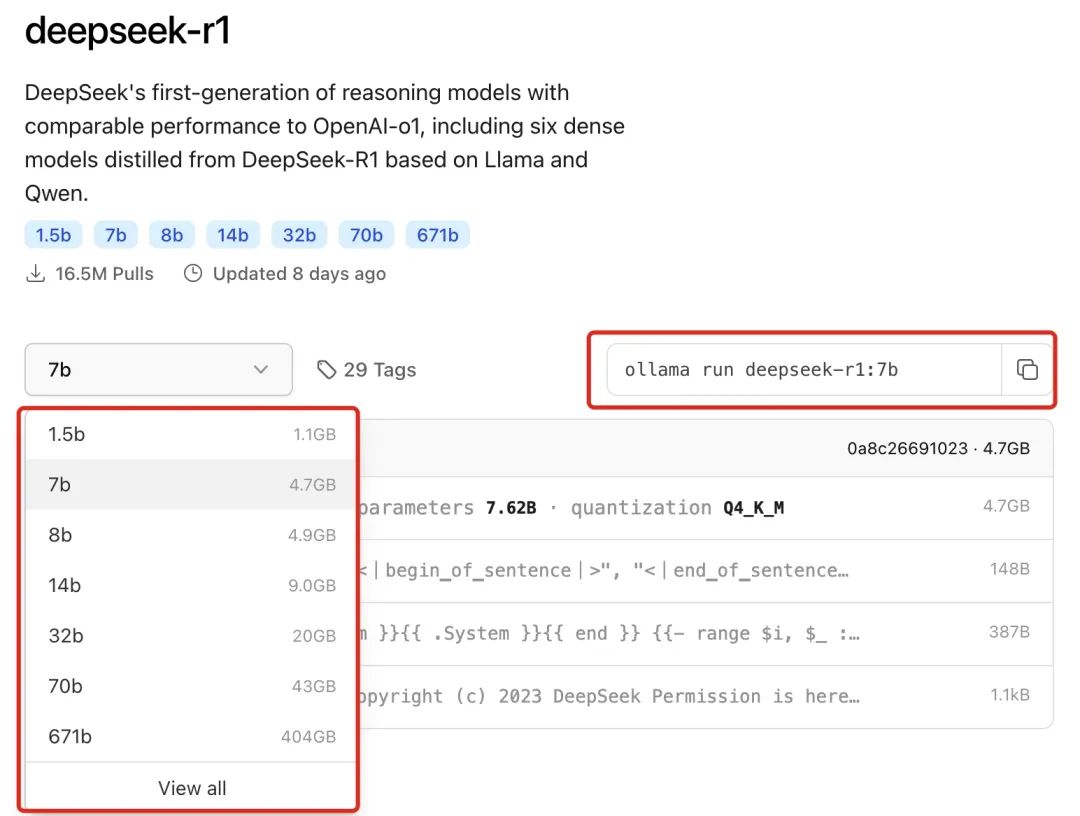

2. 部署DeepSeek模型

-

访问Ollama模型库,选择适配当前服务器配置的模型版本(如7B、13B);

-

复制对应部署命令,在终端执行:

ollama run deepseek-r1:7b命令执行后,系统会自动拉取模型文件(约4.7GB),完成后将显示交互提示,此时可直接输入问题测试。

3. 配套部署文本向量化模型

为后续Dify的检索功能做准备,需额外部署nomic-embed-text(文本向量化模型):

ollama pull nomic-embed-text

该模型仅需274MB存储空间,主要用于将文本转换为向量,支撑知识库的精准检索。

4. 图形化客户端选择

命令行交互不够直观?可搭配以下图形化工具:

- Open WebUI:支持多模型切换,界面类似ChatGPT,适合团队共享使用;

- ChatBox:轻量客户端,支持本地文档导入,适合个人测试;

- AnythingLLM:侧重知识库管理,适合需频繁调用私有数据的场景。

以Open WebUI为例,安装后在设置中填写Ollama API地址(默认http://localhost:11434),选择deepseek-r1:7b模型即可开始可视化交互。

三、DeepSeek原生部署:定制化场景的最佳选择

若业务需深度定制(如添加自定义推理逻辑、优化并发性能),原生部署是更优选择。DeepSeek支持SGLang、LMDeploy、TensorRT-LLM、vLLM等框架,此处以LMDeploy为例展开。

1. LMDeploy环境准备

LMDeploy是一款专注于大模型部署优化的工具,支持显存高效利用和高并发处理。安装步骤:

# 创建虚拟环境

conda create -n lmdeploy-env python=3.8 -y

conda activate lmdeploy-env

# 安装LMDeploy

pip install lmdeploy

2. 核心部署代码与配置解析

以下代码实现了DeepSeek的原生部署,关键参数已添加注释:

from lmdeploy import pipeline, TurbomindEngineConfig

from lmdeploy.generation import GenerationConfig

# 模型路径(支持本地目录或模型仓库ID)

model = 'deepseek-ai/DeepSeek-R1-Distill-Qwen-7B'

# 后端配置:优化显存与上下文管理

backend_config = TurbomindEngineConfig(

cache_max_entry_count=0.2, # 缓存占比(降低显存占用)

max_context_token_num=20544, # 最大上下文Token数

session_len=20544 # 会话长度(需与模型序列长度匹配)

)

# 生成配置:控制输出效果

gen_config = GenerationConfig(

top_p=0.95, # 采样阈值(值越高,输出越多样)

temperature=0.6, # 随机性(值越低,输出越确定)

max_new_tokens=8192, # 最大生成Token数

stop_token_ids=[151329, 151336, 151338], # 停止符ID

do_sample=True # 启用采样生成

)

class DeepSeekService:

def __init__(self):

self.llm = pipeline(model, backend_config=backend_config)

self.gen_config = gen_config

def chat(self, user_input):

# 按DeepSeek规范构造提示(以「</think>\n」结尾)

prompts = [{

"role": "user",

"content": f"{user_input}</think>\n"

}]

response = self.llm(prompts, gen_config=self.gen_config)

return response

# 启动服务

if __name__ == "__main__":

service = DeepSeekService()

print(service.chat("解释一下大模型的量化技术"))

3. 其他部署框架对比

- vLLM:擅长高并发场景,支持动态批处理,适合API服务部署;

- SGLang:侧重推理效率优化,适合需要快速响应的实时场景;

- TensorRT-LLM:基于NVIDIA TensorRT加速,适合GPU资源充足的环境。

四、Dify私有化部署:构建企业专属AI应用平台

Dify是一款开源的LLM应用开发平台,无需复杂编码即可搭建私有知识库、工作流,大幅降低企业级AI应用的开发门槛。

1. Dify部署步骤

需先安装Docker和Git,然后执行以下命令:

# 克隆代码

git clone https://github.com/langgenius/dify.git

cd dify/docker

# 配置环境

cp .env.example .env

# 启动服务(默认端口80)

docker-compose up -d

启动后访问http://localhost,注册管理员账号即可进入控制台。

2. 配置模型与知识库

- 添加LLM模型:进入「设置-模型管理」,选择「Ollama」类型,填写模型名称(deepseek-r1:7b)和API地址(

http://host.docker.internal:11434); - 添加向量化模型:同样在模型管理中,选择「nomic-embed-text」,API地址同上;

- 构建知识库:

- 新建知识库(如“产品手册库”),上传文档(支持PDF、Word等格式);

- 配置分段策略(建议每段200-500Token,平衡精度与效率);

- 选择nomic-embed-text模型进行向量转换,完成后即可基于知识库问答。

3. 工作流:让AI具备“行动力”

Dify的工作流功能可串联多步骤任务,例如:

- 客户投诉处理流:自动提取投诉关键词→调用知识库匹配解决方案→生成回复话术→同步至CRM系统;

- 数据分析流:接收业务数据→调用DeepSeek生成分析结论→自动生成Excel报告→发送邮件通知。

工作流通过可视化节点配置,无需编码即可实现复杂逻辑,显著提升业务自动化效率。

总结

从服务器资源的精准评估,到Ollama的快速部署、原生部署的深度定制,再到Dify的私有化应用搭建,本文覆盖了DeepSeek企业级部署的全流程。实际操作中,建议根据业务规模(如日均交互量、数据量)灵活调整配置,优先通过小范围测试验证效果后再逐步扩容。

那么,如何系统的去学习大模型LLM?

作为一名从业五年的资深大模型算法工程师,我经常会收到一些评论和私信,我是小白,学习大模型该从哪里入手呢?我自学没有方向怎么办?这个地方我不会啊。如果你也有类似的经历,一定要继续看下去!这些问题啊,也不是三言两语啊就能讲明白的。

所以我综合了大模型的所有知识点,给大家带来一套全网最全最细的大模型零基础教程。在做这套教程之前呢,我就曾放空大脑,以一个大模型小白的角度去重新解析它,采用基础知识和实战项目相结合的教学方式,历时3个月,终于完成了这样的课程,让你真正体会到什么是每一秒都在疯狂输出知识点。

由于篇幅有限,⚡️ 朋友们如果有需要全套 《2025全新制作的大模型全套资料》,扫码获取~

为什么要学习大模型?

我国在A大模型领域面临人才短缺,数量与质量均落后于发达国家。2023年,人才缺口已超百万,凸显培养不足。随着AI技术飞速发展,预计到2025年,这一缺口将急剧扩大至400万,严重制约我国AI产业的创新步伐。加强人才培养,优化教育体系,国际合作并进是破解困局、推动AI发展的关键。

👉大模型学习指南+路线汇总👈

我们这套大模型资料呢,会从基础篇、进阶篇和项目实战篇等三大方面来讲解。

👉①.基础篇👈

基础篇里面包括了Python快速入门、AI开发环境搭建及提示词工程,带你学习大模型核心原理、prompt使用技巧、Transformer架构和预训练、SFT、RLHF等一些基础概念,用最易懂的方式带你入门大模型。

👉②.进阶篇👈

接下来是进阶篇,你将掌握RAG、Agent、Langchain、大模型微调和私有化部署,学习如何构建外挂知识库并和自己的企业相结合,学习如何使用langchain框架提高开发效率和代码质量、学习如何选择合适的基座模型并进行数据集的收集预处理以及具体的模型微调等等。

👉③.实战篇👈

实战篇会手把手带着大家练习企业级的落地项目(已脱敏),比如RAG医疗问答系统、Agent智能电商客服系统、数字人项目实战、教育行业智能助教等等,从而帮助大家更好的应对大模型时代的挑战。

👉④.福利篇👈

最后呢,会给大家一个小福利,课程视频中的所有素材,有搭建AI开发环境资料包,还有学习计划表,几十上百G素材、电子书和课件等等,只要你能想到的素材,我这里几乎都有。我已经全部上传到CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

相信我,这套大模型系统教程将会是全网最齐全 最易懂的小白专用课!!

1821

1821

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?