1.什么是Dokcer容器的数据卷

数据卷是一个或多个容器中专门指定的目录,它能够绕过联合文件系统。

卷被设计用作数据持久化、并且是独立于容器的生命周期的。

因此,Docker不会在删除容器时自动删除数据卷卷,也不会主动“垃圾回收”掉容器不再使用的卷。

说白了,数据卷的存在就是想让的容器的数据持久化存在,而且可以实现容器之间的数据共享

当我们在使用docker容器的时候,会产生一系列的数据文件,这些数据文件在我们关闭docker容器时是会消失的

但是其中产生的部分内容我们是希望能够把它给保存起来另作用途的

Docker将应用与运行环境打包成容器发布,我们希望在运行过程钟产生的部分数据是可以持久化的的

而且容器之间我们希望能够实现数据共享

通俗地来说,docker容器数据卷可以看成使我们生活中常用的u盘,它存在于一个或多个的容器中

由docker挂载到容器,但不属于联合文件系统,Docker不会在容器删除时删除其挂载的数据卷

有三种数据卷类型:

①宿主机数据卷:直接在宿主机的文件系统中但是容器可以访问(bind mount)

②命名的数据卷:磁盘上Docker管理的数据卷,但是这个卷有个名字。

③匿名数据卷:磁盘上Docker管理的数据卷,因为没有名字想要找到不容易,Docker来管理这些文件。

备注:数据卷其实都在(如果没有网络文件系统等情况下)宿主机文件系统里面的,

只是第一种是在宿主机内的特定目录下,而后两种则在docker管理的目录下,这个目录一般是 /var/lib/docker/volumes/

2.数据卷的特点

(1)数据卷可以在容器之间共享或重用数据

(2)数据卷中的更改可以直接生效

(3)数据卷中的更改不会包含在镜像的更新中

(4)数据卷的生命周期一直持续到没有容器使用它为止

3.如何添加数据卷

添加数据卷的方式有两种,第一种是直接通过命令行挂载,第二种是通过dockerFile添加

(1)第一种通过命令行挂载的方式,命令如下:

docker run -it -v /宿主机绝对路径目录: /容器内目录 镜像名

这个命令会在宿主机和容器内分别建立两个目录,两个目录是对接的,里面的数据可以共享

如果我们不知道数据卷是否挂载成功时,我们可以通过以下方式来检查数据卷的挂载结果

docker ps -a查看出容器的id

docker inspect 容器id

上面的命令可以查看容器的详细情况,命令返回的是JSON格式的字符串

运行命令之后我们在返回的JSON字符串中找到Volumes属性

假如挂载成功的话,Volumes里面显示的绑定结果应该是你在挂载时输入的命令参数 (/宿主机绝对路径目录: /容器内目录 )

如果与你们之前输入的一致的话,证明挂载成功

PS: Volumes里面显示的绑定结果可能有多个,但是只要找到目标结果就可以

挂载之后,当容器停止运行的时候,宿主机上对数据卷做的内容修改是会同步到容器内的

我们再挂载的时候还可以给数据卷加上权限,假如我们要宿主机只能读取容器的数据卷内容不能修改,我们可以添加只读权限

docker run -it -v /宿主机绝对路径目录 : /容器内目录 :ro 镜像名

至于只写的话我们一般不会用到,要么就是读写,要么就是只读

而且我们可以通过docker inspect 来查看容器的volumesRW来查看容器内数据卷的读写权限

(2)第二种就是利用dockerFile的形式添加

首先在linux服务器根目录上新建docker文件夹并建立DockerFile文件

使用volume命令

(出于可移植可分享的的考虑,用以上 -v /宿主机绝对路径目录 : /容器内目录 的这种方式不能够直接在dockerFile中直接实现,

因为宿主机目录是依赖于特定的宿主机的,并不能保证所有的宿主机都存在这样特定的目录)

编写的dockerFile文件如下

FROM 镜像名

VOLUME ["/生成的目录路径"] -- privileged=true

CMD echo "success build"

CMD /bin/bash

相当于命令行: docker run -it -v /宿主机目录路径 : /生成的目录路径

然后我们通过命令行docker build执行我们写好的dockerFile文件

(docker build和docker commit两个命令都可以建立docker镜像,docker commit 需要在容器内进行,docker build 不需要)

docker build -f /docker/DockerFile -t 命名空间/镜像名

执行后输入docker images就可以发现自己通过DockerFile所build的镜像,里面有挂载数据卷

那么问题来了宿主机所对应的目录是什么呢?

同上,我们可以通过docker inspect来查看当前容器的Volumes,里面会有宿主机的数据卷目录

说了这么多,那么到底什么是docker数据卷容器?

上面介绍了docker容器数据卷,它的作用相当于生活中的活动硬盘

那么数据卷容器就相当于把多个活动硬盘再挂载到一个活动硬盘上,实现数据的传递依赖。

官网解析:命名的容器挂载数据卷,其他的容器通过挂载这个父容器实现数据共享,挂载数据卷的容器,我们称为数据卷容器。

4.docker的数据卷

数据卷是目录或文件,不是块设备

容器可以读写volume中的数据

volume数据可以持久化保存

docker提供了两种卷:

(1)bind mount

是将主机上的目录或文件mount到容器里。

使用直观高效,易于理解。

使用 -v 选项指定路径

格式<host path>:<container path>

bind mount 默认权限是读写rw,可以在挂载时指定只读ro。

-v选项指定的路径,如果不存在,挂载时会自动创建。

(2)docker managed volume

bind mount必须指定host文件系统路径,限制了移植性。

docker managed volume 不需要指定mount源。

(3)bind mount与docker managed volume对比

5.bind mount数据卷

[root@server1 ~]# docker run -it --name vm1 -v /tmp/data1:/data1 -v /tmp/data2:/data2:ro busybox

/ # ls

bin data1 data2 dev etc home proc root sys tmp usr var

/ # cd data1/

/data1 # ls

/data1 # touch file1

/data1 # ls

file1

/data1 # cd ../data2/

/data2 # touch file2

touch: file2: Read-only file system

/data2 # [root@server1 ~]#

[root@server1 ~]# cd /tmp/data1/

[root@server1 data1]# ls

file1

[root@server1 data1]# cd ../data2/

[root@server1 data2]# ls

[root@server1 data2]#

挂载文件

[root@server1 ~]# docker run -it --name vm2 -v /etc/yum.repos.d/docker-ce.repo:/etc/yum.repos.d/docker-ce.repo busybox

/ # cd /etc/yum.repos.d/

/etc/yum.repos.d # ls

docker-ce.repo

/etc/yum.repos.d # cat docker-ce.repo

[docker-ce-stable]

name=Docker CE Stable - $basearch

baseurl=https://mirrors.aliyun.com/docker-ce/linux/centos/7/$basearch/stable

enabled=1

gpgcheck=0

gpgkey=https://mirrors.aliyun.com/docker-ce/linux/centos/gpg

/etc/yum.repos.d #

6. docker managed volume数据卷

docker history registry:latest

IMAGE CREATED CREATED BY SIZE COMMENT

708bc6af7e5e 2 months ago /bin/sh -c #(nop) CMD ["/etc/docker/registr… 0B

<missing> 2 months ago /bin/sh -c #(nop) ENTRYPOINT ["/entrypoint.… 0B

<missing> 2 months ago /bin/sh -c #(nop) COPY file:507caa54f88c1f38… 155B

<missing> 2 months ago /bin/sh -c #(nop) EXPOSE 5000 0B

<missing> 2 months ago /bin/sh -c #(nop) VOLUME [/var/lib/registry] 0B

<missing> 2 months ago /bin/sh -c #(nop) COPY file:4544cc1555469403… 295B

<missing> 2 months ago /bin/sh -c #(nop) COPY file:21256ff7df5369f7… 20.1MB

有这个才可以

[root@server1 ~]# docker run -d --name vm1 registry:latest

c0278876a231498825a6fbff5d3310e30367c5f108a3d6004f251f9dc4c92d60

[root@server1 ~]# docker volume ls

DRIVER VOLUME NAME

local b91dda342e54706f75ca6fb497b72d49de4459f62d651af52b2c7749ce28bc67

[root@server1 ~]#

[root@server1 ~]# docker inspect vm1 | grep Source

"Source": "/var/lib/docker/volumes/b91dda342e54706f75ca6fb497b72d49de4459f62d651af52b2c7749ce28bc67/_data",

[root@server1 ~]# cd /var/lib/docker/volumes/b91dda342e54706f75ca6fb497b72d49de4459f62d651af52b2c7749ce28bc67/_data

[root@server1 _data]# ls

[root@server1 _data]#

source就是volume在host中的目录,是docker自动为容器生成的目录,如果挂载时指向的已有目录,原有数据会被复制到volume中。

注意,即使删除容器,管理卷也不会删除。

我们会发现,docker自动生成的目录名称会很长,不方便书写使用。我们可以在创建容器时自己定义目录名称。

(1)首先,需要先创建卷

docker volume create voll ##创建卷voll

(2)接下来,创建新的容器并将管理卷voll挂载到容器内的指定目录

7. Docker卷插件(plugins)

如果想实现跨主机的容器之间的数据共享就要使用卷插件

使用了卷插件才可以使用网络文件系统实现数据共享

docker 卷默认使用的是local类型的驱动,只能存在宿主机

docker 卷默认使用的是local类型的驱动,只能存在宿主机

跨主机的volume就需要使用第三方的驱动,可以查看一链接

https://docs.docker.com/engine/extend/legacy_plugins/#volume-plugins

docker官方只提供了卷插件的api,开发者可以根据实际需求定制卷插件驱动

Docker Plugin 是以Web Service的服务运行在每一台Docker Host上的,通过HTTP协议传输RPC风格的JSON数据完成通信

Plugin的启动和停止,并不归Docker管理,Docker Daemon依靠在缺省路径下查找Unix Socket文件,自动发现可用的插件

当客户端与Daemon交互,使用插件创建数据卷时,Daemon会在后端找到插件对应的 socket 文件

建立连接并发起相应的API请求,最终结合Daemon自身的处理完成客户端的请求

convoy卷插件

convoy卷插件

convoy卷插件支持三种运行方式:devicemapper、NFS、EBS。,我们下面的实验以nfs的运行方式来演示

实验前提:准备两台主机server1、server2,并安装好Dokcer服务

(1)首先在server1和server2上搭建nfs文件系统

server1:

[root@server1 ~]# yum install -y nfs-utils 安装

[root@server1 ~]# systemctl start rpcbind

[root@server1 ~]# mkdir /mnt/nfs 创建共享目录

[root@server1 ~]# chmod 777 /mnt/nfs 修改共享目录权限

[root@server1 ~]# vim /etc/exports 编辑共享目录文件,否则将不会被共享出去

[root@server1 ~]# cat /etc/exports

/mnt/nfs *(rw,no_root_squash)

[root@server1 ~]# systemctl start nfs

rpcbind服务必须是开启的。

这是因为:他是一个RPC服务,主要是在nfs共享时候负责通知客户端,服务器的nfs端口号的。

简单理解rpc就是一个中介服务。

server2:

[root@server2 ~]# yum install -y nfs-utils

[root@server2 ~]# systemctl start nfs-server.service

[root@server2 ~]# showmount -e 172.25.6.1

Export list for 172.25.6.1:

/mnt/nfs *

[root@server2 ~]# mkdir /mnt/nfs

[root@server2 ~]#

[root@server2 ~]# mount 172.25.6.1:/mnt/nfs/ /mnt/nfs/

[root@server2 ~]# df

Filesystem 1K-blocks Used Available Use% Mounted on

/dev/mapper/rhel-root 6486016 1751120 4734896 27% /

devtmpfs 497244 0 497244 0% /dev

tmpfs 508264 0 508264 0% /dev/shm

tmpfs 508264 13108 495156 3% /run

tmpfs 508264 0 508264 0% /sys/fs/cgroup

/dev/sda1 1038336 141700 896636 14% /boot

tmpfs 101656 0 101656 0% /run/user/0

172.25.6.1:/mnt/nfs 6486016 2886912 3599104 45% /mnt/nfs

测试:

[root@server2 ~]# cd /mnt/nfs/

[root@server2 nfs]# touch file

[root@server2 nfs]# ls

file

[root@server1 ~]# cd /mnt/nfs/

[root@server1 nfs]# ls

file

可以看出nfs实现了数据共享

(2)配置convoy环境

docker官方只提供了卷插件的api,开发者可以根据实际需求定制卷插件驱动。

[root@server1 ~]# tar zxf convoy.tar.gz

[root@server1 ~]# cd convoy/

[root@server1 convoy]# ls

convoy convoy-pdata_tools SHA1SUMS

[root@server1 convoy]# cp convoy* /usr/local/bin/ ##将二进制文件加入到PATH路径

[root@server1 convoy]# mkdir /etc/docker/plugins ##创建docker的插件目录

[root@server1 ~]# convoy daemon --drivers vfs --driver-opts vfs.path=/mnt/nfs &> /dev/null &

[1] 8677

##第一次运行上面的convoy daemon命令的时候,会在/mnt/nfs目录下生成一个config文件夹,这个文件夹不要删除,不然客户端的convoy命令就会用不了

[root@server1 ~]# cd /mnt/nfs/

[root@server1 nfs]# ls

config file

[root@server1 nfs]# echo "unix:///var/run/convoy/convoy.sock" > /etc/docker/plugins/convoy.spec

##将convoy守护进程开启生成的.sock文件放入/etc/docker/plugins目录下的convoy.spec文件中,docker就可以识别。(其中convoy.spec文件之前是不存在的)

[root@server1 nfs]# cat /etc/docker/plugins/convoy.spec

unix:///var/run/convoy/convoy.sock

(3)创建卷

[root@server1 nfs]# docker volume ls

DRIVER VOLUME NAME

[root@server1 nfs]# convoy create voll

voll

[root@server1 nfs]#

[root@server1 nfs]# ll

total 0

drwx------ 2 root root 34 Jul 4 19:19 config

-rw-r--r-- 1 root root 0 Jul 4 19:11 file

drwx------ 2 root root 6 Jul 4 19:19 voll

(4)将解压convoy目录给server2复制一份,配置convoy环境

[root@server1 ~]# scp -r convoy server2:

root@server2's password:

convoy-pdata_tools 100% 22MB 22.0MB/s 00:00

convoy 100% 19MB 19.5MB/s 00:00

SHA1SUMS 100% 124 0.1KB/s 00:00

[root@server1 ~]#

[root@server2 ~]# cd convoy/

[root@server2 convoy]# cp convoy* /usr/local/bin/

[root@server2 convoy]# mkdir /etc/docker/plugins

[root@server2 convoy]# echo "unix:///var/run/convoy/convoy.sock" > /etc/docker/plugins/convoy.spec

[root@server2 convoy]# convoy daemon --drivers vfs --driver-opts vfs.path=/mnt/nfs &> /dev/null &

[1] 2851

[root@server2 convoy]# cd /mnt/nfs/

[root@server2 nfs]# ls

config file voll

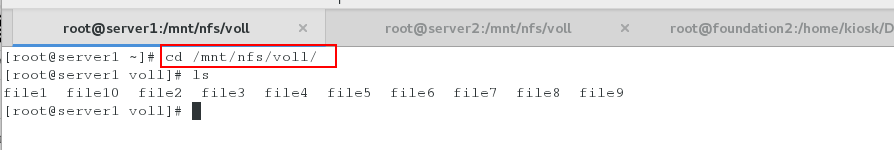

(5)操作卷

使用卷

由上可知server1和server2上看到的内容一致,即不同主机间实现了共享存储。

由上可知server1和server2上看到的内容一致,即不同主机间实现了共享存储。

731

731

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?