一 搭载hadoop环境

步骤一:安装 Hadoop 软件 安装命令如下,将安装包解压到/usr/local/src/目录下

[root@master ~]# tar -zxvf /opt/software/hadoop-2.7.1.tar.gz -C /usr/local/src/

[root@master ~]# ll /usr/local/src/

总用量 0 drwxr-xr-x. 9 10021 10021 149 6月 29 2015 hadoop-2.7.1

drwxr-xr-x. 8 10 143 255 9月 14 2017 jdk1.8.0_152

查看 Hadoop 目录,得知 Hadoop 目录内容如下:

[root@master ~]# ll /usr/local/src/hadoop-2.7.1/ 总用量 28

drwxr-xr-x. 2 10021 10021 194 6月 29 2015 bin

drwxr-xr-x. 3 10021 10021 20 6月 29 2015 etc

drwxr-xr-x. 2 10021 10021 106 6月 29 2015 include

drwxr-xr-x. 3 10021 10021 20 6月 29 2015 lib

drwxr-xr-x. 2 10021 10021 239 6月 29 2015 libexec

-rw-r--r--. 1 10021 10021 15429 6月 29 2015 LICENSE.txt

-rw-r--r--. 1 10021 10021 101 6月 29 2015 NOTICE.txt

-rw-r--r--. 1 10021 10021 1366 6月 29 2015 README.txt

drwxr-xr-x. 2 10021 10021 4096 6月 29 2015 sbin

drwxr-xr-x. 4 10021 10021 31 6月 29 2015 share

步骤二:配置 Hadoop 环境变量 和设置 JAVA 环境变量类似,修改/etc/profile 文件。 [root@master ~]# vi /etc/profile 在文件的最后增加如下两行:

export HADOOP_HOME=/usr/local/src/hadoop-2.7.1

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

执行 source 使用设置生效: [root@master ~]# source /etc/profile

检查设置是否生效: [root@master ~]# hadoop

Usage: hadoop [--config confdir] [COMMAND | CLASSNAME]

步骤三:修改目录所有者和所有者组

[root@master ~]# chown -R hadoop:hadoop /usr/local/src/

[root@master ~]# ll /usr/local/src/

总用量 0

drwxr-xr-x. 9 hadoop hadoop 149 6月 29 2015 hadoop-2.7.1

drwxr-xr-x. 8 hadoop hadoop 255 9月 14 2017 jdk1.8.0_152

步骤四:配置 Hadoop 配置文件

[root@master ~]# cd /usr/local/src/hadoop-2.7.1/

[root@master hadoop-2.7.1]# vi etc/hadoop/hadoop-env.sh 在文件中查找 export JAVA_HOME 这行,将其改为如下所示内容:

export JAVA_HOME=/usr/local/src/jdk1.8.0_152

步骤五:切换到 hadoop 用户 使用 hadoop 这个用户来运行 Hadoop 软件。

[root@master hadoop-2.7.1]# su - hadoop

步骤六: 创建输入数据存放目录 将输入数据存放在~/input 目录(hadoop 用户主目录下的 input 目录中)。

[hadoop@master ~]$ mkdir ~/input

步骤七 创建数据输入文件,测试 MapReduce 运行

[hadoop@master ~]$ hadoop jar /usr/local/src/hadoop2.7.1/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.1.jar wordcount ~/input/data.txt ~/output

[hadoop@master ~]$ vi input/data.txt 输入如下内容,保存退出。

Hello World

Hello Hadoop

Hello Husan

[hadoop@master ~]$ hadoop jar /usr/local/src/hadoop2.7.1/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.1.jar wordcount ~/input/data.txt ~/output

[hadoop@master ~]$ ll output/

总用量 4

-rw-r--r--. 1 hadoop hadoop 33 11月 10 23:50 part-r-00000

-rw-r--r--. 1 hadoop hadoop 0 11月 10 23:50 _SUCCESS #为success则为处理成功

[hadoop@master ~]$ cat output/part-r-00000

Hadoop1

Hello 3

Husan 1

World 1

二 Hadoop平台环境配置

修改 slave1 机器主机名

[root@localhost ~]# hostnamectl set-hostname slave1

[root@localhost ~]# bash

[root@slave1 ~]#

修改 slave2 机器主机名

[root@localhost ~]# hostnamectl set-hostname slave2

[root@localhost ~]# bash

[root@slave2 ~]#

设置ip

master 设置 IP 地址是“192.168.137.132”,掩码是“255.255.255.0”; slave1 设置 IP 地址“192.168.137.131”,掩码是“255.255.255.0”; slave2 设置 IP 地址是“192.168.137.130”,掩码是“255.255.255.0”。#根据自己想法设置ip即可。

在三台主机上分别修改主机配置文件“/etc/hosts”

[root@master ~]# vi /etc/hosts

127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4 ::1 localhost localhost.localdomain localhost6 localhost6.localdomain6

192.168.137.132 master

192.168.137.131 slave1

192.168.137.130 slave2

[root@slave1 ~]# vi /etc/hosts 127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4 ::1 localhost localhost.localdomain localhost6 localhost6.localdomain6

192.168.137.132 master

192.168.137.131 slave1

192.168.137.130 slave2

[root@slave2 ~]# vi /etc/hosts 127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4 28 ::1 localhost localhost.localdomain localhost6 localhost6.localdomain6

192.168.137.132 master

192.168.137.131 slave1

192.168.137.130 slave2

三 设置无密钥登录

步骤一:每个节点安装和启动 SSH 协议

[root@master ~]# rpm -qa | grep openssh

openssh-server-7.4p1-11.el7.x86_64 openssh-7.4p1-11.el7.x86_64

openssh-clients-7.4p1-11.el7.x86_64

[root@master ~]# rpm -qa | grep rsync

rsync-3.1.2-11.el7_9.x86_64

步骤二:三台都切换到 hadoop 用户

步骤三:每个节点生成秘钥对

[hadoop@master ~]$ ssh-keygen -t rsa #slave1、slave2同master

步骤四:查看"/home/hadoop/"下是否有".ssh"文件夹,且".ssh"文件下是否有两个刚 生产的无密码密钥对

[hadoop@master ~]$ ls ~/.ssh/

id_rsa id_rsa.pub

步骤五:将 id_rsa.pub 追加到授权 key 文件中

[hadoop@master ~]$ cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

[hadoop@master ~]$ ls ~/.ssh/

authorized_keys id_rsa id_rsa.pub #slave1、slave2同master

步骤六:修改文件"authorized_keys"权限

#master

[hadoop@master ~]$ chmod 600 ~/.ssh/authorized_keys

然后用ll查看

[hadoop@master ~]$ ll ~/.ssh/

总用量 12

-rw-------. 1 hadoop hadoop 395 11月 14 16:18 authorized_keys

-rw-------. 1 hadoop hadoop 1679 11月 14 16:14 id_rsa

-rw-r--r--. 1 hadoop hadoop 395 11月 14 16:14 id_rsa.pub #slave1,slave2 同上

步骤七:配置 SSH 服务

使用 root 用户登录,修改 SSH 配置文件"/etc/ssh/sshd_config"的下列内容,需要将该配 置字段前面的#号删除

[root@master ~]# vi /etc/ssh/sshd_config

PubkeyAuthentication yes #找到此行,并把#号注释删除,slave1,slave2同上

步骤八 重启ssh服务并切换到hadoop用户登录

[root@master ~]# systemctl restart sshd

[root@master ~]# su - hadoop

步骤九:验证 SSH 登录本机

在 hadoop 用户下验证能否嵌套登录本机,若可以不输入密码登录,则本机通过密钥登录 认证成功。

[hadoop@master ~]$ ssh localhost

四 交换ssh密钥

步骤一:将 Master 节点的公钥 id_rsa.pub 复制到每个 Slave 点

hadoop 用户登录,通过 scp 命令实现密钥拷贝

[hadoop@master ~]$ scp ~/.ssh/id_rsa.pub hadoop@slave1:~/

[hadoop@master ~]$ scp ~/.ssh/id_rsa.pub hadoop@slave2:~/

步骤二:在每个 Slave 节点把 Master 节点复制的公钥复制到authorized_keys 文件

hadoop 用户登录 slave1 和 slave2 节点,执行命令

[hadoop@slave1 ~]$ cat ~/id_rsa.pub >>~/.ssh/authorized_keys

[hadoop@slave2 ~]$ cat ~/id_rsa.pub >>~/.ssh/authorized_keys

步骤三:在每个 Slave 节点删除 id_rsa.pub 文件

[hadoop@slave1 ~]$ rm -rf ~/id_rsa.pub

[hadoop@slave2 ~]$ rm -rf ~/id_rsa.pub

步骤四:将每个 Slave 节点的公钥保存到 Master

(1)将 Slave1 节点的公钥复制到 Master

[hadoop@slave1 ~]$ scp ~/.ssh/id_rsa.pub hadoop@master:~/

(2)在 Master 节点把从 Slave 节点复制的公钥复制到 authorized_keys 文件

[hadoop@master ~]$ cat ~/id_rsa.pub >>~/.ssh/authorized_keys

(3)在 Master 节点删除 id_rsa.pub 文件

[hadoop@master ~]$ rm -rf ~/id_rsa.pub

(4)slave2 同上

五 验证ssh无密码登录

步骤一:查看 Master 节点 authorized_keys 文件

[hadoop@master ~]$ cat ~/.ssh/authorized_keys

步骤二:查看 Slave 节点 authorized_keys 文件

[hadoop@slave1 ~]$ cat ~/.ssh/authorized_keys

[hadoop@slave2 ~]$ cat ~/.ssh/authorized_keys

步骤三:验证 Master 到每个 Slave 节点无密码登录

hadoop 用户登录 master 节点,执行 SSH 命令登录 slave1 和 slave2 节点。可以观察 到不需要输入密码即可实现 SSH 登录

[hadoop@master ~]$ ssh slave1

Last login: Mon Nov 14 16:34:56 2022

[hadoop@slave1 ~]$ #登录slave2同上

步骤四:验证两个 Slave 节点到 Master 节点无密码登录

[hadoop@slave1 ~]$ ssh master

Last login: Mon Nov 14 16:30:45 2022 from ::1

[hadoop@master ~]$ #从slave2登录master同上

步骤五:配置两个子节点slave1、slave2的JDK环境

[root@master ~]# cd /usr/local/src/

[root@master src]# ls hadoop-2.7.1 jdk1.8.0_152

[root@master src]# scp -r jdk1.8.0_152 root@slave1:/usr/local/src/

[root@master src]# scp -r jdk1.8.0_152 root@slave2:/usr/local/src/

#slave1

[root@slave1 ~]# ls /usr/local/src/ jdk1.8.0_152

[root@slave1 ~]# vi /etc/profile #此文件最后添加下面两行

export JAVA_HOME=/usr/local/src/jdk1.8.0_152 37

export PATH=$PATH:$JAVA_HOME/bin

[root@slave1 ~]# source /etc/profile

[root@slave1 ~]# java -version

java version "1.8.0_152"

Java(TM) SE Runtime Environment (build 1.8.0_152-b16)

Java HotSpot(TM) 64-Bit Server VM (build 25.152-b16, mixed mode)

#slave2 同上slave1 操作

六 Hadoop集群运行

一 在 Master 节点上安装 Hadoop

1. 将 hadoop-2.7.1 文件夹重命名为 Hadoop

[root@master ~]# cd /usr/local/src/

[root@master src]# mv hadoop-2.7.1 hadoop

[root@master src]# ls hadoop jdk1.8.0_152

2. 配置 Hadoop 环境变量

[root@master src]# yum install -y vim

[root@master src]# vim /etc/profile #在文件末尾加入以下内容

export JAVA_HOME=/usr/local/src/jdk1.8.0_152

export PATH=$PATH:$JAVA_HOME/bin

export HADOOP_HOME=/usr/local/src/hadoop

export PATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

3. 使配置的 Hadoop 的环境变量生效

[root@master src]# su - hadoop

上一次登录:一 2 月 28 15:55:37 CST 2022 从 192.168.41.143pts/1 上

[hadoop@master ~]$ source /etc/profile

[hadoop@master ~]$ exit 登出

4. 执行以下命令修改 hadoop-env.sh 配置文件

[root@master src]# cd /usr/local/src/hadoop/etc/hadoop/

[root@master hadoop]# vim hadoop-env.sh #修改以下配置

export JAVA_HOME=/usr/local/src/jdk1.8.0_152

二:配置 hdfs-site.xml 文件参数

[root@master hadoop]# vim hdfs-site.xml #编辑以下内容

[root@master hadoop]# tail -n 14 hdfs-site.xml

<configuration>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/src/hadoop/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/src/hadoop/dfs/data</value>

</property>

<property>

<name>dfs.replication</name>

<value>3</value>

</property>

</configuration>

三:配置 core-site.xml 文件参数

[root@master hadoop]# vim core-site.xml #编辑以下内容

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://192.168.47.140:9000</value>

</property>

<property>

<name>io.file.buffer.size</name>

<value>131072</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/usr/local/src/hadoop/tmp</value>

</property>

</configuration>

四:配置 mapred-site.xml

[root@master hadoop]# pwd

/usr/local/src/hadoop/etc/hadoop

[root@master hadoop]# cp mapred-site.xml.template mapred-site.xml

[root@master hadoop]# vim mapred-site.xml #添加以下配置

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<name>mapreduce.jobhistory.address</name>

<value>master:10020</value>

</property>

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>master:19888</value>

</property>

</configuration>

五:配置 yarn-site.xml

[root@master hadoop]# vim yarn-site.xml #添加以下配置

<configuration>

<!-- Site specific YARN configuration properties -->

<property>

<name>yarn.resourcemanager.address</name>

<value>master:8032</value>

</property>

<property>

<name>yarn.resourcemanager.scheduler.address</name>

<value>master:8030</value>

</property>

<property>

<name>yarn.resourcemanager.resource-tracker.address</name>

<value>master:8031</value>

</property>

<property>

<name>yarn.resourcemanager.admin.address</name>

<value>master:8033</value>

</property>

<property>

<name>yarn.resourcemanager.webapp.address</name>

<value>master:8088</value>

</property>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.auxservices.mapreduce.shuffle.class</name>

<value>org.apache.hadoop.mapred.ShuffleHandler</value>

</property>

</configuration>

六:Hadoop 其他相关配置

1. 配置 masters 文件

[root@master hadoop]# vim masters

[root@master hadoop]# cat masters

192.168.47.140

2. 配置 slaves 文件

[root@master hadoop]# vim slaves

[root@master hadoop]# cat slaves

192.168.47.141

192.168.47.142

3. 新建目录

[root@master hadoop]# mkdir /usr/local/src/hadoop/tmp

[root@master hadoop]# mkdir /usr/local/src/hadoop/dfs/name -p

[root@master hadoop]# mkdir /usr/local/src/hadoop/dfs/data -p

4. 修改目录权限

[root@master hadoop]# chown -R hadoop:hadoop /usr/local/src/hadoop/

5. 同步配置文件到 Slave 节点

[root@master ~]# scp -r /usr/local/src/hadoop/ root@slave1:/usr/local/src/

[root@master ~]# scp -r /usr/local/src/hadoop/ root@slave2:/usr/local/src/

#slave1 配置

[root@slave1 ~]# yum install -y vim

[root@slave1 ~]# vim /etc/profile #在最后添加以下内容

export JAVA_HOME=/usr/local/src/jdk1.8.0_152

export PATH=$PATH:$JAVA_HOME/bin

export HADOOP_HOME=/usr/local/src/hadoop

export PATH=$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

[root@slave1 ~]# chown -R hadoop:hadoop /usr/local/src/hadoop/

[root@slave1 ~]# su - hadoop

上一次登录:四 2 月 24 11:29:00 CST 2022 从 192.168.41.148pts/1 上

[hadoop@slave1 ~]$ source /etc/profile

# slave2 同slave1操作

七 配置Hadoop格式化

步骤一:NameNode 格式化

执行如下命令,格式化 NameNode

[root@master ~]# su – hadoop

[hadoop@master ~]# cd /usr/local/src/hadoop/

[hadoop@master hadoop]$ bin/hdfs namenode –format

步骤二:启动 NameNode

执行如下命令,启动 NameNode:

[hadoop@master hadoop]$ hadoop-daemon.sh start namenode

starting namenode, logging to /opt/module/hadoop2.7.1/logs/hadoop-hadoop-namenode-master.out

[hadoop@master hadoop]$ jps

3557 NameNode

3624 Jps

步骤三 slave节点 启动 DataNode

执行如下命令,启动 DataNode:

[hadoop@slave1 hadoop]$ hadoop-daemon.sh start datanode

starting datanode, logging to /opt/module/hadoop2.7.1/logs/hadoop-hadoop-datanode-master.out

[hadoop@slave2 hadoop]$ hadoop-daemon.sh start datanode

starting datanode, logging to /opt/module/hadoop2.7.1/logs/hadoop-hadoop-datanode-master.out

[hadoop@slave1 hadoop]$ jps

3557 DataNode

3725 Jps

[hadoop@slave2 hadoop]$ jps

3557 DataNode

3725 Jps

步骤四 启动 SecondaryNameNode

执行如下命令,启动 SecondaryNameNode:

[hadoop@master hadoop]$ hadoop-daemon.sh start secondarynamenode

starting secondarynamenode, logging to /opt/module/hadoop2.7.1/logs/hadoop-hadoop-secondarynamenode-master.out

[hadoop@master hadoop]$ jps

34257 NameNode

34449 SecondaryNameNode

34494 Jps

**查看到有 NameNode 和 SecondaryNameNode 两个进程,就表明 HDFS 启动成

功

步骤五 查看 HDFS 数据存放位置:

执行如下命令,查看 Hadoop 工作目录:

[hadoop@master hadoop]$ ll dfs/

总用量 0

drwx------ 3 hadoop hadoop 21 8 月 14 15:26 data

drwxr-xr-x 3 hadoop hadoop 40 8 月 14 14:57 name

[hadoop@master hadoop]$ ll ./tmp/dfs

总用量 0

drwxrwxr-x. 3 hadoop hadoop 21 5 月 2 16:34 namesecondary

步骤六 查看HDFS的报告

[hadoop@master sbin]$ hdfs dfsadmin -report

Configured Capacity: 8202977280 (7.64 GB)

Present Capacity: 4421812224 (4.12 GB)

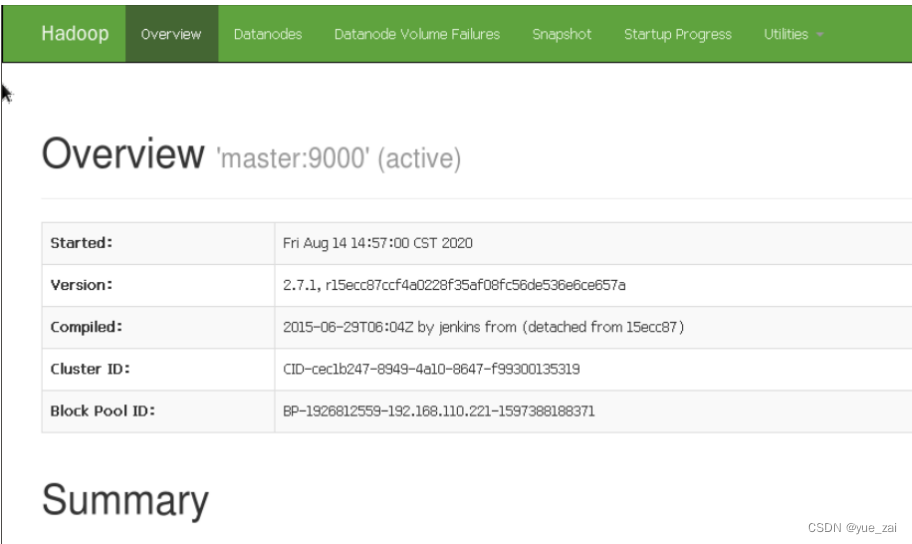

使用浏览器查看节点状态

在浏览器的地址栏输入http://master:50070,进入页面可以查看NameNode和DataNode 信息

在浏览器的地址栏输入 http://master:50090,进入页面可以查看 SecondaryNameNode信息

可以使用 start-dfs.sh 命令启动 HDFS。这时需要配置 SSH 免密码登录,否则在 启动过程中系统将多次要求确认连接和输入 Hadoop 用户密码

[hadoop@master hadoop]$ stop-dfs.sh

[hadoop@master hadoop]$ start-dfs.sh

一:在 HDFS 文件系统中创建数据输入目录

确保 dfs 和 yarn 都启动成功

[hadoop@master hadoop]$ start-yarn.sh

[hadoop@master hadoop]$ jps

34257 NameNode

34449 SecondaryNameNode

34494 Jps

32847 ResourceManager

如果是第一次运行 MapReduce 程序,需要先在 HDFS 文件系统中创建数据输入目

录,存放输入数据。这里指定/input 目录为输入数据的存放目录。 执行如下命

令,在 HDFS 文件系统中创建/input 目录:

[hadoop@master hadoop]$ hdfs dfs -mkdir /input

[hadoop@master hadoop]$ hdfs dfs -ls /

Found 1 items

drwxr-xr-x - hadoop supergroup 0 2020-05-02 22:26

/input

此处创建的/input 目录是在 HDFS 文件系统中,只能用 HDFS 命令查看和操作

二:将输入数据文件复制到 HDFS 的/input 目录中

测试用数据文件仍然是上一节所用的测试数据文件~/input/data.txt,内容如下所示。

[hadoop@master hadoop]$ cat ~/input/data.txt

Hello World

Hello Hadoop

Hello Huasan

执行如下命令,将输入数据文件复制到 HDFS 的/input 目录中:

[hadoop@master hadoop]$ hdfs dfs -put ~/input/data.txt /input

确认文件已复制到 HDFS 的/input 目录:

[hadoop@master hadoop]$ hdfs dfs -ls /input

Found 1 items

-rw-r--r-- 1 hadoop supergroup 38 2020-05-02 22:32

/input/data.txt

如果不是第一次运行MapReduce,就要先查看HDFS中的文件,是否存在/output目录。如果已经存在/output目录,就要先删除/output目录,再执行上述命令。自动创建的/output 目录在 HDFS 文件系统中,使用 HDFS 命令查看和操作。

[hadoop@master hadoop]$ hdfs dfs -mkdir /output

先执行如下命令查看 HDFS 中的文件:

[hadoop@master hadoop]$ hdfs dfs -ls /

Found 3 items

drwxr-xr-x - hadoop supergroup 0 2020-05-02 22:32

/input

drwxr-xr-x - hadoop supergroup 0 2020-05-02 22:49

/output

上述目录中/input 目录是输入数据存放的目录,/output 目录是输出数据存放的目录。执

行如下命令,删除/output 目录。

[hadoop@master hadoop]$ hdfs dfs -rm -r -f /output

20/05/03 09:43:43 INFO fs.TrashPolicyDefault: Namenode trash

configuration: Deletion interval = 0 minutes, Emptier interval = 0 minutes. Deleted

/output

执行如下命令运行 WordCount 案例:

[hadoop@master hadoop]$ hadoop jar share/hadoop/mapreduce/hado

mapreduce op-- -examples-2.7.1.jar wordcount /input/data.txt /output

MapReduce 程序运行过程中的输出信息如下所示:

20/05/02 22:39:41 INFO client.RMProxy: Connecting to

ResourceManager at localhost/127.0.0.1:8032

20/05/02 22:39:43 INFO input.FileInputFormat: Total input paths

to process : 1

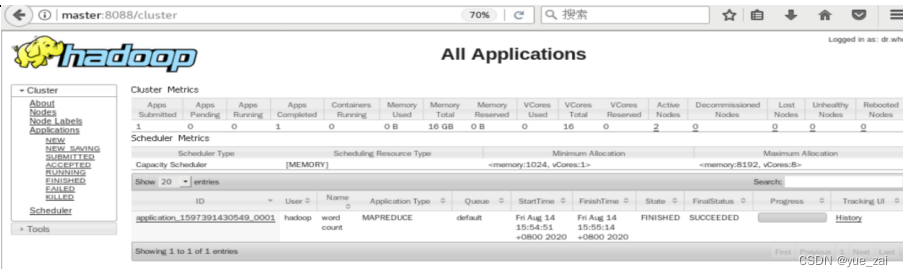

在浏 览器的地址栏输入:http://master:8088

在浏览器的地址栏输入 http://master:50070

使用 HDFS 命令直接查看 part-r-00000 文件内容,结果如下所示:

[hadoop@master hadoop]$ hdfs dfs -cat /output/part-r-00000

Hadoop 1

Hello 3

Huasan 1

World 1

可以看出统计结果正确,说明 Hadoop 运行正常

76

76

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?