[1] Liang W, Zhang W. Learning Social Relations and Spatiotemporal Trajectories for Next Check-in Inference[J]. IEEE Transactions on Neural Networks and Learning Systems, 2020.

摘要

位置感知社交网络(LSNs)的普及促进了用户移动建模和签到预测的研究,从而有利于各种下游应用,如精准营销和城市管理。现有的研究大多只关注签到的空间方面,而时空方面的联合推断更符合实际的应用场景。此外,虽然在推荐系统中对社交关系进行了广泛的研究,但在下一次签到位置预测方面的研究却很少,还有进一步改进的空间。在本文中,我们研究了next check-in的推理问题,该问题要求对目标用户(who)的下一个签到位置(where)和时间(when)进行联合推断。我们设计了一个将基于注意的递归神经点过程与图注意力网络相结合的ARNPP-GAT模型。ARNPP-GAT的核心技术是将用户长期表示学习、短期行为建模和时间点过程集成到一个统一的架构中。具体来说,ARNPP-GAT首先利用图注意力网络,通过对用户的社交关系进行编码来了解用户的长期表现。更重要的是,ARNPP赋予模型以特征过去签到事件的影响和执行多任务学习的能力,以产生下一个签到时间和位置的预测。在两个真实的数据集上的实证结果表明,ARNPP-GAT优于其他方法,验证了多任务学习和社交关系建模的贡献。

关键字

- Check-in prediction

- deep recurrent modeling

- graph attention networks,

- multitask learning,

- temporal point process (TPP)

II 相关工作

A.Next Check-in Inference

a.传统的方式:隐因子模型(不足:它假设下一个签到地点仅取决于最近访问的一些位置,与实际不符)

b.利用RNN模型预测下一个签到位置,如DeepMove、CARA等(特点:把每个轨迹作为一个整体送入模型;不足:忽略了check-in prediction是一个多任务学习问题,包括check-in time和check-in location)

c.签到时间研究 2018Yang等人第一次做了签到时间预测

本文主要对RMTPP模型(适用于多任务问题)进行改进

B.Point Process 和 注意力机制

a.点过程是一个随机过程,主要用于时间事件序列的建模。

本文在Liu等人研究的神经Hawkes过程模型(深度学习+点过程)的基础上加入了注意力机制

b.注意力机制用来选择文本、图像等中的重要部分

本文利用一个简单的基于注意力的方法自动地量化用户过去的签到事件对下一个签到事件发生的影响

C.图神经网络GNN(Graph Neural Network)

a. GNN被证明是学习图数据的最先进的方法。它们擅长将节点表示与边一起传播,并使用当前节点及其邻居的表示的组合更新节点表示。

b. 图卷积网络(GCN)和图注意网络(GAT)是GNN的代表性的类型。(Graph convolutional networks (GCNs) 、graph attention networks (GATs))

- GCN通过使用现有的边的权值来量化邻居的不同贡献,在每个卷积中相等地聚合邻居的嵌入。

- GAT利用注意力机制来学习边的权重和特征化贡献。

本文利用GATs来表征社交链接的关系强度,这提供了更多的信息来学习用户的长期表示

IV. COMPUTATIONAL APPROACH 计算方法(模型构建部分)

- 输入:user ID, user social graph, location ID, time interval (hours), and timestamp (hours in a week)

- 输出:推断出的下一个check-in的time和location

A. User Short-Term Behavior Modeling

建立3个字典,每一个都包含valid timestamps, location IDs, and user IDs

每一个timestamp或ID都能够转化为one-hot向量(之后输入嵌入层)

Vl: 位置表示对应的稠密向量

Vt: the dense vectors of time representation

用GRU建模表示用户短期行为

B. User Long-Term Representation Learning

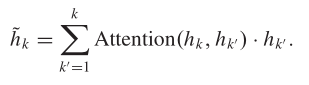

通过多层GAT学习用户长期表示

(捕获用户直接邻居和distant邻居的信息)

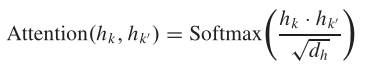

为了区分各个社交边的相对重要性,使GAT能够动态地决定边地权重,采用多头自注意力机制(Multihead self-attention mechanism)。最终获得用户长期向量表示Vu*

C. Multitask Prediction Module

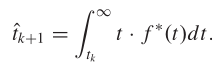

1) 签到时间预测:

因为不同时间发生的签到对整个用户轨迹的表示和未来的签到有着不同的影响

所以提出了量化过去签到对现在签到的影响的注意力计算

然后获得预测下一签到时间的条件强度函数->深度点过程的完整表达式->获得预测的下一次签到的时间点

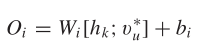

2) 签到地点预测:

通过一个全连接层和一个softmax层,将最大元素对应的地点选择为预测的下一次签到的地点

然后对其做softmax操作

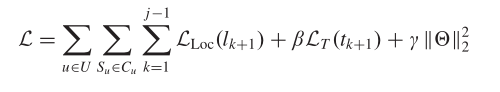

D. Multitask Training

总的损失函数

整个架构采用端到端方式的反向传播进行训练(The whole framework is trained using backpropagation in an end-to-end fashion.)

V. 实验

A. Data Sets

Gowalla、Foursquare

B. 评价标准

评估预测地点:召回率(Recall)和平均倒数秩(MRR) —越大越好

评估预测时间:均方差(MSE) —越小越好

C. Baseline

……

D. 超参数设置

E. 方法比较

分别比较了预测地点和预测时间两个方面的性能

F. 消融实验(Ablation Study)

比如你提出了某某结构,但是要想确定这个结构是否有利于最终的效果,则比较去掉该结构的网络与加上该结构的网络所得到的结果

G. 超参数结果分析

VI. Conclusion

本文从多任务学习的角度讨论了下一个check-in的位置和时间预测。提出了一种新颖的模式ARNPP-GAT, 它是RMTPP的自然的拓展: 1)引入用户表示从GATs表示用户短期偏好2)提出一个attention-based方法明确捕获过去的check-in对未来的check-in的影响。在两个真实数据集上的综合实验表明,在所有采用的方法中,ARNPP-GAT在这两种任务上都优于其他方法,并证明了模整个框架中主要模块的重要性(采用了消融实验)。

3081

3081

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?