本文手把手教你如何在本地环境快速部署DeepSeek开源大模型,并搭配VS Code实现高效开发调试。无需云端资源,利用本地GPU/CPU即可运行AI模型,适合开发者进行二次开发、学术研究及本地化AI应用搭建。

1.下载Ollama

1.1 方式1:Ollama官网下载:Ollama(这里可能会遇到权限问题)

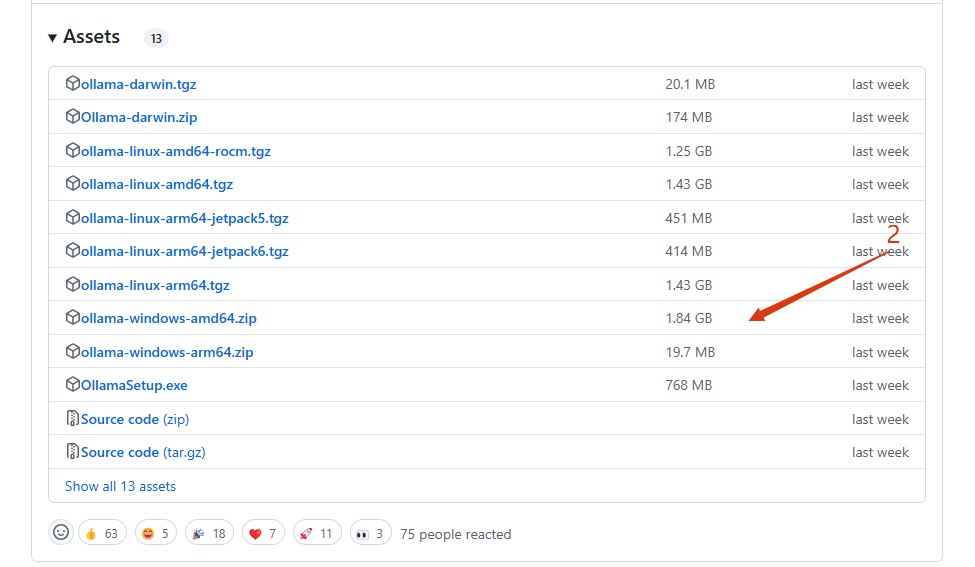

1.2 方式2:官方 GitHub 源代码仓库:https://github.com/ollama/ollama/

- 进入github官网选择Releases

- 直接选择.exe的安装包

1.3 鉴于很多朋友无法直接下载ollama,这里给大家整理好了ollama的安装包,关注wx公众号“是成同学”免费领取即可↓↓↓↓

2.安装Ollama

提供两种安装方式

- 通过命令安装(可以手动修改安装位置,推荐)

- 通过鼠标双击安装(不能修改安装目录位置,默认在C盘,不推荐)

2.1 方式1

- 使用CMD命令行窗口,定位到OllamaSetup.exe所在目录(假设

OllamaSetup.exe在E:\Users\zheng\Downloads目录下),然后执行如下命令:

上述命令中DIR的值为D:\Program_Files\Ollama,该值就是你想要安装的目录位置。

- 执行上述命令后,会弹出

OllamaSetup.exe安装窗体界面,此时我们点击Install按钮等待安装完成即可,如下图所示

2.2 方式2

我们直接双击安装包,然后点击Install按钮等待安装完成即可。(默认安装在C盘)

3.Ollama安装验证

上述步骤完成后,我们可以打开CMD,输入ollama命令,如果出现如下图所示的内容就代表Ollama安装成功了

4.修改大模型存储位置

默认存储在C盘

- 进入系统的环境变量

- 在用户变量中点击

新建按钮,变量名为OLLAMA_MODELS,变量值为D:\Program Files (x86)\Ollama\Models,其中的变量值就是大模型下载存储的目录位置,最后点击确定即可,如下图所示:

5.下载Deepseek

同样我们打开Ollama官网,点击顶部的Models链接,选择deepseek-r1模型,如下图所示:

根据电脑硬件条件选择不同的属性,这里我选择的是8b

显卡要求

然后复制所选命令,打开CMD命令,注意这里需定位到步骤4修改的大模型存储位置(D:\Program Files (x86)\Ollama\Models,否则默认在C盘)。粘贴ollama run deepseek-r1:8b到新打开的命令窗口并等待其下载完成,当出现如下界面则安装成功。

在DeepSeek下载完成后,我们就可以在CMD中输入内容进行对话了,如输入:你好,如下图所示

此时,恭喜你的电脑拥有了顶级的推理能力!

6. 将deepseek部署到VS Code

- 打开VS Code,在插件商店搜索continue,并安装

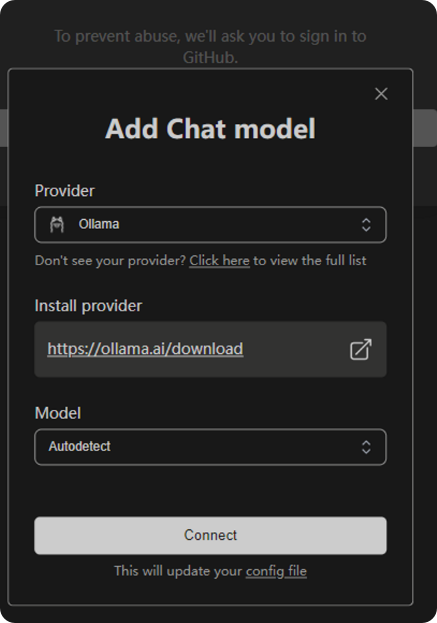

- 点击右侧图标,添加新的大语言模型

- 选择Ollama,模型不用动,电脑会自动检测有什么模型

- 一切准备就绪,此时将网络关闭,并在continue中添加一个对话窗口,让他任意写一个代码,AI会自动生成

6122

6122

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?