hadoop的HDFS文件管理系统,是为处理大文件而量身定做的,但是,在hadoop的使用过程中,难免会产生大量的小文件,首先明确概念,这里的小文件是指小于HDFS系统Block大小的文件(默认64M),如果使用HDFS存储大量的小文件,将会是一场灾难,这取决于HDFS的实现机制和框架结构,每一个存储在HDFS中的文件、目录和块映射为一个对象存储在NameNode服务器内存中,通常占用150个字节。如果有1千万个文件,就需要消耗大约3G的内存空间。如果是10亿个文件呢,简直不可想象。这里需要特别说明的是,每一个小于Block大小的文件,存储是实际占用的存储空间仍然是实际的文件大小,而不是整个block大小。

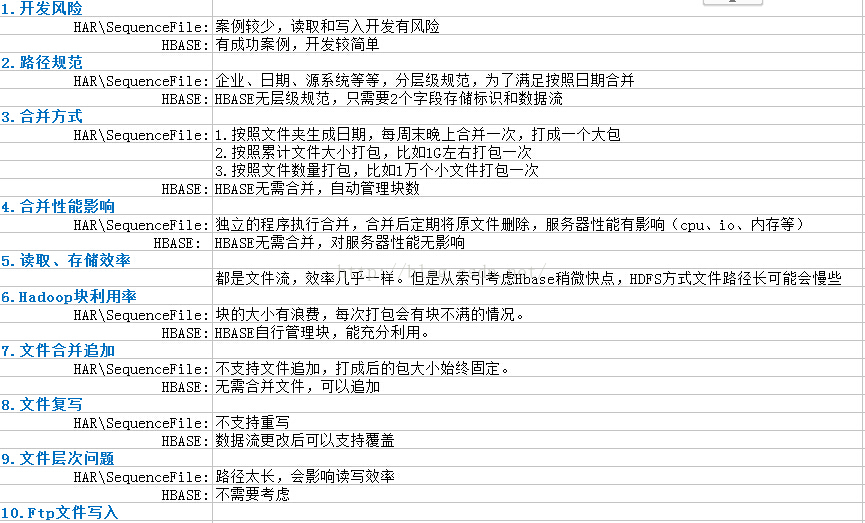

为解决小文件的存储Hadoop自身提供了两种机制来解决相关的问题,包括HAR和SequeueFile,这两种方式在某些方面解决了本层面的问题,单仍然存在着各自的不足。我们在进行多次的测试实现后最终觉得Hbase合并小文件更为靠谱些,下面我们拿三个方案进行了对比

对比中不难发现Hbase还是有很大的优势的,无论是开发还是运维,都将给我们带来极大的便利;

那么,下边就涉及开发的问题了,

下面是我们的hadoop节点配置:

<?xml version="1.0" encoding="UTF-8"?>

<!--Autogenerated by Cloudera Manager-->

<configuration>

<property>

<name>fs.hdfs.impl</name>

<value>org.apache.hadoop.hdfs.DistributedFileSystem</value>

<description>The FileSystem for hdfs: uris.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://nameservice1</value>

</property>

<property>

<name>fs.trash.interval</name>

<value>1</value>

</property>

<property>

<name>net.topology.script.file.name</name>

<value>/etc/hadoop/conf.cloudera.yarn/topology.py</value>

</property>

<property>

<name>io.compression.codecs</name>

<value>org.apache.hadoop.io.compress.DefaultCodec,org.apache.hadoop.io.compress.GzipCodec,org.apache.hadoop.io.compress.BZip2Codec,org.apache.hadoop.io.compress.DeflateCodec,org.apache.hadoop.io.compress.SnappyCodec,org.apache.hadoop.io.compress.Lz4Codec</value>

</property>

<property>

<name>io.file.buffer.size</name>

<value>65536</value>

</property>

<property>

<name>hadoop.security.authentication</name>

<value>simple</value>

</property>

<property>

<name>hadoop.rpc.protection</name>

<value>authentication</value>

</property>

<property>

<name>hadoop.security.auth_to_local</name>

<value>DEFAULT</value>

</property>

</configuration>

#文件的临时�录

path=d:/file/

#path=/home/bms/file/

#hdfs地址

hdfsPath=/file

hdfilePath=/file

#Hadoop master??

hbaseMaster=10.246.14<span style="font-family:宋体;">x.xxx</span>:60000

#??Hadoop??

hbaseZookeeperQuorum=10.246.1xx.xxx,10.246.14x.xxx,10.246.14x.xxx,10.246.14x.xxx

hbaseZookeeperPropertyClientPort=2181

corePath=

solrFileUrl=http\://yk2pdsglxxxx:8983/solr/collection2_shard1_replica1/

solrUrl=http\://yk2pdsglxxxx\:8983/solr/collection1_shard1_replica1/

#solrFileUrl=http\://yk2pdsxxxxxx\:8983/solr/collection2_shard1_replica1/

tableName=HADOOP_TEST

HDFS配置:

<?xml version="1.0" encoding="UTF-8"?>

<!--Autogenerated by Cloudera Manager-->

<configuration>

<property>

本文探讨了Hadoop HDFS在处理大量小文件时的挑战,并比较了HAR、SequenceFile和Hbase三种解决方案。通过测试,发现Hbase在合并小文件方面更具优势,因为它在开发和运维上提供了更多便利。文中还提及了HDFS的相关配置,并暗示将详细介绍如何利用Hbase进行小文件合并的开发过程。

本文探讨了Hadoop HDFS在处理大量小文件时的挑战,并比较了HAR、SequenceFile和Hbase三种解决方案。通过测试,发现Hbase在合并小文件方面更具优势,因为它在开发和运维上提供了更多便利。文中还提及了HDFS的相关配置,并暗示将详细介绍如何利用Hbase进行小文件合并的开发过程。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1041

1041

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?