Linux网卡的绑定,bond的七种模式

什么是bonding需要从网卡的混杂(promisc)模式说起。我们知道,在正常情况下,网卡只接收目的硬件地址(MAC Address)是自身Mac的以太网帧,对于别的数据都滤掉,以减轻驱动程序的负担。但是网卡也支持另外一种被称为混杂promisc的模式,可以接收网络上所有的,比如说tcpdump,就是运行在这个模式下.bonding也运行在这个模式下,而且修改了驱动程序中的mac地址,将两块网卡的 Mac地址改成相同可以接收特定mac的数据帧。然后把相应的数据帧传送给bond驱动程序处理。

bond0(balance-rr)轮询

表示负载分担round-robin,并且是轮询的方式比如第一个包走eth0,第二个包走eth1,直到数据包发送完毕。

优点:流量提高一倍

缺点:需要接入交换机做端口聚合,否则可能无法使用

特点:增加了带宽,同时支持容错能力,当有链路出问题,会把流量切换到正常的链路上。

bond1(active-backup)主备模式

一个端口处于主状态 ,一个处于从状态,所有流量都在主链路上处理,从不会有任何流量。当主端口down掉时,从端口接手主状态。

优点:冗余性高

缺点:链路利用率低,两块网卡只有1块在工作

不需要交换机端支持

bond2(balance-xor)平衡策略

该模式将限定流量,以保证到达特定对端的流量总是从同一个接口上发出。既然目的地是通过MAC地址来决定的,因此该模式在“本地”网络配置下可以工作得很好。如果所有流量是通过单个路由器(比如 “网关”型网络配置,只有一个网关时,源和目标mac都固定了,那么这个算法算出的线路就一直是同一条,那么这种模式就没有多少意义了。),那该模式就不是最好的选择。和balance-rr一样,交换机端口需要能配置为“port channel”。这模式是通过源和目标mac做hash因子来做xor算法来选路的

需要交换机配置聚合口

此模式提供负载平衡和容错能力

bond3(broadcast)(广播策略)

这种模式的特点是一个报文会复制两份往bond下的两个接口分别发送出去,当有对端交换机失效,我们感觉不到任何downtime,但此法过于浪费资源;不过这种模式有很好的容错机制。此模式适用于金融行业,因为他们需要高可靠性的网络,不允许出现任何问题

bond4(802.3ad)(IEEE 802.3ad 动态链接聚合

表示支持802.3ad协议,和交换机的聚合LACP方式配合(需要xmit_hash_policy).标准要求所有设备在聚合操作时,要在同样的速率和双工模式,而且,和除了balance-rr模式外的其它bonding负载均衡模式一样,任何连接都不能使用多于一个接口的带宽。

特点:创建一个聚合组,它们共享同样的速率和双工设定。根据802.3ad规范将多个slave工作在同一个激活的聚合体下。外出流量的slave选举是基于传输hash策略,该策略可以通过xmit_hash_policy选项从缺省的XOR策略改变到其他策略。需要注意的是,并不是所有的传输策略都是802.3ad适应的,尤其考虑到在802.3ad标准43.2.4章节提及的包乱序问题。不同的实现可能会有不同的适应性

必要条件:

• 条件1:ethtool支持获取每个slave的速率和双工设定

• 条件2:switch(交换机)支持IEEE802.3ad Dynamic link aggregation

• 条件3:大多数switch(交换机)需要经过特定配置才能支持802.3ad模式

bond5(balance-tlb)(适配器传输负载均衡)

是根据每个slave的负载情况选择slave进行发送,接收时使用当前轮到的slave。该模式要求slave接口的网络设备驱动有某种ethtool支持;而且ARP监控不可用。

特点:不需要任何特别的switch(交换机)支持的通道bonding。在每个slave上根据当前的负载(根据速度计算)分配外出流量。如果正在接受数据的slave出故障了,另一个slave接管失败的slave的MAC地址。

必要条件:

• ethtool支持获取每个slave的速率

bond6(balance-alb)(适配器适应性负载均衡)

在5的tlb基础上增加了rlb(接收负载均衡receiveload balance).不需要任何switch(交换机)的支持。接收负载均衡是通过ARP协商实现的.

特点:该模式包含了balance-tlb模式,同时加上针对IPV4流量的接收负载均衡(receiveload balance, rlb),而且不需要任何switch(交换机)的支持。接收负载均衡是通过ARP协商实现的。bonding驱动截获本机发送的ARP应答,并把源硬件地址改写为bond中某个slave的唯一硬件地址,从而使得不同的对端使用不同的硬件地址进行通信。来自服务器端的接收流量也会被均衡

bond0,bond2和bond3理论上需要静态聚合方式。

bond4需要支持802.3ad。

bond5和bond6不需要交换机端的设置,网卡能自动聚合。

双网卡绑定的配置

nmcli con add type bond con-name bond0 ifname bond0

nmcli con add type ethernet slave-type bond con-name bond0-port1 ifname ens32 master bond0

nmcli con add type ethernet slave-type bond con-name bond0-port2 ifname ens34 master bond0

nmcli con modify bond0 ipv4.addresses 192.168.1.100/24

nmcli con modify bond0 ipv4.gateway 192.168.1.1

nmcli con modify bond0 ipv4.dns 192.168.1.1

nmcli con modify bond0 ipv4.dns-search XXXX.com

nmcli con modify bond0 ipv4.method manual

nmcli con up bond0

此次实验根据实际需求配置信息如下:

环境:redhat8.6

主机双网卡IP:192.168.40.131 192.168.40.132

绑定后虚IP:192.168.40.3

网关:192.168.40.2

DNS:192.1668.40.2

nmcli con add type bond con-name bond0 ifname bond0

nmcli con add type ethernet slave-type bond con-name bond0-port1 ifname ens224 master bond0

nmcli con add type ethernet slave-type bond con-name bond0-port2 ifname ens160 master bond0

nmcli con modify bond0 ipv4.addresses 192.168.40.3/24

nmcli con modify bond0 ipv4.gateway 192.168.40.2

nmcli con modify bond0 ipv4.dns 192.168.40.2

nmcli con up bond0

除了用命令行配置也可以在配置文件里配置参数,配置文件的具体位置在:/etc/sysconfig/network-scritpts/

cd /etc/sysconfig/network-scritpts/

nmcli con add type bond con-name bond0 ifname bond0命令执行后在 /etc/sysconfig/network-scritpts/目录生成了一个ifcfg-bond0文件

nmcli con add type ethernet slave-type bond con-name bond0-port1 ifname ens32 master bond0 命令执行后了一生成个ifcfg-bond0-port1文件

nmcli con add type ethernet slave-type bond con-name bond0-port2 ifname ens32 master bond0 命令执行后就生成了一个ifcfg-bond0-port2文件

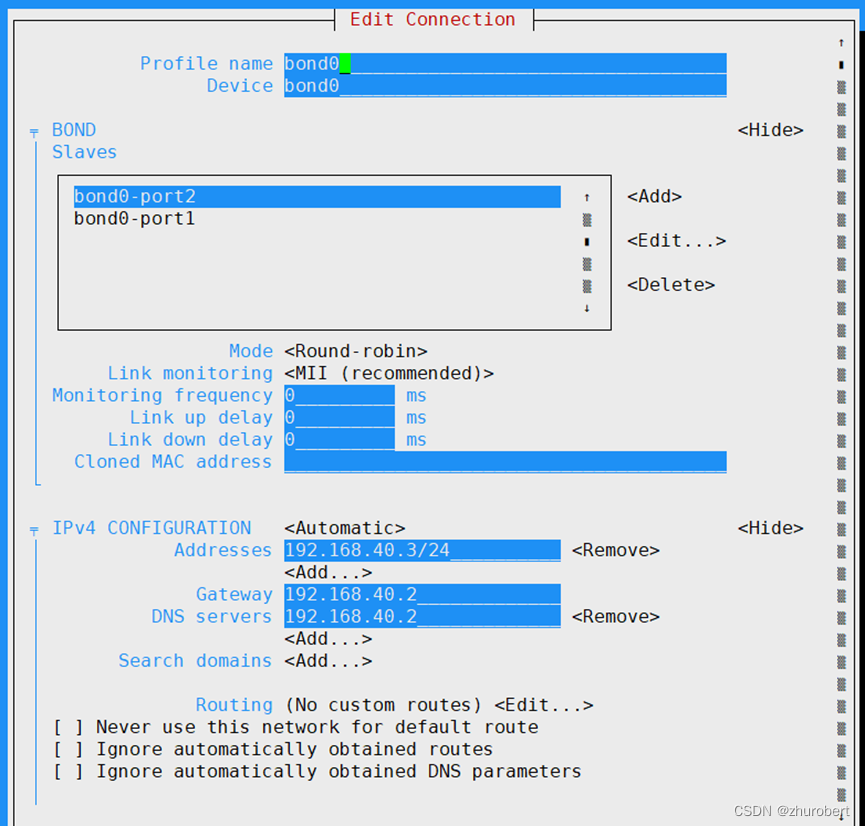

当然了您也可以对这些文件进行vim编辑,效果是一样的,和配置网卡一样,所谓条条大路通罗马。甚至可以使用nmtui 伪图形化界面也可以配置,如下图所示,这里不再累述。

577

577

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?