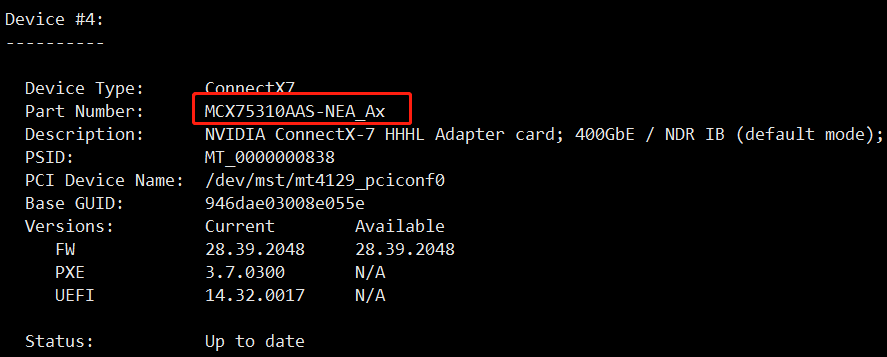

最近新上的H800、L40S等设备配备的是CX7的网卡,目前我们使用的是两种型号的网卡,定义相应的FW版本标准为:28.39.2048

相应的型号为:

单口:MCX75310AAS-NEAT

双口:MCX755106AS-HEAT

使用lspci可以看到具体型号:

使用mlxfwmanager命令查看

升级方案:

在官网下载固件,然后进行烧录升级固件

固件下载地址:Firmware for ConnectX®-7 InfiniBand | NVIDIA

升级方法:

#!/bin/bash

cd /root

wget https://content.mellanox.com/firmware/fw-ConnectX7-rel-28_39_2048-MCX75310AAS-NEA_Ax-UEFI-14.32.17-FlexBoot-3.7.300.signed.bin.zip

if [ -f "/root/fw-ConnectX7-rel-28_39_2048-MCX75310AAS-NEA_Ax-UEFI-14.32.17-FlexBoot-3.7.300.signed.bin.zip" ];then

unzip /root/fw-ConnectX7-rel-28_39_2048-MCX75310AAS-NEA_Ax-UEFI-14.32.17-FlexBoot-3.7.300.signed.bin.zip

fi

mst start

ib_devices=`mlxfwmanager |grep -A5 "MCX75310AAS-NEA_Ax"|grep "PCI Device Name"|awk '{print $NF}'`

for i in $ib_devices

do

flint -i fw-ConnectX7-rel-28_39_2048-MCX75310AAS-NEA_Ax-UEFI-14.32.17-FlexBoot-3.7.300.signed.bin -d $i burn

done

#!/bin/bash

cd /root

#wget https://content.mellanox.com/firmware/fw-ConnectX7-rel-28_39_2048-MCX75310AAS-NEA_Ax-UEFI-14.32.17-FlexBoot-3.7.300.signed.bin.zip

wget https://www.mellanox.com/downloads/firmware/fw-ConnectX7-rel-28_39_2048-MCX755106AS-HEA_Ax-UEFI-14.32.17-FlexBoot-3.7.300.signed.bin.zip

if [ -f "/root/fw-ConnectX7-rel-28_39_2048-MCX755106AS-HEA_Ax-UEFI-14.32.17-FlexBoot-3.7.300.signed.bin.zip" ];then

unzip /root/fw-ConnectX7-rel-28_39_2048-MCX755106AS-HEA_Ax-UEFI-14.32.17-FlexBoot-3.7.300.signed.bin.zip

fi

mst start

ib_devices=`mlxfwmanager |grep -A5 "MCX755106AS-HEA_Ax"|grep "PCI Device Name"|awk '{print $NF}'`

for i in $ib_devices

do

flint -i fw-ConnectX7-rel-28_39_2048-MCX755106AS-HEA_Ax-UEFI-14.32.17-FlexBoot-3.7.300.signed.bin -d $i burn

done

根据对应的网卡设备,执行脚本升级。

升级之后,需要根据提示执行mlxfwreset重置网卡或者reboot重启设备生效。

但是实际上,遇到一些设备reboot无法使新的固件生效,需要将设备机型断电重启生效。

系统下执行ipmitool power cycle可以生效

2194

2194

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?