练习pytorch,记录自己的理解,好记性不如烂笔头!

第一步:生成数据集:

num_inputs = 2

num_examples = 1000

true_w = [2, -3.4]

true_b = 4.2

features = torch.tensor(np.random.normal(0, 1, (num_examples, num_inputs)), dtype=torch.float)

labels = true_w[0] * features[:, 0] + true_w[1] * features[:, 1] + true_b

labels += torch.tensor(np.random.normal(0, 0.01, size=labels.size()), dtype=torch.float)这里的代码就是生成数据,长这个样子

features是一个tensor,它有1000行,每行有2列

labels:也是一个tensor,不要看他这么多,它其实就是1000个数,对应features的一千行

直观图:

第二步:读取数据

import torch.utils.data as Data

batch_size = 10

# 将训练数据的特征和标签组合

dataset = Data.TensorDataset(features, labels)

# 随机读取小批量

data_iter = Data.DataLoader(dataset, batch_size, shuffle=True):看一下dataset:<torch.utils.data.dataset.TensorDataset at 0x1cb82700a90>

他是一个对象,指向了一个内存地址。它将我们刚才生成的features和labels组合在一起,主要是用来当作dataloader的读取数据的参数。

再来看一下data_iter:<torch.utils.data.dataloader.DataLoader at 0x1cb82700ac8>

它也是一个对象,没有显示的数据,我们主要用它来读取数据。

来看看怎么使用它:

for X, y in data_iter:

print(X, y)

break

输出了两个Tensor,它的样子是这样的:截取了batch_size大小的tensor(10)

第三步:定义模型

class LinearNet(nn.Module):

def __init__(self, n_feature):

super(LinearNet, self).__init__()

self.linear = nn.Linear(n_feature, 1)

# forward 定义前向传播

def forward(self, x):

y = self.linear(x)

return y

net = LinearNet(num_inputs)

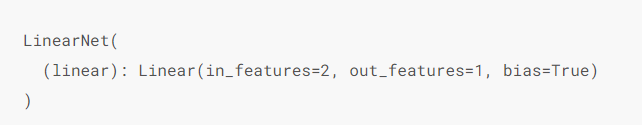

print(net) # 使用print可以打印出网络的结构

很简单的结构,输入两个特征,输出一个特征。

可以通过net.parameters()来查看模型所有的可学习参数,此函数将返回一个生成器。

for param in net.parameters():

print(param)

输出:

Parameter containing:

tensor([[-0.0277, 0.2771]], requires_grad=True)

Parameter containing:

tensor([0.3395], requires_grad=True)

这里的参数是随机初始化的,我们在后面可以修改初始化参数。

第四步:初始化模型参数

在使用net前,我们需要初始化模型参数,如线性回归模型中的权重和偏差。均值为0、标准差为0.01的正态分布。偏差会初始化为零。

这里这么设置其实也是随机,深度学习称为调参运动就是因为初始化的参数会影响最终的结果,而最好的初始化参数没有一个很好的确定方法。

from torch.nn import init

init.normal_(net.linear.weight, mean=0, std=0.01)

init.constant_(net.linear.bias, val=0)

第五步:定义损失函数

loss = nn.MSELoss()这里的损失函数用来计算损失,梯度下降法需要下降的东西就是它。

第六步:定义优化算法

这里的优化算法就是优化参数,就是优化我们上面定义的初始化参数。

import torch.optim as optim

optimizer = optim.SGD(net.parameters(), lr=0.03)

print(optimizer)

输出:

SGD (

Parameter Group 0

dampening: 0

lr: 0.03

momentum: 0

nesterov: False

weight_decay: 0

)第七步:训练模型

num_epochs = 3

for epoch in range(1, num_epochs + 1):

for X, y in data_iter:

# 使用模型,输入参数,得到输出结果

output = net(X)

# 使用损失函数计算出损失

l = loss(output, y.view(-1, 1))

optimizer.zero_grad() # 梯度清零,等价于net.zero_grad()

# 反向传播

l.backward()

# 优化参数

optimizer.step()

print('epoch %d, loss: %f' % (epoch, l.item()))

输出:

epoch 1, loss: 0.000457

epoch 2, loss: 0.000081

epoch 3, loss: 0.000198

下面我们分别比较学到的模型参数和真实的模型参数。我们从net获得需要的层,并访问其权重(weight)和偏差(bias)。学到的参数和真实的参数很接近。

dense = net[0]

print(true_w, dense.weight)

print(true_b, dense.bias)

[2, -3.4] tensor([[ 1.9999, -3.4005]])

4.2 tensor([4.2011])

原文链接:https://tangshusen.me/Dive-into-DL-PyTorch/#/chapter03_DL-basics/3.3_linear-regression-pytorch

239

239

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?