卷积神经网络(CNN)是一种专为处理网格数据(如图像、视频、语音)设计的深度学习模型。它在计算机视觉、自然语言处理等领域取得了革命性成果。以下是其核心概念、原理、组成和典型模型的详细介绍:

一、CNN 的核心概念

1. 生物视觉启发

CNN 的设计灵感来源于人脑视觉皮层的工作机制:局部感受野和权值共享。

局部感受野:单个神经元仅对局部区域的刺激响应。

权值共享:同一特征(如边缘、纹理)在不同位置的检测使用相同参数。

2. 核心优势

参数共享:减少参数量,防止过拟合。

局部连接:仅关注局部区域,保留空间信息。

平移不变性:同一特征在不同位置的检测结果一致。

二、CNN 的核心原理

1. 局部感知(Local Connectivity)

卷积核在输入数据上滑动,每次仅处理局部区域。

例如:一个 3×3 的卷积核扫描图像,提取边缘、角点等局部特征。

2. 权值共享(Weight Sharing)

同一卷积核在整个输入上共享参数,大幅减少计算量。

例如:检测“水平边缘”的卷积核在所有位置使用相同参数。

3. 空间下采样(Spatial Downsampling)

通过池化层(如最大池化)降低特征图尺寸,增强模型鲁棒性。

4. 特征层级递进

浅层网络提取低级特征(边缘、颜色),深层网络提取高级特征(物体部件、整体结构)。

三、CNN 的核心组成

1. 输入层(Input Layer)

接收原始数据(如图像的像素矩阵),通常需标准化处理。

2. 卷积层(Convolution Layer)

功能:提取局部特征。

核心参数:

卷积核(Filter):权值矩阵(如 3×3、5×5)。

步长(Stride):卷积核滑动的步距。

填充(Padding):在输入边缘补零,保持输出尺寸。

输出:特征图(Feature Map)。

3. 激活函数(Activation Function)

引入非线性,增强模型表达能力。

常用函数:ReLU(修正线性单元)、Sigmoid、Leaky ReLU。

4. 池化层(Pooling Layer)

功能:降维、防止过拟合、增强平移不变性。

类型:

最大池化(Max Pooling):取局部区域最大值。

平均池化(Average Pooling):取局部区域平均值。

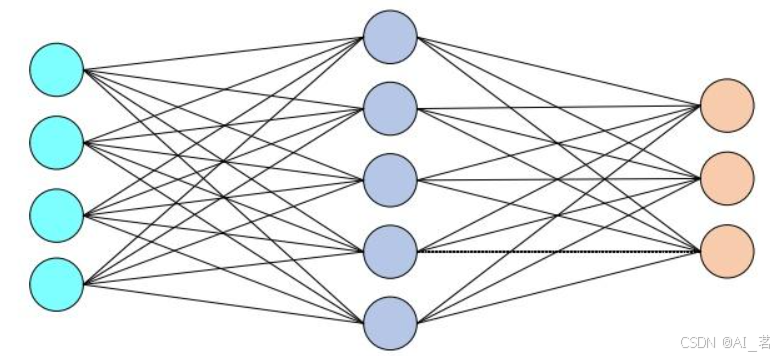

5. 全连接层(Fully Connected Layer)

功能:整合全局特征,输出分类或回归结果。

通常位于网络末端,连接所有神经元。

6. 输出层(Output Layer)

根据任务选择激活函数:

分类任务:Softmax(多分类)、Sigmoid(二分类)。

回归任务:线性激活。

四、典型卷积神经网络

1. LeNet-5(1998)

贡献:首个成功应用于手写数字识别的CNN。

结构:2 卷积层 + 2 池化层 + 3 全连接层。

特点:使用 Sigmoid 激活函数和平均池化。

2. AlexNet(2012)

贡献:在 ImageNet 竞赛中击败传统方法,开启深度学习时代。

结构:5 卷积层 + 3 全连接层。

创新:ReLU 激活函数、Dropout、数据增强、GPU 并行训练。

3. VGGNet(2014)

贡献:证明网络深度对性能的重要性。

结构:16-19 层(VGG16/VGG19),全部使用 3×3 卷积核。

特点:简单统一的模块化设计。

4. GoogLeNet(2014)

贡献:提出 Inception 模块,提升计算效率。

结构:22 层,包含多尺度并行卷积(1×1、3×3、5×5 卷积核)。

创新:1×1 卷积降维、全局平均池化。

5. ResNet(2015)

贡献:通过残差连接(Residual Block)解决梯度消失问题。

结构:可扩展至 1000+ 层(如 ResNet-152)。

创新:跳跃连接(Shortcut Connection),恒等映射。

五、总结

CNN 通过局部连接、权值共享和层级特征提取,成为处理图像等网格数据的核心工具。经典模型(如 ResNet、Inception)通过模块化设计和残差学习不断突破性能极限。实际应用中,需根据任务需求选择合适结构,并结合数据增强、正则化等技术优化模型。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?