欢迎转载,但请务必注明原文出处及作者信息。

@author: huangyongye

@creat_date: 2017-03-09

前言: 根据我本人学习 TensorFlow 实现 LSTM 的经历,发现网上虽然也有不少教程,其中很多都是根据官方给出的例子,用多层 LSTM 来实现 PTBModel 语言模型,比如:

tensorflow笔记:多层LSTM代码分析

但是感觉这些例子还是太复杂了,所以这里写了个比较简单的版本,虽然不优雅,但是还是比较容易理解。

如果你想了解 LSTM 的原理的话(前提是你已经理解了普通 RNN 的原理),可以参考我前面翻译的博客:

(译)理解 LSTM 网络 (Understanding LSTM Networks by colah)

如果你想了解 RNN 原理的话,可以参考 AK 的博客:

The Unreasonable Effectiveness of Recurrent Neural Networks

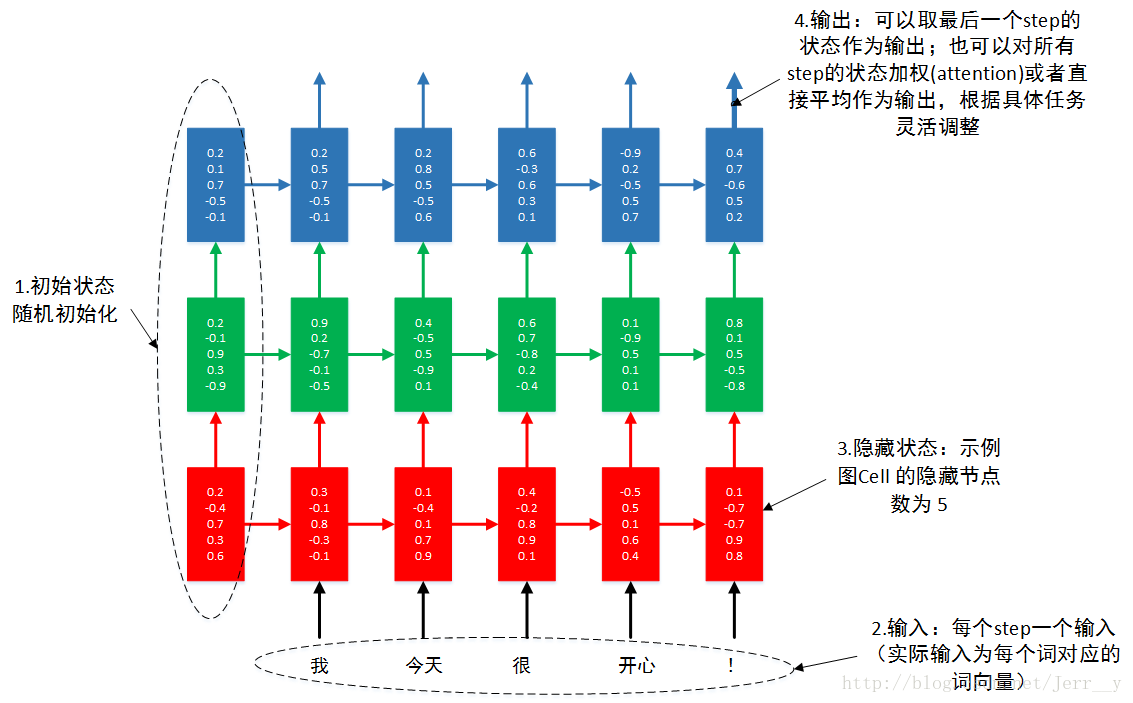

很多朋友提到多层怎么理解,所以自己做了一个示意图,希望帮助初学者更好地理解 多层RNN.

图1 3层RNN按时间步展开

本例不讲原理。通过本例,你可以了解到单层 LSTM 的实现,多层 LSTM 的实现。输入输出数据的格式。 RNN 的 dropout layer 的实现。

# -*- coding:utf-8 -*-

import tensorflow as tf

import numpy as np

from tensorflow.contrib import rnn

from tensorflow.examples.tutorials.mnist import input_data

# 设置 GPU 按需增长

config = tf.ConfigProto()

config.gpu_options.allow_growth = True

sess = tf.Session(config=config)

# 首先导入数据,看一下数据的形式

mnist = input_data.read_data_sets('MNIST_data', one_hot=True)

print mnist.train.images.shapeExtracting MNIST_data/train-images-idx3-ubyte.gz

Extracting MNIST_data/train-labels-idx1-ubyte.gz

Extracting MNIST_data/t10k-images-idx3-ubyte.gz

Extracting MNIST_data/t10k-labels-idx1-ubyte.gz

(55000, 784)

1. 首先设置好模型用到的各个超参数

lr = 1e-3

# 在训练和测试的时候,我们想用不同的 batch_size.所以采用占位符的方式

batch_size = tf.placeholder(tf.int32) # 注意类型必须为 tf.int32

# 在 1.0 版本以后请使用 :

# keep_prob = tf.placeholder(tf.float32, [])

# batch_size = tf.placeholder(tf.int32, [])

# 每个时刻的输入特征是28维的,就是每个时刻输入一行,一行有 28 个像素

input_size = 28

# 时序持续长度为28,即每做一次预测,需要先输入28行

timestep_size = 28

# 每个隐含层的节点数

hidden_size = 256

# LSTM layer 的层数

layer_num = 2

# 最后输出分类

本文提供了一个简洁的长短期记忆网络(LSTM)实现案例,用于手写数字识别任务。通过对MNIST数据集的处理,展示了如何搭建单层和多层LSTM模型,并实现了输入输出数据格式处理、Dropout层应用等关键技术点。

本文提供了一个简洁的长短期记忆网络(LSTM)实现案例,用于手写数字识别任务。通过对MNIST数据集的处理,展示了如何搭建单层和多层LSTM模型,并实现了输入输出数据格式处理、Dropout层应用等关键技术点。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

5802

5802

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?