七月在线 5月深度学习班课程笔记——No.4

这一节内容比较丰富。主要介绍神经网络的每一个层级结构,理清楚每一层可能影响结果的参数,再介绍CNN的常用框架。

1. 神经网络

1.1 神经网络——是什么?

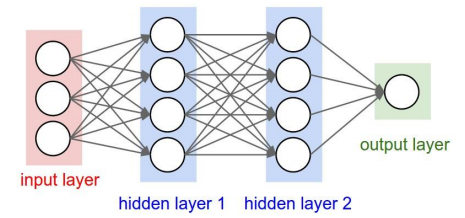

神经网络没有一个严格的正式定义。它的基本特点,是试图模仿大脑的神经元之间传递,处理信息的模式。还是有些抽象,那么看看下面这张图。

输入层和输出层之间有多个隐层hidden layer,输入层、输出层和隐层都有若干个节点。每一个节点是一个神经元,每个神经元,通过激励函数,计算处理来自其它相邻神经元的加权输入值;神经元之间的信息传递的强度,用所谓加权值来定义,算法会不断自我学习,调整这个加权值。

在逻辑回归中,我们知道回归函数中得到线性拟合 z=θ0+θ1x1+θ2x2

本文详细介绍了卷积神经网络(CNN)的层级结构,包括输入层、卷积层、ReLU激活层、池化层和全连接层,并讨论了CNN的优缺点。此外,还提及了典型的CNN模型,如LeNet、AlexNet和VGGNet,以及常用的CNN框架,如Caffe、Torch和TensorFlow。

本文详细介绍了卷积神经网络(CNN)的层级结构,包括输入层、卷积层、ReLU激活层、池化层和全连接层,并讨论了CNN的优缺点。此外,还提及了典型的CNN模型,如LeNet、AlexNet和VGGNet,以及常用的CNN框架,如Caffe、Torch和TensorFlow。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

8074

8074

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?