经过上周不懈的努力,终于把“Multi-Perspective Sentence Similarity Modeling with Convolution Neural Networks”这篇论文用tensorflow大致实现出来了,代码后续回放到我的github上面。踩了很多坑,其实现在也还有一些小的问题没有搞明白和解决,但是也算自己实现了第一个完整的Tensorflow程序,至于剩下的一些小问题,接下来慢慢边学习边解决吧。因为代码比较长,我们分为两篇来介绍,本篇主要介绍读入数据和一些功能函数。好了,接下来我们就开始介绍代码吧。

1,数据集介绍与读取

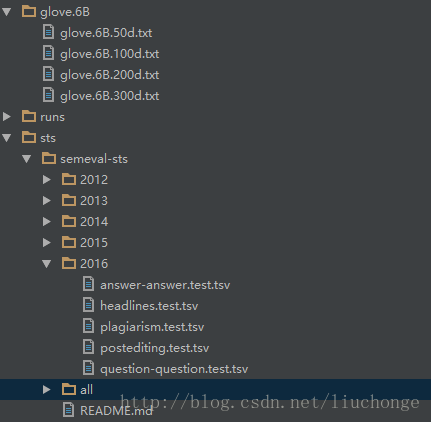

首先介绍一下数据集STS,这是一个比赛的数据集,包含有2012-2016所有年份的数据,文件中的每一行都由三元组(sentence1, sentence2, similarity)组成,也就是两个句子的相似度。每一年的数据都会有好几个文件,分别用于不同领域(比如问答系统等)。文件结构如下图所示:

其中all文件夹中包含了2012-2015之间的所有数据,我们是用all作为训练集,2016作为测试集。共有20000多条训练数据和1000多条测试数据,论文中说有10000多条训练数据,我也不知道为什么不同。但是这并不作为本文的关注点(仅以使用tensorflow实现论文提到的模型为主,至于准确率等并未考虑在内)。接下来介绍数据的读取代码,这部分代码位于data_helper.py文件中:

def load_sts(dsfile, glove):

""" 读取一个文件 """

#分别存放第一、二个句子以及他们的标签

s0 = []

s1 = []

labels = []

with codecs.open(dsfile, encoding='utf8') as f:

for line in f:

line = line.rstrip()

label, s0x, s1x = line.split('\t')

#如果是测试文件只有两个句子,而不包含其相似度分值,则不读取

if label == '':

continue

else:

#将相似性分数转化为一个六维数组(因为分数取值范围是0-6)将其转化为one-hot编码方便作为神经网络的输出

score_int = int(round(float(label)))

y = [0] * 6

y[score_int] = 1

labels.append(np.array(y))

#将两个句子进行分词,并根据word2vec转化为单词索引列表,对于不在word2vec中的单词使用UNKNOW来表示

for i, ss in enumerate([s0x, s1x]):

words = word_tokenize(ss)

index = []

for word in words:

word = word.lower()

if word

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

8736

8736

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?