最近忙着实验室的项目,一直没有时间做仿真,所以就先写一下之前看的一篇文章,总结一下吧。这次要说的是Gated CNN,这也是第一次将门限控制引入到CNN中的文章,感觉十分有新意,效果也很棒。下面我们来看一下,文章的主要贡献包括:

- 提出一种新的门控机制

- 缓解梯度传播,降低梯度弥散等现象

- 相比LSTM,模型更加简单,收敛速度更快

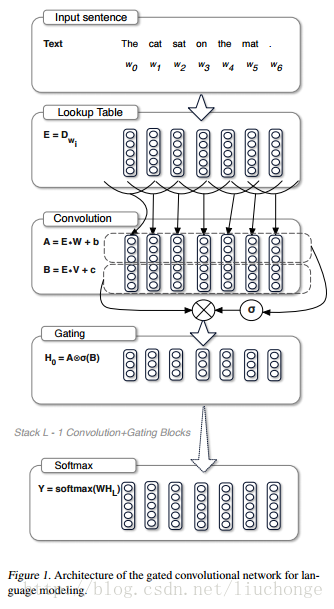

模型的结构图如下所示:

首先我们可以通过堆叠CNN来标识长文本,提取更高层、更抽象的特征,而且相比LSTM而言,我们需要的op更少(CNN需要O(N/k)个op,而LSTM将文本视为序列需要O(N)个op,其中N为文本长度,k为卷积核宽度),这样一来,我们需要的非线性操作也更少,有效地降低了梯度弥散的现象,使模型收敛和训练变得更加简单。此外,LSTM中模型下一时刻的输出依赖于前一个时刻的隐藏层状态,无法实现模型并行化。但是,CNN无需这种依赖,可以方便的实现并行化,从而实现计算速度的提升。最后,本文中提出的线性门控单元不仅有效地降低了梯度弥散,而且还保留了非线性的能力。接下来我们看一下模型的具体实现方法:

从上图可以看出,其主要结构跟原始

本文介绍了Gated CNN如何引入门控机制缓解梯度传播问题,相较于LSTM,模型更简单,收敛速度更快。通过堆叠CNN捕获长文本的高层特征,门控机制(GLU)控制信息传递,减少非线性操作,促进模型训练。实验展示了在WikiText-103和GBW数据集上的优秀效果。

本文介绍了Gated CNN如何引入门控机制缓解梯度传播问题,相较于LSTM,模型更简单,收敛速度更快。通过堆叠CNN捕获长文本的高层特征,门控机制(GLU)控制信息传递,减少非线性操作,促进模型训练。实验展示了在WikiText-103和GBW数据集上的优秀效果。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1588

1588

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?