转 : http://zongweiz.leanote.com/post/Active-Learning-%E4%B8%80%E4%B8%AA

作者 :周纵苇

下面要介绍的工作发表于CVPR2017,题为“Fine-tuning Convolutional Neural Networks for Biomedical Image Analysis: Actively and Incrementally”。它主要解决了一个深度学习中的重要问题:如何使用尽可能少的标签数据来训练一个效果promising的分类器。根据我的判断,当遇到两种情况的时候,这篇论文的可以非常强大的指导意义:

- 一共手头有100个未标记样本,和仅仅够标记10个样本的钱,老板说,通过训练这十个标记的样本,能接近甚至达到训练100个样本的performance;

- 手头有了一个已经在100个样本中训练完的分类器,现在又来了100个新标记的样本,老板说,只给提供够训练10个样本的计算机;或者只给你提供够训练10个样本的时间,让分类器尽快学习到新来样本的特征;

这两个情况发生的条件是完全不同的,Situation A发生在屌丝公司,没有钱拿到精标记的数据集,却也想做深度学习;Situation B一般发生在高富帅公司,有海量的精标记数据,但是由于目前即使是最牛逼的计算机也不能用深度学习在短时间内一次性地去处理完这些数据(e.g.,内存溢出,或者算上个几年都算不完)。

1. 为什么会想到去解决这个问题?

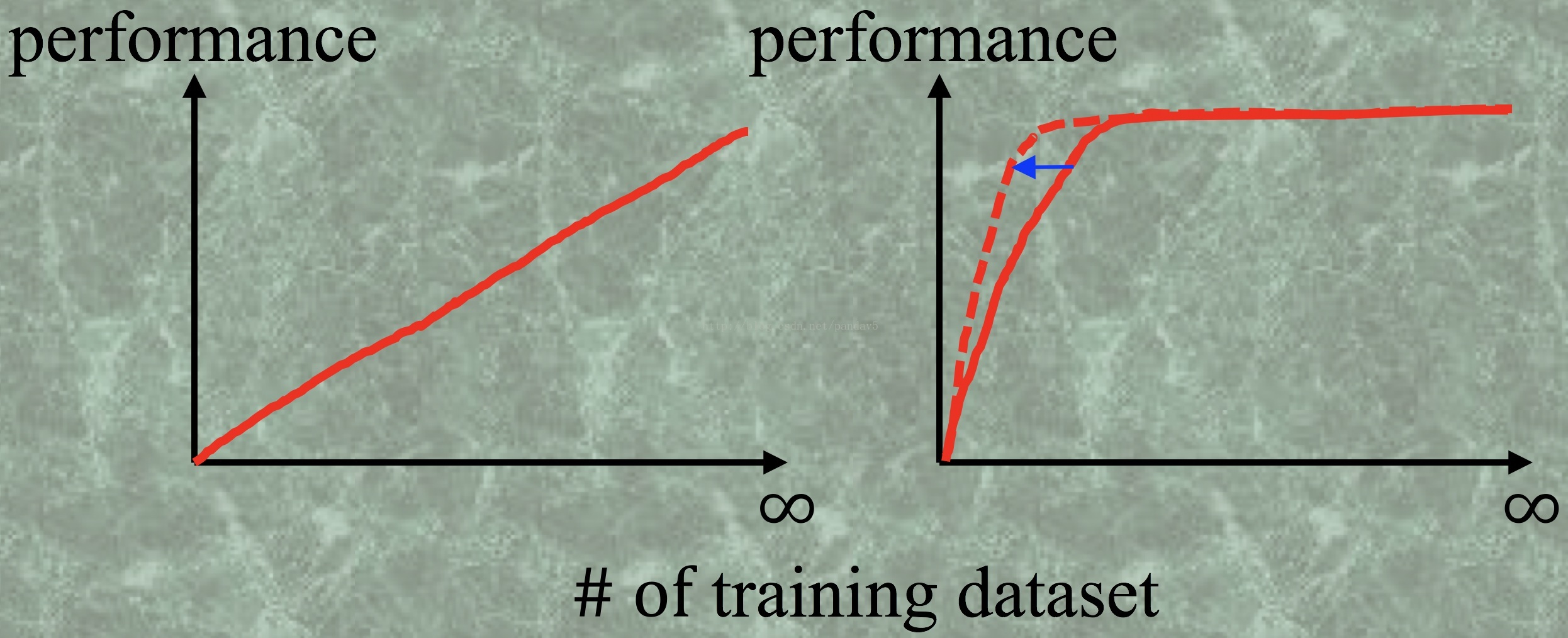

现在深度学习很火,做的人也越来越多,那么它的门槛可以说是很低的,Caffe,Keras,Torch等等框架的出现,让该领域的programming的门槛直接拆了。所以深度学习真正的门槛变成了很简单概念——钱。这个钱有两个很重要的流向,一是计算机的运算能力(GPU Power),二是标记数据的数量。这儿就引出一个很重要的问题:是不是训练数据集越多,深度学习的效果会越好呢?这个答案凭空想是想不出来的,能回答的人一定是已经拥有了海量的数据,如ImageNet,Place等等,他们可以做一系列的实验来回答这个问题。需要呈现的结果很简单,横坐标是训练集的样本数,纵坐标是分类的performance,如下图所示:

2. 如何让临界值变小?

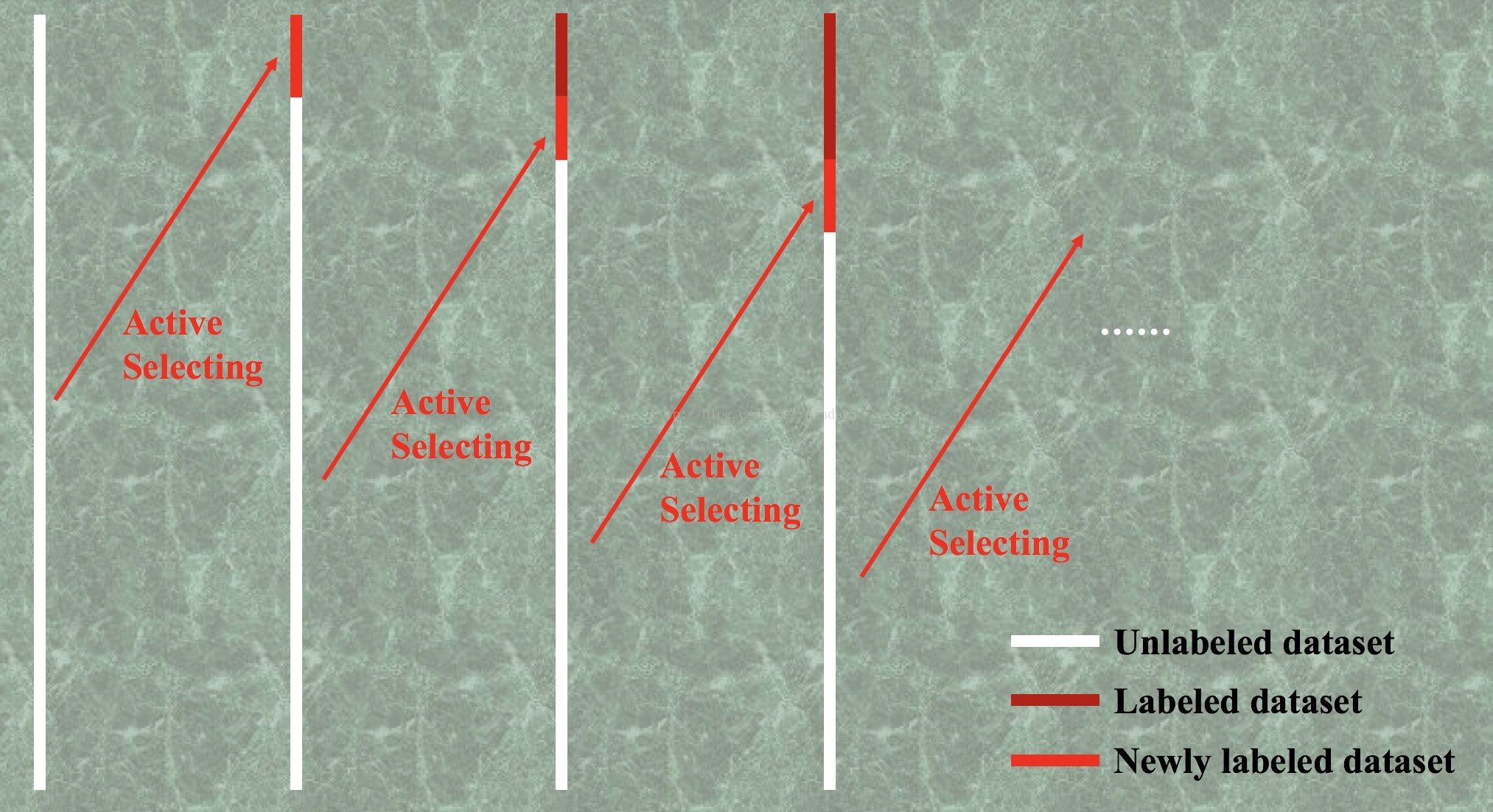

解决方案就是主动学习(Active Learning),去主动学习那些比较“难的”,“信息量大的”样本(hard mining)。关键点是每次都挑当前分类器分类效果不理想的那些样本(hard sample)给它训练,假设是训练这部分hard sample对于提升分类器效果最有效而快速。问题是在不知道真正标签的情况下怎么去定义HARD sample?或者说怎么去描述当前分类器对于不同样本的分类结果的好坏?

定义:由于深度学习的输出是属于某一类的概率(0~1),一个很直观的方法就是用“熵(entropy)”来刻画信息量,把那些预测值模棱两可的样本挑出来,对于二分类问题,就是预测值越靠近0.5,它们的信息量越大。还有一个比较直观的方法是用“多样性(diversity)”来刻画预测的一致性,当我们在做数据扩充(data augmentation)的时候,往往是知道哪些标签应该是属于一类的,尽管不知道具体是哪一类。举例来讲:对于一幅图我们进行平移变换,我们知道它们其实是来自同一幅图的,那么最后的预测应该是一致的,如果当前网络对于这写patch的预测值偏差很大,那么我们认为这个样本是比较难分类的,需要被挑出来作为训练集。这两个方法都是在“Active batch selection via convex relaxations with guaranteedsolution bounds“中被提出。是十分重要的两个Active Learning的选择指标。

有了这两个指标来选hard sample,是比较靠谱了——实验结果表明,这比随机去选已经能更快地达到临界拐点了

举例来讲,假设你是一个养狗的大户,你现在想做一个非常偏的(专业化的)分类问题,如卷毛比雄犬和哈瓦那犬的分类问题,你手头有这两种狗各50条,你自己可以很轻松地区分这100条狗,现在需要做的是训练一个分类器,给那些不懂狗的人,他们拍了狗的照片然后把照片输入到这个分类器就可以很好地判断这是卷毛比雄犬还是哈瓦那犬。首先你可以给这100条狗拍照片,每条狗都有不同形态的10张照片,一共拍了1000张没有标记的照片。对于这1000张照片,你所知道的是哪10张对应的是一条狗,其他什么都不知道。

在这个实际分类问题中,你拥有绝对的数据优势,即便是Google Image也不能企及,当然一种选择是你把1000张图片从头到尾看一遍,标注好,但是你更希望是把大多数简单的分类工作交给分类器,自己尽可能少的做标记工作,并且主要是去标记那些分类器模棱两可的那几张照片来提高分类器的性能。

我们初步提供的解决方案是:

- 把1000张图放到在大量自然图像中预训练的网络(LeNet,AlexNet,GoogLeNet,VGG,ResNet等等)中测试一遍,得到预测值,然后挑出来那些“最难的”,“信息量最大的”样本,你看一下,给出他们的标签(卷毛比雄犬还是哈瓦那犬);

如FIG.2所示,每次循环都用不断增加的标记数据集去提升分类器的性能,每次都挑对当前分类器比较难的样本来人为标记。

3. 这个过程什么时候可以停?

- 钱用光了;

以上三种情况都可以让这个循环训练过程中断,第一种就很无奈了,没钱找人标记了...第二种情况和第三种情况的前提共识是如果难的样本都分类正确了,那么我们认为简单的样本肯定也基本上分类正确了,即便不知道标签。第三种情况,举例来说就是黑白图像分类,结果分类器模棱两可的图像是灰的...也就是说事实上的确分不了,并且当前的分类器居然能把分不了的样本也找出来,这时我们认为这个分类器的性能已经不错的了,所以循环训练结束。

303

303

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?