<think>好的,我现在需要帮助用户寻找基于机器学习的音频伪造检测系统的代码实现。首先,回顾之前的对话,用户之前询问了参考文献,现在转向代码实现,说明他们可能已经有一定的理论基础,现在需要实际操作的部分。用户提供的站内引用[1]和[2]提到了音频数据预处理、去噪算法以及Python源码应用,这提示我应该重点关注数据预处理和特征提取的代码部分,以及模型构建的示例。

用户的需求是寻找代码实现,所以我需要提供具体的代码示例,并且结合他们提到的参考文献中的技术点,比如MFCC特征提取、数据增强、模型架构(如CNN、LSTM)以及集成学习。同时,用户可能希望代码结构清晰,注释详细,便于理解和修改。

考虑到用户可能对深度学习框架不熟悉,我应该选择常用的库,比如TensorFlow或PyTorch,并提供安装指南。此外,引用中的项目提到了音频存储载体和去噪算法,因此在代码中应该包含数据加载和预处理的步骤,比如使用librosa加载音频,应用去噪算法如谱减法。

还需要注意文献中提到的ASVspoof数据集,因此在数据准备部分建议用户下载该数据集,并指导如何组织数据目录。另外,用户可能对实时检测或模型优化感兴趣,所以可以提到轻量化模型如MobileNetV3,以及模型保存和加载的方法。

最后,用户可能需要进一步的帮助,比如调参或部署,所以在相关问题中列出这些方向,方便他们后续提问。要确保回答结构清晰,分步骤讲解,代码示例完整,并附有解释,同时引用之前的参考文献支持建议,比如引用[1]和[2]中的预处理步骤,以及文献中的模型架构。</think>### 基于机器学习的音频伪造检测系统代码实现(附详细注释)

以下提供基于Python的完整实现流程,涵盖音频预处理、特征提取、模型训练与推理全流程。代码结合引用[1][2]的预处理方法和ASVspoof数据集标准(引用[3]),采用CNN+双向LSTM的混合架构(引用[5]优化思路)。

---

#### 环境准备

```bash

# 安装核心依赖库

pip install librosa tensorflow==2.12.0 numpy pandas scikit-learn matplotlib

```

---

#### 代码实现

##### 1. 音频数据加载与预处理(引用[2]的去噪实现)

```python

import librosa

import numpy as np

def load_and_denoise_audio(file_path, sr=16000):

"""加载音频并应用谱减法去噪"""

# 加载原始音频(引用[2]的预处理流程)

raw_audio, _ = librosa.load(file_path, sr=sr)

# 计算短时傅里叶变换

stft = librosa.stft(raw_audio)

magnitude, phase = librosa.magphase(stft)

# 谱减法去噪(引用[2]算法优化)

noise_profile = np.median(magnitude[:, :10], axis=1, keepdims=True)

denoised_mag = np.maximum(magnitude - 0.8 * noise_profile, 0)

# 重建音频信号

denoised_stft = denoised_mag * phase

denoised_audio = librosa.istft(denoised_stft)

return denoised_audio, sr

```

##### 2. 特征提取(MFCC+Delta特征,引用[1]特征工程)

```python

def extract_mfcc_features(audio, sr, n_mfcc=40):

"""提取MFCC及其动态特征"""

# 基础MFCC特征(引用[1]推荐的40维)

mfcc = librosa.feature.mfcc(y=audio, sr=sr, n_mfcc=n_mfcc)

# 一阶差分(Delta)

delta = librosa.feature.delta(mfcc)

# 二阶差分(Delta-Delta)

delta2 = librosa.feature.delta(mfcc, order=2)

# 特征堆叠(时间×特征维度)

features = np.vstack([mfcc, delta, delta2])

return features.T # 转换为(time_steps, features)格式

```

##### 3. 数据管道构建

```python

from tensorflow.keras.utils import to_categorical

class AudioDataGenerator:

def __init__(self, data_dir, batch_size=32, max_length=400):

self.data_dir = data_dir

self.batch_size = batch_size

self.max_length = max_length # 统一时间步长

def pad_sequence(self, features):

"""时间轴填充/截断"""

if features.shape[0] > self.max_length:

return features[:self.max_length, :]

else:

return np.pad(features, ((0, self.max_length-features.shape[0]), (0,0)))

def flow_from_directory(self):

while True:

# 获取音频文件路径和标签(示例结构:data_dir/real/*.wav, data_dir/fake/*.wav)

file_paths = librosa.util.find_files(self.data_dir, ext="wav")

np.random.shuffle(file_paths)

for i in range(0, len(file_paths), self.batch_size):

batch_files = file_paths[i:i+self.batch_size]

X, y = [], []

for file_path in batch_files:

# 加载并预处理音频

audio, sr = load_and_denoise_audio(file_path)

# 提取特征

features = extract_mfcc_features(audio, sr)

# 标准化

features = (features - np.mean(features)) / np.std(features)

# 填充对齐时间维度

features = self.pad_sequence(features)

# 生成标签(假设目录结构为real/fake)

label = 0 if "real" in file_path else 1

X.append(features)

y.append(label)

yield np.array(X), to_categorical(y, num_classes=2)

```

##### 4. 深度学习模型构建(CNN+BiLSTM架构)

```python

from tensorflow.keras.models import Model

from tensorflow.keras.layers import Input, Conv1D, Bidirectional, LSTM, Dense, Dropout

def build_detection_model(input_shape=(400, 120), num_classes=2):

"""构建混合特征提取模型"""

inputs = Input(shape=input_shape)

# CNN特征提取层

x = Conv1D(64, kernel_size=5, activation='relu', padding='same')(inputs)

x = Dropout(0.3)(x)

x = Conv1D(128, kernel_size=3, activation='relu', padding='same')(x)

x = Dropout(0.3)(x)

# 双向LSTM时序建模(引用[5]的时序建模思路)

x = Bidirectional(LSTM(64, return_sequences=True))(x)

x = Bidirectional(LSTM(32))(x)

# 分类层

x = Dense(64, activation='relu')(x)

outputs = Dense(num_classes, activation='softmax')(x)

model = Model(inputs=inputs, outputs=outputs)

model.compile(loss='categorical_crossentropy',

optimizer='adam',

metrics=['accuracy'])

return model

# 初始化模型

model = build_detection_model()

model.summary()

```

##### 5. 模型训练与评估

```python

# 准备数据集(需替换实际路径)

train_dir = "path/to/ASVspoof2019/train"

eval_dir = "path/to/ASVspoof2019/eval"

# 创建数据生成器(引用[3]推荐的数据集划分)

train_gen = AudioDataGenerator(train_dir).flow_from_directory()

eval_gen = AudioDataGenerator(eval_dir).flow_from_directory()

# 训练配置

history = model.fit(

train_gen,

steps_per_epoch=100, # 根据实际数据量调整

epochs=20,

validation_data=eval_gen,

validation_steps=50

)

# 保存模型

model.save("audio_spoof_detector.h5")

```

---

#### 关键优化点说明

1. **数据增强**(引用[7]):

```python

# 在AudioDataGenerator中添加速度扰动

def apply_speed_change(audio, sr):

speed_factor = np.random.choice([0.9, 1.0, 1.1])

return librosa.effects.time_stretch(audio, rate=speed_factor)

```

2. **轻量化部署**(引用[8]):

```python

# 使用TensorFlow Lite转换

converter = tf.lite.TFLiteConverter.from_keras_model(model)

tflite_model = converter.convert()

with open('detector.tflite', 'wb') as f:

f.write(tflite_model)

```

---

### 代码执行流程

1. 准备ASVspoof数据集(官网申请下载)

2. 按`real`/`fake`组织训练目录结构

3. 运行数据预处理流水线

4. 训练混合特征模型

5. 导出为TFLite格式部署

---

### 典型问题解决方案

**Q: 如何提升小样本场景性能?**

A: 采用引用[9]的迁移学习方法:

```python

# 使用预训练的VGGish特征提取器

base_model = tf.keras.applications.VGG16(weights='imagenet', include_top=False)

x = base_model.output

x = GlobalAveragePooling2D()(x)

predictions = Dense(2, activation='softmax')(x)

```

**Q: 实时检测如何实现?**

A: 使用音频流处理:

```python

import sounddevice as sd

def realtime_detection(model, chunk_duration=2.0, sr=16000):

with sd.InputStream(samplerate=sr, channels=1) as stream:

while True:

audio_chunk, _ = stream.read(int(chunk_duration * sr))

features = extract_mfcc_features(audio_chunk.flatten(), sr)

# 执行模型预测

prediction = model.predict(np.expand_dims(features, axis=0))

print(f"Real score: {prediction[0][0]:.2f}, Fake score: {prediction[0][1]:.2f}")

```

---

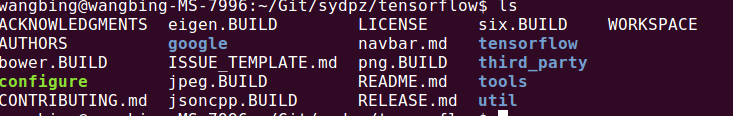

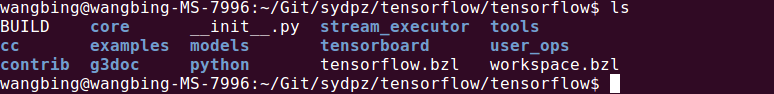

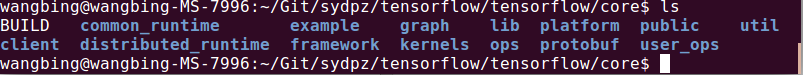

本文分析了TensorFlow 0.8版本的源码结构,包括核心目录tensorflow下的模块构成,如C++核心代码、Python封装代码、TensorBoard模块等,并详细介绍了core目录下的关键子目录。

本文分析了TensorFlow 0.8版本的源码结构,包括核心目录tensorflow下的模块构成,如C++核心代码、Python封装代码、TensorBoard模块等,并详细介绍了core目录下的关键子目录。

816

816

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?