梯度下降(gradient descent)

梯度下降利用迭代的方法,更新 θ 参数,以提高回归问题中拟合的准确性。其步骤如下。

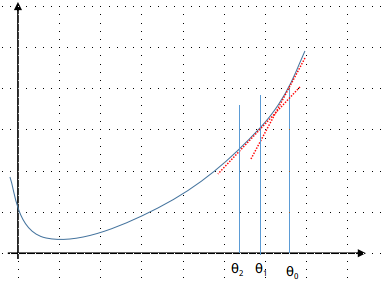

- 以某个初值来初始化 θ ,例如 θ=(0.1,0.2,0.3)T

- 使用 J(θ) 来表示代价函数,不断更新其中 θ 的值来最小化 J(θ) ,对于 θ 中的每个向量元素 θj ,更新式子为: θj:=θj−α(∂/∂θj)J(θ) 。利用这个式子,同时更新每个 θj,0≤j≤n 。

假设

J(θ)

是一个只有一个变量的函数,则下图展示了它的曲线以及

θ

的对应变化。

从图中可以看出,由于曲线的斜率在从

θ0

到

θ1...

的过程中在不断变小,所以

θ

的下降幅度也在变小,最终会到达曲线的最低点,也就是

J(θ)

的最小值处。

3689

3689

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?