目录

所需软件列表

Vmware Workstation

Linux OS(Centos 7)

JDK(1.8+)

Hadoop(2.7.7+)

Xftp

Xshell

一,安装前的准备工作

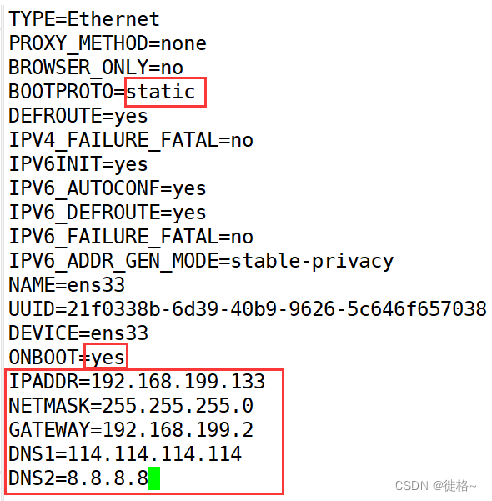

1.设置Linux系统静态IP地址

因为虚拟机网络采用bridge桥接方式,客户机和宿主机在同一个局域网中,因此按如下方式设置客户操作系统的IP地址 客户操作系统的IP地址和主操作系统在同一网段 客户操作系统的网关和主操作系统一致 客户操作系统的DNS和主操作系统一致。

命令:vi /etc/sysconfig/network-scripts/ifcfg-ens33

把BOOTPROTO=dhcp修改为static

ONBOOT=no修改为yes

其他的根据自己的电脑来更改,因为每个人改的ip什么的都不一样,我这里只是大概的说.

设置完毕执行命令: systemctl restart network.service重启Linux系统网络。

验证:ip addr命令查看设置是否成功

配置完后可以ping一下是否网络连通

命令:ping www.baidu.com

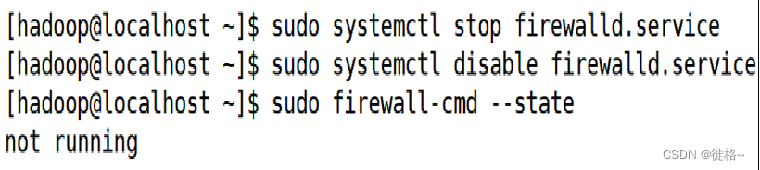

2.关闭防火墙

查看Linux系统防火墙状态命令:firewall-cmd --state

关闭防火墙命令:systemctl stop firewalld.service

关闭防火墙的自动运行命令:systemctl disable firewalld.service

3.修改主机名

修改虚拟机的主机名为master 可以改自己想改的,但是要和后面配置文件的名称相符合,不然可能导致运行不了。

命令:vi /etc/hostname

修改完主机名需要重启虚拟机

命令:reboot

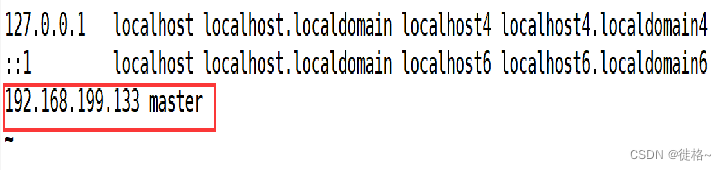

4.配置主机名与IP映射

修改完主机名后,需要将静态IP地址与主机名进行映射,即修改hosts文件。

IP地址与主机名的映射输入格式为:IP地址 主机名 其中IP地址即步骤1中设置的静态IP地址

(不要把ip和主机名搞反,不然会导致后面运行不了)

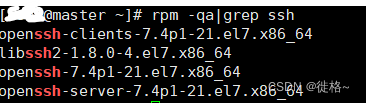

5.设置SSH免密登录

可以查看虚拟机是否安装了ssh

命令:rpm -qa|grep ssh

如下面图所示就说明ssh已安装好,否则就要使用该命令:yum-y install openssh

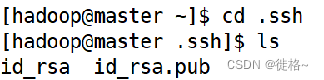

执行以下命令产生密钥,位于~/.ssh目录

命令:ssh-keygen –t rsa

将公钥(id_rsa.pub)拷贝到当前目录的 /authorized_keys列表

命令:cat id_rsa.pub >> authorized_keys

或者:ssh-copy-id -i id_rsa.pub hadoop

修改authorized_keys的权限为0600

命令:chmod 600 authorized_keys

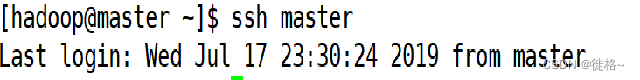

ssh免密登录设置完毕,需要验证是否真的可以免密登录虚拟机

命令:ssh master

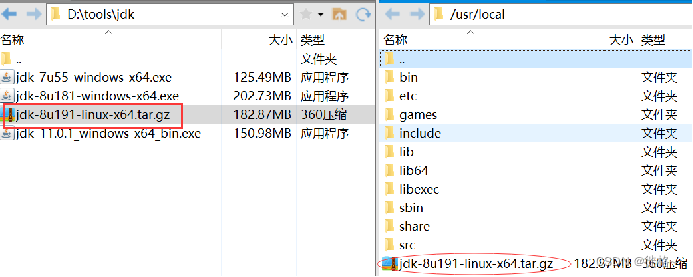

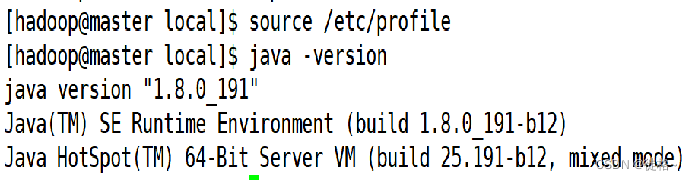

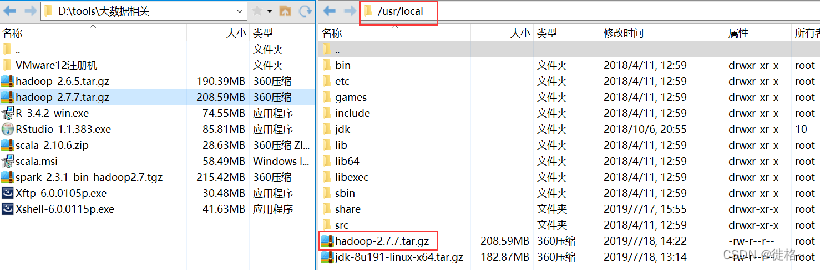

6 .安装JDK(要jdk的后期可以找我要)

通过xftp工具将安装包上传到虚拟机master的某个目录下 (我这里是放在usr/loacl下)

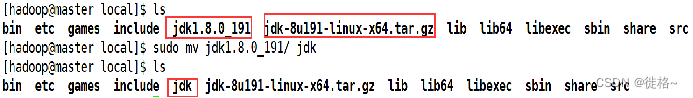

解压文件:tar -zxvf jdk-8u191-linux-x64.tar.gz

重命名解压后的文件夹:将解压后的文件夹重命名为jdk (我改主要是为了方便,你们也可以不改)

命令:sudo mv jdk1.9.0_191/ jdk

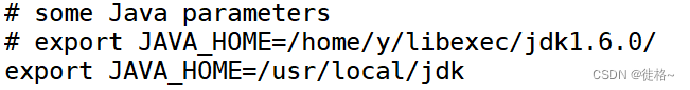

配置jdk环境变量

命令:vi /etc/profile,编辑此文件增加2行内容

/usr/local/jdk 这里是放你们自己解压jdk的目录

生效配置信息:source /etc/profile

二,Hadoop的安装与配置

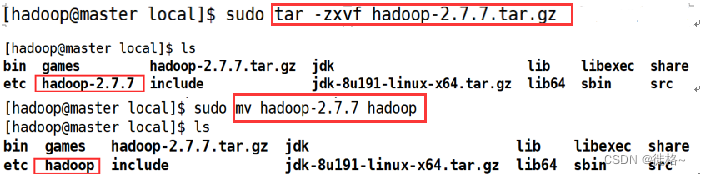

1.上传安装包至Linux服务器(我这里跟jdk一样放在/usr/local下)

2.解压安装包并重命名

命令:tar -zxvf hadoop-2.7.7.tar.gz

3.配置环境变量并立即生效

命令:vi /etc/profile,编辑此文件增加2行内容

export HADOOP_HOME=/usr/local/hadoop export PATH=.:$HADOOP_HOME/bin:$HADOOP_HOME/sbin:$PATH

生效配置文件 命令:source /etc/profile

4.修改Hadoop核心配置文件

Hadoop的核心配置文件有多个:hadoop-env.sh、yarn-env.sh、core-site.xml、hdfs-site.xml、mapred-site.xml、yarn-site.xml

其路径为:/usr/local/hadoop/etc/hadoop

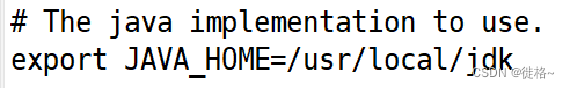

(1)修改vim hadoop-env.sh文件

修改JAVA_HOME的配置信息,将原来的值修改为Java运行环境的安装路径。

export JAVA_HOME=/usr/local/jdk…(jdk实际安装路径)

(2) 修改vim yarn-env.sh 文件

此文件是YARN框架运行环境的配置,同样需要修改JAVA_HOME的配置信息。

export JAVA_HOME=/usr/local/jdk…(jdk实际安装路径)

(3)修改 vim core-site.xml文件

配置HDFS的地址和端口号以及临时数据的目录。

<configuration>

<property>

<!-- HDFS资源路径 -->

<name>fs.defaultFS</name>

<value>hdfs://master:8020</value>

</property>

<!-- Hadoop临时文件存放目录 -->

<property>

<name>hadoop.tmp.dir</name>

<value>/usr/local/hadoop/tmp</value>

</property>

</configuration>

(4)修改hdfs-site.xml 文件

修改HDFS保存数据的副本数量以及存储NameNode和DataNode元数据的目。

<configuration>

<!-- 副本数 -->

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<!-- namenode元数据存储路径 -->

<property>

<name>dfs.namenode.name.dir</name> <value>file:/usr/local/hadoop/tmp/dfs/name</value>

</property>

<!-- 数据存储路径 -->

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/data</value>

</property>

</configuration>

(5)修改修改mapred-site.xml

配置使用yarn框架 因Hadoop的此目录下无该文件,需先创建此文件

执行命令:cp mapred-site.xml.template mapred-site.xml

然后配置如下内容:

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

(6)修改yarn-site.xml,配置yarn属性

配置内容如下:

<configuration>

<!—配置resourceManager在哪台机器 -->

<property>

<name>yarn.resourcemanager.hostname</name>

<value>master</value>

</property>

<!-- 在nodemanager中运行mapreduce服务 -->

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<!--配置web ui访问端口(默认端口为8088)-->

<property>

<name>yarn.resourcemanager.webapp.address</name>

<value>master:18088</value>

</property>

</configuration>

三,启动与停止Hadoop

Hadoop伪分布式集群的启动,可以依次单独启动HDFS和YARN,也可以一次启动所有的节点,一般建议依次单独启动HDFS和YARN。

(1)NameNode格式化

在Hadoop的解压目录:/usr/local/hadoop/bin下执行

hdfs namenode -format

(2)启动/停止HDFS

在Hadoop的解压目录:/usr/local/hodoop/sbin下存放

启动、停止的所有脚本文件

start-dfs.sh stop-dfs.sh

(3)启动/停止YARN

start-yarn.sh stop-yarn.sh

(4)一次性同时启动HDFS和YARN(此种方式不建议使用)

start-all.sh stop-all.sh

四,访问Hadoop

验证Hadoop是否配置并启动成功

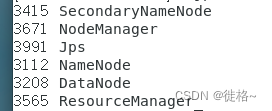

查看启动进程方式

执行命令jps查看启动的进程中是否启动了以下5个进程,如下图说明就成功了。(这里是一键启动)(主节点: NameNode,SecondaryNamenode ,ResourceManager 从节点: DataNode、NodeManager )

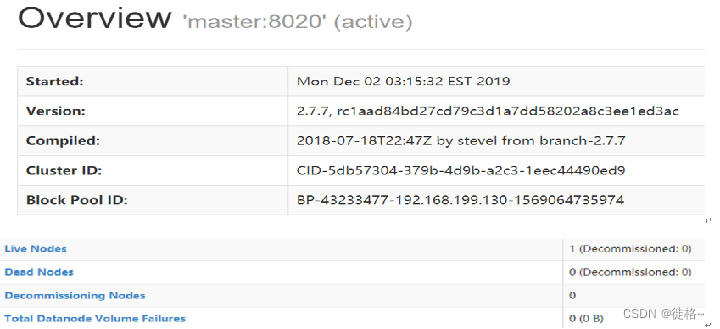

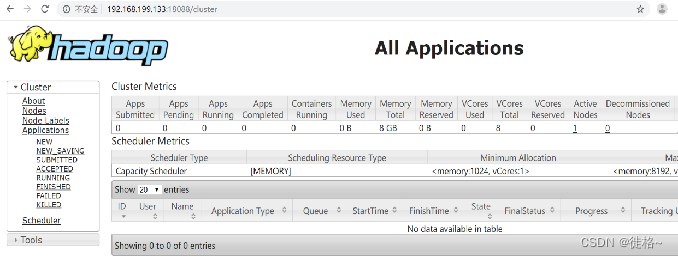

浏览器访问方式

http://192.168.199.133:50070/

http://192.168.199.133:18088/

验证Hadoop是否配置并启动成功

这样子就结束了,第一次弄,有不好的请大家在评论区说出来,有问题也可以在评论区问。有要安装包的也可以问我要。谢谢大家,观看了!

373

373

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?