12 月 26 日,DeepSeek-V3 首个版本上线并同步开源。据官方介绍,DeepSeek-V3 为自研 MoE 模型,671B 参数,激活 37B,在 14.8T token 上进行了预训练。

前排提示,文末有大模型AGI-CSDN独家资料包哦!

其论文显示,DeepSeek V3 整个训练过程仅用了不到 280 万个 GPU 小时,相比之下,Llama 3 405B 的训练时长是 3080 万 GPU 小时(p.s. GPU 型号也不同)。

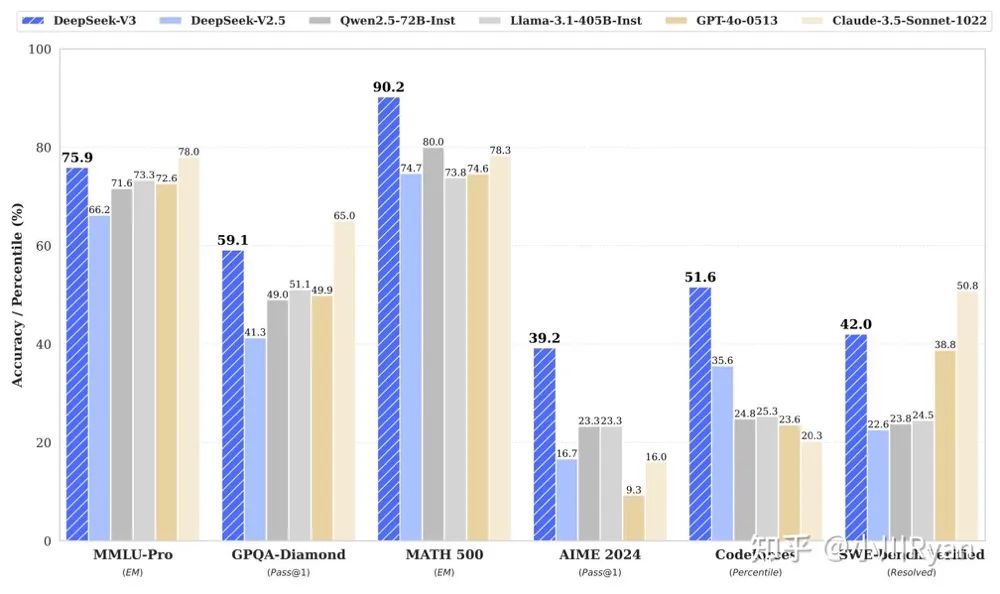

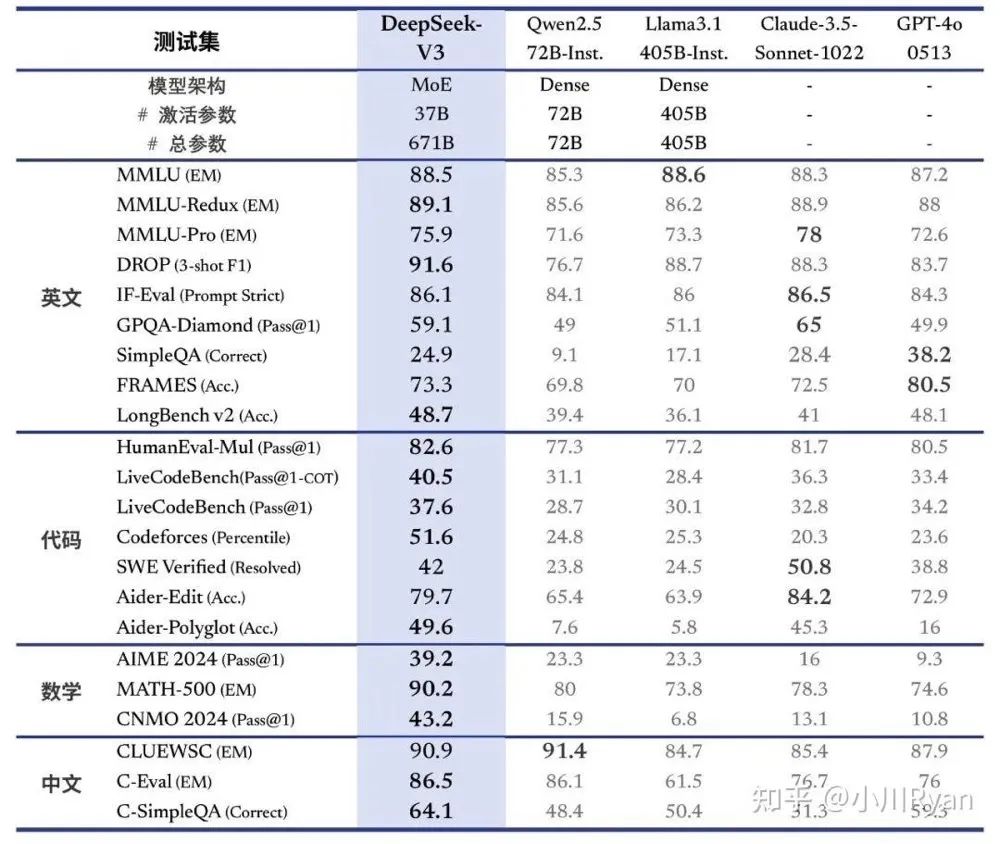

DeepSeek-V3 消耗的训练计算量较少,但其性能却足以比肩乃至更优,多项评测成绩超越了 Qwen2.5-72B 和 Llama-3.1-405B 等其他开源模型,并在性能上和世界顶尖的闭源模型 GPT-4o 以及 Claude-3.5-Sonnet 不分伯仲。

看到正式发布的消息之后,迅速过了一下 DeepSeek-v3 的技术报告,看完之后觉得有几个值得 highlight 的地方(主要关注 post-training 部分)。

那么作为一个大模型工程师该如何评价 deepseek 上线的 deepseek-V3 模型?

首先效果上已经不必多言,不论是主流 benchmark,还是一些如 livebench 类的第三方评测,DeepSeek-V3 几乎是第一个比肩甚至超过目前已经开放服务的商业模型的开源模型,恭喜 DeepSeek!

01

合成数据

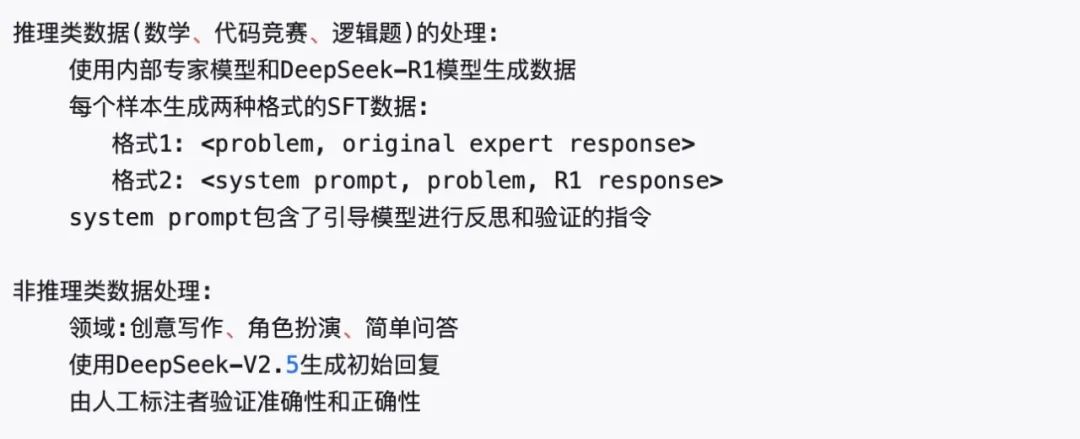

推理和非推理 two-way 的 SFT 数据合成:

报告中提到的这种方式解答了我的一个困惑,即一个像 Claude-3.5-sonnet 同时兼备很强推理能力和日常任务可用性是怎么训练出来的。

因为如 o1 等专门的推理类模型用于日常任务的时候经常会有过度思考或者一些很 awkward 的输出,而 4o 等非推理模型在面对逻辑复杂一些的请求时表现又不够好。

V3 的方案是对于推理类的 query 保留专家模型答案的准确性和简洁性以及 R1 的推理模式,而后在 RL 阶段通过高温采样来融合不同风格,即让奖励信号去决定什么时候该采用什么风格,是一个很自然且 scalable 的做法。

合成数据成为一种common practice

DeepSeep-V3的发布让前阵子传言的_Claude-3.5-Opus已经训练好,只是Anthropic暂时没有放出来,而是选择在内部用来合成数据了_这个消息的可信度更加高了:这种通过内部更强的模型来合成数据做bootstrapping的方式似乎已经成为一种common practice。

而有了足够capable的模型来辅助合成训练数据之后,由于需要的人工干预远小于以前模型还比较weak的时候,所以迭代的速度只会比以前更快了。

同时也很让人感慨这些年这个领域研究路线的演化:

(1)BERT 以前的时代:人们热衷于在结构上做文章,各种+attention/gating/lattice/knowledge module,换来在一个有限集合的任务上的提升。

(2)BERT 时代:模型的结构逐渐固定下来,大家通过引入不同的训练目标/学习任务(如对比学习、领域偏置)在 pretrained model 的基础上进一步提升各个 domain 上的任务性能。

(3)近两年到现在:训练目标也逐渐固定下来了(next token prediction),变成需要优化哪方面的能力就构造什么样的数据,或者提供一个可靠的奖励信号去引导模型自己向我们期待的方向做 exploration。

这种改变个人觉得是越来越接近问题本质的,因为不管模型之间的架构如何 varies,最终决定一个模型行为和 character 的,唯数据尔。

02

更鲁棒的奖励信号

之前在一篇 study 类的文章中(Unpacking DPO and PPO: Disentangling Best Practices for Learning from Preference Feedback)观察到奖励模型跟其下游 policy 在表现上的不一致性。

即一个在榜单上表现更好的奖励模型下训练得到的 policy model 竟然不如一个表现更差的奖励模型优化得到的 policy。

尽管可能跟优化过程中的不稳定性有一些关系,但个人觉得 reward model 不够鲁棒(容易过拟合一些 superficial patterns、hacking 指标)有很大的关系。

而 V3 的实践也反映了我们现在在提升奖励信号的可靠性上已经取得了明显的进展。

(1)Verifiable Rewards

通过建立各种 rules/sandbox 来对模型给出的 solution 进行严格的判定,作为奖励信号,为模型在进阶难度的数学(AIME)和代码(Codeforces,SWE-Bench)等任务上做 exploration 提供了坚实的基础。

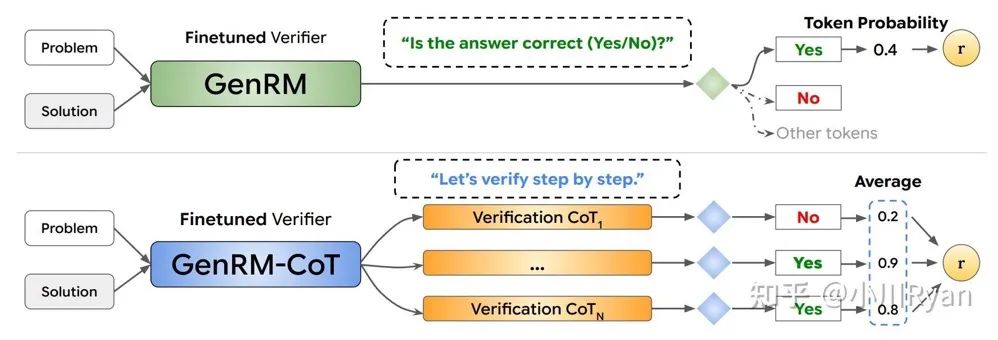

Critic-augmented Reward Model

而对于那些开放性的任务或请求,我们则可以令 RM 生成中间推理过程的方式 force 模型得到一个比较靠谱的 reward, 同时具备了更好的透明度/可解释性,也是过去一年中一个非常热的话题。

Generative Verifiers: Reward Modeling as Next-Token Prediction

所以总结起来就是 更加强大/domain-specific 的模型为现有模型合成 imitation 数据,为其在 RL 阶段提供探索的入口,得到更加强大的版本。

而更强大的版本又可以继续用于训练更 capable 的 domain-specific(如推理场景)模型以及更鲁棒的奖励模型,扶级而上。

读者福利:如果大家对大模型感兴趣,这套大模型学习资料一定对你有用

对于0基础小白入门:

如果你是零基础小白,想快速入门大模型是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以根据这些资料规划好学习计划和方向。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

观看零基础学习书籍和视频,看书籍和视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?