本篇文章将介绍基于大模型来搭建本地知识库的流程。开源工具:MaxKB + Ollama

前排提示,文末有大模型AGI-CSDN独家资料包哦!

安装docker

在官网按需选择桌面版本,安装之后在docker中搜索maxkb的镜像:

搜索maxkb

点击 Run,等镜像下载完成之后,配置参数:

配置container

在 Volumes 这里,需要配置两个 Host path 来映射容器的固定目录:

# host path是本机目录,可以随意 /host/path1 ==> /var/lib/postgresql/data /host/path2 ==> /opt/maxkb/app/sandbox/python-packages

配置好之后,点击 Run,浏览器打开 localhost:8080,就能访问了:

登录页面

输入默认的用户名和密码登录即可:admin / MaxKB@123..

除了可视化配置之外,也可在 Terminal 运行命令启动:

docker run -d --name=maxkb --restart=always -p 5432:8080 \n -v ~/.maxkb:/var/lib/postgresql/data \n -v ~/.python-packages:/opt/maxkb/app/sandbox/python-packages \n cr2.fit2cloud.com/1panel/maxkb

创建知识库

登录之后,点击知识库 --> 创建知识库:

创建知识库

然后选择 Markdown 格式的文档上传:

上传文件

示例的 README.md 是介绍组件 QueryTable组件的使用。可以把需要上传的文档放在同一个目录一起上传,待文件上传完成之后,就完成了知识库的创建。

添加Ollama

物料上传之后,去系统管理 --> 模型设置,配置本地私有模型:

模型设置

maxkb 不仅支持常见的公有模型,也支持Ollama等私有模型。对于非敏感数据,也可以选择线上的公有模型。私有模型我们选择 ollama 进行配置。

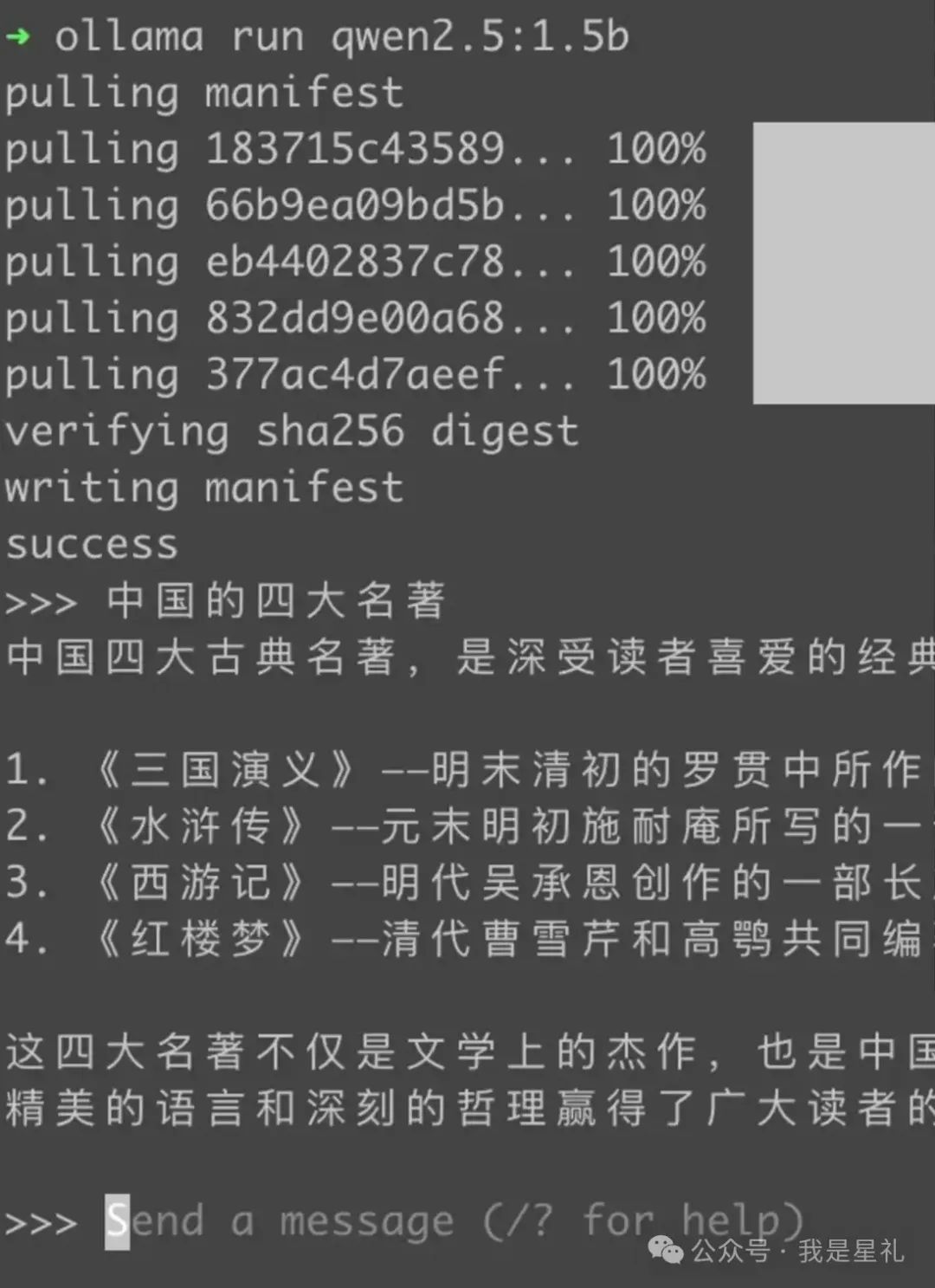

先去官网下载 ollama,安装之后可以跑一下中文模型 qwen2.5:

qwen2.5

因为物料都是中文,所以MaxKB也选择中文开源模型 qwen2.5:

添加Ollama

API域名用 http://host.docker.internal:11434,host.docker.internal 相当于容器内的 locahost, 11434 是 ollama 模型的默认端口,API Key 随便填一个就行,最后点「添加」:

创建本地模型

如果是线上模型,域名和key就用模型对应的域名和key

创建应用

知识库和本地模型都配置完成之后,就需要创建一个应用将知识库和本地模型关联起来:

创建应用

「AI模型」选择刚创建好的本地模型。应用创建好之后,会有一个本地访问连接:

应用界面

打开这个链接,输入问题:QueryTable组件怎么用。可以看到其回复中会引用知识库 component 中的内容:

结果测试

至此,我们已完成基于本地大模型的知识库搭建。

读者福利:如果大家对大模型感兴趣,这套大模型学习资料一定对你有用

对于0基础小白入门:

如果你是零基础小白,想快速入门大模型是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以根据这些资料规划好学习计划和方向。

包括:大模型学习线路汇总、学习阶段,大模型实战案例,大模型学习视频,人工智能、机器学习、大模型书籍PDF。带你从零基础系统性的学好大模型!

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

👉AI大模型学习路线汇总👈

大模型学习路线图,整体分为7个大的阶段:(全套教程文末领取哈)

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

👉大模型实战案例👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

👉大模型视频和PDF合集👈

观看零基础学习书籍和视频,看书籍和视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

8455

8455

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?