这本书全面介绍了涵盖Transformer架构、BERT模型和GPT系列(包括GPT-3和GPT-4)的详细信息的一系列主题。书中分为十个章节,从基础概念如注意力机制开始,然后是令牌化技术,探索Transformer和BERT架构的细微差别,最后在与GPT系列最新进展相关的高级主题中达到高潮,包括ChatGPT。关键章节提供了深度学习中注意力演化和重要性的洞见、Transformer架构的复杂性、对BERT家族的两部分探索,以及关于使用GPT-3的实践指导。结尾章节概述了ChatGPT、GPT-4和使用生成性AI的可视化。除了主要话题外,本书还涵盖了如DeepMind、OpenAI、Cohere、Hugging Face等影响力大的AI组织。读者将全面了解NLP模型的当前景观、它们的底层架构和实际应用。书中附有伴随文件,包括众多书中代码样本和图表。

特点:

-

提供一系列全面的主题,涵盖Transformer架构、BERT模型和GPT系列的细节,包括GPT-3和GPT-4。

-

特色伴随文件,包括书中大量代码样本和图表。

关于作者 Oswald Campesato是加州大学圣克鲁斯分校的兼职讲师,专长于深度学习、Python、数据科学和GPT-4。他是《Python与机器学习》、《数据清洗》和《开发者的NLP》(均由Mercury Learning and Information出版)等四十多本书的作者或合著者。

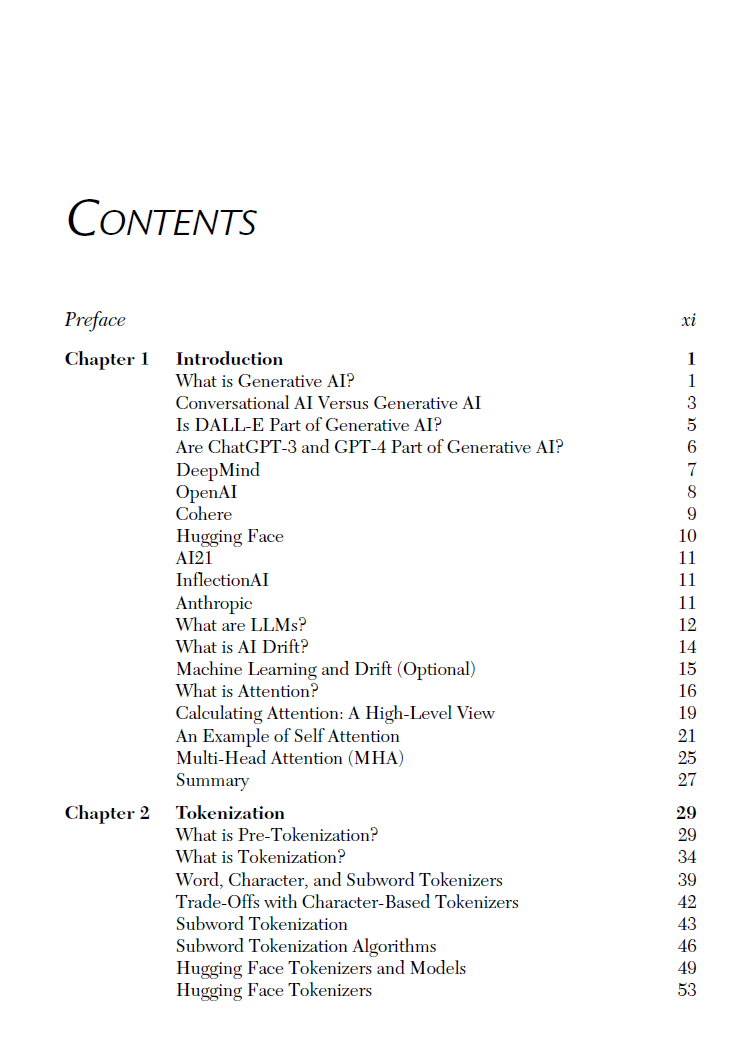

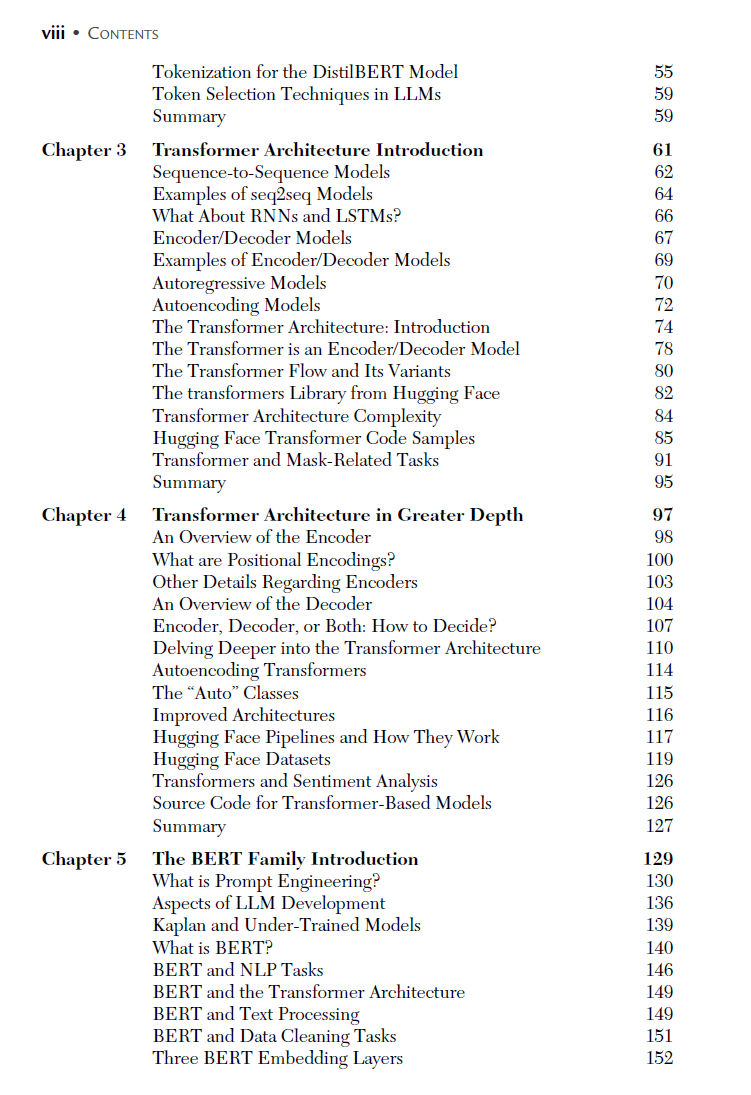

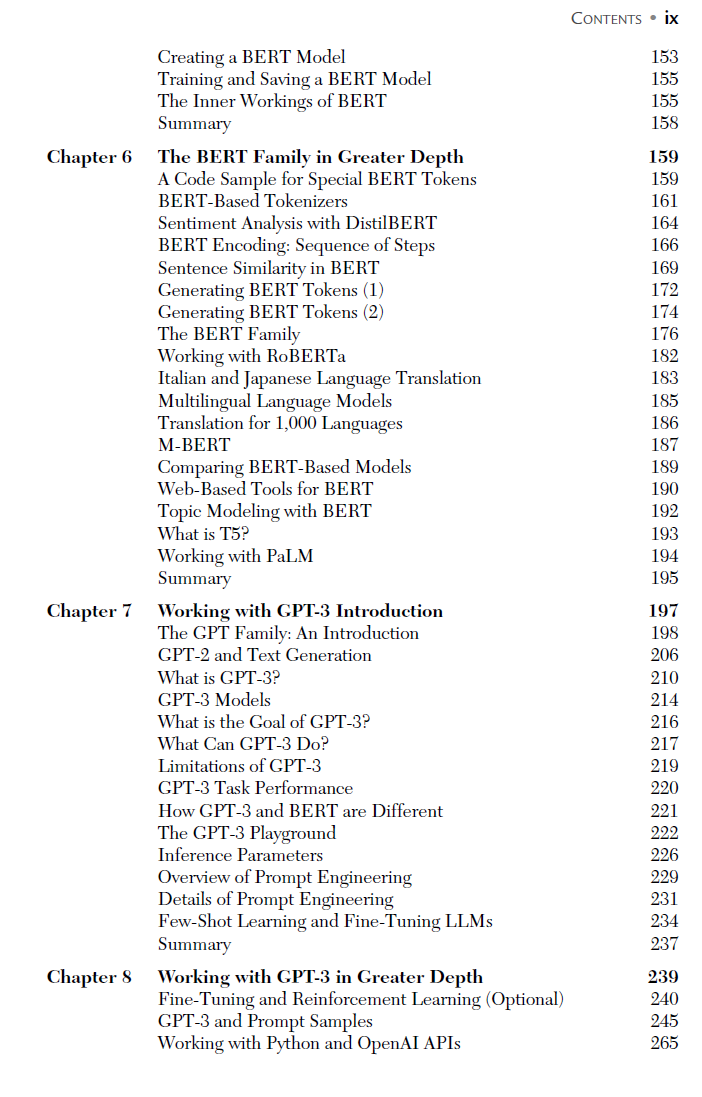

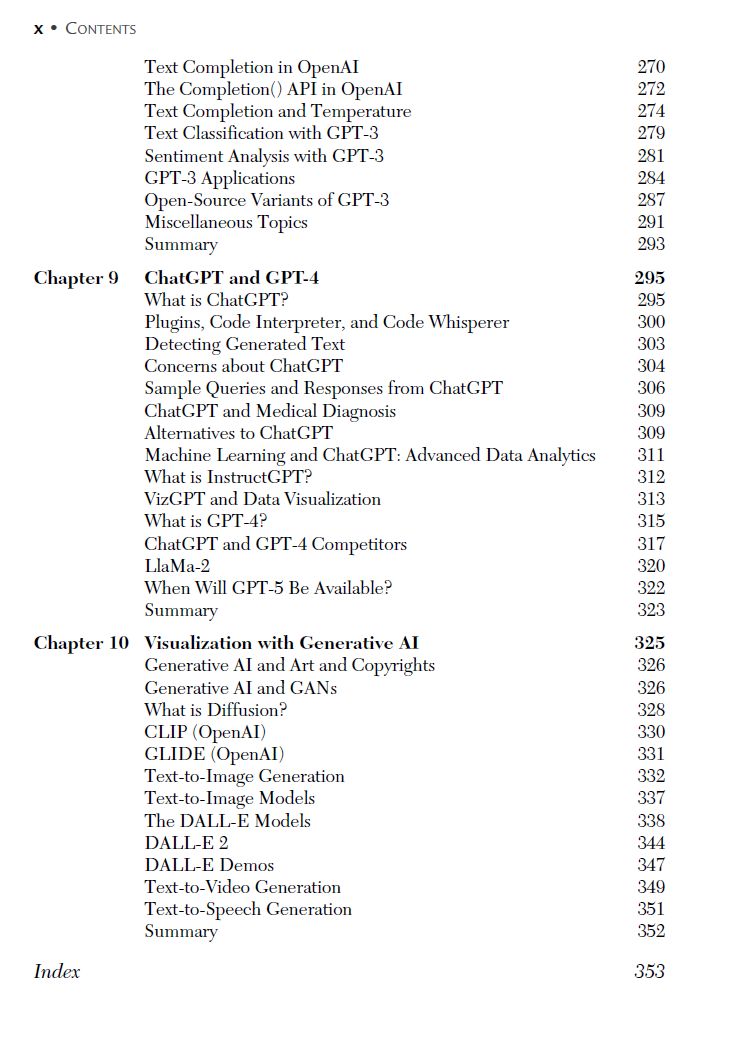

目录 1: 注意力机制 2: 令牌化 3: Transformer架构介绍 4: 更深入的Transformer架构 5: BERT家族介绍 6: 更深入的BERT家族 7: 使用GPT-3介绍 8: 更深入的使用GPT-3 9: ChatGPT和GPT-4 10: 使用生成性AI的可视化

1148

1148

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?